ChatGLM3-6B-32K 在linux(Ubuntu) GPU P100(16G)复现记录

时间:2024年6月12日

1.创建Conda环境

bash

conda create --name chatglm3 python=3.10

conda activate chatglm32.下载chatglm,并安装依赖

如果没有安装git命令,先安装git命令

bash

sudo apt-get update

sudo apt-get install git下载chatglm源代码库

bash

git clone https://github.com/THUDM/ChatGLM3

cd ChatGLM3安装依赖

bash

pip install -r requirements.txt3.下载预训练权重

如果没有安装lfs,先安装lfs

bash

sudo apt update

sudo apt install git-lfs

git lfs install注意这里下载的是6b-32k

bash

# 注意这里下载的是6b-32k

git clone https://www.modelscope.cn/ZhipuAI/chatglm3-6b-32k.git4.运行./basic_demo/cli_demo.py

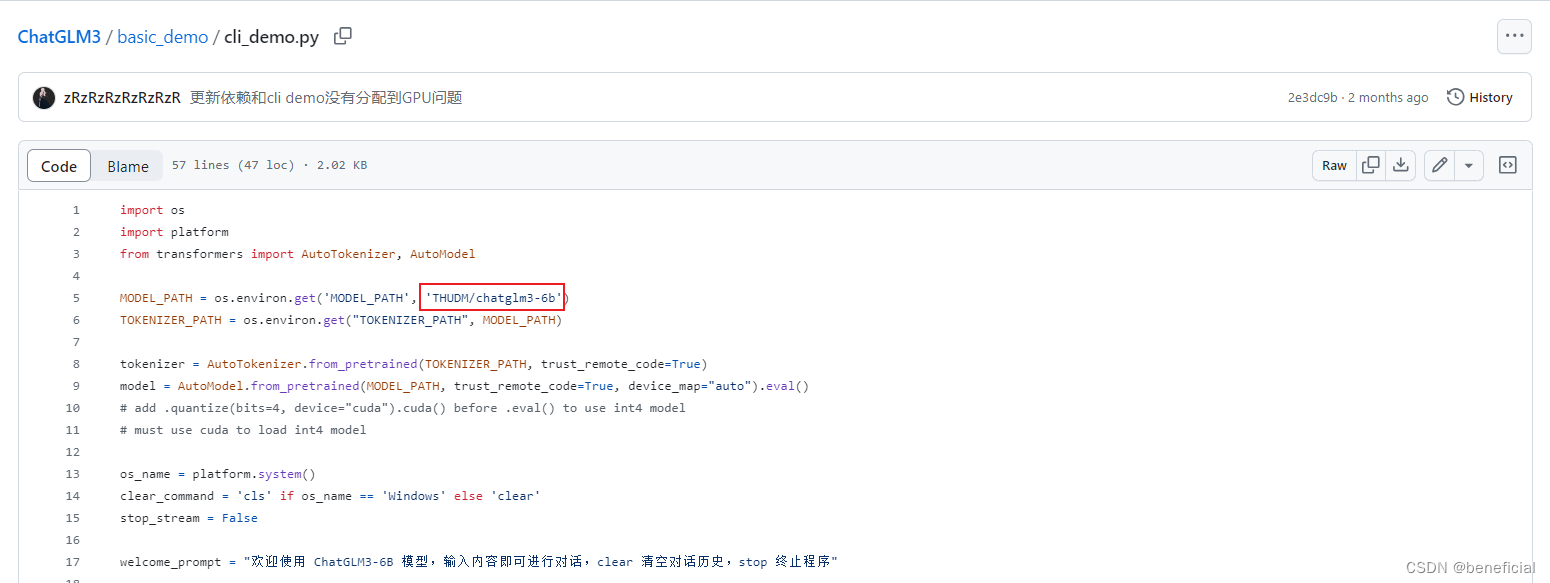

修改cli_demo.py中路径

bash

MODEL_PATH = os.environ.get('MODEL_PATH', 'THUDM/chatglm3-6b')改为

bash

MODEL_PATH = os.environ.get('MODEL_PATH', '../chatglm3-6b-32k/')

运行cli_demo.py

bash

python cli_demo.py程序会在命令行中进行交互式的对话,在命令行中通过 用户: 进行输入指示,直接输入问题回车即可生成回复,输入 clear 可以清空对话历史,输入 stop 终止程序。

显存占用情况:

5.运行composite_demo相关代码

bash

cd composite_demo

pip install -r requirements.txt

ipython kernel install --name chatglm3-demo --user修改client.py里面的路径信息

bash

MODEL_PATH = os.environ.get('MODEL_PATH', 'THUDM/chatglm3-6b')改为

bash

MODEL_PATH = os.environ.get('MODEL_PATH', '../chatglm3-6b-32k/')运行以下命令在本地加载模型并启动 demo

bash

streamlit run main.py