一、基本概念补充

在构建语言模型之前补充几个自然语言处理(NLP)基本概念。

(1)语料库(Corpus)

① 语料库的定义

在自然语言处理(NLP)领域,语料库是一个经过组织和加工的大型文本集合。这个集合可以包含各种形式的文本材料,比如书籍、报纸文章、网页内容、社交媒体帖子、对话记录等。语料库是构建和评估语言模型、进行文本分析、语法研究、机器翻译等NLP任务的基础资源。一个好的语料库往往具有代表性和广泛性,能够覆盖目标语言或领域内的各种语言现象和风格。

② 语料库可以按照不同的标准分类

- 按语言类型:单语语料库(只包含一种语言的文本)、双语或多语对照语料库。

- 按主题领域:通用语料库、法律语料库、医疗语料库等。

- 按文本来源:书面语语料库、口语语料库、网络语料库等。

- 按标注程度:未标注语料库、句法标注语料库、语义标注语料库等。

(2)NLP中的训练集

在机器学习和NLP任务中,训练集是语料库的一个子集,专门用于训练模型。 训练集中的一个个实例通常包括输入数据(如文本)及其对应的标签或期望输出(如分类标签、翻译文本等)。通过在训练集上不断调整模型参数,模型逐渐学会如何从输入预测正确的输出,从而达到学习任务的目标。

(3)分词(Tokenization)

① 分词的定义

分词(Tokenization)是自然语言处理(NLP)中的一个基本步骤,它指的是将文本数据分割成更小的、具有意义的单位,这些单位被称为"tokens"。在很多语言中,如英语,这些tokens通常是单词,但也可以是句子或任何有意义的字符序列。

一句英文句子 "The quick brown fox jumps over the lazy dog." 经过分词后,可能得到如下tokens:["The", "quick", "brown", "fox", "jumps", "over", "the", "lazy", "dog", "."]。在中文中,由于没有自然的空格分隔,分词可能更为复杂,需要识别词语边界,如"我爱北京天安门"分词后可能是 ["我", "爱", "北京", "天安门"]。

③ 以单词级医疗语料库举例

患者 主诉 腹痛 伴 发热 三 日 ,

初步 诊断 为 急性 胃炎 ,

建议 行 血常规 检查 与 腹部 B 超 。

给予 抗生素 治疗 ,

并 注意 饮食 调整 ,

避免 辛辣 刺激 食物 。在这个简化示例中,通过空格分隔词语来构造语料库是一种基本方法,这有助于模型识别和学习词语之间的统计关系。

对于中文而言,由于它是表意文字且缺乏自然的分隔符,分词(即将连续的汉字序列切分成有意义的词语单元)是一个更为复杂的过程,通常使用jieba分词器。正确的分词对于确保模型理解句子意义至关重要。

二、用RNN来构建语言模型的步骤

通过以下步骤,可以构建一个基于RNN的语言模型,该模型能够学习语言的统计规律并生成新的文本序列。

(1)准备语料库/数据预处理

- 文本清洗:去除无关字符,如标点符号、数字等(根据需求保留部分标点符号以保持语义完整性)。

- 分词:对中文文本进行分词处理,英文文本则可能直接按空格分隔。

- 构建词汇表:创建一个词汇到索引的映射表,通常包括所有出现过的单词和一个特殊的未知词(UNK)标记。

- 序列化与填充:将文本转化为数字序列,每个单词用词汇表中的索引表示,并对序列进行填充或截断以统一长度。

(2)模型架构设计

- 选择RNN类型:基于任务需求,选择标准RNN、长短期记忆网络(LSTM)或门控循环单元(GRU)等。

- 输入层:定义输入数据的形状,通常是词嵌入(word embeddings)形式。

- 循环层:构建循环结构,让模型能够捕获序列数据中的时间依赖性。

- 输出层:使用softmax函数,输出每个时间步下一个词的概率分布。

(3)训练模型

- 定义损失函数:常用交叉熵损失(Cross-Entropy Loss),衡量预测概率分布与真实标签之间的差异。

- 优化器选择:如Adam、SGD等,用于更新模型权重以最小化损失。

- 训练循环:通过反向传播和梯度下降,多次遍历整个训练数据集,逐步调整模型参数。

标准RNN训练过程

标准RNN训练过程

(4)超参数优化与评估

- 学习率 、批次大小 、隐藏层大小 、词嵌入维度等参数的选择和调整,以提升模型性能。

- 使用验证集监控过拟合,调整模型直到性能不再提升。

- 在测试集上评估模型性能,常用指标包括困惑度(Perplexity)、准确率(对于分类任务)等。

(5)生成文本

- 采样策略:可以使用贪婪搜索等策略从模型输出的概率分布中选择下一个词。

- 生成序列:给定初始词汇或随机词汇开始,不断根据模型预测的下一个词概率生成后续文本,直至达到预定长度或满足特定停止条件。

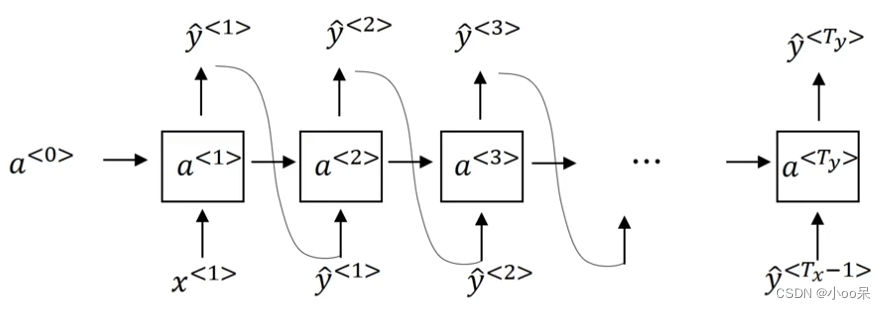

标准RNN预测过程

标准RNN预测过程