Standalone

- 升级软件

- 安装常用软件

- 关闭防火墙

- 修改主机名和IP地址

- 修改hosts配置文件

- 下载jdk和hadoop并配置环境变量

- 配置ssh免密钥登录

- 修改配置文件

- 初始化集群

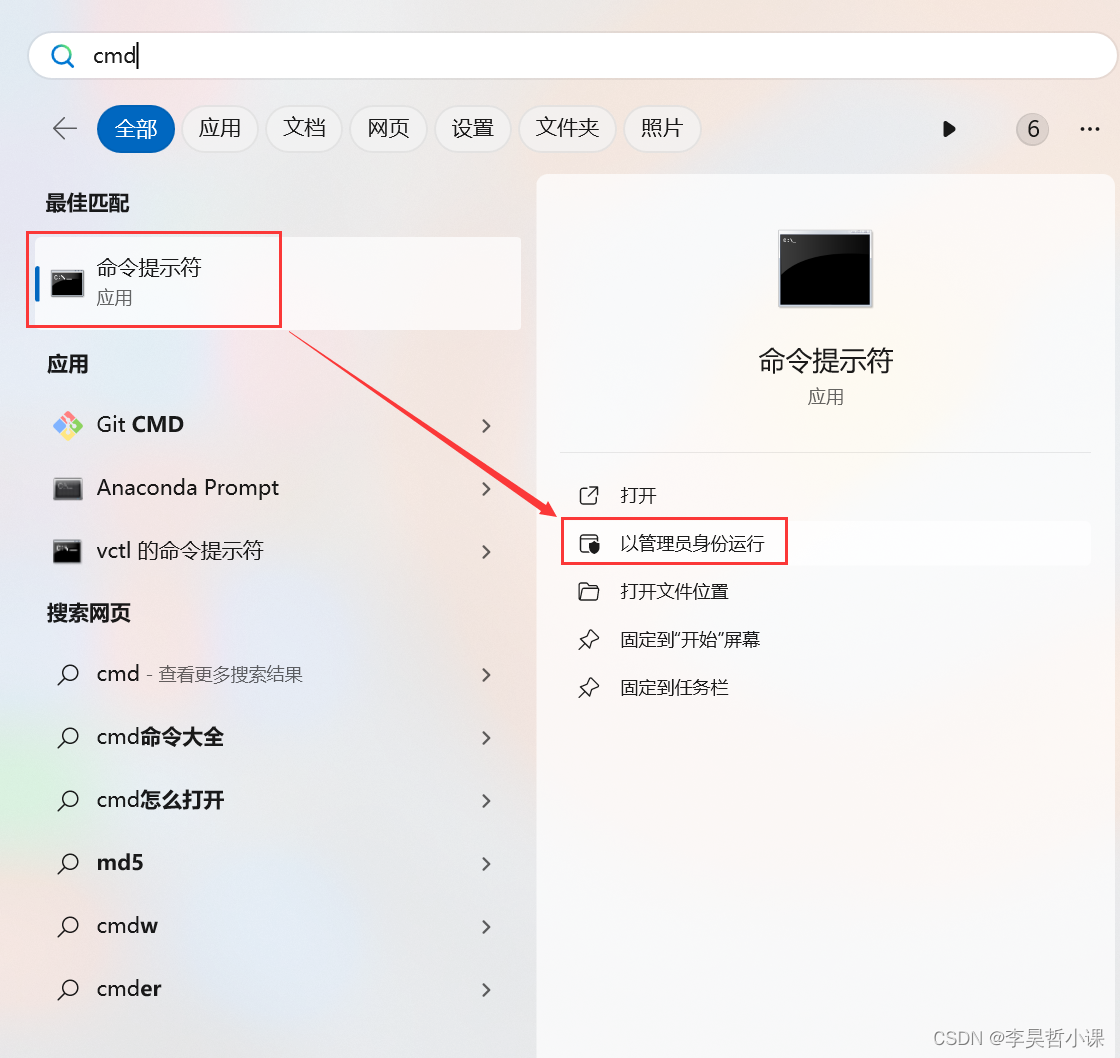

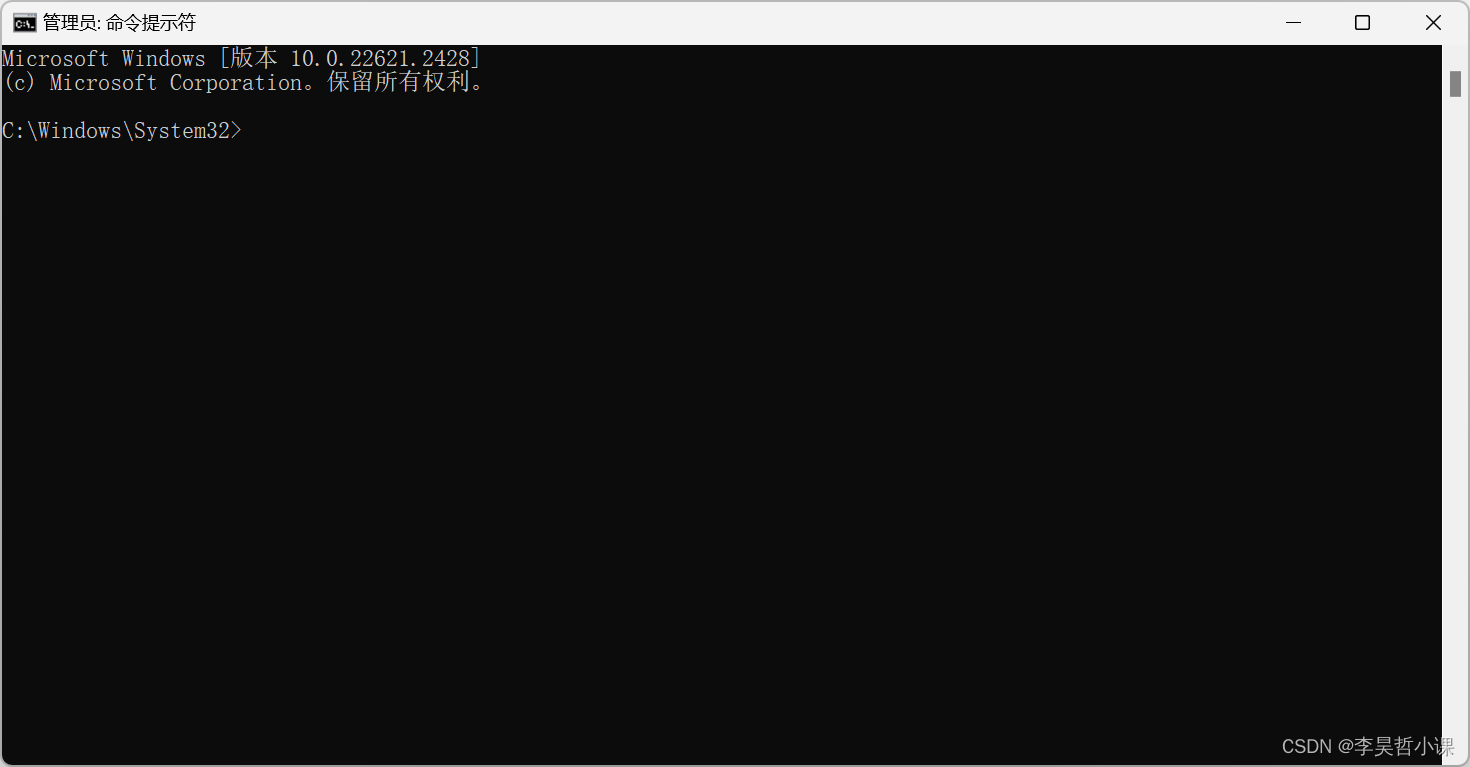

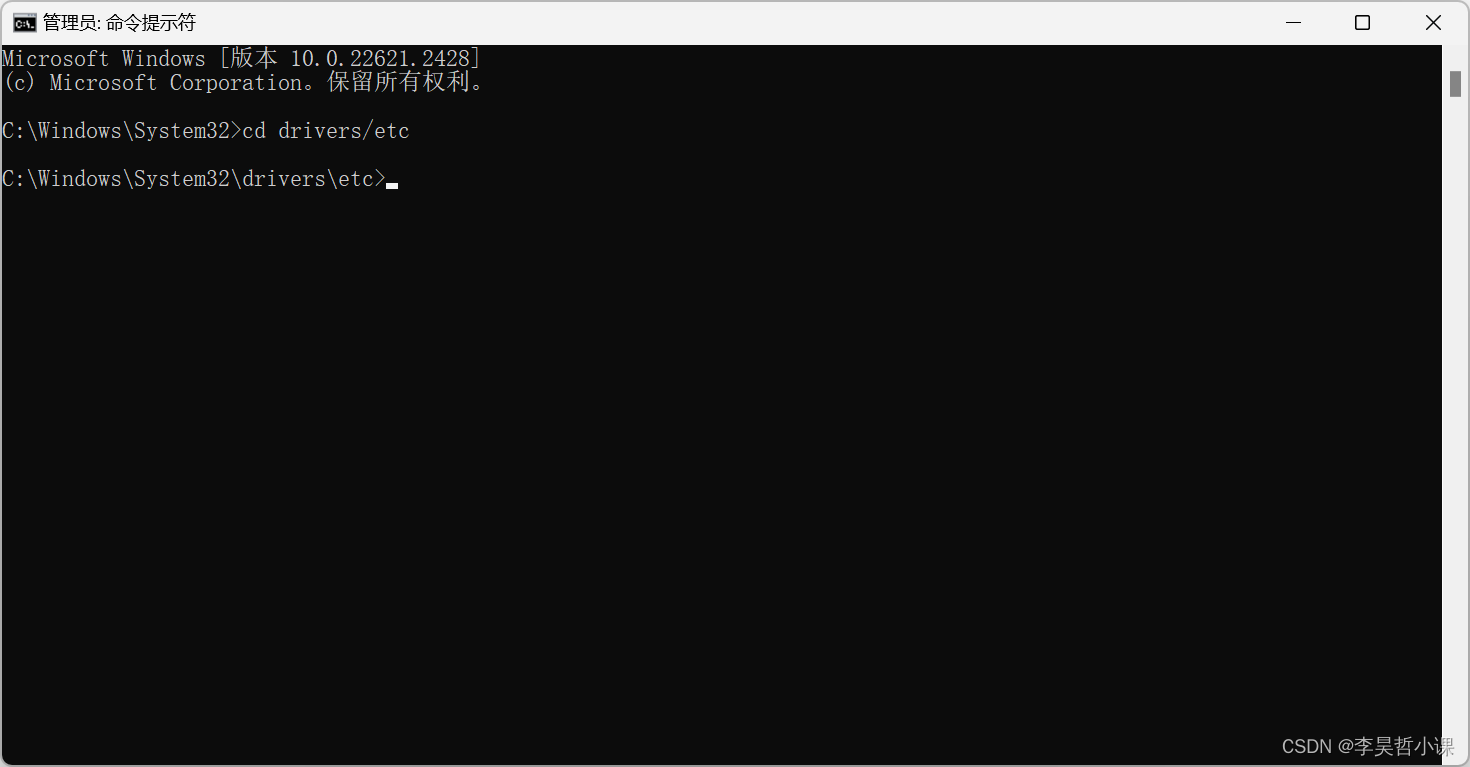

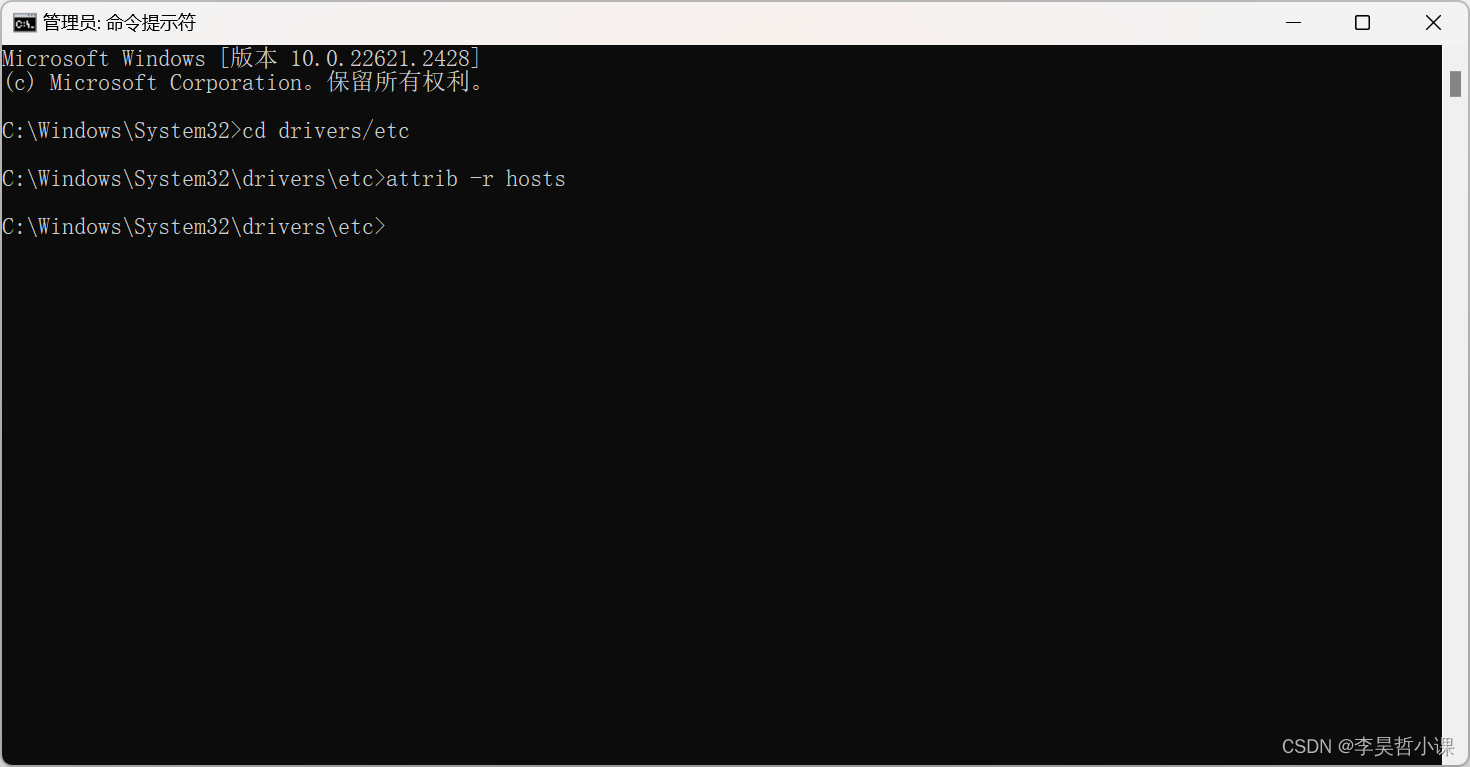

- windows修改hosts文件

- 测试

1、升级软件

bash

yum -y update2、安装常用软件

bash

yum -y install gcc gcc-c++ autoconf automake cmake make \

zlib zlib-devel openssl openssl-devel pcre-devel \

rsync openssh-server vim man zip unzip net-tools tcpdump lrzsz tar wget3、关闭防火墙

bash

sed -i 's/SELINUX=enforcing/SELINUX=disabled/g' /etc/selinux/config

setenforce 0

bash

systemctl stop firewalld

systemctl disable firewalld4、修改主机名和IP地址

bash

hostnamectl set-hostname hadoop

bash

vim /etc/sysconfig/network-scripts/ifcfg-ens32参考如下:

bash

TYPE=Ethernet

PROXY_METHOD=none

BROWSER_ONLY=no

BOOTPROTO=none

DEFROUTE=yes

IPV4_FAILURE_FATAL=no

IPV6INIT=yes

IPV6_AUTOCONF=yes

IPV6_DEFROUTE=yes

IPV6_FAILURE_FATAL=no

IPV6_ADDR_GEN_MODE=eui64

NAME=ens32

UUID=55e7ac28-39d7-4f24-b6bf-0f9fb40b7595

DEVICE=ens32

ONBOOT=yes

IPADDR=192.168.10.24

PREFIX=24

GATEWAY=192.168.10.2

DNS1=192.168.10.25、修改hosts配置文件

bash

vim /etc/hosts修改内容如下:

bash

192.168.10.24 hadoop重启系统

bash

reboot6、下载jdk和hadoop并配置环境变量

创建软件目录

bash

mkdir -p /opt/soft 进入软件目录

bash

cd /opt/soft下载 JDK

bash

下载 hadoop

bash

wget https://dlcdn.apache.org/hadoop/common/hadoop-3.3.6/hadoop-3.3.6.tar.gz解压 JDK 修改名称

bash

tar -zxvf jdk-8u411-linux-x64.tar.gz

bash

mv jdk1.8.0_411 jdk-8解压 hadoop 修改名称

bash

tar -zxvf hadoop-3.3.6.tar.gz

bash

mv hadoop-3.3.6 hadoop-3配置环境变量

bash

vim /etc/profile.d/my_env.sh编写以下内容:

bash

export JAVA_HOME=/opt/soft/jdk-8

export HDFS_NAMENODE_USER=root

export HDFS_SECONDARYNAMENODE_USER=root

export HDFS_DATANODE_USER=root

export HDFS_ZKFC_USER=root

export HDFS_JOURNALNODE_USER=root

export HADOOP_SHELL_EXECNAME=root

export YARN_RESOURCEMANAGER_USER=root

export YARN_NODEMANAGER_USER=root

export HADOOP_HOME=/opt/soft/hadoop-3

export HADOOP_INSTALL=$HADOOP_HOME

export HADOOP_MAPRED_HOME=$HADOOP_HOME

export HADOOP_COMMON_HOME=$HADOOP_HOME

export HADOOP_HDFS_HOME=$HADOOP_HOME

export YARN_HOME=$HADOOP_HOME

export HADOOP_CONF_DIR=$HADOOP_HOME/etc/hadoop

export JAVA_LIBRARY_PATH=$HADOOP_HOME/lib/native

export PATH=$PATH:$JAVA_HOME/bin:$HADOOP_HOME/bin:$HADOOP_HOME/sbin生成新的环境变量

bash

source /etc/profile7、配置ssh免密钥登录

创建本地秘钥并将公共秘钥写入认证文件

bash

ssh-keygen -t rsa -P '' -f ~/.ssh/id_rsa

bash

ssh-copy-id root@hadoop8、修改配置文件

core-site.xml

hdfs-site.xml

workers

mapred-site.xml

yarn-site.xml

hadoop-env.sh

文档末尾追加以下内容:

bash

export JAVA_HOME=/opt/soft/jdk-8

export HDFS_NAMENODE_USER=root

export HDFS_SECONDARYNAMENODE_USER=root

export HDFS_DATANODE_USER=root

export HDFS_ZKFC_USER=root

export HDFS_JOURNALNODE_USER=root

export HADOOP_SHELL_EXECNAME=root

export YARN_RESOURCEMANAGER_USER=root

export YARN_NODEMANAGER_USER=root

export JAVA_LIBRARY_PATH=$HADOOP_HOME/lib/nativecore-site.xml

xml

<?xml version="1.0" encoding="UTF-8"?>

<?xml-stylesheet type="text/xsl" href="configuration.xsl"?>

<configuration>

<property>

<name>fs.defaultFS</name>

<value>hdfs://hadoop:9000</value>

</property>

<property>

<name>hadoop.tmp.dir</name>

<value>/home/hadoop_data</value>

</property>

<property>

<name>hadoop.http.staticuser.user</name>

<value>root</value>

</property>

<property>

<name>dfs.permissions.enabled</name>

<value>false</value>

</property>

<property>

<name>hadoop.proxyuser.root.hosts</name>

<value>*</value>

</property>

<property>

<name>hadoop.proxyuser.root.groups</name>

<value>*</value>

</property>

</configuration>hdfs-site.xml

xml

<?xml version="1.0" encoding="UTF-8"?>

<?xml-stylesheet type="text/xsl" href="configuration.xsl"?>

<configuration>

<property>

<name>dfs.replication</name>

<value>1</value>

</property>

<property>

<name>dfs.namenode.secondary.http-address</name>

<value>hadoop:9868</value>

</property>

</configuration>workers

注意:

hadoop2.x中该文件名为slaves

hadoop3.x中该文件名为workers

bash

hadoopmapred-site.xml

xml

<?xml version="1.0"?>

<?xml-stylesheet type="text/xsl" href="configuration.xsl"?>

<configuration>

<property>

<name>mapreduce.framework.name</name>

<value>yarn</value>

</property>

<property>

<name>mapreduce.application.classpath</name>

<value>$HADOOP_MAPRED_HOME/share/hadoop/mapreduce/*:$HADOOP_MAPRED_HOME/share/hadoop/mapreduce/lib/*</value>

</property>

</configuration>yarn-site.xml

xml

<?xml version="1.0"?>

<configuration>

<property>

<name>yarn.nodemanager.aux-services</name>

<value>mapreduce_shuffle</value>

</property>

<property>

<name>yarn.nodemanager.env-whitelist</name>

<value>JAVA_HOME,HADOOP_COMMON_HOME,HADOOP_HDFS_HOME,HADOOP_CONF_DIR,CLASSPATH_PREPEND_DISTCACHE,HADOOP_YARN_HOME,HADOOP_HOME,PATH,LANG,TZ,HADOOP_MAPRED_HOME</value>

</property>

</configuration>9、初始化集群

bash

# 格式化文件系统

hdfs namenode -format

# 启动 NameNode SecondaryNameNode DataNode

start-dfs.sh

# 查看启动进程

jps

# 看到 DataNode SecondaryNameNode NameNode 三个进程代表启动成功

shell

# 启动 ResourceManager daemon 和 NodeManager

start-yarn.sh

# 看到 DataNode NodeManager SecondaryNameNode NameNode ResourceManager 五个进程代表启动成功重点提示:

bash

# 关机之前 依关闭服务

stop-yarn.sh

stop-dfs.sh

# 开机后 依次开启服务

start-dfs.sh

start-yarn.sh或者

bash

# 关机之前关闭服务

stop-all.sh

# 开机后开启服务

start-all.sh

bash

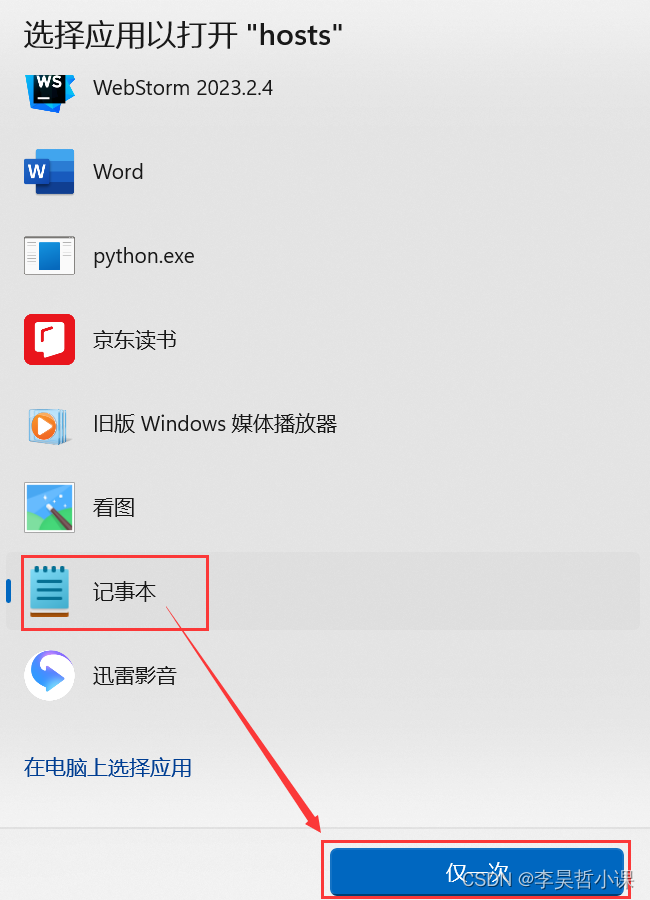

#jps 检查进程正常后开启胡哦关闭在再做其它操作10、修改windows下hosts文件

C:\Windows\System32\drivers\etc\hosts

追加以下内容:

bash

192.168.171.10 hadoopWindows11 注意 修改权限

-

开始搜索 cmd

找到命令头提示符 以管理身份运行

-

进入 C:\Windows\System32\drivers\etc 目录

cmdcd drivers/etc

-

打开 hosts 配置文件

cmdstart hosts

-

追加以下内容后保存

bash192.168.10.24 hadoop

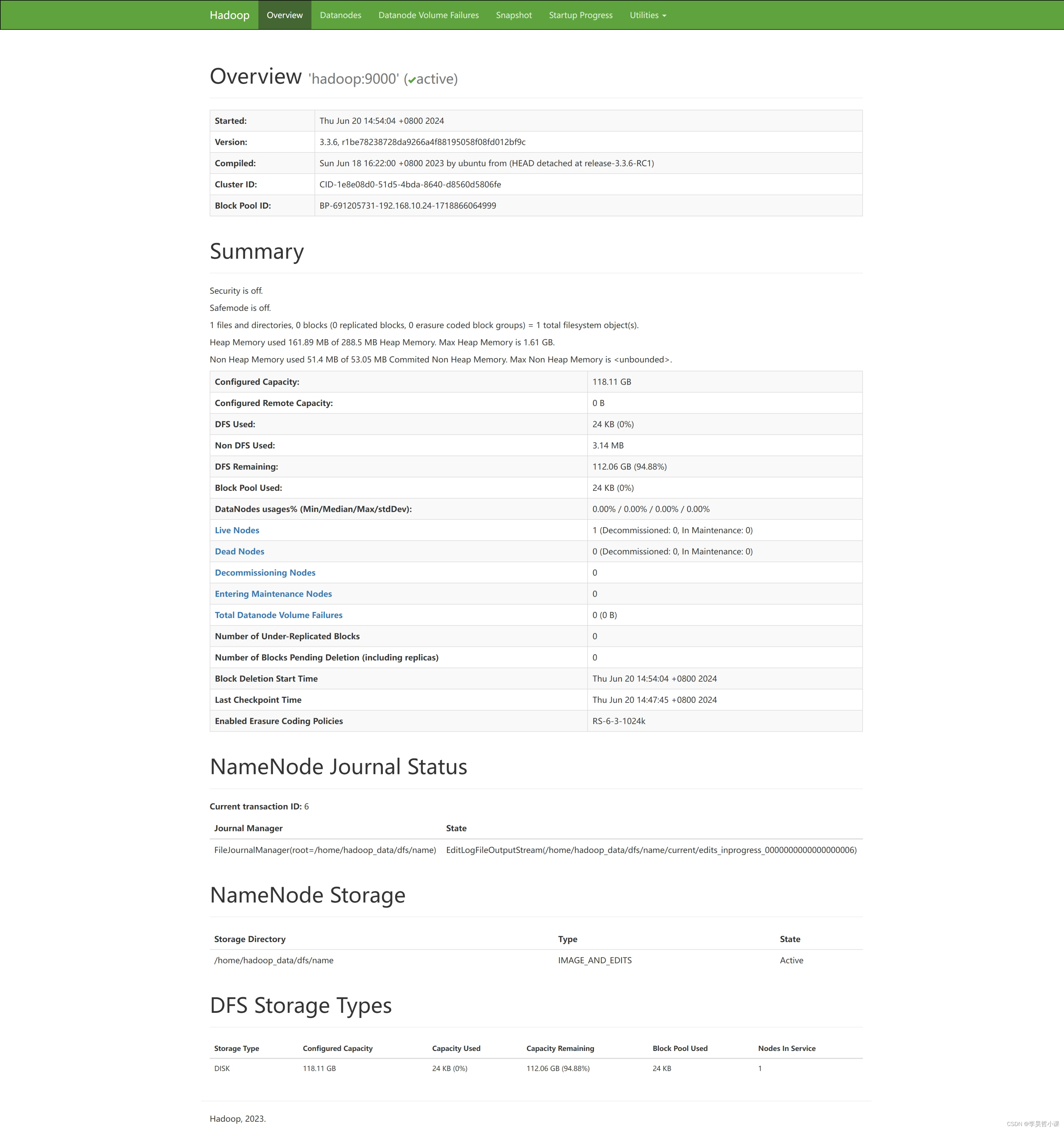

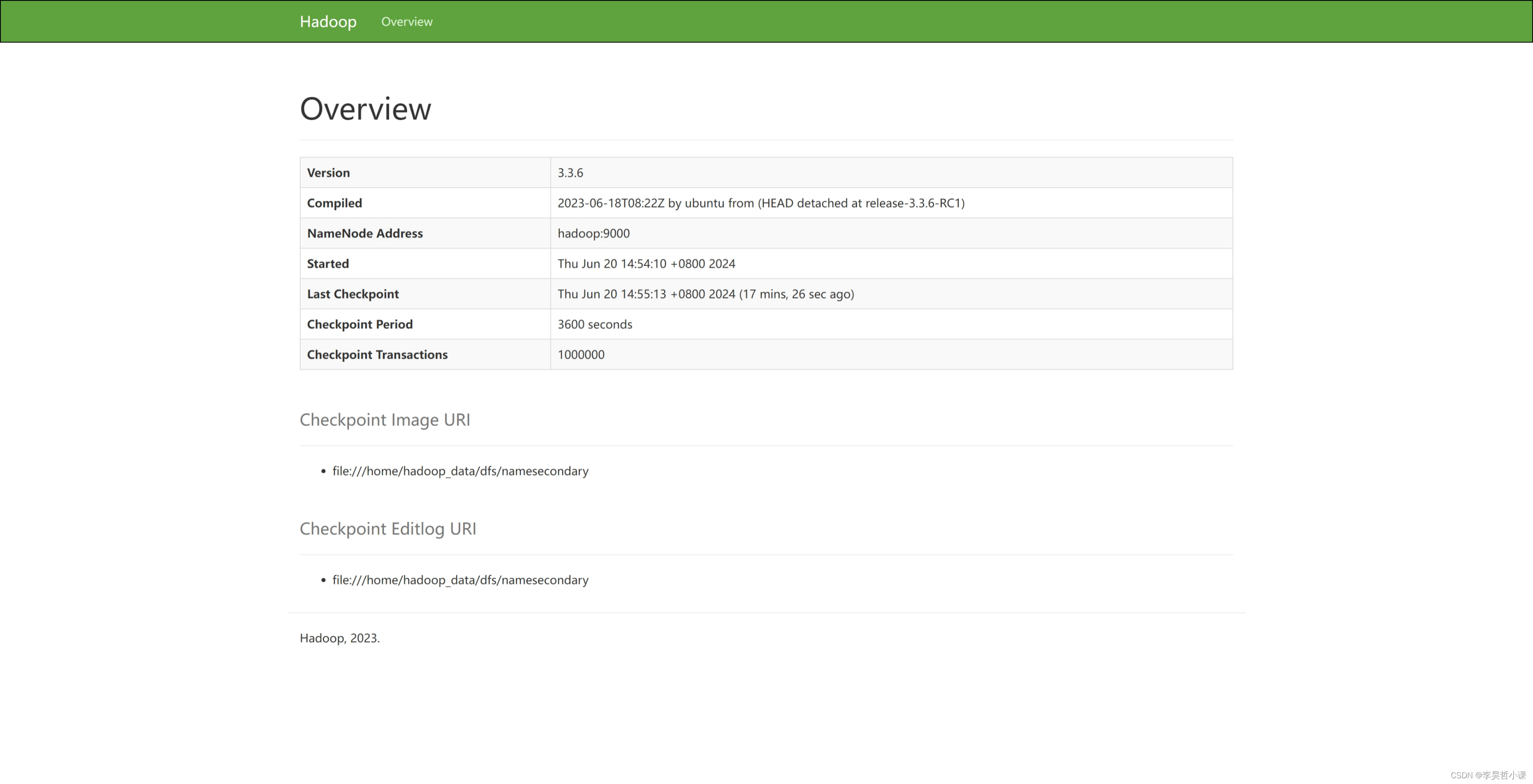

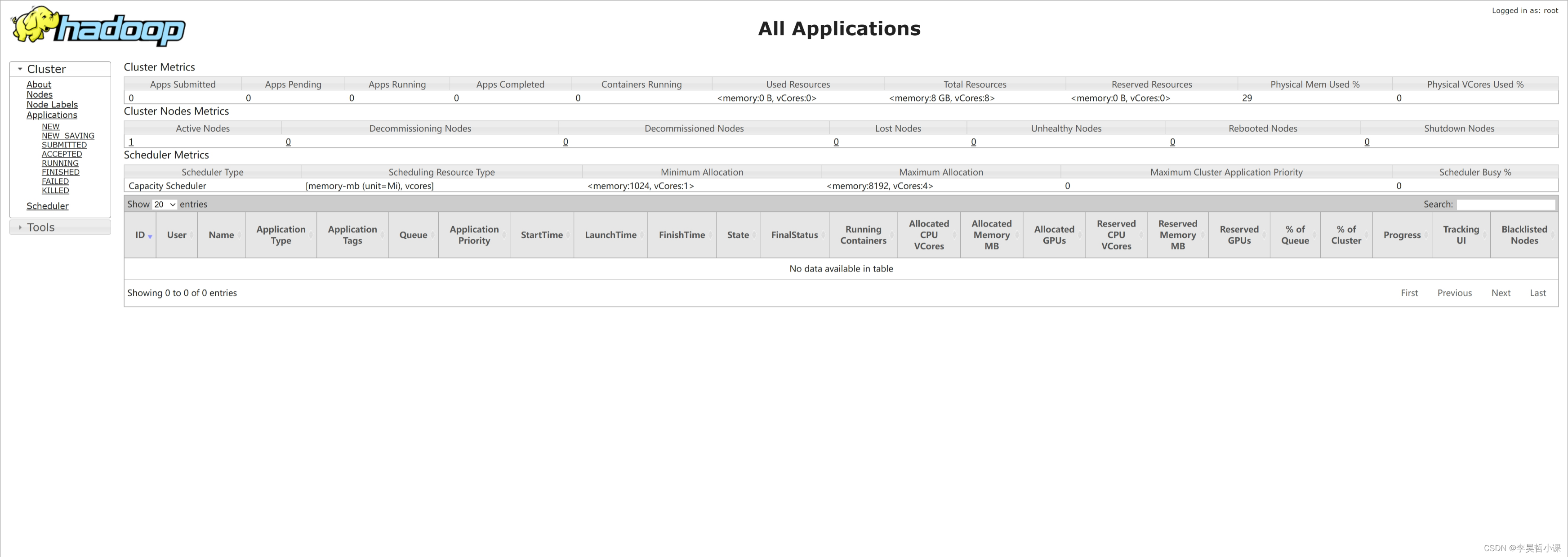

11、测试

11.1 浏览器访问hadoop

浏览器访问: http://hadoop:9870

浏览器访问:http://hadoop:9868/

浏览器访问:http://hadoop:8088

11.2 测试 hdfs

本地文件系统创建 测试文件 wcdata.txt

bash

vim wcdata.txt

bash

Spark HBaseHive Flink

Storm Hadoop HBase SparkFlinkHBase

StormHBase Hadoop Hive

FlinkHBase Flink

Hive StormHive Flink HadoopHBase

HiveHadoop Spark HBase StormHBase

Hadoop Hive FlinkHBase Flink Hive StormHive

Flink HadoopHBase Hive

Spark HBaseHive Flink

Storm Hadoop HBase SparkFlinkHBase

StormHBase Hadoop Hive

FlinkHBase Flink

Hive StormHive Flink HadoopHBase

HiveHadoop Spark HBase StormHBase

Hadoop Hive FlinkHBase Flink Hive StormHive

Flink HadoopHBase Hive

Spark HBaseHive Flink

Storm Hadoop HBase SparkFlinkHBase

StormHBase Hadoop Hive

FlinkHBase Flink

Hive StormHive Flink HadoopHBase

HiveHadoop Spark HBase StormHBase

Hadoop Hive FlinkHBase Flink Hive StormHive

Flink HadoopHBase Hive

HiveHadoop Spark HBase StormHBase

Hadoop Hive FlinkHBase Flink Hive StormHive

Flink HadoopHBase Hive

Spark HBaseHive Flink

Storm Hadoop HBase SparkFlinkHBase

StormHBase Hadoop Hive

FlinkHBase Flink

Hive StormHive Flink HadoopHBase

HiveHadoop Spark HBase StormHBase

Hadoop Hive FlinkHBase Flink Hive StormHive

Flink HadoopHBase Hive

Spark HBaseHive Flink

Storm Hadoop HBase SparkFlinkHBase

StormHBase Hadoop Hive

HiveHadoop Spark HBase StormHBase

Hadoop Hive FlinkHBase Flink Hive StormHive

Flink HadoopHBase Hive

Spark HBaseHive Flink

Storm Hadoop HBase SparkFlinkHBase

StormHBase Hadoop Hive

FlinkHBase Flink

Hive StormHive Flink HadoopHBase

HiveHadoop Spark HBase StormHBase

Hadoop Hive FlinkHBase Flink Hive StormHive

Flink HadoopHBase Hive

Spark HBaseHive Flink

Storm Hadoop HBase SparkFlinkHBase

StormHBase Hadoop Hive

Spark HBaseHive Flink

Storm Hadoop HBase SparkFlinkHBase

StormHBase Hadoop Hive

FlinkHBase Flink

Hive StormHive Flink HadoopHBase

HiveHadoop Spark HBase StormHBase

Hadoop Hive FlinkHBase Flink Hive StormHive

Flink HadoopHBase Hive

Spark HBaseHive Flink

Storm Hadoop HBase SparkFlinkHBase

StormHBase Hadoop Hive

FlinkHBase Flink

Hive StormHive Flink HadoopHBase

HiveHadoop Spark HBase StormHBase

Hadoop Hive FlinkHBase Flink Hive StormHive

Flink HadoopHBase Hive

HiveHadoop Spark HBase StormHBase

Hadoop Hive FlinkHBase Flink Hive StormHive

Flink HadoopHBase Hive

Spark HBaseHive Flink

Storm Hadoop HBase SparkFlinkHBase

StormHBase Hadoop Hive

FlinkHBase Flink

Hive StormHive Flink HadoopHBase

HiveHadoop Spark HBase StormHBase

Hadoop Hive FlinkHBase Flink Hive StormHive

Flink HadoopHBase Hive

Spark HBaseHive Flink

Storm Hadoop HBase SparkFlinkHBase

StormHBase Hadoop Hive

Spark HBaseHive Flink

Storm Hadoop HBase SparkFlinkHBase

StormHBase Hadoop Hive

FlinkHBase Flink

Hive StormHive Flink HadoopHBase

HiveHadoop Spark HBase StormHBase

Hadoop Hive FlinkHBase Flink Hive StormHive

Flink HadoopHBase Hive

Spark HBaseHive Flink

Storm Hadoop HBase SparkFlinkHBase

StormHBase Hadoop Hive

FlinkHBase Flink

Hive StormHive Flink HadoopHBase

HiveHadoop Spark HBase StormHBase

Hadoop Hive FlinkHBase Flink Hive StormHive

Flink HadoopHBase Hive

HiveHadoop Spark HBase StormHBase

Hadoop Hive FlinkHBase Flink Hive StormHive

Flink HadoopHBase Hive

Spark HBaseHive Flink

Storm Hadoop HBase SparkFlinkHBase

StormHBase Hadoop Hive

FlinkHBase Flink

Hive StormHive Flink HadoopHBase

HiveHadoop Spark HBase StormHBase

Hadoop Hive FlinkHBase Flink Hive StormHive

Flink HadoopHBase Hive

Spark HBaseHive Flink

Storm Hadoop HBase SparkFlinkHBase

StormHBase Hadoop Hive

Spark HBaseHive Flink

Storm Hadoop HBase SparkFlinkHBase

StormHBase Hadoop Hive

FlinkHBase Flink

Hive StormHive Flink HadoopHBase

HiveHadoop Spark HBase StormHBase

Hadoop Hive FlinkHBase Flink Hive StormHive

Flink HadoopHBase Hive

Spark HBaseHive Flink

Storm Hadoop HBase SparkFlinkHBase

StormHBase Hadoop Hive

FlinkHBase Flink

Hive StormHive Flink HadoopHBase

HiveHadoop Spark HBase StormHBase

Hadoop Hive FlinkHBase Flink Hive StormHive

Flink HadoopHBase Hive

Spark HBaseHive Flink

Storm Hadoop HBase SparkFlinkHBase

StormHBase Hadoop Hive

FlinkHBase Flink

Hive StormHive Flink HadoopHBase

HiveHadoop Spark HBase StormHBase

Hadoop Hive FlinkHBase Flink Hive StormHive

Flink HadoopHBase Hive

HiveHadoop Spark HBase StormHBase

Hadoop Hive FlinkHBase Flink Hive StormHive

Flink HadoopHBase Hive

Spark HBaseHive Flink

Storm Hadoop HBase SparkFlinkHBase

StormHBase Hadoop Hive

FlinkHBase Flink

Hive StormHive Flink HadoopHBase

HiveHadoop Spark HBase StormHBase

Hadoop Hive FlinkHBase Flink Hive StormHive

Flink HadoopHBase Hive

Spark HBaseHive Flink

Storm Hadoop HBase SparkFlinkHBase

StormHBase Hadoop Hive

HiveHadoop Spark HBase StormHBase

Hadoop Hive FlinkHBase Flink Hive StormHive

Flink HadoopHBase Hive

Spark HBaseHive Flink

Storm Hadoop HBase SparkFlinkHBase

StormHBase Hadoop Hive

FlinkHBase Flink

Hive StormHive Flink HadoopHBase

HiveHadoop Spark HBase StormHBase

Hadoop Hive FlinkHBase Flink Hive StormHive

Flink HadoopHBase Hive

Spark HBaseHive Flink

Storm Hadoop HBase SparkFlinkHBase

StormHBase Hadoop Hive

Spark HBaseHive Flink

Storm Hadoop HBase SparkFlinkHBase

StormHBase Hadoop Hive

FlinkHBase Flink

Hive StormHive Flink HadoopHBase

HiveHadoop Spark HBase StormHBase

Hadoop Hive FlinkHBase Flink Hive StormHive

Flink HadoopHBase Hive

Spark HBaseHive Flink

Storm Hadoop HBase SparkFlinkHBase

StormHBase Hadoop Hive

FlinkHBase Flink

Hive StormHive Flink HadoopHBase

HiveHadoop Spark HBase StormHBase

Hadoop Hive FlinkHBase Flink Hive StormHive

Flink HadoopHBase Hive

HiveHadoop Spark HBase StormHBase

Hadoop Hive FlinkHBase Flink Hive StormHive

Flink HadoopHBase Hive

Spark HBaseHive Flink

Storm Hadoop HBase SparkFlinkHBase

StormHBase Hadoop Hive

FlinkHBase Flink

Hive StormHive Flink HadoopHBase

HiveHadoop Spark HBase StormHBase

Hadoop Hive FlinkHBase Flink Hive StormHive

Flink HadoopHBase Hive

Spark HBaseHive Flink

Storm Hadoop HBase SparkFlinkHBase

StormHBase Hadoop Hive

Spark HBaseHive Flink

Storm Hadoop HBase SparkFlinkHBase

StormHBase Hadoop Hive

FlinkHBase Flink

Hive StormHive Flink HadoopHBase

HiveHadoop Spark HBase StormHBase

Hadoop Hive FlinkHBase Flink Hive StormHive

Flink HadoopHBase Hive

Spark HBaseHive Flink

Storm Hadoop HBase SparkFlinkHBase

StormHBase Hadoop Hive

FlinkHBase Flink

Hive StormHive Flink HadoopHBase

HiveHadoop Spark HBase StormHBase

Hadoop Hive FlinkHBase Flink Hive StormHive

Flink HadoopHBase Hive

HiveHadoop Spark HBase StormHBase

Hadoop Hive FlinkHBase Flink Hive StormHive

Flink HadoopHBase Hive

Spark HBaseHive Flink

Storm Hadoop HBase SparkFlinkHBase

StormHBase Hadoop Hive

FlinkHBase Flink

Hive StormHive Flink HadoopHBase

HiveHadoop Spark HBase StormHBase

Hadoop Hive FlinkHBase Flink Hive StormHive

Flink HadoopHBase Hive

Spark HBaseHive Flink

Storm Hadoop HBase SparkFlinkHBase

StormHBase Hadoop Hive在 HDFS 上创建目录 /wordcount/input

bash

hdfs dfs -mkdir -p /wordcount/input查看 HDFS 目录结构

bash

hdfs dfs -ls /

bash

hdfs dfs -ls /wordcount

bash

hdfs dfs -ls /wordcount/input上传本地测试文件 wcdata.txt 到 HDFS 上 /wordcount/input

bash

hdfs dfs -put wcdata.txt /wordcount/input检查文件是否上传成功

bash

hdfs dfs -ls /wordcount/input

bas

hdfs dfs -cat /wordcount/input/wcdata.txt11.3 测试 mapreduce

计算 PI 的值

bash

hadoop jar $HADOOP_HOME/share/hadoop/mapreduce/hadoop-mapreduce-examples-3.3.6.jar pi 10 10单词统计

bash

hadoop jar $HADOOP_HOME/share/hadoop/mapreduce/hadoop-mapreduce-examples-3.3.6.jar wordcount /wordcount/input/wcdata.txt /wordcount/result

bash

hdfs dfs -ls /wordcount/result

bash

hdfs dfs -cat /wordcount/result/part-r-00000dcount

```bash

hdfs dfs -ls /wordcount/input上传本地测试文件 wcdata.txt 到 HDFS 上 /wordcount/input

bash

hdfs dfs -put wcdata.txt /wordcount/input检查文件是否上传成功

bash

hdfs dfs -ls /wordcount/input

bas

hdfs dfs -cat /wordcount/input/wcdata.txt11.3 测试 mapreduce

计算 PI 的值

bash

hadoop jar $HADOOP_HOME/share/hadoop/mapreduce/hadoop-mapreduce-examples-3.3.6.jar pi 10 10单词统计

bash

hadoop jar $HADOOP_HOME/share/hadoop/mapreduce/hadoop-mapreduce-examples-3.3.6.jar wordcount /wordcount/input/wcdata.txt /wordcount/result

bash

hdfs dfs -ls /wordcount/result

bash

hdfs dfs -cat /wordcount/result/part-r-00000