Kafka简介

Kafka是由Apache软件基金会开发的一个开源流处理平台,由Scala和Java编写。Kafka是一种高吞吐量的分布式发布订阅消息系统,它可以处理消费者在网站中的所有动作流数据。 这种动作(网页浏览,搜索和其他用户的行动)是在现代网络上的许多社会功能的一个关键因素。 这些数据通常是由于吞吐量的要求而通过处理日志和日志聚合来解决。 对于像Hadoop一样的日志数据和离线分析系统,但又要求实时处理的限制,这是一个可行的解决方案。Kafka的目的是通过Hadoop的并行加载机制来统一线上和离线的消息处理,也是为了通过集群来提供实时的消息。

一丶主要特性

- Kafka [1]是一种高吞吐量 [2]的分布式发布订阅消息系统,有如下特性:

- 通过O(1)的磁盘数据结构提供消息的持久化,这种结构对于即使数以TB的消息存储也能够保持长时间的稳定性能。

- 高吞吐量 [2]:即使是非常普通的硬件Kafka也可以支持每秒数百万 [2]的消息。

- 支持通过Kafka服务器和消费机集群来分区消息。

- 支持Hadoop并行数据加载

二丶Kafka场景应用

日志收集:一个公司可以用Kafka可以收集各种服务的log,通过kafka以统一接口服务的方式开放给各种consumer,例如hadoop、Hbase、Solr等。

消息系统:解耦和生产者和消费者、缓存消息等。

用户活动跟踪:Kafka经常被用来记录web用户或者app用户的各种活动,如浏览网页、搜索、点击等活动,这些活动信息被各个服务器发布到kafka的topic中,然后订阅者通过订阅这些topic来做实时的监控分析,或者装载到hadoop、数据仓库中做离线分析和挖掘。

运营指标:Kafka也经常用来记录运营监控数据。包括收集各种分布式应用的数据,生产各种操作的集中反馈,比如报警和报告。

流式处理:比如spark streaming和storm事件源

三丶Kafka场景应用

- Consumergroup:各个consumer可以组成一个组,每个消息只能被组中的一个consumer消费,如果一个消息可以被多个consumer消费的话,那么这些consumer必须在不同的组。

- 消息状态:在Kafka中,消息的状态被保存在consumer中,broker不会关心哪个消息被消费了被谁消费了,只记录一个offset值(指向partition中下一个要被消费的消息位置),这就意味着如果consumer处理不好的话,broker上的一个消息可能会被消费多次。

- 消息持久化:Kafka中会把消息持久化到本地文件系统中,并且保持极高的效率。

- 消息有效期:Kafka会长久保留其中的消息,以便consumer可以多次消费,当然其中很多细节是可配置的。

- 批量发送:Kafka支持以消息集合为单位进行批量发送,以提高push效率。

- push-and-pull :Kafka中的Producer和consumer采用的是push-and-pull模式,即Producer只管向broker push消息,consumer只管从broker pull消息,两者对消息的生产和消费是异步的。

- Kafka集群中broker之间的关系:不是主从关系,各个broker在集群中地位一样,我们可以随意的增加或删除任何一个broker节点。

- 负载均衡方面: Kafka提供了一个 metadata API来管理broker之间的负载(对Kafka0.8.x而言,对于0.7.x主要靠zookeeper来实现负载均衡)。

- 同步异步:Producer采用异步push方式,极大提高Kafka系统的吞吐率(可以通过参数控制是采用同步还是异步方式)。

- 分区机制partition:Kafka的broker端支持消息分区,Producer可以决定把消息发到哪个分区,在一个分区中消息的顺序就是Producer发送消息的顺序,一个主题中可以有多个分区,具体分区的数量是可配置的。分区的意义很重大,后面的内容会逐渐体现。

- 离线数据装载:Kafka由于对可拓展的数据持久化的支持,它也非常适合向Hadoop或者数据仓库中进行数据装载。

- 插件支持:现在不少活跃的社区已经开发出不少插件来拓展Kafka的功能,如用来配合Storm、Hadoop、flume相关的插件。

四丶Kafka的安装应用

1.kafka的安装下载

网盘下载:链接:https://pan.baidu.com/s/1zv_s7K7Rav9cZsxgNMmz1w?pwd=DMDM

提取码:DMDM

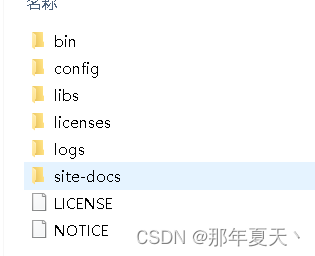

2.解压即安装,并在当前解压路径下创建logs目录

3.修改配置在*\config目录下

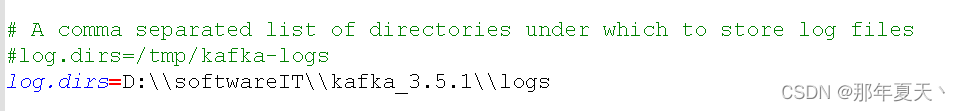

注意反双斜杠

log.dirs=D:\\bigdata\\kafka\\2.12-3.5.1\\logs

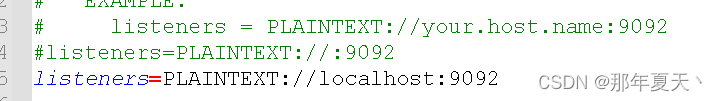

4**.** 修改 listeners 参数值,这里我是改为本地

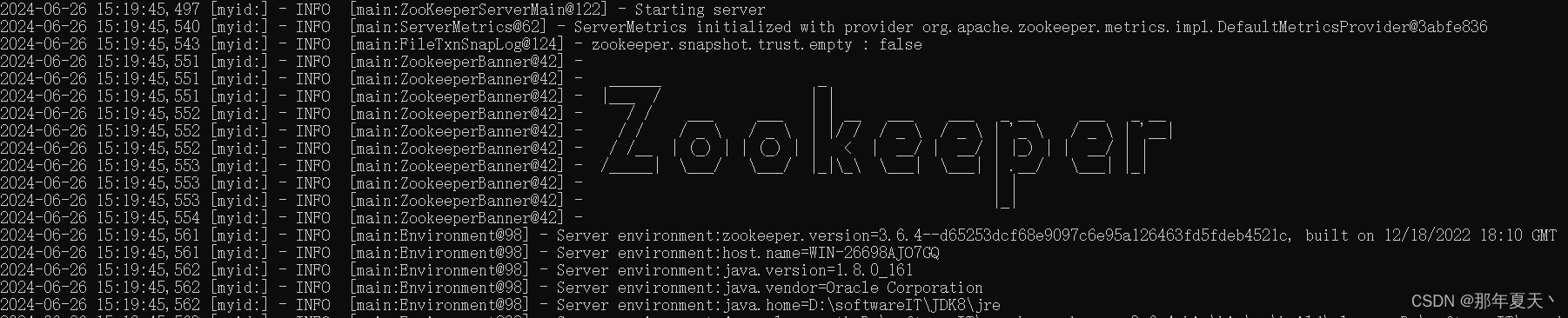

5**.启动zookeeper,因为kafka基于zookeeper运行**

打开win+r,cmd,输入:zkServer显示:

6**.启动kafka,在kafka的解压目录输入以下命令**

.\bin\windows\kafka-server-start.bat .\config\server.properties显示:

五丶Kafka的相关命令操作

**1.**创建topics,打开前面两个窗口的前提下

1.D:\softwareIT\kafka_3.5.1\bin\windows 目录下cmd 打开黑窗口

2.输入

kafka-topics.bat --create --bootstrap-server localhost:9092 --replication-factor 1 --partitions 1 --topic test**2.**创建topics,打开前面两个窗口的前提下

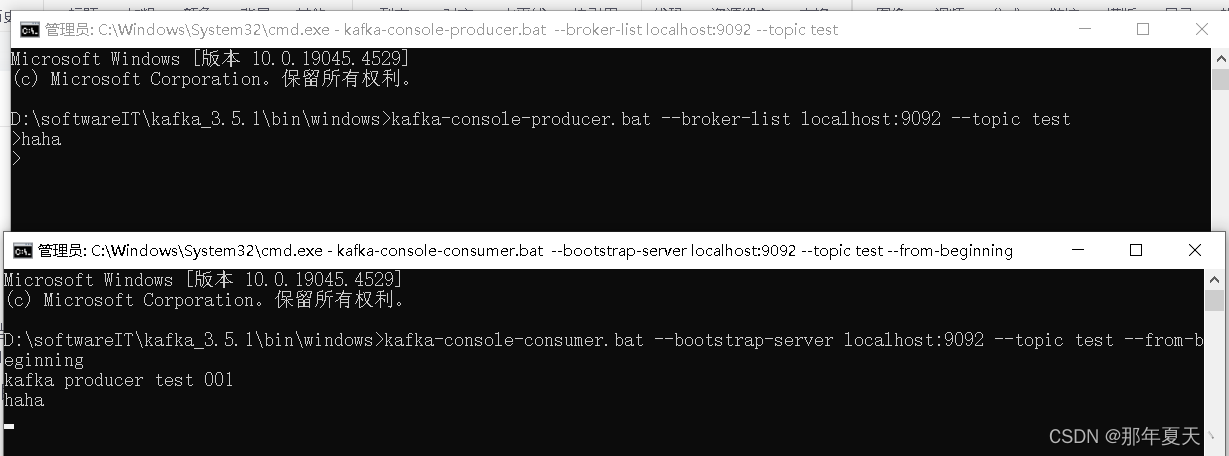

kafka-topics.bat --bootstrap-server localhost:9092 --list3.同样在windows目录下打开黑窗口(生产者)

kafka-console-producer.bat --broker-list localhost:9092 --topic test

4.同样在windows目录下打开黑窗口(消费者)

kafka-console-consumer.bat --bootstrap-server localhost:9092 --topic test --from-beginning

这里可以看到消费者这里haha打印了。

结尾:安装到这儿介绍就完了,喜欢的朋友点个赞吧,下一章将介绍springboot+kafka的基础应用