-

首先yowov2是一款简单且实时的时空动作检测方案,fastreid是行人重识别(身份识别)

- yowov2介绍链接直达

- fastreid链接直达

- 为时空动作检测任务设计实时框架仍然是一个挑战。YOWOv2 提出了一种新颖的实时动作检测框架,利用三维骨干和二维骨干进行准确的动作检测。经过改进,YOWOv2 明显优于 YOWO,并且仍然可以保持实时检测。YOWOv2 在数据集 UCF101-24 上以超过 20 FPS 的速度实现了 87.0% 的视频帧 mAP 和 52.8% 的全视频 mAP。在数据集 AVA 上,YOWOv2 在提速 20 FPS 的同时实现了 21.7% 的视频帧 mAP。

-

引入身份识别可以精确记录某个人的动作信息

-

效果图

-

ui界面 含有摄像头和视频检测, 同时右侧可以选择模型, 摄像头, 和是否使用CUDA

-

-

动作识别预览(弯腰和站立, 动作很多(摔倒动作,骑马动作都有, 如果需要自己训练动作,则自己制作ava数据集进行模型训练))

-

身份识别预览(左下角)身份识别 FastReID利用预训练的深度卷积神经网络(如ResNet、MobileNet等)作为基础模型,通过特征提取网络来提取图像中的行人特征。可以用来描述行人的外观特征、姿势等信息。并通过计算余弦相似度来度量在特征空间中度量行人之间的相似度。

-

-

-

详细实现:

-

首先创建YOWOv2环境,分为虚拟环境和Anaconda环境两种

-

先讲使用虚拟环境的,linux上主环境的是 python3.8,

1 创建虚拟环境, 当前文件夹就会有一个yowov2-virtual的文件夹

pythonpython3 -m vene yowov2-virtual2, 激活环境

pythonsource yowov2-virtual/bin/activate3, 安装环境(pytorch1.10.1和cuda10.2) (这个因为是外网的,需要梯子(不然很慢))

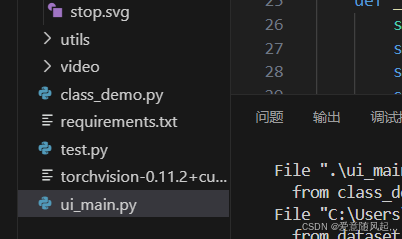

pythonpip install torch==1.10.1+cu102 torchvision==0.11.2+cu102 -f https://download.pytorch.org/whl/cu102/torch_stable.html- 进入项目安装依赖

pythonpip install -r requirements.txt如果使用anaconda, 则

- 创建anaconda环境

pythonconda create -n yowov2-fastreid python==3.8- 然后激活环境(如果activate 不行, 则试试source)

pythonconda activate yowov2-fastreid- 与上面第三步一致 之后再运行ui_main.py 启动ui界面

-

-

详细使用信息

YOWOv2(yowov2)动作识别+Fastreid身份识别 详细安装与实现

鳄鱼的眼药水2024-07-14 21:05

相关推荐

风象南5 小时前

我把大脑开源给了AIJohny_Zhao7 小时前

OpenClaw安装部署教程飞哥数智坊8 小时前

我帮你读《一人公司(OPC)发展研究》冬奇Lab11 小时前

OpenClaw 源码精读(3):Agent 执行引擎——AI 如何「思考」并与真实世界交互?没事勤琢磨13 小时前

如何让 OpenClaw 控制使用浏览器:让 AI 像真人一样操控你的浏览器用户51914958484513 小时前

CrushFTP 认证绕过漏洞利用工具 (CVE-2024-4040)牛马摆渡人52813 小时前

OpenClaw实战--Day1: 本地化前端小豆13 小时前

玩转 OpenClaw:打造你的私有 AI 助手网关BugShare13 小时前

写一个你自己的Agent Skills机器之心14 小时前

英伟达护城河被AI攻破,字节清华CUDA Agent,让人人能搓CUDA内核