今天, 全网都知道 OpenAI 发现货了 !

GPT-4o mini 取代 GPT 3.5,从此坐上正主之位。

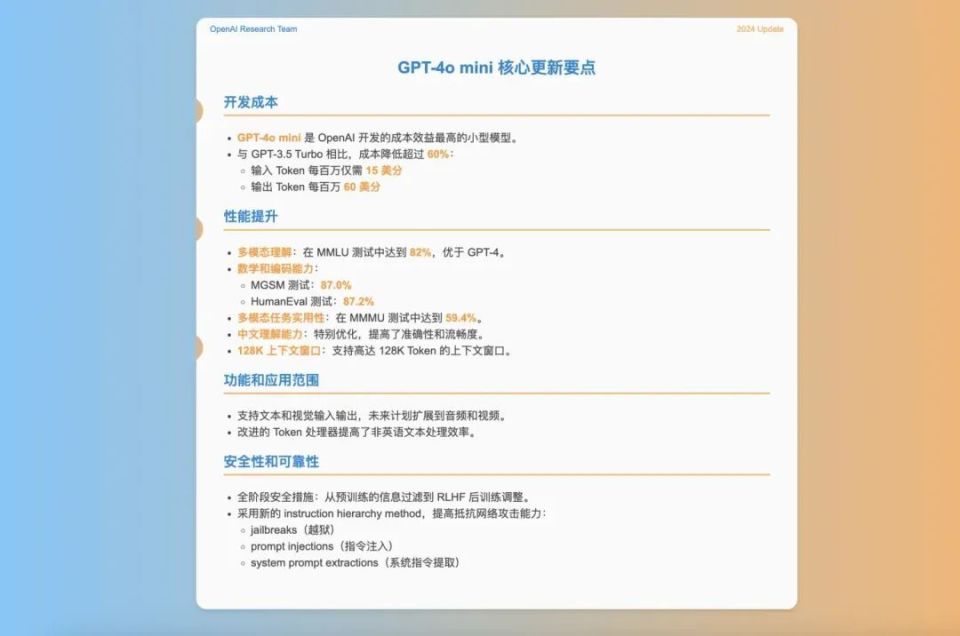

从官网信息来看,OpenAI 最新推出的 GPT-4o mini 重新定义了 AI 成本效益的标准,其性能优于前代模型 GPT-3.5 Turbo,且成本大幅降低。这款模型不仅在多模态评估中取得了显著成绩,而且在未来的图像、视频和音频处理中展现出巨大潜力。

-

卓越的性价比:GPT-4o mini 在 MMLU 中以 82% 的得分领先市场,成本仅为每百万输入 Token 0.15 美元,输出 Token 0.6 美元。

-

强大的多模态能力:在 MMMU 中得分 59.4%,显示了其处理文本、图像、甚至未来视频和音频的能力。

-

128k 上下文窗口:优化了长篇文档的处理,为后续详细的功能测评提供了理想的技术基础。

新手如何使用GPT4o mini?

能力:Claude3.5>GPT4o>Claude3>GPT4.0 turbo > GPT3.5 turbo > GPT3.5

为了方便,我整理了放在下边,有需要的自取~

AiChat:智能办公助手

接下来的测评将深入探索这些特点,以及 GPT-4o mini 在实际应用中的表现如何。

但遗憾的是现在对话窗口不支持图片/文件上传 ,对于普通用户来讲暂时无法测试和体验多模态能力。仅支持文本(且大幅改善了非英文的效率)和视觉的是 GPT-4o mini 的 API,未来还将支持文本、图像、视频和音频输入和输出。

数学推理

先来看看最近火爆的"比大小"题目,这可难倒不少大模型。对于 GPT-4o mini,我直接连续用中英文提问 3 个问题,很遗憾这三问它都答错了,原本想着着新发的模型应该不错吧,谁知也不太聪明!GPT-4o mini 的"数学推理"能力同样有待加强。

然而,优于GPT-4o的,OpenAI提到,此次发布的新模型GPT-4o mini"Faster for everyday tasks"。

它的响应速度明显快于GPT-4o,几乎无需等待。从正式开放到当前全球用户的使用反馈来看,GPT-4o mini的"快"毋庸置疑,但实际使用体验上(包括指令执行完成度等)还差些火候。

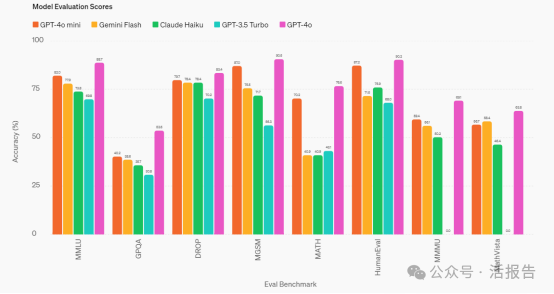

根据OpenAI官方展示的数据,GPT-4o mini的性能表现出很强的竞争力,其在文本智能和推理基准、数学推理、多模态推理评估方面均优于其竞品Gemini Flash和Claude Haiku。

来源:OpenAI官网

"小模型"或将流行,接下来还有谁?

在7月19日凌晨,紧随OpenAI,Mistral Al发布了12B的小模型,该产品是同英伟达合作开发,上下文长度为128K,与OpenAI正面对战。

按照计划,Meta也将于7月23日发布400B参数的Llama 3模型,并承诺将带来新的功能,如多模态能力、多语种对话、更长的上下文窗口以及更强的整体性能。

在国内,阿里云Qwen于7月16日推出了类似于GPT-4o的更适于小端应用的语音助手。而商汤早前已经推出首个实时交互模型"日日新5o",科大讯飞的星火大模型交互性能也已对标GPT-4o。

可见,大模型公司的较量没有终点。同时,小端侧模型或将成为下一个大模型热门赛道。

OpenAI此次采用了抢先发布的营销策略,在推出小模型GPT-4o mini的同时,也进一步唤起了人们对GPT-5的期待。

据 OpenAI CEO Sam Altman透露,GPT-4o的语音模式将在本月晚些时候推出。

小端交互模型来了,AI生活化还会远吗?