近期有十几个学生在面试大模型产品经理(薪资还可以,详情见下图),根据他们面试(包括1-4面)中出现高频大于3次的问题汇总如下,一共32道题目(有答案)。

29.讲讲T5和Bart的区别,讲讲Bart的DAE任务

T5(Text-to-Text Transfer Transformer)和Bart(Bidirectional and Auto-Regressive Transformer)都是基于Transformer的seq2seq模型,可以用于多种自然语言处理的任务,如文本生成、文本摘要、机器翻译、问答等。

它们的主要区别在于:

T5是一种基于Transformer的通用文本生成模型。T5的训练目标是将不同的自然语言处理(NLP)任务统一为文本到文本的转换任务。

它采用了编码器-解码器结构,通过输入一个自然语言文本,输出另一个相关的自然语言文本,可以应用于机器翻译、摘要生成、问题回答等多个NLP任务。

Bart是建立在T5模型基础上的一个变种,它专注于生成式任务。

Bart模型使用了自回归解码器,通过训练一个自编码器来重构原始文本,同时采用了标准的语言模型预训练目标,从而使得生成的文本更加流畅和连贯。Bart的主要应用领域包括文本生成、摘要生成、对话系统等。

在任务类型上,T5更加通用 ,适用于多种NLP任务的文本转换,而Bart则更加专注于生成式任务,并且在生成文本的质量和连贯性上有所优化。

关于Bart的DAE(Denoising AutoEncoder)任务,它是Bart模型的一种预训练目标。

Bart的DAE任务是一种利用自编码器来学习语言表示的方法,其基本思想是将一个真实的数据(如图像、文本、音频等)通过逐步添加高斯噪声的方式,转化为一个服从标准正态分布的随机变量。

然后,通过一个反向的去噪过程,从随机变量恢复出原始的数据。DAE任务要求模型从输入的有噪声的文本中恢复原始的无噪声文本。

通过在训练过程中向输入文本中添加噪声,并要求模型重建无噪声的文本,Bart可以学习到更好的文本表示和重构能力,从而提高生成文本的质量和准确性。

Bart在DAE任务中使用了以下几种噪声类型:

Token Masking: 随机将一些token替换为特殊的[MASK]符号。Token Deletion: 随机删除一些token。

Text Infilling: 随机将一段连续的token替换为一个[MASK]符号。Sentence Permutation: 随机打乱句子的顺序。Document Rotation: 随机选择一个token作为文档的开头。

30.讲讲Bart和Bert的区别

Bart和Bert是两个不同的预训练模型,它们之间的区别如下:

Bart是一种基于Transformer的生成式预训练模型,主要应用于文本生成、摘要生成、对话系统等任务。

Bart采用了自回归解码器,通过自编码器预训练目标来重构输入文本,从而生成流畅、连贯的文本。

Bert(Bidirectional Encoder Representations from Transformers)是一种双向的预训练模型,用于生成文本的上下文表示。

与Bart不同,Bert采用了双向的Transformer编码器,通过将上下文的信息融合到表示中,提供了更全面的语境理解能力。Bert主要应用于词嵌入、文本分类、命名实体识别等任务。

**预训练任务:**Bert使用了两种预训练任务,一种是无监督的掩码语言模型(Masked Language Model,MLM),另一种是有监督的下一个句子预测(Next Sentence Prediction,NSP)。

Bart使用了一种去噪自编码(Denoising Auto-Encoder,DAE)的预训练任务,即在输入序列中加入不同类型的噪声,然后在输出序列中还原原始序列。

预训练数据:Bert使用了一个干净的大规模英文预料BookCorpus和Wikipedia,包含了约3300万个句子和2500万个词汇。

Bart使用了一个小规模的英文预料XLM-R,包含了约1600万个句子和500万个词汇。

**模型结构:**Bert由Transformer的Encoder部分堆叠组成,具有双向的上下文表示能力。

Bart由Transformer的Encoder和Decoder部分组成,具有自回归的生成能力。Bart相比于同等大小的Bert模型多了大约10%的参数。

总体上说,Bart侧重于生成式任务和文本生成,而Bert侧重于上下文表示和语境理解。

它们在模型结构和应用场景上存在一定的差异。

31.对比学习负样本是否重要?负样本构造成本过高应该怎么解决?

负样本是指在机器学习或深度学习的任务中,与目标类别不匹配或不相关的数据样本。

负样本的作用是帮助模型学习到区分不同类别的特征,提高模型的泛化能力和判别能力。负样本的选择和采样方法会影响模型的性能和效率。

例如,在目标检测任务中,数据集中部分图片没有出现目标,这些图片通常被称为负样本。在文本分类任务中,与某个类别不属于同一主题或情感的文本通常被称为负样本。

对比学习负样本是指与锚点(参考数据点)不相似或不相关的数据点,它们用于训练对比学习模型,使模型能够学习到区分不同数据点的特征表示。

对比学习中负样本的重要性取决于具体的任务和数据。负样本可以帮助模型学习到样本之间的区分度,从而提高模型的性能和泛化能力。

然而,负样本的构造成本可能会较高,特别是在一些领域和任务中。对比学习负样本的重要性在于:

1)它们可以提高模型的泛化能力和鲁棒性,因为它们可以使模型在面对多样化和复杂的数据时仍然能够保持较高的性能。

2)它们可以提高模型的判别能力和表达能力,因为它们可以使模型在学习到相似数据点之间的细微差异的同时,也能够忽略不相似数据点之间的无关信息。

3)它们可以提高模型的效率和效果,因为它们可以使模型在训练过程中更加专注于重要和有用的数据点,从而减少无效和冗余的计算。

对比学习负样本的构造成本过高是一个常见的问题,因为它们需要从大量的数据中进行筛选和采样,而且还要考虑到难度和多样性等因素。

为了解决这个问题,有以下几种可能的方法:

**1) 降低负样本的构造成本:**通过设计更高效的负样本生成算法或采样策略,减少负样本的构造成本。

例如,可以利用数据增强技术生成合成的负样本,或者使用近似采样方法选择与正样本相似但不相同的负样本。

**2)确定关键负样本:**根据具体任务的特点,可以重点关注一些关键的负样本,而不是对所有负样本进行详细的构造。

这样可以降低构造成本,同时仍然能够有效训练模型。

**3)迁移学习和预训练模型:**利用预训练模型或迁移学习的方法,可以在其他领域或任务中利用已有的负样本构造成果,减少重复的负样本构造工作。

使用一些简单而有效的采样策略,例如随机采样、困难采样、分层采样等,来根据不同的任务和目标选择合适的负样本。

使用一些基于自编码器或生成对抗网络等技术的方法,来生成一些具有一定难度和多样性的人工负样本。

使用一些基于互信息或对比损失等指标的方法,来动态地调整负样本的权重或数量,以适应不同阶段的训练目标

32.AIGC方向国内的典型研究机构以及代表性工作有哪些?

AIGC是指利用人工智能技术来生成内容的领域,它被认为是继PGC(专业生成内容)和UGC(用户生成内容)之后的新型内容创作方式。

AIGC可以在创意、表现力、迭代、传播、个性化等方面,充分发挥技术优势,为各行各业提供高效、高质、高逼真的内容服务。

**百度:**百度在AIGC方向上拥有文心大模型体系,包括基础大模型、任务大模型和行业大模型,涵盖了NLP、CV和跨模态等多个领域。

百度文心大模型层、工具平台层、产品与社区三层体系,为开发者和用户提供全面的服务和支持。

百度文心大模型在多个国际公开数据集上取得了世界领先的成绩,也在金融、能源、制造、城市、传媒、互联网等行业拥有实际落地的标杆案例。

**腾讯:**腾讯在AIGC方向上拥有混元大模型体系,包括NLP大模型、CV大模型和多模态大模型等,覆盖了文本生成、图像生成、视频生成等多种内容形式。

腾讯混元大模型以太极机器学习平台为底层支持,为AI工程师打造从数据预处理、模型训练、模型评估到模型服务的全流程高效开发工具。

腾讯混元大模型在多个国际公开数据集上取得了优异的成绩,也在游戏、社交、娱乐等领域展示了丰富的应用场景。

**阿里巴巴:**阿里巴巴在AIGC方向上拥有达摩院AI创作平台,包括AI写作平台AI Writer和AI图像平台AI Painter等,提供了从文本到图像的全方位内容生成服务。

阿里巴巴达摩院AI创作平台以PAI深度学习平台为底层支持,为AI创作者提供了灵活、易用、高效的开发环境。

阿里巴巴达摩院AI创作平台在多个国内外比赛中获得了优秀的成绩,也在电商、新闻、教育等领域展现了广泛的应用价值 。

附上技术清单

在这里,我们想要强调的是:成功求职并不是一件难事,关键在于你是否做好了充分的准备。通过学习和掌握AI技术的相关知识和技能,了解面试中可能出现的问题和技巧,你就能够在面试中展现出自己的专业素养和实力,赢得面试官的青睐和认可。因此,让我们一起努力,用知识和技能武装自己,迎接AI时代的挑战和机遇吧!

有需要的朋友可以扫描下方二维码,免费获取更多相关资料!

最后,祝愿所有转行、求职的同学都能够在AI产品面试中取得优异的成绩,找到心仪的工作!加油!

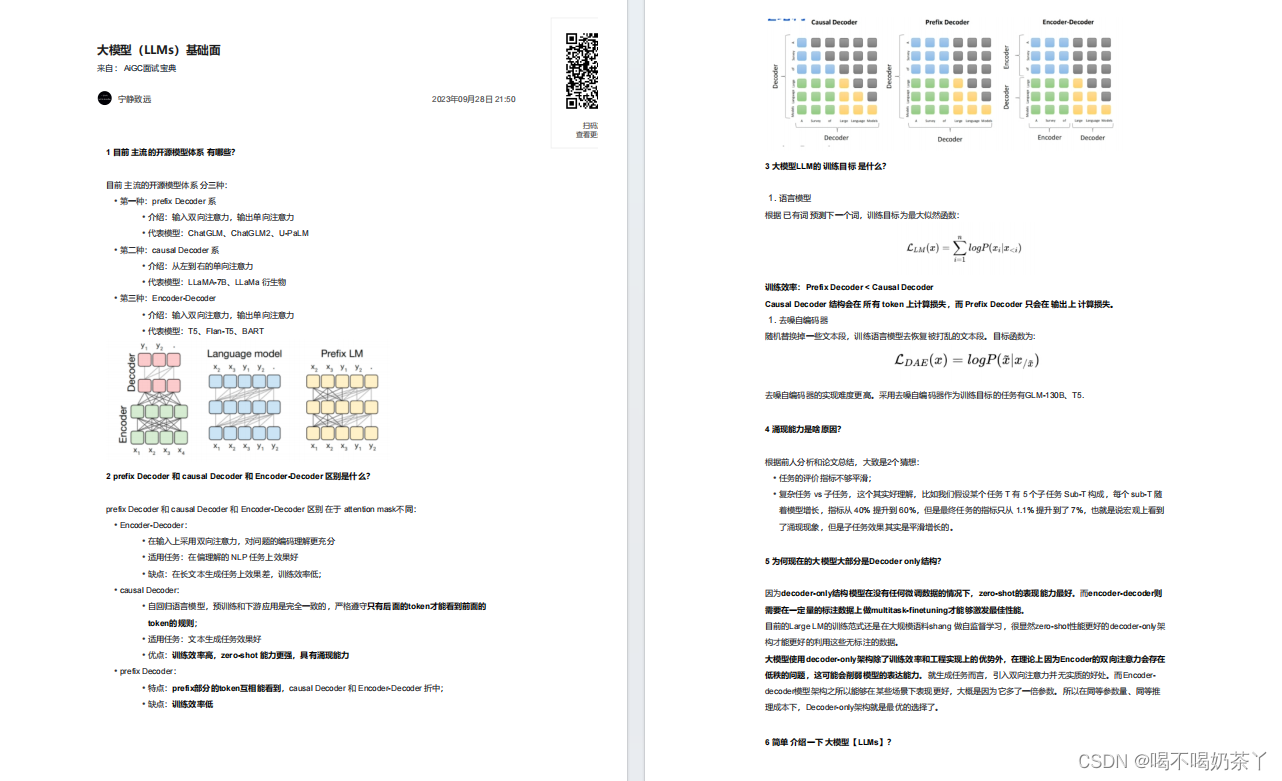

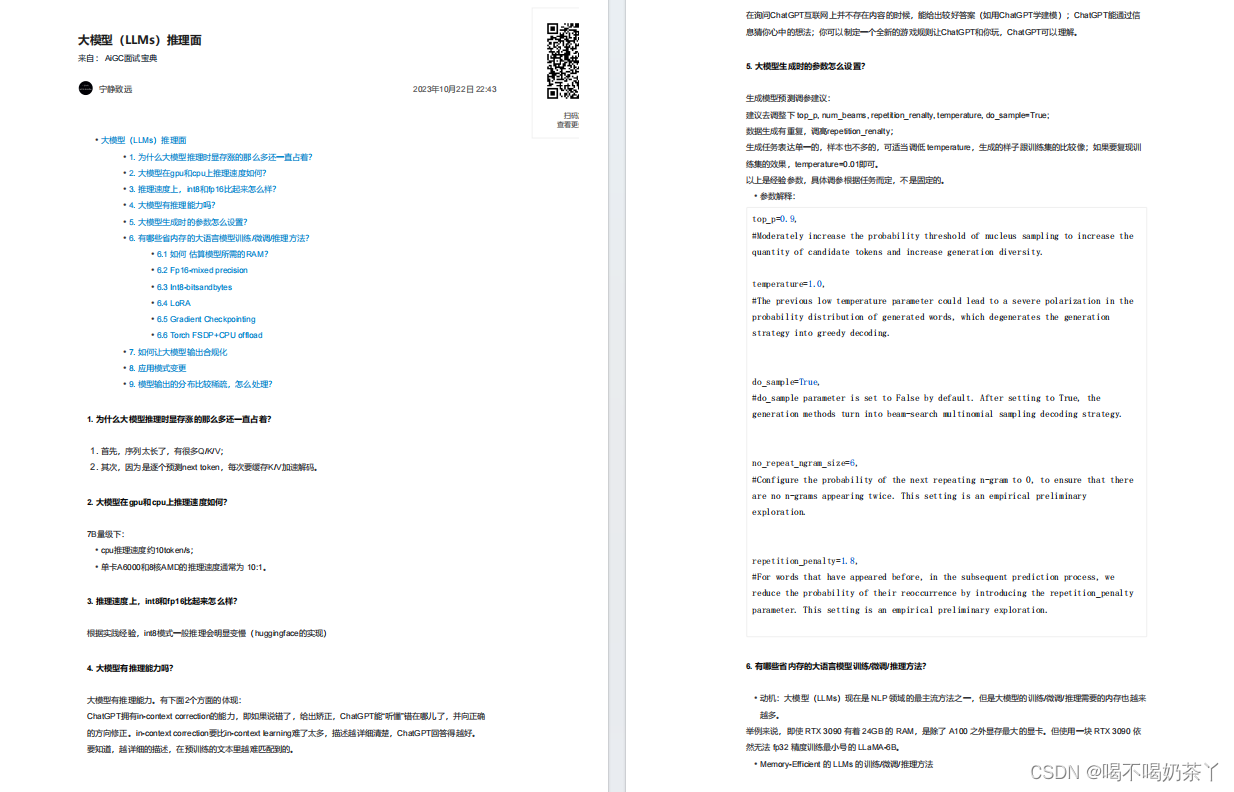

大模型基础面

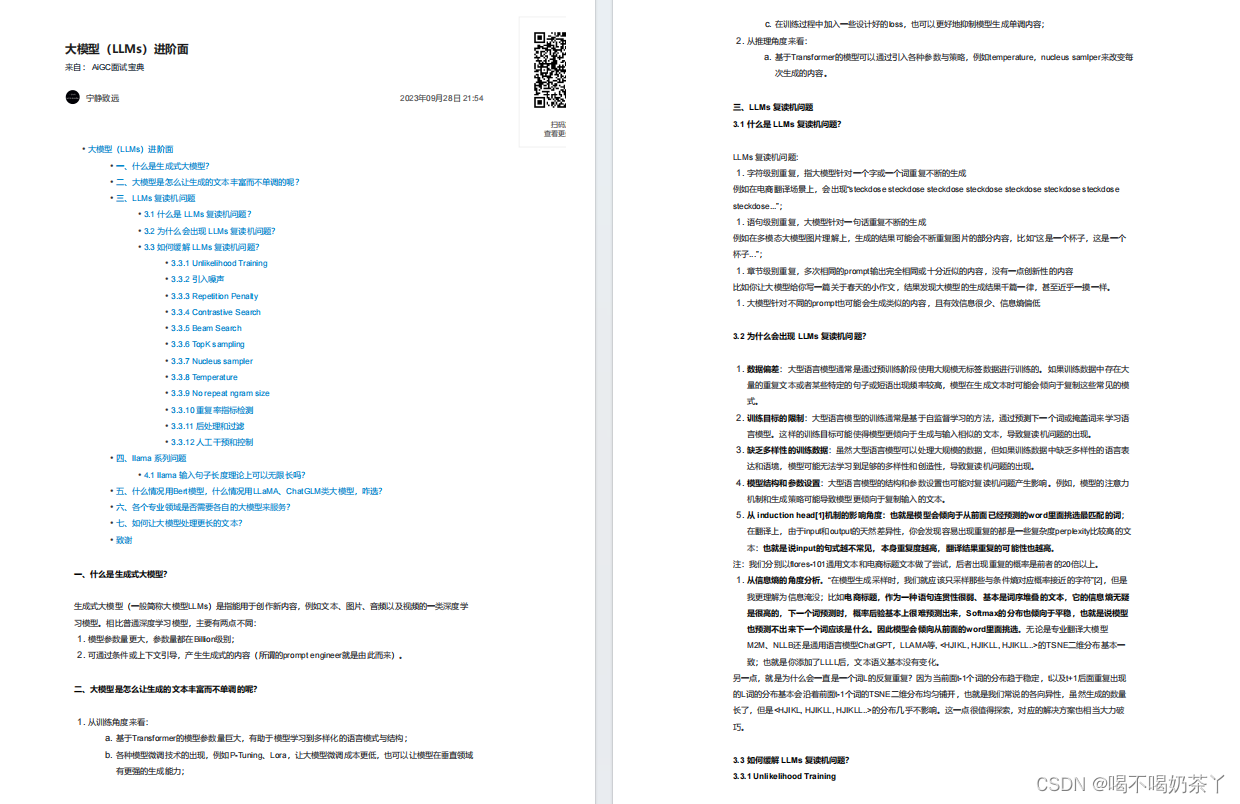

大模型进阶面

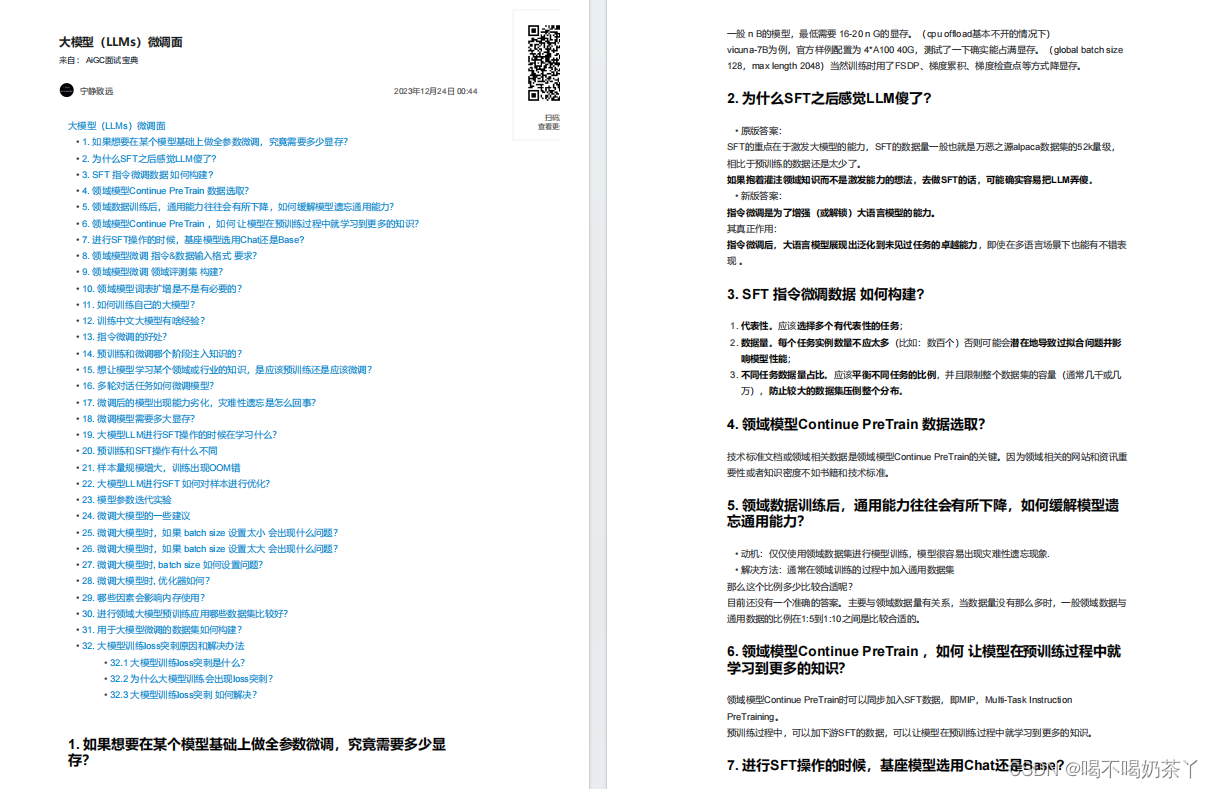

大模型微调面

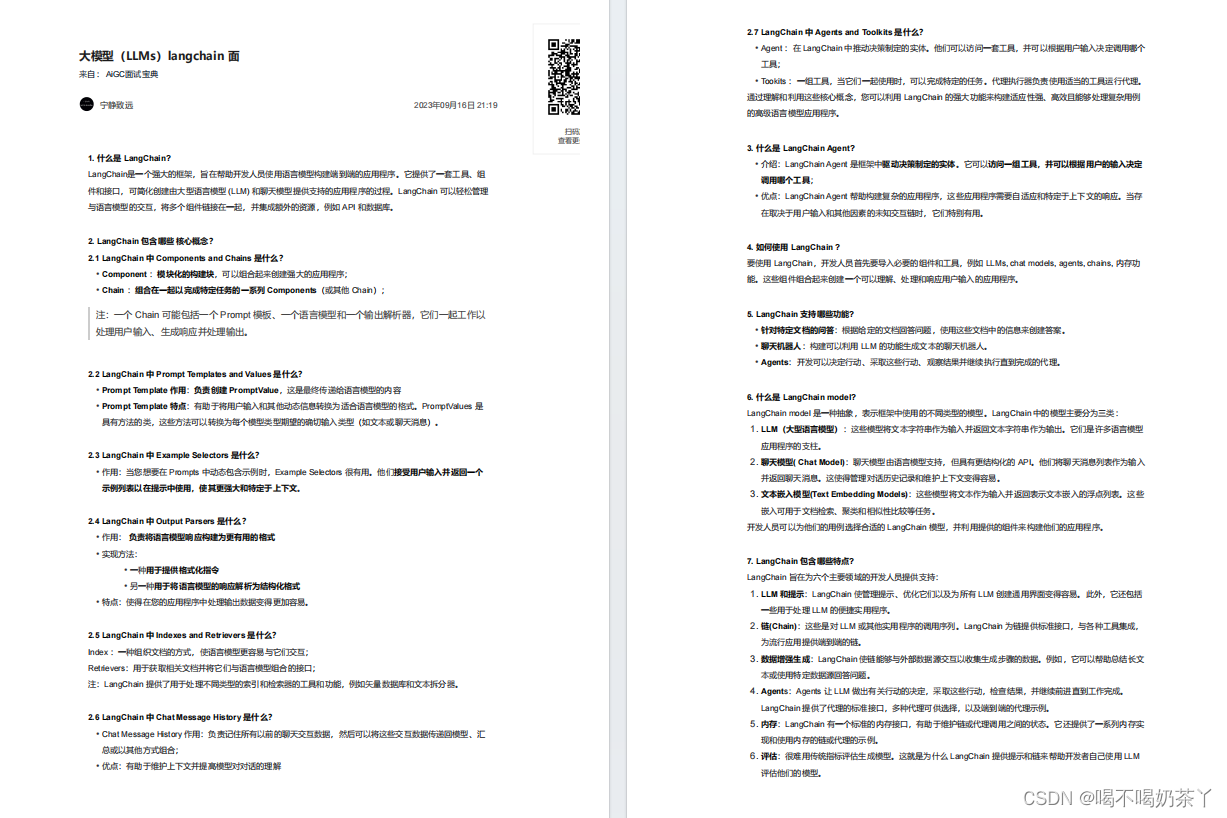

大模型langchain面

大模型推理面

更多面试题分享