《博主简介》

小伙伴们好,我是阿旭。专注于人工智能、AIGC、python、计算机视觉相关分享研究。

✌更多学习资源,可关注公-仲-hao:【阿旭算法与机器学习】,共同学习交流~

👍感谢小伙伴们点赞、关注!

《------往期经典推荐------》

二、机器学习实战专栏【链接】 ,已更新31期,欢迎关注,持续更新中~~

三、深度学习【Pytorch】专栏【链接】

四、【Stable Diffusion绘画系列】专栏【链接】

五、YOLOv8改进专栏【链接】,持续更新中~~

六、YOLO性能对比专栏【链接】,持续更新中~

《------正文------》

基本功能演示

基于YOLOv10深度学习的交通信号灯检测识别系统【python源码+Pyqt5界面+数据集+训练代码】

摘要:

交通信号灯检测识别系统是确保道路交通流畅与安全的关键技术之一。交通信号灯检测识别系统通过智能化处理交通信号,极大提升了交通管理的智能水平和效率,这对于加强城市交通安全、推动智慧交通的发展以及支持自动驾驶技术的实施都是不可或缺的。本文基于YOLOv10深度学习框架,通过5740张交通信号灯相关图片,训练了一个进行交通信号灯目标检测的模型,可以很好的检测红灯、黄灯、绿灯。并基于此模型开发了一款带UI界面的交通信号灯检测识别系统,更便于进行功能的展示。该系统是基于python与PyQT5开发的,支持图片、视频以及摄像头进行目标检测,并保存检测结果。本文提供了完整的Python代码和使用教程,给感兴趣的小伙伴参考学习,完整的代码资源文件获取方式见文末。

文章目录

- 基本功能演示

- 前言

- 一、软件核心功能介绍及效果演示

- 二、模型的训练、评估与推理

-

- 1.YOLOv10简介

- [2. 数据集准备与训练](#2. 数据集准备与训练)

- [3. 训练结果评估](#3. 训练结果评估)

- [4. 检测结果识别](#4. 检测结果识别)

- 【获取方式】

- 结束语

前言

交通信号灯检测识别系统是确保道路交通流畅与安全的关键技术之一。此系统可以精准地实时识别不同颜色的交通灯状态,对于提升自动驾驶车辆的智能决策与反应速度、减少交通违规行为、避免交通事故具有重大意义。随着城市交通日益复杂,这种技术对减轻交通压力、增强道路使用效率也起着积极作用。

其主要应用场景包括:

自动驾驶汽车:使得自动驾驶系统能够正确响应交通信号灯的变化。

交通监控系统:辅助交通管理部门监控交通流和交通信号灯状态。

智能交通控制系统:优化交通灯控制逻辑,以改善交通状况。

安全驾驶辅助:为传统车辆提供额外的安全驾驶提示。

交通违规检测:自动检测并记录闯红灯等违法行为。

行人与自行车车道管理:保障非机动车和行人安全,减少与机动车的冲突。

城市规划和研究:收集交通灯运作数据,用于交通模式分析和规划。

总结来说,交通信号灯检测识别系统通过智能化处理交通信号,极大提升了交通管理的智能水平和效率,这对于加强城市交通安全、推动智慧交通的发展以及支持自动驾驶技术的实施都是不可或缺的。未来随着技术的完善和应用场景的扩展,交通信号灯检测识别系统将发挥更加重要的作用。

博主通过搜集实际场景中的交通信号灯相关数据图片,根据YOLOv10的目标检测技术,基于python与Pyqt5开发了一款界面简洁的交通信号灯检测识别系统,可支持图片、视频以及摄像头检测,同时可以将图片或者视频检测结果进行保存。

软件初始界面如下图所示:

检测结果界面如下:

一、软件核心功能介绍及效果演示

软件主要功能

1. 可用于实际场景中的交通信号灯检测识别,可检测3个类别:红灯、绿灯、黄灯;

2. 支持图片、视频及摄像头进行检测,同时支持图片的批量检测;

3. 界面可实时显示目标位置、目标总数、置信度、用时等信息;

4. 支持图片或者视频的检测结果保存;

5. 支持图片检测结果保存csv文件。

界面参数设置说明

置信度阈值:也就是目标检测时的conf参数,只有检测出的目标置信度大于该值,结果才会显示;

交并比阈值:也就是目标检测时的iou参数,只有目标检测框的交并比大于该值,结果才会显示;

检测结果说明

显示标签名称与置信度:表示是否在检测图片上标签名称与置信度,显示默认不勾选,如果勾选则会在检测图片上显示标签名称与置信度;

总目标数:表示画面中的目标数目;

目标选择:可选择单个目标进行位置信息、置信度查看。

目标位置:表示所选择目标的检测框,左上角与右下角的坐标位置。默认显示的是置信度最大的一个目标信息;

主要功能说明

功能视频演示见文章开头,以下是简要的操作描述。

(1)图片检测说明

点击打开图片按钮,选择需要检测的图片,或者点击打开文件夹按钮,选择需要批量检测图片所在的文件夹,操作演示如下:

点击目标下拉框后,可以选定指定目标的结果信息进行显示。

点击保存按钮,会对检测结果进行保存,存储路径为:save_data目录下。

注:1.右侧目标位置默认显示置信度最大一个目标位置,可用下拉框进行目标切换。所有检测结果均在左下方表格中显示。

(2)视频检测说明

点击视频按钮,打开选择需要检测的视频,就会自动显示检测结果,再次点击可以关闭视频。

点击保存按钮,会对视频检测结果进行保存,存储路径为:save_data目录下。

(3)摄像头检测说明

点击打开摄像头按钮,可以打开摄像头,可以实时进行检测,再次点击,可关闭摄像头。

(4)保存图片与视频检测说明

点击保存按钮后,会将当前选择的图片【含批量图片】或者视频的检测结果进行保存。检测的图片与视频结果会存储在save_data目录下。

保存的检测结果文件如下:

图片文件保存的csv文件内容如下,包括图片路径、目标在图片中的编号、目标类别、置信度、目标坐标位置。

注:其中坐标位置是代表检测框的左上角与右下角两个点的x、y坐标。

二、模型的训练、评估与推理

1.YOLOv10简介

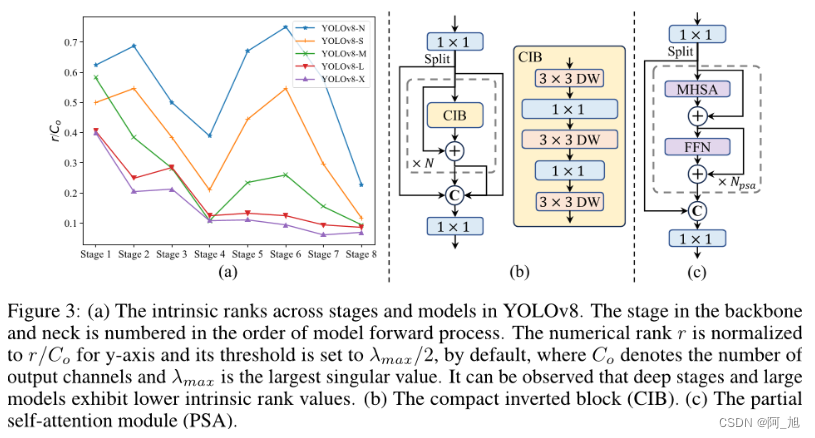

YOLOv10是YOLO最新一代版本的实时端到端目标检测算法。该算法在YOLO系列的基础上进行了优化和改进,旨在提高性能和效率之间的平衡。首先,作者提出了连续双分配方法,以实现NMS-free训练,从而降低了推理延迟并提高了模型的性能。其次,作者采用了全面的效率-准确性驱动的设计策略,对YOLO的各种组件进行了综合优化,大大减少了计算开销,并增强了模型的能力。

YOLOv10优化点

双标签分配

与一对一配对不同,一对多配对为每个真实标签分配一个预测标签,避免了后处理中的非极大抑制(NMS)。然而,它会导致弱监督,从而导致较低的准确度和收敛速度。幸运的是,这种缺陷可以通过一对多配对进行补偿。为了实现这一目标,在YOLO中引入了双标签分配来结合这两种策略的优点。具体来说,如上图所示,我们为 YOLO 添加了一个额外的一对一头部。它保留了一致的结构,并采用与原始的一对多分支相同的学习目标,但利用一对一匹配获得标签分配。在训练过程中,两个头与模型一起联合优化,允许骨干网络和脖子从一对多分支提供的丰富监督信号中受益。在推理过程中,我们丢弃一对多头,并使用一对一头进行预测。这使得 YOLO 能够端到端部署,而无需付出任何额外的推断成本。

模型设计改进

在模型设计方面,提出了以下几种改进点:

轻量级分类头: 通过对分类头进行轻量化设计,可以减少计算成本,而不会显著影响性能。

空间通道解耦降采样: 该方法通过分离空间和通道维度上的操作,提高了信息保留率,从而实现了更高的效率和竞争力。

排名引导块设计: 该方法根据各个阶段的冗余程度,采用不同的基本构建块,以实现更高效的模型设计。

大核深度卷积和部分自注意力模块: 这些模块可以在不增加太多计算开销的情况下提高模型的表现力。

2. 数据集准备与训练

通过网络上搜集关于交通信号灯相关图片,并使用Labelimg标注工具对每张图片进行标注。数据集一共包含5740张图片,其中训练集包含4009张图片,验证集包含1137张图片、测试集包含594张图片。

部分数据集及标注如下图所示:

数据集各类别数量分布如下:

模型训练

图片数据的存放格式如下,在项目目录中新建datasets目录,同时将检测的图片分为训练集与验证集放入Data目录下。

同时我们需要新建一个data.yaml文件,用于存储训练数据的路径及模型需要进行检测的类别。YOLOv10在进行模型训练时,会读取该文件的信息,用于进行模型的训练与验证。data.yaml的具体内容如下:

python

train: D:\2MyCVProgram\2DetectProgram\TrafficLightDetection_v10\datasets\Data\train

val: D:\2MyCVProgram\2DetectProgram\TrafficLightDetection_v10\datasets\Data\valid

test: D:\2MyCVProgram\2DetectProgram\TrafficLightDetection_v10\datasets\Data\test

nc: 3

names: ['green', 'red', 'yellow']注:train与val后面表示需要训练图片的路径,建议直接写自己文件的绝对路径。

数据准备完成后,通过调用train.py文件进行模型训练,epochs参数用于调整训练的轮数,batch参数用于调整训练的批次大小【根据内存大小调整,最小为1】,代码如下:

python

#coding:utf-8

from ultralytics import YOLO

import matplotlib

matplotlib.use('TkAgg')

# 模型配置文件

model_yaml_path = "ultralytics/cfg/models/v10/yolov10n.yaml"

#数据集配置文件

data_yaml_path = 'datasets/Data/data.yaml'

#预训练模型

pre_model_name = 'yolov10n.pt'

if __name__ == '__main__':

#加载预训练模型

model = YOLO(model_yaml_path).load(pre_model_name)

#训练模型

results = model.train(data=data_yaml_path,

epochs=150, # 训练轮数

batch=4, # batch大小

name='train_v10', # 保存结果的文件夹名称

optimizer='SGD') # 优化器3. 训练结果评估

在深度学习中,我们通常用损失函数下降的曲线来观察模型训练的情况。YOLOv10在训练时主要包含三个方面的损失:定位损失(box_loss)、分类损失(cls_loss)和动态特征损失(dfl_loss),在训练结束后,可以在runs/目录下找到训练过程及结果文件,如下所示:

各损失函数作用说明:

定位损失box_loss:预测框与标定框之间的误差(GIoU),越小定位得越准;

分类损失cls_loss:计算锚框与对应的标定分类是否正确,越小分类得越准;

动态特征损失(dfl_loss):DFLLoss是一种用于回归预测框与目标框之间距离的损失函数。在计算损失时,目标框需要缩放到特征图尺度,即除以相应的stride,并与预测的边界框计算Ciou Loss,同时与预测的anchors中心点到各边的距离计算回归DFLLoss。

本文训练结果如下:

我们通常用PR曲线来体现精确率和召回率的关系,本文训练结果的PR曲线如下。mAP表示Precision和Recall作为两轴作图后围成的面积,m表示平均,@后面的数表示判定iou为正负样本的阈值。mAP@.5:表示阈值大于0.5的平均mAP,可以看到本文模型目标检测的mAP@0.5值为0.989,结果是十分不错的。

4. 检测结果识别

模型训练完成后,我们可以得到一个最佳的训练结果模型best.pt文件,在runs/train/weights目录下。我们可以使用该文件进行后续的推理检测。

图片检测代码如下:

python

#coding:utf-8

from ultralytics import YOLO

import cv2

# 所需加载的模型目录

path = 'models/best.pt'

# 需要检测的图片地址

img_path = "TestFiles/C0C7644C-8227-4E99-8F6C-B1CEAFE4A23F_jpg.rf.2afe4bf9e53e7c40d54ef8bb2533854e.jpg"

# 加载预训练模型

model = YOLO(path, task='detect')

# 检测图片

results = model(img_path)

print(results)

res = results[0].plot()

# res = cv2.resize(res,dsize=None,fx=2,fy=2,interpolation=cv2.INTER_LINEAR)

cv2.imshow("YOLOv8 Detection", res)

cv2.waitKey(0)执行上述代码后,会将执行的结果直接标注在图片上,结果如下:

以上便是关于此款交通信号灯检测识别系统的原理与代码介绍。基于此模型,博主用python与Pyqt5开发了一个带界面的软件系统,即文中第二部分的演示内容,能够很好的支持图片、视频及摄像头进行检测,同时支持检测结果的保存。

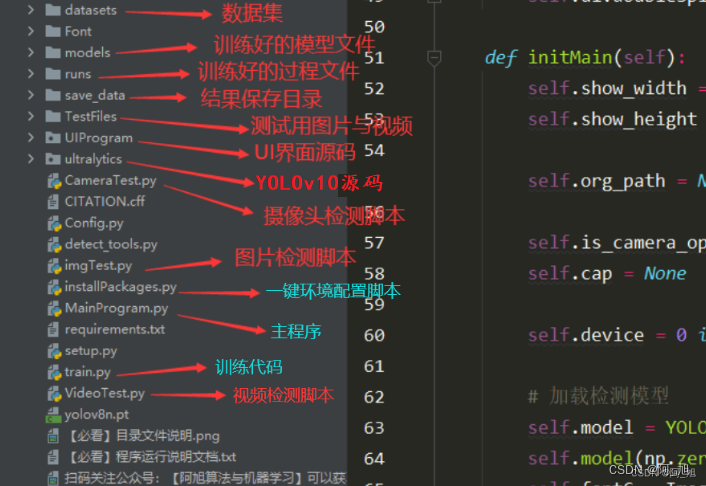

关于该系统涉及到的完整源码、UI界面代码、数据集、训练代码、测试图片视频等相关文件,均已打包上传,感兴趣的小伙伴可以通过下载链接自行获取。

【获取方式】

本文涉及到的完整全部程序文件:包括python源码、数据集、训练好的结果文件、训练代码、UI源码、测试图片视频 等(见下图),获取方式见文末:

注意:该代码基于Python3.9开发,运行界面的主程序为

MainProgram.py,其他测试脚本说明见上图。为确保程序顺利运行,请按照程序运行说明文档txt配置软件运行所需环境。

结束语

以上便是博主开发的基于YOLOv10深度学习的交通信号灯检测识别系统的全部内容,由于博主能力有限,难免有疏漏之处,希望小伙伴能批评指正。

关于本篇文章大家有任何建议或意见,欢迎在评论区留言交流!

觉得不错的小伙伴,感谢点赞、关注加收藏哦!