单纯使用 Canny 生成的图片,仅能保障图片的外轮廓、构图与人物的神态与原图相似,但颜色相差非常大:

生成图片如下:

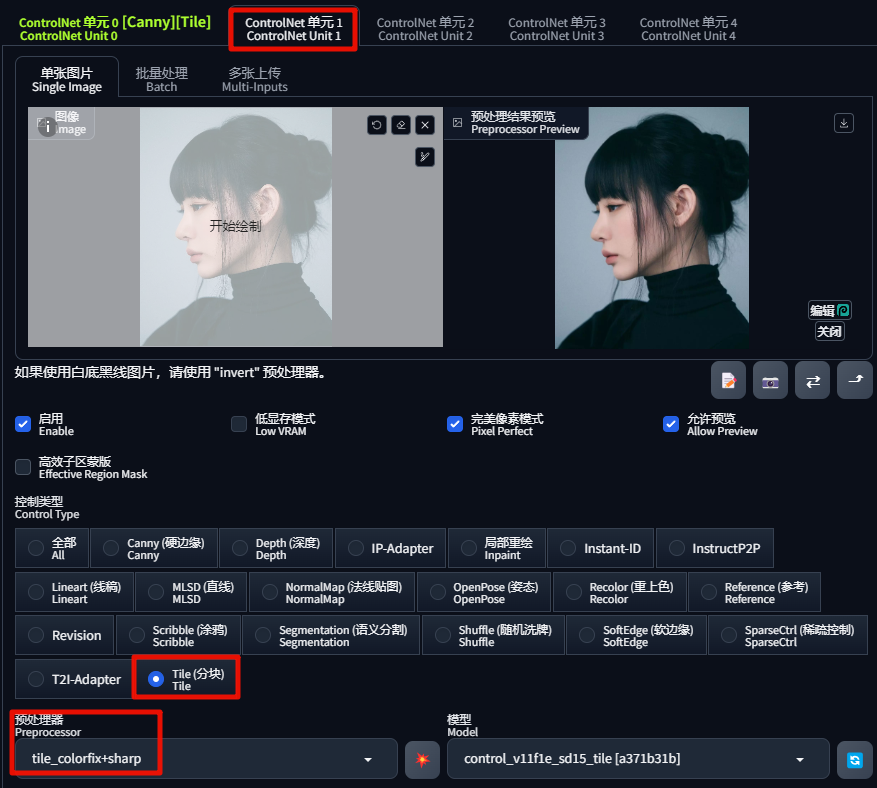

因此,开启第二个 ControlNet:

生成的图片,整体颜色就能做到与原图相似了:

将控制颜色的 Variation值 提高,能给SD在颜色上更多的发挥空间,同时将控制模式选择「更偏向 ControlNet」:

提示词输入:1girl,red hair,头发的颜色就会融入红色的元素,生成图片如下:

今天先分享到这里~

开启实践: SD绘画 | 为你所做的学习过滤