💝💝💝欢迎来到我的博客,很高兴能够在这里和您见面!希望您在这里可以感受到一份轻松愉快的氛围,不仅可以获得有趣的内容和知识,也可以畅所欲言、分享您的想法和见解。

- 推荐:kwan 的首页,持续学习,不断总结,共同进步,活到老学到老

- 导航

非常期待和您一起在这个小小的网络世界里共同探索、学习和成长。💝💝💝 ✨✨ 欢迎订阅本专栏 ✨✨

博客目录

1.下载 Kibana

选择要下载的版本 尽量和 ES 版本保持一致,版本采用 7.12.0 并选择 linux 版本

2.安装

apl

#安装目录

cd /usr/local

#解压

tar -zxvf kibana-7.12.0-linux-x86_64.tar.gz

#改名

mv kibana-7.12.0-linux-x86_64 kibana3.修改配置

修改 kibana.yml

apl

cd /usr/local/kibana

vim config/kibana.yml

apl

server.port: 5601 #kibana端口

server.host: "0.0.0.0" #所有主机都能访问,或者也可以指定一个ip

elasticsearch.hosts: "http://es服务公网IP:9200" #配置es的访问地址

kibana.index: ".kibana"

i18n.locale: "zh-CN" #配置项默认是英文,配置成中文的

apl

#root

chown -R elasticsearch:elasticsearch /usr/local/kibana4.启动

apl

#切换用户

su elasticsearch

#启动

cd /usr/local/kibana/bin

./kabana

#后台启动

nohup sh /usr/local/kibana/bin/kibana &5.验证

apl

#端口号

netstat -ntlp | grep 5601

#浏览器

http://47.119.162.180:5601/

#控制台

http://47.119.162.180:5601/app/dev_tools#/console

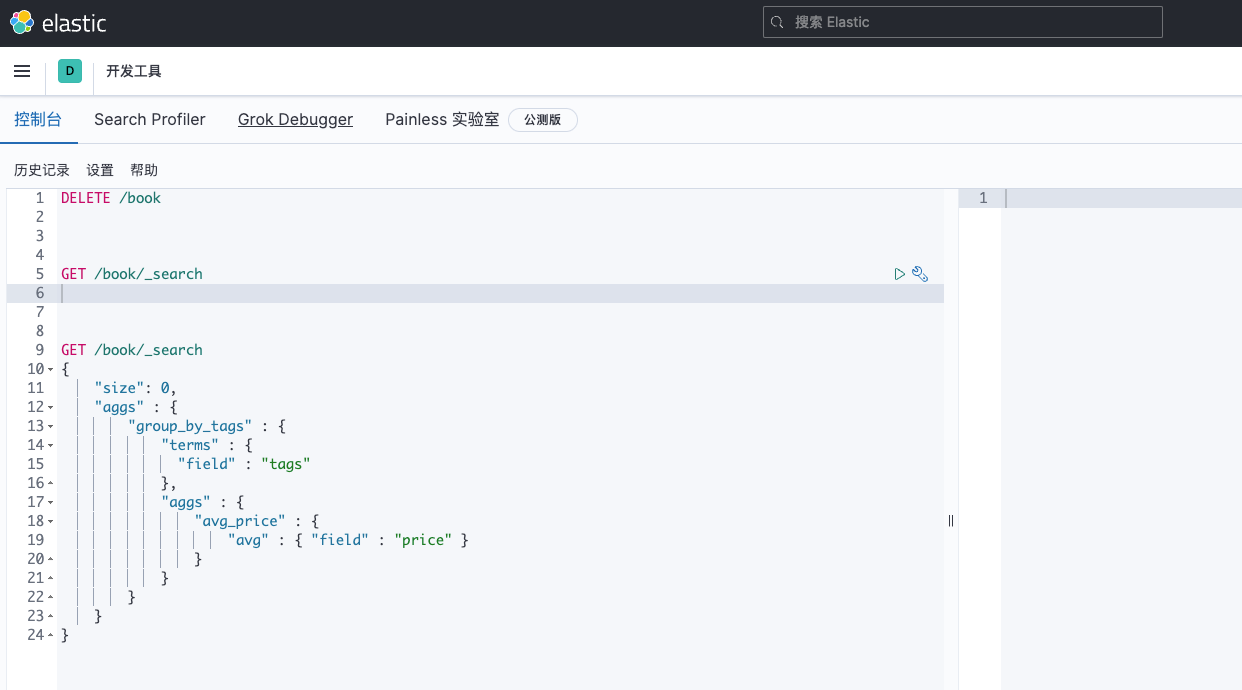

6.测试 SQL

apl

GET _search

{

"query": {

"match_all": {}

}

}

GET /

GET /_cluster/health

GET /_cat/health?v

GET /_cat/indices?v

PUT /demo_index?pretty

DELETE /demo_index?pretty

PUT /book

PUT /book/_doc/1

{

"id":1,

"title":"这是一文章",

"content":"xxxxx",

"comment":"备注信息",

"mobile":"13344556677"

}

PUT /book/_doc/2

{

"id":1,

"title":"这是一11文章",

"content":"xxxxx",

"comment":"备注信息",

"mobile":"13344556677"

}

GET /book/_doc/1

POST /book/_doc/1/_update

{

"doc": {

"title": "这是一333文章"

}

}

POST /book/_update/1

{

"doc": {

"title": "这是一3333333444555文章"

}

}

DELETE /book/_doc/1

POST /book/_doc/

{

"id":1,

"title":"这是一11文章",

"content":"xxxxx",

"comment":"备注信息",

"mobile":"13344556677"

}

GET /book/_doc/1

GET /book/_doc/1?_source_includes=id,title

PUT /read_index/_doc/1/_create

{

"id":1,

"title":"这是一11文章",

"content":"xxxxx",

"comment":"备注信息",

"mobile":"13344556677"

}

#插入数据

PUT /test_index/_doc/6

{

"num": 0

}

#执行脚本

POST /test_index/_doc/6/_update

{

"script": "ctx._source.num+=1"

}

#查询数据

GET /test_index/_doc/6

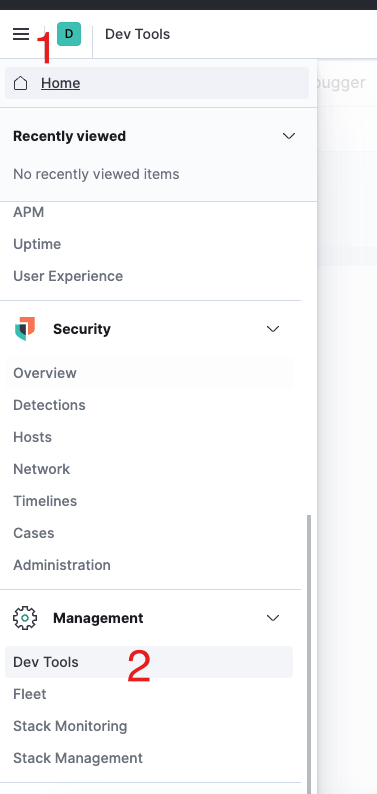

GET /test_index/_search7.kibana 控制台

apl

http://47.119.162.180:5601/app/dev_tools#/console

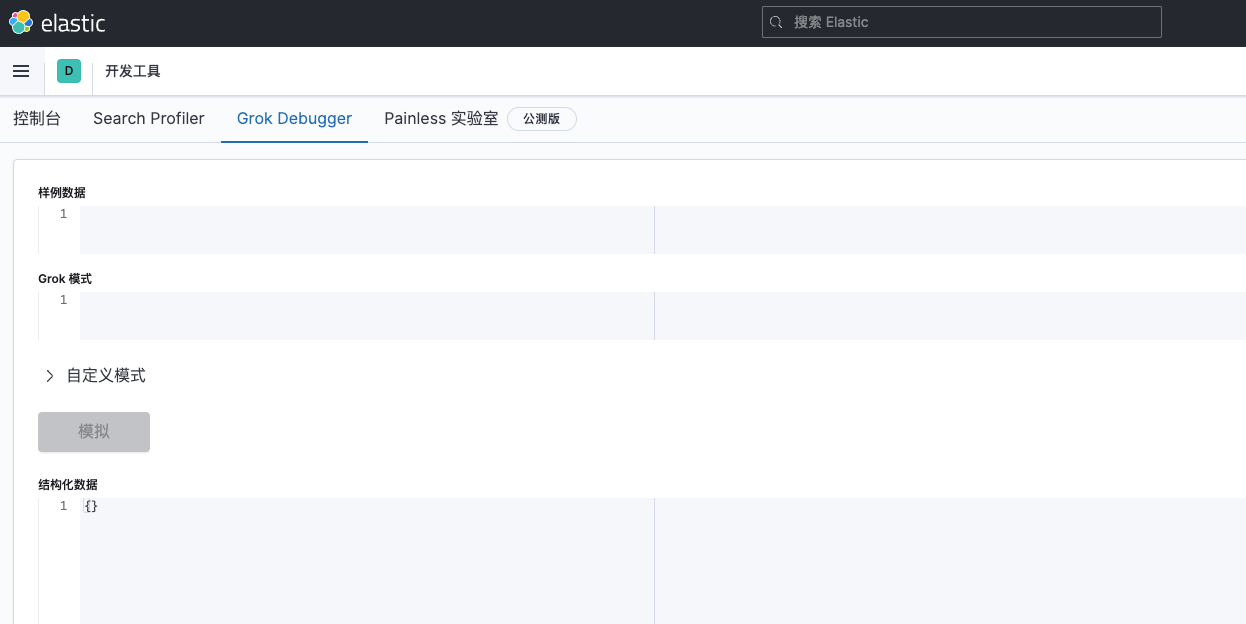

8.Grok 测试

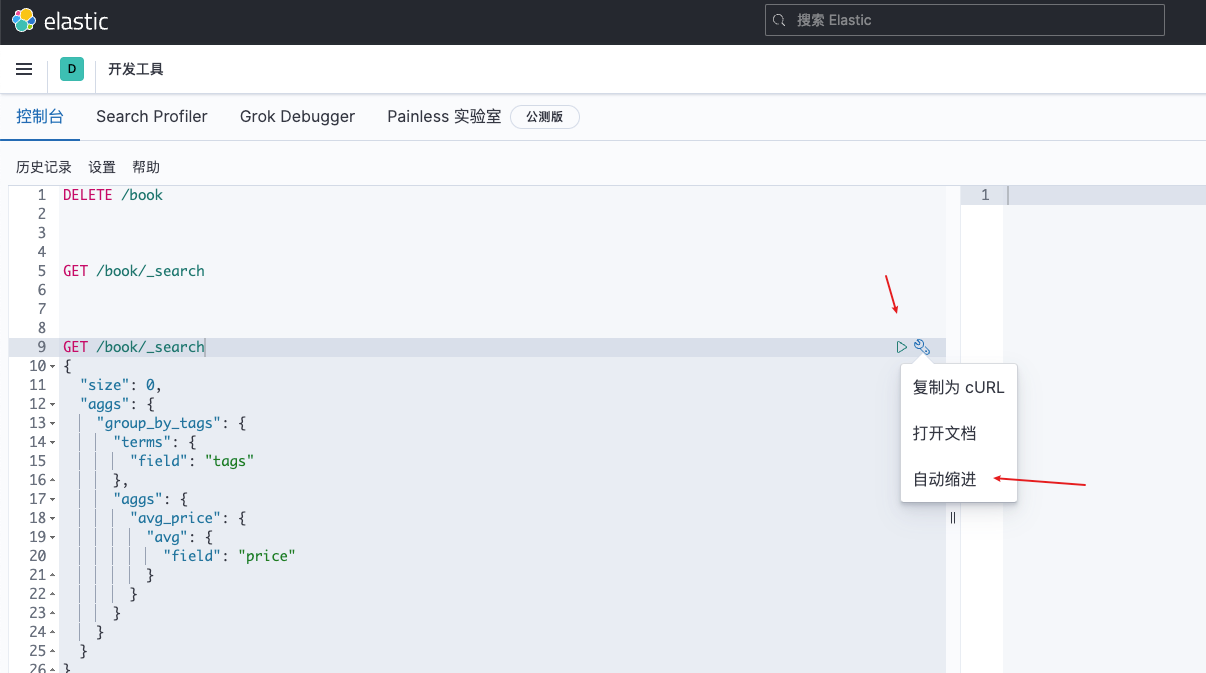

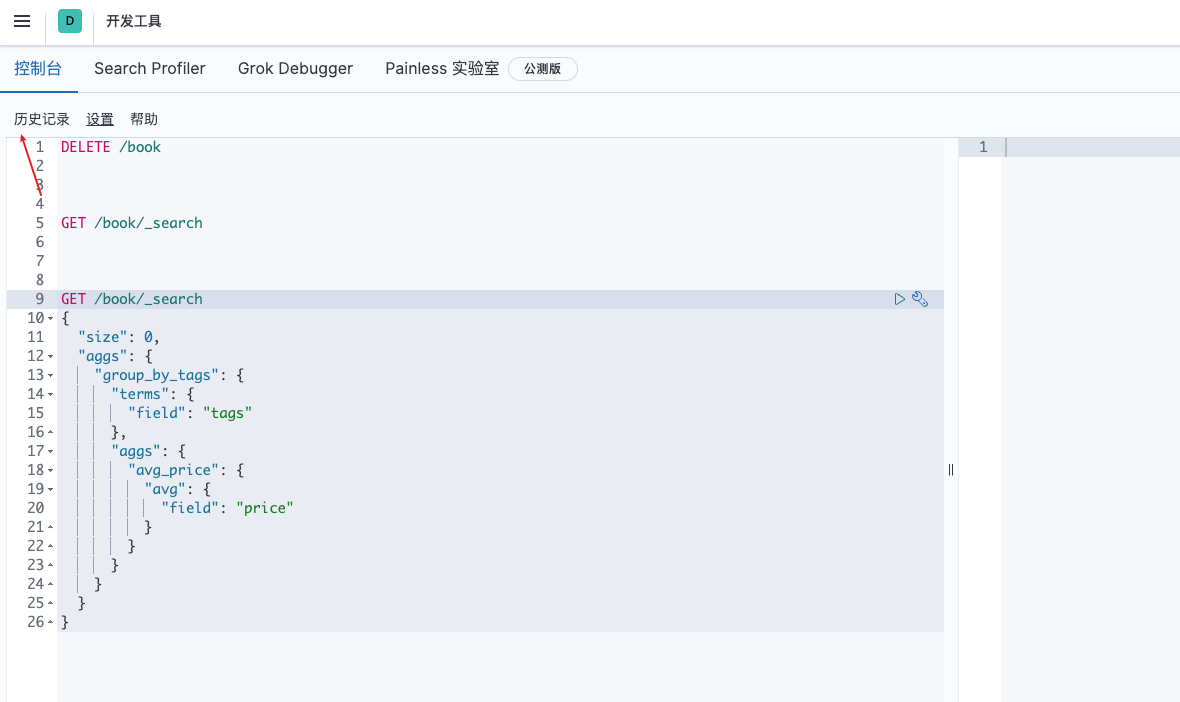

9.格式化

10.历史记录

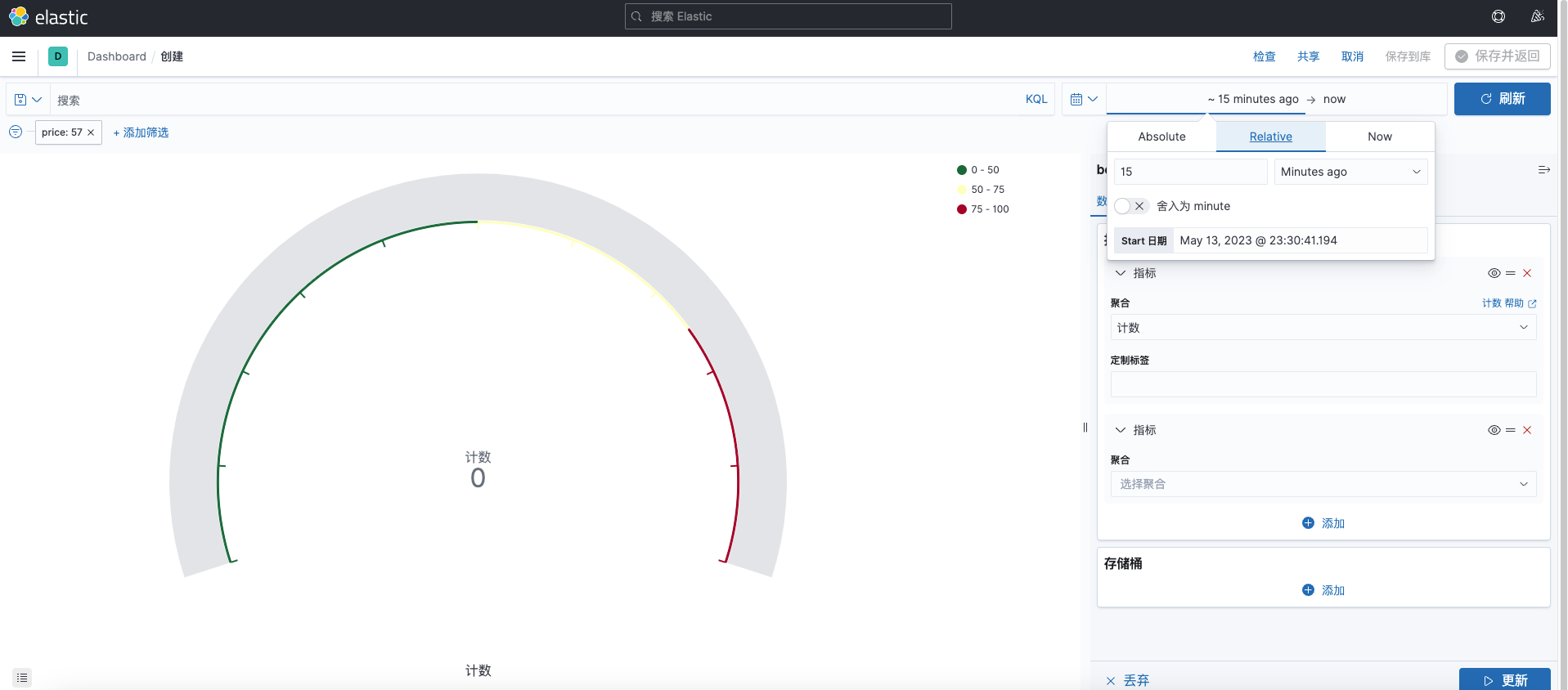

11.仪表板

觉得有用的话点个赞

👍🏻呗。❤️❤️❤️本人水平有限,如有纰漏,欢迎各位大佬评论批评指正!😄😄😄

💘💘💘如果觉得这篇文对你有帮助的话,也请给个点赞、收藏下吧,非常感谢!👍 👍 👍

🔥🔥🔥Stay Hungry Stay Foolish 道阻且长,行则将至,让我们一起加油吧!🌙🌙🌙