一、什么是生成式AI?

以ChatGPT为代表的生成式AI,是对已有的数据和知识进行向量化的归纳 ,总结出数据的联合概率 。从而在生成内容时,根据用户需求,结合关联字词的概率 ,生成新的内容。

可以这么联想,ChatGPT就是一个词语接龙的机器,他会根据你给出的关键词,自动生成关键词的下一个最有可能衔接的词语。比如你说,"世界上最高的山",ChatGPT就会回答"喜马拉雅山"。

二、怎么得到一个大模型?

大模型需要:算力、数据/存力、算法这三大要素。

算力:即需要GPU、NPU这些硬件进行训练。

数据/存力:生成式AI需要处理和存储大量的数据。以GPT-3为例,光是训练参数就达到了1750亿个,训练数据达到45TB,每天会产生45亿字内容。

算法:生成式AI的主要算法是深度学习。从仿生学的角度,人类希望AI能够模仿人脑的运行机制,对知识进行思考推理------这就是通常所说的深度学习。

三、算法

为了实现深度学习,学者们提出了大量的神经网络架构:

先看三个经典的:

- 深度神经网络(DNN)是最普遍的神经网络架构,但是随着数据对于网路架构的要求越来越复杂,这种方法逐渐有些吃力。

- 卷积神经网络(CNN)是一种专门为处理图像数据而设计的神经网络架构,能够有效地处理图像数据,但是需要对输入数据进行复杂的预处理。

- 循环神经网络(RNN)架构成为处理序列数据的常用方法。

(1)Transformer架构

由于RNN在处理长序列时容易遇到梯度消失和模型退化问题,著名的Transformer算法被提出。

Transformer架构:是目前文本生成领域的主流架构,GPT、llama等LLM(大语言模型)都是基于Transformer实现了卓越的性能。

Transformer架构 :主要由输入部分(输入输出嵌入与位置编码)、多层编码器、多层解码器以及输出部分(输出线性层与Softmax)四大部分组成。****

-

(1)输入部分:

-

**源文本嵌入层:**将源文本中的词汇数字表示转换为向量表示,捕捉词汇间的关系。

-

**位置编码器:**为输入序列的每个位置生成位置向量,以便模型能够理解序列中的位置信息。

-

目标文本嵌入层(在解码器中使用):将目标文本中的词汇数字表示转换为向量表示。

-

(2)编码器部分:

-

由N个编码器层堆叠而成。

-

每个编码器层由两个子层连接结构组成:第一个子层是一个多头自注意力子层,第二个子层是一个前馈全连接子层。每个子层后都接有一个规范化层和一个残差连接。

-

(3)解码器部分:

-

由N个解码器层堆叠而成。

-

每个解码器层由三个子层连接结构组成:第一个子层是一个带掩码的多头自注意力子层,第二个子层是一个多头注意力子层(编码器到解码器),第三个子层是一个前馈全连接子层。每个子层后都接有一个规范化层和一个残差连接。

-

(4)输出部分:

-

**线性层:**将解码器输出的向量转换为最终的输出维度。

-

**Softmax层:**将线性层的输出转换为概率分布,以便进行最终的预测。

(2)训练

目前有两种训练方式:预训练和SFT(有监督微调)

- 预训练:是指将一个大型、通用的数据集作为知识喂给AI进行初步学习。经过预训练的模型叫作"基础模型",它对每个领域都有所了解,但是无法成为某个领域的专家。

- SFT(有监督微调):SFT是指在预训练之后,将一个特定任务的数据集喂给AI,进一步训练模型。例如,在已经预训练的语言模型基础上,用专门的医学文本来微调模型,使其更擅长处理医学相关的问答或文本生成任务。

四、Transformer里的编码解码到底是什么?

语义的最小单位,是TOKEN,可以翻译成"词元",它是语言类模型中用数字来表示单词的最小语义单位。

比如下图中这句话"This is a input text." 首先被 Tokenizer 转化成最小词元,其中[CLS][SEP]为一句话的起始与结束符号(CLS:classification 告知系统这是句子级别的分类的开始、SEP:separator 告知系统结束本句或分割下一句),然后再通过 Embedding 的方式转化为向量。

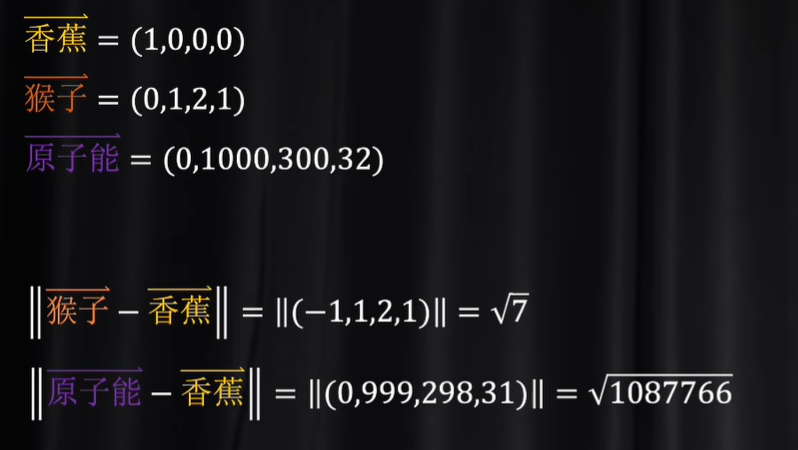

比如猴子和香蕉,这两个语义关系紧密。原子能和香蕉,差距就比较远。

Transformer中,编码器和解码器中的"码"指的是什么?

以下是ChatGPT-4o-mini给出的答案:

编码器中的"码"

- 输入表示:编码器接收输入序列(如文本),并将其转换成一个高维的向量表示。这些向量捕捉了输入序列中单词之间的关系和上下文信息。

- 特征提取:编码器通过多层自注意力机制和前馈神经网络提取特征,使得每个输入的表示包含了其在上下文中的重要性。

解码器中的"码"

- 生成输出:解码器使用编码器生成的表示以及之前生成的单词,逐步生成目标序列(如翻译后的文本)。这里的"码"指的是解码器对已生成内容的处理和对未来内容的预测。

- 上下文结合:解码器同样使用自注意力机制来考虑已生成的单词与当前生成位置的关系。

总结来说,"码"在这里代表了对输入和输出数据的数学表示方式,帮助模型理解和生成语言。

总的来说,编码器负责理解和处理输入,而解码器则负责生成输出,二者协同工作以实现有效的序列转换。

参考:

https://baijiahao.baidu.com/s?id=1801561545647449293&wfr=spider&for=pc