kafka之路-01从零搭建环境到SpringBoot集成

原创 今夜写代码 今夜写代码 2024年07月21日 21:58 浙江

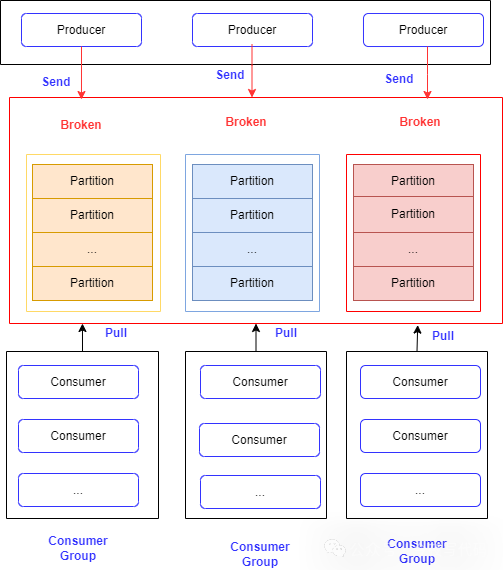

一、kafka 架构简单介绍

- 生产者将消息发送到Broker 节点,消费者从Broker 订阅消息

2)消息订阅通常有服务端Push 和 消费端Pull两种方式,Kafka采用的是Pull 方式

Kafka 相关配置比较多,本节主要内容环境搭建,以及用Spring Boot 集成kafka,实现消息发送与订阅。一些其他概念比如Partition,消费位移等等,后面文章会继续。

二、环境搭建

2.1 jdk 安装

kafka依赖jdk 环境,从2.0.0版本开始,kafka已经不支持jdk7及以下版本,本文使用的版本是JDK 8 。具体可查看官网kafka指定版本对JDK版本限制。

安装之后配置jdk环境变量

export JAVA_HOME="/opt/java/jdk1.8.0_281"export PATH=$JAVA_HOME/bin:$PATH2.2 zookeeper 安装

zookeeper 主要用来管理集群、broken、topic、partition等元数据信息管理,官网下载压缩包,

还需要配置zookeeper 配置文件(conf/zoo.cfg),可以基于zoo_sample.cfg修改,直接复制一份然后根据实际情况修改相关配置

bash

cp zoo_sample.cfg zoo.cfg配置环境变量

export ZK_HOME=/opt/zookeeper/apache-zookeeper-3.8.4-binPATH=$PATH:$ZK_HOME/bin创建相关目录

zookeeper配置文件默认 dataDir=/tmp/zookeeper,需要创建/tmp/zookeeper/log 和 /tmp/zookeeper/data 目录,并且目前全限最好设置777 否则启动报错

启动

zkServer.sh start三、kafka 安装

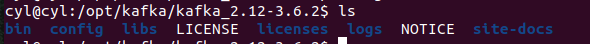

官网下载tgz文件,直接解压,解压后目录

配置修改

配置文件server.properties ,根据实际情况修改数据目录、zookeeper等信息,如

log.dirs=/tmp/kafka-logszookeeper.connect=localhost:2181/kafka启动

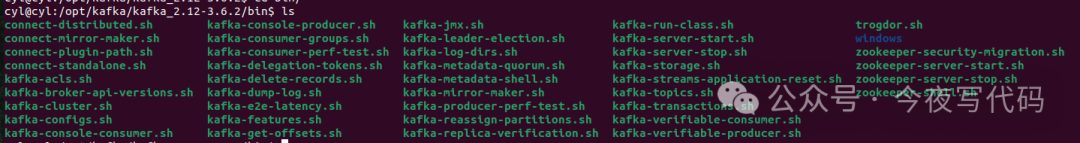

kafka-server-start.sh -daemon server.properties 启动成功后,一个单机模式kafka环境搭建好了,kafka提供了许多"脚本工具",甚至包含发送消息,消费消息。当然对于专注于后端开发者而言,代码操作,比Shell方便。

Spring Boot 集成

引入依赖

<dependency> <groupId>org.springframework.kafka</groupId> <artifactId>spring-kafka</artifactId> </dependency>添加配置

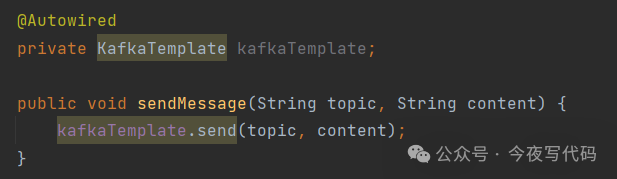

spring.kafka.bootstrap-servers=IP:9092spring.kafka.consumer.group-id=community-consumer-groupspring.kafka.consumer.enable-auto-commit=truespring.kafka.consumer.auto-commit-interval=3000发现消息可以使用 KafkaTemplate,调用其send 方法

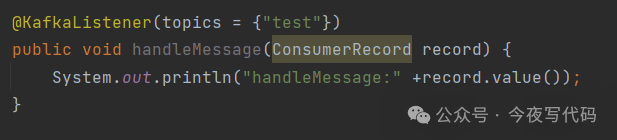

消费消息@KafkaListener

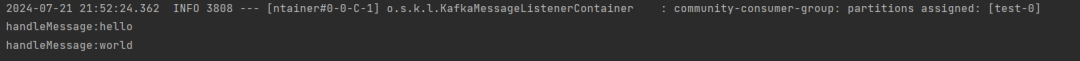

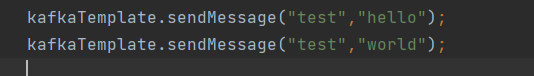

发送两条消息试试看

消息被正确消费,大功告成。