k8s-集群部署1

一、基础环境准备

首先,需要准备三个服务器实例,这里我使用了阿里云创建了三个实例,如果不想花钱,也可以在VM上创建。

这三个实例最好选择2vCPU,4GiB,因为我之前选择2vCPU,2GiB没有搭建成功,当然也可能是网络的问题。可以在创建的时候就命名好对应的实例名称:k8s-master、k8s-node1和k8s-node2。

接着,通过终端连接这三个实例,这里我使用的是FinalShell连接的。

这里要在各个实例中互相ping下各自的公网IP是否能ping通。至此,服务器实例以搭建完成。

二、docker环境准备

(1)移除以前docker相关包

bash

sudo yum remove docker \

docker-client \

docker-client-latest \

docker-common \

docker-latest \

docker-latest-logrotate \

docker-logrotate \

docker-engine(2)配置yum源

bash

sudo yum install -y yum-utils

sudo yum-config-manager \

--add-repo \

http://mirrors.aliyun.com/docker-ce/linux/centos/docker-ce.repo(3)安装docker

bash

yum install -y docker-ce-20.10.7 docker-ce-cli-20.10.7 containerd.io-1.4.6(4)启动

bash

systemctl enable docker --now(5)配置加速

bash

sudo mkdir -p /etc/docker

sudo tee /etc/docker/daemon.json <<-'EOF'

{

"registry-mirrors": ["这里填写自己的阿里云镜像加速地址"],

"exec-opts": ["native.cgroupdriver=systemd"],

"log-driver": "json-file",

"log-opts": {

"max-size": "100m"

},

"storage-driver": "overlay2"

}

EOF

sudo systemctl daemon-reload

sudo systemctl restart docker至此,docker环境已安装完毕!

三、k8s集群部署

1.kubeadm创建集群

这里需要满足以下的条件:

-

一台兼容的 Linux 主机。Kubernetes 项目为基于 Debian 和 Red Hat 的 Linux

发行版以及一些不提供包管理器的发行版提供通用的指令

-

每台机器 2 GB 或更多的 RAM (如果少于这个数字将会影响你应用的运行内存)

-

2 CPU 核或更多

-

集群中的所有机器的网络彼此均能相互连接(公网和内网都可以) 设置防火墙放行规则

-

节点之中不可以有重复的主机名、MAC 地址或 product_uuid。请参见这里了解更多详细信息。 设置不同hostname

-

开启机器上的某些端口。请参见这里 了解更多详细信息。内网互信

-

禁用交换分区。为了保证 kubelet 正常工作,你 必须 禁用交换分区。 ○ 永久关闭

根据上面的条件,通过代码依次实现:

(1)基础环境搭建

这里对三个服务器实例均执行如下代码:

bash

#各个机器设置自己的域名,不要直接复制

hostnamectl set-hostname k8s-master/k8s-node1/k8s-node2

# 将 SELinux 设置为 permissive 模式(相当于将其禁用)

sudo setenforce 0

sudo sed -i 's/^SELINUX=enforcing$/SELINUX=permissive/' /etc/selinux/config

#关闭swap

swapoff -a

sed -ri 's/.*swap.*/#&/' /etc/fstab

#允许 iptables 检查桥接流量

cat <<EOF | sudo tee /etc/modules-load.d/k8s.conf

br_netfilter

EOF

cat <<EOF | sudo tee /etc/sysctl.d/k8s.conf

net.bridge.bridge-nf-call-ip6tables = 1

net.bridge.bridge-nf-call-iptables = 1

EOF

sudo sysctl --system(2)安装kubelet、kubeadm、kubectl

bash

cat <<EOF | sudo tee /etc/yum.repos.d/kubernetes.repo

[kubernetes]

name=Kubernetes

baseurl=http://mirrors.aliyun.com/kubernetes/yum/repos/kubernetes-el7-x86_64

enabled=1

gpgcheck=0

repo_gpgcheck=0

gpgkey=http://mirrors.aliyun.com/kubernetes/yum/doc/yum-key.gpg

http://mirrors.aliyun.com/kubernetes/yum/doc/rpm-package-key.gpg

exclude=kubelet kubeadm kubectl

EOF

sudo yum install -y kubelet-1.20.9 kubeadm-1.20.9 kubectl-1.20.9 --disableexcludes=kubernetes

sudo systemctl enable --now kubelet2.使用kubeadm引导集群

(1)下载各个机器需要的镜像

为了保险起见,三个实例均执行下面的命令:

bash

sudo tee ./images.sh <<-'EOF'

#!/bin/bash

images=(

kube-apiserver:v1.20.9

kube-proxy:v1.20.9

kube-controller-manager:v1.20.9

kube-scheduler:v1.20.9

coredns:1.7.0

etcd:3.4.13-0

pause:3.2

)

for imageName in ${images[@]} ; do

docker pull registry.cn-hangzhou.aliyuncs.com/lfy_k8s_images/$imageName

done

EOF

chmod +x ./images.sh && ./images.sh(2)初始化主节点(只在主节点执行)

bash

#所有机器添加master域名映射,以下需要修改为自己的(可通过ip a来查看自己的master域名映射)

echo "172.31.0.4 cluster-endpoint" >> /etc/hosts

#主节点初始化

kubeadm init \

--apiserver-advertise-address=172.31.0.4 \

--control-plane-endpoint=cluster-endpoint \

--image-repository registry.cn-hangzhou.aliyuncs.com/lfy_k8s_images \

--kubernetes-version v1.20.9 \

--service-cidr=10.96.0.0/16 \

--pod-network-cidr=192.168.0.0/16

#所有网络范围不重叠出现下面这段,就说明主节点master初始化成功了:(这部分代码不要清楚,留着后续加入从节点和主节点)

bash

Your Kubernetes control-plane has initialized successfully!

To start using your cluster, you need to run the following as a regular user:

mkdir -p $HOME/.kube

sudo cp -i /etc/kubernetes/admin.conf $HOME/.kube/config

sudo chown $(id -u):$(id -g) $HOME/.kube/config

Alternatively, if you are the root user, you can run:

export KUBECONFIG=/etc/kubernetes/admin.conf

You should now deploy a pod network to the cluster.

Run "kubectl apply -f [podnetwork].yaml" with one of the options listed at:

https://kubernetes.io/docs/concepts/cluster-administration/addons/

You can now join any number of control-plane nodes by copying certificate authorities

and service account keys on each node and then running the following as root:

kubeadm join cluster-endpoint:6443 --token hums8f.vyx71prsg74ofce7 \

--discovery-token-ca-cert-hash sha256:a394d059dd51d68bb007a532a037d0a477131480ae95f75840c461e85e2c6ae3 \

--control-plane

Then you can join any number of worker nodes by running the following on each as root:

kubeadm join cluster-endpoint:6443 --token hums8f.vyx71prsg74ofce7 \

--discovery-token-ca-cert-hash sha256:a394d059dd51d68bb007a532a037d0a477131480ae95f75840c461e85e2c6ae3根据上面的提示,先执行如下代码:

bash

mkdir -p $HOME/.kube

sudo cp -i /etc/kubernetes/admin.conf $HOME/.kube/config

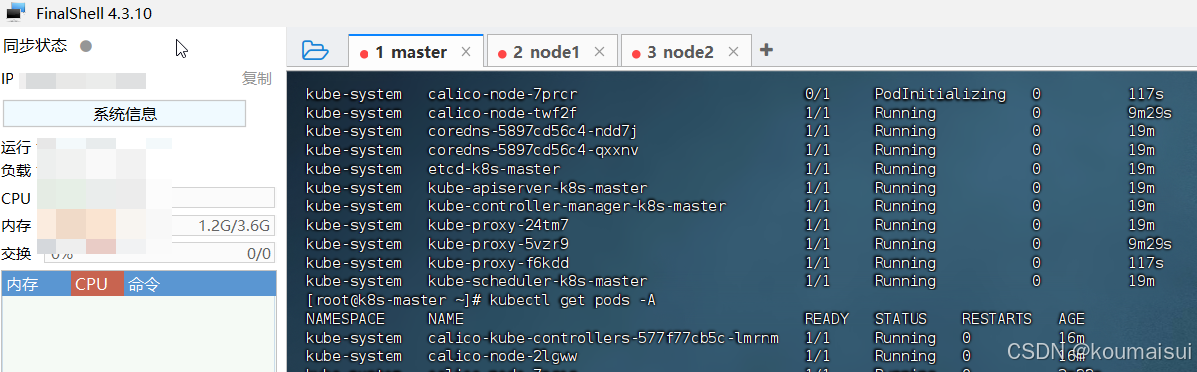

sudo chown $(id -u):$(id -g) $HOME/.kube/config(3)可以查看结点

bash

#查看集群所有节点

kubectl get nodes

#查看集群部署了哪些应用?

docker ps === kubectl get pods -A

# 运行中的应用在docker里面叫容器,在k8s里面叫Pod

kubectl get pods -A(4)设置.kube/config

bash

curl https://docs.projectcalico.org/v3.20/manifests/calico.yaml -O

##可以通过.yaml的方式执行命令,实现操作

kubectl apply -f calico.yaml(5)加入从节点

这里需要根据上面主节点控制面板成功后,给出的内容。

bash

kubeadm join cluster-endpoint:6443 --token x5g4uy.wpjjdbgra92s25pp \

--discovery-token-ca-cert-hash sha256:6255797916eaee52bf9dda9429db616fcd828436708345a308f4b917d3457a22至此集群部署完成,可以在主节点中查看结点情况:

注意,如果集群过期了,可以使用如下命令重新创建节点加入:

bash

kubeadm token create --print-join-command总结

这篇文章主要记录k8s的集群部署,1主2从。需要注意的是代码的执行不要搞乱,有些命令只能主节点执行。