本篇主要基于linux服务器部署ragflow+ollama,其他操作系统稍有差异但是大体一样。

一、先决条件

CPU ≥ 4核;

RAM ≥ 16 GB;

磁盘 ≥ 50 GB;

Docker ≥ 24.0.0 & Docker Compose ≥ v2.26.1。

如果尚未在本地计算机(Windows、Mac或Linux)上安装Docker,请参阅安装Docker引擎。

我的系统配置

二、启动RAGFLOW服务器

1、确保 vm.max_map_count ≥ 262144

在 Windows 10 系统上,WSL 2 是运行在虚拟机环境下的,因此直接通过 WSL 2 来检查 vm.max_map_count 的值并不适用。vm.max_map_count 是 Linux 内核的一个参数,而 WSL 2 的内核是托管在 Windows 上的,不能像RAGFLOW手册中那样的方式修改 vm.max_map_count值。

解决办法:

1、cmd命令行中输入下面命令进入WSL2的Linux终端

bash

wsl2、登录到您的 Linux 发行版

bash

sudo su3、临时修改 vm.max_map_count 参数(仅对当前对话有效)

bash

echo 262144 > /proc/sys/vm/max_map_count4、永久修改,编辑 /etc/sysctl.conf 文件(我们选择这种修改方式!)

bash

echo "vm.max_map_count=262144" >> /etc/sysctl.conf5、重新加载 sysctl 配置

bash

sysctl -p6、检查 vm.max_map_count 参数

bash

cat /proc/sys/vm/max_map_count成功截图如下

2、RAGFlow的拉取运行

bash

git clone https://github.com/infiniflow/ragflow.git遇到问题:

解决办法:

见另外一篇博文win10系统访问不了github,com解决办法(亲测有效)

(2)git命令未安装

报错提示:

C:\Users\Administrator>git clone https://github.com/infiniflow/ragflow.git

'git' 不是内部或外部命令,也不是可运行的程序

或批处理文件。

C:\Users\Administrator>

解决办法:

访问Git官网下载最新版本的 Git 安装程序。

运行安装程序

双击下载的安装程序,按照提示进行安装(可自定义安装位置)

一路默认即可。

添加到环境变量

添加 Git 的安装路径

我的路径:

E:\Program Files\Git\bin

注意:根据自己的git安装位置粘贴路径,环境变量粘贴到bin目录下

验证安装

注意:重新打开一个cmd窗口

bash

git --version下图为安装成功界面(版本信息)

再次运行git克隆仓库命令

bash

git clone https://github.com/infiniflow/ragflow.git如下拉取成功截图

运行

bash

cd ragflow/docker

docker compose -f docker-compose.yml up -d注意:镜像文件大约9GB,下载过程可能需要一些时间,请耐心等待。

3、确认服务器状态

bash

docker logs -f ragflow-server

三、RAGFLOW配置 Ollama 连接大模型

1.打开浏览器输入

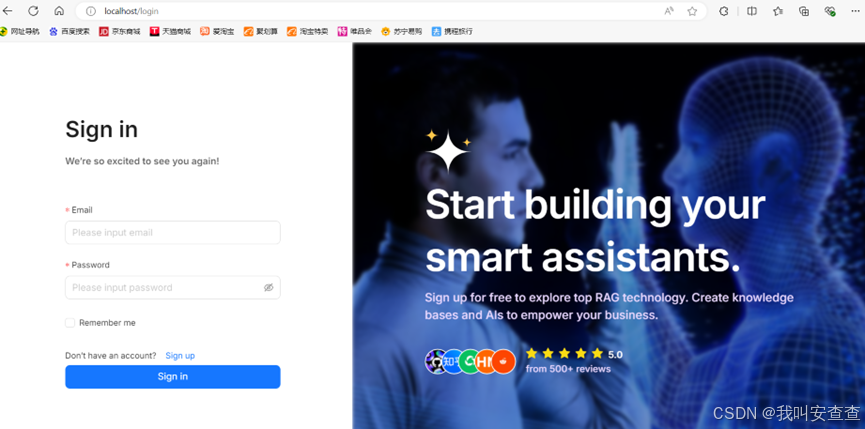

界面如下图所示

注册登录账号

登录后界面,选择配置模型

添加模型

我的基础URL

bash

http://host.docker.internal:11434注意:模型名称对应填好,不知道的使用命令查看一下复制过来

bash

ollama list关于基础URL的几点说明:

(1)Ollama和RAGFlow在同一台机器上运行,基本URL:

(2)Ollama和RAGFlow在同一台机器上运行,并且Ollama或者RAGFLOW在Docker中,基本URL:

(3)Ollama在与RAGFlow不同的机器上运行,基本URL:

http://<IP_OF_OLLAMA_MACHINE>:11434

注意:大家根据自己的实际情况填写基础URL

成功连接截图