🎯 先看看本地部署的运行效果

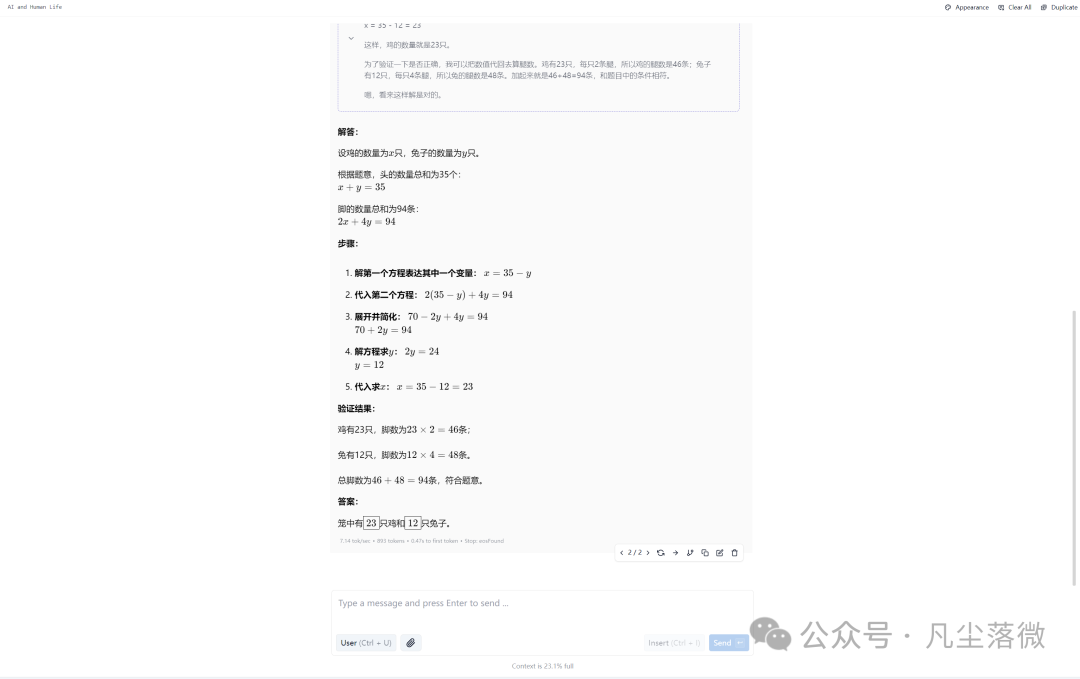

为了测试本地部署的 DeepSeek-R1 是否真的够强,我们随便问了一道经典的"鸡兔同笼"问题 ,考察它的推理能力。

📌 问题示例:

笼子里有鸡和兔,总共有 35 只头,94 只脚,问笼中各有几只鸡和兔?

🔹 AI 的推理过程

DeepSeek-R1 详细推导了方程,并一步步计算出答案 ,展现了清晰的思考逻辑。

📸

🔹 AI 的最终答案

思考后,AI 准确给出了最终答案 ,推理严谨,逻辑缜密。

📸

可以看到,本地运行的 DeepSeek-R1 推理能力极强,完全不输在线 AI!🔥

🛠️ 3 步完成本地部署,轻松上手!

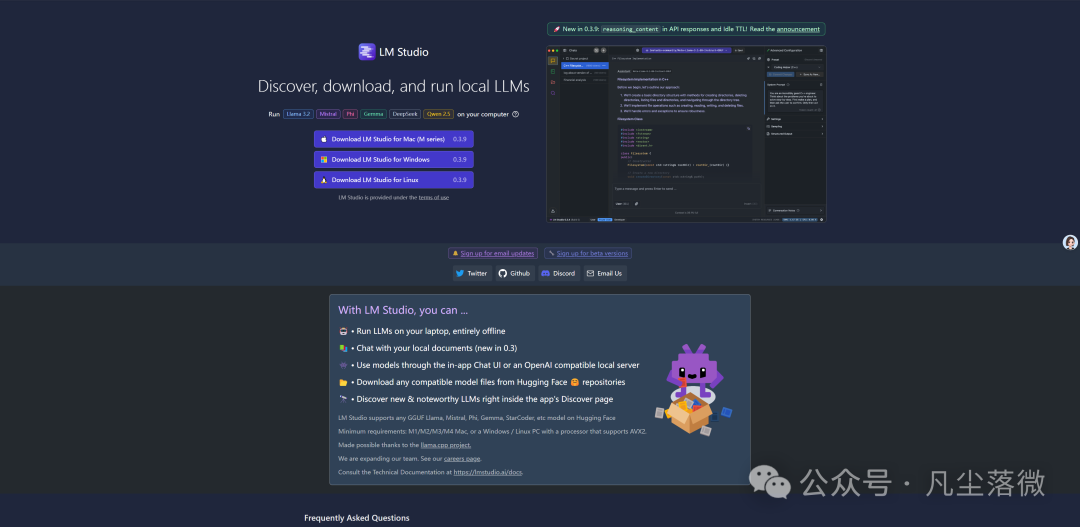

🔹 第 1 步:下载 LM Studio(本地 AI 交互软件)

LM Studio 是一个美观、易用的本地 AI 运行环境,比 Ollama 更加友好。

🔗 官方下载地址:https://lmstudio.ai/

💡 如果官网下载受限,可使用我提供的百度云链接(请私信获取)。

📸

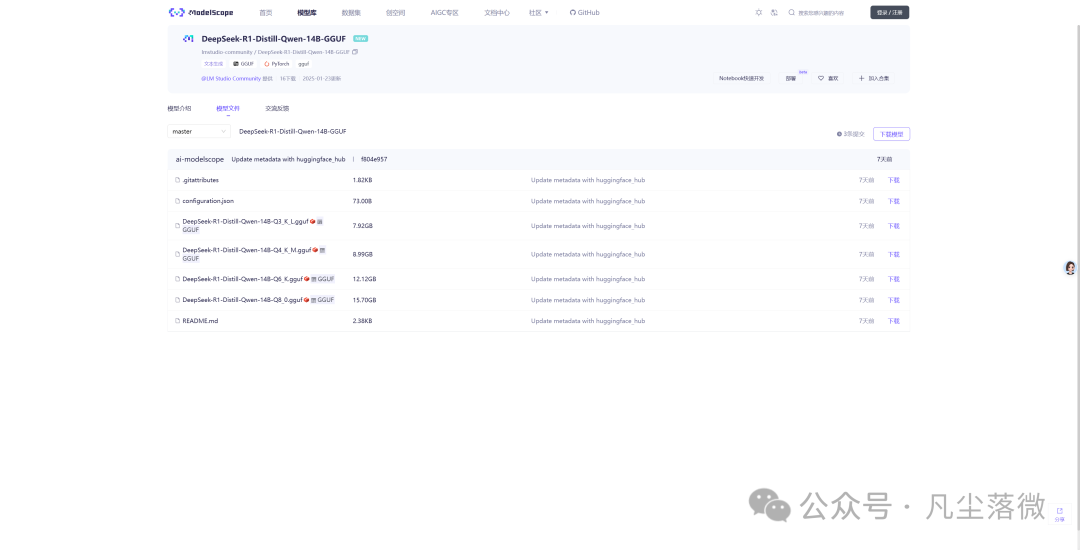

🔹 第 2 步:下载 DeepSeek-R1 模型(AI 的"大脑")

DeepSeek-R1 需要以 GGUF 格式 运行,因此我们从 ModelScope 下载官方优化的模型文件。

🔗 模型下载地址:

https://modelscope.cn/models/lmstudio-community

📌 如何选择合适的模型?

我使用的显卡是 RTX 4070Ti Super(16GB 显存) ,选择的是 14B 模型。你可以根据自己的显存选择更大或更小的模型版本,以保证流畅运行。

📸

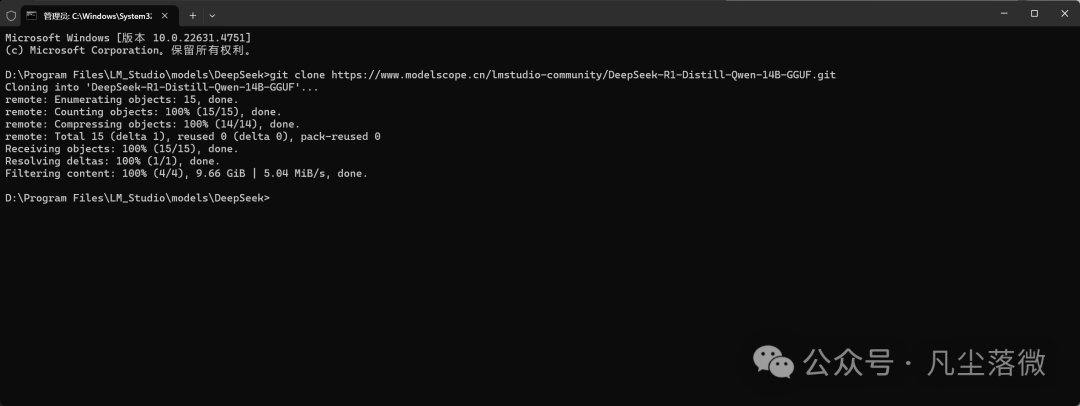

📌 下载方法(使用 Git 命令行):

-

- 安装 Git(Git 官网)

-

- 打开 CMD 终端,输入以下命令下载模型文件:

git clone https://modelscope.cn/models/lmstudio-community/DeepSeek-R1-Distill-Qwen-14B-GGUF.git

-

- 等待下载完成(文件较大,建议保持网络稳定)。

📸

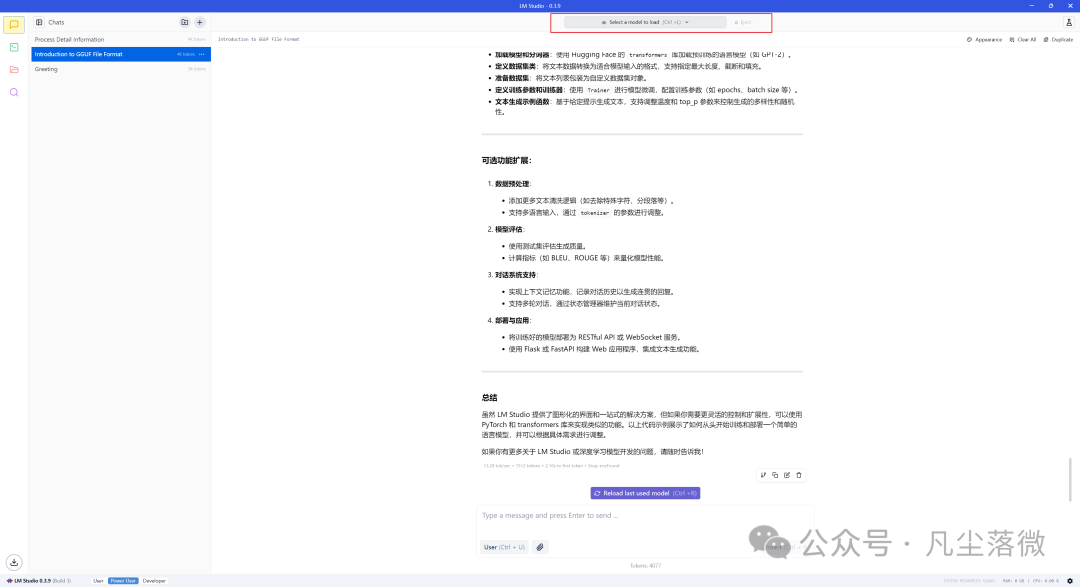

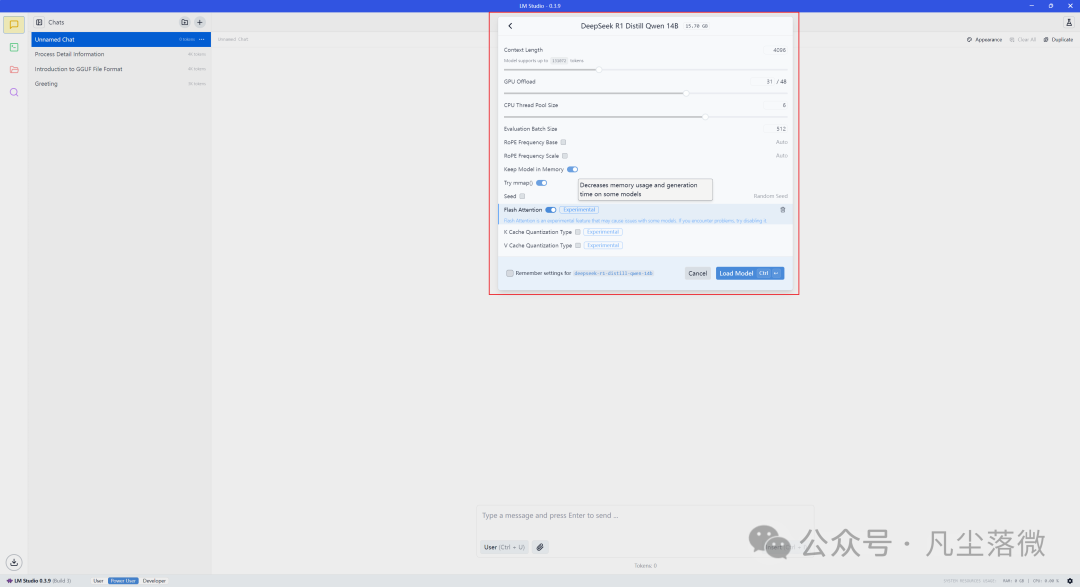

🔹 第 3 步:在 LM Studio 加载模型,开启 AI 对话!

-

- 打开 LM Studio ,找到加载模型的选项(如下图红框所示)。

-

- 选择刚刚下载的 DeepSeek-R1 GGUF 文件,并加载进软件。

-

- 点击下方"聊天框",开始聊天!🎉

📸

📌 个性化设置:

-

• 温度(Temperature):控制 AI 的创造性

-

• 最大输出长度(Max Tokens):控制回答的字数

-

• 响应速度优化

📸

🎯 体验总结:本地 AI 的真正魅力!

✨ 无需联网,随时随地运行 AI

✨ 隐私安全,不上传数据到云端

✨ 推理能力强,媲美 ChatGPT

✨ 完全免费,不用订阅 API

📢 你成功部署了吗?欢迎在评论区分享你的使用体验🔥