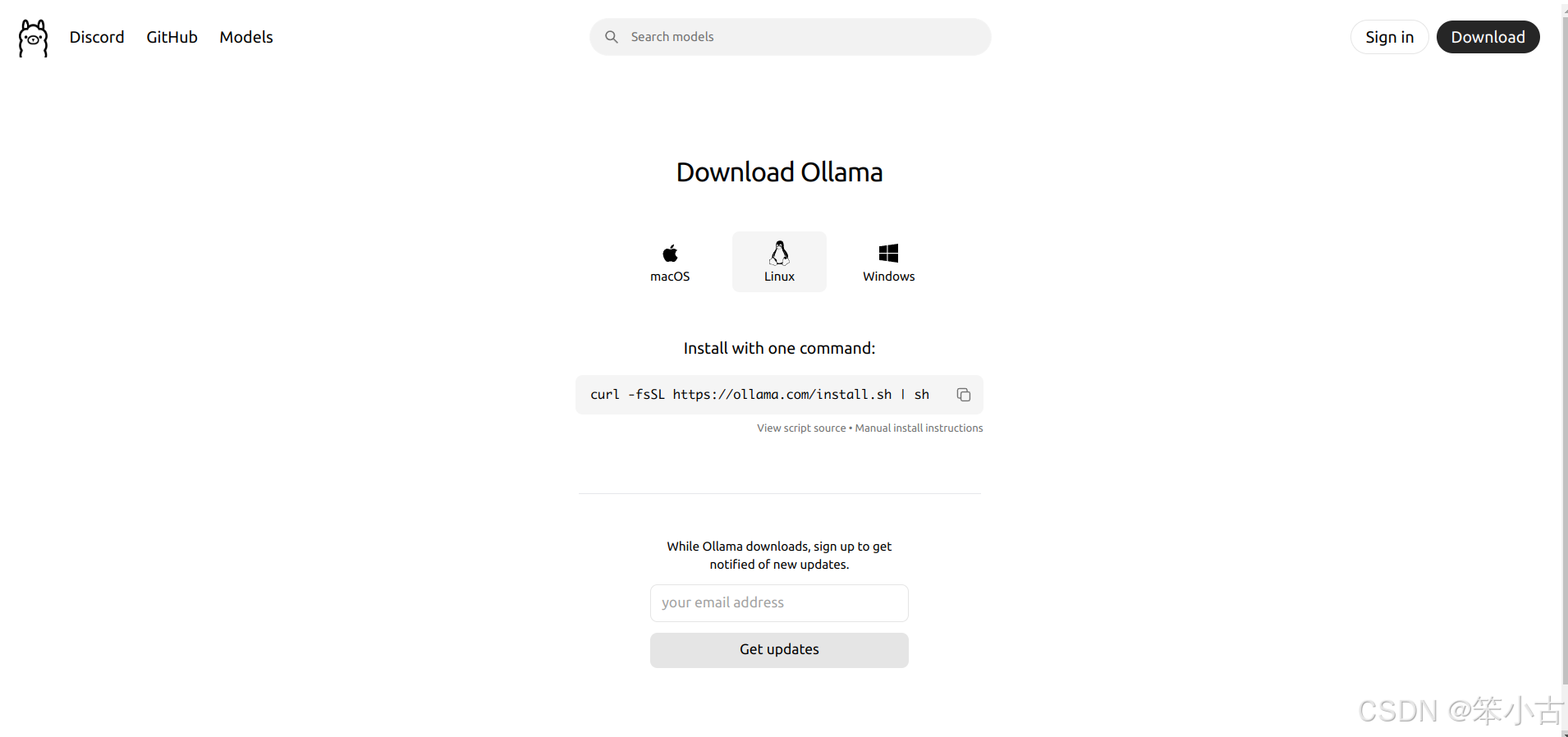

1. 安装Ollama

根据自己的系统下载Ollama,我的是Linux,所以我使用如下命令进行下载安装:

bash

curl -fsSL https://ollama.com/install.sh | sh

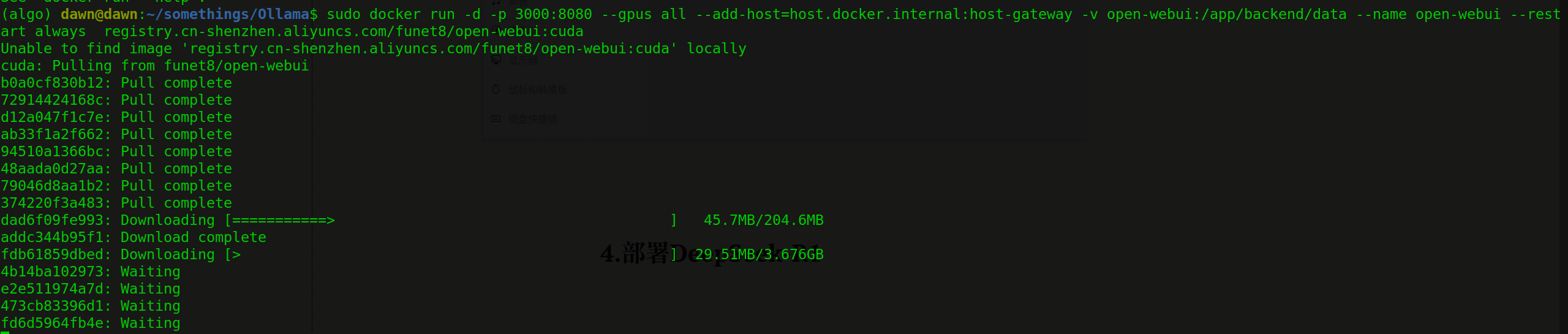

2. 安装Open-WebUI

使用 Docker 的方式部署 open-webui ,使用gpu的话按照如下命令进行

bash

sudo docker run -d -p 3000:8080 --gpus all --add-host=host.docker.internal:host-gateway -v open-webui:/app/backend/data --name open-webui --restart always ghcr.io/open-webui/open-webui:cuda官方的地址可能会出现网络问题,可以使用国内地址:

bash

sudo docker run -d -p 3000:8080 --gpus all --add-host=host.docker.internal:host-gateway -v open-webui:/app/backend/data --name open-webui --restart always registry.cn-shenzhen.aliyuncs.com/funet8/open-webui:cuda

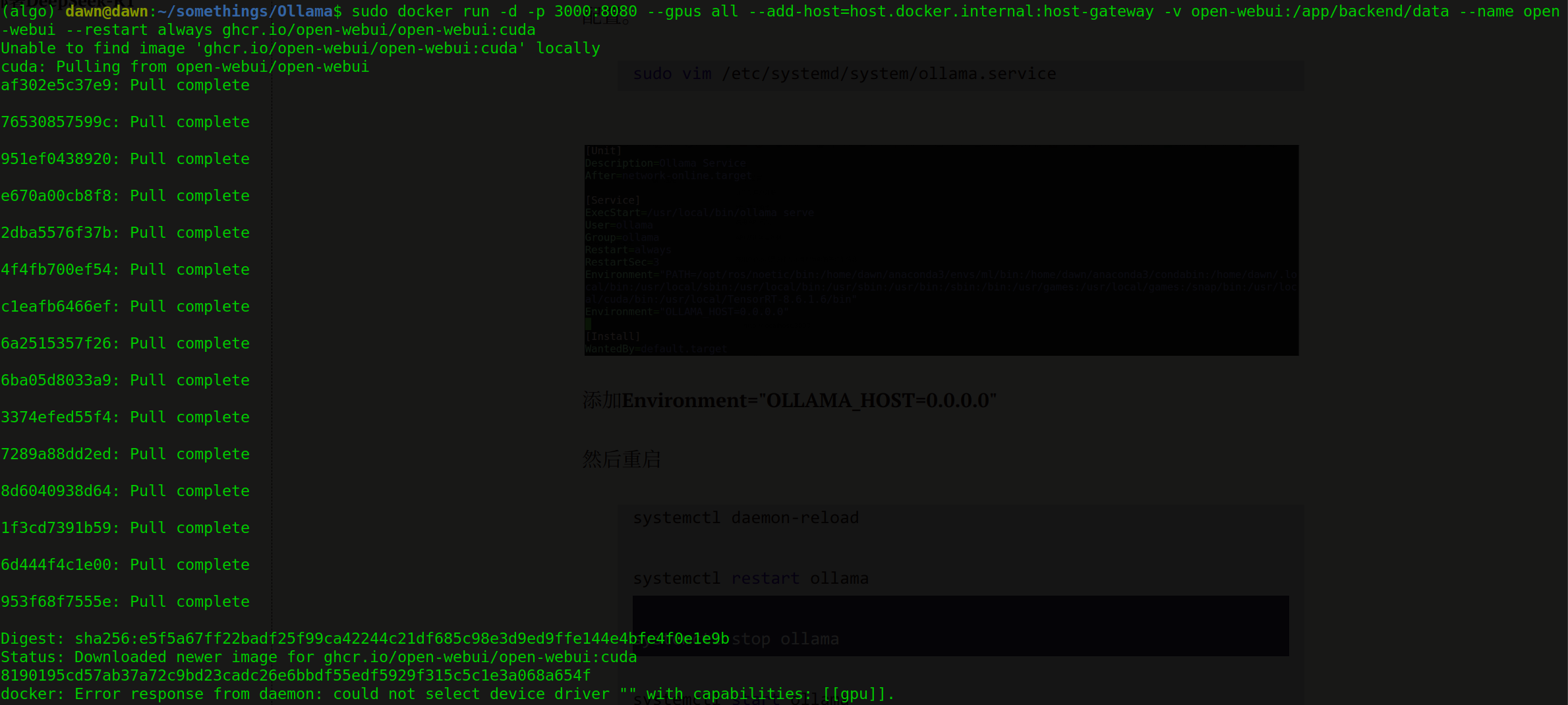

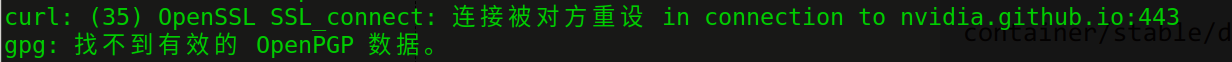

但是我遇到了一个问题,如下

应该是和显卡有关。

需要安装nvidia-container-toolkit并配置docker以使用该工具包。

参考官网给出的指南:https://docs.nvidia.com/datacenter/cloud-native/container-toolkit/latest/install-guide.html

bash

curl -fsSL https://nvidia.github.io/libnvidia-container/gpgkey | sudo gpg --dearmor -o /usr/share/keyrings/nvidia-container-toolkit-keyring.gpg \

&& curl -s -L https://nvidia.github.io/libnvidia-container/stable/deb/nvidia-container-toolkit.list | \

sed 's#deb https://#deb [signed-by=/usr/share/keyrings/nvidia-container-toolkit-keyring.gpg] https://#g' | \

sudo tee /etc/apt/sources.list.d/nvidia-container-toolkit.list如果你遇到了下面这个报错,你就在前面加个sudo重新运行一下,可能还需要覆盖一下历史配置,直接覆盖就行了。

接下来进行安装。

bash

sudo apt-get update

sudo apt-get install -y nvidia-container-toolkit然后还需要编辑一下docker的配置文件令docker运行时连接到gpu

bash

sudo vim /etc/docker/daemon.json将下面这些添加进去

json

{

"default-runtime": "nvidia",

"runtimes": {

"nvidia": {

"path": "nvidia-container-runtime",

"runtimeArgs": []

}

}

}重启docker

bash

sudo systemctl restart docker启动open-webui

bash

sudo docker start open-webui3. 部署DeepSeek-R1

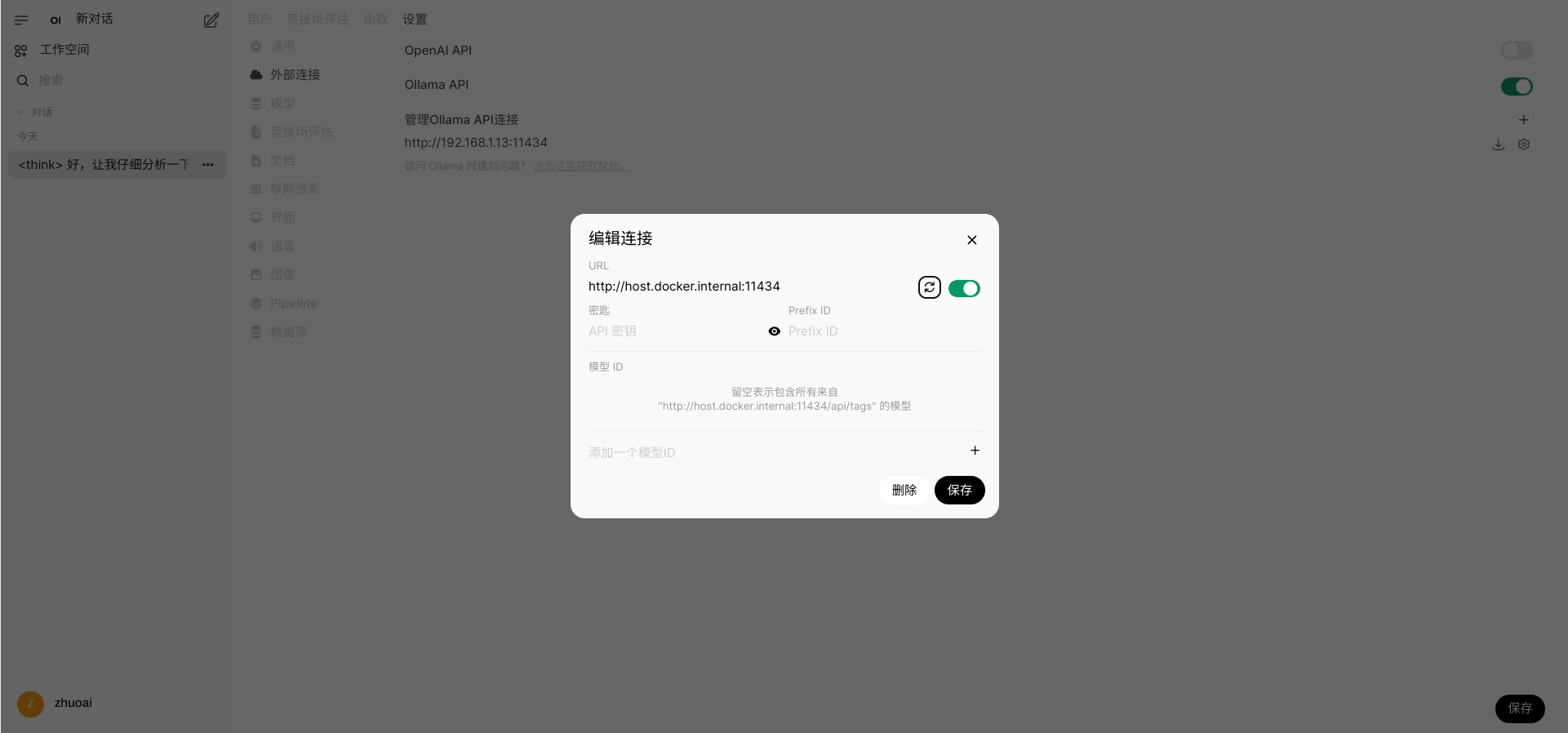

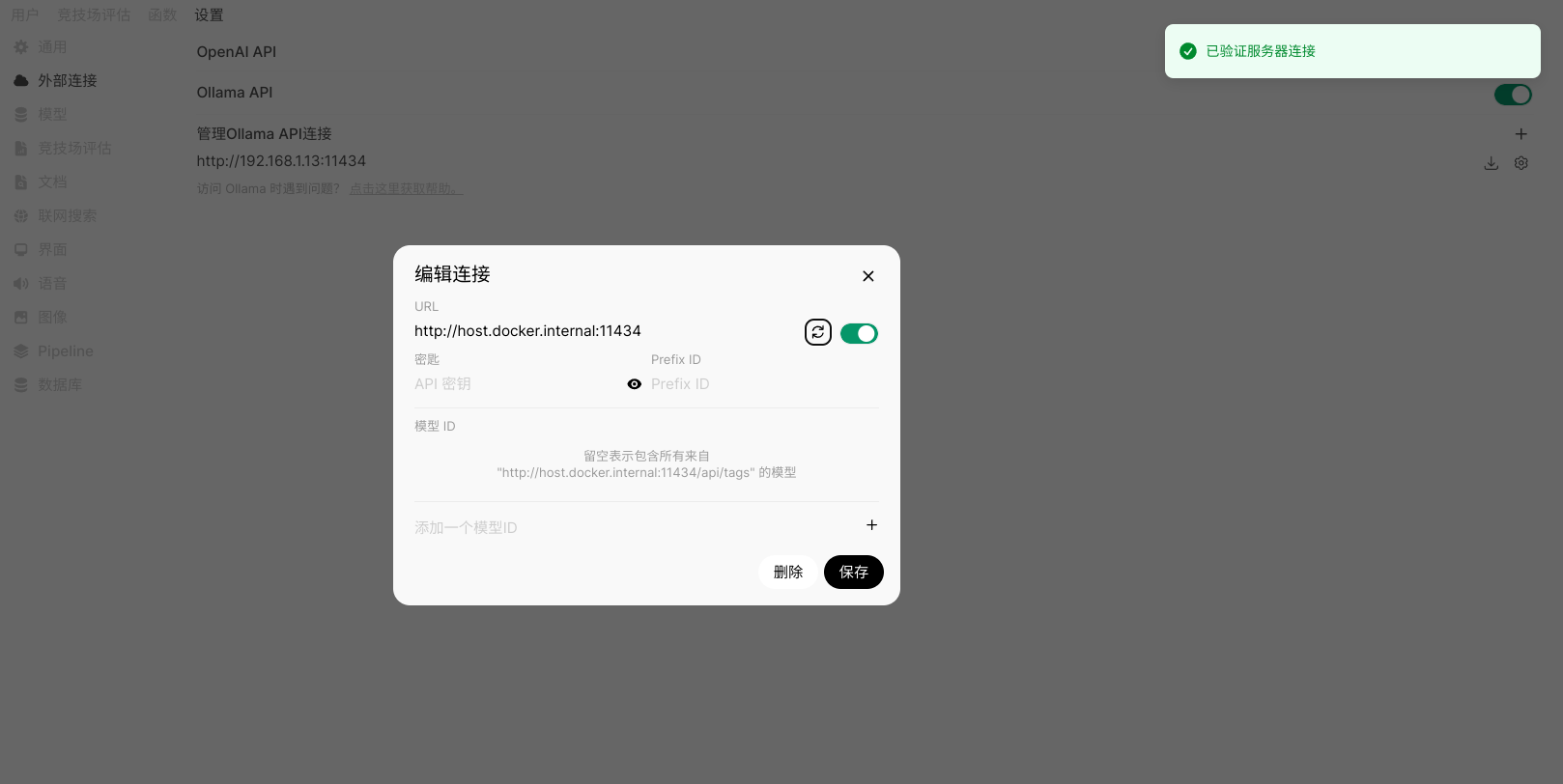

通过在浏览器中输入 http://localhost:3000/ 进入到 open-webui 界面,然后注册一个管理员账号并登录,然后进入设置->管理员设置->外部连接,在 管理 Ollama API 连接 中配置,可以通过ip+端口连接ollama并加载模型。

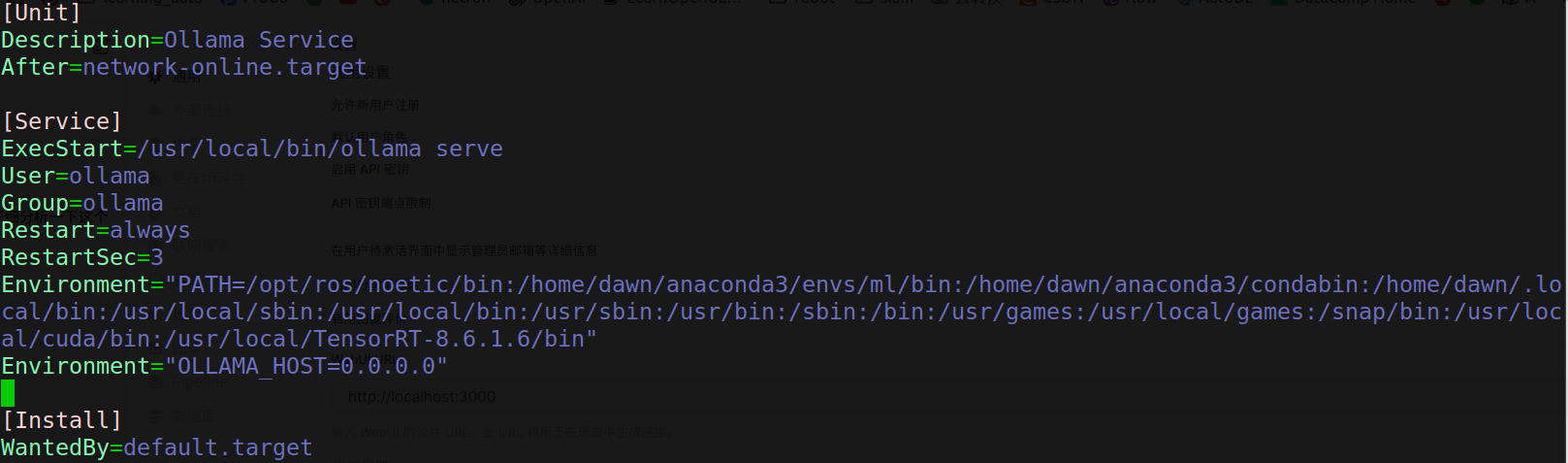

但是可能会遇到无法连接到ollama的问题,可以进行以下修改以进行ollama环境的配置。

bash

sudo vim /etc/systemd/system/ollama.service

添加Environment="OLLAMA_HOST=0.0.0.0"

然后重启

bash

systemctl daemon-reload

systemctl restart ollama

systemctl stop ollama

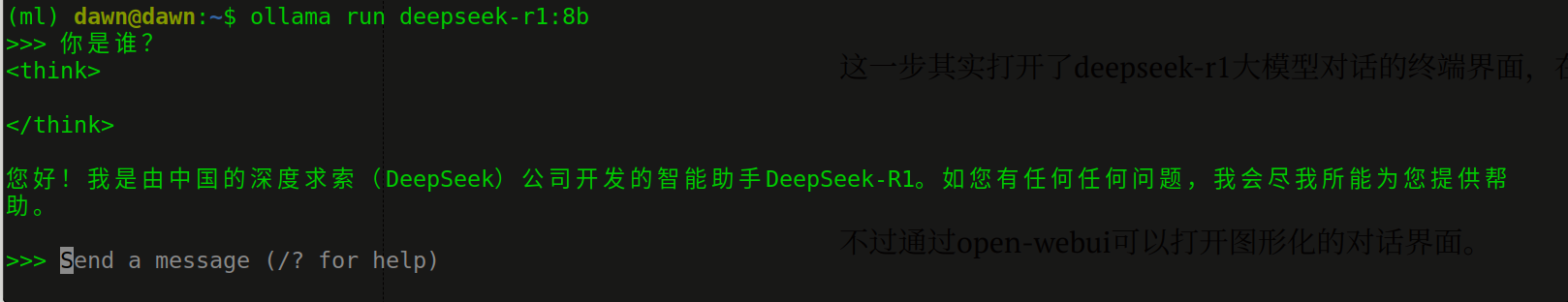

systemctl start ollama启动一个deepseek模型

bash

ollama run deepseek-r1:8b这一步其实打开了deepseek-r1大模型对话的终端界面,在这里也可以进行问答了.

不过通过open-webui可以打开图形化的对话界面,会更加舒适。

点击刷新符号验证是否连接到服务器

如果这里你无法连接成功,可以将URL改为你的ip+端口,端口号这里一般是11434。

现在就可以在对话界面进行使用了。