本指南将带你一步步完成 DeepSeek 本地模型的部署,同时结合 Ollama 提供 API 支持,并使用 Chatbox 作为 UI 界面,实现流畅的离线 AI 交互。

目标:简单易懂,让零基础用户也能顺利完成部署。

1. 安装 Ollama 并运行 DeepSeek

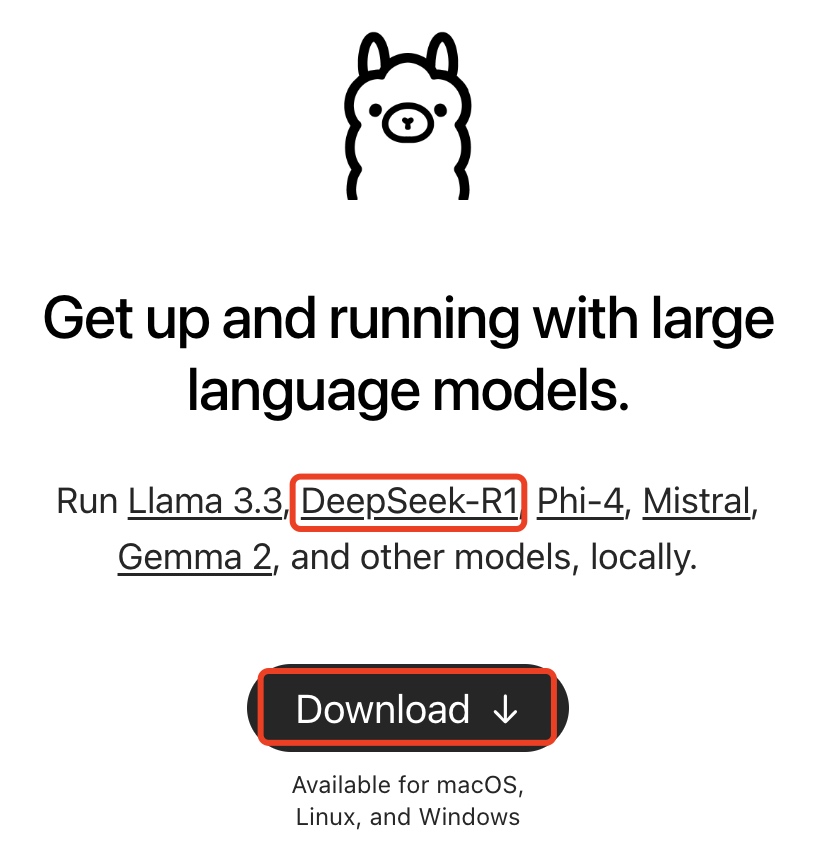

首先,从 Ollama 官方网站下载并安装 Ollama:

- 官网地址:https://ollama.com/

Ollama 现已支持 DeepSeek-R1 模型部署,进入官网后,你可以找到相关介绍:

点击 DeepSeek-R1 链接查看详情,目前 DeepSeek-R1 提供 1.5B、7B、8B、14B、32B、70B、671B 七种参数规模的模型。

由于我的设备性能有限,本次演示选择最小的 1.5B 版本:

选择建议:模型参数越大,效果越强,但对计算资源需求也更高,建议根据自身设备情况选择。

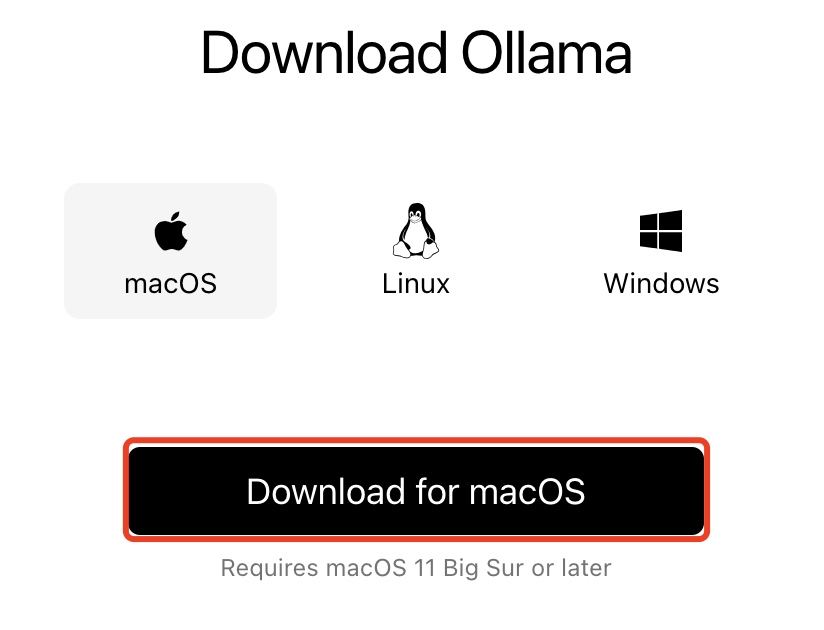

下载并安装 Ollama

在官网下载适用于自己操作系统的 Ollama:

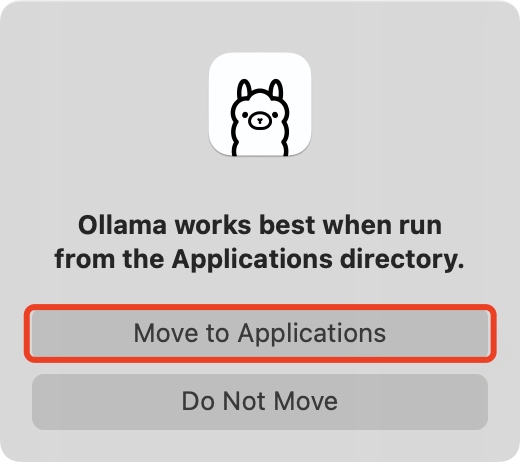

本文演示使用 macOS 版,下载后得到 Ollama-darwin.zip,解压后运行安装:

按照提示,点击 Install 进行安装:

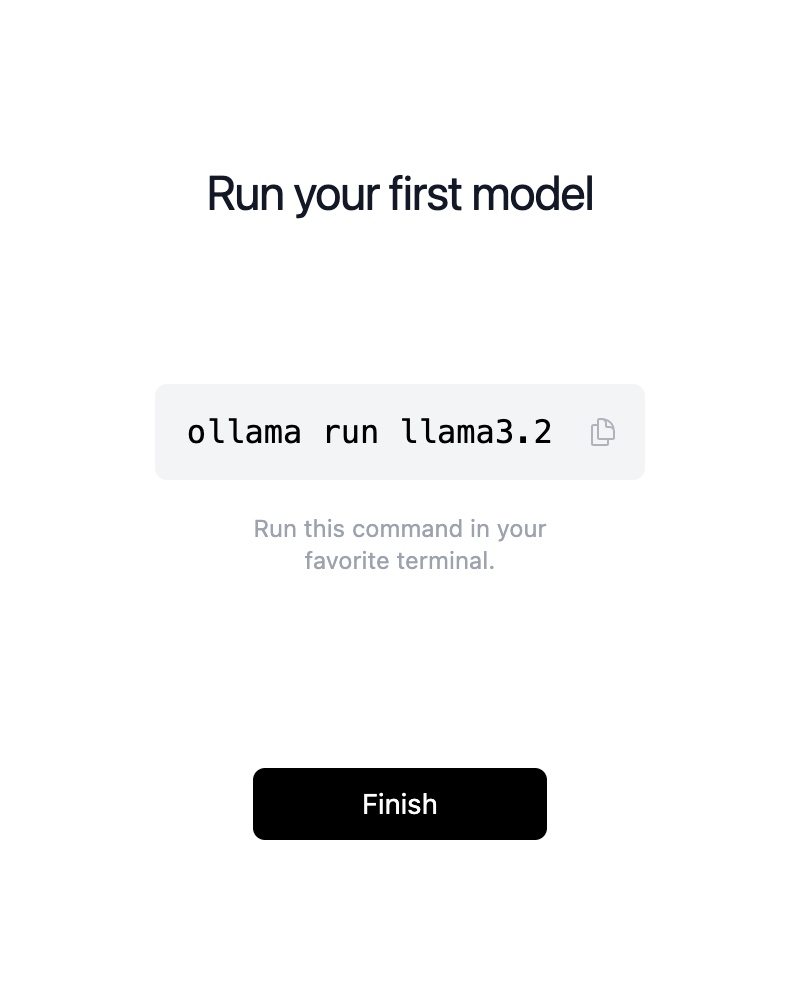

安装完成后,打开终端(Command + Space 搜索 terminal),执行以下命令下载并运行 DeepSeek 1.5B 模型:

sh

ollama run deepseek-r1:1.5b下载并加载模型后,即可开始交互:

sh

>>> Hi! Who are you?

Hi! I'm DeepSeek-R1, an artificial intelligence assistant created by DeepSeek.至此,你已成功运行本地 DeepSeek 模型!

2. 安装 Chatbox 并连接本地 DeepSeek

Chatbox 是一个便捷的 AI 聊天 UI,支持连接本地 Ollama API。

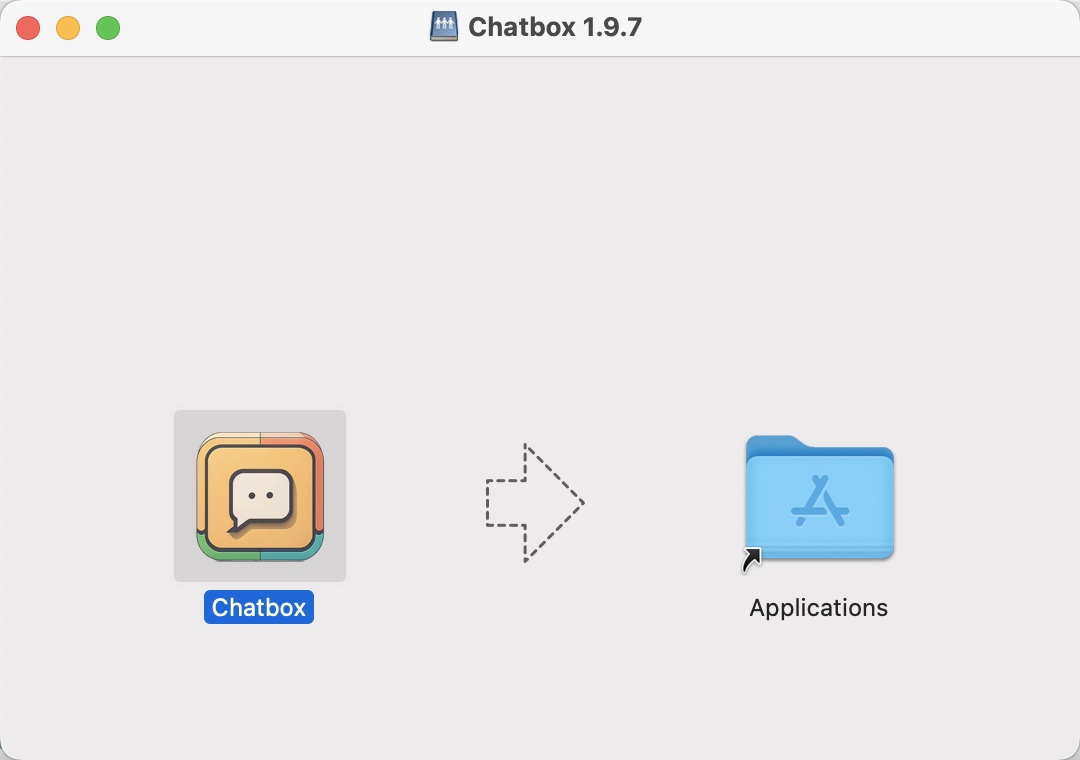

下载安装后,按提示将其拖入 Applications 目录:

配置 Chatbox 连接本地 DeepSeek

Chatbox 支持多种 API 连接方式,不要选择 DeepSeek API ,而是选择 OLLAMA API,这样才能正确识别我们在本地运行的 DeepSeek-R1 1.5B 模型。

配置完成后,即可在 Chatbox 里与本地 DeepSeek 流畅交流。

3. 无需联网,畅快对话

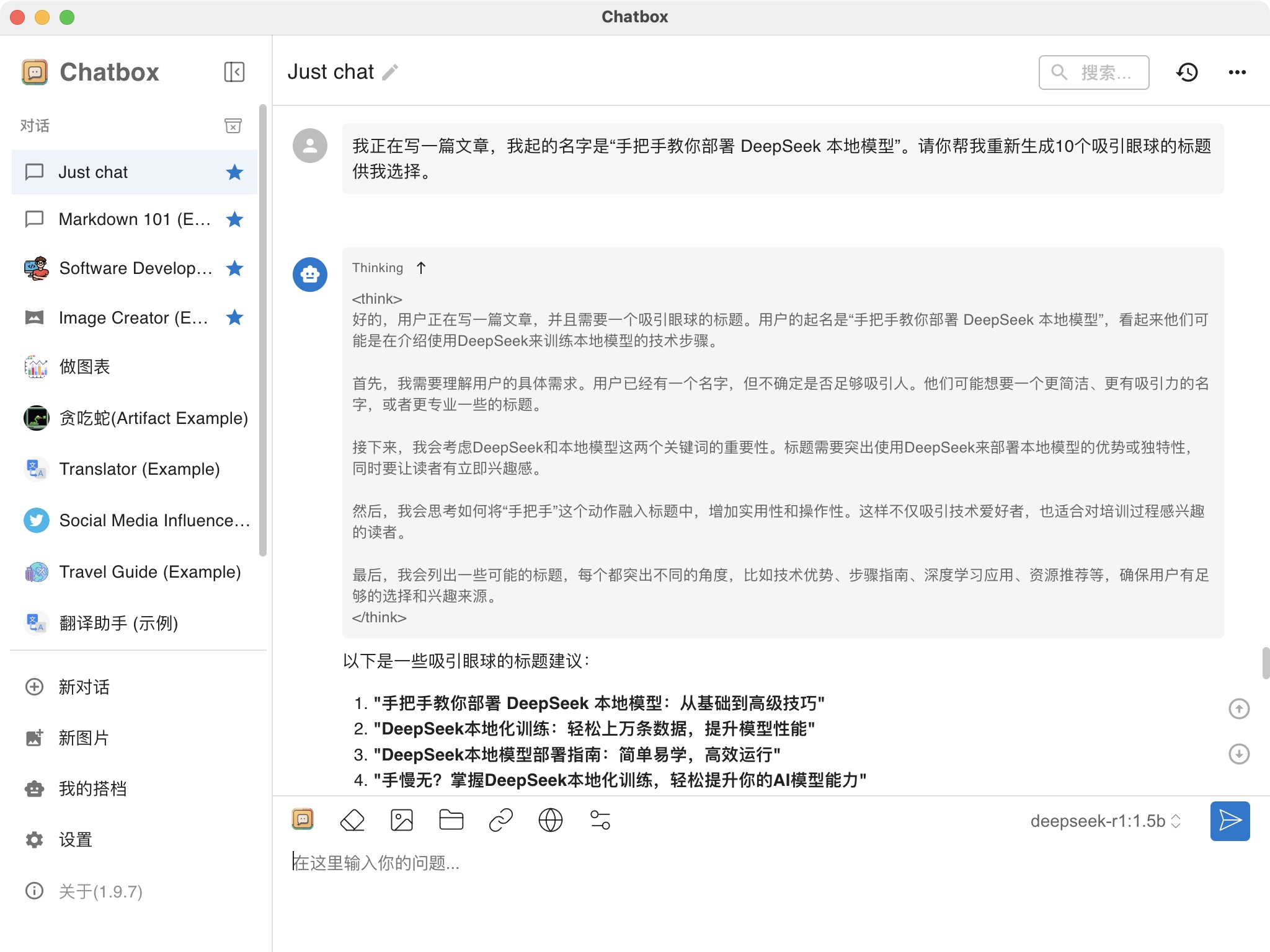

DeepSeek 本地部署的优势之一是可以在无网络状态下使用。例如,我正在撰写本文,可以让 AI 帮助生成多个吸引人的标题:

sh

我正在写一篇文章,标题是"手把手教你部署 DeepSeek 本地模型",请帮我生成 10 个更吸引人的标题。

DeepSeek 迅速返回 10 个备选标题,并给出了思考过程,响应速度即使在老旧设备上也十分流畅。

结语

通过本教程,你已经成功部署 DeepSeek 本地模型,并结合 Ollama 和 Chatbox 实现了完整的离线 AI 交互。希望本指南能帮助你轻松上手,体验强大的 AI 聊天能力!