大家好,我是编程乐趣。

DeepSeek大火,网络上也看到很多人分享本地部署心得。但想要更细了解,还是要自己本地部署一次。

我这次部署目标,就是在局域网服务器部署,并让局域网其他电脑可以直接访问。

选择方案也是当前非常流行的:Ollma+Page Assist浏览器插件。

一、安装Ollama

Ollama作为本地部署大模型的方案,还是非常不错的。

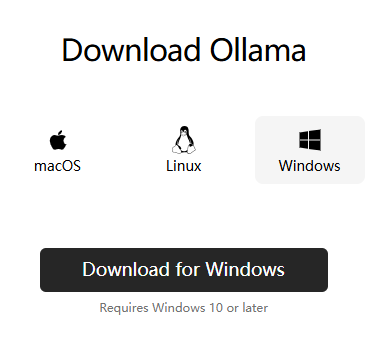

1、跨平台:支持 macOS、Linux 和 Windows。

2、市面主流开源模型都支持:包括Llama 3.3, DeepSeek-R1, Phi-4, Gemma 2等54个开源模型。

3、REST API:Ollama提供对外API能力,想要自己开发客户端、或者集成到应用系统都是非常方便的。

4、生态完善:众多开源Web项目、开源桌面软件支持Ollama,还有终端工具、移动应用、开发工具库等开源项目。

下载地址:https://ollama.com/download

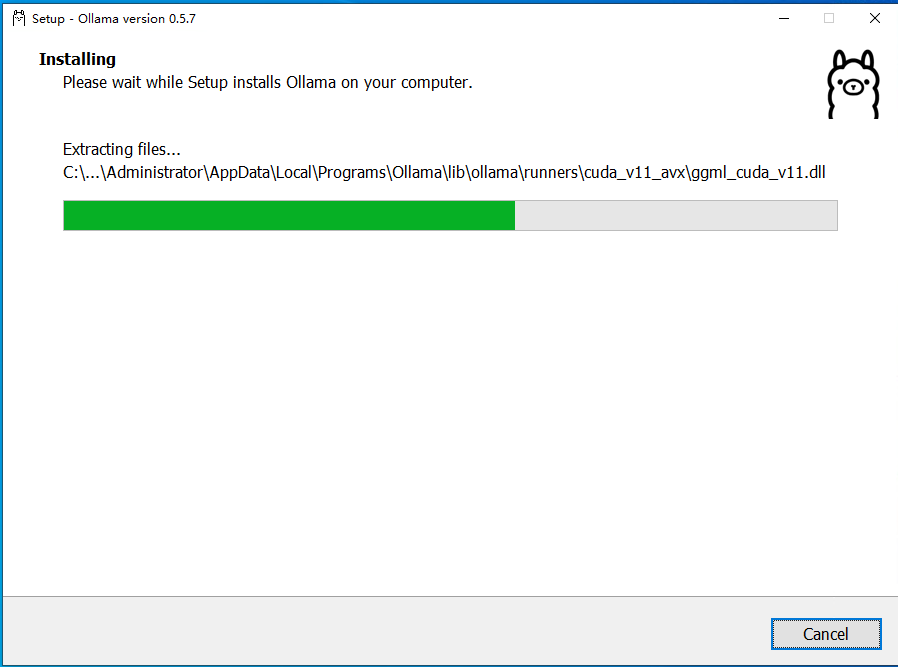

安装Ollama还是比较简单的,下载安装包后,直接安装就行。我这边选择的是Windows版本。

二、修改Ollama默认配置

Ollama安装后,我们还需要根据需求修改对应的配置。

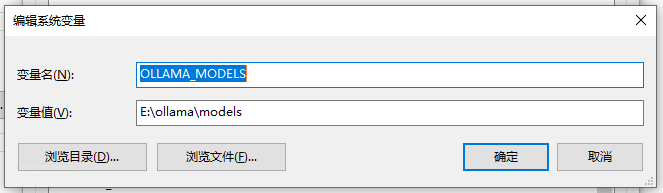

我们使用Ollama时,需要从网络下载大模型,默认存储在C盘,很容易导致C盘空间不足。

可以通过修改系统环境变量,来修改配置。

添加环境变量:OLLAMA_MODELS,并指定模型路径。

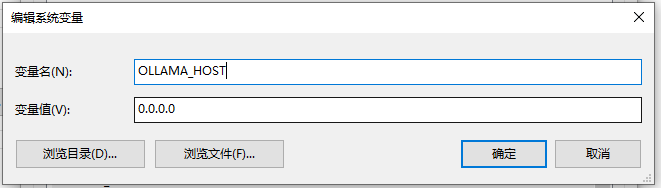

添加环境变量:OLLAMA_HOST ,并允许外部访问,这边填写:0.0.0.0,代表允许任何电脑访问。

修改配置后,记得重启Ollama。

我暂时就需要这两个,其他更多配置信息,大家可以查看官方文档:

https://github.com/ollama/ollama/tree/main/docs

三、下载并安装模型

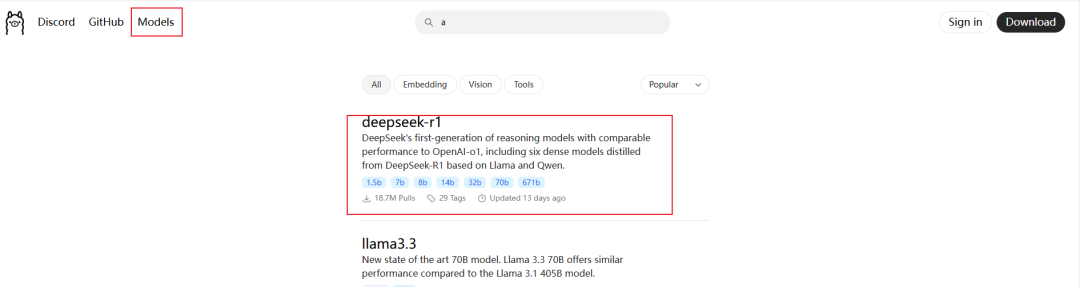

Ollama支持模型非常多,我们这边选择的是:deepseek-r1。

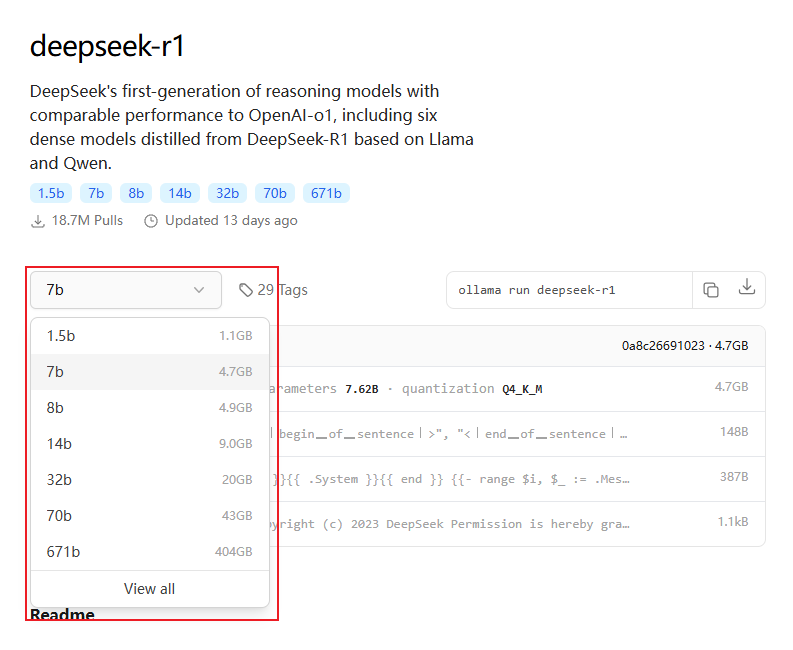

选择对应的模型,我们就可以看到模型的相信介绍、各种参数的模型。

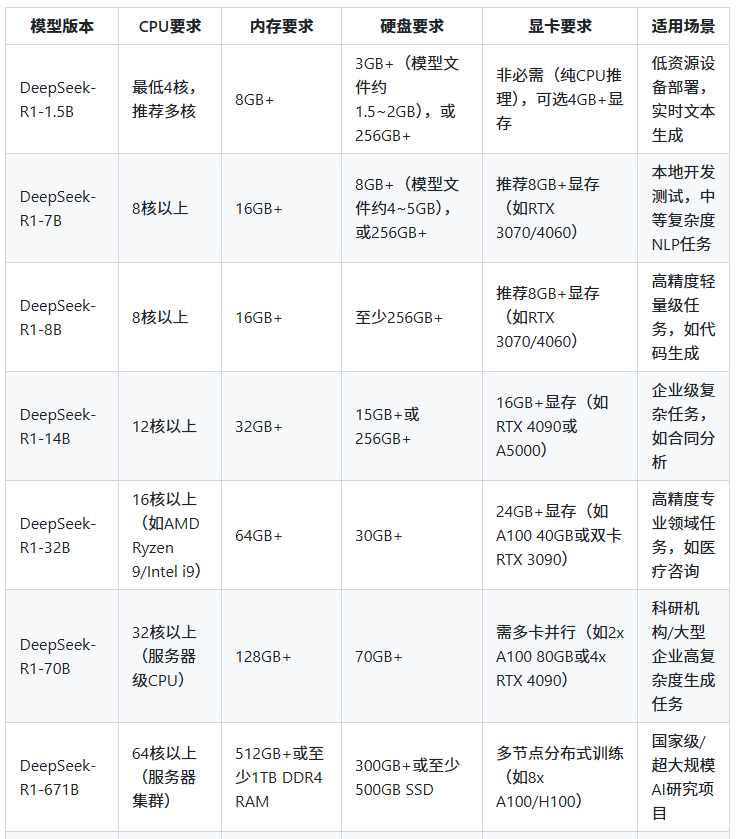

各个版本模型对硬件要求,官方没有明确的说明,根据网友分享的大概整理如下,大家可以根据自己的电脑配置选择模型。

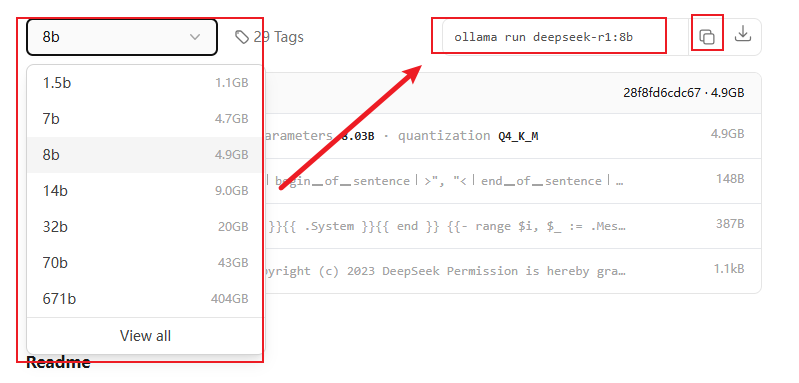

安装模型也很简单,选择对应版本的模型,拷贝命令就行。

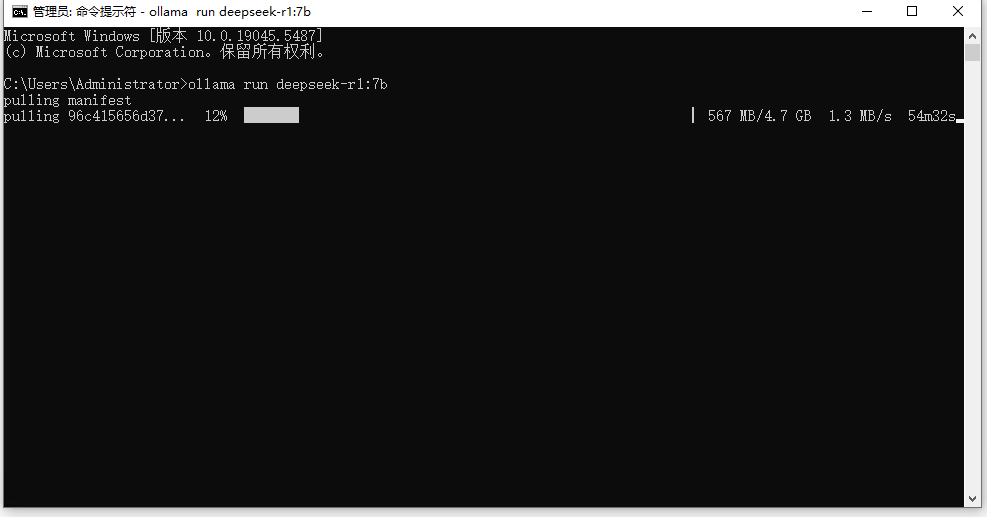

比如安装7b的命令如下:

ollama run deepseek-r1:7b在命令窗口输入以上命令,就会自动下载。

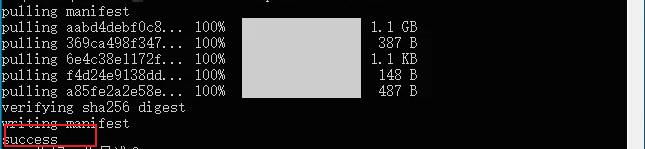

耐心等待,等出现success就代表安装成功了。

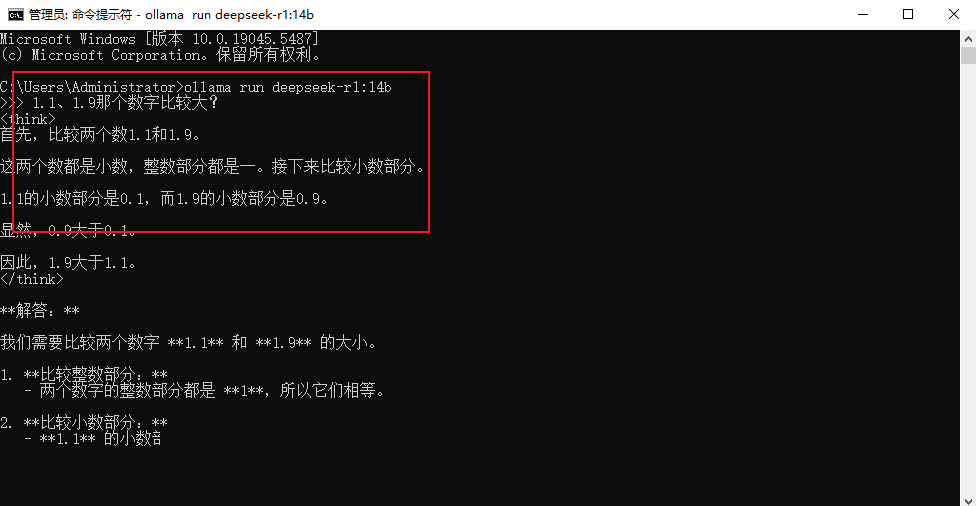

安装成功后,我们就可以直接在命令窗口进行使用了。

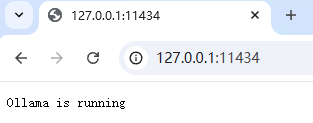

同时在浏览器访问:http://127.0.0.1:11434,有如下提示也代表启动成功了。

四、API调用

Ollama也为我们提供API接口功能,想要自己开发客户端、或者集成到应用系统都是非常方便的。

Ollama相关生态也非常完善,我们直接使用C#版本Ollama的SDK,就可以快速开发,下面一起看看简单例子。

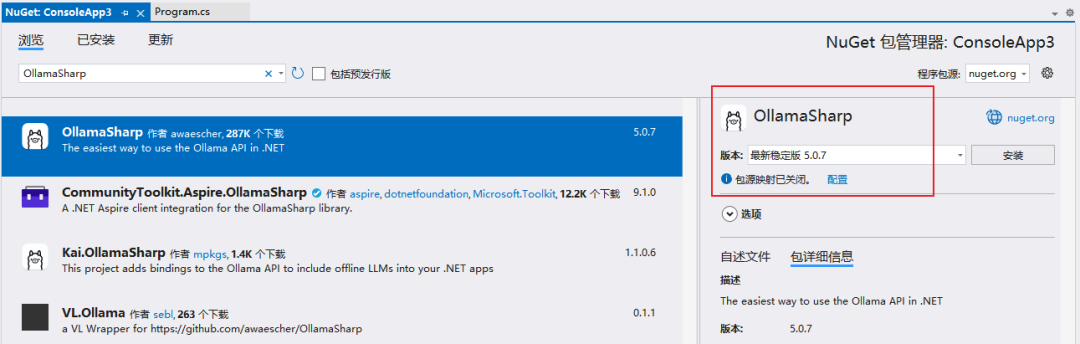

1、安装依赖包:OllamaSharp

2、示例代码

using Microsoft.Extensions.AI;

using OllamaSharp;

Uri modelEndpoint = new("http://localhost:11434");

//指定模型

string modelName = "deepseek-r1:14b";

var chatClient = new OllamaApiClient(modelEndpoint, modelName);

//提问

string question = "我是编程小白,应该如何学习编程?";

var response = chatClient.GetStreamingResponseAsync(question);

Console.WriteLine($">>> 你: {question}");

Console.Write(">>>");

Console.WriteLine(">>> DeepSeek: ");

//输出

await foreach (var item in response)

{

Console.Write(item);

}

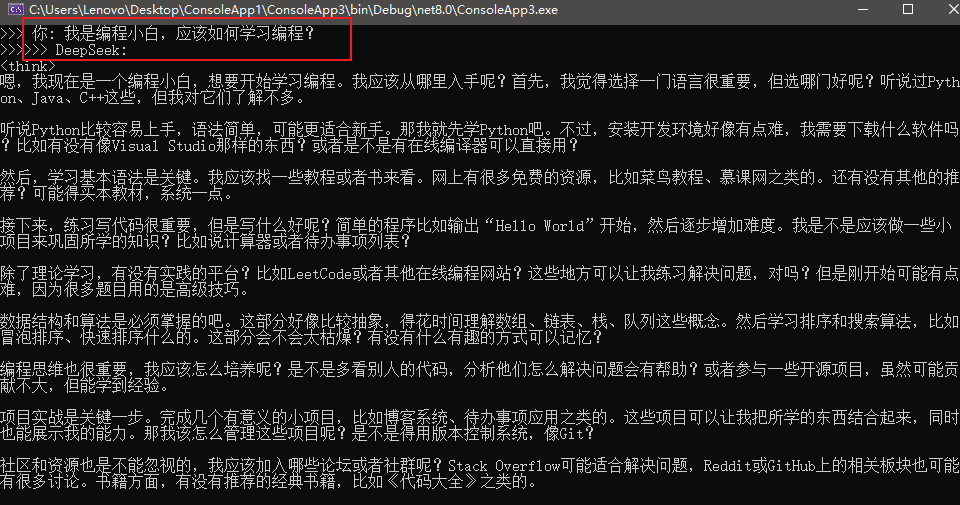

Console.ReadLine();3、效果如下

Ollama相关的API接口,也可以查看官方文档。

https://github.com/ollama/ollama/blob/main/docs/api.md

五、Ollama的客户端

在命令窗口使用DeepSeek,肯定是不方便的。自己开发客户端,又需要大量时间。

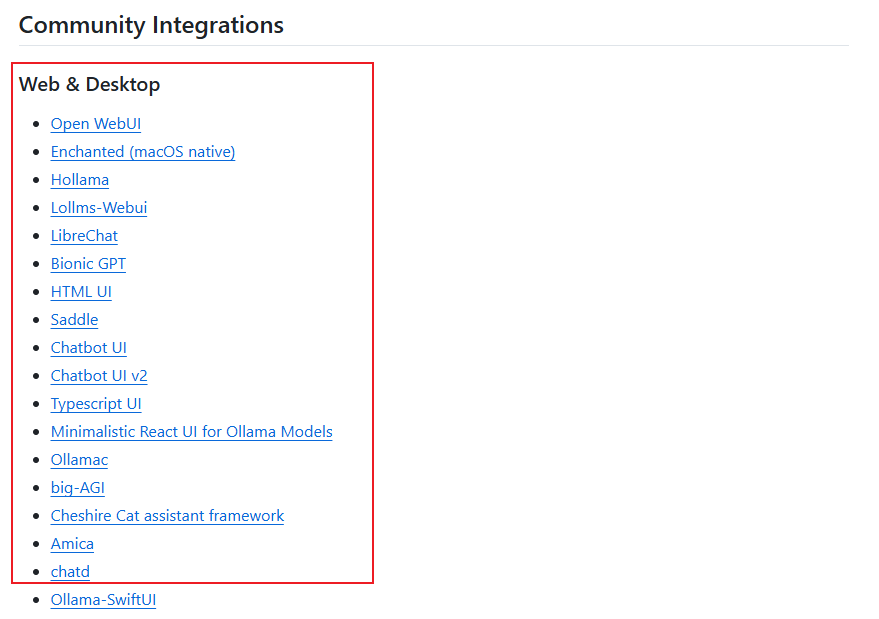

Ollama的客户端是非常众多的,而且都是开源的项目,包括:Web网页版本、桌面应用、浏览器插件、移动端APP等。

每一个客户端提供的功能也非常丰富,并且都不一样,包括:OCR图片识别、语音识别、文档解析等。

大家可以根据自己的需求自行选择。

https://github.com/ollama/ollama

六、Page Assist浏览器插件

我这边的是选择浏览器插件,比较灵活。

在Chrome应用商店,安装浏览器插件:Page Assist。

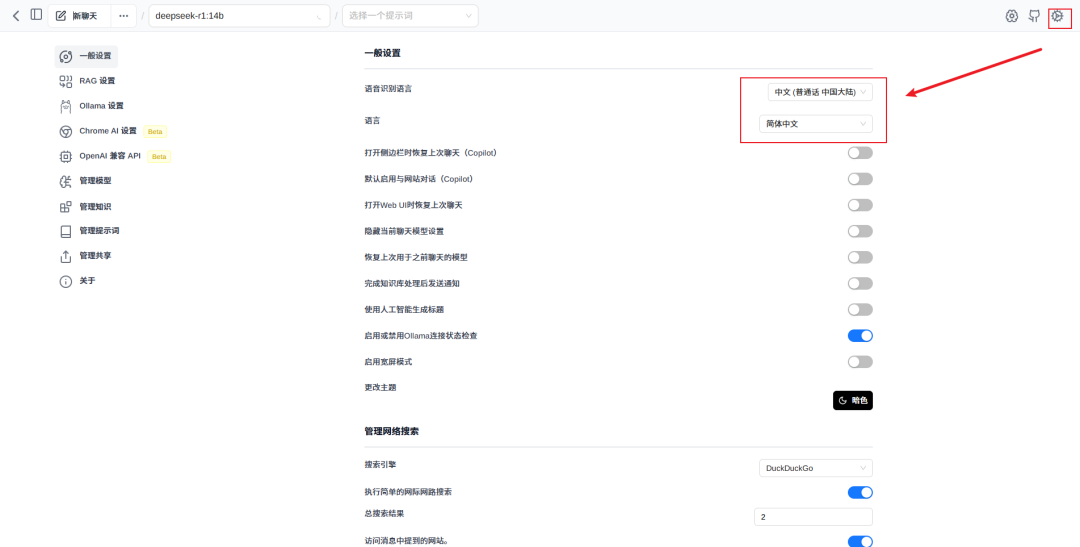

安装后打开插件,把语音识别、界面语音修改为中文,方便我们使用。

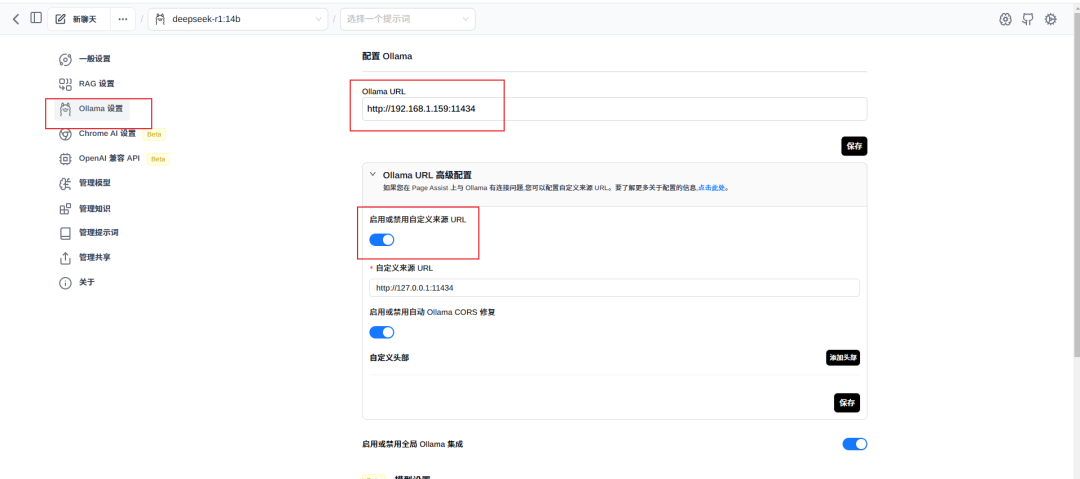

修改Ollama的配置:

1、Ollama URL修改为Ollama服务器的地址。

2、在Ollama 高级配置中,启用:启用或禁用自定义来源 URL,这样才能访问。

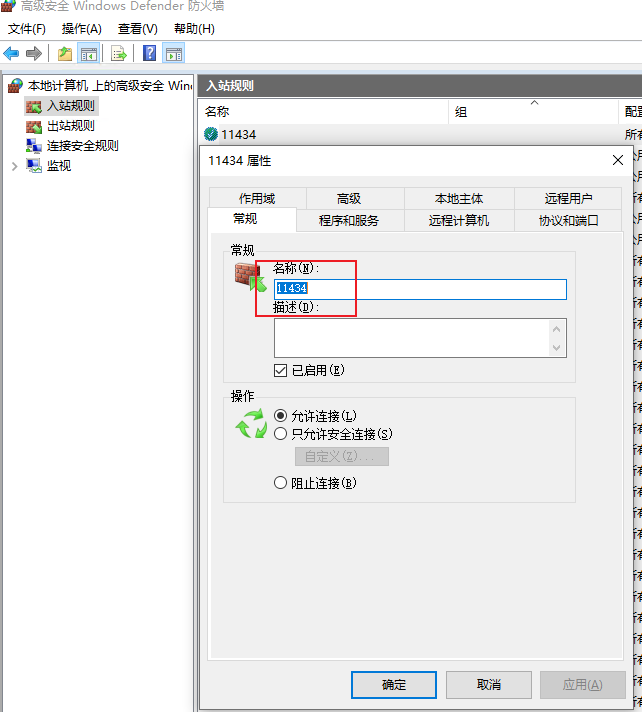

Ollama服务器需要关闭防火墙,或者在入站规则里开启端口:11434。

完成以上配置后,我们就可以使用了。

使用的时候,选择对应的模型版本就可以了。

好了,今天就分享到这边!

- End -

更多开源项目: https://github.com/bianchenglequ/NetCodeTop

我是编程乐趣,一个.Net开发经验老程序员,欢迎"关注"我,每天为你分享开源项目和编程知识。

也欢迎加入【.Net技术编程交流社区】,和大家共同学习交流!,

点击加入 :https://bbs.csdn.net/topics/613465368