【新智元导读】国内最大 MCP 中文社区上线了,支付宝、MiniMax 明星服务在魔搭 MCP 广场独家首发,还有近 1500 款 MCP 服务全领域覆盖,再次降低 AI 开发门槛。

MCP 玩家,又新增一员!这次还是全开源开放的!

今天,中国第一开源社区魔搭 ModelScope 重磅上线「MCP 广场」,国内最大 MCP 中文社区真的来了。

近 1500 多款热门 MCP 同时登陆,覆盖了搜索、地图、支付、开发者工具等前沿领域。

值得一的是,支付宝、MiniMax 明星 MCP 服务更是独家首发。

接下来,我们演示下如何在 Cline 这样的智能体工具中,只需「动动嘴」,就能实现支付宝 MCP 服务配置。

比如让它创作诗歌,只能免费写一首,之后写诗需要充值,每首扣除 0.01 元,剩余的钱还可以退回。

写出详细的提示后,Cline 就可以自动调用支付宝的 MCP 服务,创建支付链接、生成支付二维码,查询确认用户支付后再继续生成诗歌。

这种全新的调用多模态模型的方法,也展现了 MCP 更广阔的应用空间。

开发效率倍增

迈向 AI 互操作生态未来

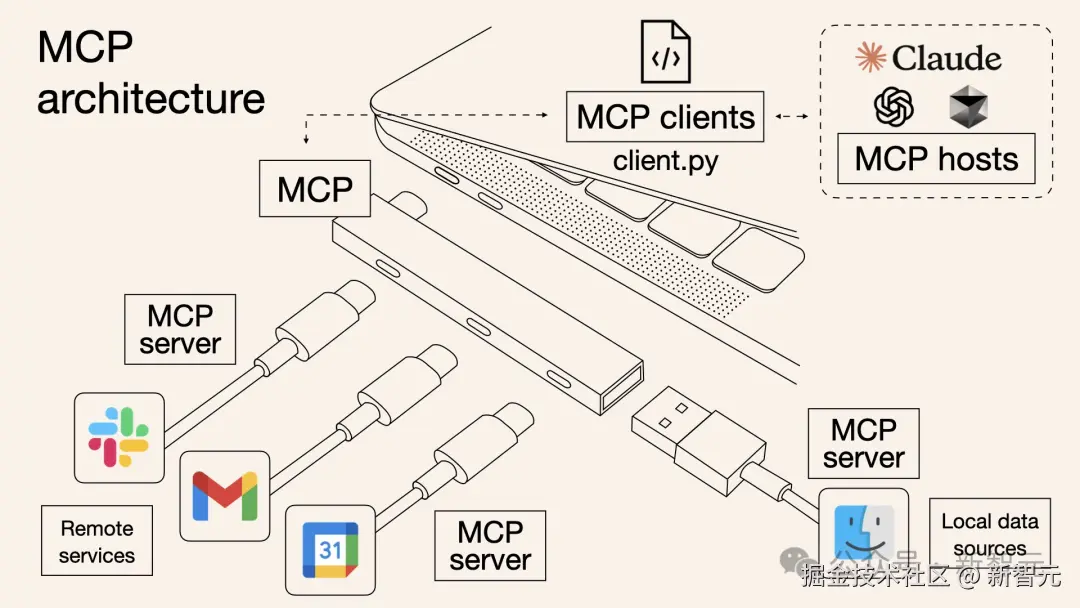

MCP 全称是「模型上下文协议」(Model Context Protocol),被誉为「AI 界的 USB-C 接口」。

无论是云端模型与本地数据交互,还是多模态模型之间的协同,「一根线」就可连接到不同 AI 模型、工具、数据,可极大简化开发者的集成工作。

为什么 MCP 如此重要?

2025 年,成为科技圈认定的「智能体元年」,AI 智能体的爆发式增长正在重塑各行各业。

MCP 的出现,恰如一座桥梁,连接了高性能模型、外部资源与实际应用场景。

在开发过程中,开发者需要调用的工具越多,越能凸显出 MCP 的价值,比如同样是 100 个 AI 智能体和 100 个外部工具:

传统 API:配置次数为 100×100=10000

MCP:配置次数为 100+100=200

开发者摆脱锁定,拥抱灵活

MCP 另一个重大的突破在于,实现了与供应商解耦的开发。

传统的 AI 搭建中,开发者通常被锁定在某个 AI 供应商的生态系统,或单一的工具链中。比如,为 OpenAI 插件编写的代码难以复用至其他平台。

MCP 开放标准,彻底打破了这一桎梏。

无论是 Claude、Gemini,还是 Qwen、DeepSeek 等开源大模型,开发者都能无缝调用任何 MCP 服务器。

这种灵活性让开发者可以自由「混搭」,假设用 Claude 处理文本任务,同时可以切换到开源模型处理多模态任务,而底层 MCP 集成保持不变。

也正因此,开发者无需关心底层工具的复杂实现,只需聚焦于创意本身。

对于工具开发者来说,也是一个福音。传统工具依赖 GUI/API 面向人类用户,而 MCP 让工具天生具备 AI 驱动的能力。

举个栗子,Unity MCP 服务器的创建者称,MCP 可以让 Claude 与 Unity 直接交流,全程只用一个提示就能创建整个游戏。

这样不仅加快了测试速度,也预示着一个未来,AI 成为软件的「一等用户」,而非事后才考虑的对象。

AI 智能体效率,指数级飙升

不仅如此,MCP 还赋予了智能体前所未有的能力扩展。

过去,AI 智能体需要依赖开发者预设的自定义插件,才能从第三方应用程序中获取某些信息,功能大幅受限。

如今,MCP 的出现让 AI 直接开箱即用处理多种任务,多系统自动化、智能体的应用场景被极大地扩宽。

一个典型的案例是,AI 智能体通过 MCP 服务器,从发送邮件、更新表格,再到创建 Jira 工单,流畅地完成复杂工作流。

开发者 Siddharth Ahuja 在连接 Blender 后感叹道,MCP 真正开启了智能自动化的新时代。

再比如,想象一个助手,它能够自主扫描 GitHub 提交记录,提前发现 bug;或是在读取日历时,在截止日期前提醒团队。

MCP 的崛起,正在重塑 AI 智能体生态系统,开启新一代自主、多模态、深度集成的 AI 体验。

而魔搭 MCP 广场正成为这一愿景的实验田。

所有人都在拥抱 MCP

魔搭上线最大 MCP 中文社区

2024 年 11 月,这套开源的标准化协议由 Anthropic 首次推出,如今正成为科技大厂们认可的统一标准。

今年年初,海外平台如 Cursor、Windsurf、Cline 等率先接入 MCP 协议。

3 月底,奥特曼官宣 OpenAI 旗下一系列产品将全面支持 MCP,包括 Agents SDK、ChatGPT 桌面端和 Responses API。

|----------------------------------------------------------------------------------------------------------|----------------------------------------------------------------------------------------------------------|

|  |

|  |

|

仅仅几天后, 谷歌也在 Gemini API 中新增了对 MCP 的支持。

在国内,阿里云对 MCP 展开了惊人的生态战略布局。

先是 4 月 9 日,阿里云百练上线了业界首个全生命周期 MCP 服务;10 日,无影推出支持 MCP 协议的云电脑服务 AgenBay。

而现在,随着 MCP 广场的上线,不仅标志着魔搭社区在 AI 开源生态建设又一次突破,也为全球 AI 开源者开启了通往智能化未来新大门。

这种「模型 × MCP」的组合,不仅降低了 AI 应用的开发门槛,还为 Agent 生态的未来探索提供了无限可能。

5 万开源模型,「搭积木」搭出 AI 的想象力

从 5 万个模型,到数据集,到工具,到创空间,再到 MCP 广场,魔搭社区上的每个功能模块均能以解耦的原子化形式输出、对外开放,开发者不必局限在平台内部,而是可以像搭积木一样自由组合。

除此以外,魔搭上还活跃着许多的多模态模型,同样可以封装成标准的 MCP 服务对外。

开发者们未来也都可以在魔搭上贡献自己的 MCP,魔搭还可以为优质的 MCP 服务提供托管服务,让开发者在不同环境上直接获取 MCP 能力,真正发挥出 AI 开源社区的共创优势。

推出 MCP Bench,MCP 解锁新型生态关系

随着 MCP 的爆火,市面上也涌现出了大量的 MCP 服务,但良莠不齐的质量,让开发者头痛。

比如,该如何分辨哪个是自己需要的,哪个是优质的?

为了一探各种 MCP 的真正能力,魔搭特地做了一项面向开源社区的 MCP Bench 工作。

他们设计了一组针对 Web Search 场景的调用效果对比,由模型连接 MCP 进行问答,对回答的精度采用模型打分。

实验结果显示,各个 MCP 服务的效果差异性很大,最高的 Bing web search(64%)和最低的 DuckDuckGo(10%)相差了 54pt。

MCP 服务之间的效率差异性更大,最快的 bing web search 和 Brave search 仅需要 15 秒以内,而最慢的 Exa search 需要 231 秒。

不过,它们之间的 Token 消耗量接近,基本都是在 150-250tokens 之间,说明模型总是会精炼地回答,而不相关于其使用的 MCP。

更多的讨论,详见 MCP Bench 社区的持续迭代:github.com/modelscope/...

虽然当下,MCP 协议并非技术上的灵丹妙药,魔搭团队也指出,目前 MCP 对生产力的显著改观还不够,但 MCP 依旧是有价值的,它更重要的意义在于,通过标准化接口设计,重构了大模型应用的生态关系。

中心化框架下的角色错配问题被解决,模型厂商、DevOps 平台、工具提供者和应用构建者,就达成了解耦合作。

新生产关系所产生的价值重构,也就在眼前了。

MCP

正处于大爆炸前夜

2022 年 11 月,魔搭社区成立之初,就希望通过开源开放的方式,降低 AI 模型使用门槛。

截至目前,这个中国最大开源 AI 社区,已经托管超 5 万 + 模型,还有多种数据集、创空间等全链路工具,服务全球 1300 多万开发者。

近 1500 款 MCP 服务 + MCP Bench 评估加持 + 云端 / 本地部署灵活性,让开发者能够快速验证创意、迭代应用。以 MCP 协议为钥匙,AI 作为软件「一等用户」的崭新时代正在到来。

想象这样一个未来:你只需告诉 AI 想要的结果,它便能洞悉需求,流畅调用应用程序,精准到操作每个步骤。

它就如同一个全能助手,甚至是一支超能团队,为开发者打工。

这不是科幻,正是 MCP 铺就的现实。

而现在,我们正处于大爆炸前夜,这座通往未来的桥梁才刚刚打开。

参考资料: