Remote Sensing Image Classification: A Comprehensive Review and Applications

遥感影像分类:全面综述与应用

0.论文摘要

遥感技术主要用于调查水坝、桥梁和管道等工程场地,以定位建筑材料并提供详细地理信息。在遥感图像分析中,通过卫星和无人机获取的图像被用于观测地球表面。基于图像分类的系统主要目标是为采集图像赋予语义标签,进而通过这些标签实现图像的语义排序。这种语义排列被广泛应用于数字图像处理与计算机视觉的多个领域,包括遥感、图像检索、物体识别、图像标注、场景分析、基于内容的图像分析以及视频分析。

早期的遥感图像分析方法主要基于低层次和中层次特征提取与表示技术。通过不同特征组合与机器学习方法,这些技术已展现出良好性能。此类早期方法多采用小规模图像数据集。当前遥感图像分析的最新趋势已转向深度学习模型的应用,多种深度学习混合方法相较于单一模型展现出更优越的效果。

本综述文章详细阐述了基于传统机器学习概念的低层次与中层次特征表示的既往研究趋势,同时汇总了公开可用的遥感图像分析基准数据集。每章节末均附有详细总结。此外,文章还系统介绍了深度学习模型的当前发展趋势,并基于最新研究对各类混合方法进行了详细比较,同时探讨了性能评估指标。本文全面梳理了遥感图像分类领域的现有研究脉络,并对未来可能的研究方向进行了展望。

1.引言

深度学习和计算机视觉广泛应用于图像分类、工业生产中的目标检测、医学图像分析、行为识别及遥感等领域[1-4]。卫星影像被视为获取地理信息的主要来源[5],其在土木工程领域的应用涵盖设计、施工、城市规划及水资源管理等多个方面。卫星数据体量庞大且呈指数级增长,需要高效的数据提取技术进行处理。通过图像分类,可将海量卫星影像按语义进行有序组织。卫星图像分类是一个多层次过程,从图像特征提取开始,最终完成类别划分[6]。

图像分类的实施流程分为多个步骤:首先需设计目标图像的分类方案;随后进行图像预处理,包括聚类、增强、缩放等操作;第三步是选定目标区域并生成初始聚类;接着应用分类算法获取结果,并在算法阶段(亦称后处理阶段)进行修正;最后如图1所示,需对分类结果的准确性进行评估。

图1:遥感影像分类流程。

近期研究主要集中于利用中层特征和深度学习模型,为智能车辆、物联网(IoT)和遥感图像构建稳健的决策支持系统[7--9]。要获取大范围地理数据,遥感技术发挥着重要作用,而通过地球航拍图像可实现高效土地利用[10]。现有方法既包含有监督技术,也包含无监督技术。同样,根据参数处理方式可分为参数化与非参数化方法;另一类为模糊分类法[11];此外还可基于像元或亚像元进行分类。遥感图像分类的最新研究趋势是混合方法,即结合两种及以上技术以获得更优分类效果[3,12,13]。当前最前沿研究集中于场景化分类。整个遥感图像分类流程可分为三大基础类型:监督学习、无监督学习与深度学习方法。监督学习技术可进一步分为分布式学习与统计学习[14--16],其中分布式学习包含逻辑回归、决策树、支持向量机(SVM)、集成方法等,统计学习技术则细分为参数化与非参数化方法。无监督学习技术详细讨论了K均值聚类、谱聚类、模糊C均值及强化学习等多种类型。第三类深度学习方法可再划分为生成式方法、混合方法与判别式方法:生成式方法涉及深度信念网络(DBN)、网络自编码器和深度玻尔兹曼机(DBM);混合方法涵盖深度神经网络(DNN)与灰狼优化算法(GWO);判别式方法则讨论了迁移学习、卷积神经网络(CNN)、AlexNet、VGG、GoogLeNet、MobileNet、ResNet、人工神经网络(ANN)等,如图2所示。

图2:监督式与无监督式学习技术。

遥感影像分类主要分为三种基本类型:基于像素的分类、基于对象的分类以及基于场景的分类,近期研究主要集中在基于场景的分类方向[17,18]。如图3所示,随着研究的深入,影像空间分辨率得到了显著提升[19]。这使得基于像素的遥感影像分类不再必要,研究趋势转向了基于对象的分类方法。所谓遥感影像中的对象,指的是语义单元或场景单元[20]。过去二十年间,图像视觉特征处理曾是耗时且计算密集的任务,需要投入大量人力与资源。根据近年文献记载,人工设计的方法包括尺度不变特征变换(SIFT)、纹理描述符(TD)、颜色直方图(CH)、方向梯度直方图(HOG)以及全局图像描述符(GIST)等[21]。随后出现的技术改进包括改进的Fisher核、空间金字塔匹配(SPM)和视觉词袋模型(BoVW)[22]。这些编码技术相比既有方法具有更高效率[23]。

简单来说,我们可以通过以下方式区分监督学习与无监督学习:监督学习算法使用标注数据进行训练,而无监督学习算法使用未标注数据。在无监督学习领域,后来出现了主成分分析(PCA)、稀疏编码和K均值聚类等方法。这些技术的优势在于能够自动学习特征,但对于大规模数据集时效果欠佳[24]。随着深度学习技术和并行计算的发展,通过初始化训练层权重可轻松实现遥感图像分类,从而在深层网络中获得更精准的场景预测[25]。现有文献记载的深度学习模型包括AlexNet、GoogLeNet、VGG和ResNet等[26]。AlexNet于2012年提出,包含6000万参数和8层网络[27];GoogLeNet于2015年提出,具有400万参数和22层网络,属于空间特征挖掘范畴[28];同年提出的VGGNet含1.38亿参数,分为16层和19层的VGG16与VGG19两种结构[26];后续提出的ResNet拥有ResNet18至ResNet1202等多种变体,参数规模达2560万[29],这些模型均属于空间特征挖掘技术。

近年来发表了多篇关于遥感图像分类的综述研究。文献[30]对多模型遥感图像分类进行了系统评述;2016年前的文献[31]详细探讨了所有遥感分类技术;2017年文献[32]深入分析了遥感图像分类流程,并整理了相关研究资源;同年文献[33]对高光谱分类的深度学习技术进行了全面对比;文献[34]讨论了遥感领域支持向量机(SVM)技术;文献[35]提出AID数据集并收录了2017年前的遥感图像分类研究;文献[36]综述了多种遥感技术并推出NWPU-RESISC45数据集。针对高光谱和空间-光谱图像分析的最新综述可参阅文献[20,37]。关于深度学习在遥感中的应用现状、当前挑战、基准测试及未来研究方向,详见综述文献[38-40]。

本文结构如下:开篇首先对遥感图像分类进行基础性介绍。第2节阐述机器学习相关内容,第3节详细讲解CNN模型及其应用场景。第4节探讨现有深度学习技术,第5节重点分析遥感图像分类常用数据集。第6节研究无监督学习技术,第7节讨论优化方法。第8至10节集中论述特征融合技术,第11节阐释混合方法。第12节说明分类性能评估标准,末节则对提出的研究进行总结性陈述。

2.机器学习

机器学习(ML)是计算机科学领域的重要分支,涵盖监督学习与无监督学习技术[41--43],可处理回归和分类问题[44]。该技术通过构建包含系统多维度参数的详细数据集,在理论认知不足以推导信息的场景中发挥关键作用[45,46],其应用范围涵盖土地利用覆盖[47]、灾害管理、大气变化等诸多领域[48]。作为人工智能(AI)的子学科[49],ML通过设计数据驱动算法实现预测功能,现有算法包括支持向量机、贝叶斯网络、决策树、集成方法、随机森林、神经网络和遗传编程等,在遥感与地学领域产生深远影响。基于统计技术的数据特征自动提取[50,51],早期遥感影像分类被视为"浅层结构",现采用决策树、支持向量机、人工神经网络、视觉词袋等方法实现[52--54]。ML另一重要应用是异常变化检测,通过卫星或无人机获取影像后,结合支持向量机与遗传算法(GA)进行预测[55]。其中支持向量机采用径向基核函数,并利用GA优化C和Ω参数,这种混合监督与非监督学习的方法通过关联相邻像素,在墨西哥与撒丁岛数据集实验中验证了性能优势[56]。早期ML仅对高光谱影像具有较好精度[57],新兴三维方法结合空间与光谱信息,在帕维亚大学、帕维亚中心及肯尼迪航天中心数据集上实现了高精度低耗的计算[58]。ML技术还广泛应用于语音识别、搜索引擎及机器人等AI领域[59]。文献记载的分类方法包括K均值聚类和主成分分析,回归技术则涵盖支持向量机、决策树、人工神经网络等[60,61]。现有CNN方法虽可实现遥感影像分类,但需高性能计算设备与大标注数据集。利用开源数据集和预训练网络可提升精度,采用防过拟合策略与dropout技术亦至关重要。GPU有效缓解了CNN模型训练耗时问题[62]。卫星遥感影像受天气条件影响会导致特征选择困难[63],下文所述研究通过专用工具箱填补该空白:第一阶段修复空间关系与像素间隙,第二阶段补全像素时序动态特征,基于Sentinel-3 SLSTR和Terra MODIS多季节数据集在GNU GPL3开源平台完成验证[64]。

3.卷积神经网络

卷积神经网络在需要无人干预实现图像分类的多媒体应用中具有重要价值。本文采用四种深度学习模型(AlexNet、VGG19、GoogLeNet和ResNet50)进行特征提取,实验数据集包括SAT4、SAT6和UCMD。其中SAT4与SAT6的图像源自NAIP数据集(包含全美约33万张场景图像),分别对应4类和6类地物分类(如树木、草地、裸地、建筑物、道路、水域等);UCMD数据集则选自USGS大型数据库,包含20个地物类别。SAT系列数据集采用80:20的训练测试比例,UCMD采用70:30的比例[65,66]。图4展示了CNN图像分类的基本流程。

图4:卷积神经网络。

ResNet50在以上三个数据集上均表现出更高的准确率:在UCM数据集上达到98%,SAT4为95.8%,SAT6为94.1%。由于卫星图像存在较大变异性,其分类任务具有挑战性,这也导致现有方法难以有效检测卫星图像中的目标。本文提出的DeepSat V2模型本质上是卷积神经网络的增强版本,其第一阶段为特征提取阶段------先提取50个特征,再通过统计方法进行特征排序以筛选有效特征。该模型包含两个卷积层(均连接RELU层),其后接最大池化层和Dropout层,接着是特征拼接层和全连接层,最终采用基于交叉熵损失函数的Softmax层,优化器选用Adadelta。所有实验均在SAT4和SAT6数据集上进行,该模型最终分别取得99.9%和99.84%的准确率[67]。

4.基于深度学习的方法与途径

卫星图像在诸多生活领域具有重要意义。本文主要探讨遥感领域的可用数据集及卫星图像分类技术。如图5所示,现有的图像分类技术可分为四类:人工特征提取、无监督特征提取、有监督特征提取以及基于对象的分类方法。

图5:通过深度学习实现的图像分类。

本文用于分类的数据集是UCM土地利用数据集,包含21个类别共2100张图像。实验采用AlexNet架构进行,训练集约占10%,经过八次迭代后准确率达到94%。与GoogLeNet和CaffeNet相比,GoogLeNet在UCM数据集上表现更优,准确率达97%,但AlexNet的运行速度约为其4倍。相较于其他特征提取技术,深度学习方法在图像分类任务中表现更佳[68]。本文重点探讨基于深度学习的特征提取方法,实验使用了AlexNet、VGG19、GoogLeNet和ResNet50四种模型,并在SAT4、SAT6及UC Merced三个不同数据集上进行验证。表1总结了UCM数据集在多种深度学习模型上的准确率表现。

所提出的ResNet50模型在SAT6数据集上的性能优于先前模型,但在SAT4数据集上准确率有所下降。该模型在SAT4、SAT6和UCM数据集上的分类准确率分别为95.8%、94.1%和98%[80]。本文提出了一种名为深度卷积神经网络(DCNN)的新型CNN模型,其工作流程分为两个阶段:第一阶段通过引入多组滤波器来降低方差,第二阶段从参数池中筛选最优超参数。基于这些参数构建了新的DCNN模型并进行实验验证,结果通过DeepSat模型在SAT4和SAT6数据集上得到验证。表2汇总了RSSCN数据集在不同CNN模型上的准确率,其中DCNN模型在SAT4和SAT6上的分类准确率分别达到98.408%和96.037%,优于验证基准模型[83]。

在卫星图像分类中,尺度选择过程至关重要。面对海量遥感图像数据集,选择合适的技术方案尤为关键。文献[84]采用改进的CNN技术,在WHU-RS、UC Merced和巴西咖啡场景数据集上进行实验:UCM数据集在第二阶段呈现最佳准确率,WHU-RS数据集则通过四个尺度阶段的测试,其中第一、二尺度改进显著,第三、四尺度提升幅度趋缓。

土地利用与土地覆盖研究深刻反映人地关系,现有研究多集中于单类提取,而多类分类亟待加强。为解决低分辨率损失问题,本文提出HR-net新模型,经与DeepLab、U-Net对比测试,其95.7%的准确率、88.01%的平均I/U值和94.55%的Kappa值均表现更优[85]。现有遥感图像分类技术可分为四类:人工特征提取、无监督特征提取、有监督特征提取和基于对象的分类。本研究采用包含21类2100张图像的UCM土地利用数据集,使用AlexNet进行实验表明:10%训练样本经8次迭代后准确率达94%。相较而言,GoogLeNet在UCM数据集上97%的准确率更优,但AlexNet运算速度快约4倍。深度学习方法在图像分类中显著优于其他特征提取技术[86]。

Xia等[76]采用GoogLeNet算法在UCM基准上获得94.31%分类准确率;Zhang等[77]基于梯度提升随机卷积网络框架实现94.53%的场景分类准确率;Zhong等[79]运用大尺度卷积神经网络取得89.90%的UCM分类准确率。表3汇总了AID数据集在不同CNN模型上的分类准确率。

在使用相同数据集的情况下,基于CaffeNet框架进行实验,分类准确率达到95.31%。第三轮实验采用VGG-VD-16算法处理UCM数据集时,准确率为95.21%。针对AID数据集的第二轮实验分别采用GoogLeNet和Inception-V3算法,文献[76]记载的准确率分别为86.39%和93%。基于ARCNet-VGG16模型对超高分辨率遥感影像进行场景分类实验时,通过循环注意力机制实现了99.12%的准确率。该模型在AID数据集上的实验准确率为93.10%(使用UCM数据集测试)[19]。文献[19]记载采用最小和着色问题(MSCP)算法处理UCM数据集时获得98.36%的准确率。针对AID数据集分别采用MSCP、DCNNS和HW-CNN三种算法的实验结果依次为94.42%、96.89%和96.98%。Zhu等[69]使用UCM基准图像数据集报告的分类准确率达99.76%。Lu等[73]采用特征聚合卷积神经网络(FACNN)处理UCM基准图像时获得98.81%的准确率。另有研究[70]显示FACNN算法处理UCM数据集的准确率达99.05%。空间频率卷积网络(SF-CNN)在UCM数据集上取得99.05%的准确率,该算法应用于AID数据集时准确率为96.66%;而同一文献[71]记载FACNN算法处理AID数据集的分类准确率为95.45%。

文献[71]指出,采用鲁棒空频联合表示(RSFJR)算法在UCM数据集上实现了98.57%的分类准确率。另一项研究显示,使用GBN算法在UCM数据集上同样取得了98.57%的准确率[74]。采用ADFF算法的研究在UCM数据集上获得97.53%的准确率。相同实验在AID数据集上进行时,准确率为94.75%[75]。另有研究通过CNN-Caps Net算法在UCM数据集上达到99.05%的准确率。文献[22]报道,采用特征RCGSVM方法在UCM数据集上的分类精度为93.81%。AlexNet和Inception算法在UCM数据集上的表现分别为94.2%和911.1%。基于AID数据集的实验表明,VGG-VD-16模型取得了89.64%的准确率[78]。某文献作者使用SCCOV方法在AID数据集上进行实验,获得96.10%的准确率[89]。采用RSFJR算法在AID数据集上的实验精度为96.81%[71]。另有研究宣称,使用ResNet模型在AID数据集上达到89.1%的准确率。我们从文献中提取了不同CNN模型在各数据集上的性能表现,表4列出了对应数据集的准确率。同时,表4也汇总了SIRIWHU数据集在不同CNN模型上的分类精度。

5.数据集

不同遥感数据集的详细信息如下所述:

5.1. SAT4与SAT6数据集。本研究采用美国国家农业影像计划(NAIP)数据集进行图像提取。如图6所示,SAT4共包含50万张图像块,SAT6则包含40.5万张图像块。

图6:SAT数据集中所有类别的图片库。

5.2 巴西咖啡场景数据集。该数据集采集自四个国家,图像尺寸为64×64像素。其中四类数据各有600张图像,第五类包含476张图像。下表汇总了基准测试中涉及的类别总数、每类图像数量、每类图像样本数及图像总量、图像空间分辨率与维度等详细信息。图7则展示了咖啡数据集图像及其他维度的具体说明。

图7:咖啡数据集所有类别的图片库。

5.3 RSSCN数据集

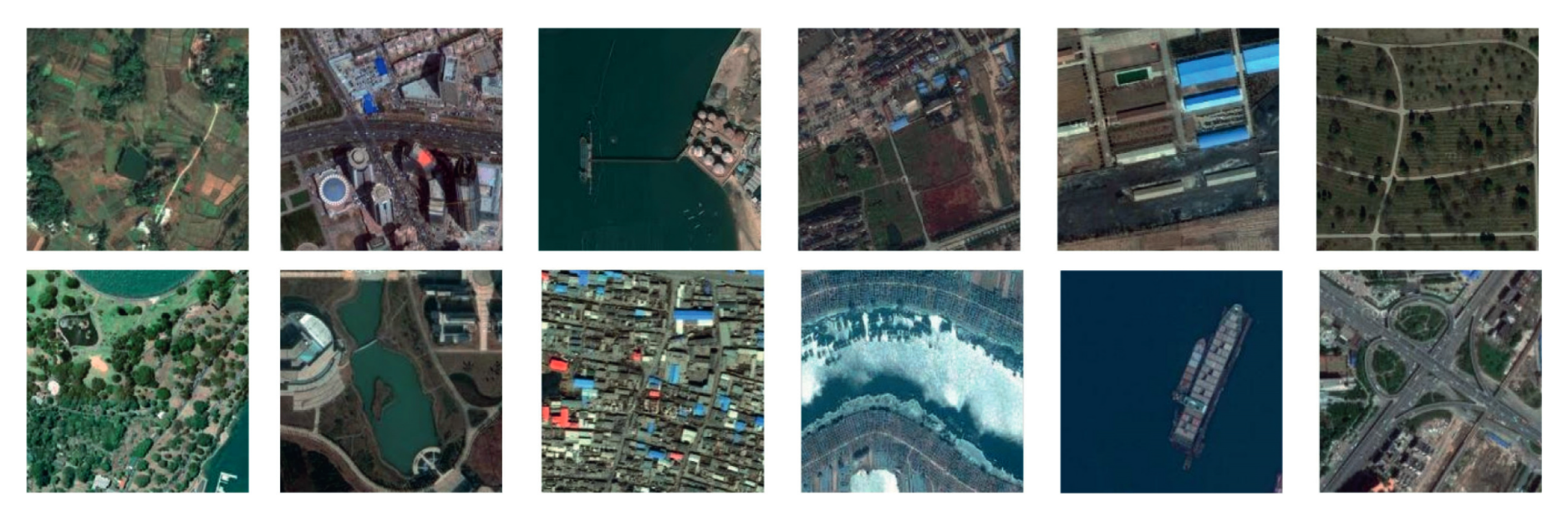

该遥感图像分类数据集由Google Earth Engine采集的图像构成,覆盖广泛地域。RSSCN包含7类典型场景图像,尺寸为400×400像素。关于该图像基准的更多说明详见数据集描述表。图8展示了RSSCN数据集所有类别的图片库。

图8:RSSCN数据集中所有类别的图片库。

5.4 SIRI-WHU数据集。关于图像尺寸、图像总数、每类图像数量及创建日期等描述详见研究论文[22]。该数据集图像空间分辨率为2米,尺寸为200×200像素。图9展示了从SIRI-WHU数据集每类中随机选取的样本图像。

图9:取自SIRI-WHU数据集所有类别的图片库。

5.5. 加州大学默塞德分校土地利用数据集。关于图像尺寸、图像总数、每类图像数量及创建日期等描述详见文献[65]。如表5数据集描述所示,该数据集共包含21个不同的场景类别,每类100张图像,图像尺寸为256×256像素。图10展示了从数据集中随机选取的各类别示例图像(表5)。

图10:UCM数据集中所有类别的图片库。

5.6 AID数据集。AID数据集包含30个不同类别的10000张图像。图11展示了AID数据集的照片图库。

图11:取自AID数据集所有类别的图片库。

5.7. DIOR数据集。DIOR数据集包含23,463张图像和192,472个目标对象。图12展示了DIOR数据集的照片图库。表5列出了部分现有数据集的图像数量及其他描述信息。

6.无监督学习方法

随着空间与卫星技术的进步,遥感技术已迈入新高度[90]。高分辨率卫星的出现使得土地利用/土地覆盖调查、变化检测、目标识别等工作变得更加便捷[91]。得益于图像分类技术的发展,自动解译图像特征也更为高效。然而如何有效利用这些卫星数据仍具挑战性,其中卷积神经网络(CNN)在图像分类过程中发挥着关键作用。下文所述论文提出了一种名为"无监督受限反卷积神经网络"(URDNN)的框架,其核心思想是通过神经网络实现无监督受限反卷积。该框架先进行像素级端到端分类学习,再将结果输入CNN模型进行标签标注,从而缓解了因大量标记数据导致的过拟合与欠拟合问题。实验基于Geoeye和Quick-bird传感器数据集[92]开展,分类准确率分别达到97%和98.9%,优于既有模型[92]。

本文介绍了基于无监督深度学习的遥感图像分类技术。该方法首先通过CNN以无监督方式提取特征,随后训练网络参数并输入分类器。无监督学习有效降低了计算成本,过程中采用SVM分类器,同时实现了空间光谱信息的高效提取。虽然增加网络层数可提升效率,但会引发过拟合问题[93]。在探讨无监督遥感图像分类时,尺度不变特征变换(SIFT)和方向梯度直方图(HOG)概念至关重要[94]。通过编码将图像转换为特征向量,相比人工设计的图像表征方法,无监督学习技术取得了显著突破[95]。该方法可直接从原始像素中提取图像特征,通过应用Gabor滤波器处理图像块获取特征。词袋模型(BOW)是另一种图像分类与检索技术[96],结合非线性核SVM可获得最佳分类精度。

在遥感图像分类中,色彩特征与强度特征具有同等重要性,但现有算法往往难以同步处理这两个维度。下文所述研究通过四元数表征色彩特征,结合无监督学习技术,实现了色彩与强度的联合建模。该模型在UCM和巴西咖啡数据集上的实验表明,其准确率优于现有技术[97]。随着深度学习技术的发展,无监督学习方法能更精准地实现遥感图像分类,尤其在标记样本有限导致监督学习困难时更具优势[98]。场景图像分类是当前研究热点,相关技术可高效应用于土地覆盖调查、城市规划、灾害管理、作物分析和气象预测等领域[99]。

传统BOW技术曾是无监督遥感图像分类的主要方法,下文提出了一种新型多层特征匹配技术以解决标记数据不足的问题。该模型结合判别式与生成式方法处理未标记数据,在UCM和咖啡数据集上的实验显示,其分类准确率分别达到94.86%和89.86%,优于现有技术[100]。

6.1. 强化学习

强化学习是一种以分类为目的的模型训练方法,通过奖励正确行为与惩罚错误行为来实现。作为机器学习的子分支,它与无监督学习类似------无需为图像预先标注标签。在强化学习中,智能体通过参数学习预测结果[101],系统根据预测结果实施奖惩机制,这一过程持续至任务终止。该技术主要应用于游戏开发、人工智能及机器人训练领域,例如教导机器人掌握新技能。强化学习包含策略、奖励、价值函数和环境模型四大核心要素[102]。当前该技术已取得突破性进展,能有效缩小训练损失与矩阵评估之间的差距[103]。

遥感图像描述是极具挑战性且需求迫切的任务。现有多数机器学习模型存在过拟合问题。下文所述研究通过提出两阶段模型解决了这一缺陷:第一阶段实现自动编码变异,第二阶段引入强化学习。卷积神经网络在首阶段完成微调,次阶段生成图像描述,再通过强化学习提升模型精度。基于NWPURESISC45数据集的实验表明,其效果显著优于既往成果,但仍需在未来解决过拟合问题[104]。

全极化雷达具备全天候成像优势,可应用于土地利用分类、作物管理、森林估测、灾害预防及目标识别等领域。相关研究提出深度Q网络(DQN)模型------一种针对极化SAR图像分类的深度神经网络架构。该方案先对数据进行降噪和特征提取预处理,再输入神经网络进行分类,期间引入强化学习机制。在两组PolSAR数据集上的实验证明,该模型性能超越多种现有方案[105]。

7.遥感影像分类优化技术

优化是指寻找能使输出结果最佳化的输入值的过程,这一过程需要明确定义目标函数。对于这项关键任务,目前存在多种机器学习算法。优化的本质在于降低运营成本并提升精度,算法会不断尝试不同解决方案,直至获得针对特定问题的最优解[106]。在遥感图像分类中,特征选择是最核心的任务,其效果取决于可用标注样本的数量。该过程需要从特征池中筛选出更重要的特征,同时排除相关性强的特征。下文讨论的论文针对这一特征选择任务提出了解决方案,为此引入了随机方法来实现相关重要特征的筛选。

实验在AVIRIS和ROSIS两个数据集上进行,结果表明所提方法比现有方法具有更高精度[107]。特征选择是遥感影像分类中最关键的任务之一。由于数据量庞大且特征间存在相关性,该任务变得极具挑战性。为解决这一问题,本研究引入结合小波分析的新方法。该框架采用三阶段策略:第一阶段改进分辨率处理技术,第二阶段引入三维离散小波变换,最终阶段采用卷积神经网络(CNN),并在Indian Pines、University of Pavia和Salinas三个数据集上验证新模型性能。该模型取得的分类精度分别达到99.4%、99.85%和99.8%[108]。

在高光谱遥感领域,我们通常面临训练样本有限的问题。传统技术难以实现高精度分类,而支持向量机(SVM)因其良好的泛化能力和最小结构风险展现出优势,有效解决了耗时过长和参数优化不足的难题。下文所述研究利用EO-1 Hyperion卫星数据进行参数优化,测试结果表明该模型达到了91.3%的分类准确率,显著优于现有方法[109]。遥感影像分类在土地利用/覆被研究中具有重要价值,这是当前的前沿领域。现有分类方法存在效率低下且依赖大数据集的缺陷,为此研究者提出引入极限编程概念的新方法,该模型融合集成学习、全特征利用和深度学习技术。三种方法在分类精度和效率上均有提升,多数据集实验表明分类效果与数据类型相关。结合深度学习的优化技术展现出超越其他方法的性能[110]。针对影像分类任务的不同维度,现有多种优化技术,其概要将在后续章节详述。

7.1. 灰狼优化算法

灰狼优化算法(GWO)是一种新型元启发式技术,其灵感来源于灰狼的等级制度[111]。灰狼群体分为四个等级:头狼α、次狼β、第三级δ以及末级ω。最优解对应α狼,次优解为β狼,第三优解为δ狼,最差解为ω狼。该算法通过模拟灰狼捕猎的三个阶段------搜寻猎物、包围猎物和攻击猎物来实现优化性能,本质上是一种基于特征选择的技术[112,113]。

高光谱图像(HSI)中存在大量连续且狭窄的光谱波段,这些波段承载着各类地物信息。由于特征数量庞大,会导致时间复杂度增加。如何从海量特征中筛选最优特征集是一项艰巨挑战。下文所述论文提出了一种HSI特征选择新技术,能有效减少冗余特征。该方法采用模糊C均值算法进行特征子集分解,结合灰狼优化与最大熵原理进行特征选择,并在Indian Pines、Pavia University和Salinas三个经典数据集上验证了其分类精度优于现有技术[114]。

图像处理与分析是计算机视觉领域的新兴方向,涵盖图像分类、分割、医学成像、图像压缩等诸多应用。针对这些问题存在多种解决算法,如遗传算法(GA)、遗传规划(GP)、灰狼算法、蝙蝠算法等。下文综述了多种优化技术的原理、应用场景及实际案例[115]。灰狼算法作为群体智能的新兴分支,其性能优于传统群体智能算法,具有实现简单、易于理解的优势。另一篇文献则系统梳理了灰狼算法的多元化应用场景[116]。这些优化算法可总结如下:

(i) 灰狼算法能高效处理大规模数据,但会忽略需要解决的细微细节。(ii) 灰狼算法将特征划分为四组,未来应探索形成多于或少于四组的分组方向。(iii) 需结合其他优化算法验证灰狼算法的有效性。(iv) 应重点研究利用灰狼算法解决动态问题。(v) 未来还可聚焦灰狼算法的参数调优。表6汇总了文献中描述的若干优化技术。

8. 深度学习与光谱特征的融合

高光谱图像(HSI)的分类精度在与卷积神经网络(CNN)结合使用时显著提升。为获得更优性能,需采用更密集的网络结构,但这会导致过拟合、精度下降及梯度消失问题。为解决上述问题,本文提出新型分层特征融合网络框架(HFFN),其核心思想是通过融合所有网络层的输出以提高分类精度。实验在三个真实HSI数据集上进行:AVIRIS印第安松树林图像、ROSIS-03帕维亚大学图像及AVIRIS萨利纳斯图像。实验结果与DCNN、SVM和DRN进行对比,表明所提方法优于现有深度学习方法[117]。

卷积神经网络(CNN)被视为高光谱图像分类领域最强大的方法。其池化层和特征采样结构通常是固定的,因此无法用于特征下采样。某研究论文提出了一种可变形高光谱成像系统(HIS)。该方法在帕维亚大学和休斯顿大学两个真实高光谱数据集上进行评估,这两个数据集分别包含12类和15类地物。第一组实验在帕维亚数据集上进行,每类随机选取45、55和65个训练样本。结果表明,该方法能准确分类近边缘区域的像素。第二组实验在休斯顿数据集上进行,每类同样随机选取30、40和50个训练样本。实验证实该方法性能优于其他现有方法[118]。

提出了一种具有9层结构的更深层网络,称为上下文深度卷积神经网络。该研究的核心思想在于构建一个能够通过联合利用相邻像素向量的局部空间-光谱关系,精确捕捉局部上下文交互的模型,如图13所示。

图13:表示光谱特征提取细节的框图。

第一步通过滤波器组实现空谱信息的多尺度联合挖掘,并将结果融合成特征图。实验在三个数据集上进行:印第安松树数据集、萨利纳斯数据集和帕维亚大学数据集。印第安松树数据集包含12个类别,但由于图像数量过多仅采用其中8类;帕维亚数据集包含16个类别,所有类别均参与实验。采用所提技术后,印第安松树的分类精度达93.6%,萨利纳斯达95.07%,帕维亚达95.97%[119]。

高光谱图像(HSI)是一个新兴的研究领域。本文提出了一种特殊的CNN模型,通过减少数据训练和微调来实现目标分类。该任务可通过拉近同类像素间的距离,同时推远异类像素间的距离来完成。实验在三个HSI数据集上进行:印第安纳松林、帕维亚和萨利纳斯。结果在AlexNet、VGG-CNN-S和GoogLeNet上得到验证。先前模型的准确率分别为88.45%、85.5%和88.8%,而所提模型的准确率分别达到96.21%、86.46%和88.48%[120]。

在文献[121]中,研究者提出了一种新型SAFF模型。第一阶段通过预训练CNN网络识别多标签特征,随后引入自注意力层实现通道与空间维度的权重分配,最终采用支持向量机进行分类。实验在三个数据集上进行:(1) 包含2100张图像、21个类别的UC Merced土地利用数据集;(2) 含10000张图像、30个类别的AID航空影像数据集;(3) 具有31500张图像、45个类别的NWPU-RESISC45数据集。实验结果表明:UCM数据集总体准确率达97.02%,AID数据集为90.25%,NWPU数据集达到84.38%。

9. 特征融合

在早期文献中,我们看到图像检索曾采用单一技术,后续研究发现多技术融合能获得更高精度[122]。本文提出了一种新型权重特征卷积神经网络模型(WFCNN),可实现图像分割与信息提取。该模型先进行编码处理,再执行分类任务,采用随机梯度下降(SGD)算法进行训练。实验使用高分六号卫星影像和航拍图像两组数据集,通过SegNet、U-Net和RefineNet模型验证,分别获得94.13%和96.9%的准确率[123]。任等人[124]针对遥感图像分类中的类别不平衡问题,提出基于多尺度特征融合的全卷积网络DeepLab V3+,通过损失函数解决样本失衡。在哨兵2号/3号数据集上的实验表明,相比U-Net、PSPNet和ICNet,该方法准确率最高达97%[124]。本文提出将大幅图像分割为小尺度图像的新方法,采用支持向量机(SVM)进行样本分类,并加入主动学习模块。所提出的SSFFSC-AL模型在印度松树和帕维亚数据集[125]上表现出更高的分类精度与更快的运算速度。特征融合主要包括局部特征融合与全局特征融合两种基础方法。

朱等人[126]提出了一种针对高分辨率空间影像场景分类的局部与全局特征融合方法。他们整合了两种不同的特征融合技术:局部融合与全局融合。实验采用的数据集为21类UC Merced和12类SIRI-WHU谷歌数据集,其中谷歌数据集准确率达到99.76%,另一数据集为96.37%。本文指出的未来研究方向包括

(1) 将社交媒体数据用于此训练目的。

(2) 提高遥感图像的分类精度。

(3) 在非光学数据上实施此项研究。

李等人[127]探讨了通过融合策略实现场景图像分类的方法,该方法利用卷积神经网络(CNN)对预训练数据进行多层特征整合。研究采用CNN进行特征提取,随后通过全连接层进行深层特征提取;继而使用主成分分析(PCA)融合这些特征;最终执行分类流程。实验采用WHU-RS和UCM数据集,作者宣称其分类精度优于既有方法。文中指出的研究空白在于降低计算耗时并提升分类准确率[127]。

袁等人在文献[128]中探讨了通过局部特征的全局重排实现场景图像分类的方法,该重排策略有助于获取图像的空间信息。实验在UCM、WHURS19、Sydney和AID四个不同数据集上进行,结果表明其分类性能达到预期效果。未来研究应着重提升分类精度。

在文献[128]中,采用多层协方差池化技术进行特征提取;随后将这些特征堆叠形成协方差矩阵,最终使用支持向量机进行分类。实验在UCM、AID和NWPU-RESISC45数据集上进行,所提方法优于现有分类方法。未来应开发端到端CNN模型,通过减少每层特征图数量实现更高精度分类。

一篇研究论文探讨了通过特征聚合进行场景分类学习的方法。该模型在训练过程中将特征学习、聚合和分类统一整合到卷积神经网络(CNN)中。通过微调以优化训练流程,该方法在数据不足的情况下同样有效。实验在三个数据集(AID、UCM和WHU-RS19)上完成。本研究的局限性在于缺乏一种无需裁剪或调整图像尺寸即可获取图像语义信息的技术[87]。

图14展示了特征提取及图像分类流程的完整过程。另一篇文献提出了一种用于CNN训练的无监督特征融合技术,该方法使训练过程更简易高效;随后通过特征融合实现图像分类。实验在UCM和巴西咖啡数据集上进行,所提模型取得了87.83%的更高准确率。需重点关注不同特征融合策略的效果验证[73]。表7对上述研究文献进行了总结性对比。

图14:深度学习模型。

10. 纹理特征

特征选择与提取是基于内容的图像检索中最重要的任务。特征可分为两类:全局特征与局部特征。全局特征包括颜色、纹理、形状及空间信息,而局部特征则涵盖图像分割、边缘检测、角点与斑点检测等信息[129]。

纹理特征被认为是所有特征中最具影响力的特征,它们是图像中最显著且最易察觉的模式。然而,我们无法单独使用纹理特征。在低层次视觉特征中,图像的纹理被视为一种可区分的图像表征,它们被认为是图像中可见且引人注意的模式。不同的纹理特征融合方法已在遥感和图像检索的多种应用中展现出良好的效果[130]。

在具备这些优点的同时,纹理特征提取也存在一些缺陷。其处理与提取过程的复杂度较高[131]。为解决这些问题,文献中报道了多种纹理特征提取方法,如小波变换[132]和Gabor滤波器[133],表8对纹理特征进行了详细总结。

在本文[134]中,提出了一种用于SAR图像分类与特征提取的新技术。该方法分为三个阶段:在第一阶段,提取了两种特征:灰度共生矩阵和Gabor滤波器。在第二阶段进行降维处理,最终阶段引入支持向量机(SVM)实现图像分类。实验表明该模型具有更高分类准确率,同时具备良好降维效果。研究采用SAR图像数据集进行验证,准确率达87.5%[134]。

斑点效应是极化合成孔径雷达(PolSAR)中非常常见的问题。为解决该问题,本文提出一种先提取特征再进行分类的特殊技术。研究采用真实极化SAR图像进行实验,并通过现有技术进行验证。文章宣称其准确率达到了99.8%[135]。

高光谱传感器如今能够采集海量数据,但实现高精度的高光谱图像分类仍具挑战性。既往研究采用的空间-光谱联合分类技术未能实现准确分类。本文作者提出一种三阶段新型分类技术:第一阶段执行特征提取,第二阶段采用概率支持向量机进行分类,第三阶段通过概率计算得出分类结果。实验基于印第安纳松树和帕维亚两套高光谱数据集开展,结果表明该模型的分类精度优于既有技术[136]。

Kai等[137]声称他们采用Gabor方法提取纹理特征。实验所用数据集为Corel、Li和Caltech 101,其方法实现了准确率提升。结果显示各数据集准确率分别为83%、88%和70%。该研究存在的主要局限在于特征提取过程中计算成本增加。Sajjad等[138]指出,利用小波方法可高效提取纹理特征,并宣称在Corel 1K、Corel 5K和Corel 10K数据集上分别达到99%、56%和35%的高准确率。采用小波纹理特征提取方法虽能提高精度,但也会导致计算成本上升。在另一篇文献[139]中,Sajjad等通过直方图法提取纹理特征,实验基于Corel 1K和Corel 5K数据集实现87%的分类准确率。2018年其研究报道称,采用边缘检测方法提取的纹理特征可获得更高精度(达98%),实验数据集为NUSWIND,但该研究同样存在计算成本增加的局限性。

王等[140]发现,使用Canny边缘检测器提取的纹理特征可获得68%的更高准确率。实验所用数据集为Corel 10K。该研究的缺点在于运行成本较高,因其输入图像数量过于庞大。

Nazir等[141]在文章中指出,通过离散小波变换(DWT)和边缘直方图描述符(EDH)提取的纹理特征相较于其他方法具有更高准确率。实验基于Corel数据集进行,该文献报告的准确率为73.5%。此项研究的不足之处在于未采用任何机器学习方法进行特征分类或提取。

在文献[142]中,Usnavis Bella与Vasuki采用ranklet变换方法进行纹理特征提取。研究者宣称其方法提升了分类准确率,实验所用数据集为Corel 5k与Corel 10K,测得准确率分别为67.4%与67.9%。该研究的局限性在于纹理特征维度较高导致计算成本显著增加。

在文献[143]中,Ashraf等人声称通过使用Gabor滤波器提取了纹理特征。该实验在Corel 5K数据集上实现了79%的准确率。这项研究的局限性还在于随着特征维度的增加,计算精度也会相应提高。

在文献[144]中,Alsamadi等人报道了采用DWT方法提取纹理特征的研究。实验采用Corel数据集,其准确率达到90%。该研究的局限性在于计算耗时较高。

11. 混合方法

本文采用混合方法对遥感航拍图像进行精确分类,结合了支持向量机(SVM)与K近邻(KNN)算法。首先训练SVM模型将图像划分至不同类别;在测试阶段输入新样本后,通过距离公式计算每类测试样本的平均间距;最终将图像归入平均距离最小的对应类别。该流程循环执行直至所有图像完成分类。实验基于ALOS仪通河数据集与PMS传感器数据开展,分类准确率分别达到92.44%与97.8%[148]。

在一篇论文中,研究者结合参数化与非参数化方法对遥感影像(特别是土地利用/覆被数据)进行分类。该研究还为此提出了一个可应用于其他相关领域的新数据集,所采集的土地数据同时包含干旱和湿润两种状态。提出的模型本质上是ISODATA聚类与决策树的结合,其在干旱条件下的分类准确率达到84.54%,而湿润天气条件下的准确率更高,达到91.10%,优于现有深度学习模型[149]。

在一篇论文中,作者结合了两种算法:核内值模糊C均值聚类与多值C均值聚类;通过与常规模糊C均值聚类的结果对比,发现所提方法性能优于现有方法。他们构建了一个新数据集:LANDSAT-7巴地-头顿区域与河内区域。该研究记录的准确率分别为98.2%和94.13%[11]。

一篇论文阐述了稀疏编码现象,该技术用于减少特征提取的计算时间。在航空影像处理中,稀疏编码表现尤为出色,因此被广泛采用。通过现有方法的改进,局部特征提取的准确率较传统技术有所提升。实验基于无人机操作系统采集的数据集展开,该数据集记录了近2小时无中断的飞行数据,最终达到85.7%的准确率[150]。

一篇文章指出,该研究结合了两种技术:基于像素的多层感知器和卷积神经网络。该混合算法应用于通过航拍和卫星获取的数据集,该数据集包含南安普顿不同土地利用类型的城乡区域图像。所提出的方法在性能上超越了现有深度学习模型,其分类准确率在城市区域达到90.93%,乡村区域为89.64%[151]。

该文提出了一种结合支持向量机(SVM)与人工神经网络(ANN)的混合方法,用于卫星影像的土地利用与土地覆盖(LULC)分类。如图15所示,采用模糊层次聚类方法实现分类目的。

图15:混合方法。

本研究还提出了"Landsat-8卫星影像"数据集,所有数据均采集自海得拉巴及其周边区域。文中实现的分类精度为:支持向量机(SVM)93.159%,人工神经网络(ANN)89.925%。作者宣称所提方法较现有方法[153]具有更优效果。

杨等[134]提出了一种基于空间与光谱图像特征的高效农用地分类技术。该研究采用混合方法对健康与非健康作物进行分类,采集了台湾嘉义县嘉南平原及太保市稻田的无人机影像数据,分类准确率达90.67%[154]。

另一篇文章阐述了一种用于遥感影像分类的混合方法研究。该研究结合了支持向量机(SVM)与K近邻算法(KNN)以获得更优结果。实验采用两组数据集:数据集1包含"长春市伊通河的ALOS数据",数据集2则为"江苏省某工业区的正射影像"。最终分类精度分别为DS1: 92.4%与DS2: 97.9%[155]。

一篇论文阐述了印度南部遭遇洪灾的情景。该研究采集了200张洪水淹没区与非淹没区的图像数据,采用支持向量机(SVM)与K均值聚类相结合的研究方法,最终达到92%的准确率。Bitner等学者[157]通过混合方法提取多分辨率遥感影像,实现了建筑物轮廓的自动识别。研究采用德国慕尼黑WorldView-2卫星影像数据,在Caffe深度学习框架上集成U-Net进行实验验证。这种新型混合技术的性能优于现有方法,准确率达到97.4%[157]。表9汇总了本节所述全部混合方法的研究成果。

12. 性能评估标准

评估分类性能的方法在文献中存在多种方式[65, 158]。性能指标的选择完全取决于我们所要执行的分类类型以及所需的结果类型。分类算法的选择对性能指标的选取同样具有重要影响。以下是用于检验分类准确性的性能指标:

真阳性(TP):正确标记的图像数量

真阴性(TN):错误标记的图像数量

假阳性(FP):将不属于某类别的图像错误标记为该类别

假阴性(FN):未将实际属于某类别的图像进行标记

以下是用于衡量基于内容的图像检索性能的部分方法类型:

(i) 精确度/预测值:指相关输出与输出图像总数之比。

P r e c i s i o n = T P T P + F P . ( 1 ) \mathrm{Precision}=\frac{TP}{TP+FP}.\quad(1) Precision=TP+FPTP.(1)

(ii) 平均准确率:可定义为所有相关查询结果的平均值。

Avg.Precision = ∑ k = 1 n N R I p ( k ) × R ( k ) N R I . \text{Avg.Precision}=\sum_{k=1}^{nNRI}p\left(k\right)\times\frac{R\left(k\right)}{\mathrm{NRI}}. Avg.Precision=k=1∑nNRIp(k)×NRIR(k).

(iii) 平均精度均值:定义为所有相关查询的平均精度的算术平均值。

M A P = ∑ ( q = 1 ) s A P ( q ) S , ( 3 ) \mathrm{MAP}=\sum_{(q=1)}^sAP\frac{(q)}{S},\quad(3) MAP=(q=1)∑sAPS(q),(3)

其中S为查询数量。

(iv) 精确率-召回率曲线:表示不同阈值下精确率与召回率之间的权衡关系。

(v) 召回率/灵敏度:指相关输出占全部输入与输出查询的比率。

R e c a l l = T P T P + F N . ( 4 ) \mathrm{Recall}=\frac{TP}{TP+FN}.\quad(4) Recall=TP+FNTP.(4)

(vi) F值:精确率与准确率的调和平均数。

F − m e a s u r e = 2 ( P × R P + R ′ ) . F-\mathrm{measure}=2\left(\frac{P\times R}{P+R^{\prime}}\right). F−measure=2(P+R′P×R).

(vii) 阴性预测值:可定义为正确标记为阴性的图像数量与阴性标记图像总数之比。

Negative predictive value = T N T N + F N . ( 6 ) \text{Negative predictive value}=\frac{TN}{TN+FN}.\quad(6) Negative predictive value=TN+FNTN.(6)

(viii) 特异性:指正确标记的阴性图像数量与阴性图像总数之比。

Specificity = T N T N + F P . \text{Specificity}=\frac{TN}{TN+FP}.\quad Specificity=TN+FPTN.

(ix) 准确率:即正确标记或错误标记的所有结果与总标记数量之比。

A c c u r a c y = T P + T N T P + F P + F N + T N . \mathrm{Accuracy}=\frac{TP+TN}{TP+FP+FN+TN}. Accuracy=TP+FP+FN+TNTP+TN.

(x) 总体准确率:其定义为所有正确标记图像的总和与现有全部图像数量的比值。

w = ∑ i = 0 n c e i i N T , ( 9 ) N T = ∑ i = 1 n c ∑ j = 1 n c e i j , \begin{gathered}w=\sum_{i=0}^{nc}e\frac{ii}{NT},\\\mathrm{(9)}\\NT=\sum_{i=1}^{nc}\sum_{j=1}^{nc}eij,\end{gathered} w=i=0∑nceNTii,(9)NT=i=1∑ncj=1∑nceij,

其中w表示总体准确率,NT表示混淆矩阵中所有非对角线元素之和,eij表示总正确单元格数。

(xi) 均方误差:最常用的误差衡量指标是均方误差。它计算目标值与模型预测值之间平方差的平均值。

M S E = 1 N ∑ J = 1 N ( y j − y j ′ ) 2 , ( 10 ) \mathrm{MSE}=\frac{1}{N}\sum_{J=1}^N\left(y_j-y_j^{\prime}\right)^2,\quad(10) MSE=N1J=1∑N(yj−yj′)2,(10)

其中N为最终迭代次数, y j y_j yj为真实值, y j , y_j^, yj,为模型预测值。

(12)平均绝对误差:当我们尝试计算实际值与预测值之间的平均值时,会使用MAE。该指标的数学表达式如下所示。

M A E = 1 N ∑ J = 1 N ∣ y j − y j ′ ∣ , ( 11 ) \mathrm{MAE}=\frac{1}{N}\sum_{J=1}^N\left|y_j-y_j^{\prime}\right|,\quad(11) MAE=N1J=1∑N yj−yj′ ,(11)

其中N为最终迭代次数, y j y_j yj为真实值, y j , y_j^, yj,为模型预测值。

(13)均方根误差:其计算简便,能更直观反映模型性能。仅需取目标值与预测值差值的平方平均值的平方根即可。数学表达式为

D = 1 N ∑ J = 1 N ( y j − y j ′ ) 2 . ( 12 ) D=\sqrt{\frac{1}{N}\sum_{J=1}^{N}\left(y_{j}-y_{j}^{\prime}\right)^{2}}.\quad(12) D=N1J=1∑N(yj−yj′)2 .(12)

(xiv) 受试者工作特征曲线下面积(AUROC):这是一项非常有趣的指标,亦称为AUC-ROC分数/曲线。计算AUROC时需使用真阳性率(TPR)和假阳性率(FPR)。其数学表达式如下:

T R P = T P T P + F N , ( 13 ) F R P = F P F P + T N . \begin{aligned}&\mathrm{TRP}=\frac{TP}{TP+FN},\\&&(13)\\&\mathrm{FRP}=\frac{FP}{FP+TN}.\end{aligned} TRP=TP+FNTP,FRP=FP+TNFP.(13)

13. 结论与未来方向

遥感图像分析广泛应用于地球监测、城市发展、城乡规划、水利工程、建筑施工需求供给以及农业规划等实时应用领域。对于从事遥感应用研究的学界而言,图像分析与分类始终是一个开放的研究课题。随着成像技术的最新发展,视频和数字图像等多媒体内容的数量和规模呈指数级增长。面对海量数字图像,如何实现自动化图像分类成为计算机视觉学界亟待解决的研究难题。

尽管近年来提出了多种研究模型,但人类认知与机器感知之间仍存在研究空白。为此,遥感图像分析领域的研究人员正在探索能够弥合这一差距的可能研究方向。早期的遥感图像分析方法基于低层特征提取和中层特征表示,这些方法在训练和测试样本有限的小规模图像基准测试中表现良好。采用具有多尺度特征的判别性特征表示可以提升学习模型的性能,但这些方法通常只能为图像分配单一标签,而当下需求是根据图像内容实现多标签标注。

构建可用于训练复杂深度网络的大规模图像基准库,是深度学习模型的主要需求之一。建立涵盖所有可能类别的遥感图像大规模基准库,既是该领域的重要需求,也是当前开放的研究课题。现有基于深度学习的研究模型主要采用微调技术和数据增强方法来优化学习效果。若具备大规模图像基准库,将有助于学习模型更高效地获取参数。现有的大规模图像基准库主要通过监督学习方式使用,这一过程耗时且计算成本高昂。探索基于无监督和半监督学习的可能学习能力,是未来潜在的研究方向。

深度学习模型的训练需要大量计算资源,目前研究模型主要采用GPU作为高性能计算设备。设计计算量更少的深度学习模型也是一个可能的研究方向,此类模型可部署在计算能力较弱的设备上运行。在遥感图像分类领域,还可探索小样本学习/零样本学习方法的运用。

参考文献

- [1] C. Shi, X. Zhang, J. Sun, and L. Wang, "Remote sensing scene image classification based on self-compensating convolution neural network," Remote Sensing, vol. 14, no. 3, p. 545, 2022.

- [2] S. Karimi Jafarbigloo and H. Danyali, "Nuclear atypia grading in breast cancer histopathological images based on cnn feature extraction and lstm classification," CAAI Transactions on Intelligence Technology, vol. 6, no. 4, pp. 426--439, 2021.

- [3] X. Zhang and G. Wang, "Stud pose detection based on photometric stereo and lightweight yolov4," Journal of Artificial Intelligence and Technology, vol. 2, no. 1, pp. 32--37, 2022.

- [4] A. Shabbir, A. Rasheed, H. Rasheed et al., "Detection of glaucoma using retinal fundus images: a comprehensive review," Mathematical Biosciences and Engineering, vol. 18, no. 3, pp. 2033--2076, 2021.

- [5] W. Zhang, P. Du, P. Fu et al., "Attention-aware dynamic selfaggregation network for satellite image time series classification," IEEE Transactions on Geoscience and Remote Sensing, vol. 60, pp. 1--17, 2022.

- [6] N. Hamid and J. R. Abdul Hamid, "Multi level image segmentation for urban land cover classifications," IOP Conference Series: Earth and Environmental Science, vol. 767, no. 1, Article ID 012024, 2021.

- [7] S. Fatima, N. Aiman Aslam, I. Tariq, and N. Ali, "Home security and automation based on internet of things: a comprehensive review," IOP Conference Series: Materials Science and Engineering, vol. 899, no. 1, Article ID 012011, 2020.

- [8] Q. Zou, K. Xiong, Q. Fang, and B. Jiang, "Deep imitation reinforcement learning for self driving by vision," CAAI Transactions on Intelligence Technology, vol. 6, no. 4, pp. 493--503, 2021.

- [9] M. Arsalan Aslam, M. Naveed Salik, F. Chughtai, N. Ali, S. Hanif Dar, and T. Khalil, "Image classification based on mid-level feature fusion," in Proceedings of the 15th International Conference on Emerging Technologies (ICET), pp. 1--6, IEEE, Peshawar, Pakistan, February 2019.

- [10] Z. Y. Lv, W. Shi, X. Zhang, and J. A. Benediktsson, "Landslide inventory mapping from bitemporal high-resolution remote sensing images using change detection and multiscale segmentation," Ieee Journal of Selected Topics in Applied Earth Observations and Remote Sensing, vol. 11, no. 5, pp. 15201532, 2018.

- [11] D. D. Nguyen, L. T. Ngo, L. T. Pham, and W. Pedrycz, "Towards hybrid clustering approach to data classification: multiple kernels based interval-valued fuzzy c-means algorithms," Fuzzy Sets and Systems, vol. 279, pp. 17--39, 2015.

- [12] M. Sajid, N. Ali, S. H. Dar et al., "Data augmentation-assisted makeup-invariant face recognition," Mathematical Problems in Engineering, vol. 2018, pp. 1--10, Article ID 2850632, 2018.

- [13] M. Saqlain, S. Rubab, M. M. Khan, N. Ali, and S. Ali, "Hybrid approach for shelf monitoring and planogram compliance (hyb-smpc) in retails using deep learning and computer vision," Mathematical Problems in Engineering, vol. 2022, pp. 1--18, Article ID 4916818, 2022.

- [14] N. Ali, B. Zafar, F. Riaz et al., "A hybrid geometric spatial image representation for scene classification," PLoS One, vol. 13, no. 9, Article ID 0203339, 2018.

- [15] A. Latif, A. Rasheed, U. Sajid et al., "Content-based image retrieval and feature extraction: a comprehensive review," Mathematical Problems in Engineering, vol. 2019, pp. 1--21, Article ID 9658350, 2019.

- [16] K. Yadav, M. Yadav, and S. Saini, "Stock values predictions using deep learning based hybrid models," CAAI Transactions on Intelligence Technology, vol. 7, no. 1, pp. 107--116, 2022.

- [17] Ke Li, G. Wan, G. Cheng, L. Meng, and J. Han, "Object detection in optical remote sensing images: a survey and a new benchmark," ISPRS Journal of Photogrammetry and Remote Sensing, vol. 159, pp. 296--307, 2020.

- [18] M. Asif, M. Bin Ahmad, S. Mushtaq, K. Masood, T. Mahmood, and A. Ali Nagra, "Long multi-digit number recognition from images empowered by deep convolutional neural networks," ?e Computer Journal, vol. 117, 2021.

- [19] Qi Wang, S. Liu, J. Chanussot, and X. Li, "Scene classification with recurrent attention of vhr remote sensing images," IEEE Transactions on Geoscience and Remote Sensing, vol. 57, no. 2, pp. 1155--1167, 2019.

- [20] S. Li, W. Song, L. Fang, Y. Chen, P. Ghamisi, and J. A. Benediktsson, "Deep learning for hyperspectral image classification: an overview," IEEE Transactions on Geoscience and Remote Sensing, vol. 57, no. 9, pp. 6690--6709, 2019.

- [21] Si B. Chen, Q. S. Wei, W.-Z. Wang, J. Tang, B. Luo, and Zu. Y. Wang, "Remote sensing scene classification via multibranch local attention network," IEEE Transactions on Image Processing, vol. 31, pp. 99--109, 2022.

- [22] N. Ali, B. Zafar, M. K. Iqbal et al., "Modeling global geometric spatial information for rotation invariant classification of satellite images," PLoS One, vol. 14, no. 7, Article ID 0219833, 2019.

- [23] X. Wang, S. Wang, C. Ning, and H. Zhou, "Enhanced feature pyramid network with deep semantic embedding for remote sensing scene classification," IEEE Transactions on Geoscience and Remote Sensing, vol. 59, no. 9, pp. 7918--7932, 2021.

- [24] M. M. Elkholy, M. S. Mostafa, H. M. Ebeid, and M. Tolba, "Unsupervised hyperspectral band selection with deep autoencoder unmixing," International Journal of Image and Data Fusion, vol. 13, no. 3, pp. 244--261, 2021.

- [25] A. Vali, S. Comai, and M. Matteucci, "Deep learning for land use and land cover classification based on hyperspectral and multispectral earth observation data: a review," Remote Sensing, vol. 12, no. 15, p. 2495, 2020.

- [26] H. Yang and W. Yang, "Gscctl: a general semi-supervised scene classification method for remote sensing images based on clustering and transfer," International Journal of Remote Sensing, pp. 1--25, 2022.

- [27] P. K. Sethy, "Identification of wheat tiller based on alexnet feature fusion," Multimedia Tools and Applications, vol. 81, pp. 8309--8316, 2022.

- [28] D. Wang, C. Zhang, and M. Han, "Mlfc net: a multi level feature combination attention model for remote sensing scene classification," Computers & Geosciences, vol. 160, Article ID 105042, 2022.

- [29] O. Kechagias-Stamatis and N. Aouf, "Automatic target recognition on synthetic aperture radar imagery: a survey," IEEE Aerospace and Electronic Systems Magazine, vol. 36, no. 3, pp. 56--81, 2021.

- [30] L. Gomez-Chova, D. Tuia, G. Moser, and G. Camps-Valls, "Multimodal classification of remote sensing images: a review and future directions," Proceedings of the IEEE, vol. 103, no. 9, pp. 1560--1584, 2015.

- [31] L. Zhang, L. Zhang, and Bo Du, "Deep learning for remote sensing data: a technical tutorial on the state of the art," IEEE Geoscience and remote sensing magazine, vol. 4, no. 2, pp. 22--40, 2016.

- [32] X. X. Zhu, D. Tuia, L. Mou et al., "Deep learning in remote sensing: a comprehensive review and list of resources," IEEE Geoscience and Remote Sensing Magazine, vol. 5, no. 4, pp. 8--36, 2017.

- [33] P. Ghamisi, J. Plaza, Y. Chen, J. Li, and A. J. Plaza, "Advanced spectral classifiers for hyperspectral images: a review," IEEE Geoscience and Remote Sensing Magazine, vol. 5, no. 1, pp. 8--32, 2017.

- [34] U. Chakraborty and D. Chakraborty, "Remote sensing image classification: a survey of support-vector-machine-based advanced techniques," IEEE Geoscience and Remote Sensing Magazine, vol. 5, no. 1, pp. 33--52, 2017.

- [35] W. Zhou, S. Newsam, C. Li, and Z. Shao, "Patternnet: a benchmark dataset for performance evaluation of remote sensing image retrieval," ISPRS Journal of Photogrammetry and Remote Sensing, vol. 145, pp. 197--209, 2018.

- [36] G. Cheng, J. Han, and X. Lu, "Remote sensing image scene classification: benchmark and state of the art," Proceedings of the IEEE, vol. 105, no. 10, pp. 1865--1883, 2017.

- [37] L. He, J. Li, C. Liu, and S. Li, "Recent advances on spectralspatial hyperspectral image classification: an overview and new guidelines," IEEE Transactions on Geoscience and Remote Sensing, vol. 56, no. 3, pp. 1579--1597, 2018.

- [38] L. Ma, Yu Liu, X. Zhang, Y. Ye, G. Yin, and B. A. Johnson, "Deep learning in remote sensing applications: a meta analysis and review," ISPRS Journal of Photogrammetry and Remote Sensing, vol. 152, pp. 166--177, 2019.

- [39] S. Kumar and D. Kumar, "A review of remotely sensed satellite image classification," International Journal of Electrical and Computer Engineering, vol. 9, no. 3, p. 1720, 2019.

- [40] G. Cheng, X. Xie, J. Han, L. Guo, and G. S. Xia, "Remote sensing image scene classification meets deep learning: challenges, methods, benchmarks, and opportunities," Ieee Journal of Selected Topics in Applied Earth Observations and Remote Sensing, vol. 13, pp. 3735--3756, 2020.

- [41] M. Govind and S. K. Pandeyand Dr, A Comparative Study on Supervised and Unsupervised Techniques of Land Use and Land Cover Classification, 2022.

- [42] G. De Luca, "A survey of nisq era hybrid quantum classical machine learning research," Journal of Artificial Intelligence and Technology, vol. 2, no. 1, pp. 9--15, 2022.

- [43] M. Alyas Khan, M. Ali, M. Shah et al., "Machine learningbased detection and classification of walnut fungi diseases," Intelligent Automation & Soft Computing, vol. 30, no. 3, pp. 771--785, 2021.

- [44] V. Nasiri, A. A. Darvishsefat, H. Arefi, V. C. Griess, S. M. M. Sadeghi, and S. A. Borz, "Modeling forest canopy cover: a synergistic use of sentinel 2, aerial photogrammetry data, and machine learning," Remote Sensing, vol. 14, no. 6, p. 1453, 2022.

- [45] D. Cabrera, L. Cabrera, and E. Cabrera, "Perspectives organize information in mind and nature: empirical findings of point-view perspective § in cognitive and material complexity," Systems, vol. 10, no. 3, p. 52, 2022.

- [46] N. Ali, K. B. Bajwa, R. Sablatnig et al., "A novel image retrieval based on visual words integration of sift and surf," PLoS One, vol. 11, no. 6, Article ID 0157428, 2016.

- [47] M. Wang, M. Wander, S. Mueller, N. Martin, and J. B. Dunn, "Evaluation of survey and remote sensing data products used to estimate land use change in the United States: evolving issues and emerging opportunities," Environmental Science & Policy, vol. 129, pp. 68--78, 2022.

- [48] R. Jacobsen, C. A. Bernabel, M. Hobbs, N. Oishi, M. PuigHall, and Z. Shannon, "Machine learning: paving the way for more efficient disaster relief," AIAA SCITECH 2022 Forum, p. 0397, 2022.

- [49] Z. Zheng, S. Du, H. Taubenb ̈ock, and X. Zhang, "Remote sensing techniques in the investigation of aeolian sand dunes: a review of recent advances," Remote Sensing of Environment, vol. 271, Article ID 112913, 2022.

- [50] D. J. Lary, A. H. Alavi, A. H. Gandomi, and A. L. Walker, "Machine learning in geosciences and remote sensing," Geoscience Frontiers, vol. 7, no. 1, pp. 3--10, 2016.

- [51] N. Ali, K. B. Bajwa, R. Sablatnig, and Z. Mehmood, "Image retrieval by addition of spatial information based on histograms of triangular regions," Computers & Electrical Engineering, vol. 54, pp. 539--550, 2016.

- [52] A. Ben Hamida, A. Benoit, P. Lambert, and C. Ben Amar, "3 d deep learning approach for remote sensing image classification," IEEE Transactions on Geoscience and Remote Sensing, vol. 56, no. 8, pp. 4420--4434, 2018.

- [53] B. Zafar, R. Ashraf, N. Ali et al., "Intelligent image classification-based on spatial weighted histograms of concentric circles," Computer Science and Information Systems, vol. 15, no. 3, pp. 615--633, 2018.

- [54] B. Zafar, R. Ashraf, N. Ali, M. Ahmed, S. Jabbar, and S. A. Chatzichristofis, "Image classification by addition of spatial information based on histograms of orthogonal vectors," PLoS One, vol. 13, no. 6, Article ID 0198175, 2018.

- [55] M. Jain, M. Bajwa, H. Kumar et al., "Agriculture assistant for crop prediction and farming selection using machine learning model with real-time data using imaging through uav drone," in Emergent Converging Technologies and Biomedical Systems, pp. 311--330, Springer, Singapore, 2022.

- [56] C. Pati, A. K. Panda, A. K. Tripathy, S. K. Pradhan, and S. Patnaik, "A novel hybrid machine learning approach for change detection in remote sensing images," Engineering Science and Technology, an International Journal, vol. 23, no. 5, pp. 973--981, 2020.

- [57] Y. Li, J. Ma, and Y. Zhang, "Image retrieval from remote sensing big data: a survey," Information Fusion, vol. 67, pp. 94--115, 2021.

- [58] H. Shirmard, E. Farahbakhsh, R. D. Mu ̈ller, and R. Chandra, "A review of machine learning in processing remote sensing data for mineral exploration," Remote Sensing of Environment, vol. 268, Article ID 112750, 2022.

- [59] A. J. Moshayedi, A. S. Roy, A. Kolahdooz, and Y. Shuxin, "Deep learning application pros and cons over algorithm," EAI Endorsed Transactions on AI and Robotics, vol. 1, pp. 1--13, 2022.

- [60] K. D. P. Pijush, S. Pal, M. Mukhopadhyay, and S. P. Singh, "Big data classification: techniques and tools," in Applications of Big Data in Healthcare, pp. 1--43, Elsevier, Landran, India, 2021.

- [61] M. Sajid, N. Ali, N. I. Ratyal et al., "Deep learning in ageinvariant face recognition: a comparative study," ?e Computer Journal, vol. 65, no. 4, pp. 940--972, 2022.

- [62] K. Schulz, R. H ̈ansch, and U. So ̈rgel, "Machine learning methods for remote sensing applications: an overview," Earth resources and environmental remote sensing/GIS applications, Article ID 1079002, 2018.

- [63] M. Awais, W. Li, S. Hussain et al., "Comparative evaluation of land surface temperature images from unmanned aerial vehicle and satellite observation for agricultural areas using in situ data," Agriculture, vol. 12, no. 2, p. 184, 2022.

- [64] M. Sarafanov, E. Kazakov, N. O. Nikitin, and A. V. Kalyuzhnaya, "A machine learning approach for remote sensing data gap-filling with open bsource implementation: an example regarding land surface temperature, surface albedo and ndvi," Remote Sensing, vol. 12, no. 23, p. 3865, 2020.

- [65] A. Shabbir, N. Ali, J. Ahmed et al., "Satellite and scene image classification based on transfer learning and fine tuning of resnet50," Mathematical Problems in Engineering, vol. 2021, pp. 1--18, Article ID 5843816, 2021.

- [66] M. Kadhim and M. Abed, M. Huk, M. Maleszka, and E Szczerbicki, Convolutional neural network for satellite image classification," in Asian Conference on Intelligent Information and Database Systems, pp. 165--178, Springer, Cham, 2019.

- [67] Q. Liu, S. Basu, S. Ganguly et al., "Deepsat v2: feature augmented convolutional neural nets for satellite image classification," Remote Sensing Letters, vol. 11, no. 2, pp. 156--165, 2020.

- [68] M. A. Shafaey, H. Ebied, M. N. Al-Berry et al., "Deep learning for satellite image classification," in International Conference on Advanced Intelligent Systems and Informatics, pp. 383391, Springer, 2018.

- [69] Q. Zhu, Y. Zhong, L. Zhang, and D. Li, "Adaptive deep sparse semantic modeling framework for high spatial resolution image scene classification," IEEE Transactions on Geoscience and Remote Sensing, vol. 56, no. 10, pp. 1--16, 2018.

- [70] J. Xie, N. He, L. Fang, and A. Plaza, "Scale-free convolutional neural network for remote sensing scene classification," IEEE Transactions on Geoscience and Remote Sensing, vol. 57, no. 9, pp. 6916--6928, 2019.

- [71] J. Fang, Y. Yuan, X. Lu, and Y. Feng, "Robust space-frequency joint representation for remote sensing image scene classification," IEEE Transactions on Geoscience and Remote Sensing, vol. 57, no. 10, pp. 7492--7502, 2019.

- [72] Y. Liu, Y. Zhong, and Q. Qin, "Scene classification based on multiscale convolutional neural network," IEEE Transactions on Geoscience and Remote Sensing, vol. 56, no. 12, pp. 7109--7121, 2018.

- [73] X. Lu, H. Sun, and X. Zheng, "A feature aggregation convolutional neural network for remote sensing scene classification," IEEE Transactions on Geoscience and Remote Sensing, vol. 57, no. 10, pp. 7894--7906, 2019.

- [74] R. Zhu, Li Yan, Mo Mo, and Yi Liu, "AttentionBased deep feature fusion for the scene classification of HighResolution remote sensing images," Remote Sensing, vol. 11, no. 17, p. 1996, 2019.

- [75] W. Zhang, P. Tang, and L. Zhao, "Remote sensing image scene classification using cnn-capsnet," Remote Sensing, vol. 11, no. 5, p. 494, 2019.

- [76] G. S. Xia, J. Hu, F. Hu et al., "Aid: a benchmark data set for performance evaluation of aerial scene classification," IEEE Transactions on Geoscience and Remote Sensing, vol. 55, no. 7, pp. 3965--3981, 2017.

- [77] F. Zhang, Bo Du, and L. Zhang, "Scene classification via a gradient boosting random convolutional network framework," IEEE Transactions on Geoscience and Remote Sensing, vol. 54, no. 3, pp. 1793--1802, 2016.

- [78] R. S. A. Kareem, A. G. Ramanjineyulu, R. Rajan et al., "Multilabel land cover aerial image classification using convolutional neural networks," Arabian Journal of Geosciences, vol. 14, no. 17, p. 1681, 2021.

- [79] Y. Zhong, F. Fei, and L. Zhang, "Large patch convolutional neural networks for the scene classification of high spatial resolution imagery," Journal of Applied Remote Sensing, vol. 10, no. 2, Article ID 025006, 2016.

- [80] M. Verma, N. Gupta, B. Tolani, and R. Kaushal, "Explainable custom cnn architecture for land use classification using satellite images,"vol. 6, pp. 304--309, in Proceedings of the Sixth International Conference on Image Information Processing (ICIIP), vol. 6, IEEE, Shimla, India, Februrary 2021.

- [81] M. Wang, X. Zhang, X. Niu, F. Wang, and X. Zhang, "Scene classification of high-resolution remotely sensed image based on resnet," Journal of Geovisualization and Spatial Analysis, vol. 3, no. 2, p. 16, 2019.

- [82] B. Zafar, R. Ashraf, N. Ali et al., "A novel discriminating and relative global spatial image representation with applications in cbir," Applied Sciences, vol. 8, no. 11, p. 2242, 2018.

- [83] Ma Zhong, Z. Wang, C. Liu, and X. Liu, "Satellite imagery classification based on deep convolution network," International Journal of Computer and Information Engineering, vol. 10, no. 6, pp. 1155--1159, 2016.

- [84] N. Laban, B. Abdellatif, M. Ebied, H. A. Shedeed, and M. F. Tolba, "Multiscale satellite image classification using deep learning approach," Studies in Computational Intelligence: Machine Learning and Data Mining in Aerospace Technology, Springer, Cham, pp. 165--186, 2020.

- [85] X. Chang, C. Li, J. Wu, Li Lei, Q. Li, and A. Benjamin, "Land cover extraction of remote sensing images with parallel convolutional network," in Proceedings of the International Conference on Agro-Geoinformatics (Agro-Geoinformatics), pp. 1--6, IEEE, Shenzhen, China, September 2021.

- [86] H. Ebied, M. Al Berry, and M. Tolba, "Deep learning for satellite image classification," in Proceedings of the International Conference on Advanced Intelligent Systems and Informatics, pp. 383--391, Springer, Cham, Switzerland, March 2018.

- [87] N. He, L. Fang, S. Li, A. Plaza, and J. Plaza, "Remote sensing scene classification using multilayer stacked covariance pooling," IEEE Transactions on Geoscience and Remote Sensing, vol. 56, no. 12, pp. 6899--6910, 2018.

- [88] N. B. Crews and K. A. Crews, "Mapping vegetation morphology types in a dry savanna ecosystem: integrating hierarchical object-based image analysis with random forest," International Journal of Remote Sensing, vol. 35, no. 3, pp. 1175--1198, 2014.

- [89] N. He, L. Fang, S. Li, J. Plaza, and A. Plaza, "Skip-connected covariance network for remote sensing scene classification," IEEE Transactions on Neural Networks and Learning Systems, vol. 31, no. 5, pp. 1461--1474, 2020.

- [90] R. Shofiyati, "&e role of remote sensing technology (latest geospatial) for agriculture in Indonesia," in 2nd International Conference on Smart and Innovative Agriculture (ICoSIA 2021), pp. 243--248, Atlantis Press, Holland, Netherlands, 2022.

- [91] H. Jiang, M. Peng, Y. Zhong et al., "A survey on deep learning-based change detection from high-resolution remote sensing images," Remote Sensing, vol. 14, no. 7, p. 1552, 2022.

- [92] Y. Tao, M. Xu, F. Zhang, Bo Du, and L. Zhang, "Unsupervised-restricted deconvolutional neural network for very high resolution remote-sensing image classification," IEEE Transactions on Geoscience and Remote Sensing, vol. 55, no. 12, pp. 6805--6823, 2017.

- [93] A. Romero, C. Gatta, and G. Camps Valls, "Unsupervised deep feature extraction for remote sensing image classification," IEEE Transactions on Geoscience and Remote Sensing, vol. 54, no. 3, pp. 1349--1362, 2016.

- [94] Z. H. Choudhury, "Encryption and encoding of facial images into quick response and high capacity color 2d code for biometric passport security system," 2022, https://arxiv.org/ abs/2203.15738.

- [95] Z. Xiong, F. Mo, X. Zhao, F. Xu, X. Zhang, and Y. Wu, "Dynamic texture classification based on 3d ica learned filters and Fisher vector encoding in big data environment," Journal of Signal Processing Systems, vol. 10, pp. 1--15, 2022.

- [96] Y. D. Kwadiki and K. Kwadiki, "Content-based image retrieval using integrated features and multi-subspace randomization and collaboration," International Journal of System Assurance Engineering and Management, pp. 1--11, 2022.

- [97] V. Babic and Z. Babic ́, "Unsupervised quaternion feature learning for remote sensing image classification," Ieee Journal of Selected Topics in Applied Earth Observations and Remote Sensing, vol. 9, no. 4, pp. 1521--1531, 2016.

- [98] S. Bujwid, A. Pieropan, H. Azizpour, A. Maki, and M. Miquel, "An Analysis of Over-sampling Labeled Data in Semi-supervised Learning with Fixmatch," 2022, https:// arxiv.org/pdf/2201.00604.pdf.

- [99] K. Abhas, R. Bloch, and J. Lamond, Cities and Flooding: A Guide to Integrated Urban Flood Risk Management for the 21st century, World Bank Publications, 2012.

- [100] D. Lin, K. Fu, Y. Wang, G. Xu, and X. Sun, "Marta gans: unsupervised representation learning for remote sensing image classification," IEEE Geoscience and Remote Sensing Letters, vol. 14, no. 11, pp. 2092--2096, 2017.

- [101] P. Ladosz, L. Weng, M. Kim, and H. Oh, Exploration in Deep Reinforcement Learning: A Survey, Information Fusion, 2022.

- [102] S. Milani, N. Topin, M. Veloso, and F. Fang, "A Survey of Explainable Reinforcement Learning," 2022, https://arxiv. org/abs/2005.06247.

- [103] M. Maroto-Go ́mez, ́A. Castro-Gonz ́alez, J. C. Castillo, M. Malfaz, and M. ́A. Salichs, "An adaptive decision-making system supported on user preference predictions for humanrobot interactive communication," User Modeling and UserAdapted Interaction, vol. 554, pp. 1--45, 2022.

- [104] X. Shen, B. Liu, Y. Zhou, J. Zhao, and M. Liu, "Remote sensing image captioning via variational autoencoder and reinforcement learning," Knowledge-Based Systems, vol. 203, Article ID 105920, 2020.

- [105] K. Huang, W. Nie, and N. Luo, "Fully polarized sar imagery classification based on deep reinforcement learning method using multiple polarimetric features," Ieee Journal of Selected Topics in Applied Earth Observations and Remote Sensing, vol. 12, no. 10, pp. 3719--3730, 2019.

- [106] T. Hermosilla, M. A. Wulder, J. C. White, and N. C. Coops, "Land cover classification in an era of big and open data: optimizing localized implementation and training data selection to improve mapping outcomes," Remote Sensing of Environment, vol. 268, Article ID 112780, 2022.

- [107] S. A. Medjahed and M. Ouali, "Band selection based on optimization approach for hyperspectral image classification," ?e Egyptian Journal of Remote Sensing and Space Science, vol. 21, no. 3, pp. 413--418, 2018.

- [108] P. Boggavarapu and P. K. L. N. Boggavarapu, "Improved whale optimization based band selection for hyperspectral remote sensing image classification," Infrared Physics & Technology, vol. 119, Article ID 103948, 2021.

- [109] Z. Zhang and G. Zhang, "Genetic algorithm-based parameter optimization for eo 1 hyperion remote sensing image classification," European Journal of Remote Sensing, vol. 53, no. 1, pp. 124--131, 2020.

- [110] F. Huang, J. Lu, J. Tao, and L. Li, "Research on optimization methods of elm classification algorithm for hyperspectral remote sensing images," IEEE Access, vol. 7, pp. 201970108089, Article ID 108070, 2019.

- [111] A. Rezaeipanah and M. Mojarad, "Modeling the scheduling problem in cellular manufacturing systems using genetic algorithm as an efficient meta-heuristic approach," Journal of Artificial Intelligence and Technology, vol. 1, no. 4, pp. 228234, 2021.

- [112] A. Rida, A. Hicham, and N. Abderrahim, "Optimization of object-based image analysis with genetic programming to generate explicit knowledge from worldview-2 data for urban mapping," in Geospatial Intelligence, pp. 157--169, Springer, Cham, Switzerland, 2022.

- [113] A. Jamshed, B. Mallick, and R. Kumar Bharti, "An Efficient Pattern Mining Convolution Neural Network (Cnn) Algorithm with Grey Wolf Optimization (Gwo)," 2022, https:// arxiv.org/abs/2204.04704.

- [114] F. Xie, C. Lei, F. Li, D. Huang, and J. Yang, "Unsupervised hyperspectral feature selection based on fuzzy c-means and grey wolf optimizer," International Journal of Remote Sensing, vol. 40, no. 9, pp. 3344--3367, 2019.

- [115] A. Kumar and S. Lekhraj, "Grey wolf optimizer and other metaheuristic optimization techniques with image processing as their applications: a review," IOP Conference Series: Materials Science and Engineering, vol. 1136, no. 1, Article ID 012053, 2021.

- [116] H. Faris, I. Aljarah, M. A. Al-Betar, and S. Mirjalili, "Grey wolf optimizer: a review of recent variants and applications," Neural Computing & Applications, vol. 30, no. 2, pp. 413435, 2018.

- [117] W. Song, S. Li, L. Fang, and T. Lu, "Hyperspectral image classification with deep feature fusion network," IEEE Transactions on Geoscience and Remote Sensing, vol. 56, no. 6, pp. 3173--3184, 2018.

- [118] J. Zhu, L. Fang, and P. Ghamisi, "Deformable convolutional neural networks for hyperspectral image classification," IEEE Geoscience and Remote Sensing Letters, vol. 15, no. 8, pp. 1254--1258, 2018.

- [119] H. Kwon and H. Kwon, "Going deeper with contextual cnn for hyperspectral image classification," IEEE Transactions on Image Processing, vol. 26, no. 10, pp. 4843--4855, 2017.

- [120] G. Cheng, Z. Li, J. Han, X. Yao, and L. Guo, "Exploring hierarchical convolutional features for hyperspectral image classification," IEEE Transactions on Geoscience and Remote Sensing, vol. 56, no. 11, pp. 6712--6722, 2018.

- [121] R. Cao, L. Fang, T. Lu, and N. He, "Self-attention-based deep feature fusion for remote sensing scene classification," IEEE Geoscience and Remote Sensing Letters, vol. 18, no. 1, pp. 43--47, 2021.

- [122] T. Deselaers, D. Keysers, and H. Ney, "Features for image retrieval: an experimental comparison," Information Retrieval, vol. 11, no. 2, pp. 77--107, 2008.

- [123] C. Zhang, Y. Chen, X. Yang et al., "Improved remote sensing image classification based on multi-scale feature fusion," Remote Sensing, vol. 12, no. 2, p. 213, 2020.

- [124] Y. Ren, X. Zhang, Y. Ma et al., "Full convolutional neural network based on multi-scale feature fusion for the class imbalance remote sensing image classification," Remote Sensing, vol. 12, no. 21, p. 3547, 2020.

- [125] C. Mu, J. Liu, Yi Liu, and Y. Liu, "Hyperspectral image classification based on active learning and spectral-spatial feature fusion using spatial coordinates," IEEE Access, vol. 8, pp. 6768--6781, 2020.

- [126] Q. Zhu, Y. Zhong, Y. Liu, L. Zhang, and D. Li, "A deep-localglobal feature fusion framework for high spatial resolution imagery scene classification," Remote Sensing, vol. 10, no. 4, p. 568, 2018.

- [127] E. Li, J. Xia, P. Du, and C. Lin, "Integrating multilayer features of convolutional neural networks for remote sensing scene classification," IEEE Transactions on Geoscience and Remote Sensing, vol. 55, no. 10, pp. 5653--5665, 2017.

- [128] Y. Yuan, J. Fang, X. Lu, and Y. Feng, "Remote sensing image scene classification using rearranged local features," IEEE Transactions on Geoscience and Remote Sensing, vol. 57, no. 3, pp. 1779--1792, 2019.

- [129] L. Kumar Tyagi, R. Kant, and A. Gupta, "A comparative analysis of various local feature descriptors in content-based image retrieval system," Journal of Physics: Conference Series, vol. 1854, Article ID 012043, 2021.

- [130] M. J. Alvarez, E. Gonzalez, F. Bianconi, J. Armesto, and A. Fernandez, "Colour and texture features for image retrieval in granite industry," Dyna, vol. 77, no. 161, pp. 121130, 2010.

- [131] M. Ahmed and M. Taha, "A brief survey on modern iris feature extraction methods," Engineering and Technology Journal, vol. 39, no. 1, pp. 123--129, 2021.

- [132] Yu-xing Li, S.-bin Jiao, and X. Gao, "A novel signal feature extraction technology based on empirical wavelet transform and reverse dispersion entropy," Defence Technology, vol. 17, no. 5, pp. 1625--1635, 2021.

- [133] H. S. Munawar, R. Aggarwal, Z. Qadir, S. I. Khan, A. Z. Kouzani, and M. A. P. Mahmud, "A gabor filter-based protocol for automated image-based building detection," Buildings, vol. 11, no. 7, p. 302, 2021.

- [134] A. S. Ismail, X. Gao, and C. Deng, "Sar image classification based on texture feature fusion," in Proceedings of the IEEE China Summit & International Conference on Signal and Information Processing (ChinaSIP), pp. 153--156, IEEE, Xi'an, China, September 2014.

- [135] H. Bi, L. Xu, X. Cao, and Z. Xu, "Polsar image classification based on three-dimensional wavelet texture features and Markov random field," in Proceedings of the IEEE International Geoscience and Remote Sensing Symposium (IGARSS), pp. 3921--3928, IEEE, Fort Worth, TX, USA, December 2017.

- [136] R. Seifi Majdar and H. Ghassemian, "A probabilistic svm approach for hyperspectral image classification using spectral and texture features," International Journal of Remote Sensing, vol. 38, no. 15, pp. 4265--4284, 2017.

- [137] X. G. Kai, Q. L. Zhi, J. J. Wang et al., "&e effect of cryogenic treatment on the microstructure and properties of ti-6al-4v titanium alloy," Materials Science Forum, vol. 747, pp. 899--903, 2013.

- [138] P. Khare and A. Khare, "Integration of wavelet transform, local binary patterns and moments for content-based image retrieval," Journal of Visual Communication and Image Representation, vol. 42, pp. 78--103, 2017.

- [139] M. Sajjad, A. Ullah, J. Ahmad, N. Abbas, S. Rho, and S. W. Baik, "Integrating salient colors with rotational invariant texture features for image representation in retrieval systems," Multimedia Tools and Applications, vol. 77, no. 4, pp. 4769--4789, 2018.

- [140] X.-yang Wang, Yu-nan Liu, H. Xu, P. Wang, and H.-ying Yang, "Robust copy-move forgery detection using quaternion exponent moments," Pattern Analysis & Applications, vol. 21, no. 2, pp. 451--467, 2018.

- [141] A. Nazir, R. Ashraf, T. Hamdani, and N. Ali, "Content based image retrieval system by using hsv color histogram, discrete wavelet transform and edge histogram descriptor," in Proceedings of the international conference on computing, mathematics and engineering technologies (iCoMET), pp. 16, IEEE, Sukkur, Pakistan, April 2018.

- [142] M. I. &usnavis Bella and A. Vasuki, "An efficient image retrieval framework using fused information feature," Computers & Electrical Engineering, vol. 75, pp. 46--60, 2019.

- [143] R. Ashraf, M. Ahmed, U. Ahmad, M. A. Habib, S. Jabbar, and K. Naseer, "Mdcbir-mf: multimedia data for content-based image retrieval by using multiple features," Multimedia Tools and Applications, vol. 79, no. 13-14, pp. 8553--8579, 2020.

- [144] M. K. Alsmadi, "Content based image retrieval using color, shape and texture descriptors and features," Arabian Journal for Science and Engineering, vol. 45, no. 4, pp. 3317--3330, 2020.

- [145] P. Alexey, S. Hitesh, I. Babakov, S. Parkhi, and G. Buddhawar, "Content-based image retrieval using color, texture and shape features," Key Engineering Materials, vol. 685, pp. 872--876, 2016.

- [146] B. S. Phadikar, A. Phadikar, and G. K. Maity, "Content-based image retrieval in dct compressed domain with mpeg-7 edge descriptor and genetic algorithm," Pattern Analysis & Applications, vol. 21, no. 2, pp. 469--489, 2018.

- [147] L. K. Sharmila and T. S. Sharmila, "An efficient framework for image retrieval using color, texture and edge features," Computers & Electrical Engineering, vol. 70, pp. 580--593, 2018.

- [148] G. Alimjan, T. Sun, Yi Liang, H. Jumahun, and Yu Guan, "A new technique for remote sensing image classification based on combinatorial algorithm of svm and knn," International Journal of Pattern Recognition and Artificial Intelligence, vol. 32, no. 07, Article ID 1859012, 2018.

- [149] L. N. Neelamsetti and P. Neelamsetti, "Multi temporal land use classification using hybrid approach," ?e Egyptian Journal of Remote Sensing and Space Science, vol. 18, no. 2, pp. 289--295, 2015.

- [150] A. Qayyum, A. Saeed Malik, N. M. Saad et al., "Image classification based on sparse-coded features using sparse coding technique for aerial imagery: a hybrid dictionary approach," Neural Computing & Applications, vol. 31, no. 8, pp. 3587--3607, 2019.

- [151] Ce Zhang, X. Pan, H. Li et al., "A hybrid mlp-cnn classifier for very fine resolution remotely sensed image classification," ISPRS Journal of Photogrammetry and Remote Sensing, vol. 140, pp. 133--144, 2018.

- [152] R. Nijhawan, H. Sharma, H. Sahni, and A. Batra, "A deep learning hybrid cnn framework approach for vegetation cover mapping using deep features," in Proceedings of the 13th International Conference on Signal-Image Technology & Internet-Based Systems (SITIS), pp. 192--196, IEEE, Jaipur, India, April 2017.

- [153] S. V. S. Prasad, T. S. Savithri, and I. Murali Krishna, "Comparison of accuracy measures for rs image classification using svm and ann classifiers," International Journal of Electrical and Computer Engineering, vol. 7, no. 3, p. 1180, 2017.

- [154] M. D. Yang, K. S. Huang, Yi H. Kuo, H. P. Tsai, and L.-M. Lin, "Spatial and spectral hybrid image classification for rice lodging assessment through uav imagery," Remote Sensing, vol. 9, no. 6, p. 583, 2017.

- [155] J. Akshya and P. L. K. Priyadarsini, "A hybrid machine learning approach for classifying aerial images of flood-hit areas," in Proceedings of the International Conference on Computational Intelligence in Data Science (ICCIDS), pp. 1--5, IEEE, Chennai, India, October 2019.

- [156] Y. Hua, L. Mou, and X. Zhu, "Recurrently exploring classwise attention in a hybrid convolutional and bidirectional lstm network for multi-label aerial image classification," ISPRS Journal of Photogrammetry and Remote Sensing, vol. 149, pp. 188--199, 2019.

- [157] K. Bitner and K. Bittner, "Automatic building footprint extraction from multi-resolution remote sensing images using a hybrid fcn," ISPRS International Journal of GeoInformation, vol. 8, no. 4, p. 191, 2019.

- [158] P. Deepan and L. R. Sudha, Scene classification of remotely sensed images using ensembled machine learning models, pp. 535--550, Environmental Science, Springer, Singapore, 2021.