一、起源与早期发展(2010-2015)

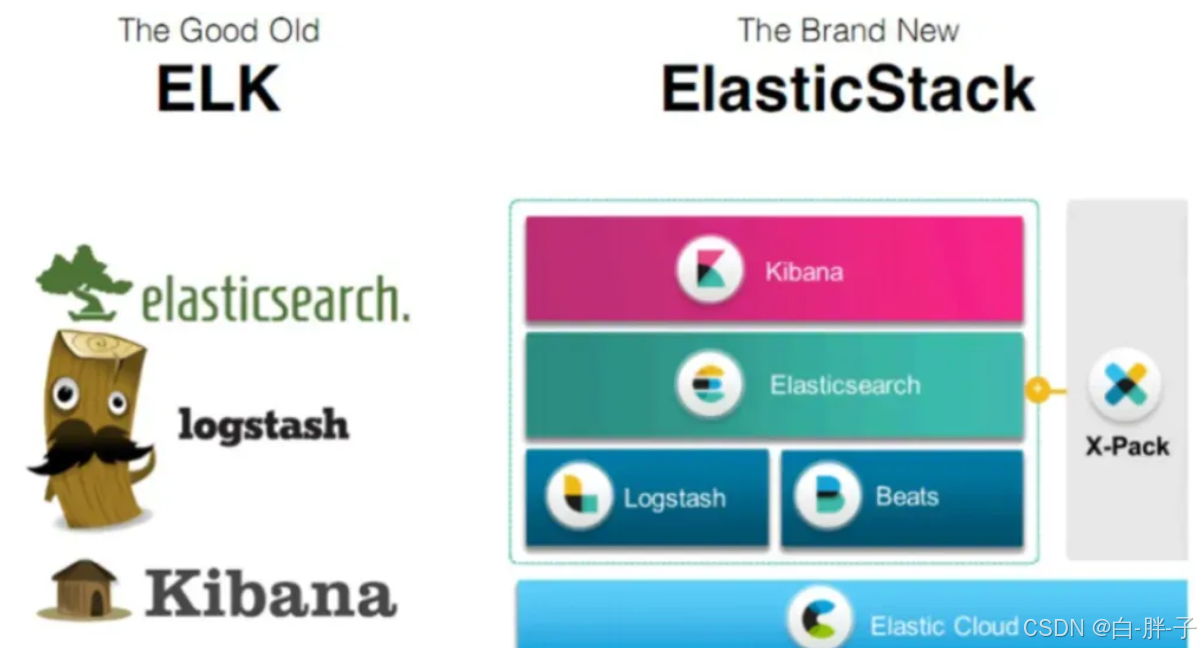

ELK技术栈的诞生源于互联网时代对海量日志处理的迫切需求。2010年,Elasticsearch作为基于Apache Lucene的分布式搜索引擎问世,其核心能力包括实时全文检索、倒排索引和分片存储机制,填补了传统数据库在非结构化数据处理上的不足。随后,Logstash作为日志采集和过滤引擎加入生态,通过插件化架构支持多源数据输入(如Syslog、JDBC、Kafka)和Grok正则解析,实现结构化与非结构化日志的统一处理。2013年Kibana的发布完成了技术闭环,其基于D3.js的可视化引擎和Canvas画布功能,使得时序数据聚合(如Date Histogram、Terms Aggregation)结果可通过Dashboard动态呈现。

此时的典型架构为单层直连模式:Logstash Agent部署于各节点,通过TCP/UDP协议直传至Elasticsearch集群。该架构虽简单,但存在资源消耗高(Logstash Java堆内存占用超2GB/节点)和可靠性缺陷(无缓冲队列易丢数据)。

二、架构革新与生态扩展(2016-2020)

为应对企业级需求,ELK架构经历三次重大迭代:

- 消息队列引入:通过Kafka或Redis实现生产者-消费者解耦,Logstash Indexer从Agent模式升级为中央处理集群,支持背压机制和流量削峰,数据可靠性提升至99.99%。

- 轻量化数据采集:Logstash-forwarder(后演进为Filebeat)采用Go语言重构,CPU占用从15%降至3%,内存消耗从2GB压缩至100MB,并支持SSL/TLS加密传输。

- 模块化扩展:Beats家族(Metricbeat、Packetbeat等)覆盖基础设施监控、网络流量分析等场景,形成完整可观测性解决方案。

技术栈核心组件同步升级:

• Elasticsearch:引入Doc Values列式存储,聚合查询性能提升5倍;跨集群复制(CCR)支持异地多活部署。

• Logstash:Pipeline批处理机制优化,配合Persistent Queues实现至少一次语义(At-Least-Once Delivery)。

• Kibana:集成Canvas实现动态报表,APM模块支持分布式追踪(Trace ID注入与火焰图分析)。

三、现状与应用场景(2021-2025)

当前ELK技术栈(Elastic Stack 8.x)已发展为覆盖日志、指标、追踪的三位一体可观测平台,主要应用场景包括:

-

智能运维监控

• 日志分析:通过Ingest Pipeline实现日志字段实时解析,结合Machine Learning模块检测异常模式(如错误率突增、高频慢查询)。

• 性能诊断:APM Agent自动注入应用埋点,追踪微服务调用链,定位99th百分位延迟瓶颈。

• 容量规划:基于Rollup API对历史指标降采样,预测存储增长趋势(如TSDB预测误差<3%)。

-

安全威胁狩猎

• SIEM集成:通过Elastic Common Schema(ECS)标准化日志格式,关联防火墙、IDS事件,检测横向移动、权限滥用等APT行为。

• 合规审计:利用Transform API生成用户行为基线,实时比对GDPR/等保2.0合规要求。

-

业务智能分析

• 用户画像:借助Terms Enrichment扩展用户标签,通过Kibana Lens构建RFM分层模型。

• A/B测试:在Kibana中配置对比查询(如对比实验组/对照组转化率),显著性检验结果秒级可视化。

四、技术架构最佳实践

-

部署拓扑

• 大型集群:采用Hot-Warm架构,SSD存储热节点处理实时写入,HDD存储暖节点存放历史数据,冷数据通过ILM策略自动归档至S3。

• 安全加固:启用RBAC(Role-Based Access Control)和TLS双向认证,通过Cross-Cluster Search实现多租户隔离。

-

性能调优

• 索引设计:按时间周期划分索引(如logs-YYYY.MM.DD),设置15-30GB分片大小,禁用_all字段降低存储开销20%。

• JVM配置:堆内存设为物理内存50%(不超过32GB),启用G1GC并设置-XX:MaxGCPauseMillis=200ms。

-

生态整合

• 流处理:通过Kafka Connect Elasticsearch Sink实现流批一体处理,Exactly-Once语义保障金融级数据一致性。

• 云原生:在Kubernetes中部署ECK(Elastic Cloud on Kubernetes),通过Operator实现自动扩缩容和滚动升级。

五、行业应用案例

• 携程旅行网:日均处理160亿条日志(5TB),通过冷热数据分层和查询路由优化,聚合查询响应时间从15s降至800ms。

• 某头部电商:基于Elasticsearch向量检索实现商品语义搜索,召回率提升40%,GMV增长12%。

技术价值与趋势展望

ELK技术栈通过持续进化,已从单一日志工具发展为企业级数据操作系统。其核心价值体现在:

• 开放性:Apache 2.0协议支持二次开发,避免厂商锁定。

• 扩展性:通过自定义Analyzer、Painless Scripting满足业务定制需求。

• 实时性:Refresh Interval可调至1s,支持流式数据分析。

未来技术演进将聚焦:

- Serverless化:按查询量弹性计费,冷启动延迟<100ms。

- AI增强:集成大语言模型实现自然语言查询(NL2SQL)。

- 边缘计算:轻量级Beats代理支持离线同步与边缘聚合。

ELK的持续创新证明,开源生态在解决企业级数据挑战中具有不可替代性,其技术路径为下一代数据分析平台树立了标杆。