一、Wan2.1系列

Wan2.1 系列是阿里巴巴通义实验室推出的开源视频生成模型套件,共有 4 个模型,包括文生视频的 Wan2.1-T2V-1.3B 和 Wan2.1-T2V-14B,以及图生视频的 Wan2.1-I2V-14B

在权威评测集 VBench 中,Wan2.1 以总分 86.22% 的成绩登上榜首位置,大幅领先了 Sora、Minimax、Luma、Gen3、Pika 等国内外视频生成模型

具体来说,Wan2.1开源了文生视频和图生视频两种模型。

其中,文生视频模型有1.3B和14B两种大小,图生视频模型大小都是14B,不过,一个是480P,另一个是720P。

大尺寸14B版本主打高性能,但1.3B小版本适合消费级显卡,只需要 8.2GB 显存就可以生成 480P 高质量视频。

也即是说,只要你有一张4060显卡(8G显存),就能跑得动这个模型,并且可以在大约4分钟以内生成5秒的480p视频。

刚好,ComfyUI官方也支持了Wan2.1模型,所以,这篇文章就带大家一步一步在本地部署Wan2.1模型。

二、ComfyUI

ComfyUI 和大家熟知的 WebUI 一样,都是 Stable Diffusion 的一种用户界面,可以实现文生图、图生图、图像处理、AI 视频生成等操作。但 ComfyUI 是节点式模块化的界面,需要用户自己搭建工作流,而且各方面的资源比较松散,需要自己安装部署,因此入门难度较高,不适合零基础的 AI 绘画小白,一般都推荐大家先掌握 Stable Diffusion WebUI 的用法,再学习 ComfyUI。

ComfyUI 越来越受欢迎,是因为用户可以按需要搭建自定义工作流,高效完成各种图像生成任务,很多最新的 AI 技术比如 SVD、InstantID 发布没多久就能在 ComfyUI 中用上,这点是 WebUI 做不到的;ComfyUI 会将图像生成流程保存为工作流(workflow)文件,下次使用时直接拖入界面加载就行,这样不仅方便自己复用已有工作流,还能轻松借用大神的生成作品;而且 ComfyUI 对低显存用户也更友好,在 WebUI 中容易爆显存生成任务在 ComfyUI 中可以顺利完成。

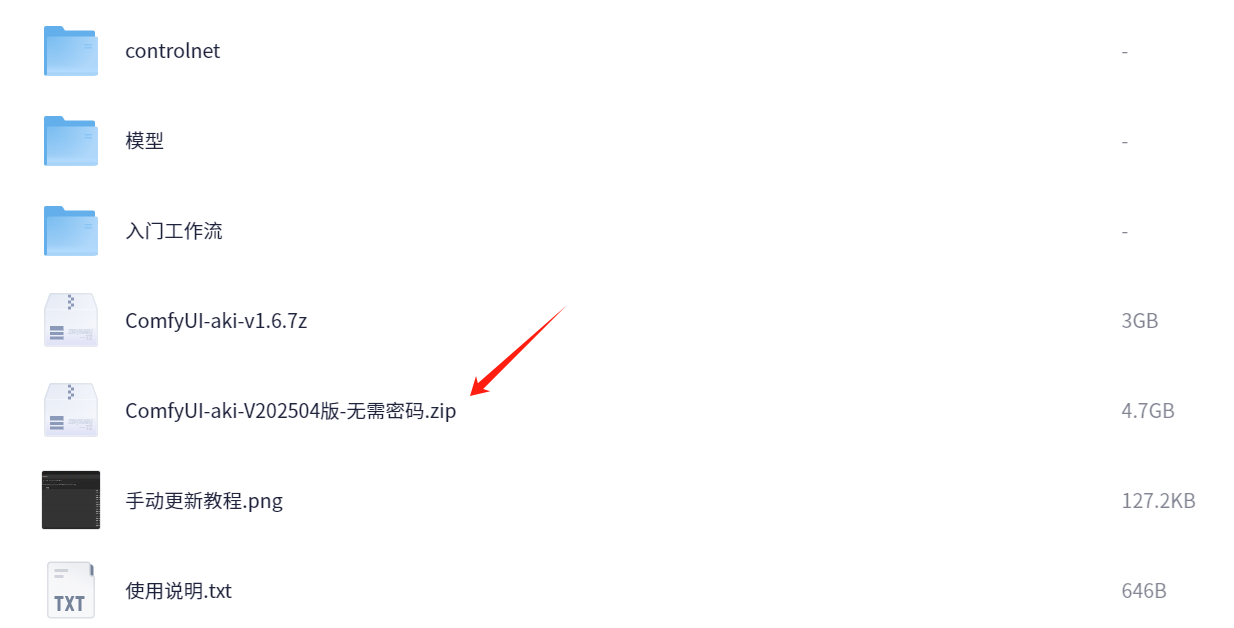

下载

夸克网盘

链接:https://pan.quark.cn/s/fed0656eb3f1

打开链接,只需要下载ComfyUI-aki-V202504版-无需密码.zip,其他文件不需要下载。

安装

解压zip文件,得到文件夹ComfyUI-aki-V202504版-无需密码,进入目录ComfyUI-aki-V202504版

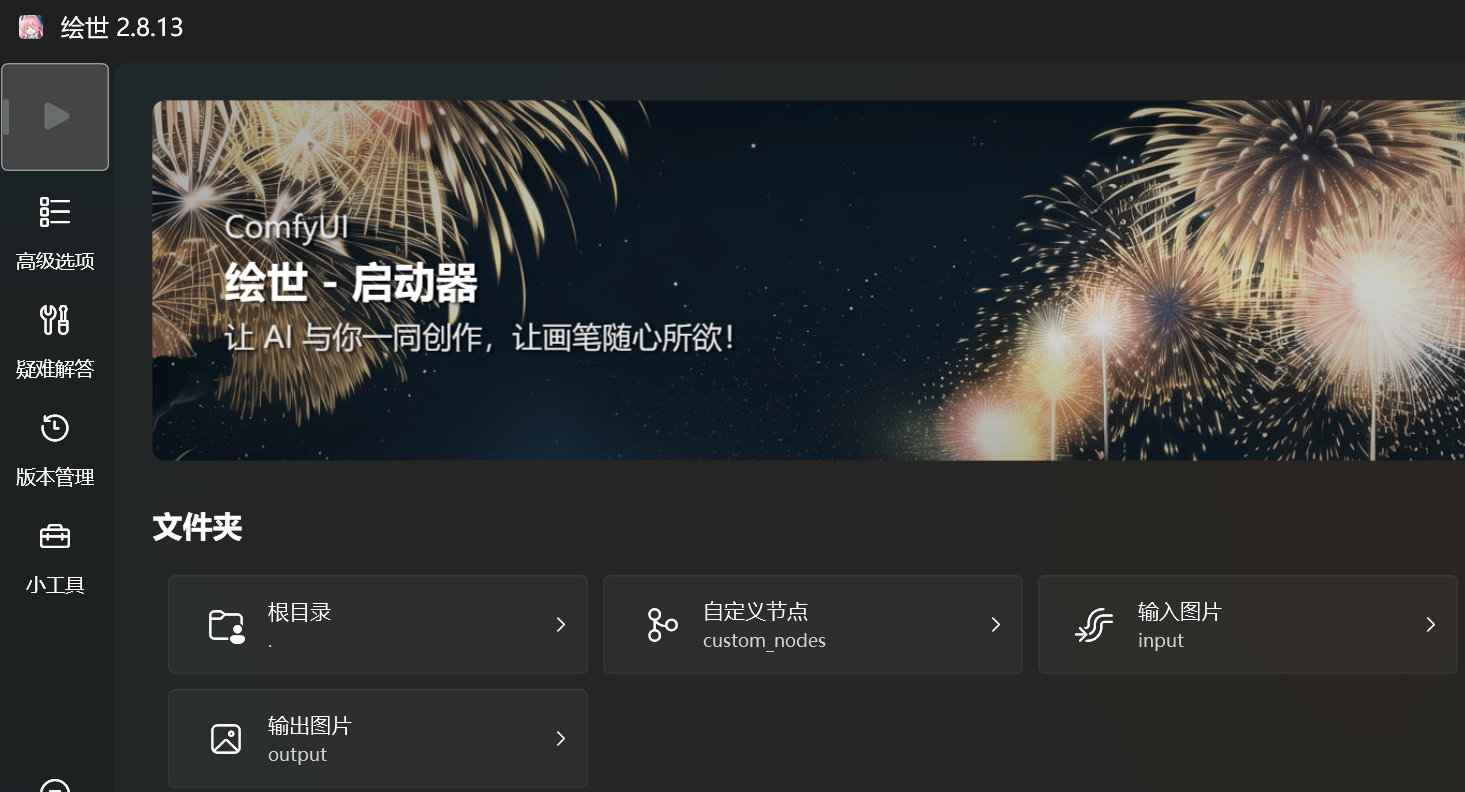

双击文件,绘世启动器.exe

第一次打开,会提示安装组件windowsdesktop-runtime,安装提示下载安装即可。

安装完成,首页效果如下:

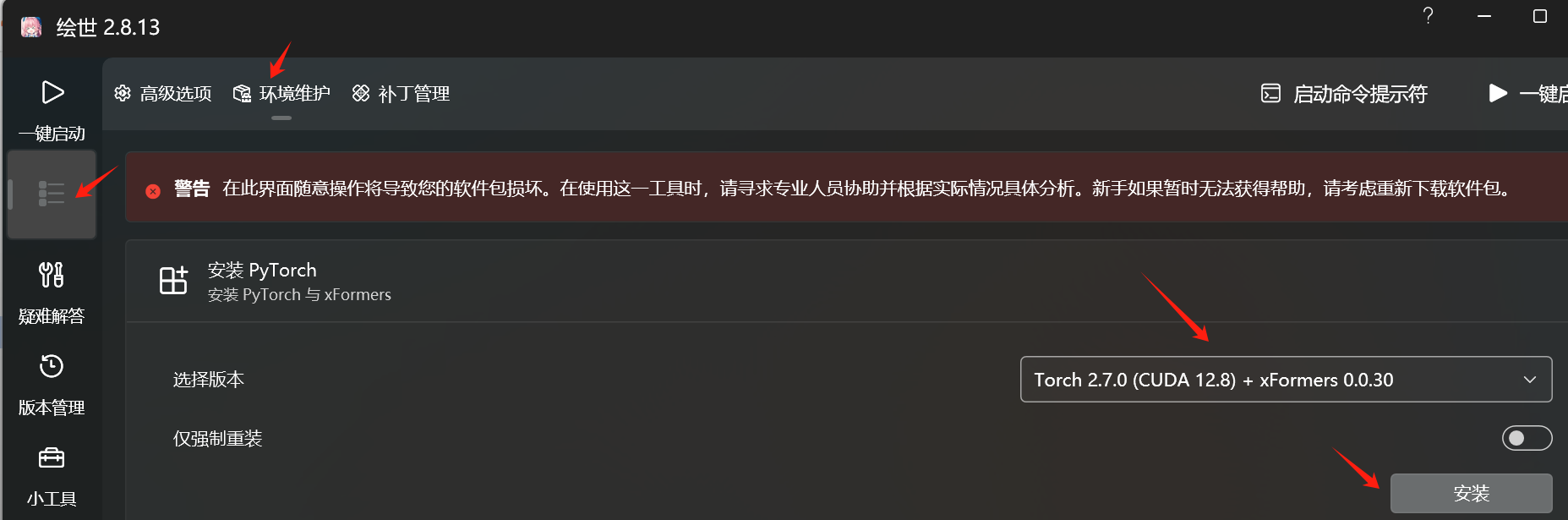

点击左侧的高级选项-->环境维护-->安装PyTorch,选择最新版本CUDA 12.8,点击安装。

安装需要一点时间,请耐心等待

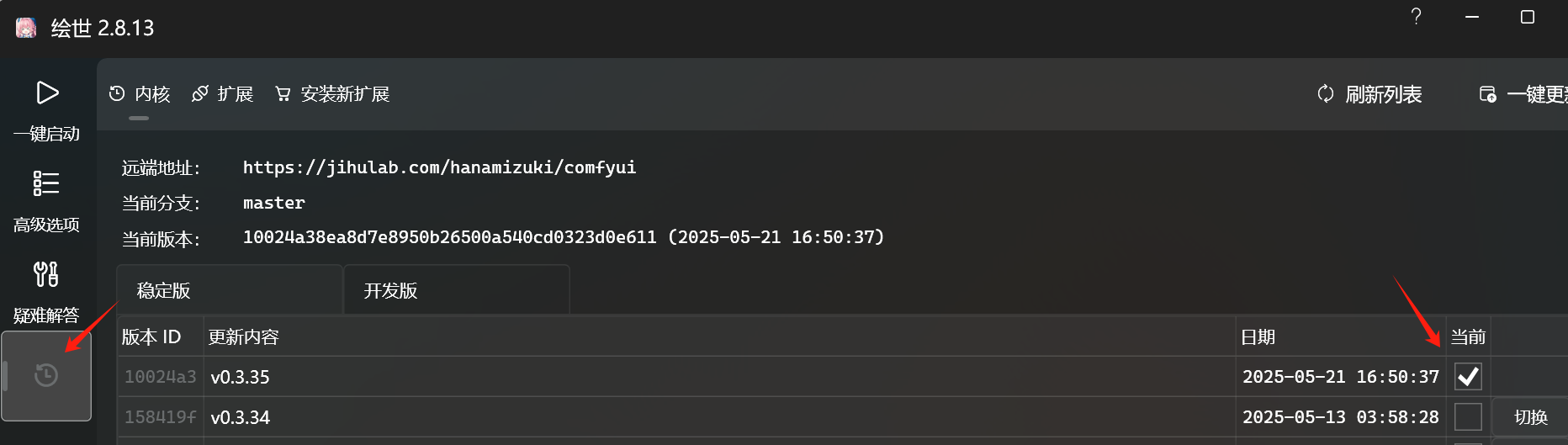

点击版本管理,更新到最新版本

三、ComfyUI模型文件下载

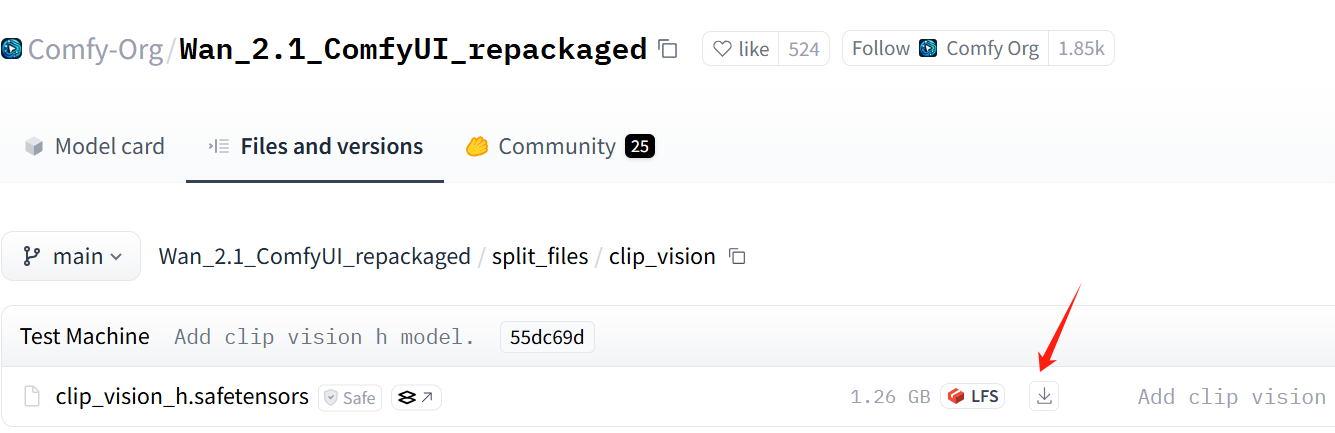

clip_vision下载

打开下面这个页面,下载clip_vision:

https://huggingface.co/Comfy-Org/Wan_2.1_ComfyUI_repackaged/tree/main/split_files/clip_vision

下载文件

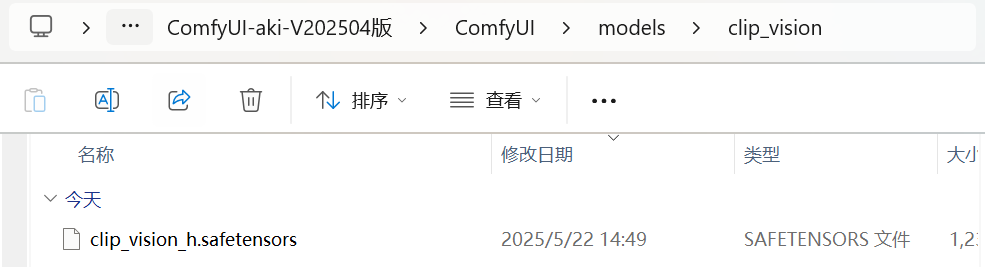

下载到本地后,移到下载到本地后,移到ComfyUI整合包的ComfyUI\models\clip_vision目录下。

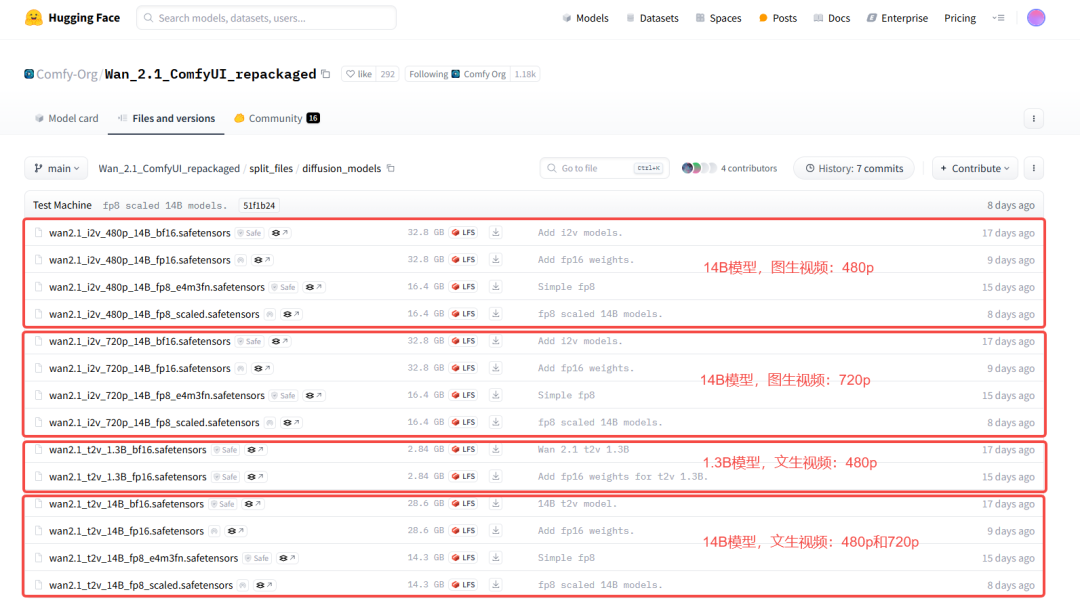

diffusion_models下载

https://huggingface.co/Comfy-Org/Wan_2.1_ComfyUI_repackaged/tree/main/split_files/diffusion_models

Wan2.1模型支持文生视频和图生视频两种方式,每种方式下又有14B和1.3B两种尺寸的模型,其中:

- 文生视频

- wan2.1_t2v_1.3B的模型,最大只支持生成832×480像素视频

- wan2.1_t2v_14B的模型,支持1280×720像素和832×480像素视频

- 图生视频

- wan2.1_i2v_480p_14B的模型,最大支持生成832×480像素视频

- wan2.1_i2v_720p_14B的模型,最大支持生成1280×720像素视频

同时,每个尺寸的模型下也有多个模型,根据生成质量的优劣,按照如下原则选择(质量等级从高到低):

fp16 > bf16 > fp8_scaled > fp8_e4m3fn

结合自己的显存大小,我选择这两个模型下载到本地:

文生视频:wan2.1_t2v_1.3B_fp16.safetensors

图生视频:wan2.1_i2v_480p_14B_fp8_scaled.safetensors

然后移到ComfyUI-aki-V202504版\ComfyUI\models\diffusion_models目录下面。

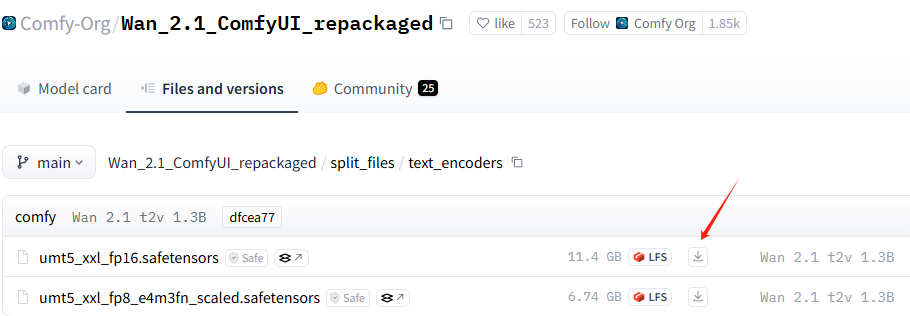

text_encoders下载

打开下面这个页面,下载text_encoders:

https://huggingface.co/Comfy-Org/Wan_2.1_ComfyUI_repackaged/tree/main/split_files/text_encoders

- 如果显存 >= 12G,选择第一个text_encoder

下载 - 如果显存 < 12G,选择第二个text_encoder

下载

选择第一个下载

下载到本地后,移到下载到本地后,移到ComfyUI整合包的ComfyUI\models\text_encoders目录下。

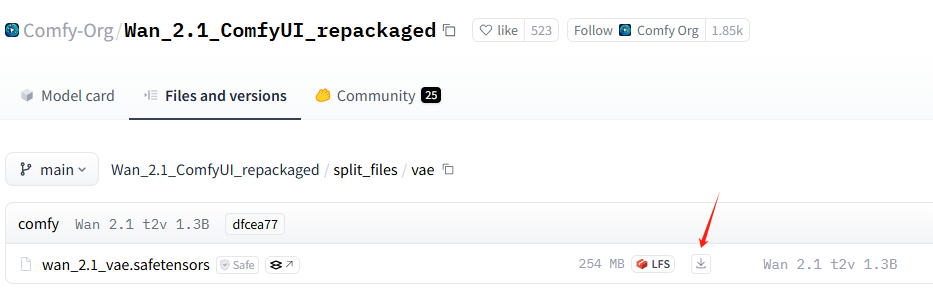

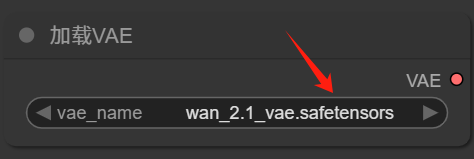

vae下载

打开下面这个页面,下载vae:

https://huggingface.co/Comfy-Org/Wan_2.1_ComfyUI_repackaged/tree/main/split_files/vae

下载到本地后,移到下载到本地后,移到ComfyUI整合包的ComfyUI\models\vae目录下。

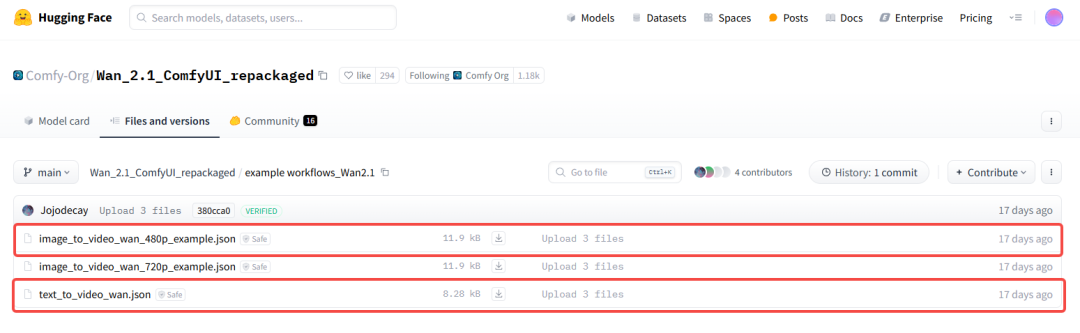

四、工作流下载

打开下面这个页面,下载工作流:

https://huggingface.co/Comfy-Org/Wan_2.1_ComfyUI_repackaged/tree/main/example%20workflows_Wan2.1

我们根据第三步下载的diffusion_model,相对应地选择第一个和第三个工作流下载:

下载到本地后,移到下载到本地后,移到ComfyUI整合包的ComfyUI\user\default\workflows目录下。

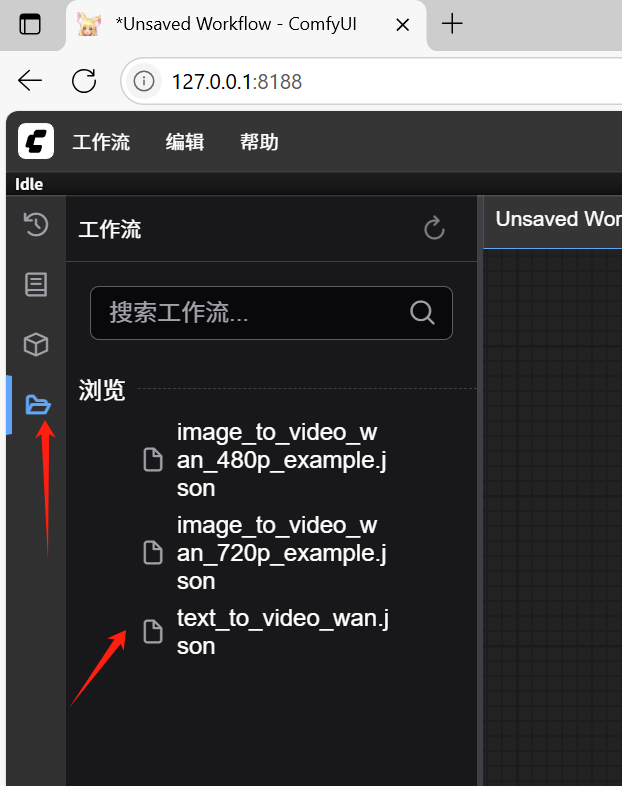

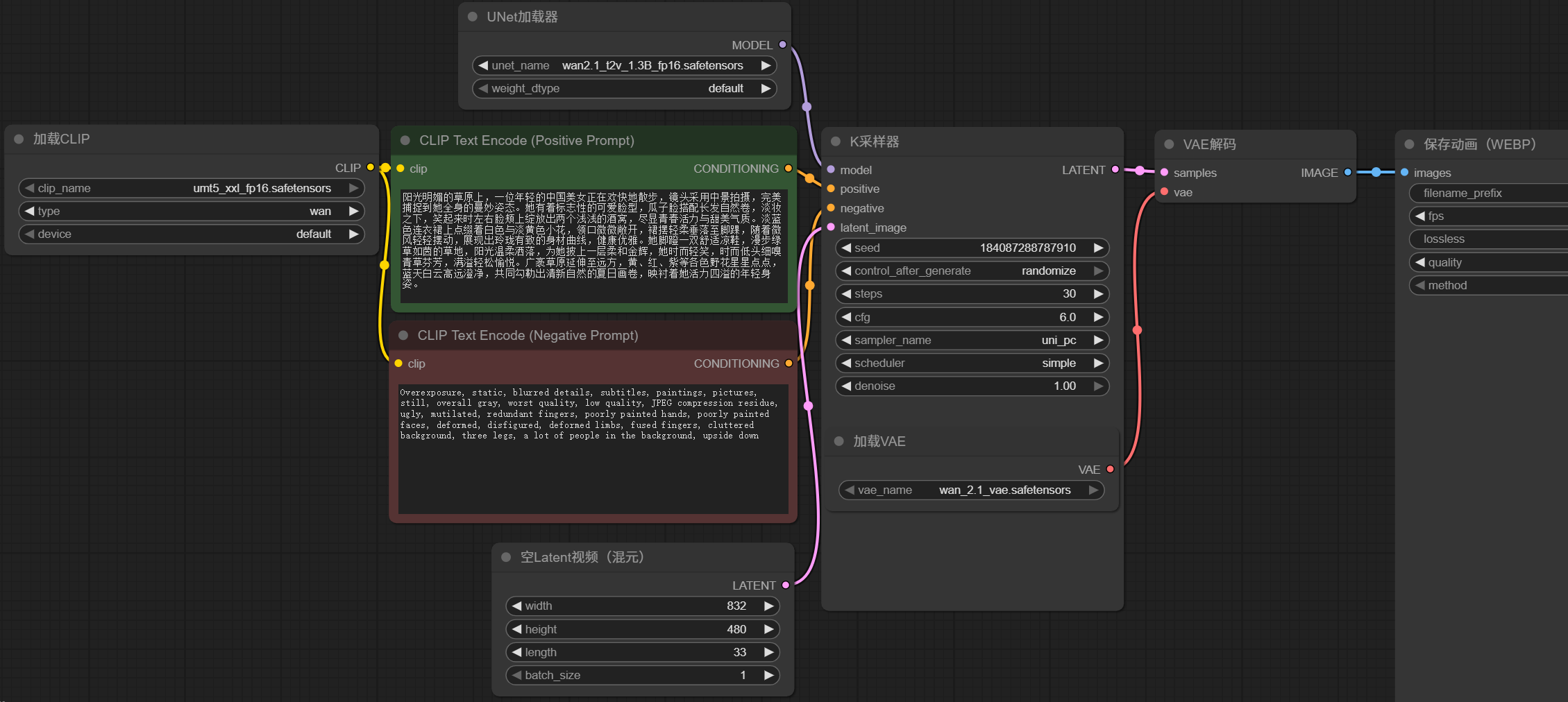

五、文生视频

第一步,打开秋叶启动器,确保是最新版本,点击左上角,一键启动。

启动完成后,会自动打开网页: http://127.0.0.1:8188/

第二步,点击左边侧栏,打开文生视频工作流。

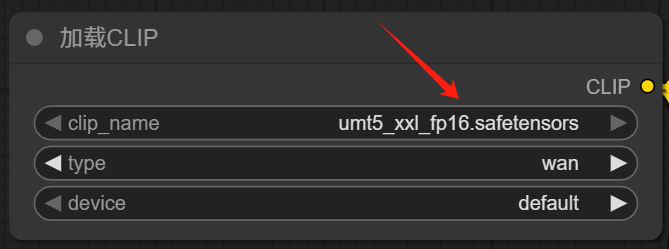

第三步,调整diffusion_model、text_encoder和vae的配置,选择之前下载好的模型。

注意必须要手动选择umt5 xxl fp16.safetensors

注意必须要手动选择,这里选择wan2.1 t2v 1.3B fp16.safetensors

注意必须要手动选择wan 2.1 vae.safetensors

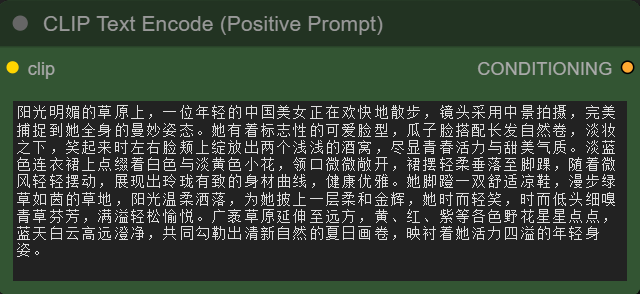

第四步,在CLIP文本编码器框输入正向提示词

这里的提示词如下:

阳光明媚的草原上,一位年轻的中国美女正在欢快地散步,镜头采用中景拍摄,完美捕捉到她全身的曼妙姿态。她有着标志性的可爱脸型,瓜子脸搭配长发自然卷,淡妆之下,笑起来时左右脸颊上绽放出两个浅浅的酒窝,尽显青春活力与甜美气质。淡蓝色连衣裙上点缀着白色与淡黄色小花,领口微微敞开,裙摆轻柔垂落至脚踝,随着微风轻轻摆动,展现出玲珑有致的身材曲线,健康优雅。她脚蹬一双舒适凉鞋,漫步绿草如茵的草地,阳光温柔洒落,为她披上一层柔和金辉,她时而轻笑,时而低头细嗅青草芬芳,满溢轻松愉悦。广袤草原延伸至远方,黄、红、紫等各色野花星星点点,蓝天白云高远澄净,共同勾勒出清新自然的夏日画卷,映衬着她活力四溢的年轻身姿。完整流程如下:

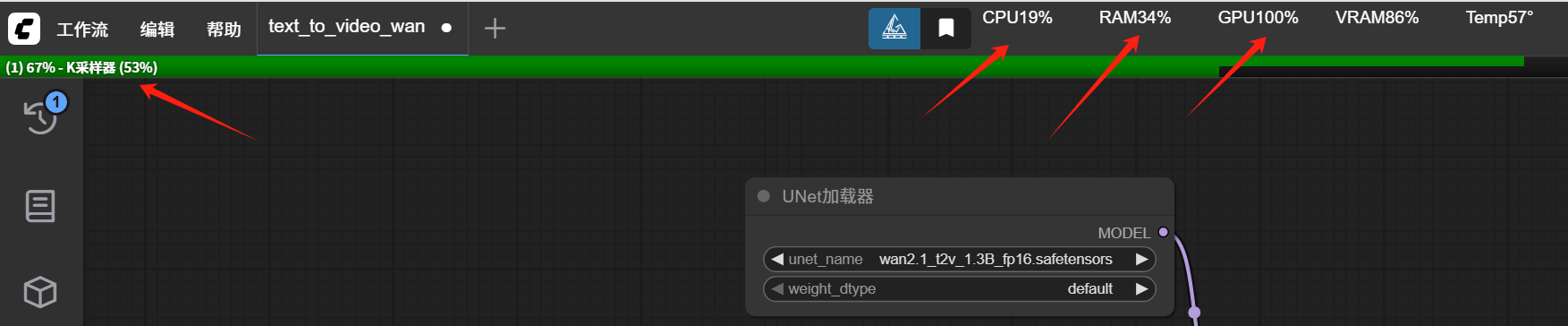

最后点执行按钮,开始生成视频。

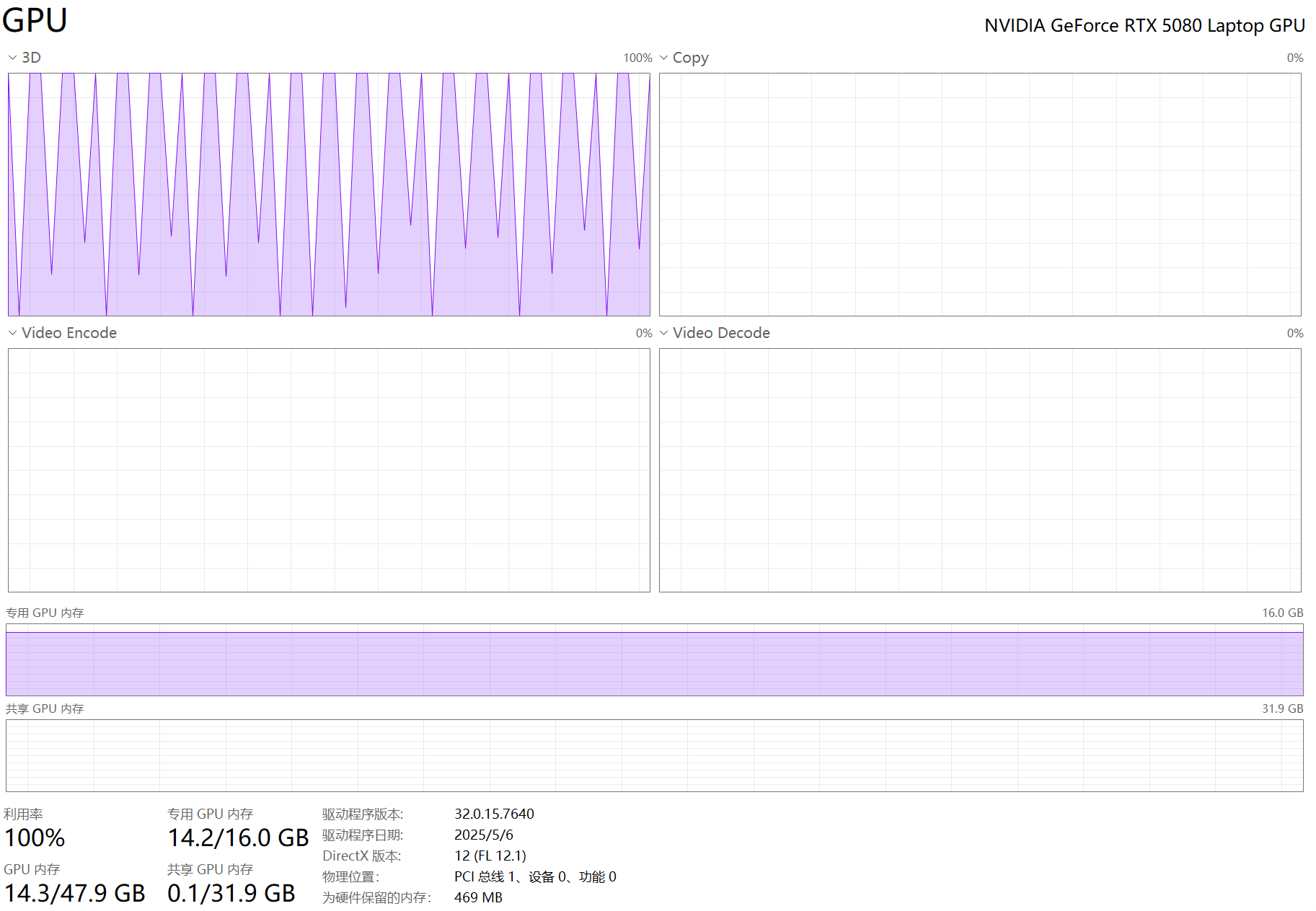

注意看,左上角会显示进度,中间顶部会显示CPU,内存,GPU的使用率

生成过程中,GPU使用率会很高

不过不用担心,大概2分钟左右,就可以完成了。

生成完成后,左下角,会播放效果

生成的图片,会保存在目录ComfyUI-aki-V202504版\ComfyUI\output

会出现一个ComfyUI_00001_.webp文件,打开文件,效果如下:

这是1.3b的效果,花草有点模糊,人物还是比较清晰的。

本文参考链接:

https://zhuanlan.zhihu.com/p/30647063188

https://blog.csdn.net/weixin_59486588/article/details/147836457