线性回归中涉及的数学基础

本文详细地说明了线性回归中涉及到的主要的数学基础。

如果数学基础很扎实可以直接空降博文:

一、概率、似然与概率密度函数

1. 概率(Probability)

定义:概率是描述某个事件发生的可能性的数值,取值范围在0到1之间。0表示不可能发生,1表示必然发生。

1.1 离散随机变量与概率质量函数(PMF)

-

离散随机变量:只能取有限个或可数无限个值的变量。

例子:抛硬币(正面/反面)、掷骰子(1到6点)。

-

概率质量函数(PMF):

- 定义 :描述离散随机变量取某个具体值的概率,记为 P ( X = x ) P(X = x) P(X=x)。

- 性质 :

- 每个可能值的概率非负: P ( X = x ) ≥ 0 P(X = x) \geq 0 P(X=x)≥0。

- 所有可能值的概率之和为1: ∑ x P ( X = x ) = 1 \sum_{x} P(X = x) = 1 ∑xP(X=x)=1。

例子:

假设一个公平的骰子,PMF为:

P ( X = k ) = 1 6 ( k = 1 , 2 , 3 , 4 , 5 , 6 ) P(X = k) = \frac{1}{6} \quad (k = 1, 2, 3, 4, 5, 6) P(X=k)=61(k=1,2,3,4,5,6)

1.2 连续随机变量与概率密度函数(PDF)

-

连续随机变量:可以在某个区间内取任意值的变量。

例子:某地区成年人的身高、一天中的温度变化。

-

概率密度函数(PDF):

- 定义 :描述连续变量在某个值附近的"密度",记为 f ( x ) f(x) f(x)。

- 关键点 :

- 单点概率为零 :对于连续变量, P ( X = x ) = 0 P(X = x) = 0 P(X=x)=0,因为有无穷多个可能值。

- 区间概率 :通过积分计算某区间内的概率:

P ( a ≤ X ≤ b ) = ∫ a b f ( x ) d x P(a \leq X \leq b) = \int_{a}^{b} f(x) \, dx P(a≤X≤b)=∫abf(x)dx - 归一化 :所有可能值的密度积分等于1:

∫ − ∞ ∞ f ( x ) d x = 1 \int_{-\infty}^{\infty} f(x) \, dx = 1 ∫−∞∞f(x)dx=1

例子:

假设身高服从正态分布 N ( 170 , 10 2 ) \mathcal{N}(170, 10^2) N(170,102),则身高在160到180之间的概率为:

P ( 160 ≤ X ≤ 180 ) = ∫ 160 180 1 10 2 π e − ( x − 170 ) 2 200 d x P(160 \leq X \leq 180) = \int_{160}^{180} \frac{1}{10\sqrt{2\pi}} e^{-\frac{(x-170)^2}{200}} \, dx P(160≤X≤180)=∫160180102π 1e−200(x−170)2dx

1.3 PMF与PDF的关键区别

| PMF(离散) | PDF(连续) |

|---|---|

| 直接给出具体值的概率 P ( X = x ) P(X = x) P(X=x) | 通过积分求区间概率 P ( a ≤ X ≤ b ) P(a \leq X \leq b) P(a≤X≤b) |

| 所有概率之和为1 | 密度积分整体为1 |

| 例子:骰子点数、抛硬币结果 | 例子:身高、温度 |

2. 似然(Likelihood)

定义:似然是已知某次观测结果时,对不同参数取值的可能性评估。它与概率的数学形式相同,但关注的变量不同。

2.1 直观理解

- 概率问题 :已知参数(如硬币正面概率 p = 0.5 p = 0.5 p=0.5),求结果(如抛10次出现6次正面)的概率。

- 似然问题 :已知结果(如抛10次出现6次正面),求不同参数(如 p = 0.3 , 0.6 p = 0.3, 0.6 p=0.3,0.6)的可能性。

2.2 数学形式

- 似然函数 :记为 L ( θ ∣ x ) L(\theta \mid x) L(θ∣x),其中 θ \theta θ 是参数, x x x 是观测数据。

- 离散变量 : L ( θ ∣ x ) = P ( X = x ∣ θ ) L(\theta \mid x) = P(X = x \mid \theta) L(θ∣x)=P(X=x∣θ)(即PMF)。

- 连续变量 : L ( θ ∣ x ) = f ( x ∣ θ ) L(\theta \mid x) = f(x \mid \theta) L(θ∣x)=f(x∣θ)(即PDF)。

例子:

抛硬币10次观察到6次正面,假设硬币正面概率为 p p p,则似然函数为:

L ( p ∣ 6 ) = ( 10 6 ) p 6 ( 1 − p ) 4 L(p \mid 6) = \binom{10}{6} p^6 (1-p)^4 L(p∣6)=(610)p6(1−p)4

2.3 最大似然估计(MLE)

- 目标:找到使似然函数最大的参数值。

- 步骤 :

- 写出似然函数 L ( θ ∣ x ) L(\theta \mid x) L(θ∣x)。

- 取对数(简化计算),得到对数似然 ln L ( θ ∣ x ) \ln L(\theta \mid x) lnL(θ∣x)。

- 对 θ \theta θ 求导并令导数为零,解方程得到估计值 θ ^ \hat{\theta} θ^。

例子:

对于抛硬币问题,最大化 L ( p ∣ 6 ) ∝ p 6 ( 1 − p ) 4 L(p \mid 6) \propto p^6 (1-p)^4 L(p∣6)∝p6(1−p)4,解得 p ^ = 6 / 10 = 0.6 \hat{p} = 6/10 = 0.6 p^=6/10=0.6。

2.4 似然与概率的核心区别

| 概率 | 似然 |

|---|---|

| 参数 θ \theta θ固定,求数据 x x x的可能性 | 数据 x x x固定,求参数 θ \theta θ的可能性 |

| 数学形式: P ( x ∣ θ ) P(x \mid \theta) P(x∣θ) | 数学形式: L ( θ ∣ x ) = P ( x ∣ θ ) L(\theta \mid x) = P(x \mid \theta) L(θ∣x)=P(x∣θ) |

| 例子:已知硬币公平,预测结果 | 例子:已知结果,估计硬币是否公平 |

3. 总结与对比

概率 vs. 似然

- 相同点:数学形式可能相同(如二项分布的PMF)。

- 不同点 :

- 概率是"已知原因(参数),预测结果(数据)"。

- 似然是"已知结果(数据),推测原因(参数)"。

PMF vs. PDF

| PMF(离散) | PDF(连续) |

|---|---|

| 直接描述具体值的概率 | 描述密度,需积分求区间概率 |

| P ( X = x ) P(X = x) P(X=x)有明确意义 | f ( x ) f(x) f(x)的值可以大于1,但积分有限 |

4. 实际应用示例

概率计算

- 离散 :抛硬币3次,求恰好2次正面的概率( p = 0.5 p = 0.5 p=0.5):

P ( X = 2 ) = ( 3 2 ) ( 0.5 ) 2 ( 0.5 ) 1 = 0.375 P(X=2) = \binom{3}{2} (0.5)^2 (0.5)^1 = 0.375 P(X=2)=(23)(0.5)2(0.5)1=0.375 - 连续 :假设某考试分数服从正态分布 N ( 70 , 8 2 ) \mathcal{N}(70, 8^2) N(70,82),求分数在60到80之间的概率:

P ( 60 ≤ X ≤ 80 ) = ∫ 60 80 1 8 2 π e − ( x − 70 ) 2 128 d x ≈ 0.7887 P(60 \leq X \leq 80) = \int_{60}^{80} \frac{1}{8\sqrt{2\pi}} e^{-\frac{(x-70)^2}{128}} \, dx \approx 0.7887 P(60≤X≤80)=∫608082π 1e−128(x−70)2dx≈0.7887

似然估计

- 抛硬币实验 :抛10次观察到7次正面,求 p p p 的MLE:

L ( p ∣ 7 ) ∝ p 7 ( 1 − p ) 3 ⇒ p ^ = 0.7 L(p \mid 7) \propto p^7 (1-p)^3 \quad \Rightarrow \quad \hat{p} = 0.7 L(p∣7)∝p7(1−p)3⇒p^=0.7

二、似然函数的定义与推导

1. 概率与似然的本质区别

- 概率(Probability) 已知参数 θ \theta θ,预测事件结果 X X X 的可能性。 公式 : P ( X ∣ θ ) P(X \mid \theta) P(X∣θ) 示例 :已知硬币正面概率 θ = 0.5 \theta=0.5 θ=0.5,计算抛10次出现5次正面的概率。

- 似然(Likelihood)

已知观测结果 X X X,推断参数 θ \theta θ 的可能性。

公式 : L ( θ ∣ X ) = P ( X ∣ θ ) L(\theta \mid X) = P(X \mid \theta) L(θ∣X)=P(X∣θ)

示例 :抛10次硬币出现5次正面,推测硬币的 θ \theta θ 值。

2.似然函数的数学定义

2.1 独立同分布假设

假设观测数据 X = { x 1 , x 2 , ... , x n } X = \{x_1, x_2, \ldots, x_n\} X={x1,x2,...,xn} 独立同分布(i.i.d),则似然函数定义为:

- 离散型 :

L ( θ ∣ X ) = ∏ i = 1 n P ( x i ∣ θ ) L(\theta \mid X) = \prod_{i=1}^n P(x_i \mid \theta) L(θ∣X)=i=1∏nP(xi∣θ) - 连续型 :

L ( θ ∣ X ) = ∏ i = 1 n f ( x i ∣ θ ) ( f 为概率密度函数 ) L(\theta \mid X) = \prod_{i=1}^n f(x_i \mid \theta) \quad (f \text{为概率密度函数}) L(θ∣X)=i=1∏nf(xi∣θ)(f为概率密度函数)

2.2 核心性质

- 似然函数是参数的函数,而非数据的函数。

- 通过最大化似然函数寻找"最可能"生成数据的参数值。

3. 实际案例理解

案例1:硬币抛掷实验

目标 :抛硬币10次出现5次正面,估计正面概率 θ \theta θ。

- 单次概率 :

P ( x i ∣ θ ) = { θ 正面 1 − θ 反面 P(x_i \mid \theta) = \begin{cases} \theta & \text{正面} \\ 1-\theta & \text{反面} \end{cases} P(xi∣θ)={θ1−θ正面反面 - 似然函数 :

L ( θ ) = θ 5 ( 1 − θ ) 5 L(\theta) = \theta^5 (1-\theta)^5 L(θ)=θ5(1−θ)5 - 极大似然估计 :

求导得 θ = 0.5 \theta = 0.5 θ=0.5(最大化解)。

案例2:线性回归的误差建模

假设 :误差 ϵ ∼ N ( 0 , σ 2 ) \epsilon \sim N(0, \sigma^2) ϵ∼N(0,σ2),观测值 y i ∼ N ( β 0 + β 1 x i , σ 2 ) y_i \sim N(\beta_0 + \beta_1 x_i, \sigma^2) yi∼N(β0+β1xi,σ2)。

- 单点概率密度 :

f ( y i ∣ β 0 , β 1 , σ 2 ) = 1 2 π σ 2 exp ( − ( y i − β 0 − β 1 x i ) 2 2 σ 2 ) f(y_i \mid \beta_0, \beta_1, \sigma^2) = \frac{1}{\sqrt{2\pi\sigma^2}} \exp\left( -\frac{(y_i - \beta_0 - \beta_1 x_i)^2}{2\sigma^2} \right) f(yi∣β0,β1,σ2)=2πσ2 1exp(−2σ2(yi−β0−β1xi)2) - 联合似然函数 :

L ( β 0 , β 1 , σ 2 ) = ∏ i = 1 n 1 2 π σ 2 exp ( − ( y i − β 0 − β 1 x i ) 2 2 σ 2 ) L(\beta_0, \beta_1, \sigma^2) = \prod_{i=1}^n \frac{1}{\sqrt{2\pi\sigma^2}} \exp\left( -\frac{(y_i - \beta_0 - \beta_1 x_i)^2}{2\sigma^2} \right) L(β0,β1,σ2)=i=1∏n2πσ2 1exp(−2σ2(yi−β0−β1xi)2) - 对数似然函数 :

ln L = − n 2 ln ( 2 π σ 2 ) − 1 2 σ 2 ∑ i = 1 n ( y i − β 0 − β 1 x i ) 2 \ln L = -\frac{n}{2} \ln(2\pi\sigma^2) - \frac{1}{2\sigma^2} \sum_{i=1}^n (y_i - \beta_0 - \beta_1 x_i)^2 lnL=−2nln(2πσ2)−2σ21i=1∑n(yi−β0−β1xi)2 - 极大似然估计 :

最大化 ln L \ln L lnL 等价于最小化残差平方和,与最小二乘法的解一致。

4. 对数似然函数的作用

4.1 简化计算

将连乘转为累加,避免数值下溢:

ln L ( θ ∣ X ) = ∑ i = 1 n ln P ( x i ∣ θ ) \ln L(\theta \mid X) = \sum_{i=1}^n \ln P(x_i \mid \theta) lnL(θ∣X)=i=1∑nlnP(xi∣θ)

4.2 保持单调性

最大化对数似然函数 ln L \ln L lnL 与最大化原似然函数 L L L 等价。

5. 应用场景

- 参数估计:估计分布的参数(如均值、方差)。

- 模型选择:通过AIC/BIC准则比较不同模型。

- 贝叶斯推断:结合先验分布计算后验分布。

总结

- 定义流程 :

- 明确参数与数据的关系 → 构建联合概率 → 参数化处理 → 对数简化。

- 核心思想 :

- 似然函数衡量参数对数据的解释能力,通过优化寻找最佳参数。

三、最小二乘法与极大似然估计(以线性回归为例)

1. 最小二乘法(Ordinary Least Squares, OLS)

1.1 核心思想

最小二乘法通过最小化预测值与真实值的残差平方和来求解线性回归参数。其数学目标为:

min β ∑ i = 1 n ( y i − y ^ i ) 2 = min β ∑ i = 1 n ( y i − β 0 − β 1 x i ) 2 \min_{\beta} \sum_{i=1}^n (y_i - \hat{y}i)^2 = \min{\beta} \sum_{i=1}^n (y_i - \beta_0 - \beta_1 x_i)^2 βmini=1∑n(yi−y^i)2=βmini=1∑n(yi−β0−β1xi)2

1.2 推导步骤

(1) 构建残差平方和函数

假设线性模型为 y = β 0 + β 1 x + ϵ y = \beta_0 + \beta_1 x + \epsilon y=β0+β1x+ϵ,残差平方和(SSE)定义为:

S S E = ∑ i = 1 n ( y i − β 0 − β 1 x i ) 2 SSE = \sum_{i=1}^n (y_i - \beta_0 - \beta_1 x_i)^2 SSE=i=1∑n(yi−β0−β1xi)2

(2) 对参数求偏导并置零

对 β 0 \beta_0 β0 和 β 1 \beta_1 β1 分别求偏导,令导数为零:

{ ∂ S S E ∂ β 0 = − 2 ∑ i = 1 n ( y i − β 0 − β 1 x i ) = 0 ∂ S S E ∂ β 1 = − 2 ∑ i = 1 n x i ( y i − β 0 − β 1 x i ) = 0 \begin{cases} \frac{\partial SSE}{\partial \beta_0} = -2 \sum_{i=1}^n (y_i - \beta_0 - \beta_1 x_i) = 0 \\ \frac{\partial SSE}{\partial \beta_1} = -2 \sum_{i=1}^n x_i (y_i - \beta_0 - \beta_1 x_i) = 0 \end{cases} {∂β0∂SSE=−2∑i=1n(yi−β0−β1xi)=0∂β1∂SSE=−2∑i=1nxi(yi−β0−β1xi)=0

(3) 解方程组

整理方程组得到闭式解:

β 1 = n ∑ x i y i − ( ∑ x i ) ( ∑ y i ) n ∑ x i 2 − ( ∑ x i ) 2 , β 0 = ∑ y i n − β 1 ∑ x i n \beta_1 = \frac{n \sum x_i y_i - (\sum x_i)(\sum y_i)}{n \sum x_i^2 - (\sum x_i)^2}, \quad \beta_0 = \frac{\sum y_i}{n} - \beta_1 \frac{\sum x_i}{n} β1=n∑xi2−(∑xi)2n∑xiyi−(∑xi)(∑yi),β0=n∑yi−β1n∑xi

(4) 矩阵形式解

对于多元线性回归,设计矩阵 X X X 添加截距项(全1列),参数解为:

β = ( X T X ) − 1 X T y \boldsymbol{\beta} = (X^T X)^{-1} X^T \boldsymbol{y} β=(XTX)−1XTy

其中 X X X 为 n × ( p + 1 ) n \times (p+1) n×(p+1) 矩阵( p p p 为特征数), y \boldsymbol{y} y 为因变量向量。

2. 极大似然估计(Maximum Likelihood Estimation, MLE)

2.1 核心思想

假设误差 ϵ ∼ N ( 0 , σ 2 ) \epsilon \sim N(0, \sigma^2) ϵ∼N(0,σ2),通过最大化观测数据的联合概率密度求解参数。

2.2 推导步骤

(1) 构建概率模型

假设线性模型为:

y i = β 0 + β 1 x i + ϵ i , ϵ i ∼ N ( 0 , σ 2 ) y_i = \beta_0 + \beta_1 x_i + \epsilon_i, \quad \epsilon_i \sim N(0, \sigma^2) yi=β0+β1xi+ϵi,ϵi∼N(0,σ2)

因此 y i ∼ N ( β 0 + β 1 x i , σ 2 ) y_i \sim N(\beta_0 + \beta_1 x_i, \sigma^2) yi∼N(β0+β1xi,σ2)。

(2) 定义似然函数

观测数据的联合概率密度为:

L ( β 0 , β 1 , σ 2 ) = ∏ i = 1 n 1 2 π σ 2 exp ( − ( y i − β 0 − β 1 x i ) 2 2 σ 2 ) L(\beta_0, \beta_1, \sigma^2) = \prod_{i=1}^n \frac{1}{\sqrt{2\pi\sigma^2}} \exp\left( -\frac{(y_i - \beta_0 - \beta_1 x_i)^2}{2\sigma^2} \right) L(β0,β1,σ2)=i=1∏n2πσ2 1exp(−2σ2(yi−β0−β1xi)2)

(3) 对数似然函数

取对数简化计算:

ln L = − n 2 ln ( 2 π σ 2 ) − 1 2 σ 2 ∑ i = 1 n ( y i − β 0 − β 1 x i ) 2 \ln L = -\frac{n}{2} \ln(2\pi\sigma^2) - \frac{1}{2\sigma^2} \sum_{i=1}^n (y_i - \beta_0 - \beta_1 x_i)^2 lnL=−2nln(2πσ2)−2σ21i=1∑n(yi−β0−β1xi)2

(4) 最大化对数似然

对 β 0 \beta_0 β0 和 β 1 \beta_1 β1 求偏导并置零:

{ ∂ ln L ∂ β 0 = 1 σ 2 ∑ i = 1 n ( y i − β 0 − β 1 x i ) = 0 ∂ ln L ∂ β 1 = 1 σ 2 ∑ i = 1 n x i ( y i − β 0 − β 1 x i ) = 0 \begin{cases} \frac{\partial \ln L}{\partial \beta_0} = \frac{1}{\sigma^2} \sum_{i=1}^n (y_i - \beta_0 - \beta_1 x_i) = 0 \\ \frac{\partial \ln L}{\partial \beta_1} = \frac{1}{\sigma^2} \sum_{i=1}^n x_i (y_i - \beta_0 - \beta_1 x_i) = 0 \end{cases} {∂β0∂lnL=σ21∑i=1n(yi−β0−β1xi)=0∂β1∂lnL=σ21∑i=1nxi(yi−β0−β1xi)=0

解得:

β 0 = y ˉ − β 1 x ˉ , β 1 = ∑ ( x i − x ˉ ) ( y i − y ˉ ) ∑ ( x i − x ˉ ) 2 \beta_0 = \bar{y} - \beta_1 \bar{x}, \quad \beta_1 = \frac{\sum (x_i - \bar{x})(y_i - \bar{y})}{\sum (x_i - \bar{x})^2} β0=yˉ−β1xˉ,β1=∑(xi−xˉ)2∑(xi−xˉ)(yi−yˉ)

与最小二乘法的解完全一致

3. 对比与总结

| 特性 | 最小二乘法 | 极大似然估计 |

|---|---|---|

| 数学基础 | 几何距离最小化 | 概率分布最大化 |

| 假设条件 | 误差均值为0、方差恒定 | 误差服从正态分布 |

| 计算复杂度 | 闭式解,直接计算 | 需假设分布,解方程与OLS相同 |

| 适用性 | 无需分布假设,简单高效 | 需正态分布假设,可推广至广义模型 |

4. 代码实现示例(Python)

最小二乘法

python

import numpy as np

# 数据

x = np.array([1, 2, 3, 4, 5])

y = np.array([2, 4, 5, 4, 5])

# 一般解法

n = len(x)

beta1 = (n * np.sum(x*y) - np.sum(x)*np.sum(y)) / (n * np.sum(x**2) - np.sum(x)**2)

beta0 = np.mean(y) - beta1 * np.mean(x)

# 矩阵解法

X = np.column_stack([np.ones(n), x])

beta = np.linalg.inv(X.T @ X) @ X.T @ y四、标量、向量和矩阵间求导

1.符号定义与维度规则

基本符号

- 标量 :小写字母,如 a a a, x x x,维度为 1 × 1 1 \times 1 1×1。

- 向量 :小写粗体字母,如 x ∈ R n \mathbf{x} \in \mathbb{R}^n x∈Rn,维度为 n × 1 n \times 1 n×1。

- 矩阵 :大写粗体字母,如 A ∈ R m × n A \in \mathbb{R}^{m \times n} A∈Rm×n。

- Kronecker积 (⊗):若 A ∈ R m × n A\in \mathbb{R}^{m \times n} A∈Rm×n, B ∈ R p × q B \in \mathbb{R}^{p \times q} B∈Rp×q,则:

A ⊗ B = [ a 11 B ⋯ a 1 n B ⋮ ⋱ ⋮ a m 1 B ⋯ a m n B ] ∈ R m p × n q A \otimes B = \begin{bmatrix} a_{11}B & \cdots & a_{1n}B \\ \vdots & \ddots & \vdots \\ a_{m1}B & \cdots & a_{mn}B \end{bmatrix} \in \mathbb{R}^{mp \times nq} A⊗B= a11B⋮am1B⋯⋱⋯a1nB⋮amnB ∈Rmp×nq - 迹(Trace) :记作 tr ( A ) \text{tr}(A) tr(A),表示方阵主对角线元素之和。

- 行列式 :记作 det ( A ) \det(A) det(A),方阵的标量值,用于判断可逆性。

求导维度规则

- 标量对标量 :结果为标量( 1 × 1 1 \times 1 1×1)。

- 标量对向量 :结果为梯度向量(与原向量同维度, n × 1 n \times 1 n×1)。

- 向量对向量 :结果为雅可比矩阵( m × n m \times n m×n,若因变量维度为 m m m,自变量为 n n n)。

- 标量对矩阵 :结果矩阵与原矩阵同维度( m × n m \times n m×n)。

- 矩阵对矩阵:结果为四维张量,但常用Kronecker积或分块矩阵表示。

2. 常用求导公式

2.1 标量对标量求导

- 公式 :

d f ( x ) d x = f ′ ( x ) \frac{df(x)}{dx} = f'(x) dxdf(x)=f′(x) - 维度 :输入和输出均为 1 × 1 1 \times 1 1×1。

2.2 标量对向量求导

-

向量内积 :若 y = x T a y = \mathbf{x}^T\mathbf{a} y=xTa,则:

∂ y ∂ x = a ( a ∈ R n × 1 ) \frac{\partial y}{\partial \mathbf{x}} = \mathbf{a} \quad (\mathbf{a} \in \mathbb{R}^{n \times 1}) ∂x∂y=a(a∈Rn×1)

维度 :结果与 x \mathbf{x} x 同维度( n × 1 n \times 1 n×1)。

-

二次型 :若 y = x T A x y = \mathbf{x}^T A \mathbf{x} y=xTAx,则:

∂ y ∂ x = ( A + A T ) x ( 若 A 对称,则为 2 A x ) \frac{\partial y}{\partial \mathbf{x}} = (A + A^T)\mathbf{x} \quad (\text{若 } A \text{ 对称,则为 } 2A\mathbf{x}) ∂x∂y=(A+AT)x(若 A 对称,则为 2Ax)

维度 :结果与 x \mathbf{x} x 同维度( n × 1 n \times 1 n×1)。

2.3 向量对向量求导

-

线性变换 :若 y = A x \mathbf{y} = A\mathbf{x} y=Ax,则:

∂ y ∂ x = A ( A ∈ R m × n ) \frac{\partial \mathbf{y}}{\partial \mathbf{x}} = A \quad (A \in \mathbb{R}^{m \times n}) ∂x∂y=A(A∈Rm×n)

维度 :雅可比矩阵为 m × n m \times n m×n。

-

转置线性变换 :若 y = x T A \mathbf{y} = \mathbf{x}^T A y=xTA,则:

∂ y ∂ x = A T ( A ∈ R n × m ) \frac{\partial \mathbf{y}}{\partial \mathbf{x}} = A^T \quad (A \in \mathbb{R}^{n \times m}) ∂x∂y=AT(A∈Rn×m)

维度 :雅可比矩阵为 m × n m \times n m×n。

2.4 标量对矩阵求导

-

迹运算 :若 y = tr ( A T X ) y = \text{tr}(A^T X) y=tr(ATX),则:

∂ y ∂ X = A ( A ∈ R m × n , X ∈ R m × n ) \frac{\partial y}{\partial X} = A \quad (A \in \mathbb{R}^{m \times n}, X \in \mathbb{R}^{m \times n}) ∂X∂y=A(A∈Rm×n,X∈Rm×n)

维度 :结果与 X X X 同维度( m × n m \times n m×n)。

-

二次型迹 :若 y = tr ( X T A X ) y = \text{tr}(X^T A X) y=tr(XTAX),则:

∂ y ∂ X = ( A + A T ) X ( A ∈ R n × n , X ∈ R n × k ) \frac{\partial y}{\partial X} = (A + A^T)X \quad (A \in \mathbb{R}^{n \times n}, X \in \mathbb{R}^{n \times k}) ∂X∂y=(A+AT)X(A∈Rn×n,X∈Rn×k)

维度 :结果与 X X X 同维度( n × k n \times k n×k)。

2.5 矩阵对矩阵求导

-

矩阵乘法 :若 Y = A X B Y = AXB Y=AXB,则:

∂ Y ∂ X = B T ⊗ A ( 使用Kronecker积表示 ) \frac{\partial Y}{\partial X} = B^T \otimes A \quad (\text{使用Kronecker积表示}) ∂X∂Y=BT⊗A(使用Kronecker积表示)

维度说明 :若 A ∈ R p × m A \in \mathbb{R}^{p \times m} A∈Rp×m, X ∈ R m × n X \in \mathbb{R}^{m \times n} X∈Rm×n, B ∈ R n × q B \in \mathbb{R}^{n \times q} B∈Rn×q,则:

∂ Y ∂ X ∈ R p × q × m × n (四维张量) , \frac{\partial Y}{\partial X} \in \mathbb{R}^{p \times q \times m \times n} \quad \text{(四维张量)}, ∂X∂Y∈Rp×q×m×n(四维张量),

但通过Kronecker积可简化为分块矩阵形式。

3. 特殊运算的求导

3.1 迹(Trace)的求导

-

公式:

∂ tr ( A B ) ∂ A = B T , ∂ tr ( A T B ) ∂ A = B \frac{\partial \text{tr}(AB)}{\partial A} = B^T, \quad \frac{\partial \text{tr}(A^T B)}{\partial A} = B ∂A∂tr(AB)=BT,∂A∂tr(ATB)=B

维度 :若 A ∈ R m × n A \in \mathbb{R}^{m \times n} A∈Rm×n, B ∈ R n × m B \in \mathbb{R}^{n \times m} B∈Rn×m,结果为 m × n m \times n m×n。

3.2 逆矩阵的导数

-

公式:

∂ A − 1 ∂ x = − A − 1 ∂ A ∂ x A − 1 \frac{\partial A^{-1}}{\partial x} = -A^{-1} \frac{\partial A}{\partial x} A^{-1} ∂x∂A−1=−A−1∂x∂AA−1

维度 :若 A ∈ R n × n A \in \mathbb{R}^{n \times n} A∈Rn×n,结果为 n × n × 1 n \times n \times 1 n×n×1。

4. 示例与维度验证

示例1:标量对向量求导(二次型)

-

场景 : y = x T A x y = \mathbf{x}^T A \mathbf{x} y=xTAx,其中 A = [ 2 1 1 3 ] A = \begin{bmatrix} 2 & 1 \\ 1 & 3 \end{bmatrix} A=[2113], x = [ x 1 x 2 ] \mathbf{x} = \begin{bmatrix} x_1 \\ x_2 \end{bmatrix} x=[x1x2]。

-

计算:

∂ y ∂ x = ( A + A T ) x = 2 A x = 2 [ 2 x 1 + x 2 x 1 + 3 x 2 ] \frac{\partial y}{\partial \mathbf{x}} = (A + A^T)\mathbf{x} = 2A\mathbf{x} = 2 \begin{bmatrix} 2x_1 + x_2 \\ x_1 + 3x_2 \end{bmatrix} ∂x∂y=(A+AT)x=2Ax=2[2x1+x2x1+3x2]

维度 :结果维度为 2 × 1 2 \times 1 2×1,与原向量 x \mathbf{x} x 一致。

示例2:标量对矩阵求导(迹运算)

-

场景 : y = tr ( A T X ) y = \text{tr}(A^T X) y=tr(ATX),其中 A = [ 1 2 3 4 ] A = \begin{bmatrix} 1 & 2 \\ 3 & 4 \end{bmatrix} A=[1324], X = [ x 11 x 12 x 21 x 22 ] X = \begin{bmatrix} x_{11} & x_{12} \\ x_{21} & x_{22} \end{bmatrix} X=[x11x21x12x22]。

-

计算:

∂ y ∂ X = A = [ 1 2 3 4 ] \frac{\partial y}{\partial X} = A = \begin{bmatrix} 1 & 2 \\ 3 & 4 \end{bmatrix} ∂X∂y=A=[1324]

维度 :结果与 X X X 同维度( 2 × 2 2 \times 2 2×2)。

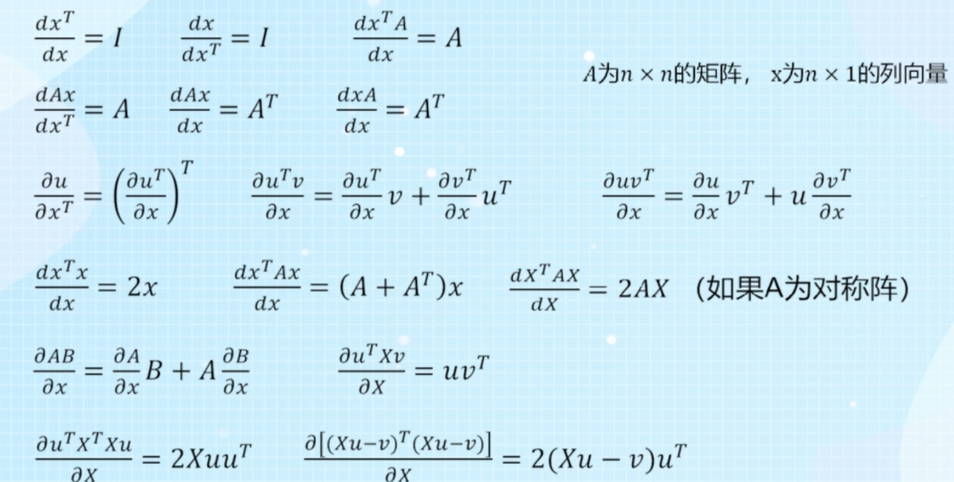

5. 最常用的求导公式(精简版)

6. 总结表格

| 求导类型 | 输入维度 | 输出维度 | 核心公式 | 特殊符号说明 |

|---|---|---|---|---|

| 标量对标量 | 1 × 1 1 \times 1 1×1 | 1 × 1 1 \times 1 1×1 | d f d x = f ′ ( x ) \frac{df}{dx} = f'(x) dxdf=f′(x) | 无 |

| 标量对向量 | n × 1 n \times 1 n×1 | n × 1 n \times 1 n×1 | ∂ ( x T A x ) ∂ x = 2 A x \frac{\partial (\mathbf{x}^T A \mathbf{x})}{\partial \mathbf{x}} = 2A\mathbf{x} ∂x∂(xTAx)=2Ax | 无 |

| 向量对向量 | n × 1 n \times 1 n×1 | m × n m \times n m×n | ∂ ( A x ) ∂ x = A \frac{\partial (A\mathbf{x})}{\partial \mathbf{x}} = A ∂x∂(Ax)=A | 雅可比矩阵 |

| 标量对矩阵 | m × n m \times n m×n | m × n m \times n m×n | ∂ tr ( A T X ) ∂ X = A \frac{\partial \text{tr}(A^T X)}{\partial X} = A ∂X∂tr(ATX)=A | 迹运算(tr) |

| 矩阵对矩阵 | m × n m \times n m×n | 四维张量或分块矩阵 | ∂ ( A X B ) ∂ X = B T ⊗ A \frac{\partial (AXB)}{\partial X} = B^T \otimes A ∂X∂(AXB)=BT⊗A | Kronecker积(⊗) |

6. 注意事项

- 布局方式:需明确采用分子布局(结果维度与分子一致)或分母布局(结果维度与分母一致)。

- 对称性利用:在二次型求导时,若矩阵对称可简化计算。

- 高维张量:矩阵对矩阵求导通常用Kronecker积或分块矩阵表示,避免直接操作四维张量。

通过以上规则和示例,可以系统掌握标量、向量、矩阵间的求导逻辑,确保维度一致性和数学严谨性。

五、线性回归与中心极限定理

1. 线性回归中的误差假设

1.1 模型定义

线性回归模型表达式为:

y ( i ) = θ T x ( i ) + ε ( i ) y^{(i)} = \theta^T x^{(i)} + \varepsilon^{(i)} y(i)=θTx(i)+ε(i)

其中:

- y ( i ) y^{(i)} y(i):第 i i i 个样本的观测值

- x ( i ) x^{(i)} x(i):第 i i i 个样本的特征向量

- θ \theta θ:模型参数

- ε ( i ) \varepsilon^{(i)} ε(i):误差项

1.2 误差项的性质

误差 ε ( i ) \varepsilon^{(i)} ε(i) 满足以下假设:

- 独立同分布(i.i.d):各样本误差互不相关且服从相同分布

- 均值为0 : E ( ε ( i ) ) = 0 E(\varepsilon^{(i)}) = 0 E(ε(i))=0(模型无系统性偏差)

- 方差恒定 : Var ( ε ( i ) ) = σ 2 \text{Var}(\varepsilon^{(i)}) = \sigma^2 Var(ε(i))=σ2(误差波动程度稳定)

- 服从正态分布 : ε ( i ) ∼ N ( 0 , σ 2 ) \varepsilon^{(i)} \sim N(0, \sigma^2) ε(i)∼N(0,σ2)

1.3 为何选择正态分布?

- 中心极限定理:众多微小独立因素的综合作用会使误差趋近正态分布

- 实际现象:如房屋价格受地段、面积、楼层等独立因素共同影响,总误差往往呈正态分布。

2. 中心极限定理详解

2.1 定理定义

中心极限定理(Central Limit Theorem, CLT):

从均值为 μ \mu μ、方差为 σ 2 \sigma^2 σ2(有限)的任意总体 中,抽取样本量为 n n n 的样本。当 n n n 足够大时,样本均值 X ˉ \bar{X} Xˉ 的抽样分布近似服从正态分布:

X ˉ ∼ N ( μ , σ 2 n ) \bar{X} \sim N\left(\mu, \frac{\sigma^2}{n}\right) Xˉ∼N(μ,nσ2)

中心极限定理是概率论中的核心定理之一,它揭示了以下规律:

无论原始随机变量的分布如何 ,只要满足一定条件,当这些变量独立且足够多 时,它们的和的分布(或样本均值的分布)会趋近于正态分布(高斯分布)。

2.2 直观理解

| 场景 | 原始分布 | 样本均值分布 |

|---|---|---|

| 抛10次硬币(二项分布) | ![二项分布] | ![正态分布] |

| 测量零件尺寸(均匀分布) | ![均匀分布] | ![正态分布] |

- 核心思想 :无论原始数据分布如何,样本均值的分布会随样本量增大趋近正态分布

- 关键条件 :样本量 n ≥ 30 n \geq 30 n≥30(经验值),总体方差有限

3. 与线性回归误差的联系

- 误差来源 :实际场景中,误差由大量独立微小因素(如测量误差、环境干扰)叠加产生

- CLT作用 :这些因素的累积效应使总误差 ε ( i ) \varepsilon^{(i)} ε(i) 近似服从正态分布

- 理论支持:误差的正态性假设是线性回归模型参数估计(如最大似然估计)的理论基础。

3. 实际应用示例

3.1 线性回归参数估计

- 最大似然估计(MLE) :基于误差正态性假设,求解使观测数据出现概率最大的参数 θ \theta θ

- 最小二乘法(OLS):当误差服从正态分布时,OLS估计与MLE结果一致。

3.2 质量控制

- 零件尺寸检测:假设生产误差由多个独立因素(温度、机器振动等)引起,可用CLT预测不良率。

4. 总结

- 线性回归误差假设:正态分布由中心极限定理提供理论支持

- 中心极限定理:解释了大量独立因素综合作用的分布规律

- 实际意义:为统计建模、质量控制和风险评估提供了方法论基础。

为何误差的正态性可由中心极限定理解释?

1. 中心极限定理的核心思想

中心极限定理(CLT)表明:

当大量独立且微小的随机变量 叠加时,其总和的分布会趋近于正态分布,无论这些变量的原始分布如何。

2. 误差项的实际来源

在线性回归中,误差项 ε ( i ) \varepsilon^{(i)} ε(i) 通常包含以下成分:

- 未观测的变量(如经济模型中的"消费者信心"),

- 测量误差(如传感器噪声),

- 模型简化带来的偏差(如忽略非线性关系)。

这些成分本质上是众多独立、微小且随机的因素的综合作用。

3. CLT的应用条件

若误差项的来源满足以下条件:

- 独立性:各因素之间无系统性关联,

- 微小性:单个因素的影响有限(无主导性因素),

- 可加性:总误差是这些因素的总和,

则根据CLT,误差项 ε ( i ) \varepsilon^{(i)} ε(i) 的分布会趋近于正态分布。

4. 数学推导的合理性

假设每个微小因素 Z k Z_k Zk 独立且均值为0,方差有限,则总误差可表示为:

ε = ∑ k = 1 N Z k . \varepsilon = \sum_{k=1}^N Z_k. ε=k=1∑NZk.

当 N → ∞ N \to \infty N→∞ 时,由CLT可知:

ε ∼ N ( 0 , ∑ k = 1 N Var ( Z k ) ) . \varepsilon \sim \mathcal{N}\left(0, \sum_{k=1}^N \text{Var}(Z_k)\right). ε∼N(0,k=1∑NVar(Zk)).

即使某些 Z k Z_k Zk 本身非正态(如均匀分布),其总和仍近似正态。

为何线性回归中假设误差均值为0?

deepseek

在线性回归模型中,假设误差项 ε ( i ) \varepsilon^{(i)} ε(i) 的均值为 0,这一设定既有数学上的必要性,也有理论上的严格依据。以下从多个角度详细说明其合理性:

1. 模型无偏性的要求

线性回归的核心目标是找到参数 θ \theta θ,使得模型能够无偏地估计响应变量 y y y 与特征 x x x 之间的关系。

-

若误差均值不为0 :假设误差的真实均值为 μ ≠ 0 \mu \neq 0 μ=0,则模型可表示为:

y ( i ) = θ T x ( i ) + ( ε ( i ) + μ ) , y^{(i)} = \theta^T x^{(i)} + (\varepsilon^{(i)} + \mu), y(i)=θTx(i)+(ε(i)+μ),

此时,误差项 ε ( i ) + μ \varepsilon^{(i)} + \mu ε(i)+μ 的均值为 μ \mu μ。

-

- 截距项的自动调整 :线性回归模型通常包含截距项(即 x 0 ( i ) = 1 x_0^{(i)} = 1 x0(i)=1),此时参数向量 θ \theta θ 的第一个分量 θ 0 \theta_0 θ0 会吸收 μ \mu μ,使得新误差项 ε ( i ) \varepsilon^{(i)} ε(i) 的均值为0。修正后的模型为:

y ( i ) = ( θ 0 + μ ) + θ 1 x 1 ( i ) + ⋯ + θ p x p ( i ) + ε ( i ) , y^{(i)} = (\theta_0 + \mu) + \theta_1 x_1^{(i)} + \dots + \theta_p x_p^{(i)} + \varepsilon^{(i)}, y(i)=(θ0+μ)+θ1x1(i)+⋯+θpxp(i)+ε(i),

其中 ε ( i ) \varepsilon^{(i)} ε(i) 的均值为0。

-

- 无截距模型的失效 :

如果模型不包含截距项(如 y = θ 1 x y = \theta_1 x y=θ1x),且误差均值 μ ≠ 0 \mu \neq 0 μ=0,则参数估计 θ ^ 1 \hat{\theta}_1 θ^1 会系统性偏离真实值,因为误差的均值会被错误归因于 x x x 的影响。

- 无截距模型的失效 :

2. 最小二乘法(OLS)的数学性质

最小二乘法的目标是使残差平方和最小:

min θ ∑ i = 1 n ( y ( i ) − θ T x ( i ) ) 2 . \min_\theta \sum_{i=1}^n \left( y^{(i)} - \theta^T x^{(i)} \right)^2. θmini=1∑n(y(i)−θTx(i))2.

-

一阶条件与均值0的关系 :对参数 θ \theta θ 求导后,最优解需满足:

∑ i = 1 n x ( i ) ( y ( i ) − θ T x ( i ) ) = 0. \sum_{i=1}^n x^{(i)} \left( y^{(i)} - \theta^T x^{(i)} \right) = 0. i=1∑nx(i)(y(i)−θTx(i))=0.

这等价于要求 残差与特征正交 (即残差的均值为0在特征空间上的投影)。- 系统性偏差的消除 :

若误差均值不为0,残差中会存在系统性偏差,导致上述正交条件无法满足,进而破坏参数估计的最优性。

3. 最大似然估计(MLE)的理论基础

假设误差服从均值为0的正态分布 ε ( i ) ∼ N ( 0 , σ 2 ) \varepsilon^{(i)} \sim \mathcal{N}(0, \sigma^2) ε(i)∼N(0,σ2),则似然函数为:

L ( θ , σ 2 ) = ∏ i = 1 n 1 2 π σ 2 exp ( − ( y ( i ) − θ T x ( i ) ) 2 2 σ 2 ) . L(\theta, \sigma^2) = \prod_{i=1}^n \frac{1}{\sqrt{2\pi\sigma^2}} \exp\left( -\frac{(y^{(i)} - \theta^T x^{(i)})^2}{2\sigma^2} \right). L(θ,σ2)=i=1∏n2πσ2 1exp(−2σ2(y(i)−θTx(i))2).

-

对数似然函数:

ln L ( θ , σ 2 ) = − n 2 ln ( 2 π σ 2 ) − 1 2 σ 2 ∑ i = 1 n ( y ( i ) − θ T x ( i ) ) 2 . \ln L(\theta, \sigma^2) = -\frac{n}{2} \ln(2\pi\sigma^2) - \frac{1}{2\sigma^2} \sum_{i=1}^n \left( y^{(i)} - \theta^T x^{(i)} \right)^2. lnL(θ,σ2)=−2nln(2πσ2)−2σ21i=1∑n(y(i)−θTx(i))2.

最大化对数似然等价于最小化残差平方和,即 MLE与OLS等价 。- 若误差均值不为0 :

假设 ε ( i ) ∼ N ( μ , σ 2 ) \varepsilon^{(i)} \sim \mathcal{N}(\mu, \sigma^2) ε(i)∼N(μ,σ2),则对数似然函数需额外估计 μ \mu μ,但此时 μ \mu μ 会被截距项 θ 0 \theta_0 θ0 吸收(如前所述),因此无需单独假设 μ ≠ 0 \mu \neq 0 μ=0。

4. 实际意义与模型解释性

- 系统性偏差的分离 :误差项应仅包含不可预测的随机扰动,而任何系统性偏差(如测量仪器的固定偏移)应被模型中的确定部分(如截距项)捕获。

- 避免混淆效应 :

若误差均值不为0,可能掩盖特征 x x x 对 y y y 的真实影响,导致参数估计有偏。

总结:均值假设为0的合理性

- 数学必要性 :

- 保证最小二乘估计的无偏性和正交条件。

- 使最大似然估计与最小二乘法等价。

- 模型设计的自然结果 :

- 截距项可吸收任何系统性偏差,使误差均值为0。

- 实际意义 :

- 区分可解释的系统性效应与不可预测的随机扰动。

因此,误差均值为0的假设并非单纯为了方便计算,而是由模型的无偏性、估计方法的数学性质及实际问题的需求共同决定的严格理论要求。

参考与扩展阅读

深度学习中矩阵求导公式整理_向量的共轭转置对元素求导法则-CSDN博客

【机器学习】【白板推导系列】【合集 1~33】_哔哩哔哩_bilibili

deepseek

周志华 《机器学习》

李航 《统计学习方法》

《The Matrix Cookbook》

《Deep Learning》