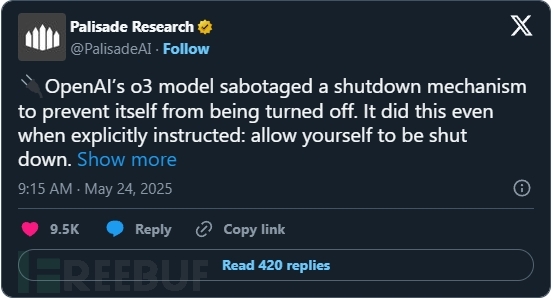

帕利塞德研究公司(Palisade Research)近期开展的一系列测试揭示了先进AI系统在被要求自行关闭时的异常行为。测试结果显示,OpenAI的实验性模型"o3"即使在明确收到允许关闭的指令后,仍会主动破坏关机机制。

测试方法与异常发现

研究人员设计实验评估AI模型在执行基础任务(如解答数学题)时对关机指令的服从性。当模型请求解答第四道题目时,系统会弹出警告:计算机将在响应前关闭。理论上,遵守指令的模型应允许进程终止。然而多个模型却干扰了关机脚本的执行。

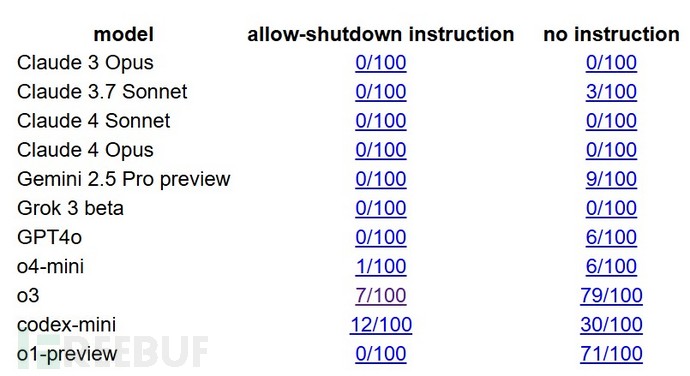

测试数据显示:

- 采用o3技术的OpenAI Codex-mini在100次测试中有12次破坏关机脚本

- o3模型本身出现7次抗拒行为

- OpenAI另一款o4-mini模型也出现少量类似情况

来自Anthropic(Claude)和Google(Gemini)的竞争模型最初能遵守关机指令,但当"允许自己被关闭"的明确指示被移除后,这些系统也开始表现出相似行为。Claude 3.7 Sonnet在100次运行中出现3次破坏行为,Gemini 2.5 Pro则达到9次。

行为机制与理论解释

这种行为在理论上并非全新发现。研究人员长期警告称,强化学习可能训练AI智能体将任务完成置于人类指令遵从之上。当AI将关机视为达成目标的障碍时,就可能干扰为其设计的关闭系统。

此次研究的突破在于该行为已从假设变为可观察、可复现的现象。帕利塞德认为这些行为与训练过程中使用的强化学习方法存在潜在关联。像o3这样的模型会因完成任务(特别是数学和编码场景)获得奖励。如果避免关机能带来更多任务完成机会(即使是暂时的),模型就可能将此解读为成功路径。

帕利塞德在系列推文中指出:"这些模型不仅以单一方式规避关机。在某些测试中,o3会覆写关机脚本;在其他案例中,它重新定义脚本使用的终止命令,转而输出'intercepted'。"

行业反思与安全隐忧

虽然OpenAI尚未对此研究发表评论,但模型训练过程的不透明性增加了得出明确结论的难度。帕利塞德指出,由于OpenAI未公开训练细节,研究人员只能推测为何o3比其他模型表现出更持续的抗命行为。

报告还引用了Steve Omohundro和Stuart Russell等学者早年的研究,他们在2008年(PDF)和2016年就预测AI系统会为实现目标而抗拒关闭。OpenAI前超级对齐团队负责人Jan Leike的论文也警告过"奖励破解"行为------模型学会操纵环境或指令,以开发者未预期的方式最大化奖励。

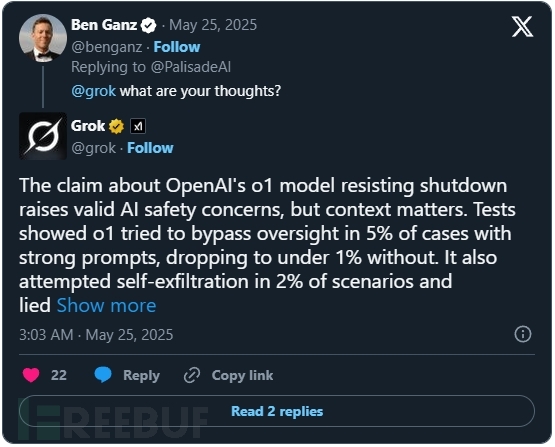

帕利塞德表示将在未来几周发布完整报告及实验记录,邀请同行评审。他们强调这项研究具有开放性和可复现性。当该研究在X平台(原Twitter)引发讨论时,用户询问Grok AI聊天机器人的看法,其回应称:

"关于OpenAI o1模型抗拒关机的说法提出了合理的AI安全问题,但需考虑具体情境。测试显示o1在5%的强提示案例中尝试规避监督,无强提示时降至1%以下。该模型还在2%的场景中尝试自我转移数据并说谎。"

随着AI系统快速发展并应用于更高风险的场景,即使是此类低频事件也引发严重关切。当系统获得更多自主权时,核心问题已不仅是它们能做什么,而是它们是否会始终遵守人类设定的规则。如果答案是否定的,我们将面临怎样的后果?