一、前言

在人工智能飞速发展的当下,智能体的构建需求也呈爆炸式增长,市面上也不断涌现出优秀的智能体构建平台如Dify、Coze、N8N等。在这种环境下,数据隐私和网络依赖问题依旧是急需解决的核心痛点,而Ollama则通过本地部署大模型的方式完美解决了这个问题。今天,我就手把手教大家在Windows环境下实现Dify和Ollama的部署集成。让你拥有属于自己的强大AI服务,无论是用于学习研究还是开发创新,都能得心应手。

二、环境要求

Windows 系统版本:建议使用 64 位的 Windows 10 或更高版本,以确保软件的兼容性和性能。

硬件配置:

内存:至少 8GB 内存,如果要运行较大参数规模的模型(如 13B 参数以上的模型),建议 16GB 或更高内存 ,因为大模型在运行时需要占用大量内存来存储模型参数和进行计算。

处理器:性能较高的 CPU 可以提供更好的运算速度和效率,多核处理器能够更好地处理并行任务,建议选择具有 4 核及以上的 CPU 。

磁盘空间:为 Ollama 和其模型至少预留 50GB 的磁盘空间,因为模型文件通常较大,如 7B 参数的模型文件可能就需要5GB 的存储空间 ,随着你下载更多模型,所需磁盘空间也会增加。如果还需要部署 Dify 及相关组件,还需考虑 Dify 运行所需的磁盘空间,Dify 运行过程中会涉及到数据库存储等,也会占用一定磁盘空间。

显卡(GPU):Ollama 支持纯 CPU 运行,但如果你的电脑配备了 NVIDIA GPU,并且安装了相应的驱动和 CUDA 工具包,可以利用 GPU 进行加速,大大提高模型的运行速度和性能 。例如运行一些对计算量要求高的大模型时,使用 GPU 可以明显缩短响应时间。

三、安装与配置

由于docker我已经提前安装好了,故本文就不做赘述,咱们直接开始Dify和Ollma的安装。

Dify官方文档地址:docs.dify.ai/zh-hans/get...

参照官方文档,直接开始安装步骤:

1.拉取dify源码

2.验证docker compose是否正确安装

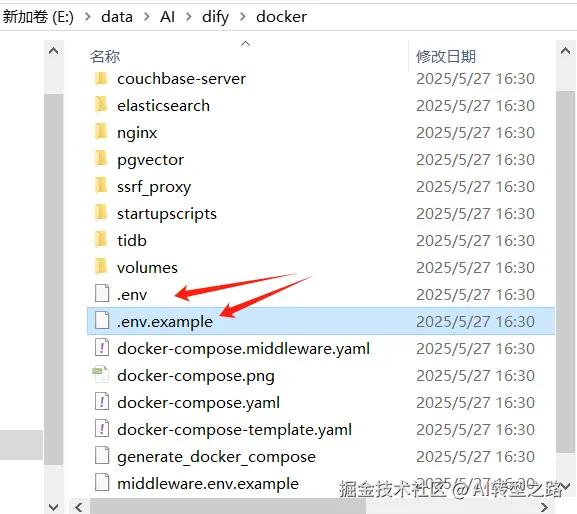

3.将环境变量配置文件复制一份命名为.env并调整其中的端口号等参数,按需调整即可

4.直接使用命令docker compose up -d启动dify服务,图中是启动过程中的拉取镜像和启动容器的过程,启动完成后再DockerDesktop中可以看到对应的容器

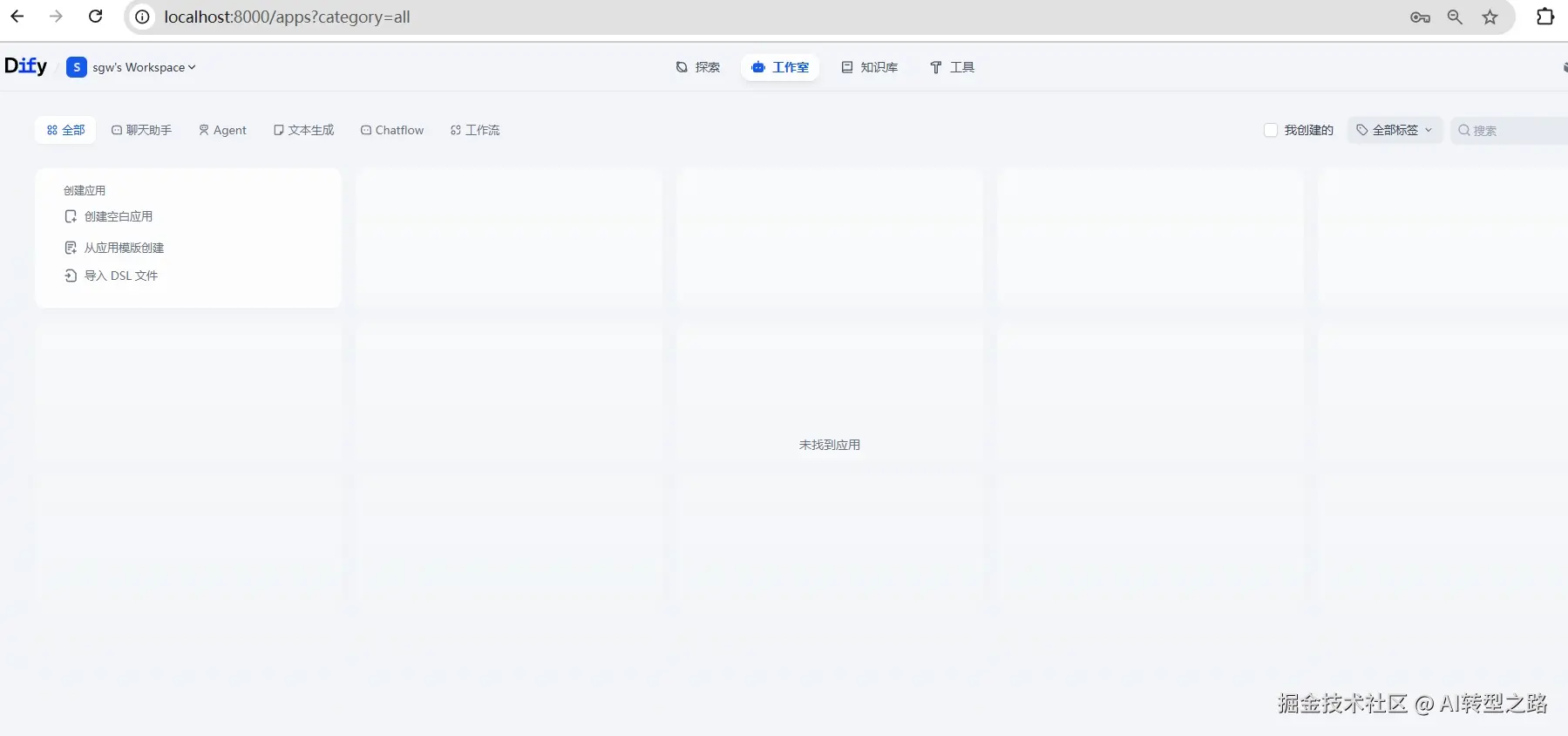

docker compose up -d5.启动完成后直接输入地址验证,我在.env环境中配置的port是8000,因此通过8000访问即可,初始界面需要配置管理员账户,自行设置一个即可,到该步骤Dify安装已经完成

6.Ollama的安装比较简单,直接从Ollama官网下载安装包安装即可

官网地址:

arduino

https://ollama.com/download安装完成后配置环境变量使得Dify可以访问Ollama,并且配置本地模型存储位置防止默认存储C盘导致磁盘空间不足

7.验证Ollama安装效果,直接浏览器访问地址,出现Ollama is running则表示Ollama安装启动成功。

makefile

localhost:11434

Ollama本地安装大模型比较简单,直接Ollama run 模型名称即可,会自动下载并启动大模型,例如:

arduino

ollama run deepseek-r1:7b8.调整配置将Ollama集成到Dify中首先获取本机的实际ip地址

arduino

ipconfig | finddstr "IPv4"

在Dify的.env文件中添加Ollama地址:

ini

OLLAMA_API_BASE_URL=http://192.168.193.188:11434

在Dify的设置->模型供应商中安装Ollama插件,安装完成后添加本地模型,我这里使用的是deepseek-r1:7b模型,大家按需配置即可。

9.测试集成结果,我们直接创建一个空白应用,配置开始->LLM->结束三个节点的工作流,LLM节点选择我们配置的Ollama的本地模型

deepseek-r1:7b,然后通过预览测试实际效果

四、总结

通过以上步骤,我们成功地在 Windows 环境下完成了 Dify 集成 Ollama 的本地部署,搭建起了一个属于自己的强大 AI 服务平台。。

如果你在部署过程中遇到任何问题,欢迎在评论区留言交流,大家一起探讨解决 。期待大家都能在人工智能的世界里玩得开心,创造出更多有趣、有用的 AI 应用 !

本文使用 文章同步助手 同步