文章目录

-

- 前言

- [1. 本地部署Ollama+DeepSeek](#1. 本地部署Ollama+DeepSeek)

- [2. 本地安装Anything LLM](#2. 本地安装Anything LLM)

- [3. 配置与使用演示](#3. 配置与使用演示)

- [4. 远程调用大模型](#4. 远程调用大模型)

- [5. 安装内网穿透](#5. 安装内网穿透)

- [6. 配置固定公网地址](#6. 配置固定公网地址)

前言

在人工智能技术加速迭代的今天,您是否渴望获得一个能够深度理解业务需求并实时响应的智能协作系统?本文将系统阐述一种创新性解决方案------依托本地化部署模式,在Windows操作系统中构建专属AI工作平台。通过Ollama技术框架与DeepSeek R1计算引擎的有机融合,结合Anything LLM交互界面及cpolar网络穿透工具,可实现完全脱离云服务的自主化AI系统建设。

该技术体系突破了传统云架构的部署限制,使用户能够全面掌控AI系统的运行环境。从底层架构搭建到功能模块的动态扩展,我们将深入解析如何将这些先进技术转化为实际生产力。通过这种技术组合,用户不仅可获得即时响应的智能交互能力,更能构建定制化的知识管理体系,实现人工智能与日常办公场景的深度融合。这种本地部署方案在确保数据安全性的基础上,通过内网穿透机制实现了跨地域的远程访问,为个性化AI应用开辟了全新的技术路径。

【视频教程】

本地部署DeepSeek结合Anything LLM打造智能AI知识库并实现远程访问

1. 本地部署Ollama+DeepSeek

如果没有安装Ollama与DeepSeek,可以查看这篇教程进行安装:《Windows本地部署deepseek-r1大模型并使用web界面远程交互》

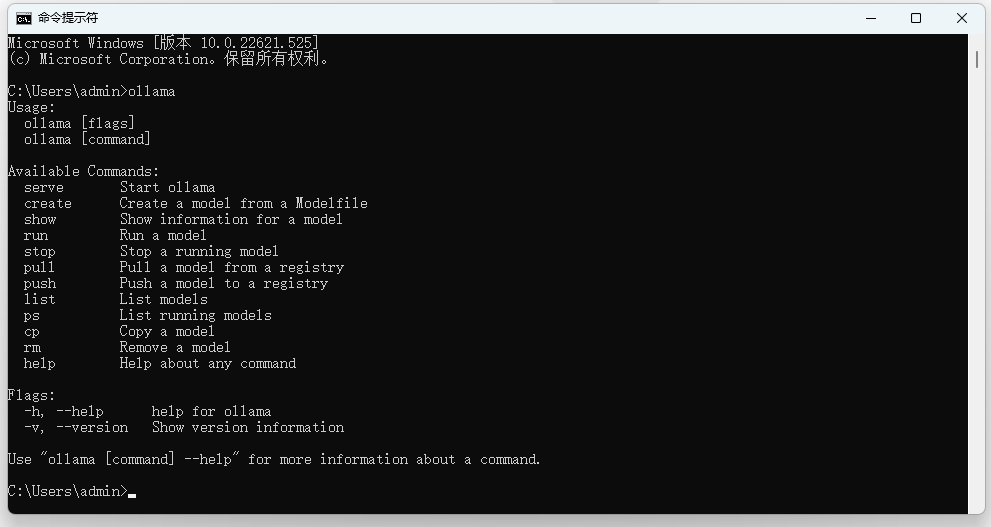

简单来说就是访问Ollama的官网,下载适配你的操作系统的客户端,安装好之后用cmd打开Windows系统自带的终端界面:

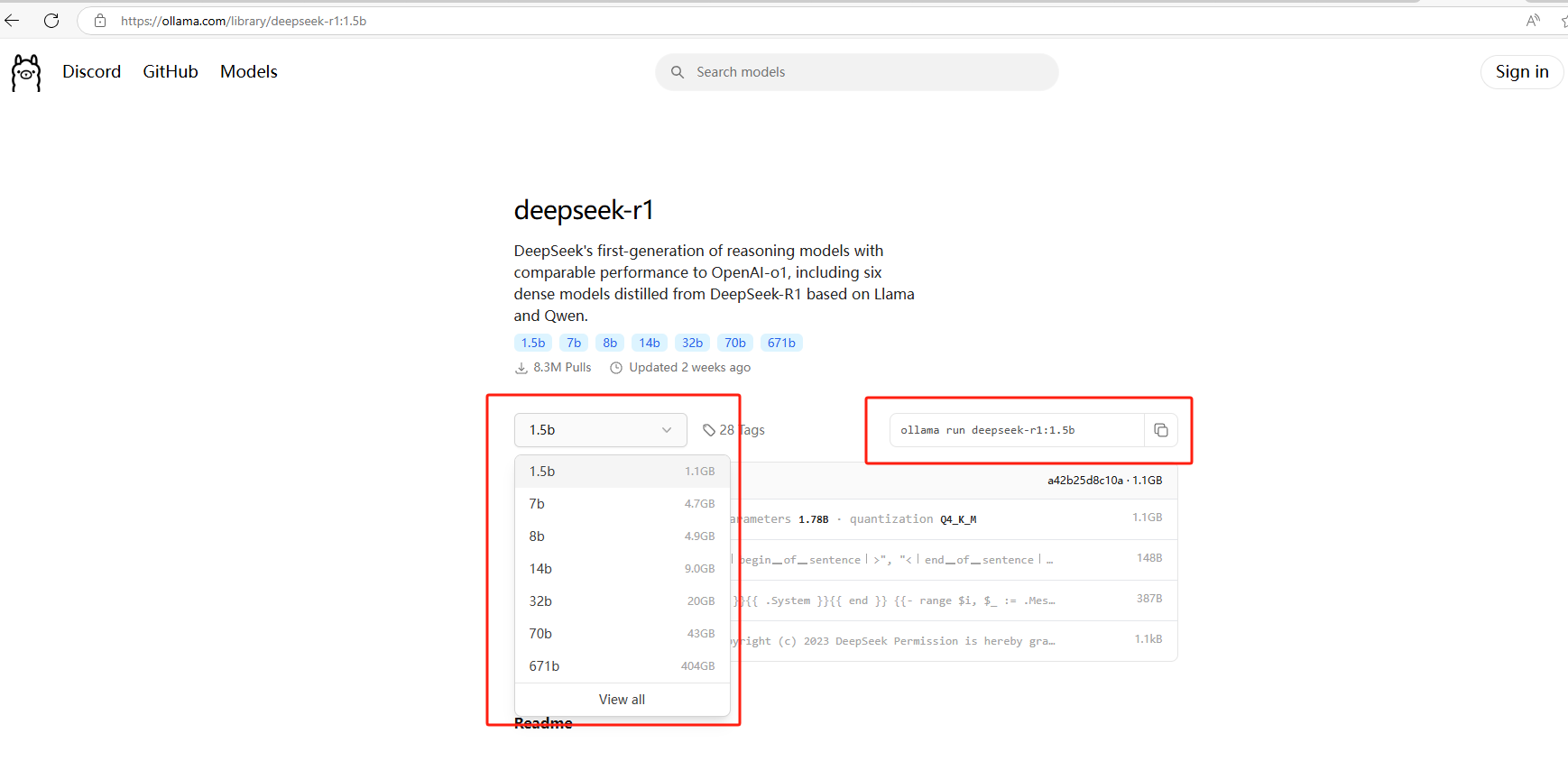

然后回到Ollama的官网,找到你想要下载的各种量级的模型对应的模型下载命令:

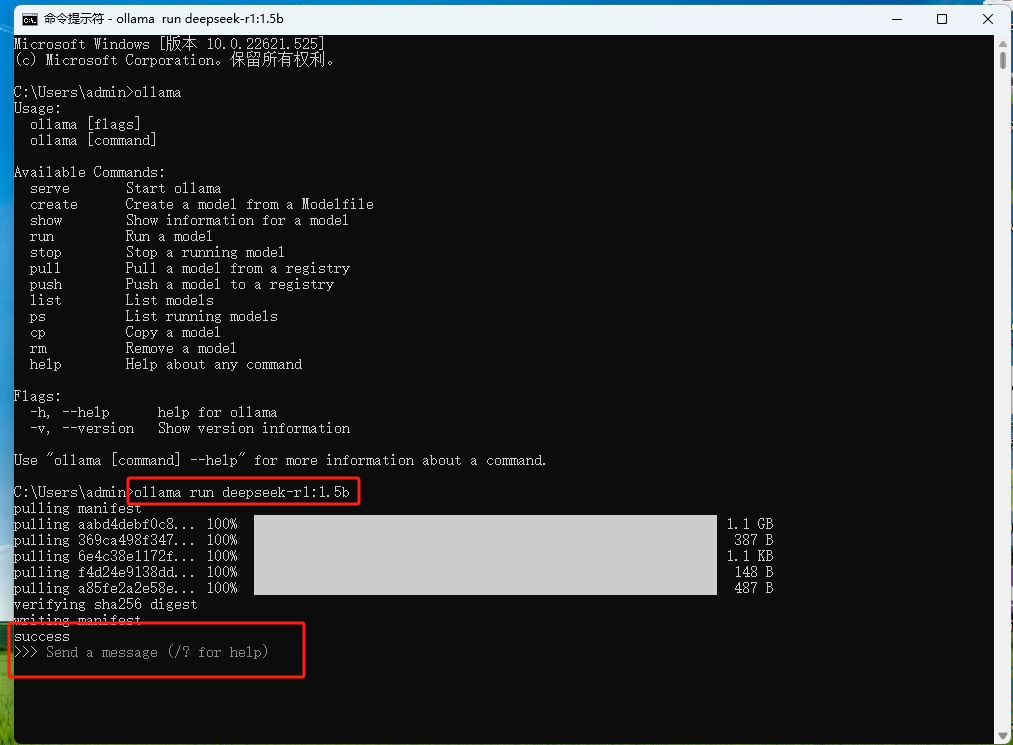

比如我这里下载1.5b的轻量级deepseek模型,就在cmd终端中执行这个命令就能安装了:

shell

ollama run deepseek-r1:1.5b

现在我们就已经能够在本地Windows电脑上通过ollama正常使用deepseek-r1模型与AI进行聊天了!

2. 本地安装Anything LLM

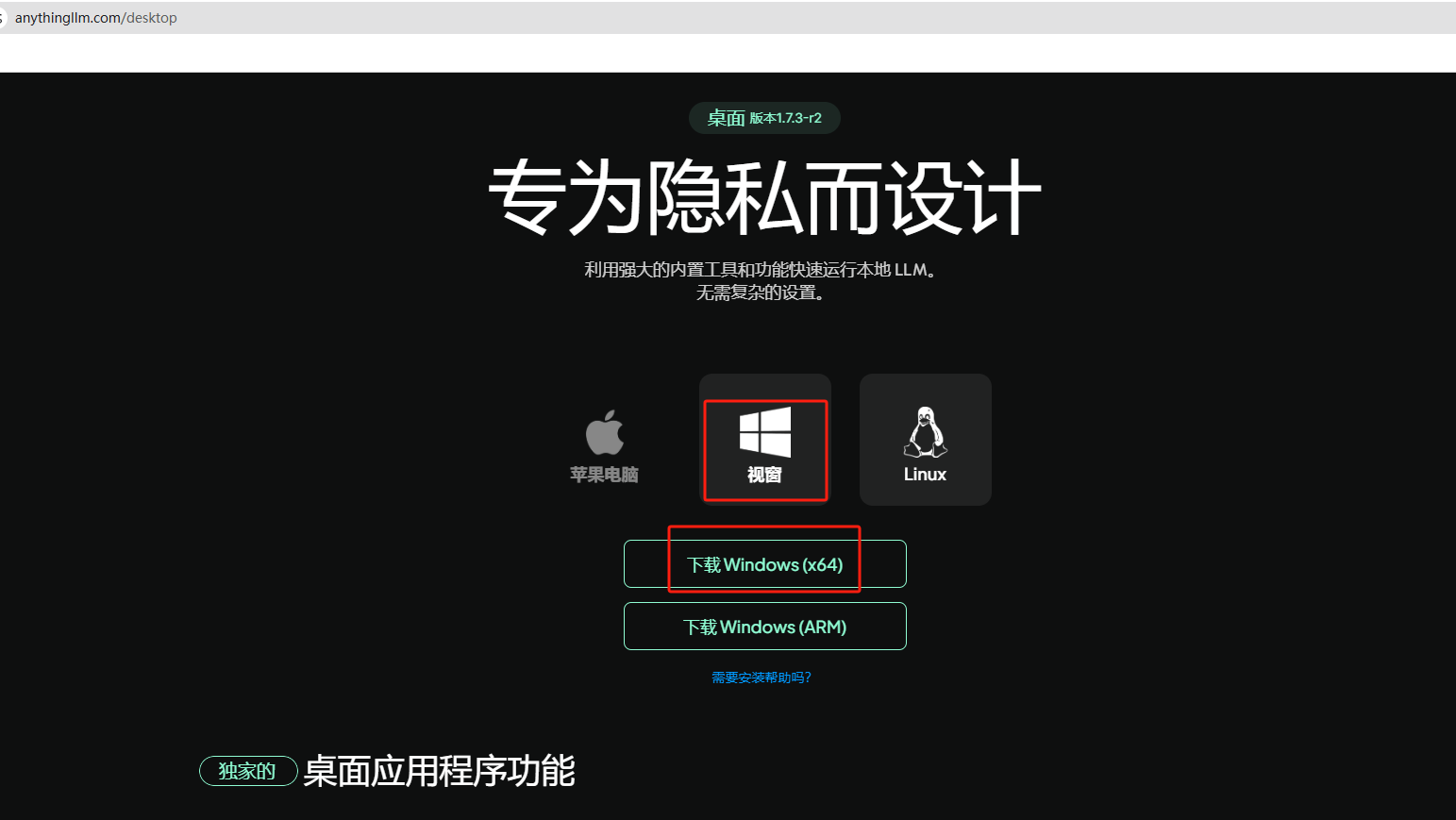

下面我们访问Anything LLM的官网下载Windows客户端:

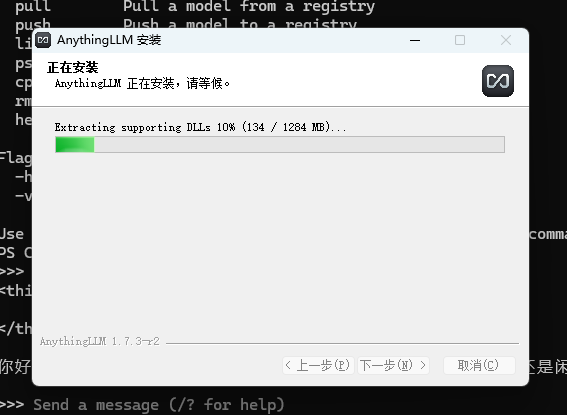

下载后,双击应用程序进行安装:

安装完毕后打开软件后,点击get started按钮进入使用界面:

3. 配置与使用演示

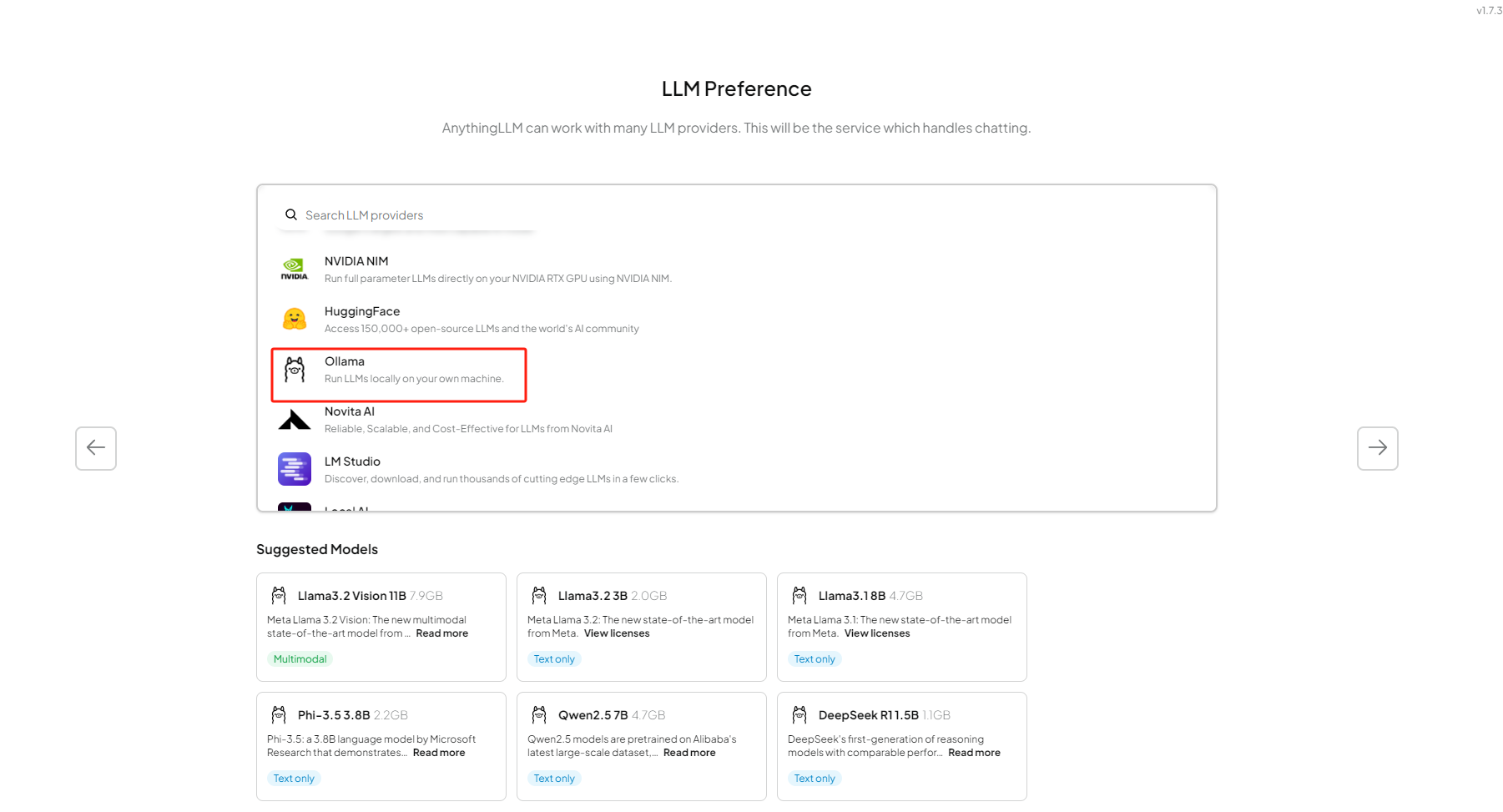

第一步选择Ollama:

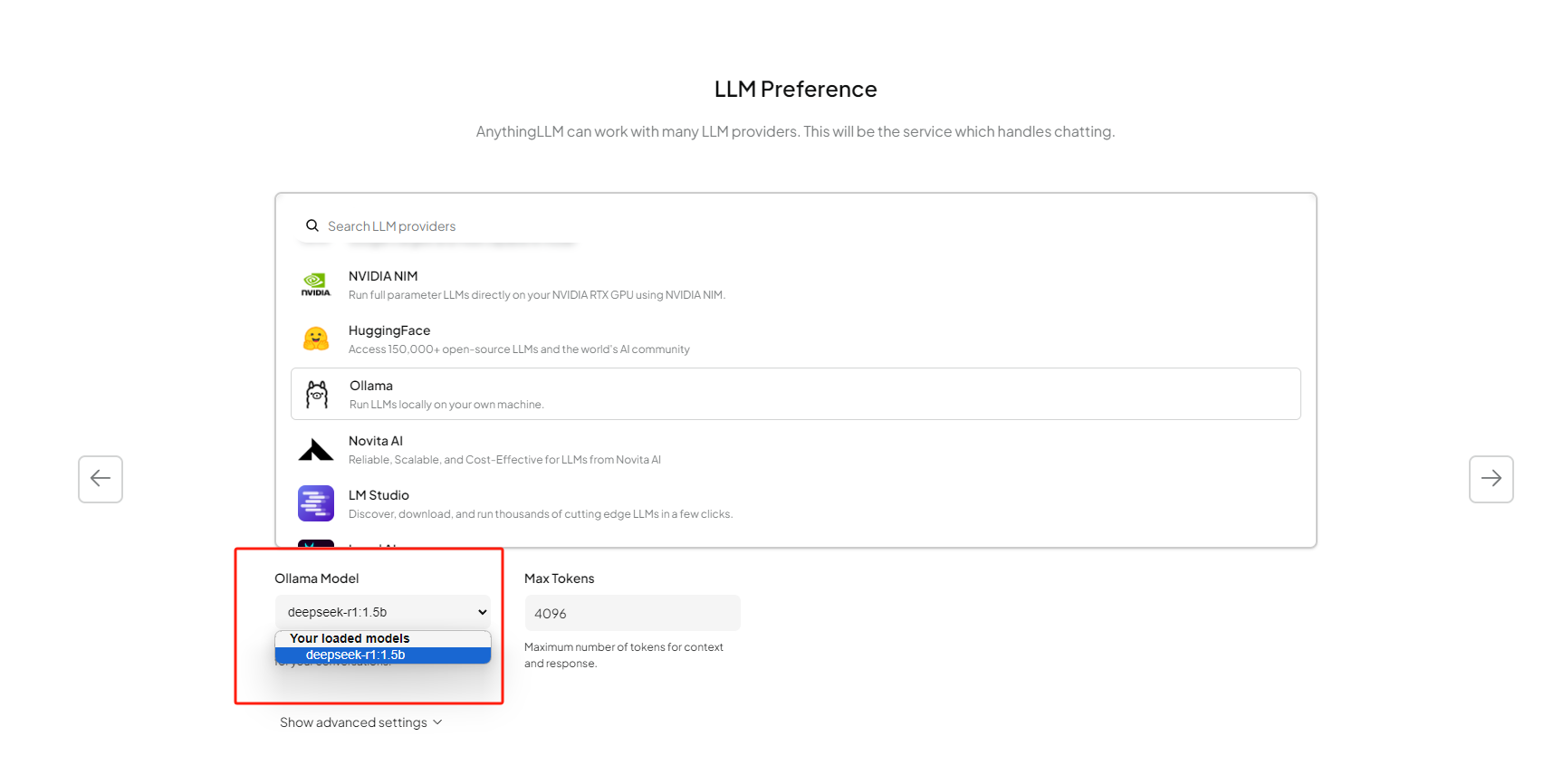

选择好之后,点击右侧的箭头,下方会出现选择使用哪个大模型的下拉框,我们可以在这里看到之前本地部署的deepseek-r1:1.5b模型,如果你本地还有其他模型,也会出现在这里。

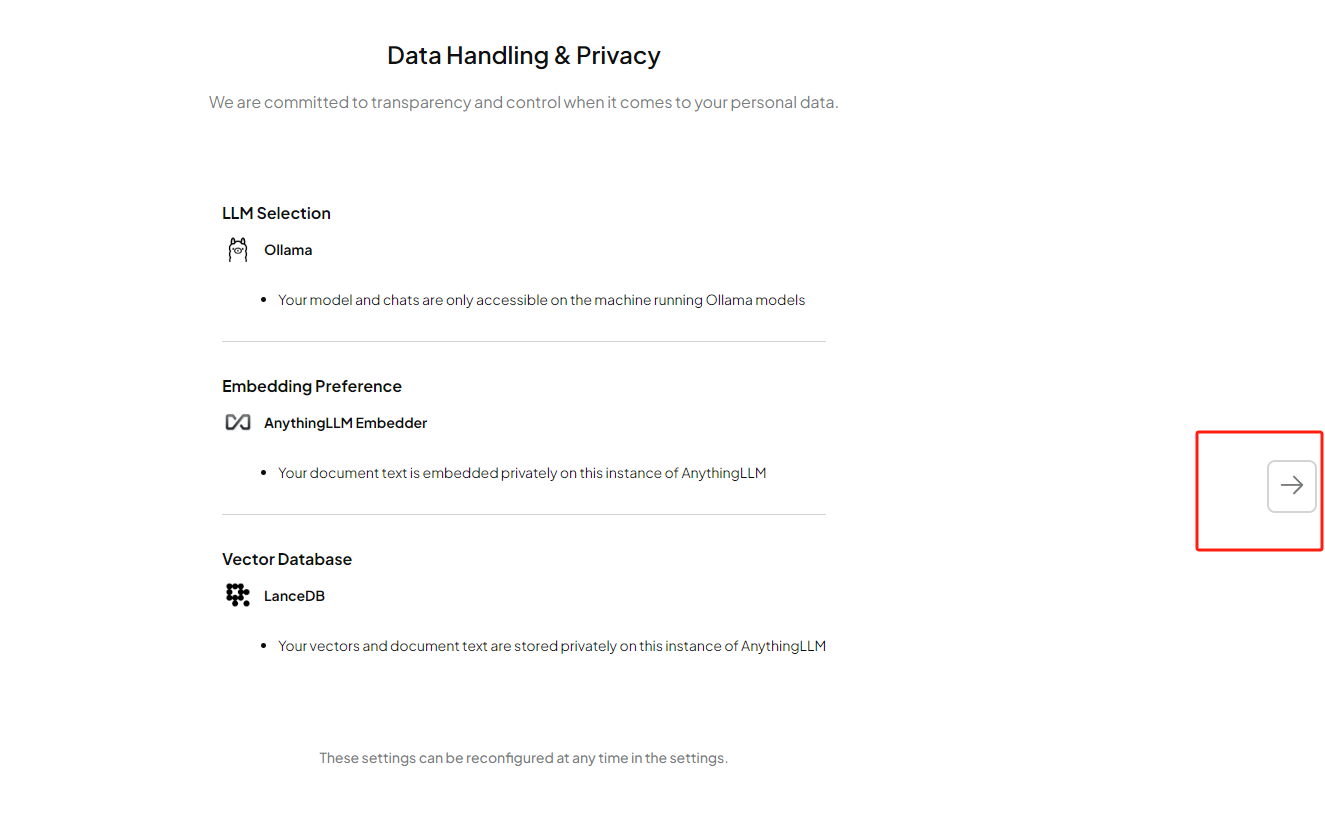

下一步确认信息后,点击右侧箭头继续:

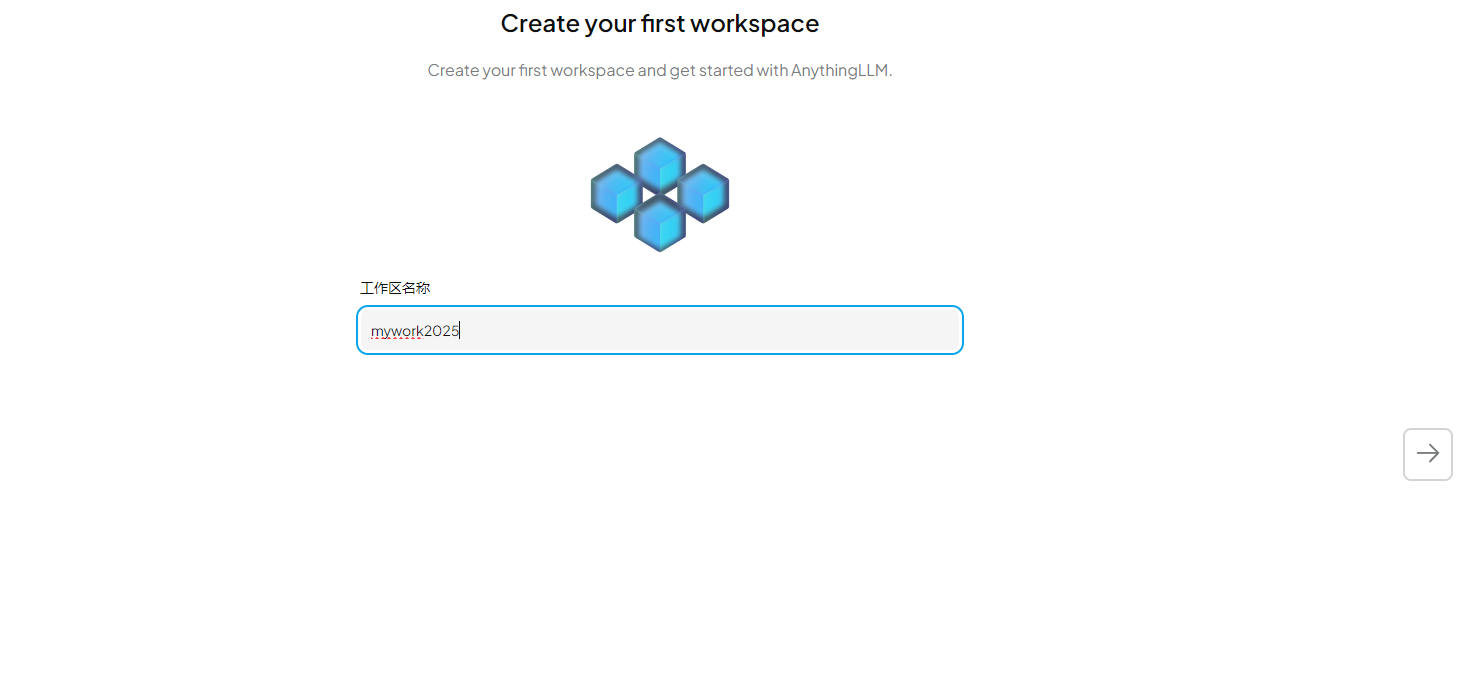

现在我们需要创建一个工作区,并给它取个名字,输入后继续点击右侧箭头:

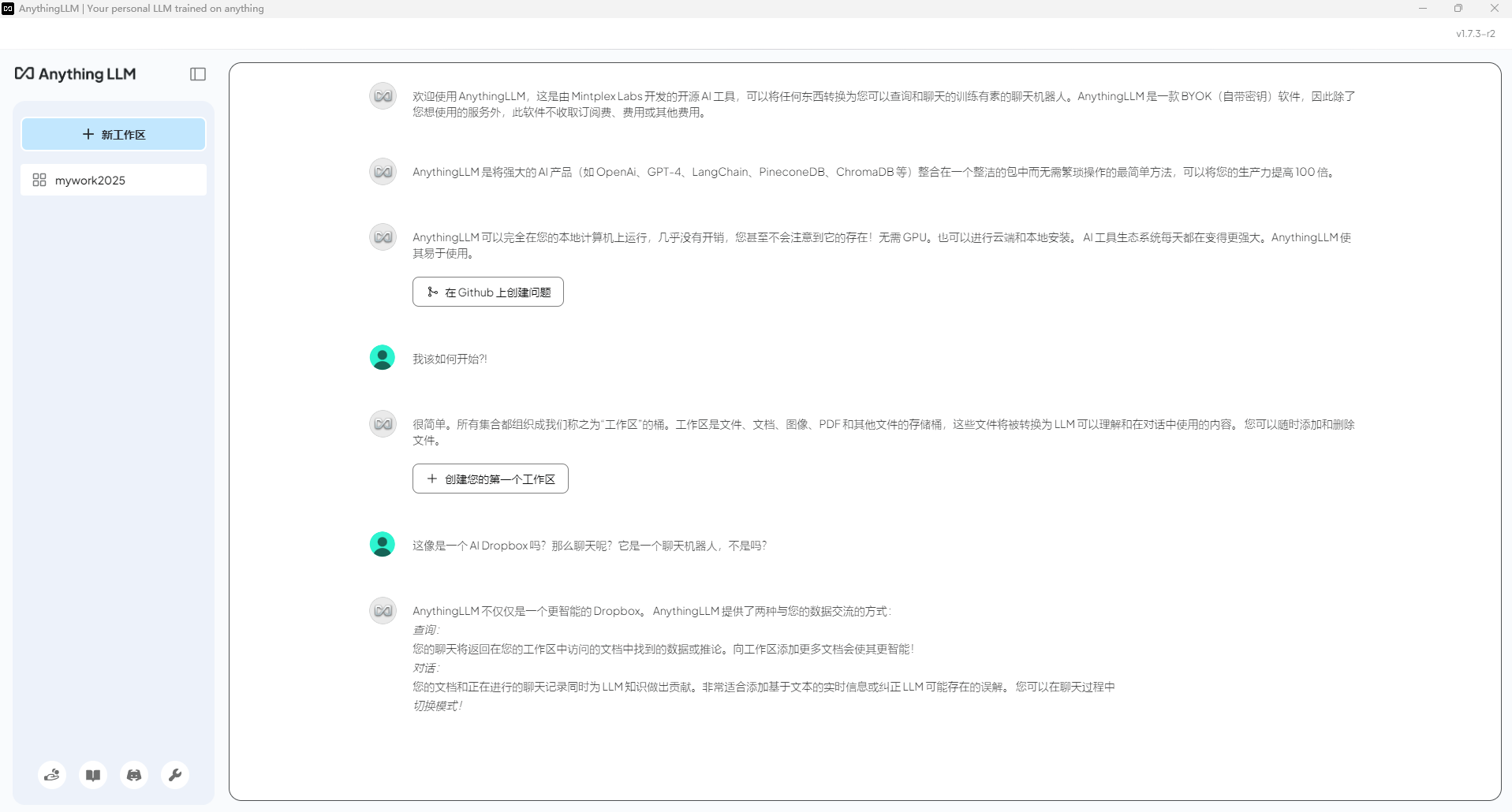

在Anything LLM中配置好了大模型,并创建了一个工作区后就可以看到欢迎界面了:

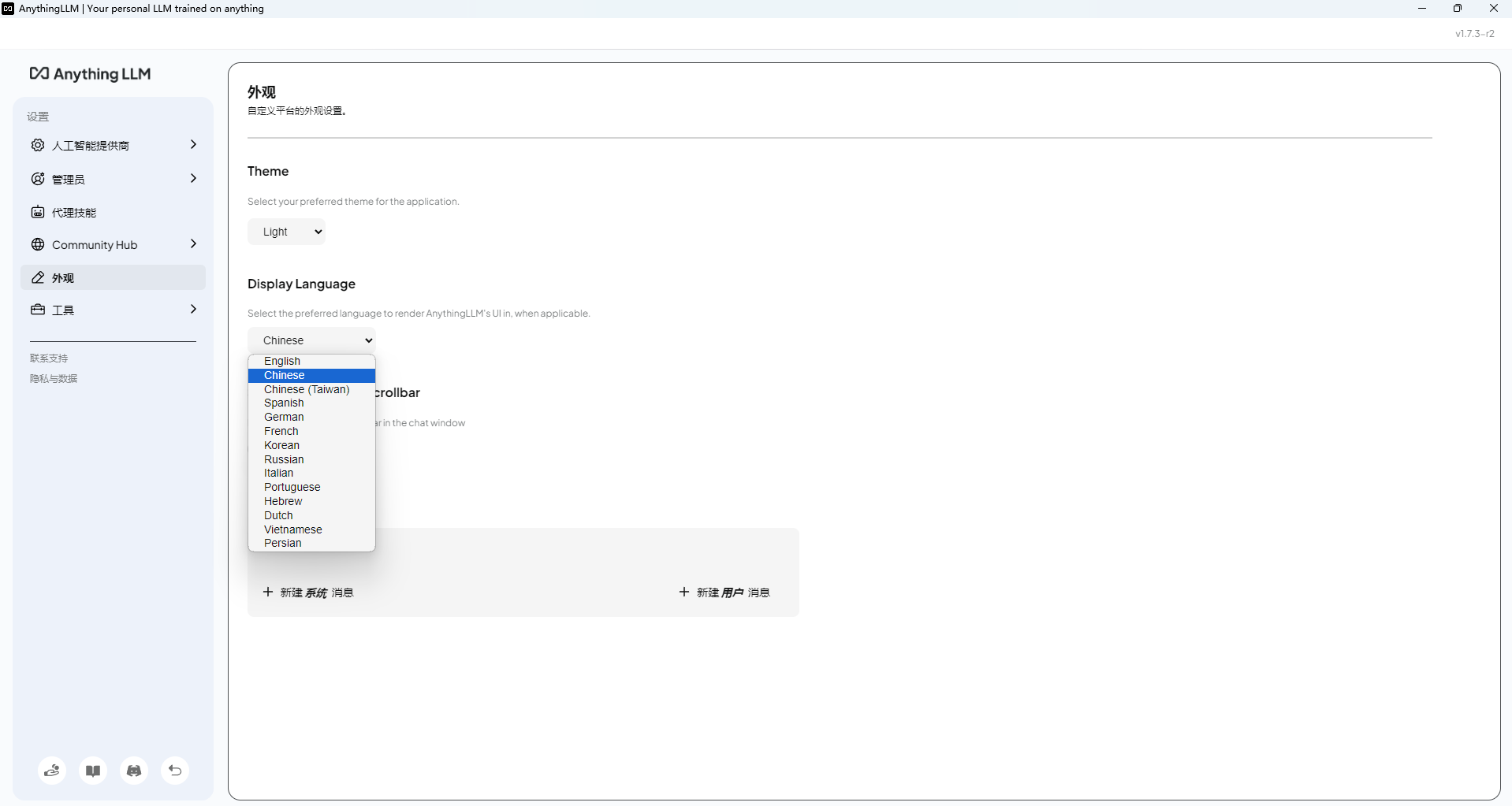

点击左下角的扳手(设置),我们可以对界面语言进行修改:

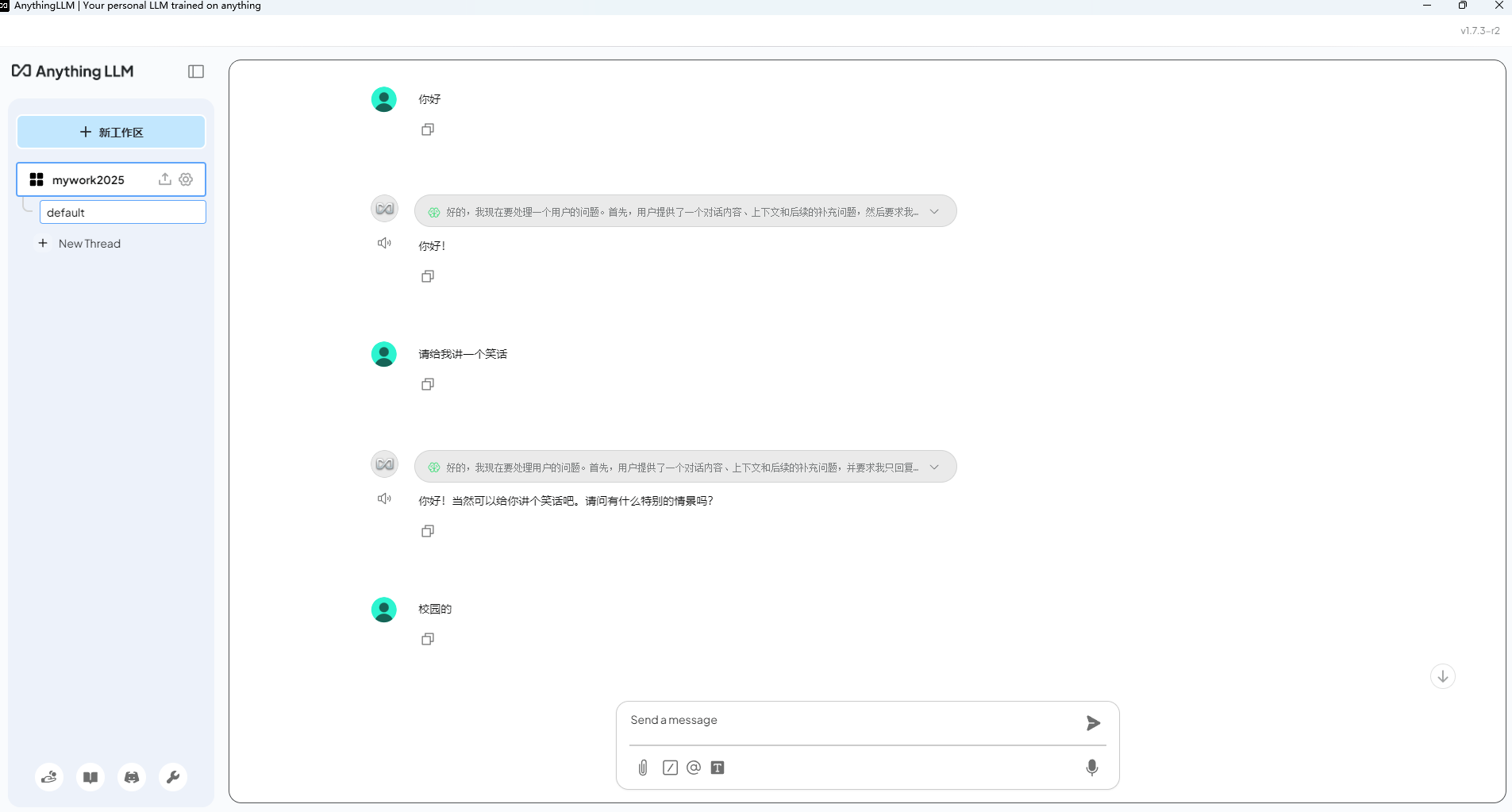

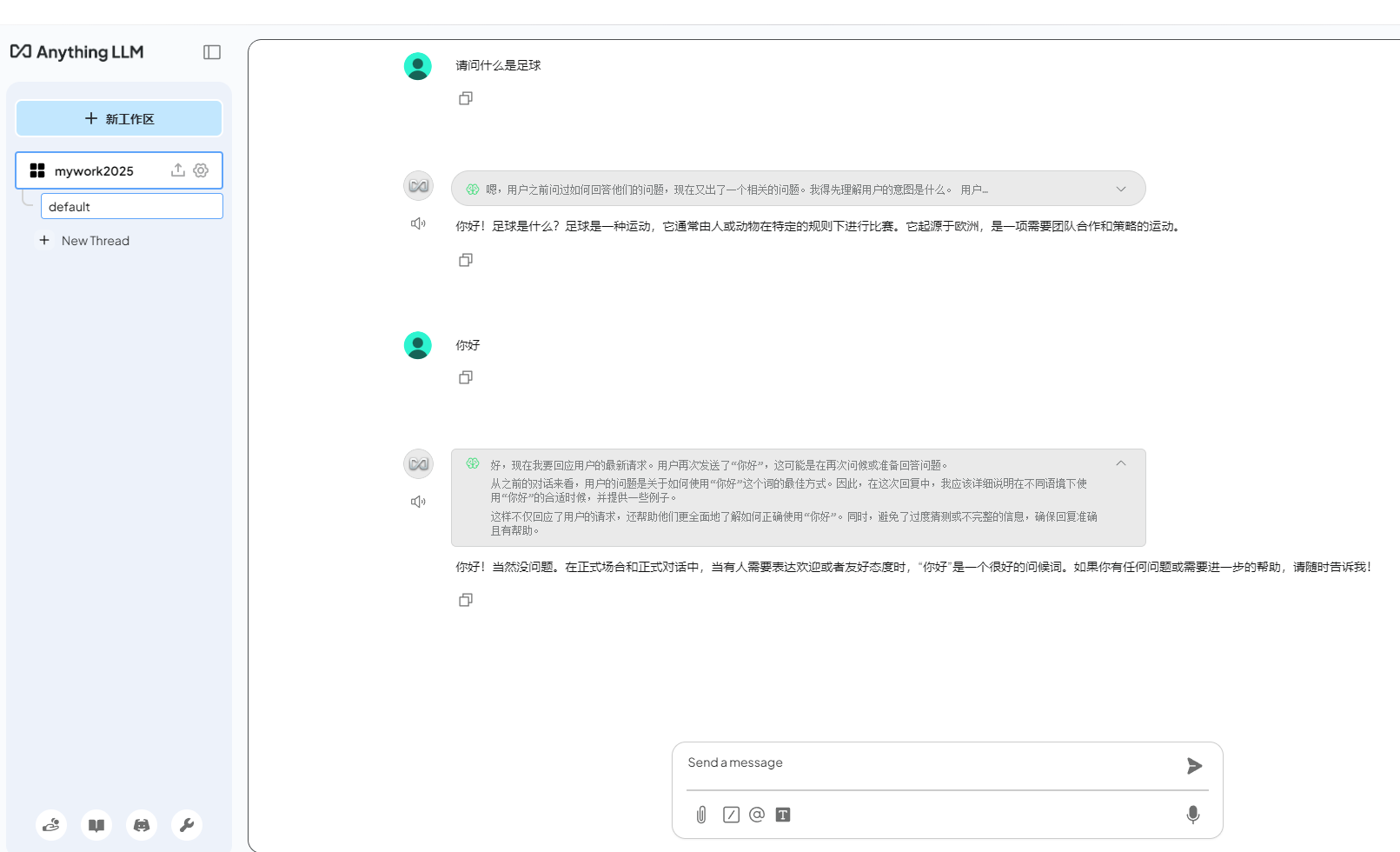

设置好之后,点击同一位置的返回按钮,即可回到工作区,在下方的输入框中,就可以和大模型聊天了!

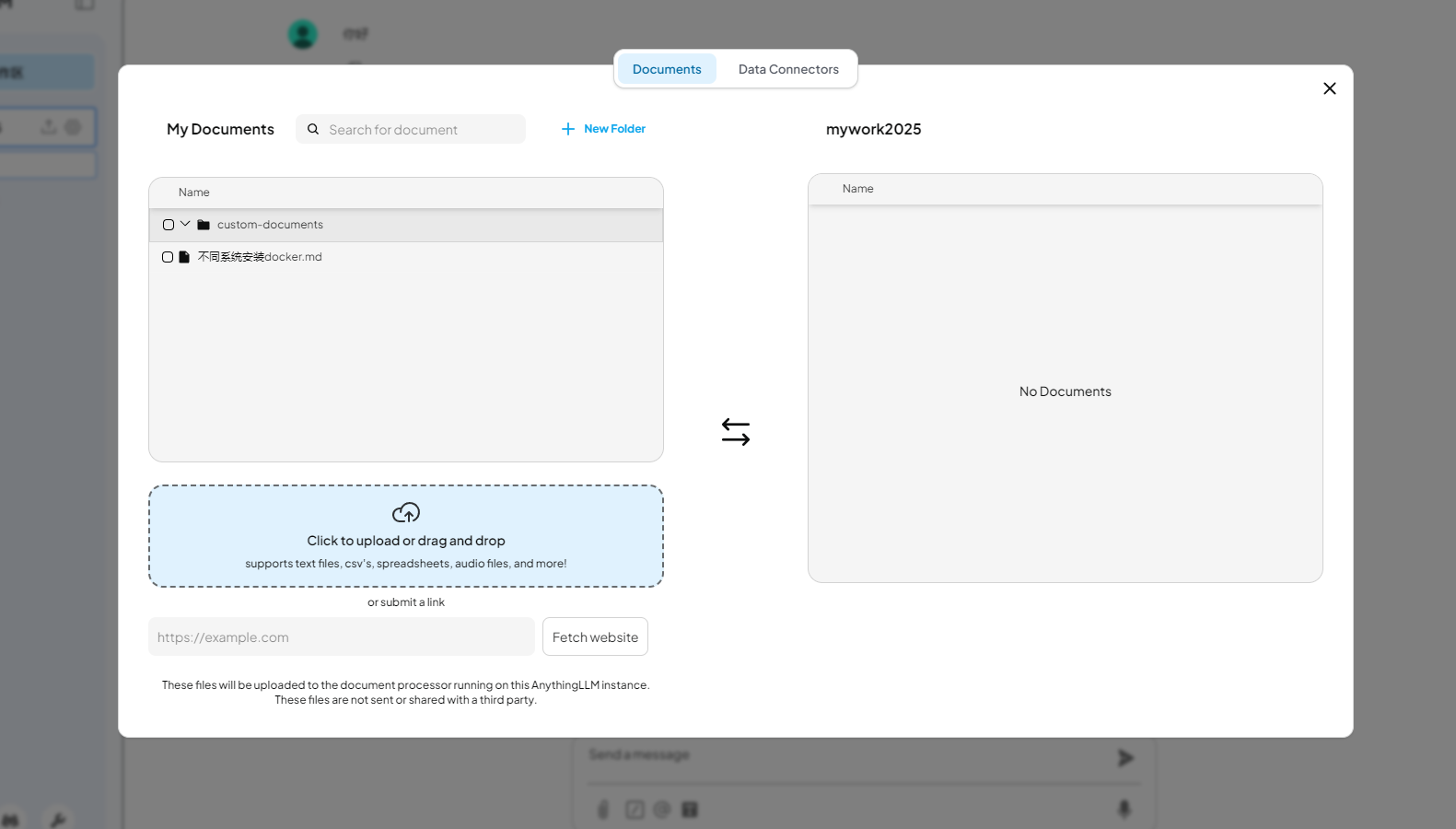

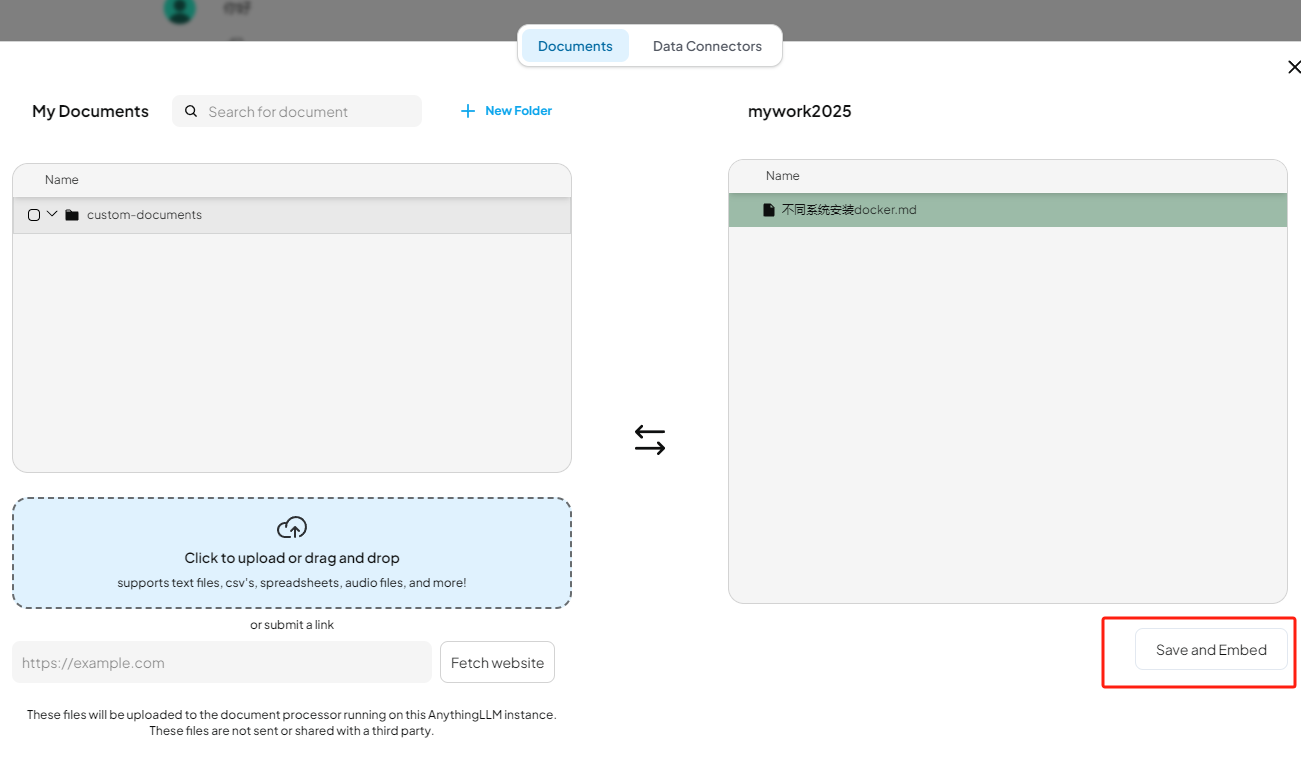

如果我们需要上传文件或是图片等资料,点击工作区名称标签后的上传按钮即可打开上传界面:

除了支持多种文档类型(PDF、TXT、DOCX等),在上传按钮下方还可以直接粘贴网址,真的是非常方便又全面。勾选你要上传的文件,

点击右下角的保存和嵌入按钮即可上传你的资料。通过Anything LLM管理超大文档时高效、低耗。只需要一次就可以嵌入(Embedding)一个庞大的文档或文字记录,比其他文档聊天机器人解决方案节省超多成本。

4. 远程调用大模型

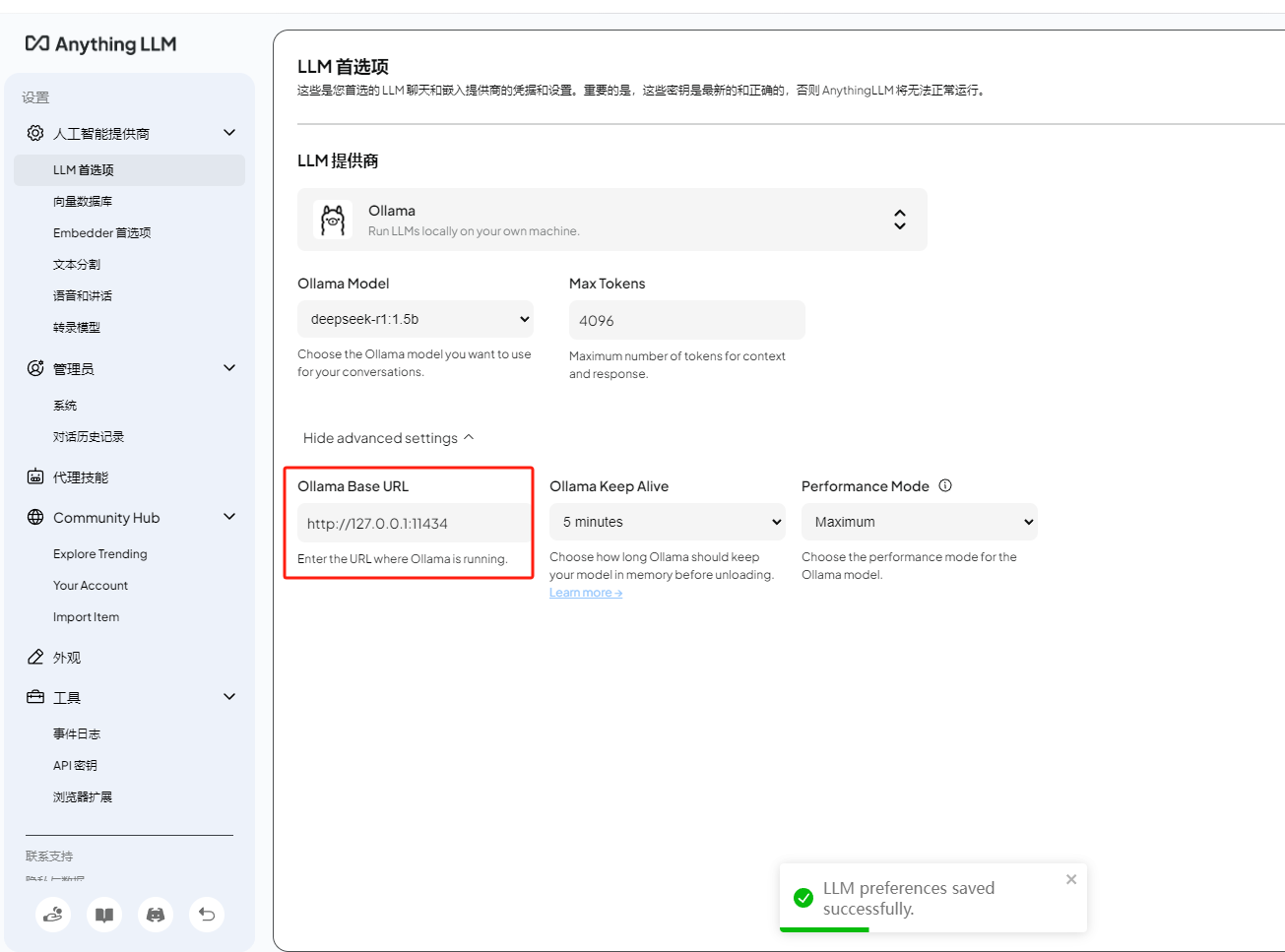

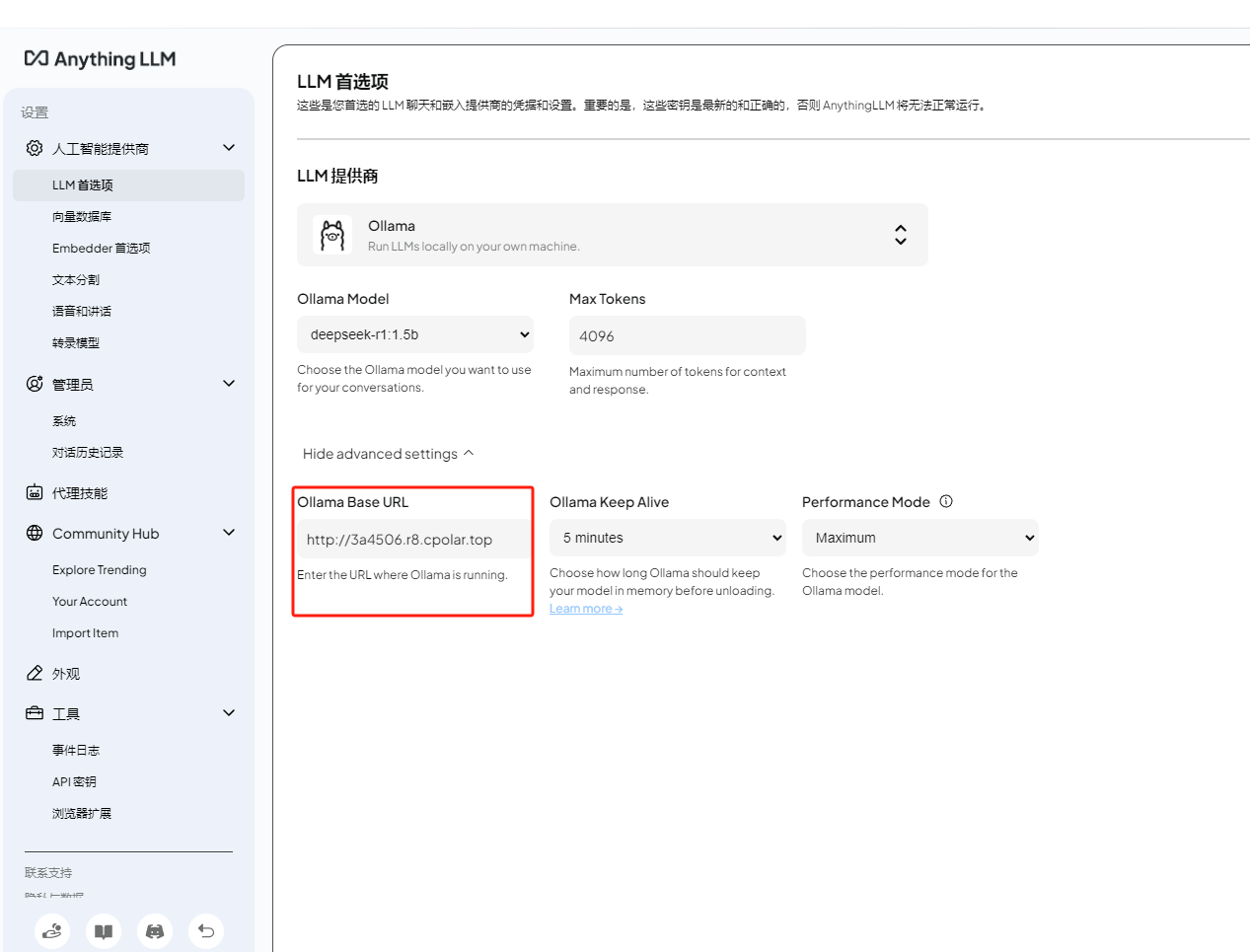

在设置界面的LLM首选项中,我们能看到刚才选择的LLM提供商是ollama,下方是模型信息,最底部有ollama运行的地址和端口:

如果我们想要在局域网内让其他的小伙伴也能远程使用Anything LLM调用ollama使用大模型进行聊天,那么我们需要进行对ollama进行一下环境变量设置!

打开cmd终端,执行下面两个命令:

cmd

setx OLLAMA_HOST "0.0.0.0"

setx OLLAMA_ORIGINS "*"然后点击电脑桌面右下角的ollama图标退出并重启服务:

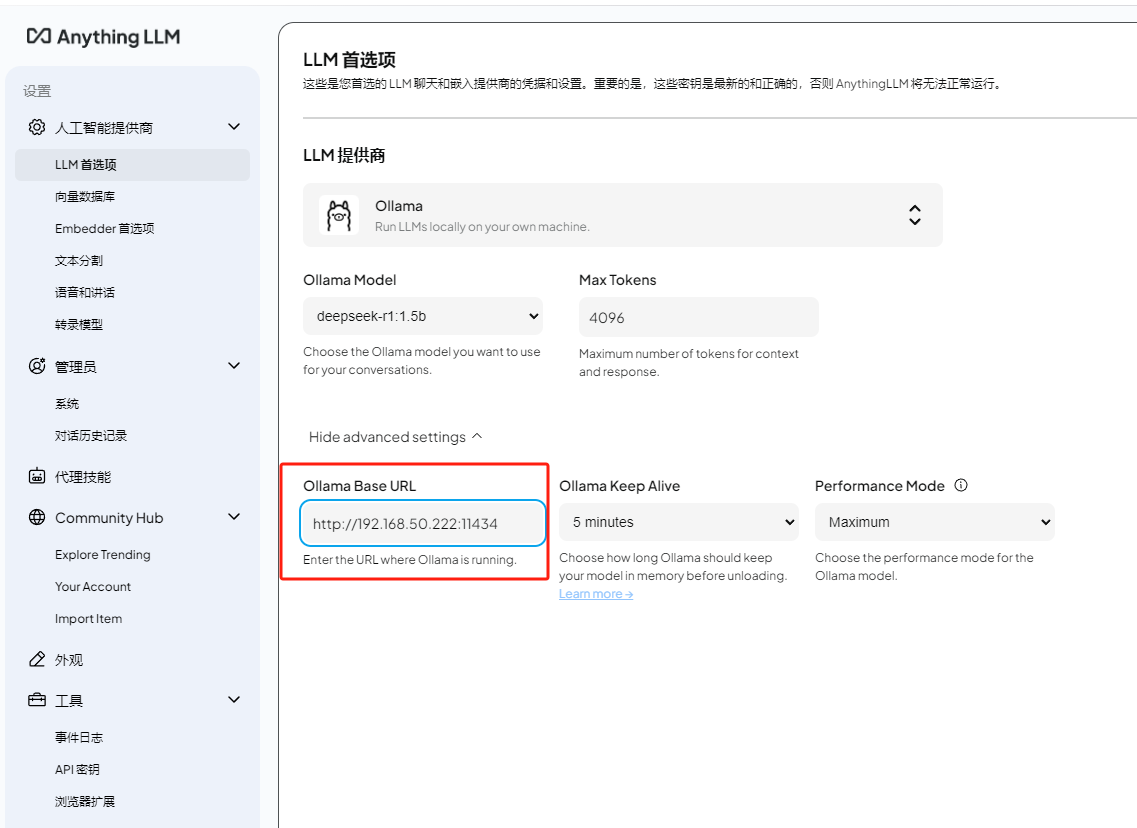

重新开启ollama服务后,同一局域网下的小伙伴在Anything LLM中将ollama的地址改为你的电脑IP加上端口号11434后,就能使用你在本地部署的大模型进行聊天或者上传文件训练了。

5. 安装内网穿透

不过我们目前只能在本地局域网内多人使用Anything LLM远程访问大模型,如果想让异地好友、让更多人也能使用你在部署的deepseek大模型应该怎么办呢?很简单,只要安装一个cpolar内网穿透工具就能轻松实现远程访问内网主机中部署的服务了,接下来介绍一下如何安装cpolar内网穿透。

首先进入cpolar官网:

cpolar官网地址: https://www.cpolar.com

点击免费使用注册一个账号,并下载最新版本的cpolar:

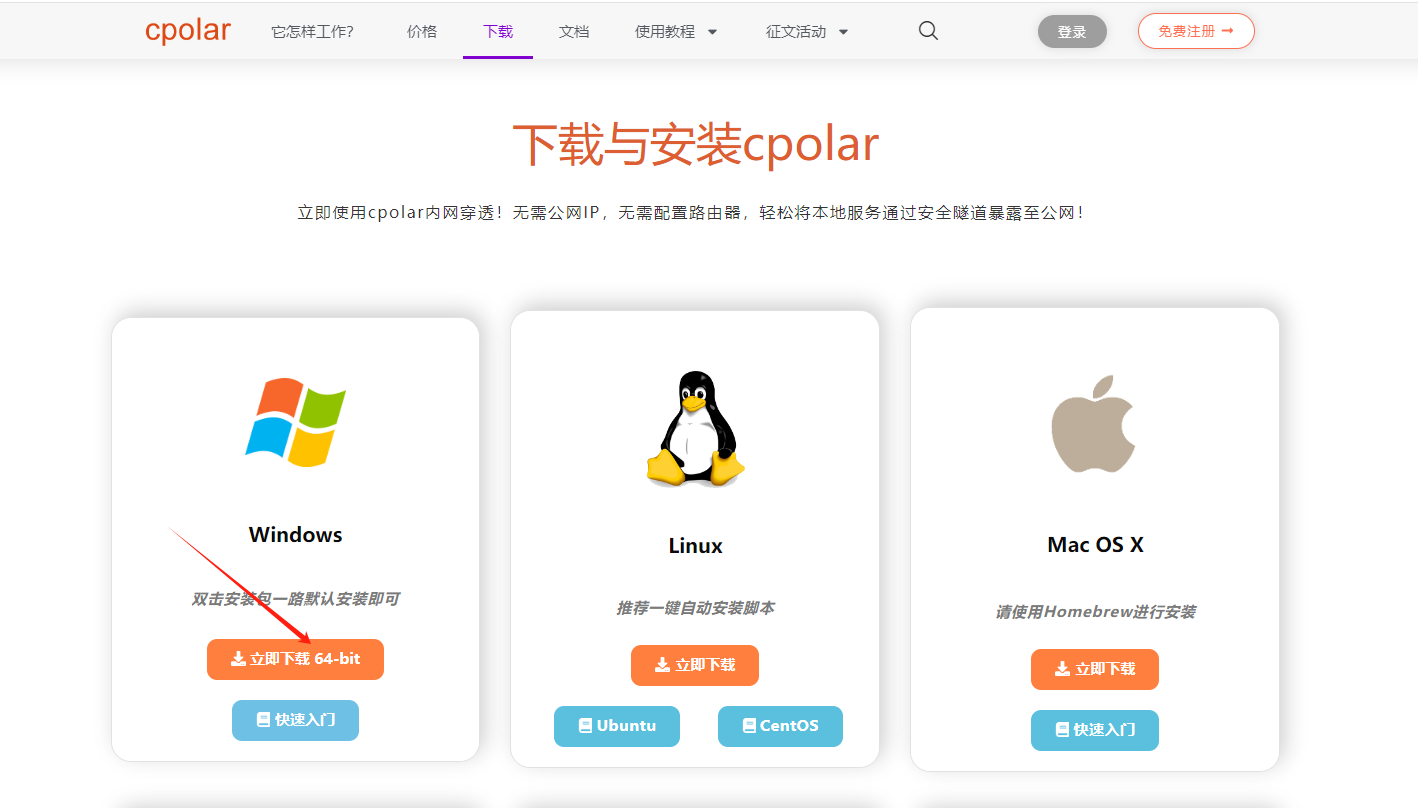

登录成功后,点击下载cpolar到本地并安装(一路默认安装即可)本教程选择下载Windows版本。

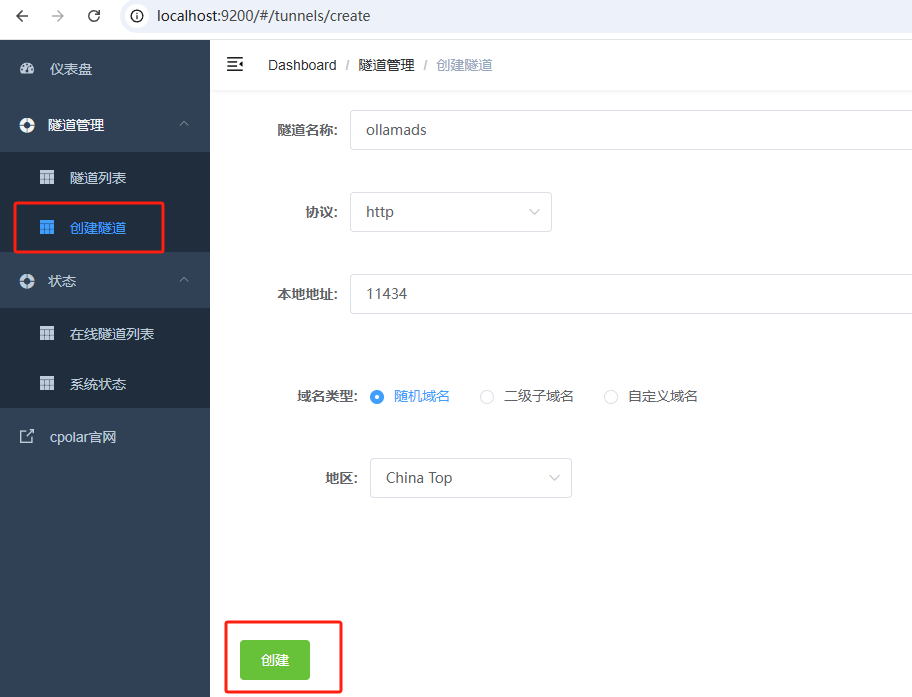

cpolar安装成功后,在浏览器上访问http://localhost:9200,使用cpolar账号登录,登录后即可看到配置界面,结下来在WebUI管理界面配置即可。

接下来配置一下 Ollama 的公网地址,

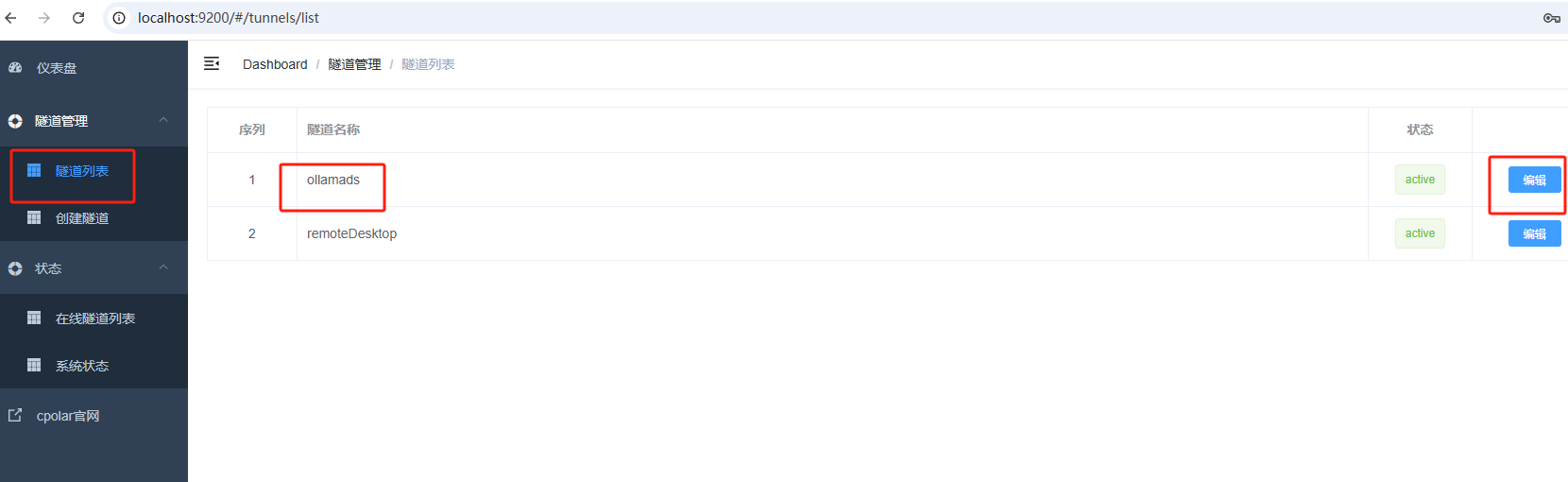

登录后,点击左侧仪表盘的隧道管理------创建隧道,

- 隧道名称:ollamads(可自定义命名,注意不要与已有的隧道名称重复)

- 协议:选择 http

- 本地地址:11434

- 域名类型:选择随机域名

- 地区:选择China Top

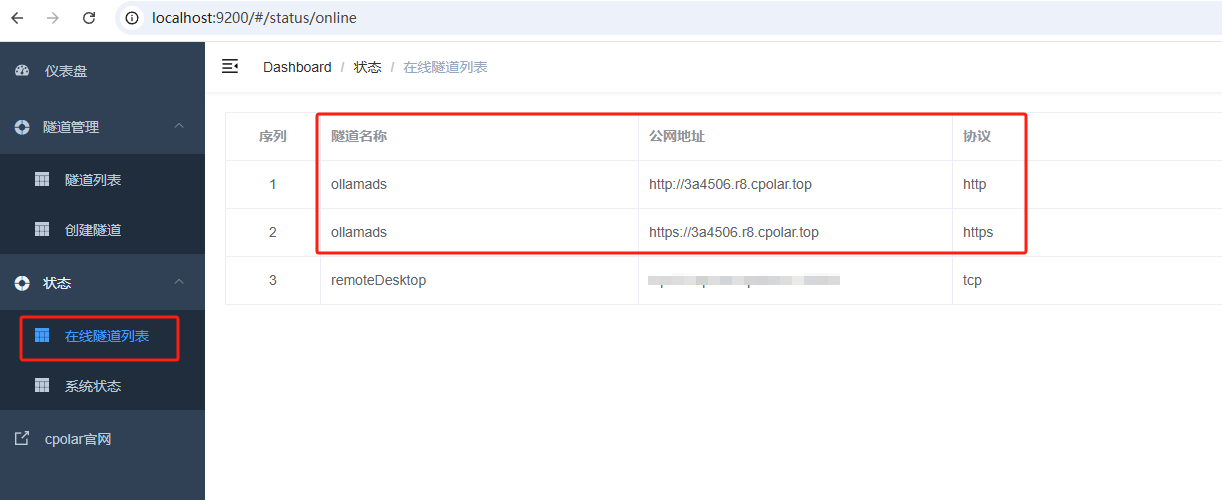

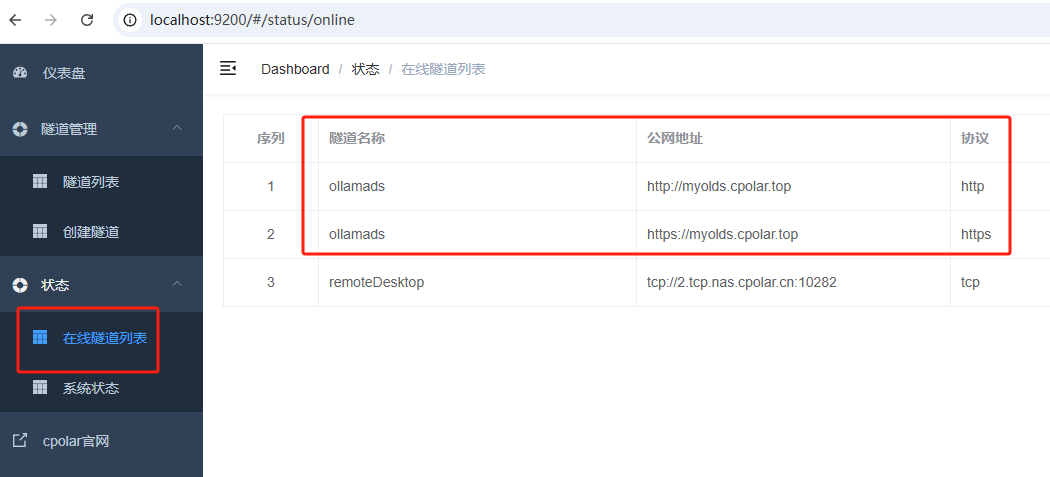

隧道创建成功后,点击左侧的状态------在线隧道列表,查看所生成的公网访问地址,有两种访问方式,一种是http 和https:

在Anything LLM的设置界面中使用上面的任意一个公网地址替换刚才IP加端口号的地址,点击右上角的保存按钮后,就可以实现异地远程访问本地部署的deepseek大模型聊天了!使用了cpolar的公网域名,无需自己购买云服务器,轻松搞定远程访问。

PS:如果替换地址后无法使用,退出重新启动一下Anything LLM即可

总结

为了方便演示,我们在上边的操作过程中使用cpolar生成的HTTP公网地址隧道,其公网地址是随机生成的。这种随机地址的优势在于建立速度快,可以立即使用。然而,它的缺点是网址是随机生成,这个地址在24小时内会发生随机变化,更适合于临时使用。

如果有长期使用Anything LLM远程访问本地部署的DeepSeek等大模型,或者异地访问与使用其他本地部署的服务的需求,但又不想每天重新配置公网地址,还想让公网地址好看又好记并体验更多功能与更快的带宽,那我推荐大家选择使用固定的二级子域名方式来配置公网地址。

6. 配置固定公网地址

接下来演示如何为ollama服务配置固定的HTTP公网地址,该地址不会变化,方便分享给别人长期访问你部署的大模型,而无需每天重复修改服务器地址。

登录cpolar官网,点击左侧的预留,选择保留二级子域名,设置一个二级子域名名称,点击保留,保留成功后复制保留的二级子域名名称:

保留成功后复制保留成功的二级子域名的名称:myolds,大家也可以设置自己喜欢的名称。

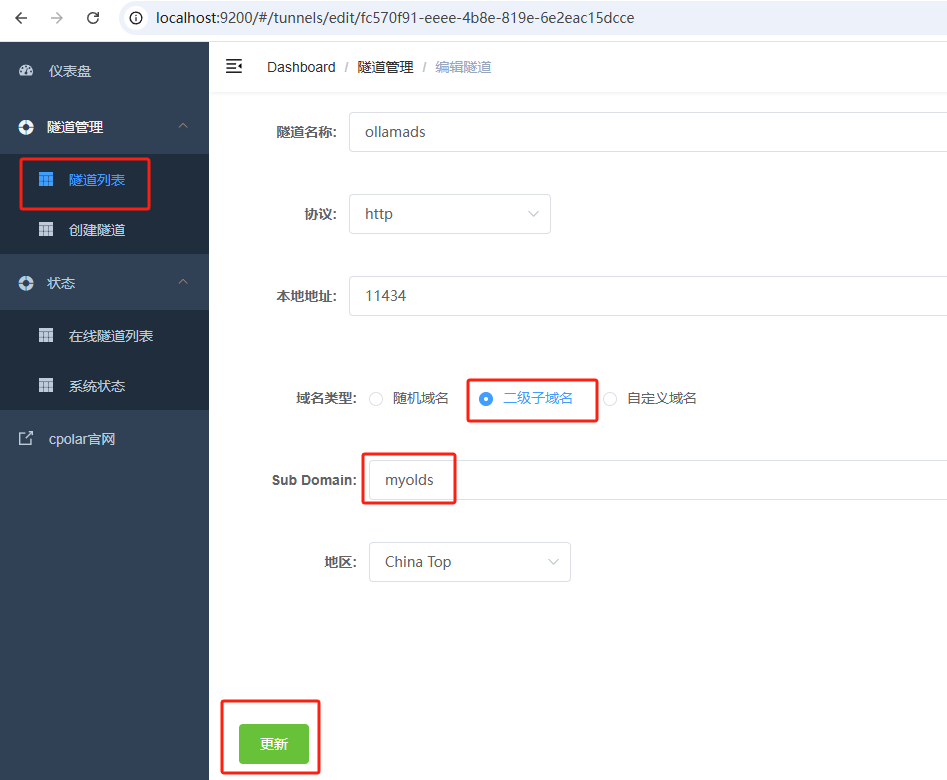

返回Cpolar web UI管理界面,点击左侧仪表盘的隧道管理------隧道列表,找到所要配置的隧道:ollamads,点击右侧的编辑:

修改隧道信息,将保留成功的二级子域名配置到隧道中

- 域名类型:选择二级子域名

- Sub Domain:填写保留成功的二级子域名:myolds

点击更新(注意,点击一次更新即可,不需要重复提交)

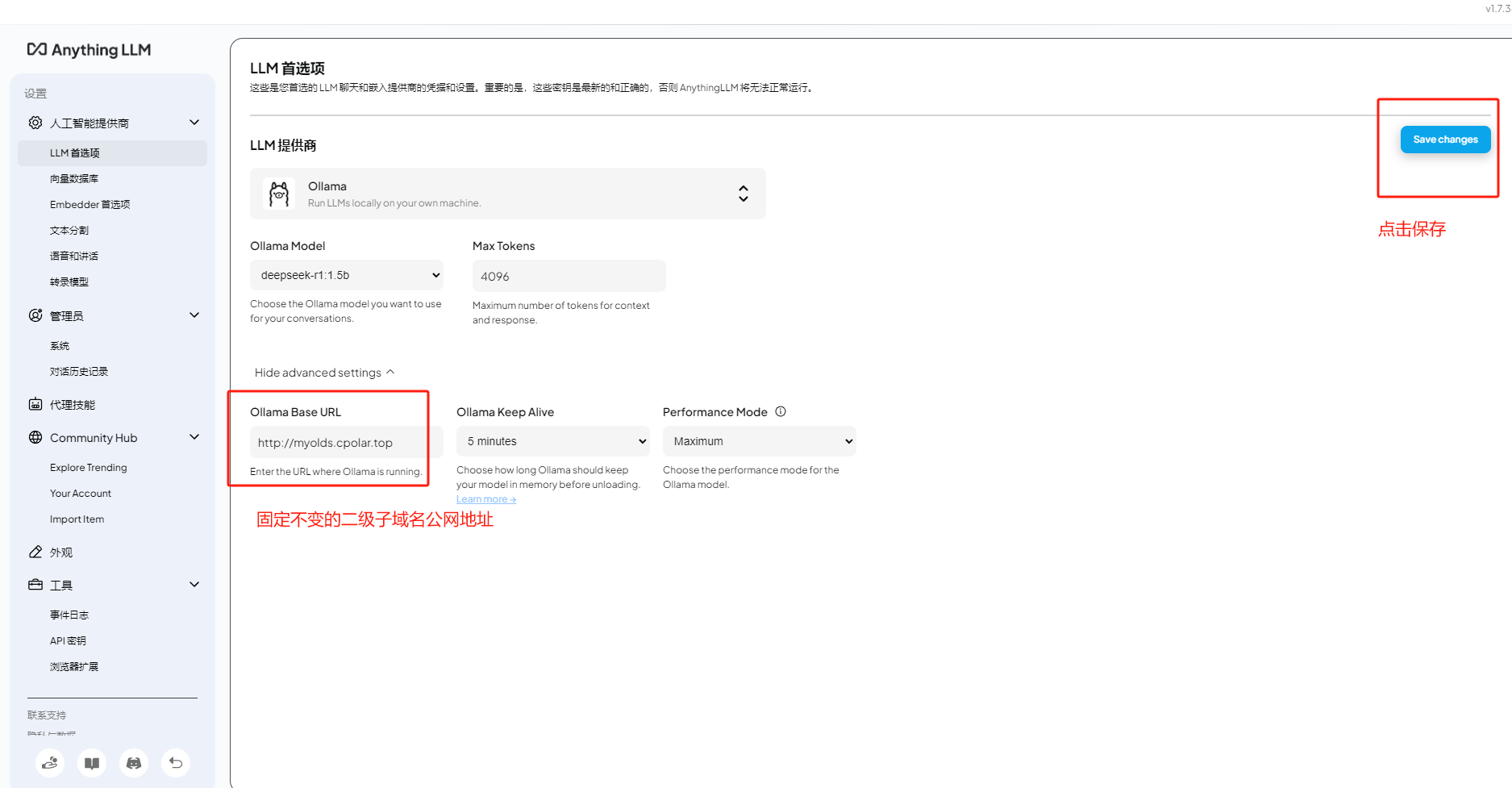

更新完成后,打开在线隧道列表,此时可以看到公网地址已经发生变化,地址名称也变成了固定的二级子域名名称的域名:

最后,我们在Anything LLM的设置界面中使用上面的任意一个固定的二级子域名公网地址替换刚才的随机公网地址,现在开始就不用每天都更换公网地址来远程访问本地部署的大模型了。

在人工智能技术持续演进的当下,您是否体验到智能工具触手可及的便捷性?基于Ollama技术架构的实施部署,结合DeepSeek R1算法模型的优化整合,配合Anything LLM交互系统的智能对话功能,以及cpolar工具实现的远程连接能力,您已掌握构建专属知识体系的完整技术路径。该解决方案不仅具备高效率的运作体系,更通过前沿技术的协同应用,展现出人工智能创新的全新维度。

当您准备开启技术实践时,建议立即启动操作手册中的实施步骤。在实施过程中遇到技术难题,可随时通过专家交流平台获取针对性解决方案。相信借助AI技术的深度整合,您将突破传统交互模式的限制,进入更智能化的数字协作新纪元。我们期待在创新工作坊中见证您的技术突破,共同探索人工智能应用的无限可能。