本文将会讲述什么是熵、交叉熵、相对熵。

文章目录

1.熵

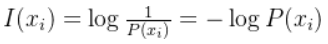

熵是衡量一个概率分布的随机程度,也可以说是其包含信息量的大小。用数学语言表达则是信息x出现不确定性的大小I(x)。其值越大说明包含的信息量越大,发生的概率越小。

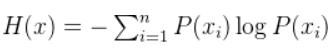

但是以上仅为单一信息量的求解方法,其实情况中,我们需要求一个多个信息的信息量,即平均信息量H(x),也叫信息熵。

2.交叉熵

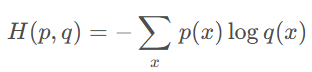

交叉熵是描述两个分布逼近的程度,交叉熵越大表示两个分布越可以近似,当两个分布相同时,交叉熵取得极小值。

3.相对熵(KL散度)

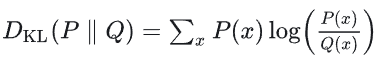

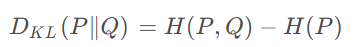

相对熵是描述两个分布之间的差异程度,相对熵越小表示两个分布之间的差异越小,当P和Q分布相同时,相对熵为0。

将交叉熵和信息熵的公式代入,相对熵可以表示为以下: