目录

三、最好的开源,是让你"开箱即用":开发者的福音CookBook

🎬 攻城狮7号 :个人主页

🔥 个人专栏 :《AI前沿技术要闻》

⛺️ 君子慎独!

🌈 大家好,欢迎来访我的博客!

⛳️ 此篇文章主要介绍 MiniCPM-V 4.0开源

📚 本期文章收录在《AI前沿技术要闻》,大家有兴趣可以自行查看!

⛺️ 欢迎各位 ✔️ 点赞 👍 收藏 ⭐留言 📝!

前言

**曾几何时,我们惊叹于云端AI那如同"天眼"般的视觉能力。**无论是识别万物、解读图表,还是理解复杂的场景,它们都无所不能。但这种强大,似乎总是隔着一层屏幕,需要稳定的网络、昂贵的服务器,以及我们对数据隐私的一丝担忧。

**我们不禁会想:什么时候,这种顶级的视觉智能,能够真正地、完全地属于我们自己?**不依赖网络,不上传数据,就安安静静地待在我们的手机里,成为我们口袋中一个无需联网、即用即有的"私人视觉专家"?

今天,这个梦想正在照进现实。

来自OpenBMB团队 (面壁智能与清华大学自然语言处理实验室联合发起)的最新开源力作------MiniCPM-V 4.0,正是一把开启这个未来的钥匙。它被誉为"手机上的GPT-4V",这并非一句夸张的宣传口号,而是对其能力与定位最精准的描述。

一、"小钢炮"的逆袭:4B参数如何比肩云端巨头?

在AI的世界里,"大"通常意味着"强"。动辄数千亿甚至万亿的参数量,似乎是通往更高智能的唯一途径。而MiniCPM-V 4.0却选择了一条截然不同的路------极致的"知识密度"。

它的参数量仅有40亿(4B),在巨无霸横行的AI领域,这个体量堪称"迷你"。然而,这门"小钢炮"的威力却足以让业界为之震动。

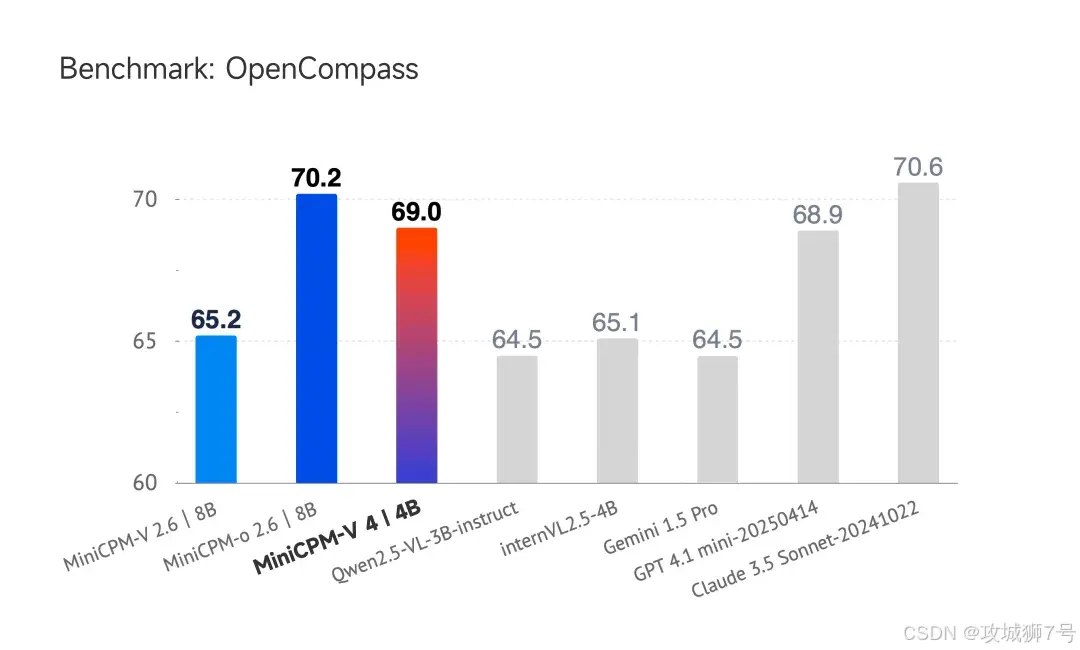

**在一系列国际公认的权威评测基准上(如OpenCompass),MiniCPM-V 4.0的表现堪称"屠榜"。**它的综合性能不仅超越了Qwen2.5-VL(3B)、InternVL2.5(4B)等同量级的竞争对手,甚至能够与云端大厂的明星模型GPT-4.1-mini、Claude 3.5 Sonnet一较高下。

更令人惊叹的是,相较于它自己的上一代8B模型,MiniCPM-V 4.0在参数量减半 的情况下,多模态能力反而实现了显著的飞跃。

这就像一位武林高手,他放弃了沉重的兵器,转而修炼内功,举手投足间,威力却更胜从前。MiniCPM-V 4.0用无可辩驳的实力证明了:**模型的智慧,不在于体型的庞大,而在于知识的精炼与浓缩。**它能从一张图片中读出更多的细节,从多张图片的关联中理清更复杂的逻辑,甚至能看懂视频的来龙去脉。

二、告别"暖手宝":为手机而生的极致效率

对于任何一个试图在手机上运行的AI模型来说,**性能跑分只是第一关,真正的考验在于实际的用户体验。**如果一个模型让你的手机变成"暖手宝",或者回答一个问题需要等待几十秒,那么再强大的能力也毫无意义。

而这,正是MiniCPM-V 4.0最闪耀的地方。它天生就是为"端侧"(即手机、平板、笔记本等个人设备)而生的效率之王。

面壁团队在最新的iPhone 16 Pro Max上进行的实测结果,足以说明一切:

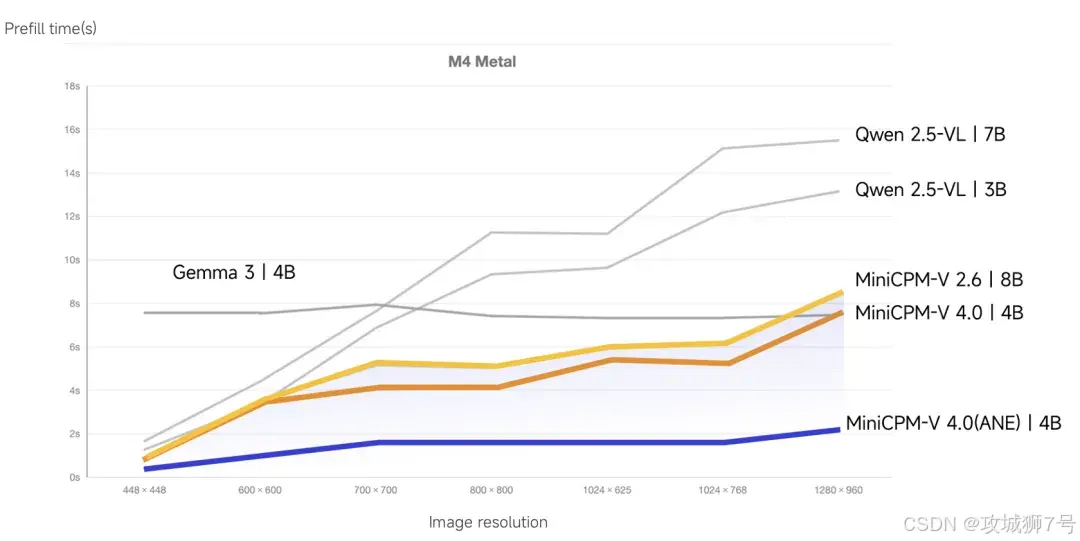

**(1)快如闪电的响应:**当你向它提问时,它的首次响应时间(可以理解为它"开口说话"的速度)不到2秒,随后以超过每秒17个字的速度流畅输出。这种"即问即答"的体验,与云端模型几乎没有差别。

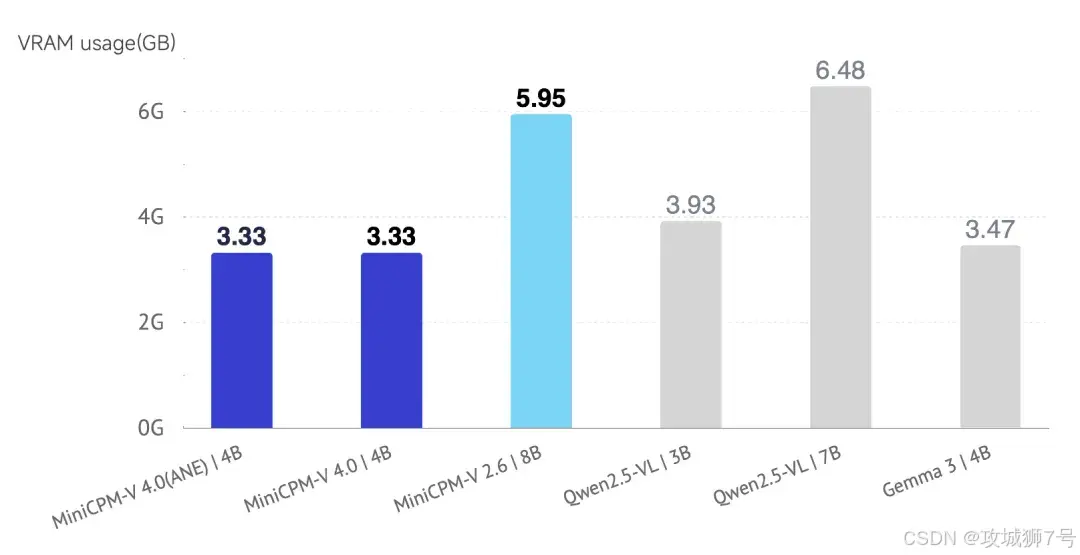

**(2)冷静沉着的运行:**得益于精巧的模型结构设计和极致的优化,它在运行时对手机显存的占用极低(在苹果M4芯片上仅需3.33GB),并且能够有效控制设备发热。这意味着你可以长时间、连续地使用它,而不用担心手机电量告急或烫得拿不住。

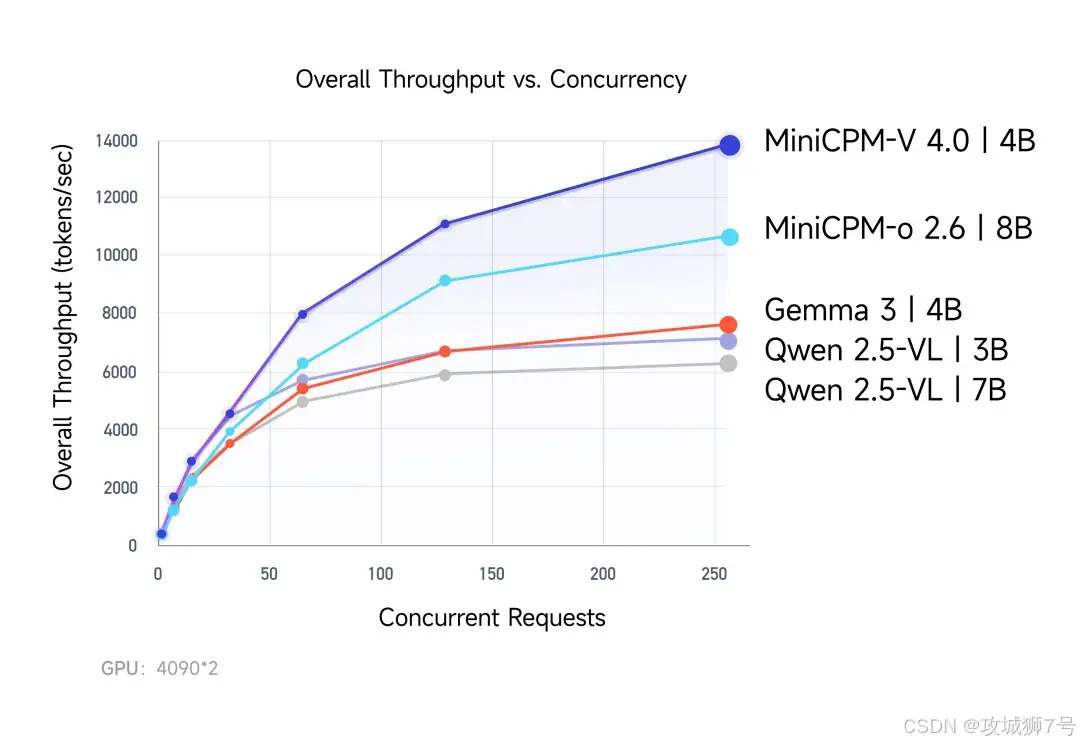

**(3)从容应对高并发:**在企业级的应用场景中,它同样表现出色。测试表明,在同等算力下,它处理高并发请求的能力(吞吐量)远超同类模型,能够稳定地为大量用户提供服务。

这些特性,让MiniCPM-V 4.0不再是一个只能在实验室里展示的"概念车",而是一辆真正可以开上日常道路,性能可靠、油耗经济的"家用超跑"。

三、最好的开源,是让你"开箱即用":开发者的福音CookBook

如果说强大的性能和极致的效率是MiniCPM-V 4.0的"硬实力",那么团队同步开源的**MiniCPM-V CookBook(可以理解为"烹饪指南"或"宝藏菜谱")**则是其最温暖人心的"软实力"。

一个项目最好的开源,不是仅仅把代码和模型扔出来,而是手把手地教会大家如何使用它,让每一个人都能轻松地将这道"珍馐"端上自己的餐桌。MiniCPM-V CookBook正是为此而生。

这份"菜谱"考虑到了几乎所有类型的开发者:

**(1)对于个人开发者和AI爱好者:**你想在自己的MacBook或Windows PC上体验一下?没问题。通过`llama.cpp`和`Ollama`这些流行的框架,你只需要几行简单的命令,就能在本地把模型跑起来,进行图像问答,体验AI的乐趣。

**(2)对于企业和创业公司:**你需要为成千上万的用户提供稳定、高效的视觉分析服务?没问题。CookBook里提供了与`vLLM`等顶级高并发服务框架的深度集成方案,让你轻松构建企业级的应用。

**(3)对于学术研究者和算法工程师:**你想在MiniCPM-V 4.0的基础上进行二次开发,验证自己的新想法?没问题。它完全兼容Hugging Face生态,你可以自由地进行微调、量化和各种实验。

更贴心的是,这份"菜谱"里还包含了:

**(1)一键启动的Web演示:**帮你快速搭建一个私有的Web服务,无论是做内部知识库还是产品原型,都极其方便。

**(2)多种量化方案:**内置了多种模型压缩技术,让本就轻巧的模型能被进一步优化,在资源更有限的设备上也能流畅运行。

**(3)完整的iOS App示例:**这可能是最直观、最给力的部分。团队直接提供了一个可以在iPhone和iPad上运行的App源码。这等于直接告诉你:"看,在手机上实现实时多模态交互,就是这么简单!"

结语:一个属于每个人的"视觉智能"时代

MiniCPM-V 4.0的发布,其意义远不止是又一个性能强大的开源模型。

**它是一次对"AI必须在云端"这一传统观念的有力挑战。**它证明了,通过精巧的设计和极致的优化,我们完全可以在个人设备上,实现媲美云端的智能体验。

**它是一份面向全球开发者的慷慨馈赠。**详尽的CookBook,展现了一种真正为社区着想的开源精神,极大地降低了前沿AI技术的落地门槛。

更重要的是,它为我们描绘了一个激动人心的未来:在这个未来里,强大的AI视觉能力不再是少数科技巨头的专利,而是像手机摄像头一样,成为每个人都能拥有和掌控的基础能力。你的手机不仅能"看见",更能"看懂"。它能帮你整理相册、识别路标、辅导作业、甚至成为视障人士的眼睛......而这一切,都可以在完全离线、绝对安全的环境下进行。

这,或许才是AI普惠化,最动人的模样。

Github:https://github.com/OpenBMB/MiniCPM-o

Hugging Face:https://huggingface.co/openbmb/MiniCPM-V-4

ModelScope:https://modelscope.cn/models/OpenBMB/MiniCPM-V-4

CookBook:https://github.com/OpenSQZ/MiniCPM-V-CookBook

看到这里了还不给博主点一个:

⛳️ 点赞☀️收藏 ⭐️ 关注!

💛 💙 💜 ❤️ 💚💓 💗 💕 💞 💘 💖

再次感谢大家的支持!

你们的点赞就是博主更新最大的动力!