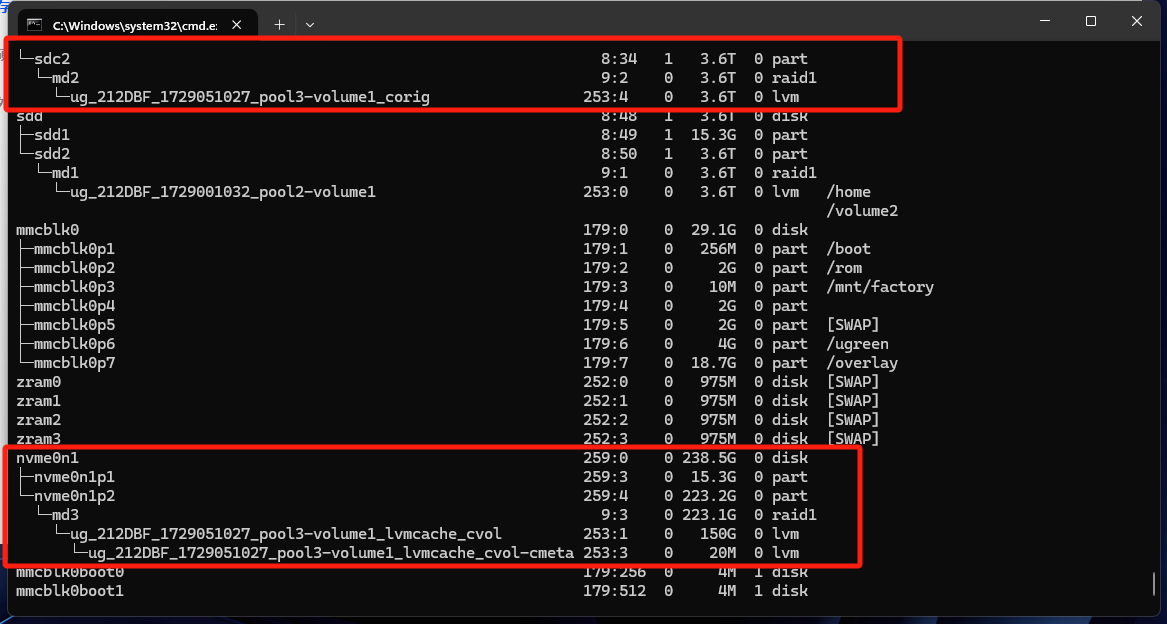

现象为:机械盘丢失cvol-cmeta卷

如图所示,lvm逻辑卷中缺失缓存的lvm,这边以只读cache为例

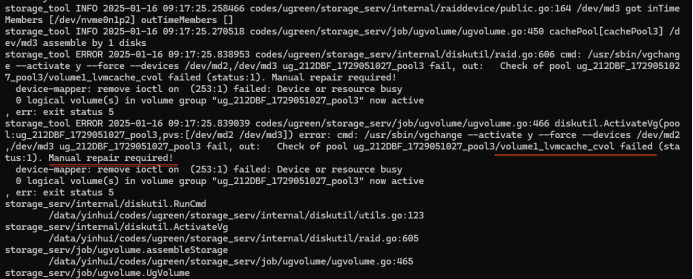

日志现象报错信息为:lvmcache_cvol failed manual repair required!

日志现象报错信息为:lvmcache_cvol failed manual repair required!

lvmcache_cvol failed: manual repair required! 这类报错,本质上是 LVM cache 池(cache-pool)的元数据或数据区域出现了损坏,导致 LVM 在激活卷组时自检失败。

根据社区大量案例和官方文档.常见成因可以归纳为以下 3 类:

缓存盘掉线或损坏

• 典型的 SSD 故障、RAID 卡掉盘、SATA/电源线接触不良等都会使 cache-pool 的 data LV 或 metadata LV 无法读取,从而触发自检错误 。

• 如果 cachemode 设为 writeback,缓存盘一旦离线,尚未写回的数据就会丢失,LVM 会拒绝激活逻辑卷 。

异常掉电/强制关机导致元数据不一致

• writeback 模式下,脏数据只存在于缓存盘,系统突然断电会使 cache metadata 与 origin LV 不同步,重启后自检报错 。

缓存池空间耗尽

• 当 SSD 使用率达到 100 %,新的写入无法分配缓存块,metadata 区域可能出现"非法指针",从而触发 thin_check / cache_check 失败 。

下面是修复的操作步骤方法:

操作步骤 一 :

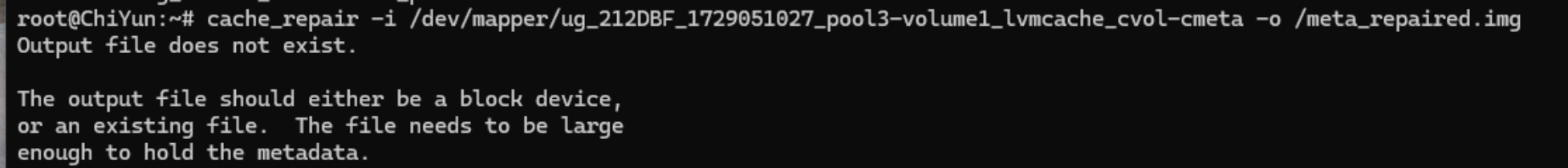

bash

cache_repair -i /dev/mapper/ug_212DBF_1729051027_pool3-volume1_lvmcache_cvol-cmeta -o /meta_repaired.img

#这条命令的作用是读取指定的损坏的缓存元数据文件(/dev/mapper/ug_212DBF_1729051027_pool3-volume1_lvmcache_cvol-cmeta),尝试对其进行修复,并将修复后的元数据保存到指定的输出文件(/meta_repaired.img)中。

PS:提示报错The output file should either be a block device是因为提示输入需要块设备才可以.这时候需要使用DD命令将ug_212DBF_1729051027_pool3-volume1_lvmcache_cvol-cmeta变为块设备

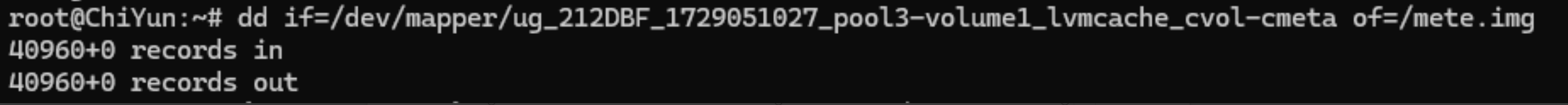

bash

dd if=/dev/mapper/ug_212DBF_1729051027_pool3-volume1_lvmcache_cvol-cmeta of=/meta.img 创建一个与

创建一个与 /meta.img 同大小的空文件 /meta_repaired.img

bash

cp /meta.img /meta_repaired.img再次执行修复缓存元数据的命令:

bash

cache_repair -i /meta.img -o /meta_repaired.img

cache_repair

#会读取损坏的元数据镜像,尝试修正内部指针、校验和等错误,生成一份 新的、尽量可用的元数据镜像。

-i /meta.img

#输入文件:损坏的 cache-pool 元数据卷

-o /meta_repaired.img

#输出文件:修复后的元数据镜像,之后可用来 替换原元数据卷。操作步骤 二 :

修复出来的元数据检查是否还存在损坏:

bash

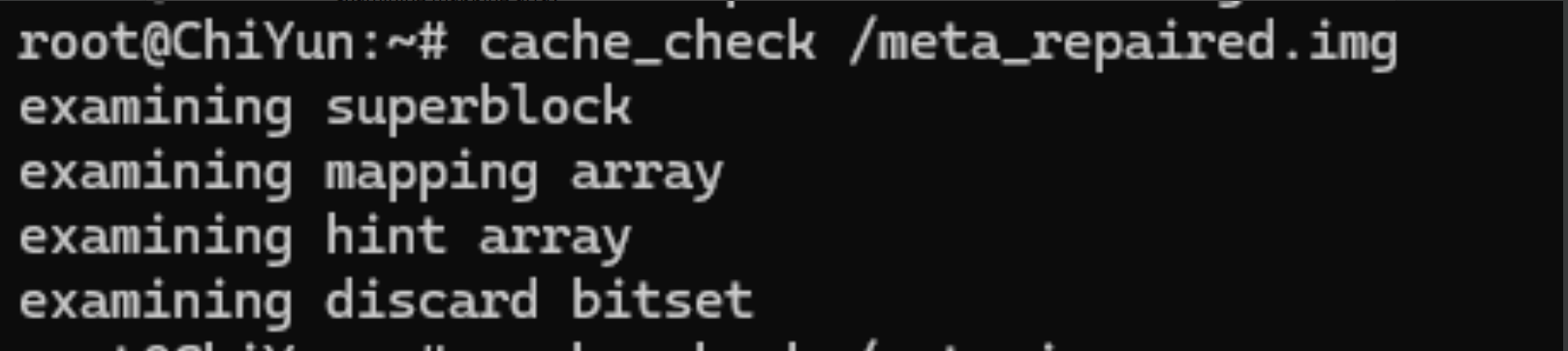

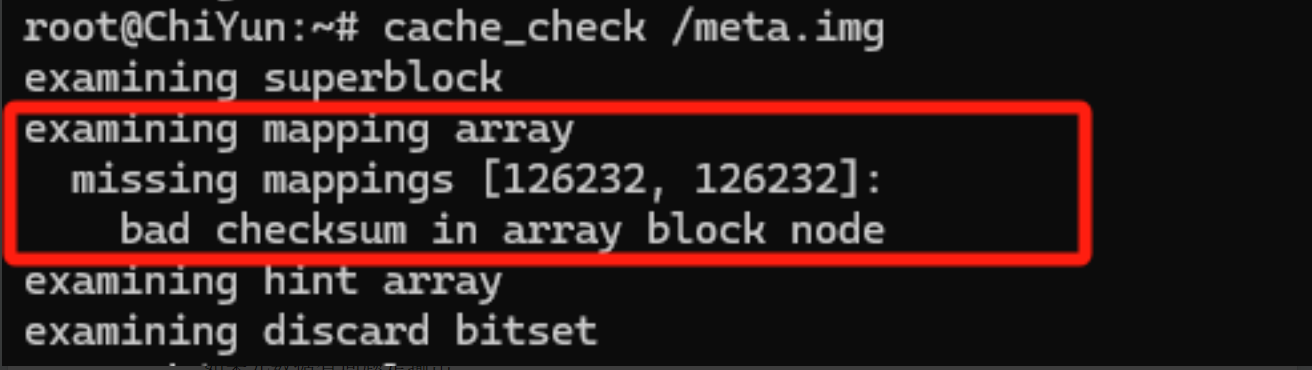

cache_check /meta_repaired.img正常现象是输出:

如果元数据有问题是输出:

操作步骤 三 :

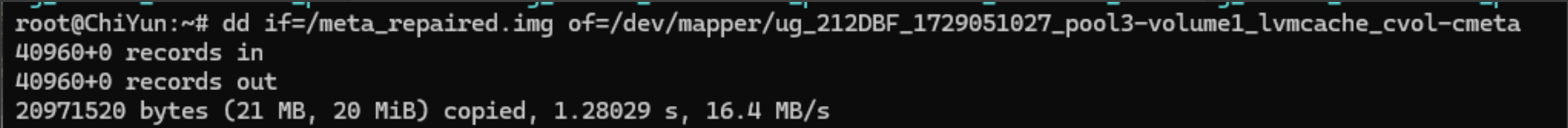

将修复回来的元数据覆盖到原来损坏的meta卷中:

bash

dd if=/meta_repaired.img of=/dev/mapper/ug_212DBF_1729051027_pool3-volume1_lvmcache_cvol-cmeta

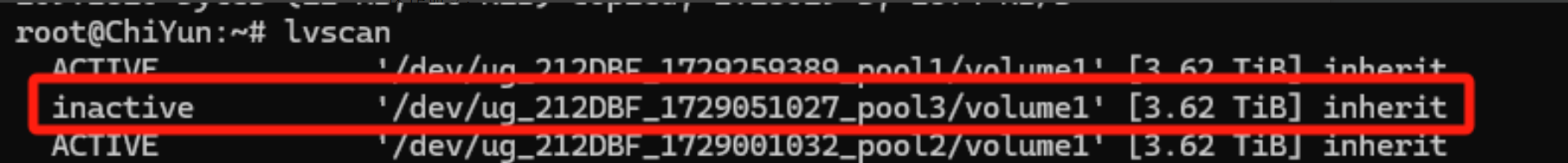

(1)检查:

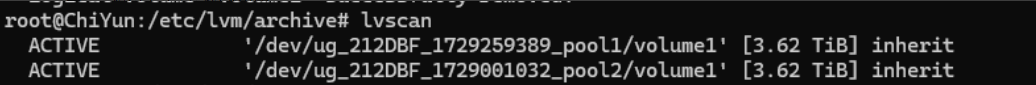

lvscan是否有出现pool3-volume1

(2)操作可能出现的报错:

bash

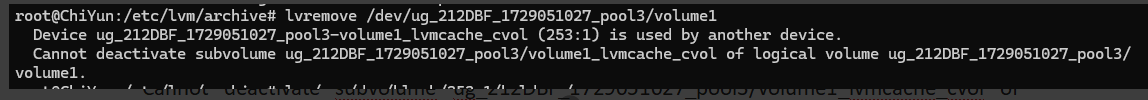

lvremove /dev/ug_212DBF_1729051027_pool3/volume1

#移除lv

PS:上面提示253:1被占用

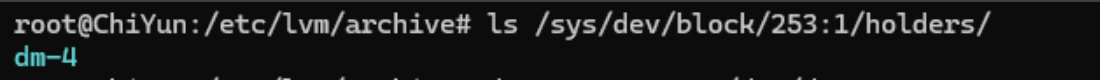

使用命令查看是被什么占用:

bash

ls /sys/dev/block/253:1/holders/

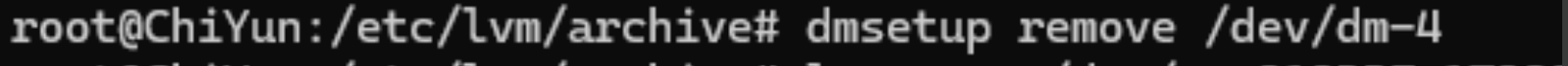

使用命令解除占用:

bash

dmsetup remove /dev/dm-4

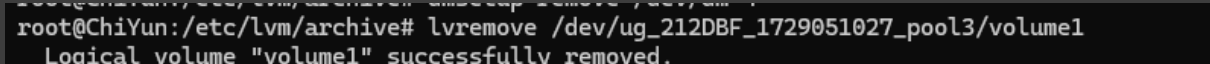

再移除使用命令移除:

bash

lvremove /dev/ug_212DBF_1729051027_pool3/volume1

检查是否被移除:

bash

lvscan

可以看到已经没有pool3了,说明已经被移除

操作步骤 四 :

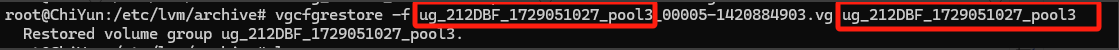

到****/etc/lvm/archive****找到带有cache缓存的备份卷恢复

使用命令恢复vg卷和lv卷:

bash

vgcfgrestore -f ug_212DBF_1729051027_pool3_00005-1420884903.vg ug_212DBF_1729051027_pool3

PS:需要grep筛选或vi进去查看找有cache信息的vg备份卷来进行恢复

恢复的时候,要恢复的卷组名称需要跟图示红框对应才可以.

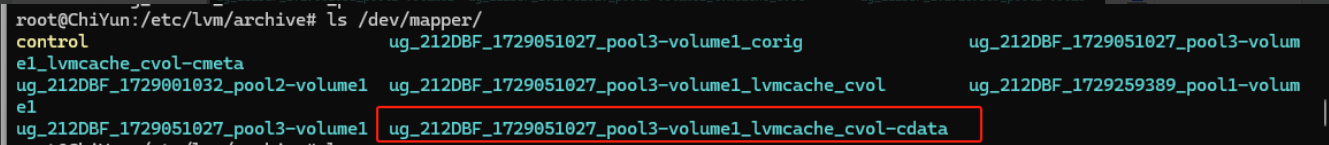

恢复以后进行激活卷组:

bash

lvchange -ay /dev/ug_212DBF_1729051027_pool3/volume1检查data卷是否有恢复出来:

bash

ls /dev/mapper/

最后尝试挂载data卷:

bash

mount /dev/ug_212DBF_1729051027_pool3/volume1 /volume3正常以后重启storage服务即可:

bash

systemctl restart storage_serv