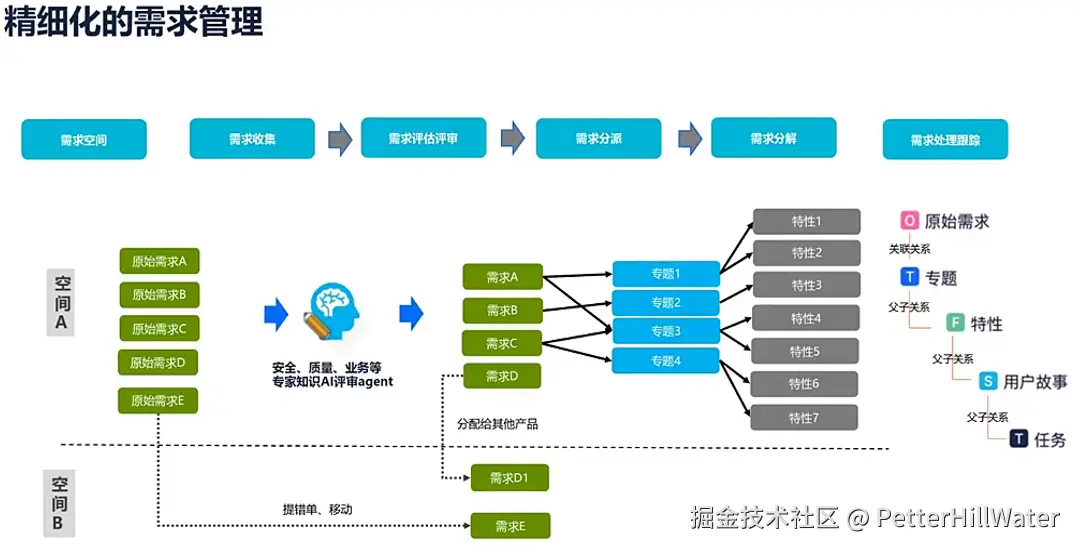

精细化需求管理

-

业务部门在需求管理中占据主导地位,严格收集并精细化管理甲方或客户的需求,确保与业务紧密相关。

-

如广告部门等业务单元能够根据客户强相关性,精细管理客户需求,为后续产品开发提供准确方向。

-

客户需求管理成熟后,转化为产品产研需求,通过不同层级如EPIC史诗级、特性、用户故事等,细化到具体开发任务。

-

需求处理虽复杂,但通过业务部门和技术部门的有效分离与协作,确保最终产品能精准满足客户需求。

-

整个需求管理流程,从原始需求到开发任务,体现了从宏观到微观、从抽象到具体的需求转化过程。

AI在软件研发管理中的应用

-

AI在项目管理中的应用,特别是在核心生产流程如需求管理、设计生成、编码辅助、测试用例生成及客户反馈智能收集等方面,显著提升了生产效率。

-

需求阶段,AI可辅助编写与评审,使需求更规范,尤其适用于严格需求管理,提升需求管理效率。

-

设计环节,AI能生成符合规范的设计,大幅提高设计效率,尤其在游戏和UI设计团队中应用广泛。

-

编码与测试阶段,AI辅助编码生成及代码评审,同时生成测试用例并评审,优化发布流程,确保产品质量。

-

度量与反馈,AI智能收集客户反馈,识别需求,辅助快速需求编写,实现需求闭环管理,提升产品迭代效率。

AI需求评审

-

定义需求评审的安全角色,整合安全专家知识,自动执行需求评审,识别并规范需求中的明显问题,提升需求质量。

-

引入质量专家与业务专家,通过AI方式记录企业内部专家知识,实现知识配置化,自动化需求评审流程,提高评审效率。

-

利用代码助手工具,如Qwen3-Coder,辅助工程开发,提升代码质量和开发效率,虽不详述,但强调其重要性。

-

通过专家知识的整合与自动化工具的应用,实现需求评审的专业化、规范化,减少人工错误,加速项目进程。

-

安全、质量与业务知识在需求评审中的关键作用,通过自动化配置与执行,提升整体项目管理与执行水平。

MCP集成与自动化

-

MCP在研发工具领域被广泛应用,通过MCP server连接各种工具,实现快速应用和效率提升,如代码提交、需求关联和工时记录等,减少传统操作步骤。

-

MCP方式连接研发管理、代码、构建、发布、运维等各类工具,以及业务系统、联通工具和制品库工具,形成一体化工具链。

-

通过MCP,可以实现代码提交时自动关联需求、记录工时,甚至根据编码时间自动提交公式,极大提升开发效率和流程自动化。

-

MCP在提效方面的应用,包括AI测试等场景,通过工具联动和流程优化,实现更高效的工作流程。

-

这种工具研究和MCP应用的结合,使得在研发领域的工作更加高效,减少手动操作,提升自动化水平和整体效率。

AI测试

-

AI测试过程中,首先生成测试模块,确保全面覆盖不同功能领域,为后续测试点的拆分和用例编写奠定基础。

-

通过AI技术拆分测试点,提高测试用例的场景覆盖度和准确性,从而提升测试效率和规范性。

-

利用AI进行测试用例的自动生成,确保用例的全面性和精准性,减少人工编写过程中的遗漏和错误。

-

AI评审机制可拦截基础能力不足的测试用例,进一步提升测试质量,确保每个用例的有效性和实用性。

-

采用AI辅助测试管理,不仅提高了测试效率,还规范了测试流程,使测试工作更加系统化和专业化。

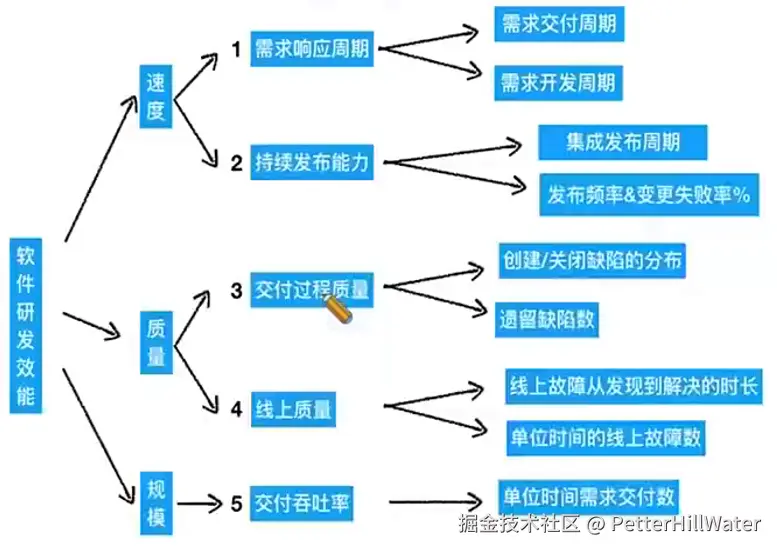

研发效能洞察

-

企业应首先基于现有数据配置基本研发指标,建立核心关注指标表盘,为AI提供建议奠定基础。

-

AI与企业自建指标系统相辅相成,AI可辅助发现未知风险,优化指标与团队,实现持续改进。

-

避免误区,即认为有了AI就不需要自建指标,强调AI应基于企业已有指标体系进行辅助分析。

-

强调通过AI进行风险识别与改进,持续优化企业指标与团队效能,实现研发策略的持续优化。

-

AI研究所的用处在于帮助企业建立并持续改进指标体系,同时利用AI技术辅助发现风险与优化策略。

绩效考核指标参考

1. 软件质量与稳定性

- Crash率:衡量软件在运行过程中崩溃的频率,是软件稳定性的直接体现。

- 单元测试有效性(变异测试) :通过修改代码中的某些部分来检查单元测试是否能够检测到这些变化,从而评估测试的有效性。

- 单测稳定性:确保单元测试在不同环境下的一致性和可靠性。

- 原始反馈处理率:反映团队对用户或内部测试反馈的响应速度和处理能力。

2. 测试自动化与覆盖率

- 全量用例自动化率:包括白盒和黑盒测试在内的所有测试用例实现自动化的比例,提高测试效率。

- 增量用例自动化率:针对新功能或代码变更部分的测试用例自动化程度,确保新增功能的质量。

- 全量自动化测试覆盖率:自动化测试覆盖的代码行数占总代码行数的比例,越高说明测试越全面。

- 增量自动化测试覆盖率:新添加或修改的代码被自动化测试覆盖的程度。

3. 开发效率与代码质量

- Leadtime平均值:从需求提出到功能上线的平均时间,反映开发流程的效率。

- 人均代码行数:每个开发人员平均编写的代码量,可以用来评估开发效率和工作量。

- 代码提交人数:参与代码提交的开发人员数量,了解团队的活跃度和协作情况。

- 千行Bug率:每千行代码中出现的错误数量,是代码质量的一个重要指标。

4. 缺陷管理与修复

- 千行Bug率:在同一时间段内发现的缺陷数量,可能反映开发过程中的问题集中爆发。

- ****千行bug的有效缺陷数:在千行发现的缺陷中,真正需要修复的有效缺陷数量。

- 已处理原始反馈数:已经解决的用户或内部测试反馈的数量,反映团队的问题解决能力。

- 线上缺陷漏出率:在产品上线后发现的缺陷占总缺陷的比例,反映测试阶段的遗漏情况。

5. 团队协作与资源分配

- 开发测试人员比例:开发人员与测试人员的比例,合理的比例有助于平衡开发和测试的工作量。

- 开发负责的新增自动化用例占比:开发人员参与编写自动化测试用例的比例,鼓励开发人员关注测试。

- 换包(含补丁)次数:软件更新或打补丁的频率,反映产品的维护和迭代速度。

- 等待耗时:在开发过程中因等待资源、环境等原因造成的非生产性时间,应尽量减少以提高效率。

6. 版本控制与分支管理

- 自动化测试分支覆盖率:自动化测试在不同分支上的覆盖情况,确保各分支的质量。

- 自动化测试稳定性:自动化测试在不同分支上的一致性和可靠性。

- 自动化用例漏出缺陷数:自动化测试未能发现的缺陷数量,反映测试策略的不足。

- 默认分支人均代码行数:默认分支上每个开发人员平均编写的代码量,评估主要开发线的效率。

度量仪表盘

-

度量效率与响应能力,包括上线周期实现和质量攻坚,通过建立专门板子如质量攻坚板,将问题如抑制增量、消除存量、上线质量把控等分块,形成作战板子,持续改进团队效果。

-

强调度量板子的可工作性,确保数据的实用性和有效性,作为持续改进的关键工具,通过查看数据板子,直观评估改进效果,实现迭代优化。

-

文化理念与价值观在团队实践中的融合,自下而上与自上而下的实践方法结合,推动团队发展。

-

AI实践在团队中的应用,提升工作效率和质量控制。

-

度量在团队实践中的重要性,不仅用于持续改进,还强调度量板子的实际操作性和数据的可工作性,确保度量结果的有效应用。

-

建立业务与技术部门间统一的需求标准和语言,确保需求评估准确无误,避免部门间扯皮。

-

统计需求数量、工时分配及项目进度,作为衡量团队工作效率和项目管理的关键指标。

-

监控需求响应周期和产品质量,特别是重大缺陷事故率,以提升服务质量和客户满意度。

-

定期汇报工程能力,如构建速度和代码编写效率,展示团队技术水平和行业竞争力。

-

引入持续改进指标,鼓励团队自主提出并优化指标体系,促进团队自我提升和指标体系的动态进化。

小结

1. 需求这块儿,业务部门是老大!

• 业务部门(比如搞广告的那帮人)得把客户想要啥摸得清清楚楚、管得明明白白,确保客户的需求和他们自己的活儿紧密挂钩。

• 客户的要求攒得差不多了,就该变成我们开发看得懂的活儿了。像那种大型目标(EPIC)、具体功能(特性)、再到小的开发任务(用户故事),一级一级拆开,越细越好。

• 这事儿看着复杂?不怕!业务部门和技术部门各干各的,配合好了就成。目标就一个:最后做出来的东西,必须是客户真正想要的。

• 说白了,就是把客户那笼统的想法,一步步变成程序员小哥能动手干的具体活儿。

2. AI这家伙,在我们干活儿中简直是个超级帮手!

• 你发现没?现在从客户要啥(需求),到画设计图(设计),写代码(编码),找bug(测试),还有看用户反应(反馈),AI都能帮上大忙,效率嗖嗖的!

• 想想要点啥功能(需求):AI能帮忙写更规范的需求文档,还帮着评审,特别适合管得严的项目。用户有啥不爽它也能智能抓取,省事儿!

• 画图做设计(设计):游戏和UI团队可爱用AI了!它能哗啦哗啦生成符合要求的设计稿,设计师小哥哥小姐姐能省不少力气。

• 敲代码和找bug(编码&测试):

◦ 写代码?有AI助手(比如Qwen3-Coder这种)帮写帮审。

◦ 找bug(测试)更神了:AI先把测试范围框出来,再拆出测试点,然后自动造出测试用例!还能检查写出来的测试用例靠不靠谱,拦下那些不太行的。这流程,又快又规范。

• 评审也更专业了:不用每次都把安全、质量专家本人薅过来,AI里面"录"好了他们的经验,自动看需求有没有毛病、合不合规范,出错少了,项目跑得快了。

3. 工具链,连起来用才痛快!

• 搞研发的谁不想流程顺点?现在都用MCP这种"研发工具大管家"把需要的工具(管项目的、写代码的、打包发布的、运维的、甚至业务系统)统统连起来!

• 这样搞好处大了!码农小哥提交代码时,动动手指就能关联需求、记录干活儿时间(有些甚至自动算!),省得来回切换系统,麻烦得要命。AI测试这种也搞得更溜了。

• 说白了,就是让工具们自己串通好,帮咱们打工仔少动手、少折腾,效率自然上去了。

4. 研发干得咋样?得看"数"说话!

• 公司首先得知道自己研发的"健康指标"是啥,搞个基本数据盘(像汽车仪表盘似的),这样AI也才好给建议。

• AI和大数据分析是好搭档:它能基于咱们自己的数据,帮忙发现那些"哎呀,没想到这也会有问题"的风险点,优化咱们的指标设置和团队效率。

• 可别想着有了AI就可以偷懒不做基础数据了!咱们自己必须得有套指标体系,AI才能更好地"辅助"分析。

• AI实验室最大的价值,就是帮咱们把这套度量体系建好、用活,不断发现风险、优化策略,让研发队伍越来越能打。

5. 绩效考核?参考下这些方面!

• 产品稳不稳、好不好用? 看老是崩溃不(Crash率)?单元测试给不给力?对大家的反馈处理得快不快?

• 自动测试覆盖全不全? 老功能(全量)新功能(增量)都用机器测的比例高不高?机器测试覆盖了多少代码?新加的代码测到了吗?

• 开发快不快、代码行不行? 一个需求从开始到上线平均多久(Leadtime)?人均写了多少行代码?多少人提交了代码?每千行代码里藏着多少bug?

• 抓bug管得怎么样? 发现了多少bug?里面真有价值的有多少?反馈解决了多少?测试漏过几个缺陷上到了线上(线上缺陷漏出率)?

• 团队配合顺不顺? 开发人员和测试人员的比例合不合理?开发人员写的自动测试用例多不多?更新版本(或打补丁)次数多不多?大家等资源、等别人回复浪费了多少时间?

• 分支和版本管好没? 自动测试有没有覆盖各个分支?测试结果稳不稳?自动测试漏掉了多少缺陷?主分支(默认分支)上人均写了多少代码?

6. 怎么看数据?拿个"作战地图"来!

• 真想提高效率、解决质量问题?搞个"质量攻坚作战板"之类的特别管用!把要解决的问题(比如别让新问题越来越多、干掉老问题、保证上线稳当)分门别类摆出来,盯着干!

• 数据看板不是摆着看的,得能用、能指导行动!用它来评估改进效果最直观了,这样才能持续进步。

• 团队讲究协同合作的文化也很重要,上头指导加上下头实践,大家一起使劲儿。

• AI也得用起来啊,帮大家省时省力还做得更好。

• 说白了,看数据是为了:

◦ 让大家劲儿往一处使:业务和技术部门对需求的理解和标准要一致,避免互相甩锅。

◦ 看清楚进度和人力:看看有多少需求在干,时间花哪了,项目进度到哪儿了,团队效率到底咋样?

◦ 关注响应速度和产品质量:客户需求多久能响应?上线后出没出过大事故?这些问题直接影响口碑。

◦ 秀秀技术实力:比如构建速度快不快、开发效率高不高,这些都是硬实力。

◦ 鼓励大家自己进步:让大家自己琢磨更好的数据指标,不断优化,这套东西也得是活的是吧!