模型无关元学习(MAML)在AI Agent快速适应中的应用研究

在人工智能(AI)领域,AI Agent的快速适应能力是衡量其智能程度的重要指标之一。传统的AI模型通常需要大量的训练数据才能够适应新环境,但随着问题的复杂性增加,这种方法往往效率低下且无法满足快速变化的需求。元学习(Meta-Learning)作为一种研究如何使模型能够"学习如何学习"的技术,为提升AI Agent的快速适应能力提供了新的思路。

本文将详细探讨元学习如何帮助AI Agent快速适应新任务,并通过代码实例来展示如何将其应用于实际问题。

元学习简介

元学习,也叫做"学习的学习",旨在让AI模型能够通过少量的数据,迅速适应新的任务。与传统的深度学习方法不同,元学习模型通过积累不同任务的经验,学会了如何从有限的示例中进行学习和推理。

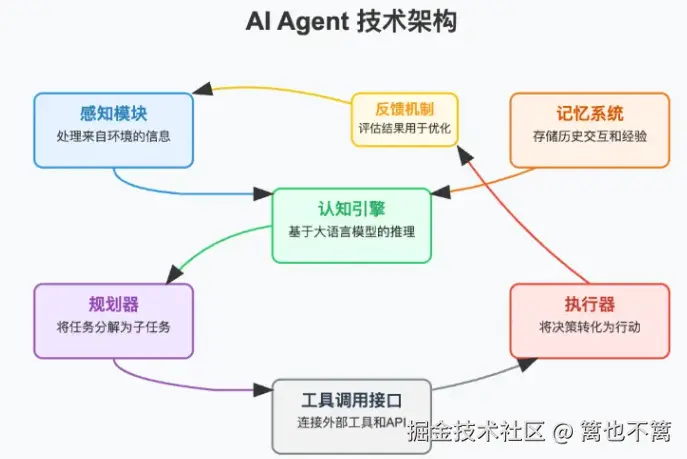

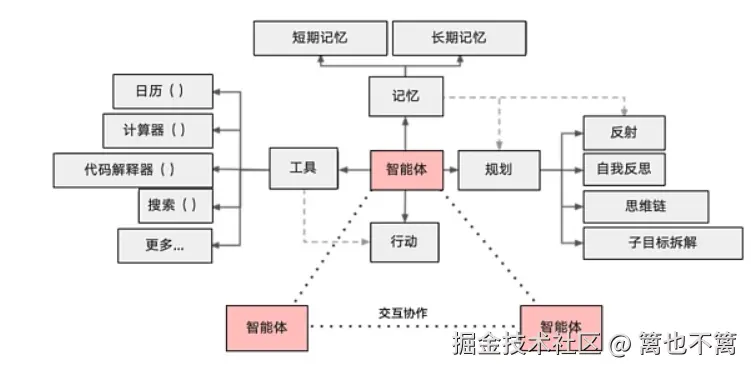

在元学习的框架下,AI Agent能够通过几次迭代,快速地调整自己的参数,适应新环境或新任务。常见的元学习算法有模型无关的元学习(MAML)、优化器学习(Learning to Learn)、记忆增强网络(Meta-RNN)等。

AI Agent的快速适应能力需求

随着AI在各个领域的应用,AI Agent必须具备快速适应能力。例如,在游戏环境中,AI Agent需要能够迅速从环境反馈中学习和调整策略;在自动驾驶系统中,AI Agent需要根据不同的驾驶场景迅速调整驾驶决策。这些都需要元学习技术的支持。

传统的训练方法往往依赖于大量的标注数据和反复的训练,而元学习通过在多个任务上训练模型,使其能够从少量数据中快速学习新任务。

元学习如何提升AI Agent的快速适应能力

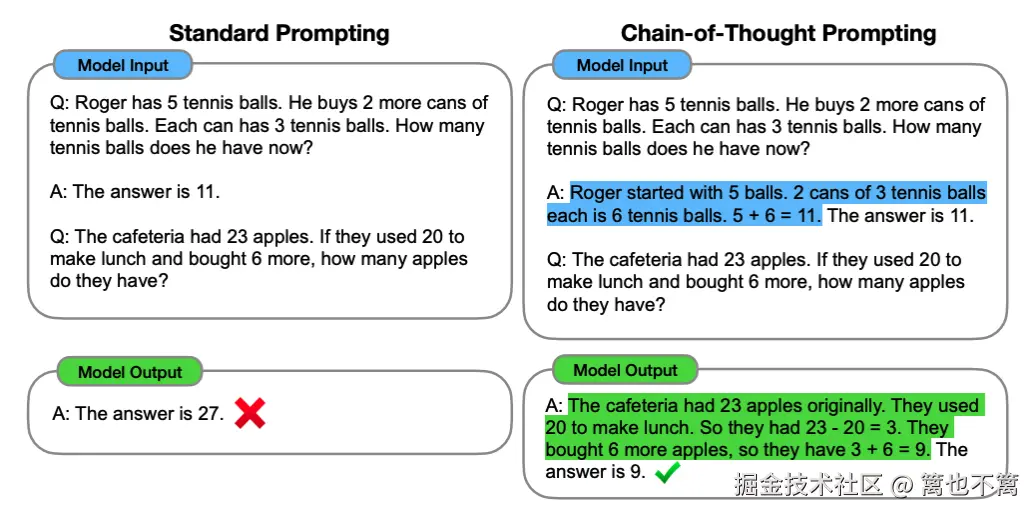

元学习的关键在于"训练"的方式。在传统深度学习中,AI模型通常需要大量的样本进行训练,并逐步优化参数。而在元学习中,AI模型通过在不同任务上的训练,学会如何通过少量的样本迅速调整自己的参数,从而达到在新任务上快速学习和适应的目的。

元学习通过引入"任务"的概念,使得AI模型不再是针对单一任务进行训练,而是通过多个任务的训练,使模型能够获得"元知识",从而提升其在新任务中的适应能力。

元学习算法:MAML(Model-Agnostic Meta-Learning)

模型无关元学习(MAML)是一种常用的元学习算法,它的核心思想是通过在多个任务上进行训练,使得模型能够通过少量的梯度更新来快速适应新任务。MAML通过在任务上计算梯度,并对模型进行更新,从而使得模型能够在面对新任务时,利用已有的经验进行快速调整。

MAML算法步骤

- 任务采样:从任务空间中随机选择一组任务。

- 内部训练:在每个任务上进行少量的梯度更新,使得模型在每个任务上能够快速调整。

- 外部更新:根据所有任务的表现,更新模型的参数,使得模型能够在新的任务上更好地进行快速适应。

代码实现:MAML在强化学习中的应用

以下是一个简单的MAML算法在强化学习任务中的实现:

python

import torch

import torch.nn as nn

import torch.optim as optim

from torch.autograd import Variable

class MLP(nn.Module):

def __init__(self):

super(MLP, self).__init__()

self.fc1 = nn.Linear(3, 32)

self.fc2 = nn.Linear(32, 2)

def forward(self, x):

x = torch.relu(self.fc1(x))

return self.fc2(x)

def maml_update(model, data, target, lr_inner=0.01):

criterion = nn.CrossEntropyLoss()

optimizer = optim.SGD(model.parameters(), lr=lr_inner)

optimizer.zero_grad()

output = model(data)

loss = criterion(output, target)

loss.backward()

optimizer.step()

return model, loss.item()

def meta_update(meta_model, models, data, targets, lr_outer=0.001):

criterion = nn.CrossEntropyLoss()

optimizer = optim.SGD(meta_model.parameters(), lr=lr_outer)

optimizer.zero_grad()

loss_total = 0

for model, (task_data, task_target) in zip(models, zip(data, targets)):

output = model(task_data)

loss = criterion(output, task_target)

loss_total += loss

loss_total.backward()

optimizer.step()

return meta_model, loss_total.item()

# 初始化元学习模型

meta_model = MLP()

tasks_data = [torch.randn(5, 3) for _ in range(3)] # 任务数据

tasks_targets = [torch.randint(0, 2, (5,)) for _ in range(3)] # 任务标签

# 模拟元学习过程

for epoch in range(10):

# 内部任务训练

models = []

for task_data, task_target in zip(tasks_data, tasks_targets):

model = MLP()

model, _ = maml_update(model, task_data, task_target)

models.append(model)

# 外部任务更新

meta_model, _ = meta_update(meta_model, models, tasks_data, tasks_targets)

print(f"Epoch {epoch+1} completed")解释:

- MLP模型:一个简单的多层感知机,用于分类任务。

- maml_update:在每个任务上进行内部训练,通过少量的梯度更新来调整模型参数。

- meta_update:根据任务的表现,进行外部参数更新,优化元学习模型。

元学习在AI Agent中的实际应用

自动驾驶系统

在自动驾驶领域,AI Agent需要在复杂且不断变化的环境中作出决策。元学习能够帮助AI Agent快速适应不同的驾驶情境,如天气变化、交通流量等。通过在多个驾驶场景上进行训练,AI Agent能够学会如何快速调整决策策略,确保在新环境下的安全性和可靠性。

游戏AI

在游戏AI中,AI Agent需要应对各种变化的对手和场景,快速适应新策略。通过元学习,游戏AI可以在极短的时间内,从新的游戏场景中学习有效的策略,并应用到实际游戏中。这使得AI能够在竞技类游戏中展现出更高的灵活性和智能。

元学习在AI Agent中的挑战与解决方案

尽管元学习能够显著提升AI Agent的快速适应能力,但在实际应用中,仍然面临着一些挑战,主要包括训练效率、任务的多样性以及如何有效处理不同任务之间的相关性等问题。为了解决这些问题,研究者们提出了多种优化方法和变种算法。

挑战一:训练效率

元学习通常需要在多个任务上进行训练,这使得训练过程变得十分复杂且时间消耗较大。尤其是对于任务空间较大的问题,训练时间可能会呈指数级增长。因此,提高训练效率成为元学习领域的一大挑战。

解决方案:任务选择与样本重用

为了提高训练效率,研究者们提出了任务选择和样本重用的方法。任务选择通过选择具有代表性的任务进行训练,避免了无意义的任务浪费时间。而样本重用则通过使用之前任务的训练样本来加速新任务的学习过程,从而减少每个任务的训练时间。

一种常用的技术是任务难度分级。任务被分为简单任务和复杂任务,元学习模型优先在简单任务上进行训练,逐步过渡到复杂任务。这种方式帮助AI Agent在有限时间内积累足够的经验,提高训练效率。

挑战二:任务多样性

现实中的任务往往具有高度的多样性。在某些情况下,任务之间的差异可能非常大,这会导致元学习模型很难从中获得通用的学习经验。因此,如何应对任务多样性并确保学习到的策略具有较强的泛化能力,是元学习中的又一挑战。

解决方案:自适应任务生成与多模态学习

一种常见的应对策略是使用自适应任务生成(Adaptive Task Generation)。在这种方法中,元学习模型会根据当前训练阶段的学习效果,动态调整任务生成策略,使得模型可以在不同阶段获得最适合的任务,从而促进学习效果的提升。

另外,多模态学习(Multi-modal Learning)也是解决任务多样性的有效手段。在多模态学习中,模型可以通过处理多种类型的数据(如图像、文本、声音等)来学习任务的不同方面,从而提高对复杂任务的适应能力。

挑战三:任务之间的相关性

任务之间的相关性也是元学习中的一个难题。在一些任务中,任务之间的相似度较高,模型可以直接从一个任务迁移到另一个任务;而在另一些任务中,任务之间的差异较大,模型需要从头开始学习,无法直接借用已有的经验。因此,如何有效处理任务之间的相关性是元学习中的重要问题。

解决方案:任务关联性学习与元网络

为了更好地捕捉任务之间的关系,任务关联性学习(Task Relation Learning)应运而生。通过引入任务间的关系信息,模型能够根据任务的相关性进行有针对性的调整,从而提高学习效率。

此外,元网络 (Meta-Networks)也被提出作为一种解决方案。元网络通过建立任务之间的关联网络,使得模型可以在训练过程中显式地考虑任务间的相似性和差异性。这种方法在处理复杂任务时表现出色,能够更好地捕捉任务间的依赖关系。

AI Agent在元学习中的优化策略

元学习技术虽然在提高AI Agent适应能力方面表现出色,但在不同应用场景下,依然需要进一步的优化和调试。为了进一步提升AI Agent在实际应用中的表现,以下几种优化策略被广泛应用:

自适应元学习算法

自适应元学习算法旨在根据AI Agent的学习进度、环境反馈以及任务特征,动态调整学习策略。通过在训练过程中不断调整学习率、梯度更新方式等超参数,AI Agent可以在任务中达到最佳的学习效果。

例如,Meta-SGD算法是一种自适应元学习方法,通过为每个任务学习一个任务特定的优化器,使得在面对不同任务时,优化过程可以更加灵活和高效。这种算法能够帮助AI Agent更快地适应环境中的变化,并且提高其泛化能力。

知识蒸馏与迁移学习

知识蒸馏和迁移学习作为两种有效的学习策略,在元学习中被广泛应用。知识蒸馏 通过将一个大模型的知识迁移到小模型中,使得小模型能够在保持性能的同时,减少训练的时间和计算量。而迁移学习则利用已有任务的知识,在新任务上进行微调,使得AI Agent能够快速适应新环境。

通过结合知识蒸馏与迁移学习,AI Agent能够在有限的样本和资源下进行高效学习,并且增强其在未知任务上的快速适应能力。

强化学习与元学习结合

将元学习与强化学习结合是提升AI Agent适应能力的另一个重要策略。强化学习使得AI Agent能够通过与环境的交互不断优化策略,而元学习则帮助其快速适应新的任务和环境。

例如,Meta-Reinforcement Learning(Meta-RL)是将元学习应用于强化学习的一种方法。在这种方法中,AI Agent通过在不同的任务环境中进行训练,学会如何快速调整自己的策略,从而在面对新的环境时,能够迅速适应并优化行为。

元学习应用案例:机器人控制系统

在机器人控制系统中,AI Agent需要能够快速适应不同的操作任务,例如路径规划、抓取与放置、环境感知等任务。通过应用元学习,机器人可以在多任务学习过程中,积累对不同操作的经验,并通过少量数据快速调整行为策略。

例如,研究者通过将MAML算法应用于机器人控制中,使机器人能够在不同的物体抓取任务中,基于有限的示例迅速调整控制策略。这一方法显著提升了机器人的学习效率和适应能力,使其能够在实际应用中表现得更加智能和高效。

总结

元学习为提升AI Agent的快速适应能力提供了一种有效的方法。通过在多个任务上训练,AI Agent可以积累"元知识",并通过少量的训练样本快速适应新任务。这一技术在自动驾驶、游戏AI等领域具有广泛的应用前景。通过MAML等算法,AI Agent能够更高效地进行任务迁移和快速学习,从而提升其在动态环境中的表现和智能化水平。