文章目录

- torch.sparse

-

- 稀疏化的适用场景与优势

- 功能概述

- 算子概述

- 稀疏半结构化张量

-

- 构建稀疏半结构化张量

- 稀疏半结构化张量运算

- [加速半结构化稀疏的 nn.Linear](#加速半结构化稀疏的 nn.Linear)

- 稀疏COO张量

- 稀疏压缩张量

- 支持的操作

- torch.Storage

- torch.testing

- torch.utils

- [基准测试工具 - torch.utils.benchmark](#基准测试工具 - torch.utils.benchmark)

- torch.utils.bottleneck

- torch.utils.checkpoint

- torch.utils.cpp_extension

- torch.utils.data

-

- 数据集类型

- 数据加载顺序与采样器

- 加载批处理与非批处理数据

-

- 自动批处理(默认情况)

- 禁用自动批处理

- [使用 `collate_fn`](#使用

collate_fn)

- 单进程与多进程数据加载

- 内存固定

- torch.utils.deterministic

- torch.utils.dlpack

- torch.utils.mobile_optimizer

- torch.utils.model_zoo

torch.sparse

https://docs.pytorch.org/docs/stable/sparse.html

警告:PyTorch 的稀疏张量 API 目前处于测试阶段,近期可能会发生变化。

我们非常欢迎通过 GitHub issues 提交功能请求、错误报告和一般性建议。

稀疏化的适用场景与优势

默认情况下,PyTorch会将torch.Tensor元素以连续方式存储在物理内存中。这种存储方式能高效支持需要快速访问元素的各类数组处理算法实现。

但某些场景下,用户可能选择用大部分元素为零值的张量来表示数据,例如图邻接矩阵、剪枝后的权重或点云数据。我们认识到这些应用的重要性,旨在通过稀疏存储格式为这类用例提供性能优化。

业界已发展出多种稀疏存储格式,如COO、CSR/CSC、半结构化、LIL等。虽然具体布局方式不同,但它们都通过高效表示零值元素来实现数据压缩。我们将未压缩的值称为显式值 ,以区别于被压缩的隐式值。通过压缩重复的零值,稀疏存储格式能节省CPU和GPU的内存与计算资源。特别是在高稀疏度或高度结构化稀疏场景下,这可能带来显著的性能提升。因此,稀疏存储格式可视为一种性能优化手段。

与其他性能优化技术类似,稀疏存储格式并非总是有利。实际测试中,您可能会发现执行时间不降反增。

如果您通过理论分析预期应获得显著性能提升,但实测结果却出现性能下降,欢迎提交GitHub issue。这将帮助我们优先实现高效内核和更广泛的性能优化。

我们提供了便捷的方式来尝试不同稀疏布局,并支持格式间转换,而不会对特定应用场景预设最优方案。

功能概述

我们希望通过为每种布局提供转换例程,能够轻松地从给定的稠密张量构建稀疏张量。

在接下来的示例中,我们将一个默认稠密(跨步)布局的二维张量转换为由COO内存布局支持的二维张量。在这种情况下,仅存储非零元素的值和索引。

python

>>> a = torch.tensor([[0, 2.], [3, 0]])

>>> a.to_sparse()

tensor(indices=tensor([[0, 1], [1, 0]]), values=tensor([2., 3.]), size=(2, 2), nnz=2, layout=torch.sparse_coo)PyTorch 目前支持 COO、CSR、CSC、BSR 和 BSC 稀疏格式。

我们还提供了支持 :ref: 半结构化稀疏 的原型实现。

更多详情请参阅相关文档。

请注意,我们对这些格式进行了轻微泛化。

批处理:GPU 等设备需要批处理才能获得最佳性能,因此我们支持批处理维度。

当前我们提供了一种非常简单的批处理方式,即稀疏格式的每个组件本身都进行批处理。这要求每个批次条目具有相同数量的指定元素。

在这个示例中,我们从 3D 密集张量构建了一个 3D(批处理)CSR 张量。

python

>>> t = torch.tensor([[[1., 0], [2., 3.]], [[4., 0], [5., 6.]]])

>>> t.dim()

3

>>> t.to_sparse_csr()

tensor(crow_indices=tensor([[0, 1, 3], [0, 1, 3]]), col_indices=tensor([[0, 0, 1], [0, 0, 1]]), values=tensor([[1., 2., 3.], [4., 5., 6.]]), size=(2, 2, 2), nnz=3, layout=torch.sparse_csr)稠密维度:另一方面,像图嵌入这样的数据更适合被视为向量的稀疏集合,而非标量。

在这个示例中,我们从一个3D跨步张量创建了一个具有2个稀疏维度和1个稠密维度的3D混合COO张量。如果3D跨步张量中的整行都为零,则不会存储该行。但如果行中有任何非零值,则会完整存储整行。这种方式减少了索引数量,因为我们只需要每行一个索引,而非每个元素一个索引。但同时也增加了值的存储量,因为只有完全为零的行才能被省略,而任何非零元素的存在都会导致整行被存储。

python

>>> t = torch.tensor([[[0., 0], [1., 2.]], [[0., 0], [3., 4.]]])

>>> t.to_sparse(sparse_dim=2)

tensor(indices=tensor([[0, 1], [1, 1]]),

values=tensor([[1., 2.], [3., 4.]]),

size=(2, 2, 2), nnz=2,

layout=torch.sparse_coo)算子概述

从根本上说,采用稀疏存储格式的 Tensor 运算与采用跨步(或其他)存储格式的 Tensor 运算行为一致。存储的特殊性(即数据的物理布局)会影响运算性能,但不应该影响运算语义。

我们正在积极扩展稀疏张量的算子覆盖范围。但目前用户不应期望获得与稠密张量相同级别的支持。具体支持算子列表请参阅我们的算子文档。

python

>>> b = torch.tensor([[0, 0, 1, 2, 3, 0], [4, 5, 0, 6, 0, 0]])

>>> b_s = b.to_sparse_csr()

>>> b_s.cos()

Traceback (most recent call last):

File "<stdin>", line 1, in <module>

RuntimeError: unsupported tensor layout: SparseCsr

>>> b_s.sin()

tensor(crow_indices=tensor([0, 3, 6]), col_indices=tensor([2, 3, 4, 0, 1, 3]), values=tensor([0.8415, 0.9093, 0.1411, -0.7568, -0.9589, -0.2794]), size=(2, 6), nnz=6, layout=torch.sparse_csr)如上述示例所示,我们不支持非零保留的一元运算符(如cos)。非零保留一元运算的输出无法像输入那样充分利用稀疏存储格式的优势,可能导致内存使用量灾难性增长。

因此,我们建议用户先显式转换为稠密张量(dense Tensor),然后再执行运算。

python

>>> b_s.to_dense().cos()

tensor([[1.0000, -0.4161], [-0.9900, 1.0000]])我们注意到部分用户希望在诸如余弦(cos)等运算中忽略压缩零值,而非严格保持运算的原始语义。为此,我们可以推荐使用 torch.masked 及其 MaskedTensor,该功能同样由稀疏存储格式和计算内核提供支持。

还需注意的是,目前用户无法自主选择输出布局。例如,将稀疏张量与常规步幅张量相加时,结果会转为步幅张量。部分用户可能更希望保持稀疏布局,因为他们预知运算结果仍会保持足够的稀疏性。

python

>>> a + b.to_sparse()

tensor([[0., 3.], [3., 0.]])我们认识到,能够高效生成不同输出布局的内核访问非常有用。后续操作可能会因接收特定布局而显著受益。我们正在开发一个API来控制结果布局,并意识到这是规划任何给定模型更优执行路径的重要功能。

稀疏半结构化张量

警告:稀疏半结构化张量目前是原型功能,可能会发生变化。如果发现错误或有任何反馈,欢迎提交问题报告。

半结构化稀疏是一种稀疏数据布局,最初由NVIDIA的Ampere架构引入。它也被称为细粒度结构化稀疏 或2:4结构化稀疏。

这种稀疏布局存储每2n个元素中的n个元素,其中n由张量数据类型(dtype)的宽度决定。最常用的dtype是float16,此时n=2,因此称为"2:4结构化稀疏"。

关于半结构化稀疏的更详细说明,请参阅NVIDIA的这篇博客文章。

在PyTorch中,半结构化稀疏通过张量子类实现。通过子类化,我们可以重写__torch_dispatch__,从而在执行矩阵乘法时使用更快的稀疏内核。我们还可以在子类中以压缩形式存储张量,以减少内存开销。

在这种压缩形式中,稀疏张量仅存储指定的元素和一些编码掩码的元数据。

注意:半结构化稀疏张量的指定元素和元数据掩码一起存储在一个扁平压缩张量中。它们相互追加形成一个连续的内存块。

压缩张量 = [原始张量的指定元素 | 元数据掩码]

对于大小为(r, c)的原始张量,前m * k // 2个元素是保留的元素,张量的其余部分是元数据。

为了方便用户查看指定元素和掩码,可以使用.indices()和.values()分别访问掩码和指定元素:

.values()返回指定元素,形成一个大小为(r, c//2)的张量,且与密集矩阵具有相同的dtype.indices()返回元数据掩码,形成一个大小为(r, c//2)的张量,元素类型为torch.int16(当dtype是torch.float16或torch.bfloat16时)或torch.int32(当dtype是torch.int8时)

对于2:4稀疏张量,元数据开销很小------每个指定元素只需2比特。

注意:需要特别注意的是,torch.float32仅支持1:2稀疏度,因此不遵循上述相同的公式。

下面我们分解计算2:4稀疏张量的压缩比(密集大小/稀疏大小):

设(r, c) = tensor.shape,e = bitwidth(tensor.dtype),因此对于torch.float16和torch.bfloat16,e=16;对于torch.int8,e=8。

M d e n s e = r × c × e M s p a r s e = M s p e c i f i e d + M m e t a d a t a = r × c 2 × e + r × c 2 × 2 = r c e 2 + r c = r c e ( 1 2 + 1 e ) M_{dense} = r \times c \times e \\ M_{sparse} = M_{specified} + M_{metadata} = r \times \frac{c}{2} \times e + r \times \frac{c}{2} \times 2 = \frac{rce}{2} + rc =rce(\frac{1}{2} +\frac{1}{e}) Mdense=r×c×eMsparse=Mspecified+Mmetadata=r×2c×e+r×2c×2=2rce+rc=rce(21+e1)

通过这些计算,我们可以确定原始密集表示和新稀疏表示的总内存占用。

这给出了一个简单的压缩比公式,该公式仅依赖于张量数据类型的位宽:

C = M s p a r s e M d e n s e = 1 2 + 1 e C = \frac{M_{sparse}}{M_{dense}} = \frac{1}{2} + \frac{1}{e} C=MdenseMsparse=21+e1

使用这个公式,我们发现对于torch.float16或torch.bfloat16,压缩比为56.25%;对于torch.int8,压缩比为62.5%。

构建稀疏半结构化张量

只需使用 torch.to_sparse_semi_structured 函数,即可将密集张量转换为稀疏半结构化张量。

请注意,由于半结构化稀疏性仅支持 NVIDIA GPU 的硬件兼容性,因此我们仅支持 CUDA 张量。

以下是支持半结构化稀疏性的数据类型。注意每种数据类型都有其特定的形状约束和压缩因子。

| PyTorch 数据类型 | 形状约束 | 压缩因子 | 稀疏模式 |

|---|---|---|---|

torch.float16 |

张量必须为 2D,且 (r, c) 必须均为 64 的正整数倍 | 9/16 | 2:4 |

torch.bfloat16 |

张量必须为 2D,且 (r, c) 必须均为 64 的正整数倍 | 9/16 | 2:4 |

torch.int8 |

张量必须为 2D,且 (r, c) 必须均为 128 的正整数倍 | 10/16 | 2:4 |

要构建半结构化稀疏张量,首先需要创建一个符合 2:4(或半结构化)稀疏格式的常规密集张量。为此,我们可以平铺一个小的 1x4 条带,生成一个 16x16 的密集 float16 张量。之后,调用 to_sparse_semi_structured 函数对其进行压缩,以加速推理。

python

>>> from torch.sparse import to_sparse_semi_structured

>>> A = torch.Tensor([0, 0, 1, 1]).tile((128, 32)).half().cuda()

tensor([[0., 0., 1., ..., 0., 1., 1.],

[0., 0., 1., ..., 0., 1., 1.],

[0., 0., 1., ..., 0., 1., 1.],

...,

[0., 0., 1., ..., 0., 1., 1.],

[0., 0., 1., ..., 0., 1., 1.],

[0., 0., 1., ..., 0., 1., 1.]], device='cuda:0', dtype=torch.float16)

>>> A_sparse = to_sparse_semi_structured(A)

SparseSemiStructuredTensor(shape=torch.Size([128, 128]), transposed=False, values=tensor([[1., 1., 1., ..., 1., 1., 1.],

[1., 1., 1., ..., 1., 1., 1.],

[1., 1., 1., ..., 1., 1., 1.],

...,

[1., 1., 1., ..., 1., 1., 1.],

[1., 1., 1., ..., 1., 1., 1.],

[1., 1., 1., ..., 1., 1., 1.]], device='cuda:0', dtype=torch.float16), metadata=tensor([[-4370, -4370, -4370, ..., -4370, -4370, -4370],

[-4370, -4370, -4370, ..., -4370, -4370, -4370],

[-4370, -4370, -4370, ..., -4370, -4370, -4370],

...,

[-4370, -4370, -4370, ..., -4370, -4370, -4370],

[-4370, -4370, -4370, ..., -4370, -4370, -4370],

[-4370, -4370, -4370, ..., -4370, -4370, -4370]], device='cuda:0',

dtype=torch.int16))稀疏半结构化张量运算

目前支持对半结构化稀疏张量进行以下运算:

- torch.addmm(bias, dense, sparse.t())

- torch.mm(dense, sparse)

- torch.mm(sparse, dense)

- aten.linear.default(dense, sparse, bias)

- aten.t.default(sparse)

- aten.t.detach(sparse)

要使用这些运算,只需在张量已转换为半结构化稀疏格式(包含0值)后,传入to_sparse_semi_structured(tensor)的输出结果替代原始tensor即可,示例如下:

python

>>> a = torch.Tensor([0, 0, 1, 1]).tile((64, 16)).half().cuda()

>>> b = torch.rand(64, 64).half().cuda()

>>> c = torch.mm(a, b)

>>> a_sparse = to_sparse_semi_structured(a)

>>> torch.allclose(c, torch.mm(a_sparse, b))

True加速半结构化稀疏的 nn.Linear

只需几行代码,如果权重已经是半结构化稀疏的,就可以加速模型中的线性层:

python

>>> input = torch.rand(64, 64).half().cuda()

>>> mask = torch.Tensor([0, 0, 1, 1]).tile((64, 16)).cuda().bool()

>>> linear = nn.Linear(64, 64).half().cuda()

>>> linear.weight = nn.Parameter(to_sparse_semi_structured(linear.weight.masked_fill(~mask, 0)))稀疏COO张量

PyTorch实现了所谓的坐标格式(COO格式),作为实现稀疏张量的存储格式之一。在COO格式中,指定的元素以索引元组和对应值的形式存储。具体来说:

- 指定元素的索引收集在大小为

(ndim, nse)、元素类型为torch.int64的indices张量中 - 对应的值收集在大小为

(nse,)、元素类型为任意整数或浮点数的values张量中

其中ndim是张量的维度数,nse是指定元素的数量。

注意:稀疏COO张量的内存消耗至少为(ndim * 8 + <元素类型字节大小>) * nse字节(加上存储其他张量数据的固定开销)。

而跨步张量的内存消耗至少为product(<张量形状>) * <元素类型字节大小>。

例如,一个10,000×10,000大小、包含100,000个非零32位浮点数的张量,使用COO张量布局时内存消耗至少为(2 * 8 + 4) * 100 000 = 2 000 000字节,而使用默认跨步张量布局时为10 000 * 10 000 * 4 = 400 000 000字节。可见使用COO存储格式可节省200倍内存。

构造方式

可以通过向 torch.sparse_coo_tensor() 函数提供索引张量、值张量以及稀疏张量的尺寸(当无法从索引和值张量推断时)来构建一个稀疏COO张量。

假设我们需要定义一个稀疏张量,其中位置(0,2)处值为3,位置(1,0)处值为4,位置(1,2)处值为5。未指定的元素默认采用相同的填充值(默认为零),此时可以这样编写代码:

python

>>> i = [[0, 1, 1], [2, 0, 2]]

>>> v = [3, 4, 5]

>>> s = torch.sparse_coo_tensor(i, v, (2, 3))

>>> s

tensor(indices=tensor([[0, 1, 1], [2, 0, 2]]), values=tensor([3, 4, 5]), size=(2, 3), nnz=3, layout=torch.sparse_coo)

>>> s.to_dense()

tensor([[0, 0, 3], [4, 0, 5]])请注意,输入参数 i 并不是一个索引元组列表。如果你想以这种方式编写索引,应在传递给稀疏矩阵构造函数之前先进行转置操作:

python

>>> i = [[0, 2], [1, 0], [1, 2]]

>>> v = [3, 4, 5 ]

>>> s = torch.sparse_coo_tensor(list(zip(i)), v, (2, 3))

>>> # Or another equivalent formulation to get s

>>> s = torch.sparse_coo_tensor(torch.tensor(i).t(), v, (2, 3))

>>> torch.sparse_coo_tensor(i.t(), v, torch.Size([2,3])).to_dense()

tensor([[0, 0, 3], [4, 0, 5]])可以仅通过指定尺寸来构造一个空的稀疏COO张量

python

>>> torch.sparse_coo_tensor(size=(2, 3))

tensor(indices=tensor([], size=(2, 0)), values=tensor([], size=(0,)), size=(2, 3), nnz=0, layout=torch.sparse_coo)稀疏混合COO张量

PyTorch实现了从标量值的稀疏张量到(连续)张量值的稀疏张量的扩展。这类张量被称为混合张量。

PyTorch混合COO张量扩展了稀疏COO张量的功能,允许values张量是一个多维张量,因此我们具有:

- 指定元素的索引收集在大小为

(sparse_dims, nse)、元素类型为torch.int64的indices张量中; - 对应的(张量)值收集在大小为

(nse, dense_dims)、元素类型为任意整数或浮点数的values张量中。

注意:我们使用(M + K)维张量来表示一个N维稀疏混合张量,其中M和K分别是稀疏维度和密集维度的数量,满足M + K == N的关系。

假设我们要创建一个(2 + 1)维的张量,其中位置(0, 2)处的条目为[3, 4],位置(1, 0)处的条目为[5, 6],位置(1, 2)处的条目为[7, 8]。我们可以这样表示:

python

>>> i = [[0, 1, 1], [2, 0, 2]]

>>> v = [[3, 4], [5, 6], [7, 8]]

>>> s = torch.sparse_coo_tensor(i, v, (2, 3, 2))

>>> s

tensor(indices=tensor([[0, 1, 1], [2, 0, 2]]), values=tensor([[3, 4], [5, 6], [7, 8]]), size=(2, 3, 2), nnz=3, layout=torch.sparse_coo)

python

>>> s.to_dense()

tensor([[[0, 0], [0, 0], [3, 4]], [[5, 6], [0, 0], [7, 8]]])通常来说,如果 s 是一个稀疏 COO 张量,且 M = s.sparse_dim(),K = s.dense_dim(),那么以下不变式成立:

M + K == len(s.shape) == s.ndim- 张量的维度等于稀疏维度和密集维度之和,s.indices().shape == (M, nse)- 稀疏索引被显式存储,s.values().shape == (nse,) + s.shape[M : M + K]- 混合张量的值是 K 维张量,s.values().layout == torch.strided- 值以跨步张量的形式存储。

注意:密集维度始终位于稀疏维度之后,也就是说,不支持混合稀疏维度和密集维度。

注意:为了确保构造的稀疏张量具有一致的索引、值和大小,可以通过 check_invariants=True 关键字参数在每次张量创建时启用不变式检查,或者全局使用 torch.sparse.check_sparse_tensor_invariants 上下文管理器实例。默认情况下,稀疏张量的不变式检查是禁用的。

未合并的稀疏COO张量

PyTorch稀疏COO张量格式允许存在稀疏的未合并 张量,其索引中可能包含重复坐标。这种情况下,该索引处的值被解释为所有重复值条目的总和。例如,可以为同一个索引1指定多个值3和4,这将生成一个一维未合并张量:

python

>>> i = [[1, 1]]

>>> v = [3, 4]

>>> s=torch.sparse_coo_tensor(i, v, (3,))

>>> s

tensor(indices=tensor([[1, 1]]), values=tensor( [3, 4]), size=(3,), nnz=2, layout=torch.sparse_coo)合并过程将通过求和运算将多值元素累积为单一值:

python

>>> s.coalesce()

tensor(indices=tensor([[1]]), values=tensor([7]), size=(3,), nnz=1, layout=torch.sparse_coo)通常来说,torch.Tensor.coalesce() 方法的输出是一个具有以下特性的稀疏张量:

- 指定张量元素的索引是唯一的,且按字典序排序,此时

torch.Tensor.is_coalesced()会返回True。

注意:在大多数情况下,你不需要关心稀疏张量是否经过合并(coalesced),因为大多数操作对于合并或未合并的稀疏张量都能同样工作。

然而,某些操作在未合并张量上可以实现更高效率,而另一些则在合并张量上更高效。

例如,稀疏COO张量的加法实现方式就是简单地拼接索引张量和值张量。

python

>>> a = torch.sparse_coo_tensor([[1, 1]], [5, 6], (2,))

>>> b = torch.sparse_coo_tensor([[0, 0]], [7, 8], (2,))

>>> a + b

tensor(indices=tensor([[0, 0, 1, 1]]), values=tensor([7, 8, 5, 6]), size=(2,), nnz=4, layout=torch.sparse_coo)如果你反复执行可能产生重复条目的操作(例如 torch.Tensor.add()),应该定期合并稀疏张量以防止其变得过大。

另一方面,索引的字典序排列有利于实现涉及大量元素选择操作的算法,例如切片或矩阵乘积。

稀疏COO张量操作

让我们来看以下示例:

python

>>> i = [[0, 1, 1], [2, 0, 2]]

>>> v = [[3, 4], [5, 6], [7, 8]]

>>> s = torch.sparse_coo_tensor(i, v, (2, 3, 2))如前所述,稀疏COO张量是torch.Tensor的实例。为了将其与其他布局类型的张量实例区分开,可以使用torch.Tensor.is_sparse属性或torch.Tensor.layout属性进行判断:

python

>>> isinstance(s, torch.Tensor)

True

>>> s.is_sparse

True

>>> s.layout == torch.sparse_coo

True可以通过以下方法分别获取稀疏维度和密集维度的数量:

torch.Tensor.sparse_dim() 和 torch.Tensor.dense_dim()。例如:

python

>>> s.sparse_dim(), s.dense_dim()

(2, 1)如果 s 是一个稀疏 COO 张量,可以通过 torch.Tensor.indices() 和 torch.Tensor.values() 方法获取其 COO 格式数据。

注意:目前仅当张量实例处于合并状态时,才能获取其 COO 格式数据。

python

>>> s.indices()

RuntimeError: Cannot get indices on an uncoalesced tensor, please call .coalesce() first要获取未合并张量的COO格式数据,请使用 torch.Tensor._values() 和 torch.Tensor._indices():

python

>>> s._indices()

tensor([[0, 1, 1], [2, 0, 2]])警告:调用 torch.Tensor._values() 将返回一个分离的张量。

如需跟踪梯度,必须改用 torch.Tensor.coalesce().values()。

构建新的稀疏 COO 张量会产生一个未合并的张量:

python

>>> s.is_coalesced()

False但可以通过 torch.Tensor.coalesce() 方法构造稀疏 COO 张量的合并副本:

python

>>> s2 = s.coalesce()

>>> s2.indices()

tensor([[0, 1, 1], [2, 0, 2]])在处理未合并的稀疏COO张量时,必须考虑未合并数据的可加性特性:相同索引的值是求和项,其计算结果对应张量元素的值。例如,稀疏未合并张量的标量乘法可以通过将所有未合并值与标量相乘来实现,因为c*(a + b) == c*a + c*b成立。然而,任何非线性操作(比如平方根)不能直接应用于未合并数据,因为sqrt(a + b) == sqrt(a) + sqrt(b)通常不成立。

稀疏COO张量的切片操作(步长为正)仅支持稠密维度。索引操作则同时支持稀疏维度和稠密维度。

python

>>> s[1]

tensor(indices=tensor([[0, 2]]), values=tensor([[5, 6], [7, 8]]), size=(3, 2), nnz=2, layout=torch.sparse_coo)

>>> s[1, 0, 1]

tensor(6)

>>> s[1, 0, 1:]

tensor([6])在PyTorch中,稀疏张量的填充值通常无法显式指定,一般默认为零。但某些操作可能会以不同方式解释填充值。例如,torch.sparse.softmax()在计算softmax时会假设填充值为负无穷。

稀疏压缩张量

稀疏压缩张量代表了一类具有共同特征的稀疏张量:通过对特定维度的索引进行压缩编码,从而实现对稀疏压缩张量线性代数核的特定优化。该编码基于压缩稀疏行(CSR)格式,PyTorch稀疏压缩张量在此基础上扩展了稀疏张量批次支持、允许多维张量值,并以密集块形式存储稀疏张量值。

注意:我们使用(B + M + K)维张量来表示N维稀疏压缩混合张量,其中B、M和K分别表示批次维度、稀疏维度和密集维度的数量,满足B + M + K == N关系。稀疏压缩张量的稀疏维度数始终为二,即M == 2。

注意:当满足以下不变条件时,我们称索引张量compressed_indices使用了CSR编码:

compressed_indices是连续步进的32位或64位整数张量compressed_indices的形状为(batchsize, compressed_dim_size + 1),其中compressed_dim_size表示压缩维度数(如行或列)compressed_indices[..., 0] == 0,其中...表示批次索引compressed_indices[..., compressed_dim_size] == nse,其中nse表示指定元素的数量- 对于

i=1,...,compressed_dim_size,满足0 <= compressed_indices[..., i] - compressed_indices[..., i - 1] <= plain_dim_size,其中plain_dim_size表示正交于压缩维度的普通维度数(如列或行)。

为确保构建的稀疏张量具有一致的索引、值和尺寸,可通过check_invariants=True关键字参数在张量创建时启用不变性检查,或全局使用torch.sparse.check_sparse_tensor_invariants上下文管理器实例。默认情况下,稀疏张量不变性检查处于禁用状态。

注意:稀疏压缩布局向N维张量的泛化可能导致关于指定元素计数的混淆。当稀疏压缩张量包含批次维度时,指定元素数量将对应每个批次的此类元素数量。当稀疏压缩张量具有密集维度时,所考虑的元素变为K维数组。对于块稀疏压缩布局,被指定的元素是二维块。以三维块稀疏张量为例,设批次维度长度为b,块形状为p, q。若该张量有n个指定元素,则实际表示每个批次有n个指定块。该张量的values形状将为(b, n, p, q)。这种对指定元素数量的解释源于所有稀疏压缩布局都派生自二维矩阵的压缩------批次维度被视为稀疏矩阵的堆叠,密集维度则将元素含义从简单标量值更改为具有自身维度的数组。

稀疏CSR张量

相比COO格式,CSR格式的主要优势在于更高效的存储利用,以及更快的计算操作(例如使用MKL和MAGMA后端进行稀疏矩阵-向量乘法)。

在最简单的情况下,(0 + 2 + 0)维的稀疏CSR张量由三个一维张量组成:crow_indices、col_indices和values:

crow_indices张量包含压缩的行索引。这是一个大小为nrows + 1(行数加1)的一维张量。crow_indices的最后一个元素是已指定元素的数量nse。该张量根据给定行的起始位置,编码values和col_indices中的索引。张量中每个连续数字减去前一个数字,表示该行的元素数量。col_indices张量包含每个元素的列索引。这是一个大小为nse的一维张量。values张量包含CSR张量元素的值。这是一个大小为nse的一维张量。

注意:索引张量crow_indices和col_indices的元素类型应为torch.int64(默认)或torch.int32。如果要使用MKL启用的矩阵操作,请使用torch.int32。这是因为PyTorch默认链接的是MKL LP64,它使用32位整数索引。

在一般情况下,(B + 2 + K)维的稀疏CSR张量由两个(B + 1)维的索引张量crow_indices和col_indices,以及一个(1 + K)维的values张量组成,满足以下条件:

crow_indices.shape == (batchsize, nrows + 1)col_indices.shape == (batchsize, nse)values.shape == (nse, densesize)

而稀疏CSR张量的形状为(batchsize, nrows, ncols, densesize),其中len(batchsize) == B且len(densesize) == K。

注意:稀疏CSR张量的批次是相互依赖的:所有批次中已指定元素的数量必须相同。这种人为约束允许高效存储不同CSR批次的索引。

注意:稀疏维度和密集维度的数量可以通过torch.Tensor.sparse_dim()和torch.Tensor.dense_dim()方法获取。批次维度可以从张量形状计算得出:batchsize = tensor.shape[:-tensor.sparse_dim() - tensor.dense_dim()]。

注意:稀疏CSR张量的内存消耗至少为(nrows * 8 + (8 + <元素类型字节大小> * prod(densesize)) * nse) * prod(batchsize)字节(加上存储其他张量数据的常量开销)。以稀疏COO格式介绍中的注释示例为例,一个10,000 x 10,000的张量,包含100,000个非零32位浮点数,使用CSR张量布局时,内存消耗至少为(10000 * 8 + (8 + 4 * 1) * 100 000) * 1 = 1 280 000字节。请注意,与COO和strided格式相比,使用CSR存储格式分别节省了1.6倍和310倍的内存。

CSR张量的构建

稀疏CSR张量可以直接通过使用torch.sparse_csr_tensor()函数来构建。用户需要分别提供行索引、列索引和值张量,其中行索引必须使用CSR压缩编码格式进行指定。size参数是可选的,如果未提供该参数,系统会根据crow_indices和col_indices自动推断张量尺寸。

python

>>> crow_indices = torch.tensor([0, 2, 4])

>>> col_indices = torch.tensor([0, 1, 0, 1])

>>> values = torch.tensor([1, 2, 3, 4])

>>> csr = torch.sparse_csr_tensor(crow_indices, col_indices, values, dtype=torch.float64)

>>> csr

tensor(crow_indices=tensor([0, 2, 4]), col_indices=tensor([0, 1, 0, 1]), values=tensor([1., 2., 3., 4.]), size=(2, 2), nnz=4, dtype=torch.float64)

>>> csr.to_dense()

tensor([[1., 2.], [3., 4.]], dtype=torch.float64)注意:推导出的size中稀疏维度的值是根据crow_indices的大小和col_indices中的最大索引值计算得出的。如果需要列数大于推导出的size,则必须显式指定size参数。

从跨步(strided)或稀疏COO张量构建2-D稀疏CSR张量的最简单方法是使用torch.Tensor.to_sparse_csr()方法。(跨步)张量中的任何零值将被解释为稀疏张量中的缺失值。

python

>>> t = torch.tensor([[[1., 0], [2., 3.]], [[4., 0], [5., 6.]]])

>>> t.dim()

3

>>> t.to_sparse_csr()

tensor(crow_indices=tensor([[0, 1, 3],

[0, 1, 3]]),

col_indices=tensor([[0, 0, 1],

[0, 0, 1]]),

values=tensor([[1., 2., 3.],

[4., 5., 6.]]), size=(2, 2, 2), nnz=3,

layout=torch.sparse_csr)CSR张量运算

稀疏矩阵-向量乘法可以通过tensor.matmul()方法执行。这是目前CSR张量唯一支持的数学运算。

python

>>> vec = torch.randn(4, 1, dtype=torch.float64)

>>> sp.matmul(vec)

tensor([[0.9078], [1.3180], [0.0000]], dtype=torch.float64)稀疏 CSC 张量

稀疏 CSC(压缩稀疏列)张量格式实现了用于存储二维张量的 CSC 格式,并扩展支持批量稀疏 CSC 张量及多维张量值。

注意:当转置操作涉及交换稀疏维度时,稀疏 CSC 张量本质上是稀疏 CSR 张量的转置形式。

与[稀疏 CSR 张量](#稀疏 CSR 张量)类似,稀疏 CSC 张量由三个张量组成:ccol_indices、row_indices 和 values:

ccol_indices张量包含压缩的列索引。这是一个 (B + 1) 维张量,形状为(batchsize, ncols + 1)。最后一个元素表示指定元素的数量nse。该张量根据给定列起始位置编码values和row_indices中的索引。张量中每个连续数字减去前一个数字的结果表示该列中的元素数量。row_indices张量包含每个元素的行索引。这是一个 (B + 1) 维张量,形状为(batchsize, nse)。values张量存储 CSC 张量元素的值。这是一个 (1 + K) 维张量,形状为(nse, densesize)。

CSC 张量的构建

稀疏 CSC 张量可以直接通过 torch.sparse_csc_tensor() 函数构建。用户需要分别提供行索引、列索引和值张量,其中列索引必须使用 CSR 压缩编码格式进行指定。size 参数是可选的,如果未提供该参数,系统会从 row_indices 和 ccol_indices 张量中自动推断出张量尺寸。

python

>>> ccol_indices = torch.tensor([0, 2, 4])

>>> row_indices = torch.tensor([0, 1, 0, 1])

>>> values = torch.tensor([1, 2, 3, 4])

>>> csc = torch.sparse_csc_tensor(ccol_indices, row_indices, values, dtype=torch.float64)

>>> csc

tensor(ccol_indices=tensor([0, 2, 4]), row_indices=tensor([0, 1, 0, 1]), values=tensor([1., 2., 3., 4.]), size=(2, 2), nnz=4, dtype=torch.float64, layout=torch.sparse_csc)

>>> csc.to_dense()

tensor([[1., 3.], [2., 4.]], dtype=torch.float64)注意:稀疏 CSC 张量构造函数的参数顺序中,压缩列索引参数排在行索引参数之前。

您可以使用 torch.Tensor.to_sparse_csc() 方法,将任何二维张量构造为 (0 + 2 + 0) 维的稀疏 CSC 张量。在(跨步)张量中的任何零值,都将被解释为稀疏张量中的缺失值。

python

>>> a = torch.tensor([[0, 0, 1, 0], [1, 2, 0, 0], [0, 0, 0, 0]], dtype=torch.float64)

>>> sp = a.to_sparse_csc()

>>> sp

tensor(ccol_indices=tensor([0, 1, 2, 3, 3]), row_indices=tensor([1, 1, 0]), values=tensor([1., 2., 1.]), size=(3, 4), nnz=3, dtype=torch.float64, layout=torch.sparse_csc)稀疏BSR张量

稀疏BSR(块压缩稀疏行)张量格式实现了BSR存储格式,用于存储二维张量,并扩展支持批量稀疏BSR张量及多维张量块组成的值。

稀疏BSR张量由三个张量组成:crow_indices、col_indices和values:

crow_indices张量包含压缩的行索引。这是一个(B+1)维张量,形状为(batchsize, nrowblocks + 1)。最后一个元素是已指定块的数量nse。该张量根据列块的起始位置,编码values和col_indices中的索引。张量中每个连续数字减去前一个数字,表示该行中的块数量。col_indices张量包含每个元素的列块索引。这是一个(B+1)维张量,形状为(batchsize, nse)。values张量包含收集到二维块中的稀疏BSR张量元素值。这是一个(1+2+K)维张量,形状为(nse, nrowblocks, ncolblocks, *densesize)。

BSR张量的构建

稀疏BSR张量可以直接通过使用torch.sparse_bsr_tensor()函数来构建。用户需要分别提供行块索引、列块索引和值张量,其中行块索引必须使用CSR压缩编码格式进行指定。

size参数是可选的,如果未提供该参数,系统会根据crow_indices和col_indices张量自动推断大小。

python

>>> crow_indices = torch.tensor([0, 2, 4])

>>> col_indices = torch.tensor([0, 1, 0, 1])

>>> values = torch.tensor([1, 2, 3, 4])

>>> csr = torch.sparse_csr_tensor(crow_indices, col_indices, values, dtype=torch.float64)

>>> csr

tensor(crow_indices=tensor([0, 2, 4]),

col_indices=tensor([0, 1, 0, 1]),

values=tensor([1., 2., 3., 4.]), size=(2, 2), nnz=4,

dtype=torch.float64)

>>> csr.to_dense()

tensor([[1., 2.],

[3., 4.]], dtype=torch.float64)可以通过 torch.Tensor.to_sparse_bsr() 方法,从任意二维张量构造 (0 + 2 + 0) 维稀疏 BSR 张量。该方法还需要指定值块的大小:

python

>>> dense = torch.tensor([[0, 1, 2, 3, 4, 5],

... [6, 7, 8, 9, 10, 11],

... [12, 13, 14, 15, 16, 17],

... [18, 19, 20, 21, 22, 23]])

>>> bsr = dense.to_sparse_bsr(blocksize=(2, 3))

>>> bsr

tensor(crow_indices=tensor([0, 2, 4]),

col_indices=tensor([0, 1, 0, 1]),

values=tensor([[[ 0, 1, 2],

[ 6, 7, 8]],

[[ 3, 4, 5],

[ 9, 10, 11]],

[[12, 13, 14],

[18, 19, 20]],

[[15, 16, 17],

[21, 22, 23]]]), size=(4, 6), nnz=4,

layout=torch.sparse_bsr)稀疏BSC张量

稀疏BSC(块压缩稀疏列)张量格式实现了BSC存储格式,用于存储二维张量,并扩展支持批量稀疏BSC张量以及多维张量块的值。

一个稀疏BSC张量由三个张量组成:ccol_indices、row_indices和values:

ccol_indices张量包含压缩的列索引。这是一个(B + 1)维张量,形状为(batchsize, ncolblocks + 1)。最后一个元素是指定块的数量nse。该张量根据给定行块的起始位置编码values和row_indices中的索引。张量中每个连续数字减去前一个数字表示给定列中的块数量。row_indices张量包含每个元素的行块索引。这是一个(B + 1)维张量,形状为(batchsize, nse)。values张量包含收集到二维块中的稀疏BSC张量元素值。这是一个(1 + 2 + K)维张量,形状为(nse, nrowblocks, ncolblocks, *densesize)。

BSC张量的构建

稀疏BSC张量可以直接通过使用torch.sparse_bsc_tensor()函数来构建。用户需要分别提供行块索引、列块索引和值张量,其中列块索引必须使用CSR压缩编码格式进行指定。

size参数是可选的,如果未提供该参数,系统会根据ccol_indices和row_indices张量自动推导出张量尺寸。

python

>>> ccol_indices = torch.tensor([0, 2, 4])

>>> row_indices = torch.tensor([0, 1, 0, 1])

>>> values = torch.tensor([[[0, 1, 2], [6, 7, 8]],

... [[3, 4, 5], [9, 10, 11]],

... [[12, 13, 14], [18, 19, 20]],

... [[15, 16, 17], [21, 22, 23]]])

>>> bsc = torch.sparse_bsc_tensor(ccol_indices, row_indices, values, dtype=torch.float64)

>>> bsc

tensor(ccol_indices=tensor([0, 2, 4]),

row_indices=tensor([0, 1, 0, 1]),

values=tensor([[[ 0., 1., 2.],

[ 6., 7., 8.]],

[[ 3., 4., 5.],

[ 9., 10., 11.]],

[[12., 13., 14.],

[18., 19., 20.]],

[[15., 16., 17.],

[21., 22., 23.]]]), size=(4, 6), nnz=4,

dtype=torch.float64, layout=torch.sparse_bsc)稀疏压缩张量处理工具

所有稀疏压缩张量(包括CSR、CSC、BSR和BSC张量)在概念上都非常相似,它们的索引数据被分为两部分:采用CSR编码的压缩索引(compressed indices),以及与压缩索引正交的普通索引(plain indices)。这种设计使得针对这些张量的各种工具可以共享相同的实现逻辑,只需通过张量布局进行参数化配置即可。

稀疏压缩张量的构建

可以通过使用 torch.sparse_compressed_tensor() 函数来构建稀疏的 CSR、CSC、BSR 和 BSC 张量。该函数的接口与之前讨论的构造函数 torch.sparse_csr_tensor()、torch.sparse_csc_tensor()、torch.sparse_bsr_tensor() 和 torch.sparse_bsc_tensor() 相同,但需要额外提供一个必需的 layout 参数。以下示例展示了如何通过为 torch.sparse_compressed_tensor() 函数指定相应的布局参数,使用相同输入数据构建 CSR 和 CSC 张量的方法:

python

>>> compressed_indices = torch.tensor([0, 2, 4])

>>> plain_indices = torch.tensor([0, 1, 0, 1])

>>> values = torch.tensor([1, 2, 3, 4])

>>> csr = torch.sparse_compressed_tensor(compressed_indices, plain_indices, values, layout=torch.sparse_csr)

>>> csr

tensor(crow_indices=tensor([0, 2, 4]),

col_indices=tensor([0, 1, 0, 1]),

values=tensor([1, 2, 3, 4]), size=(2, 2), nnz=4,

layout=torch.sparse_csr)

>>> csc = torch.sparse_compressed_tensor(compressed_indices, plain_indices, values, layout=torch.sparse_csc)

>>> csc

tensor(ccol_indices=tensor([0, 2, 4]),

row_indices=tensor([0, 1, 0, 1]),

values=tensor([1, 2, 3, 4]), size=(2, 2), nnz=4,

layout=torch.sparse_csc)

>>> (csr.transpose(0, 1).to_dense() == csc.to_dense()).all()

tensor(True)支持的操作

线性代数运算

下表总结了稀疏矩阵支持的线性代数运算,其中操作数的布局可能有所不同。这里 T[layout] 表示具有给定布局的张量。类似地,M[layout] 表示矩阵(2维 PyTorch 张量),V[layout] 表示向量(1维 PyTorch 张量)。此外,f 表示标量(浮点数或0维 PyTorch 张量),* 表示逐元素乘法,@ 表示矩阵乘法。

| PyTorch 运算 | 支持稀疏梯度? | 布局签名 |

|---|---|---|

torch.mv() |

否 | M[sparse_coo] @ V[strided] -V[strided] |

torch.mv() |

否 | M[sparse_csr] @ V[strided] -V[strided] |

torch.matmul() |

否 | M[sparse_coo] @ M[strided] -M[strided] |

torch.matmul() |

否 | M[sparse_csr] @ M[strided] -M[strided] |

torch.matmul() |

否 | M[SparseSemiStructured] @ M[strided] -M[strided] |

torch.matmul() |

否 | M[strided] @ M[SparseSemiStructured] -M[strided] |

torch.mm() |

否 | M[sparse_coo] @ M[strided] -M[strided] |

torch.mm() |

否 | M[SparseSemiStructured] @ M[strided] -M[strided] |

torch.mm() |

否 | M[strided] @ M[SparseSemiStructured] -M[strided] |

torch.sparse.mm() |

是 | M[sparse_coo] @ M[strided] -M[strided] |

torch.smm() |

否 | M[sparse_coo] @ M[strided] -M[sparse_coo] |

torch.hspmm() |

否 | M[sparse_coo] @ M[strided] -M[hybrid sparse_coo] |

torch.bmm() |

否 | T[sparse_coo] @ T[strided] -T[strided] |

torch.addmm() |

否 | f * M[strided] + f * (M[sparse_coo] @ M[strided]) -M[strided] |

torch.addmm() |

否 | f * M[strided] + f * (M[SparseSemiStructured] @ M[strided]) -M[strided] |

torch.addmm() |

否 | f * M[strided] + f * (M[strided] @ M[SparseSemiStructured]) -M[strided] |

torch.sparse.addmm() |

是 | f * M[strided] + f * (M[sparse_coo] @ M[strided]) -M[strided] |

torch.sparse.spsolve() |

否 | SOLVE(M[sparse_csr], V[strided]) -V[strided] |

torch.sspaddmm() |

否 | f * M[sparse_coo] + f * (M[sparse_coo] @ M[strided]) -M[sparse_coo] |

torch.lobpcg() |

否 | GENEIG(M[sparse_coo]) -M[strided], M[strided] |

torch.pca_lowrank() |

是 | PCA(M[sparse_coo]) -M[strided], M[strided], M[strided] |

torch.svd_lowrank() |

是 | SVD(M[sparse_coo]) -M[strided], M[strided], M[strided] |

其中"支持稀疏梯度?"列表示 PyTorch 运算是否支持对稀疏矩阵参数的梯度反向传播。除 torch.smm() 外,所有 PyTorch 运算均支持对 strided 矩阵参数的梯度反向传播。

注意:目前 PyTorch 不支持布局签名为 M[strided] @ M[sparse_coo] 的矩阵乘法。但应用仍可通过矩阵关系 D @S == (S.t() @ D.t()).t() 计算该运算。

张量方法与稀疏性

以下是与稀疏张量相关的Tensor方法:

Tensor.is_sparse |

若张量采用稀疏COO存储布局则为True,否则为False |

|---|---|

Tensor.is_sparse_csr |

若张量采用稀疏CSR存储布局则为True,否则为False |

Tensor.dense_dim |

返回[稀疏张量](#Tensor.is_sparse 若张量采用稀疏COO存储布局则为True,否则为False Tensor.is_sparse_csr 若张量采用稀疏CSR存储布局则为True,否则为False Tensor.dense_dim 返回稀疏张量self中的稠密维度数量 Tensor.sparse_dim 返回稀疏张量self中的稀疏维度数量 Tensor.sparse_mask 通过稀疏张量mask的索引过滤步进张量self的值,返回新的稀疏张量 Tensor.to_sparse 返回张量的稀疏副本 Tensor.to_sparse_coo 将张量转换为坐标格式 Tensor.to_sparse_csr 将张量转换为压缩行存储格式(CSR) Tensor.to_sparse_csc 将张量转换为压缩列存储格式(CSC) Tensor.to_sparse_bsr 将张量转换为给定块大小的块稀疏行(BSR)存储格式 Tensor.to_sparse_bsc 将张量转换为给定块大小的块稀疏列(BSC)存储格式 Tensor.to_dense 若self不是步进张量则创建其步进副本,否则返回self Tensor.values 返回稀疏COO张量的值张量)self中的稠密维度数量 |

Tensor.sparse_dim |

返回[稀疏张量](#Tensor.is_sparse 若张量采用稀疏COO存储布局则为True,否则为False Tensor.is_sparse_csr 若张量采用稀疏CSR存储布局则为True,否则为False Tensor.dense_dim 返回稀疏张量self中的稠密维度数量 Tensor.sparse_dim 返回稀疏张量self中的稀疏维度数量 Tensor.sparse_mask 通过稀疏张量mask的索引过滤步进张量self的值,返回新的稀疏张量 Tensor.to_sparse 返回张量的稀疏副本 Tensor.to_sparse_coo 将张量转换为坐标格式 Tensor.to_sparse_csr 将张量转换为压缩行存储格式(CSR) Tensor.to_sparse_csc 将张量转换为压缩列存储格式(CSC) Tensor.to_sparse_bsr 将张量转换为给定块大小的块稀疏行(BSR)存储格式 Tensor.to_sparse_bsc 将张量转换为给定块大小的块稀疏列(BSC)存储格式 Tensor.to_dense 若self不是步进张量则创建其步进副本,否则返回self Tensor.values 返回稀疏COO张量的值张量)self中的稀疏维度数量 |

Tensor.sparse_mask |

通过稀疏张量mask的索引过滤步进张量self的值,返回新的[稀疏张量](#Tensor.is_sparse 若张量采用稀疏COO存储布局则为True,否则为False Tensor.is_sparse_csr 若张量采用稀疏CSR存储布局则为True,否则为False Tensor.dense_dim 返回稀疏张量self中的稠密维度数量 Tensor.sparse_dim 返回稀疏张量self中的稀疏维度数量 Tensor.sparse_mask 通过稀疏张量mask的索引过滤步进张量self的值,返回新的稀疏张量 Tensor.to_sparse 返回张量的稀疏副本 Tensor.to_sparse_coo 将张量转换为坐标格式 Tensor.to_sparse_csr 将张量转换为压缩行存储格式(CSR) Tensor.to_sparse_csc 将张量转换为压缩列存储格式(CSC) Tensor.to_sparse_bsr 将张量转换为给定块大小的块稀疏行(BSR)存储格式 Tensor.to_sparse_bsc 将张量转换为给定块大小的块稀疏列(BSC)存储格式 Tensor.to_dense 若self不是步进张量则创建其步进副本,否则返回self Tensor.values 返回稀疏COO张量的值张量) |

Tensor.to_sparse |

返回张量的稀疏副本 |

Tensor.to_sparse_coo |

将张量转换为[坐标格式](#Tensor.is_sparse 若张量采用稀疏COO存储布局则为True,否则为False Tensor.is_sparse_csr 若张量采用稀疏CSR存储布局则为True,否则为False Tensor.dense_dim 返回稀疏张量self中的稠密维度数量 Tensor.sparse_dim 返回稀疏张量self中的稀疏维度数量 Tensor.sparse_mask 通过稀疏张量mask的索引过滤步进张量self的值,返回新的稀疏张量 Tensor.to_sparse 返回张量的稀疏副本 Tensor.to_sparse_coo 将张量转换为坐标格式 Tensor.to_sparse_csr 将张量转换为压缩行存储格式(CSR) Tensor.to_sparse_csc 将张量转换为压缩列存储格式(CSC) Tensor.to_sparse_bsr 将张量转换为给定块大小的块稀疏行(BSR)存储格式 Tensor.to_sparse_bsc 将张量转换为给定块大小的块稀疏列(BSC)存储格式 Tensor.to_dense 若self不是步进张量则创建其步进副本,否则返回self Tensor.values 返回稀疏COO张量的值张量) |

Tensor.to_sparse_csr |

将张量转换为压缩行存储格式(CSR) |

Tensor.to_sparse_csc |

将张量转换为压缩列存储格式(CSC) |

Tensor.to_sparse_bsr |

将张量转换为给定块大小的块稀疏行(BSR)存储格式 |

Tensor.to_sparse_bsc |

将张量转换为给定块大小的块稀疏列(BSC)存储格式 |

Tensor.to_dense |

若self不是步进张量则创建其步进副本,否则返回self |

Tensor.values |

返回[稀疏COO张量](#Tensor.is_sparse 若张量采用稀疏COO存储布局则为True,否则为False Tensor.is_sparse_csr 若张量采用稀疏CSR存储布局则为True,否则为False Tensor.dense_dim 返回稀疏张量self中的稠密维度数量 Tensor.sparse_dim 返回稀疏张量self中的稀疏维度数量 Tensor.sparse_mask 通过稀疏张量mask的索引过滤步进张量self的值,返回新的稀疏张量 Tensor.to_sparse 返回张量的稀疏副本 Tensor.to_sparse_coo 将张量转换为坐标格式 Tensor.to_sparse_csr 将张量转换为压缩行存储格式(CSR) Tensor.to_sparse_csc 将张量转换为压缩列存储格式(CSC) Tensor.to_sparse_bsr 将张量转换为给定块大小的块稀疏行(BSR)存储格式 Tensor.to_sparse_bsc 将张量转换为给定块大小的块稀疏列(BSC)存储格式 Tensor.to_dense 若self不是步进张量则创建其步进副本,否则返回self Tensor.values 返回稀疏COO张量的值张量)的值张量 |

以下方法专用于稀疏COO张量:

Tensor.coalesce |

若self是[未合并张量](#Tensor.coalesce 若self是未合并张量则返回其合并副本 Tensor.sparse_resize_ 将self稀疏张量调整为指定尺寸及稀疏/稠密维度数量 Tensor.sparse_resize_and_clear_ 从稀疏张量self中移除所有指定元素并调整尺寸 Tensor.is_coalesced 若self是已合并的稀疏COO张量则返回True,否则False Tensor.indices 返回稀疏COO张量的索引张量)则返回其合并副本 |

|---|---|

Tensor.sparse_resize_ |

将self[稀疏张量](#Tensor.coalesce 若self是未合并张量则返回其合并副本 Tensor.sparse_resize_ 将self稀疏张量调整为指定尺寸及稀疏/稠密维度数量 Tensor.sparse_resize_and_clear_ 从稀疏张量self中移除所有指定元素并调整尺寸 Tensor.is_coalesced 若self是已合并的稀疏COO张量则返回True,否则False Tensor.indices 返回稀疏COO张量的索引张量)调整为指定尺寸及稀疏/稠密维度数量 |

Tensor.sparse_resize_and_clear_ |

从[稀疏张量](#Tensor.coalesce 若self是未合并张量则返回其合并副本 Tensor.sparse_resize_ 将self稀疏张量调整为指定尺寸及稀疏/稠密维度数量 Tensor.sparse_resize_and_clear_ 从稀疏张量self中移除所有指定元素并调整尺寸 Tensor.is_coalesced 若self是已合并的稀疏COO张量则返回True,否则False Tensor.indices 返回稀疏COO张量的索引张量)self中移除所有指定元素并调整尺寸 |

Tensor.is_coalesced |

若self是已合并的[稀疏COO张量](#Tensor.coalesce 若self是未合并张量则返回其合并副本 Tensor.sparse_resize_ 将self稀疏张量调整为指定尺寸及稀疏/稠密维度数量 Tensor.sparse_resize_and_clear_ 从稀疏张量self中移除所有指定元素并调整尺寸 Tensor.is_coalesced 若self是已合并的稀疏COO张量则返回True,否则False Tensor.indices 返回稀疏COO张量的索引张量)则返回True,否则False |

Tensor.indices |

返回[稀疏COO张量](#Tensor.coalesce 若self是未合并张量则返回其合并副本 Tensor.sparse_resize_ 将self稀疏张量调整为指定尺寸及稀疏/稠密维度数量 Tensor.sparse_resize_and_clear_ 从稀疏张量self中移除所有指定元素并调整尺寸 Tensor.is_coalesced 若self是已合并的稀疏COO张量则返回True,否则False Tensor.indices 返回稀疏COO张量的索引张量)的索引张量 |

Tensor.crow_indices |

当self是布局为sparse_csr的稀疏CSR张量时,返回包含压缩行索引的张量 |

|---|---|

Tensor.col_indices |

当self是布局为sparse_csr的稀疏CSR张量时,返回包含列索引的张量 |

Tensor.row_indices |

|

|---|---|

Tensor.ccol_indices |

以下Tensor方法支持稀疏COO张量:

add()

add_()

addmm()

addmm_()

any()

asin()

asin_()

arcsin()

arcsin_()

bmm()

clone()

deg2rad()

deg2rad_()

detach()

detach_()

dim()

div()

div_()

floor_divide()

floor_divide_()

get_device()

index_select()

isnan()

log1p()

log1p_()

mm()

mul()

mul_()

mv()

narrow_copy()

neg()

neg_()

negative()

negative_()

numel()

rad2deg()

rad2deg_()

resize_as_()

size()

pow()

sqrt()

square()

smm()

sspaddmm()

sub()

sub_()

t()

t_()

transpose()

transpose_()

zero_()

稀疏张量专用 Torch 函数

sparse_coo_tensor |

在给定indices位置构造一个[COO(坐标)格式的稀疏张量](#sparse_coo_tensor 在给定indices位置构造一个COO(坐标)格式的稀疏张量,并填充指定值。 sparse_csr_tensor 在给定crow_indices和col_indices位置构造一个CSR(压缩稀疏行)格式的稀疏张量,并填充指定值。 sparse_csc_tensor 在给定ccol_indices和row_indices位置构造一个CSC(压缩稀疏列)格式的稀疏张量,并填充指定值。 sparse_bsr_tensor 在给定crow_indices和col_indices位置构造一个BSR(块压缩稀疏行)格式的稀疏张量,并填充指定的二维块数据。 sparse_bsc_tensor 在给定ccol_indices和row_indices位置构造一个BSC(块压缩稀疏列)格式的稀疏张量,并填充指定的二维块数据。 sparse_compressed_tensor 在给定compressed_indices和plain_indices位置构造一个压缩稀疏格式(CSR/CSC/BSR/BSC)的稀疏张量,并填充指定值。 sparse.sum 返回给定稀疏张量每行的元素和。 sparse.addmm 该函数在前向计算中与torch.addmm()功能完全相同,但额外支持稀疏COO矩阵mat1的反向传播。 sparse.sampled_addmm 在input的稀疏模式指定位置,对稠密矩阵mat1和mat2执行矩阵乘法。 sparse.mm 执行稀疏矩阵mat1的矩阵乘法运算。 sspaddmm 将稀疏张量mat1与稠密张量mat2进行矩阵乘法,再将稀疏张量input加到结果上。 hspmm 执行稀疏COO矩阵mat1与跨步矩阵mat2的矩阵乘法。 smm 执行稀疏矩阵input与稠密矩阵mat的矩阵乘法。 sparse.softmax 应用softmax函数。 sparse.spsolve 计算具有唯一解的线性方程组的解。 sparse.log_softmax 应用softmax函数后再进行对数运算。 sparse.spdiags 通过将diagonals行的值沿指定对角线放置,构造一个稀疏的二维张量。),并填充指定值。 |

|---|---|

sparse_csr_tensor |

在给定crow_indices和col_indices位置构造一个[CSR(压缩稀疏行)格式的稀疏张量](#sparse_coo_tensor 在给定indices位置构造一个COO(坐标)格式的稀疏张量,并填充指定值。 sparse_csr_tensor 在给定crow_indices和col_indices位置构造一个CSR(压缩稀疏行)格式的稀疏张量,并填充指定值。 sparse_csc_tensor 在给定ccol_indices和row_indices位置构造一个CSC(压缩稀疏列)格式的稀疏张量,并填充指定值。 sparse_bsr_tensor 在给定crow_indices和col_indices位置构造一个BSR(块压缩稀疏行)格式的稀疏张量,并填充指定的二维块数据。 sparse_bsc_tensor 在给定ccol_indices和row_indices位置构造一个BSC(块压缩稀疏列)格式的稀疏张量,并填充指定的二维块数据。 sparse_compressed_tensor 在给定compressed_indices和plain_indices位置构造一个压缩稀疏格式(CSR/CSC/BSR/BSC)的稀疏张量,并填充指定值。 sparse.sum 返回给定稀疏张量每行的元素和。 sparse.addmm 该函数在前向计算中与torch.addmm()功能完全相同,但额外支持稀疏COO矩阵mat1的反向传播。 sparse.sampled_addmm 在input的稀疏模式指定位置,对稠密矩阵mat1和mat2执行矩阵乘法。 sparse.mm 执行稀疏矩阵mat1的矩阵乘法运算。 sspaddmm 将稀疏张量mat1与稠密张量mat2进行矩阵乘法,再将稀疏张量input加到结果上。 hspmm 执行稀疏COO矩阵mat1与跨步矩阵mat2的矩阵乘法。 smm 执行稀疏矩阵input与稠密矩阵mat的矩阵乘法。 sparse.softmax 应用softmax函数。 sparse.spsolve 计算具有唯一解的线性方程组的解。 sparse.log_softmax 应用softmax函数后再进行对数运算。 sparse.spdiags 通过将diagonals行的值沿指定对角线放置,构造一个稀疏的二维张量。),并填充指定值。 |

sparse_csc_tensor |

在给定ccol_indices和row_indices位置构造一个[CSC(压缩稀疏列)格式的稀疏张量](#sparse_coo_tensor 在给定indices位置构造一个COO(坐标)格式的稀疏张量,并填充指定值。 sparse_csr_tensor 在给定crow_indices和col_indices位置构造一个CSR(压缩稀疏行)格式的稀疏张量,并填充指定值。 sparse_csc_tensor 在给定ccol_indices和row_indices位置构造一个CSC(压缩稀疏列)格式的稀疏张量,并填充指定值。 sparse_bsr_tensor 在给定crow_indices和col_indices位置构造一个BSR(块压缩稀疏行)格式的稀疏张量,并填充指定的二维块数据。 sparse_bsc_tensor 在给定ccol_indices和row_indices位置构造一个BSC(块压缩稀疏列)格式的稀疏张量,并填充指定的二维块数据。 sparse_compressed_tensor 在给定compressed_indices和plain_indices位置构造一个压缩稀疏格式(CSR/CSC/BSR/BSC)的稀疏张量,并填充指定值。 sparse.sum 返回给定稀疏张量每行的元素和。 sparse.addmm 该函数在前向计算中与torch.addmm()功能完全相同,但额外支持稀疏COO矩阵mat1的反向传播。 sparse.sampled_addmm 在input的稀疏模式指定位置,对稠密矩阵mat1和mat2执行矩阵乘法。 sparse.mm 执行稀疏矩阵mat1的矩阵乘法运算。 sspaddmm 将稀疏张量mat1与稠密张量mat2进行矩阵乘法,再将稀疏张量input加到结果上。 hspmm 执行稀疏COO矩阵mat1与跨步矩阵mat2的矩阵乘法。 smm 执行稀疏矩阵input与稠密矩阵mat的矩阵乘法。 sparse.softmax 应用softmax函数。 sparse.spsolve 计算具有唯一解的线性方程组的解。 sparse.log_softmax 应用softmax函数后再进行对数运算。 sparse.spdiags 通过将diagonals行的值沿指定对角线放置,构造一个稀疏的二维张量。),并填充指定值。 |

sparse_bsr_tensor |

在给定crow_indices和col_indices位置构造一个[BSR(块压缩稀疏行)格式的稀疏张量](#sparse_coo_tensor 在给定indices位置构造一个COO(坐标)格式的稀疏张量,并填充指定值。 sparse_csr_tensor 在给定crow_indices和col_indices位置构造一个CSR(压缩稀疏行)格式的稀疏张量,并填充指定值。 sparse_csc_tensor 在给定ccol_indices和row_indices位置构造一个CSC(压缩稀疏列)格式的稀疏张量,并填充指定值。 sparse_bsr_tensor 在给定crow_indices和col_indices位置构造一个BSR(块压缩稀疏行)格式的稀疏张量,并填充指定的二维块数据。 sparse_bsc_tensor 在给定ccol_indices和row_indices位置构造一个BSC(块压缩稀疏列)格式的稀疏张量,并填充指定的二维块数据。 sparse_compressed_tensor 在给定compressed_indices和plain_indices位置构造一个压缩稀疏格式(CSR/CSC/BSR/BSC)的稀疏张量,并填充指定值。 sparse.sum 返回给定稀疏张量每行的元素和。 sparse.addmm 该函数在前向计算中与torch.addmm()功能完全相同,但额外支持稀疏COO矩阵mat1的反向传播。 sparse.sampled_addmm 在input的稀疏模式指定位置,对稠密矩阵mat1和mat2执行矩阵乘法。 sparse.mm 执行稀疏矩阵mat1的矩阵乘法运算。 sspaddmm 将稀疏张量mat1与稠密张量mat2进行矩阵乘法,再将稀疏张量input加到结果上。 hspmm 执行稀疏COO矩阵mat1与跨步矩阵mat2的矩阵乘法。 smm 执行稀疏矩阵input与稠密矩阵mat的矩阵乘法。 sparse.softmax 应用softmax函数。 sparse.spsolve 计算具有唯一解的线性方程组的解。 sparse.log_softmax 应用softmax函数后再进行对数运算。 sparse.spdiags 通过将diagonals行的值沿指定对角线放置,构造一个稀疏的二维张量。),并填充指定的二维块数据。 |

sparse_bsc_tensor |

在给定ccol_indices和row_indices位置构造一个[BSC(块压缩稀疏列)格式的稀疏张量](#sparse_coo_tensor 在给定indices位置构造一个COO(坐标)格式的稀疏张量,并填充指定值。 sparse_csr_tensor 在给定crow_indices和col_indices位置构造一个CSR(压缩稀疏行)格式的稀疏张量,并填充指定值。 sparse_csc_tensor 在给定ccol_indices和row_indices位置构造一个CSC(压缩稀疏列)格式的稀疏张量,并填充指定值。 sparse_bsr_tensor 在给定crow_indices和col_indices位置构造一个BSR(块压缩稀疏行)格式的稀疏张量,并填充指定的二维块数据。 sparse_bsc_tensor 在给定ccol_indices和row_indices位置构造一个BSC(块压缩稀疏列)格式的稀疏张量,并填充指定的二维块数据。 sparse_compressed_tensor 在给定compressed_indices和plain_indices位置构造一个压缩稀疏格式(CSR/CSC/BSR/BSC)的稀疏张量,并填充指定值。 sparse.sum 返回给定稀疏张量每行的元素和。 sparse.addmm 该函数在前向计算中与torch.addmm()功能完全相同,但额外支持稀疏COO矩阵mat1的反向传播。 sparse.sampled_addmm 在input的稀疏模式指定位置,对稠密矩阵mat1和mat2执行矩阵乘法。 sparse.mm 执行稀疏矩阵mat1的矩阵乘法运算。 sspaddmm 将稀疏张量mat1与稠密张量mat2进行矩阵乘法,再将稀疏张量input加到结果上。 hspmm 执行稀疏COO矩阵mat1与跨步矩阵mat2的矩阵乘法。 smm 执行稀疏矩阵input与稠密矩阵mat的矩阵乘法。 sparse.softmax 应用softmax函数。 sparse.spsolve 计算具有唯一解的线性方程组的解。 sparse.log_softmax 应用softmax函数后再进行对数运算。 sparse.spdiags 通过将diagonals行的值沿指定对角线放置,构造一个稀疏的二维张量。),并填充指定的二维块数据。 |

sparse_compressed_tensor |

在给定compressed_indices和plain_indices位置构造一个[压缩稀疏格式(CSR/CSC/BSR/BSC)的稀疏张量](#sparse_coo_tensor 在给定indices位置构造一个COO(坐标)格式的稀疏张量,并填充指定值。 sparse_csr_tensor 在给定crow_indices和col_indices位置构造一个CSR(压缩稀疏行)格式的稀疏张量,并填充指定值。 sparse_csc_tensor 在给定ccol_indices和row_indices位置构造一个CSC(压缩稀疏列)格式的稀疏张量,并填充指定值。 sparse_bsr_tensor 在给定crow_indices和col_indices位置构造一个BSR(块压缩稀疏行)格式的稀疏张量,并填充指定的二维块数据。 sparse_bsc_tensor 在给定ccol_indices和row_indices位置构造一个BSC(块压缩稀疏列)格式的稀疏张量,并填充指定的二维块数据。 sparse_compressed_tensor 在给定compressed_indices和plain_indices位置构造一个压缩稀疏格式(CSR/CSC/BSR/BSC)的稀疏张量,并填充指定值。 sparse.sum 返回给定稀疏张量每行的元素和。 sparse.addmm 该函数在前向计算中与torch.addmm()功能完全相同,但额外支持稀疏COO矩阵mat1的反向传播。 sparse.sampled_addmm 在input的稀疏模式指定位置,对稠密矩阵mat1和mat2执行矩阵乘法。 sparse.mm 执行稀疏矩阵mat1的矩阵乘法运算。 sspaddmm 将稀疏张量mat1与稠密张量mat2进行矩阵乘法,再将稀疏张量input加到结果上。 hspmm 执行稀疏COO矩阵mat1与跨步矩阵mat2的矩阵乘法。 smm 执行稀疏矩阵input与稠密矩阵mat的矩阵乘法。 sparse.softmax 应用softmax函数。 sparse.spsolve 计算具有唯一解的线性方程组的解。 sparse.log_softmax 应用softmax函数后再进行对数运算。 sparse.spdiags 通过将diagonals行的值沿指定对角线放置,构造一个稀疏的二维张量。),并填充指定值。 |

sparse.sum |

返回给定稀疏张量每行的元素和。 |

sparse.addmm |

该函数在前向计算中与torch.addmm()功能完全相同,但额外支持稀疏COO矩阵mat1的反向传播。 |

sparse.sampled_addmm |

在input的稀疏模式指定位置,对稠密矩阵mat1和mat2执行矩阵乘法。 |

sparse.mm |

执行稀疏矩阵mat1的矩阵乘法运算。 |

sspaddmm |

将稀疏张量mat1与稠密张量mat2进行矩阵乘法,再将稀疏张量input加到结果上。 |

hspmm |

执行[稀疏COO矩阵](#sparse_coo_tensor 在给定indices位置构造一个COO(坐标)格式的稀疏张量,并填充指定值。 sparse_csr_tensor 在给定crow_indices和col_indices位置构造一个CSR(压缩稀疏行)格式的稀疏张量,并填充指定值。 sparse_csc_tensor 在给定ccol_indices和row_indices位置构造一个CSC(压缩稀疏列)格式的稀疏张量,并填充指定值。 sparse_bsr_tensor 在给定crow_indices和col_indices位置构造一个BSR(块压缩稀疏行)格式的稀疏张量,并填充指定的二维块数据。 sparse_bsc_tensor 在给定ccol_indices和row_indices位置构造一个BSC(块压缩稀疏列)格式的稀疏张量,并填充指定的二维块数据。 sparse_compressed_tensor 在给定compressed_indices和plain_indices位置构造一个压缩稀疏格式(CSR/CSC/BSR/BSC)的稀疏张量,并填充指定值。 sparse.sum 返回给定稀疏张量每行的元素和。 sparse.addmm 该函数在前向计算中与torch.addmm()功能完全相同,但额外支持稀疏COO矩阵mat1的反向传播。 sparse.sampled_addmm 在input的稀疏模式指定位置,对稠密矩阵mat1和mat2执行矩阵乘法。 sparse.mm 执行稀疏矩阵mat1的矩阵乘法运算。 sspaddmm 将稀疏张量mat1与稠密张量mat2进行矩阵乘法,再将稀疏张量input加到结果上。 hspmm 执行稀疏COO矩阵mat1与跨步矩阵mat2的矩阵乘法。 smm 执行稀疏矩阵input与稠密矩阵mat的矩阵乘法。 sparse.softmax 应用softmax函数。 sparse.spsolve 计算具有唯一解的线性方程组的解。 sparse.log_softmax 应用softmax函数后再进行对数运算。 sparse.spdiags 通过将diagonals行的值沿指定对角线放置,构造一个稀疏的二维张量。)mat1与跨步矩阵mat2的矩阵乘法。 |

smm |

执行稀疏矩阵input与稠密矩阵mat的矩阵乘法。 |

sparse.softmax |

应用softmax函数。 |

sparse.spsolve |

计算具有唯一解的线性方程组的解。 |

sparse.log_softmax |

应用softmax函数后再进行对数运算。 |

sparse.spdiags |

通过将diagonals行的值沿指定对角线放置,构造一个稀疏的二维张量。 |

其他函数

以下 torch 函数支持稀疏张量:

cat()

dstack()

empty()

empty_like()

hstack()

index_select()

is_complex()

is_floating_point()

is_nonzero()

is_same_size()

is_signed()

is_tensor()

lobpcg()

mm()

native_norm()

pca_lowrank()

select()

stack()

svd_lowrank()

unsqueeze()

vstack()

zeros()

zeros_like()

稀疏张量约束检查

sparse.check_sparse_tensor_invariants |

用于控制稀疏张量约束检查的工具。 |

|---|

梯度检查扩展

sparse.as_sparse_gradcheck |

装饰器函数,用于扩展稀疏张量的梯度检查功能。 |

|---|

保零一元函数

我们致力于支持所有"保零一元函数":即那些将零映射为零的单参数函数。

如果您发现我们遗漏了您需要的保零一元函数,欢迎提交功能请求的issue。在创建issue前,请一如既往地先尝试使用搜索功能。

以下运算符目前支持稀疏COO/CSR/CSC/BSR/CSR张量输入:

abs()

asin()

asinh()

atan()

atanh()

ceil()

conj_physical()

floor()

log1p()

neg()

round()

sin()

sinh()

sign()

sgn()

signbit()

tan()

tanh()

trunc()

expm1()

sqrt()

angle()

isinf()

isposinf()

isneginf()

isnan()

erf()

erfinv()

torch.Storage

在PyTorch中,常规张量是一个由以下组件定义的多维数组:

- Storage:张量的实际数据,以连续的字节一维数组形式存储

dtype:张量元素的数据类型,例如torch.float32或torch.int64shape:表示张量各维度大小的元组- Stride:在每个维度中从一个元素移动到下一个元素所需的步长

- Offset:张量数据在存储中的起始位置。对于新创建的张量,该值通常为0

这些组件共同定义了张量的结构和数据,其中Storage保存实际数据,其余部分作为元数据。

无类型存储 API

torch.UntypedStorage 是一个连续的、一维的元素数组。其长度等于张量的字节数。该存储作为张量的底层数据容器。

通常,使用常规构造函数(如 zeros()、zeros_like() 或 new_zeros())在 PyTorch 中创建的张量,其存储与张量本身存在一一对应关系。

然而,一个存储可以被多个张量共享。例如,任何张量的视图(通过 view() 或某些但不是所有类型的索引(如整数和切片)获得)将指向与原始张量相同的底层存储。当序列化和反序列化共享同一存储的张量时,这种关系会被保留,张量继续指向同一存储。有趣的是,反序列化指向单个存储的多个张量可能比反序列化多个独立张量更快。

可以通过 untyped_storage() 方法访问张量的存储。这将返回一个 torch.UntypedStorage 类型的对象。幸运的是,存储有一个唯一的标识符,可通过 torch.UntypedStorage.data_ptr() 方法访问。在常规情况下,具有相同数据存储的两个张量将具有相同的存储 data_ptr。

然而,张量本身可以指向两个独立的存储,一个用于其数据属性,另一个用于其梯度属性。每个存储都需要自己的 data_ptr()。一般来说,不能保证 torch.Tensor.data_ptr() 和 torch.UntypedStorage.data_ptr() 匹配,因此不应假设这一点成立。

无类型存储与构建在其上的张量在一定程度上是独立的。实际上,这意味着具有不同数据类型或形状的张量可以指向同一存储。这也意味着张量的存储可以更改,如下例所示:

python

>>> t = torch.ones(3)

>>> s0 = t.untyped_storage()

>>> s0

0

0

128

63

0

0

128

63

0

0

128

63

[torch.storage.UntypedStorage(device=cpu) of size 12]

>>> s1 = s0.clone()

>>> s1.fill_(0)

0

0

0

0

0

0

0

0

0

0

0

0

[torch.storage.UntypedStorage(device=cpu) of size 12]

>>> # Fill the tensor with a zeroed storage

>>> t.set_(s1, storage_offset=t.storage_offset(), stride=t.stride(), size=t.size())

tensor([0., 0., 0.])警告:请注意,直接修改张量的存储(如本示例所示)并非推荐做法。

此处展示底层操作仅出于教学目的,用于说明张量与其底层存储之间的关系。通常情况下,使用标准torch.Tensor方法(如clone()和fill_())来实现相同效果会更高效且更安全。

除data_ptr外,无类型存储还具有其他属性,例如:

存储可通过以下方法进行原地或非原地操作:

更多信息请参阅下方API参考。请注意,修改存储属于底层API操作,存在风险!

这些API大多在张量层级也有对应实现:如果存在,应优先使用张量层级的对应方法。

特殊情况

我们提到过,当张量的 grad 属性不为 None 时,实际上它内部包含两部分数据。在这种情况下,untyped_storage() 会返回 data 属性的存储空间,而梯度部分的存储空间可以通过 tensor.grad.untyped_storage() 获取。

python

>>> t = torch.zeros(3, requires_grad=True)

>>> t.sum().backward()

>>> assert list(t.untyped_storage()) == [0] * 12 # the storage of the tensor is just 0s

>>> assert list(t.grad.untyped_storage()) != [0] * 12 # the storage of the gradient isn't还存在一些特殊情况,张量可能没有典型的存储结构,或者根本没有存储:

"meta"设备上的张量:这类张量用于形状推断,并不保存实际数据。- 伪张量(Fake Tensors):PyTorch编译器使用的另一种内部工具是FakeTensor,其基于相似原理实现。

张量子类或类张量对象也可能表现出非典型行为。总体而言,我们预计大多数使用场景不需要在存储层级进行操作!

python

class torch.UntypedStorage(*args, **kwargs)

python

bfloat16()将此存储转换为 bfloat16 类型。

python

bool()将此存储转换为布尔类型。

python

byte()将此存储转换为字节类型。

python

byteswap(dtype)交换底层数据中的字节顺序。

python

char()将此存储转换为 char 类型。

python

clone()返回此存储的一个副本。

python

complex_double()将此存储转换为复数双精度类型。

python

complex_float()将此存储转换为复数浮点类型。

python

copy_()

python

cpu()如果该存储不在CPU上,则返回其CPU副本。

python

cuda(device=None, non_blocking=False)返回该对象在CUDA内存中的副本。

如果该对象已在CUDA内存中且位于正确的设备上,则不会执行复制操作,直接返回原对象。

参数

device ( int )-- 目标GPU的ID。默认为当前设备。non_blocking ([bool])-- 如果为True且源数据位于固定内存中,则复制操作将与主机异步执行。否则该参数无效。

返回类型:Union [_StorageBase, TypedStorage]

python

data_ptr()

python

device: device

python

double()将此存储转换为双精度类型。

python

element_size()

python

property filename: Optional[str ] 返回与此存储关联的文件名。

如果存储位于CPU上,并且是通过from_file()方法创建且shared参数为True时,文件名将是一个字符串。否则该属性为None。

python

fill_()

float()将此存储转换为浮点类型。

python

float8_e4m3fn()将此存储转换为 float8_e4m3fn 类型

python

float8_e4m3fnuz()将此存储转换为 float8_e4m3fnuz 类型

python

float8_e5m2()将此存储转换为 float8_e5m2 类型

python

float8_e5m2fnuz()将此存储转换为 float8_e5m2fnuz 类型

python

static from_buffer()

python

static from_file(filename, shared=False, size=0) → Storage 创建一个基于内存映射文件的CPU存储。

如果shared为True,则所有进程之间共享内存。所有更改都会写入文件。如果shared为False,则存储上的更改不会影响文件。

size表示存储中的元素数量。如果shared为False,则文件必须至少包含size * sizeof(Type)字节(Type是存储类型,对于UnTypedStorage,文件必须至少包含size字节)。如果shared为True,则会在需要时创建文件。

参数

filename (str)-- 要映射的文件名shared ([bool])-- 是否共享内存(决定底层mmap(2)调用传递的是MAP_SHARED还是MAP_PRIVATE)size ( int )-- 存储中的元素数量

python

get_device()返回类型:int

python

half()将此存储转换为半精度类型。

python

hpu(device=None, non_blocking=False)返回该对象在HPU内存中的副本。

如果该对象已在HPU内存中且位于正确的设备上,则不会执行复制操作,直接返回原对象。

参数

device ( int )-- 目标HPU设备ID。默认为当前设备。non_blocking ([bool])-- 如果为True且源数据位于固定内存中,则复制操作将与主机异步执行。否则该参数无效。

返回类型:Union [_StorageBase, TypedStorage]

python

int()将此存储转换为 int 类型。

python

property is_cuda

python

property is_hpu

python

is_pinned(device='cuda')判断CPU存储是否已在设备上固定。

参数

device (str 或 torch.device)-- 用于固定内存的设备(默认值:'cuda')。

不建议使用此参数,未来可能被弃用。

返回值

一个布尔变量。

python

is_shared()

is_sparse: bool * = False

is_sparse_csr: bool * = False

long()将此存储转换为 long 类型。

python

mps()如果该存储不在 MPS 上,则返回其 MPS 副本。

python

nbytes()

new()

pin_memory(device='cuda')将CPU存储复制到固定内存中(如果尚未固定)。

参数

device (str 或 torch.device)-- 用于固定内存的设备(默认:'cuda')。不推荐使用此参数,未来可能会被弃用。

返回值:一个已固定的CPU存储。

python

resizable()

resize_()

share_memory_(*args, **kwargs)将存储移动到共享内存中。

对于已经在共享内存中的存储和CUDA存储(这些存储无需移动即可跨进程共享),此操作无效。

共享内存中的存储无法调整大小。

请注意,为了避免类似此问题的情况,从多个线程对同一对象调用此函数是线程安全的。

但如果没有适当的同步机制,调用其他任何函数都不是线程安全的。更多详情请参阅多进程最佳实践。

注意:当共享内存中存储的所有引用被删除时,关联的共享内存对象也会被删除。PyTorch有一个特殊的清理过程,确保即使当前进程意外退出,这种情况也会发生。

值得注意 share_memory_() 和 from_file() 与 shared = True 的区别:

1、share_memory_ 使用 shm_open(3) 创建一个POSIX共享内存对象,而 from_file() 使用 open(2) 打开用户传递的文件名。

2、两者都使用 mmap(2) 调用 和 MAP_SHARED 将文件/对象映射到当前虚拟地址空间。

3、share_memory_ 在映射后会调用 shm_unlink(3) 以确保当没有进程打开该对象时,共享内存对象会被释放。torch.from_file(shared=True) 不会取消链接文件。该文件是持久性的,将一直存在,直到用户删除它。

返回

self

python

short()将此存储转换为 short 类型。

python

size()返回类型:int

python

to(*, device, non_blocking=False)

python

tolist()返回包含此存储元素的列表。

python

type(dtype=None, non_blocking=False)返回类型:Union [_StorageBase, TypedStorage]

python

untyped()遗留类型化存储

警告:出于历史背景考虑,PyTorch 曾使用类型化存储类,这些类现已弃用,应避免使用。以下内容详细介绍了该 API,以防您遇到它,但强烈不建议使用。未来将移除除 torch.UntypedStorage 之外的所有存储类,并且 torch.UntypedStorage 将在所有情况下使用。

torch.Storage 是与默认数据类型 (torch.get_default_dtype()) 对应的存储类的别名。例如,如果默认数据类型是 torch.float,则 torch.Storage 解析为 torch.FloatStorage。

torch.<type>Storage 和 torch.cuda.<type>Storage 类,如 torch.FloatStorage、torch.IntStorage 等,实际上从未实例化。调用它们的构造函数会创建一个具有适当 torch.dtype 和 torch.device 的 torch.TypedStorage。torch.<type>Storage 类具有 torch.TypedStorage 的所有类方法。

torch.TypedStorage 是一个连续的、一维的特定 torch.dtype 元素数组。它可以接受任何 torch.dtype,并且内部数据将被正确解释。torch.TypedStorage 包含一个 torch.UntypedStorage,后者将数据存储为无类型的字节数组。

每个跨步 torch.Tensor 都包含一个 torch.TypedStorage,用于存储 torch.Tensor 视图中的所有数据。

python

class torch.TypedStorage(*args, wrap_storage=None, dtype=None, device=None, _internal=False)

python

bfloat16()将此存储转换为 bfloat16 类型。

python

bool()将此存储转换为布尔类型。

python

byte()将此存储转换为字节类型。

python

char()将此存储转换为 char 类型。

python

clone()返回此存储的一个副本。

python

complex_double()将此存储转换为复数双精度类型。

python

complex_float()将此存储转换为复数浮点类型。

python

copy_(source, non_blocking=None)

python

cpu()如果该存储不在CPU上,则返回其CPU副本。

python

cuda(device=None, non_blocking=False)返回该对象在CUDA内存中的副本。

如果该对象已在CUDA内存中且位于正确的设备上,则不会执行复制操作,直接返回原对象。

参数

device (int)- 目标GPU ID。默认为当前设备。non_blocking ([bool])- 如果为True且源数据位于固定内存中,则复制操作将与主机异步执行。否则该参数无效。

返回类型

Self

python

data_ptr()

python

property device

double()将此存储转换为双精度类型。

python

dtype: [dtype](tensor_attributes.html#torch.dtype "torch.dtype")

python

element_size()

python

property filename: Optional[str ]

Returns the file name associated with this storage if the storage was memory mapped from a file. or `None` if the storage was not created by memory mapping a file.

fill_(value)

python

float()将此存储转换为浮点类型。

python

float8_e4m3fn()将此存储转换为 float8_e4m3fn 类型

python

float8_e4m3fnuz()将此存储转换为 float8_e4m3fnuz 类型

python

float8_e5m2()将此存储转换为 float8_e5m2 类型

python

float8_e5m2fnuz()将此存储转换为 float8_e5m2fnuz 类型

python

CLASSMETHOD from_buffer(*args, **kwargs)

python

CLASSMETHOD from_file(filename, shared=False, size=0) → Storage创建一个基于内存映射文件的CPU存储。

如果shared为True,则所有进程之间共享该内存。

所有更改都会写入文件。如果shared为False,则存储上的更改不会影响文件。

size表示存储中的元素数量。如果shared为False,则文件必须至少包含size * sizeof(Type)字节(Type是存储的类型)。如果shared为True,则会在需要时创建文件。

参数

filename (str)-- 要映射的文件名shared ([bool])--

是否共享内存(决定是传递MAP_SHARED还是MAP_PRIVATE给底层的mmap(2)调用)size ( int )-- 存储中的元素数量

python

get_device()返回类型:int

python

half()将此存储转换为半精度浮点类型。

python

hpu(device=None, non_blocking=False)返回该对象在HPU内存中的副本。

如果该对象已在HPU内存中且位于正确的设备上,则不会执行复制操作,直接返回原对象。

参数

device ( int )- 目标HPU设备ID。默认为当前设备。non_blocking ([bool])- 如果为True且源数据位于固定内存中,则复制操作将与主机异步执行。否则该参数无效。

返回类型:Self

python

int()将此存储转换为 int 类型。

python

property is_cuda

python

property is_hpu is_pinned(device='cuda')判断 CPU TypedStorage 是否已在设备上固定。

参数

device (str 或 torch.device)-- 要固定内存的设备(默认:'cuda')。不建议使用此参数,未来将被弃用。

返回

一个布尔值变量。

is_shared()is_sparse: bool * = False

long()将此存储转换为 long 类型。

python

nbytes()pickle_storage_type()pin_memory(device='cuda')将CPU的TypedStorage复制到固定内存中(如果尚未固定)。

参数

device (str 或 torch.device)-- 用于固定内存的设备(默认:'cuda')。

不建议使用此参数,未来可能会被弃用。

返回值:一个已固定的CPU存储。

resizable()resize_(size)share_memory_()请参考 torch.UntypedStorage.share_memory_() 方法文档

python

short()将此存储转换为短整型。

python

size()to(*, device, non_blocking=False)返回该对象在设备内存中的副本。

如果该对象已在目标设备上,则不会执行复制操作,直接返回原对象。

参数

device ( int )-- 目标设备编号。non_blocking ([bool])-- 若为True且源数据位于固定内存中,则复制操作将与主机异步执行。否则该参数无效。

返回类型:Self

tolist()返回包含此存储元素的列表。

type(dtype=None, non_blocking=False)如果未提供 dtype 参数,则返回当前类型;否则将对象转换为指定类型。

若对象已符合目标类型,则不会创建副本,直接返回原对象。

参数说明

dtype (type 或 *字符串)-- 目标类型non_blocking ([布尔值])-- 当设为True时,若源数据位于固定内存而目标在GPU(或反之),则复制操作会以异步方式执行(相对于主机)。其他情况下该参数无效。**kwargs-- 为保持兼容性,可用async键替代non_blocking参数。注意:async参数已弃用。

返回类型

Union [_StorageBase, TypedStorage, 字符串 ]

python

untyped()返回内部的 torch.UntypedStorage。

python

class torch.DoubleStorage(*args, wrap_storage=None, dtype=None, device=None, _internal=False)

python

dtype: torch.dtype = torch.float64*

python

class torch.FloatStorage(*args, wrap_storage=None, dtype=None, device=None, _internal=False)

python

dtype: torch.dtype = torch.float32*

python

class torch.HalfStorage(*args, wrap_storage=None, dtype=None, device=None, _internal=False)

python

dtype: torch.dtype = torch.float16

python

class torch.LongStorage(*args, wrap_storage=None, dtype=None, device=None, _internal=False)

python

dtype: torch.dtype = torch.int64*

python

class torch.IntStorage(*args, wrap_storage=None, dtype=None, device=None, _internal=False)

python

dtype: torch.dtype = torch.int32*

python

class torch.ShortStorage(*args, wrap_storage=None, dtype=None, device=None, _internal=False)

python

dtype: torch.dtype = torch.int16*

python

class torch.CharStorage(*args, wrap_storage=None, dtype=None, device=None, _internal=False)

python

dtype: torch.dtype = torch.int8*

python

class torch.ByteStorage(*args, wrap_storage=None, dtype=None, device=None, _internal=False)

python

dtype: torch.dtype = torch.uint8*

python

class torch.BoolStorage(*args, wrap_storage=None, dtype=None, device=None, _internal=False)

python

dtype: torch.dtype = torch.bool*

python

class torch.BFloat16Storage(*args, wrap_storage=None, dtype=None, device=None, _internal=False)

python

dtype: torch.dtype = torch.bfloat16*

python

class torch.ComplexDoubleStorage(*args, wrap_storage=None, dtype=None, device=None, _internal=False)

python

dtype: torch.dtype = torch.complex128*

python

class torch.ComplexFloatStorage(*args, wrap_storage=None, dtype=None, device=None, _internal=False)

python

dtype: torch.dtype = torch.complex64*

python

class torch.QUInt8Storage(*args, wrap_storage=None, dtype=None, device=None, _internal=False)

python

dtype: torch.dtype = torch.quint8*

python

class torch.QInt8Storage(*args, wrap_storage=None, dtype=None, device=None, _internal=False)

python

dtype: torch.dtype = torch.qint8*

python

class torch.QInt32Storage(*args, wrap_storage=None, dtype=None, device=None, _internal=False)

python

dtype: torch.dtype = torch.qint32*

python

class torch.QUInt4x2Storage(*args, wrap_storage=None, dtype=None, device=None, _internal=False)

python

dtype: torch.dtype = torch.quint4x2*

python

class torch.QUInt2x4Storage(*args, wrap_storage=None, dtype=None, device=None, _internal=False)

python

dtype: torch.dtype = torch.quint2x4*torch.testing

python

torch.testing.assert_close(actual, expected, *, allow_subclasses=True, rtol=None, atol=None, equal_nan=False, check_device=True, check_dtype=True, check_layout=True, check_stride=False, msg=None)断言 actual 和 expected 近似相等。

如果 actual 和 expected 是步进式(strided)、非量化、实数值且有限的张量,当满足以下条件时认为两者近似:

∣ actual − expected ∣ ≤ atol + rtol ⋅ ∣ expected ∣ \lvert \text{actual} - \text{expected} \rvert \le \texttt{atol} + \texttt{rtol} \cdot \lvert \text{expected} \rvert ∣actual−expected∣≤atol+rtol⋅∣expected∣

非有限值(-inf 和 inf)仅在完全相等时才被认为近似。NaN 值仅在 equal_nan 为 True 时被认为彼此相等。

此外,还需满足以下条件才被视为近似:

- 相同的

device(当check_device为True) - 相同的

dtype(当check_dtype为True) - 相同的

layout(当check_layout为True) - 相同的步长(stride)(当

check_stride为True)

如果 actual 或 expected 是元张量(meta tensor),则仅执行属性检查。

对于稀疏张量(COO、CSR、CSC、BSR 或 BSC 布局),会分别检查其步进式成员。索引(COO的indices,CSR/BSR的crow_indices和col_indices,CSC/BSC的ccol_indices和row_indices)始终检查是否相等,而值则根据上述定义检查近似性。

对于量化张量,当具有相同的 qscheme() 且 dequantize() 后的结果符合上述近似定义时,认为两者近似。

actual 和 expected 可以是 Tensor 或任何能通过 torch.as_tensor() 转换为张量的类张量/标量。除Python标量外,输入类型必须直接相关。此外,它们也可以是 Sequence 或 Mapping,此时要求结构匹配且所有元素都符合上述近似定义。

注意:Python标量是类型关系要求的例外,因为它们的 type()(如 int、float、complex)等价于张量的dtype。因此可以检查不同类型的Python标量,但需要设置 check_dtype=False。

参数:

actual (Any)- 实际输入expected (Any)- 预期输入allow_subclasses ([bool])- 若为True(默认),除Python标量外允许直接相关的类型输入;否则要求类型严格相等rtol (Optional[float])- 相对容差。若指定则必须同时指定atol。未指定时根据dtype按下表选择默认值atol (Optional[float])- 绝对容差。若指定则必须同时指定rtol。未指定时根据dtype按下表选择默认值equal_nan (Union[[bool],* str])- 若为True,两个NaN值将被视为相等check_device ([bool])- 若为True(默认),断言对应张量位于相同device。禁用时会将不同设备的张量移至CPU再比较check_dtype ([bool])- 若为True(默认),断言对应张量具有相同dtype。禁用时会按torch.promote_types()提升至共同类型check_layout ([bool])- 若为True(默认),断言对应张量具有相同layout。禁用时会转换为步进式张量再比较check_stride ([bool])- 若为True且对应张量是步进式,断言它们具有相同步长msg (Optional[Union[str, Callable[[str],* str]]])- 比较失败时使用的可选错误信息。也可传入可调用对象,接收生成的消息并返回新消息

抛出异常:

ValueError- 无法从输入构造torch.Tensor时ValueError- 仅指定rtol或atol时AssertionError- 对应输入不是Python标量且不直接相关时AssertionError-allow_subclasses为False但对应输入不是Python标量且类型不同时AssertionError- 输入为Sequence但长度不匹配时AssertionError- 输入为Mapping但键集合不匹配时AssertionError- 对应张量shape不同时AssertionError-check_layout为True但对应张量layout不同时AssertionError- 仅一个对应张量被量化时AssertionError- 对应量化张量qscheme()不同时AssertionError-check_device为True但对应张量不在相同device时AssertionError-check_dtype为True但对应张量dtype不同时AssertionError-check_stride为True但对应步进式张量步长不同时AssertionError- 对应张量值不满足上述近似定义时

下表展示了不同dtype的默认rtol和atol。当dtype不匹配时,取两者容差的最大值。

dtype |

rtol |

atol |

|---|---|---|

float16 |

1e-3 |

1e-5 |

bfloat16 |

1.6e-2 |

1e-5 |

float32 |

1.3e-6 |

1e-5 |

float64 |

1e-7 |

1e-7 |

complex32 |

1e-3 |

1e-5 |

complex64 |

1.3e-6 |

1e-5 |

complex128 |

1e-7 |

1e-7 |

quint8 |

1.3e-6 |

1e-5 |

quint2x4 |

1.3e-6 |

1e-5 |

quint4x2 |

1.3e-6 |

1e-5 |

qint8 |

1.3e-6 |

1e-5 |

qint32 |

1.3e-6 |

1e-5 |

| 其他 | 0.0 |

0.0 |

注意:assert_close() 具有严格的默认配置。建议使用 partial() 定制需求。例如若需等值检查,可定义默认对所有dtype使用零容差的assert_equal。

python

>>> import functools

>>> assert_equal = functools.partial(torch.testing.assert_close, rtol=0, atol=0)

>>> assert_equal(1e-9, 1e-10)

Traceback (most recent call last):

...

AssertionError: Scalars are not equal!

Expected 1e-10 but got 1e-09、Absolute difference: 9.000000000000001e-10

Relative difference: 9.0Examples

python

>>> # tensor to tensor comparison

>>> expected = torch.tensor([1e0, 1e-1, 1e-2])

>>> actual = torch.acos(torch.cos(expected))

>>> torch.testing.assert_close(actual, expected)

python

>>> # scalar to scalar comparison

>>> import math

>>> expected = math.sqrt(2.0)

>>> actual = 2.0 / math.sqrt(2.0)

>>> torch.testing.assert_close(actual, expected)

python

>>> # numpy array to numpy array comparison

>>> import numpy as np

>>> expected = np.array([1e0, 1e-1, 1e-2])

>>> actual = np.arccos(np.cos(expected))

>>> torch.testing.assert_close(actual, expected)

python

>>> # sequence to sequence comparison

>>> import numpy as np

>>> # The types of the sequences do not have to match. They only have to have the same >>> # length and their elements have to match.

>>> expected = [torch.tensor([1.0]), 2.0, np.array(3.0)]

>>> actual = tuple(expected)

>>> torch.testing.assert_close(actual, expected)

python

>>> # mapping to mapping comparison

>>> from collections import OrderedDict

>>> import numpy as np

>>> foo = torch.tensor(1.0)

>>> bar = 2.0

>>> baz = np.array(3.0)

>>> # The types and a possible ordering of mappings do not have to match. They only

>>> # have to have the same set of keys and their elements have to match.

>>> expected = OrderedDict([("foo", foo), ("bar", bar), ("baz", baz)])

>>> actual = {"baz": baz, "bar": bar, "foo": foo}

>>> torch.testing.assert_close(actual, expected)

python

>>> expected = torch.tensor([1.0, 2.0, 3.0])

>>> actual = expected.clone()

>>> # By default, directly related instances can be compared

>>> torch.testing.assert_close(torch.nn.Parameter(actual), expected)

>>> # This check can be made more strict with allow_subclasses=False

>>> torch.testing.assert_close(

... torch.nn.Parameter(actual), expected, allow_subclasses=False

... )

Traceback (most recent call last):

...

TypeError: No comparison pair was able to handle inputs of type

<class 'torch.nn.parameter.Parameter'and <class 'torch.Tensor'>.

>>> # If the inputs are not directly related, they are never considered close

>>> torch.testing.assert_close(actual.numpy(), expected)

Traceback (most recent call last):

...

TypeError: No comparison pair was able to handle inputs of type <class 'numpy.ndarray'and <class 'torch.Tensor'>.

>>> # Exceptions to these rules are Python scalars. They can be checked regardless of >># their type if check_dtype=False.

>>> torch.testing.assert_close(1.0, 1, check_dtype=False)

python

>>> # NaN != NaN by default.

>>> expected = torch.tensor(float("Nan"))

>>> actual = expected.clone()

>>> torch.testing.assert_close(actual, expected)

Traceback (most recent call last):

...

AssertionError: Scalars are not close!

Expected nan but got nan.

Absolute difference: nan (up to 1e-05 allowed)

Relative difference: nan (up to 1.3e-06 allowed)

>>> torch.testing.assert_close(actual, expected, equal_nan=True)

python

>>> expected = torch.tensor([1.0, 2.0, 3.0])

>>> actual = torch.tensor([1.0, 4.0, 5.0])

>>> # The default error message can be overwritten.

>>> torch.testing.assert_close(actual, expected, msg="Argh, the tensors are not close!")

Traceback (most recent call last):

...

AssertionError: Argh, the tensors are not close!

>>> # If msg is a callable, it can be used to augment the generated message with >># extra information

>>> torch.testing.assert_close(

... actual, expected, msg=lambda msg: f"Header\n\n{msg}\n\nFooter"

... )

Traceback (most recent call last):

...

AssertionError: Header

Tensor-likes are not close!

Mismatched elements: 2 / 3 (66.7%)

Greatest absolute difference: 2.0 at index (1,) (up to 1e-05 allowed)

Greatest relative difference: 1.0 at index (1,) (up to 1.3e-06 allowed)

Footer

python

torch.testing.make_tensor(*shape, dtype, device, low=None, high=None, requires_grad=False, noncontiguous=False, exclude_zero=False, memory_format=None)创建一个具有指定shape、device和dtype的张量,其值均匀采样自区间[low, high)。

如果指定的low或high超出了该dtype可表示有限值的范围,则会被分别截断至最低或最高可表示有限值。

若参数为None,则low和high的默认值如下表所示,具体取决于dtype:

dtype |

low |

high |

|---|---|---|

| 布尔类型 | 0 |

2 |

| 无符号整型 | 0 |

10 |

| 有符号整型 | -9 |

10 |

| 浮点类型 | -9 |

9 |

| 复数类型 | -9 |

9 |

参数说明

- shape (Tuple[int, ...]) - 定义输出张量形状的整数或整数序列

- dtype (

torch.dtype) - 返回张量的数据类型 - device (Union[str, torch.device]) - 返回张量的设备位置

- low (Optional[Number]) - 设置区间下限(包含)。若提供数值,会被截断至该dtype的最小可表示有限值。默认为

None时根据dtype自动确定(见上表) - high (Optional[Number]) - 设置区间上限(不包含)。若提供数值,会被截断至该dtype的最大可表示有限值。默认为

None时根据dtype自动确定(见上表)

自版本2.1起弃用:为浮点或复数类型传递

low==high参数的行为已被弃用,将在2.3版本移除,请改用torch.full()

- requires_grad (Optional[bool]) - 是否在返回张量上启用自动求导记录。默认:

False - noncontiguous (Optional[bool]) - 若为True则返回非连续张量。当张量元素少于两个时此参数无效,且与

memory_format互斥 - exclude_zero (Optional[bool]) - 若为True则将零值替换为dtype的最小正值:布尔/整型替换为1;浮点型替换为该dtype的最小正规数(来自

finfo()的"tiny"值);复数型替换为实部/虚部均为复数类型最小正规数的复数。默认:False - memory_format (Optional[torch.memory_format]) - 返回张量的内存格式,与

noncontiguous互斥

异常抛出

- ValueError - 整型dtype传入了

requires_grad=True - ValueError - 当

low >= high时 - ValueError - 当

low或high为nan时 - ValueError - 同时传入了

noncontiguous和memory_format - TypeError - 不支持的

dtype类型

返回类型:Tensor

使用示例

python

>>> from torch.testing import make_tensor

>>> # Creates a float tensor with values in [-1, 1)

>>> make_tensor((3,), device='cpu', dtype=torch.float32, low=-1, high=1)

tensor([0.1205, 0.2282, -0.6380])

>>> # Creates a bool tensor on CUDA

>>> make_tensor((2, 2), device='cuda', dtype=torch.bool)

tensor([[False, False], [False, True]], device='cuda:0')

python

torch.testing.assert_allclose(actual, expected, rtol=None, atol=None, equal_nan=True, msg='')警告:自 1.12 版本起,torch.testing.assert_allclose() 已被弃用,并将在未来版本中移除。

请改用 torch.testing.assert_close()。详细的升级指南可参阅此处。

torch.utils

rename_privateuse1_backend |

重命名privateuse1后端设备,使其在PyTorch API中作为设备名更方便使用。 |

|---|---|

generate_methods_for_privateuse1_backend |

在重命名privateuse1后端后,自动为自定义后端生成属性和方法。 |

get_cpp_backtrace |

返回包含当前线程C++堆栈跟踪的字符串。 |

set_module |

为Python对象设置模块属性,以便更清晰地打印显示。 |

swap_tensors |

该函数用于交换两个Tensor对象的内容。 |

基准测试工具 - torch.utils.benchmark

python

class torch.utils.benchmark.Timer(stmt='pass', setup='pass', global_setup='', timer=<built-in function perf_counter>, globals=None, label=None, sub_label=None, description=None, env=None, num_threads=1, language=Language.PYTHON)用于测量PyTorch语句执行时间的辅助类。

完整使用教程请参阅:

https://pytorch.org/tutorials/recipes/recipes/benchmark.html

PyTorch计时器基于timeit.Timer(内部实际使用timeit.Timer实现),但具有几个关键差异:

1、运行时感知:计时器会执行预热(这对PyTorch某些延迟初始化的组件很重要),设置线程池大小以确保比较条件一致,并在必要时同步异步CUDA函数。

2、聚焦重复测量:在测量代码(特别是复杂内核/模型)时,运行间的差异是重要干扰因素。所有测量都应包含重复次数以量化噪声并支持中位数计算(比平均值更鲁棒)。为此,本类在概念上合并了timeit.Timer.repeat和timeit.Timer.autorange方法(具体算法见方法文档字符串)。保留timeit方法用于不需要自适应策略的场景。

3、可选元数据:定义计时器时可选指定label、sub_label、description和env等字段(后文定义)。这些字段会包含在结果对象的表示中,并被Compare类用于分组和显示对比结果。

4、指令计数:除挂钟时间外,计时器可通过Callgrind运行语句并报告执行指令数。

直接对应timeit.Timer构造参数: stmt, setup, timer, globals

PyTorch计时器特有构造参数:label, sub_label, description, env, num_threads

参数说明

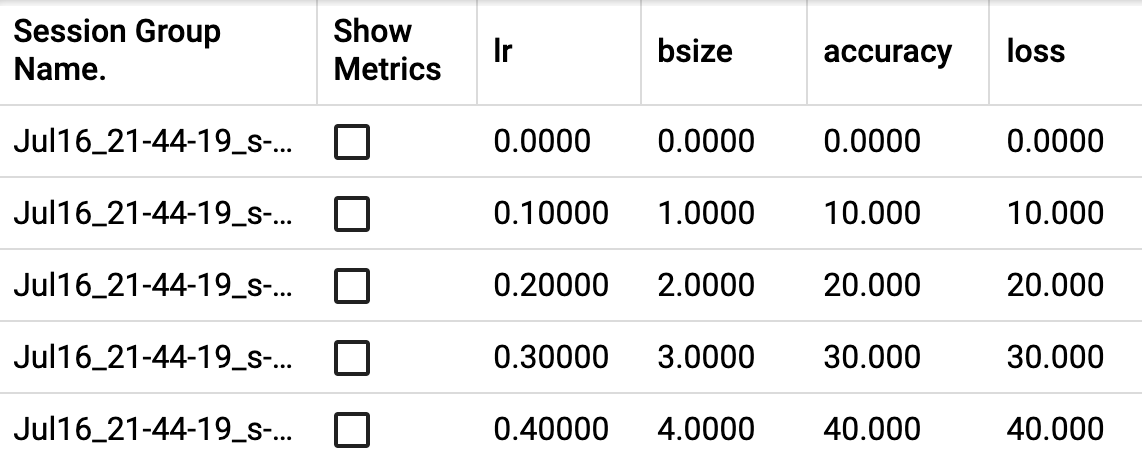

stmt (str)-- 在循环中运行并计时的代码片段setup (str)-- 可选设置代码,用于定义stmt中使用的变量global_setup (str)-- (仅C++)置于文件顶层的代码,如#include语句timer (Callable[[], float])-- 返回当前时间的可调用对象。如果PyTorch未启用CUDA或没有GPU,默认使用timeit.default_timer;否则会在测量时间前同步CUDAglobals (Optional[dict[str, Any]])-- 执行stmt时的全局变量字典,这是提供stmt所需变量的另一种方式label (Optional[str])-- 概括stmt的字符串。例如stmt为torch.nn.functional.relu(torch.add(x, 1, out=out))时,可设为"ReLU(x + 1)"提高可读性sub_label (Optional[str])-- 提供补充信息以区分相同stmt或label的测量。例如上例中可设为"float"或"int",便于在打印Measurements或用Compare汇总时区分:ReLU(x + 1): (float)和ReLU(x + 1): (int)description (Optional[str])-- 区分相同label和sub_label测量的字符串。主要用途是通过Compare标识数据列。例如可根据输入尺寸创建如下表格:

python

| n=1 | n=4 | ...

------------- ...

ReLU(x + 1): (float) | ... | ... | ...

ReLU(x + 1): (int) | ... | ... | ...使用 Compare 时,该标签也会在打印 Measurement 时包含。

env (Optional[str])-- 此标签表示其他条件相同的任务在不同环境中运行,因此不等价。例如在进行内核变更的 A/B 测试时,Compare 在合并重复运行结果时会将具有不同 env 指定的 Measurement 视为不同实体。num_threads ( int )-- 执行 stmt 时 PyTorch 线程池的大小。单线程性能既是一个关键推理工作负载指标,也是内在算法效率的重要体现,因此默认值设为 1。这与默认 PyTorch 线程池大小(会尝试利用所有核心)形成对比。

python

adaptive_autorange(threshold=0.1, *, min_run_time=0.01, max_run_time=10.0, callback=None)类似于blocked_autorange,但还会检查测量值的变异性,并重复执行直到iqr/median小于阈值或达到max_run_time。

从高层次来看,adaptive_autorange执行以下伪代码:

setup

python

times = []

while times.sum < max_run_time

start = timer()

for _ in range(block_size):

`stmt`

times.append(timer() - start)

enough_data = len(times)>3 and times.sum min_run_time

small_iqr=times.iqr/times.mean<threshold

if enough_data and small_iqr:

break参数

threshold (float)-- 用于停止的iqr/median阈值min_run_time (float)-- 检查阈值前所需的总运行时间max_run_time (float)-- 不考虑阈值情况下所有测量的总运行时间

返回值:一个包含测量运行时间和重复次数的Measurement对象,可用于计算统计量(如平均值、中位数等)。

返回类型:Measurement

python

blocked_autorange(callback=None, min_run_time=0.2)在保持计时器开销最小化的同时测量多个重复样本。

从高层次来看,blocked_autorange 执行以下伪代码:

python

`setup`

total_time = 0

while total_time < min_run_time

start = timer()

for _ in range(block_size):

`stmt`

total_time += (timer() - start)请注意内层循环中的变量block_size。选择适当的块大小对测量质量至关重要,需要平衡两个相互制约的目标:

1、较小的块大小会产生更多重复样本,通常能获得更好的统计结果。

2、较大的块大小能更好地分摊计时器调用的开销,从而减少测量偏差。这一点尤为重要,因为CUDA同步时间不可忽视(通常在个位数到低两位数微秒量级),否则会影响测量准确性。

blocked_autorange通过运行预热阶段来设置block_size,它会逐步增加块大小,直到计时器开销低于总计算时间的0.1%。这个最终确定的块大小值将用于主测量循环。

返回值:返回一个Measurement对象,其中包含测量的运行时间和重复次数,可用于计算统计量(如平均值、中位数等)。

返回类型:Measurement

python

collect_callgrind(number: int , *, repeats: None , collect_baseline: bool , retain_out_file: bool ) → CallgrindStats

python

collect_callgrind(number: int , *, repeats: int , collect_baseline: bool , retain_out_file: bool ) → tuple [torch.utils.benchmark.utils.valgrind_wrapper.timer_interface.CallgrindStats ,

...]使用 Callgrind 收集指令计数。

与挂钟时间不同,指令计数具有确定性(程序本身的非确定性和 Python 解释器产生的少量抖动除外)。这使其成为详细性能分析的理想选择。该方法在独立进程中运行 stmt 语句,以便 Valgrind 能够对程序进行插桩。虽然插桩会显著降低性能,但由于通常只需少量迭代即可获得良好测量结果,这一缺点得到了缓解。

使用此方法需要安装 valgrind、callgrind_control 和 callgrind_annotate。

由于调用者(当前进程)与 stmt 执行之间存在进程边界,全局变量不能包含任意内存数据结构(与计时方法不同)。作为替代,全局变量仅限于内置类型、nn.Modules 和 TorchScripted 函数/模块,以减少序列化与反序列化带来的意外因素。GlobalsBridge 类提供了关于此主题的更多细节。特别注意 nn.Modules:它们依赖 pickle,可能需要添加导入设置才能正确传输。

默认情况下,系统会收集并缓存空语句的分析文件,用于指示驱动 stmt 的 Python 循环产生的指令数量。

返回值:返回一个 CallgrindStats 对象,该对象提供指令计数及用于分析和处理结果的基本功能。

python

timeit(number=1000000)实现了与 timeit.Timer.timeit() 相同的语义功能。

将主语句(stmt)执行指定次数(number)。

https://docs.python.org/3/library/timeit.html#timeit.Timer.timeit

返回类型:Measurement

python

class torch.utils.benchmark.Measurement(number_per_run, raw_times, task_spec, metadata=None)计时器测量结果。

该类存储给定语句的一次或多次测量数据。它具有可序列化特性,并为下游使用者提供了多个便捷方法(包括详细的__repr__实现)。

python

static merge(measurements)合并重复样本的便捷方法。

该方法会将时间数据外推至 number_per_run=1 且不会转移任何元数据(因为不同重复样本间可能存在差异)。

返回类型:list [Measurement]

python

property significant_figures: int 近似有效数字估计。

该属性旨在提供一种便捷方式来评估测量精度。它仅使用四分位距区域来估算统计量,以减轻尾部偏斜的影响,并采用静态z值1.645(因为预期不会用于小样本量n的情况,此时z可近似替代t)。

有效数字估计需与trim_sigfig方法配合使用,以提供更符合人类直觉的数据摘要。注意__repr__方法不会使用此功能,而是直接显示原始值。有效数字估计功能主要为Compare模块设计。

python

class torch.utils.benchmark.CallgrindStats(task_spec, number_per_run, built_with_debug_symbols, baseline_inclusive_stats, baseline_exclusive_stats, stmt_inclusive_stats, stmt_exclusive_stats, stmt_callgrind_out)Timer收集的Callgrind结果顶级容器。

通常通过FunctionCounts类进行操作,该类可通过调用CallgrindStats.stats(...)获取。同时还提供了多个便捷方法,其中最重要的是CallgrindStats.as_standardized()。

python

as_standardized()从函数字符串中去除库名称和某些前缀。

在比较两组不同的指令计数时,路径前缀可能成为绊脚石。Callgrind 在报告函数时会包含完整文件路径(这是合理的做法)。然而,这在进行性能分析对比时可能引发问题。例如,如果关键组件(如 Python 或 PyTorch)在两个分析文件中分别构建于不同位置,可能会导致类似以下情况:

python

23234231 /tmp/first_build_dir/thing.c:foo(...)

9823794 /tmp/first_build_dir/thing.c:bar(...)

...

53453 .../aten/src/Aten/...:function_that_actually_changed(...)

...

-9823794 /tmp/second_build_dir/thing.c:bar(...)

-23234231 /tmp/second_build_dir/thing.c:foo(...)通过去除前缀可以改善这一问题,它能规范化字符串并在差异比较时实现更好的等效调用点消除效果。

返回类型:CallgrindStats

python

counts(*, denoise=False)返回已执行指令的总数。

关于去噪参数的解释,请参阅 FunctionCounts.denoise()。

返回类型:int

python

delta(other, inclusive=False)对比两组计数数据。

收集指令计数的一个常见原因是为了确定特定变更对执行某项工作单元所需指令数量的影响。如果变更导致指令数增加,接下来自然要问"为什么"。这通常需要查看代码中哪部分的指令计数有所增加。此函数自动化了这一过程,使用户能够轻松地进行包含性和排他性的计数差异分析。

返回类型:FunctionCounts

python

stats(inclusive=False)返回详细的函数调用计数。

从概念上讲,返回的FunctionCounts可以视为由(计数, 路径及函数名)元组组成的元组。

参数inclusive的语义与callgrind一致。若设为True,计数将包含子函数执行的指令。inclusive=True适用于识别代码热点;inclusive=False则有助于在比较两次运行的计数差异时减少干扰(更多细节请参阅CallgrindStats.delta(...))。

返回类型:FunctionCounts

python

class torch.utils.benchmark.FunctionCounts(_data, inclusive, truncate_rows=True, _linewidth=None)用于操作 Callgrind 结果的容器。

支持功能包括:

1、通过加减运算合并或对比结果

2、类元组索引访问

3、降噪功能,可去除已知非确定性且噪声较大的 CPython 调用

4、提供两种高阶方法(filter 和 transform)用于自定义操作处理

python

denoise()移除已知的噪声指令。

CPython解释器中有几个指令会产生较多噪声。这些指令涉及Unicode到字典的查找操作,Python用这种方式来映射变量名。FunctionCounts通常是一个与内容无关的容器,但对于获取可靠结果而言,这个处理非常重要,因此需要作为例外情况处理。

返回类型:FunctionCounts

python

filter(filter_fn)仅保留函数名经 filter_fn 处理后返回 True 的元素。

返回类型:FunctionCounts

python

transform(map_fn)对所有函数名称应用map_fn映射。

该功能可用于:

- 规范化函数名称(例如去除文件路径中的无关部分)

- 通过将多个函数映射到相同名称来合并条目(此时计数会累加)

返回类型:

FunctionCounts

python

class torch.utils.benchmark.Compare(results)用于以格式化表格形式展示多项测量结果的辅助类。

该表格格式基于 torch.utils.benchmark.Timer 提供的信息字段(description、label、sub_label、num_threads 等)。

可通过 print() 直接打印表格,或转换为字符串。

完整使用教程请参阅:

https://pytorch.org/tutorials/recipes/recipes/benchmark.html

参数

results (list[torch.utils.benchmark.utils.common.Measurement])-- 待展示的 Measurement 对象列表

python

colorize(rowwise=False)为格式化表格添加颜色。

默认按列着色。

python

extend_results(results)将结果追加到已存储的数据中。

所有添加的结果必须是 Measurement 的实例。

python

highlight_warnings()启用格式化表格构建时的警告高亮功能。

python

print()打印格式化表格

python

trim_significant_figures()在构建格式化表格时启用有效数字的截断功能。

torch.utils.bottleneck

torch.utils.bottleneck 是一个工具,可作为程序性能瓶颈调试的初步步骤。它会结合 Python 分析器和 PyTorch 的自动梯度分析器来汇总脚本的运行情况。

在命令行中通过以下方式运行:

shell

python -m torch.utils.bottleneck /path/to/source/script.py [args]其中[args]是传递给script.py的任意数量参数,或运行python -m torch.utils.bottleneck -h获取更多使用说明。

警告:由于脚本将被性能分析,请确保它能在有限时间内退出。

警告:由于CUDA内核的异步特性,在分析CUDA代码时,cProfile输出和CPU模式的自动梯度分析器可能无法显示正确的时间:报告的CPU时间仅包含内核启动耗时,除非操作执行了同步,否则不会包含内核在GPU上的实际执行时间。

在常规CPU模式分析器下,执行同步的操作会显得极其耗时。

当出现计时不准确的情况时,CUDA模式的自动梯度分析器可能会有所帮助。

注意:要决定查看哪种(仅CPU模式或CUDA模式)自动梯度分析器输出,首先应检查脚本是否受CPU限制("CPU总时间远大于CUDA总时间")。

如果是CPU受限,查看CPU模式分析器的结果将有所帮助。反之,如果脚本大部分时间在GPU上执行,则应开始查看CUDA模式分析器输出中相关的CUDA算子。

当然实际情况更为复杂,根据模型评估部分的不同,脚本可能不处于这两种极端情况。如果分析器输出没有帮助,可以尝试结合nvprof查看torch.autograd.profiler.emit_nvtx()的结果。

但请注意NVTX的开销非常高,通常会导致时间线严重失真。类似地,Intel® VTune™ Profiler可通过torch.autograd.profiler.emit_itt()进一步分析Intel平台的性能。

警告:如果分析CUDA代码,bottleneck运行的第一个分析器(cProfile)会在时间报告中包含CUDA启动时间(CUDA缓冲区分配成本)。当瓶颈导致的代码延迟远大于CUDA启动时间时,这通常不会产生影响。

关于分析器更复杂的用法(如多GPU场景),请参阅https://docs.python.org/3/library/profile.html或torch.autograd.profiler.profile()获取更多信息。

torch.utils.checkpoint

注意:检查点机制通过在反向传播期间重新运行每个检查点段的前向传播段来实现。这可能导致持久状态(如RNG随机数生成器状态)比不使用检查点时更超前。默认情况下,检查点包含处理RNG状态的逻辑,使得使用RNG的检查点传递(例如通过dropout)与非检查点传递相比具有确定性输出。根据检查点操作的运行时情况,保存和恢复RNG状态的逻辑可能会带来中等性能损耗。如果不需要与非检查点传递相比的确定性输出,可以向checkpoint或checkpoint_sequential传入preserve_rng_state=False来省略每次检查点时对RNG状态的保存和恢复。

该保存逻辑会为CPU和另一种设备类型(通过_infer_device_type从非CPU张量参数推断设备类型)向run_fn保存并恢复RNG状态。如果存在多个设备,仅会保存单一设备类型的设备状态,其余设备将被忽略。因此,如果任何检查点函数涉及随机性,这可能导致梯度计算错误。(注意:如果检测到CUDA设备,将优先处理;否则会选择遇到的第一个设备。)如果没有CPU张量,将保存和恢复默认设备类型状态(默认值为cuda,可通过DefaultDeviceType设置为其他设备)。

但该逻辑无法预知用户是否会在run_fn内部将张量移动到新设备。因此,如果在run_fn内将张量移动到新设备("新"指不属于[当前设备+张量参数设备集合]),与非检查点传递相比的确定性输出将永远无法得到保证。

python

torch.utils.checkpoint.checkpoint(function, *args, use_reentrant=None, context_fn=<function noop_context_fn>, determinism_check='default', debug=False, **kwargs)对模型或部分模型进行检查点保存。

激活检查点是一种用计算资源换取内存空间的技术。在检查点区域的前向计算中,不会保存用于反向传播的张量,而是在反向传播时重新计算这些张量,而不是将它们一直保留到梯度计算时才使用。激活检查点可以应用于模型的任何部分。

目前有两种检查点实现方式,由use_reentrant参数决定。建议使用use_reentrant=False。关于两者差异的讨论,请参考下文说明。

警告 :如果在反向传播过程中function的调用与前向传播不同(例如由于全局变量导致),检查点版本可能不等价,可能会引发错误或导致梯度计算静默错误。

警告 :必须显式传递use_reentrant参数。在2.4版本中,如果未传递该参数将会抛出异常。如果使用use_reentrant=True变体,请参考下文说明了解重要注意事项和潜在限制。

说明 :可重入检查点(use_reentrant=True)与非可重入检查点(use_reentrant=False)存在以下差异:

-

非可重入检查点会在所有需要的中间激活值重新计算完成后立即停止。此功能默认启用,但可通过

set_checkpoint_early_stop()禁用。 -

可重入检查点在反向传播时会完整地重新计算整个

function。 -

可重入变体在前向传播时不记录autograd计算图,因为它在前向传播时运行在

torch.no_grad()模式下。非可重入版本会记录autograd计算图,允许在检查点区域内对计算图执行反向传播。 -

可重入检查点仅支持不带输入参数的

torch.autograd.backward()API进行反向传播,而非可重入版本支持所有反向传播方式。 -

可重入变体要求至少有一个输入和输出具有

requires_grad=True。如果不满足此条件,模型的检查点部分将没有梯度。非可重入版本没有此要求。 -

可重入版本不认为嵌套结构中的张量(如自定义对象、列表、字典等)参与autograd计算,而非可重入版本则认为参与。

-

可重入检查点不支持计算图中分离张量的检查点区域,而非可重入版本支持。对于可重入变体,如果检查点段包含使用

detach()或torch.no_grad()分离的张量,反向传播将引发错误。这是因为checkpoint会使所有输出都需要梯度,当模型中定义不需要梯度的张量时会导致问题。为避免此问题,应在checkpoint函数外部分离张量。

参数说明

function- 描述模型或部分模型在前向传播中运行的内容。它还应知道如何处理作为元组传递的输入。例如在LSTM中,如果用户传递(activation, hidden),function应正确使用第一个输入作为activation,第二个输入作为hiddenpreserve_rng_state ([bool], 可选)- 是否在每个检查点期间省略保存和恢复RNG状态。注意在torch.compile下,此标志不生效,我们始终保留RNG状态。默认值:Trueuse_reentrant ([bool])- 指定是否使用需要可重入autograd的激活检查点变体。必须显式传递此参数。在2.5版本中,如果未传递该参数将会抛出异常。如果use_reentrant=False,checkpoint将使用不需要可重入autograd的实现,从而支持更多功能,如与torch.autograd.grad正常配合工作,并支持向检查点函数输入关键字参数。context_fn (Callable, 可选)- 返回两个上下文管理器元组的可调用对象。函数及其重新计算将分别在第一个和第二个上下文管理器下运行。仅当use_reentrant=False时支持此参数。determinism_check (str, 可选)- 指定确定性检查的字符串。默认为"default",会比较重新计算张量与保存张量的形状、数据类型和设备。要关闭此检查,请指定"none"。目前仅支持这两个值。如需更多确定性检查,请提交issue。仅当use_reentrant=False时支持此参数,若use_reentrant=True则始终禁用确定性检查。debug ([bool], 可选)- 如果为True,错误信息还将包含原始前向计算和重新计算期间运行的操作符追踪。仅当use_reentrant=False时支持此参数。args- 包含function输入参数的元组

返回值

运行function在*args上的输出结果

python

torch.utils.checkpoint.checkpoint_sequential(functions, segments, input, use_reentrant=None, **kwargs)对顺序模型进行检查点保存以节省内存。

顺序模型会按顺序执行一系列模块/函数(即顺序执行)。因此,我们可以将这类模型划分为多个片段,并对每个片段设置检查点。除最后一段外,其他片段都不会存储中间激活值。每个检查点片段的输入会被保存,以便在反向传播时重新运行该片段。

警告:必须显式传递 use_reentrant 参数。在 2.4 版本中,如果没有传递该参数,我们将抛出异常。

如果使用 use_reentrant=True 的变体,请参阅 :func:~torch.utils.checkpoint.checkpoint 了解该变体的重要注意事项和限制。建议使用 use_reentrant=False。

参数