告别参数"炼丹",拥抱节点式"魔法"!这篇超详细的 ComfyUI 入门指南,从软件介绍、本地搭建到基础使用,手把手带你打开 AI 绘画新世界的大门。更高效、更自由、更强大,快来释放你的创造力!

Github:github.com/comfyanonym...

还在为 Stable Diffusion 复杂的参数设置而头疼吗?还在羡慕大神们能创造出各种惊艳的AI绘画作品,而自己却在"炼丹"的道路上屡屡受挫?

今天,就给大家介绍一款颠覆传统 的AI绘画工具------ComfyUI!它正以其独特的魅力,席卷整个AI绘画社区。

ComfyUI 是什么?

简单来说,ComfyUI 是一个基于节点式 用户界面的 Stable Diffusion GUI(图形用户界面)。相较于我们熟知的 Automatic1111(WebUI),ComfyUI 拥有以下核心优势:

- 极致的性能与效率: ComfyUI 在底层逻辑上进行了大量优化,只重新执行工作流中发生变化的部分。这意味着在调整参数后,它能以更快的速度生成图片,大大节省显存和时间。

- 无与伦比的灵活性和可定制性: 节点式的设计让你能够完全掌控AI绘画的每一个细节。你可以自由组合、拆分、重组流程,实现各种天马行空的创意,比如复杂的模型串联、LoRA的精细控制、视频生成等。

- 清晰直观的工作流: 整个图像生成过程一目了然,非常有助于理解 Stable Diffusion 的工作原理。对于新手来说,它是一个绝佳的学习工具;对于高级玩家,它则是实现复杂创作的利器。

本地搭建:三步搞定 ComfyUI

心动不如行动!ComfyUI 的本地部署非常简单,尤其是对于Windows用户,官方提供了"一键启动包",无需配置复杂的Python环境。

Windows、MacOS 用户(推荐"一键安装包")

-

下载安装包:

访问 ComfyUI官网,根据系统版本下载对应的安装包。

-

双击运行:

按照系统的环境,根据

ComfyUI的引导信息进行配置。

Linux 用户

对于 Linux 用户,部署过程需要一些命令行操作,但同样不复杂,官方文档。

-

安装 Git 和 Anaconda:

请确保你的系统中安装了 Git 和 Conda。

-

克隆仓库:

打开你的终端,使用以下命令克隆 ComfyUI 的代码仓库:

bashgit clone https://github.com/comfyanonymous/ComfyUI.git -

安装依赖:

进入 ComfyUI 目录并安装所需的依赖包:

bashconda create -n comfy conda activate comfy cd ComfyUI pip install -r requirements.txt -

运行:

在终端中运行以下命令启动:

bashpython main.py启动成功后,在浏览器中访问

http://127.0.0.1:8188。

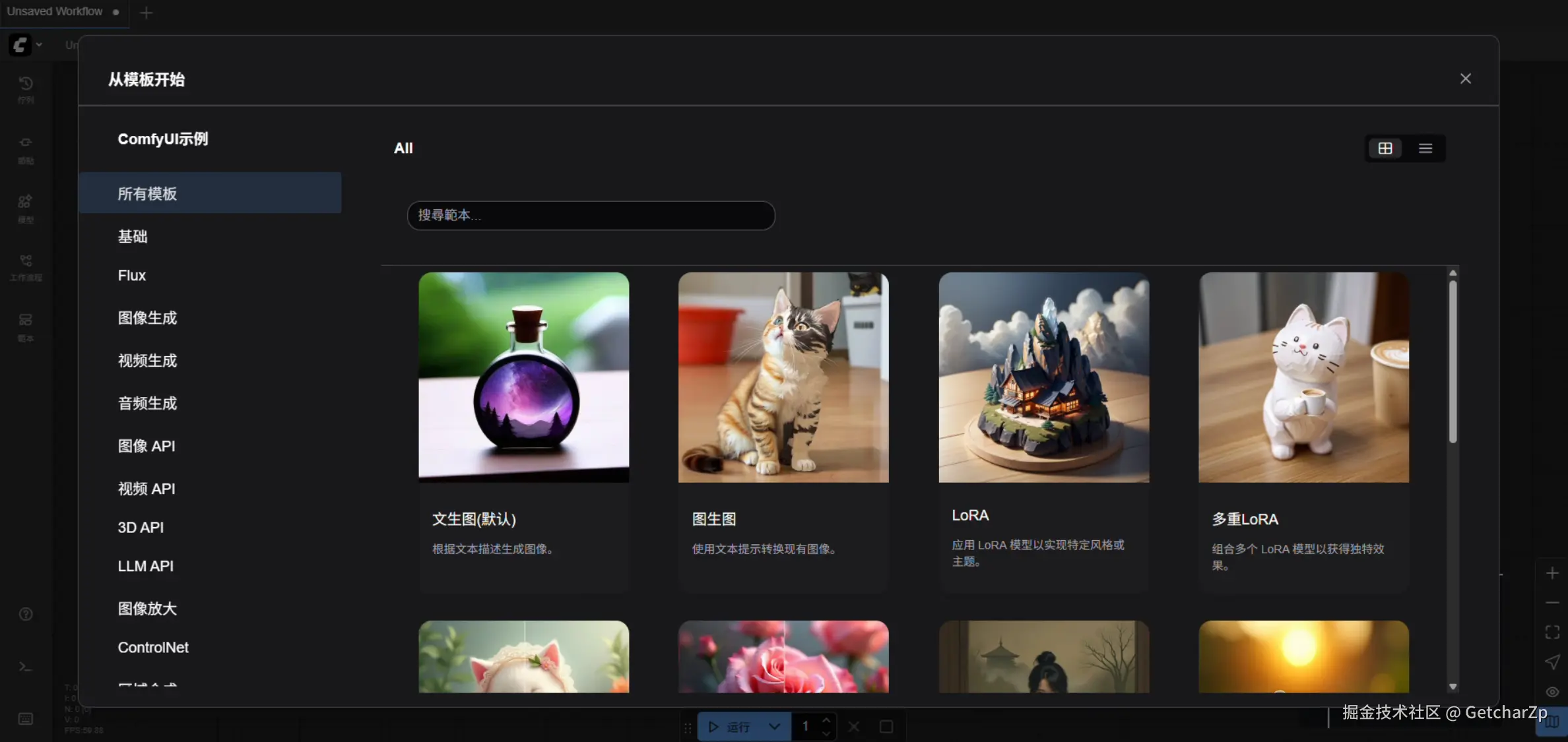

快速上手:你的第一张 ComfyUI 作品

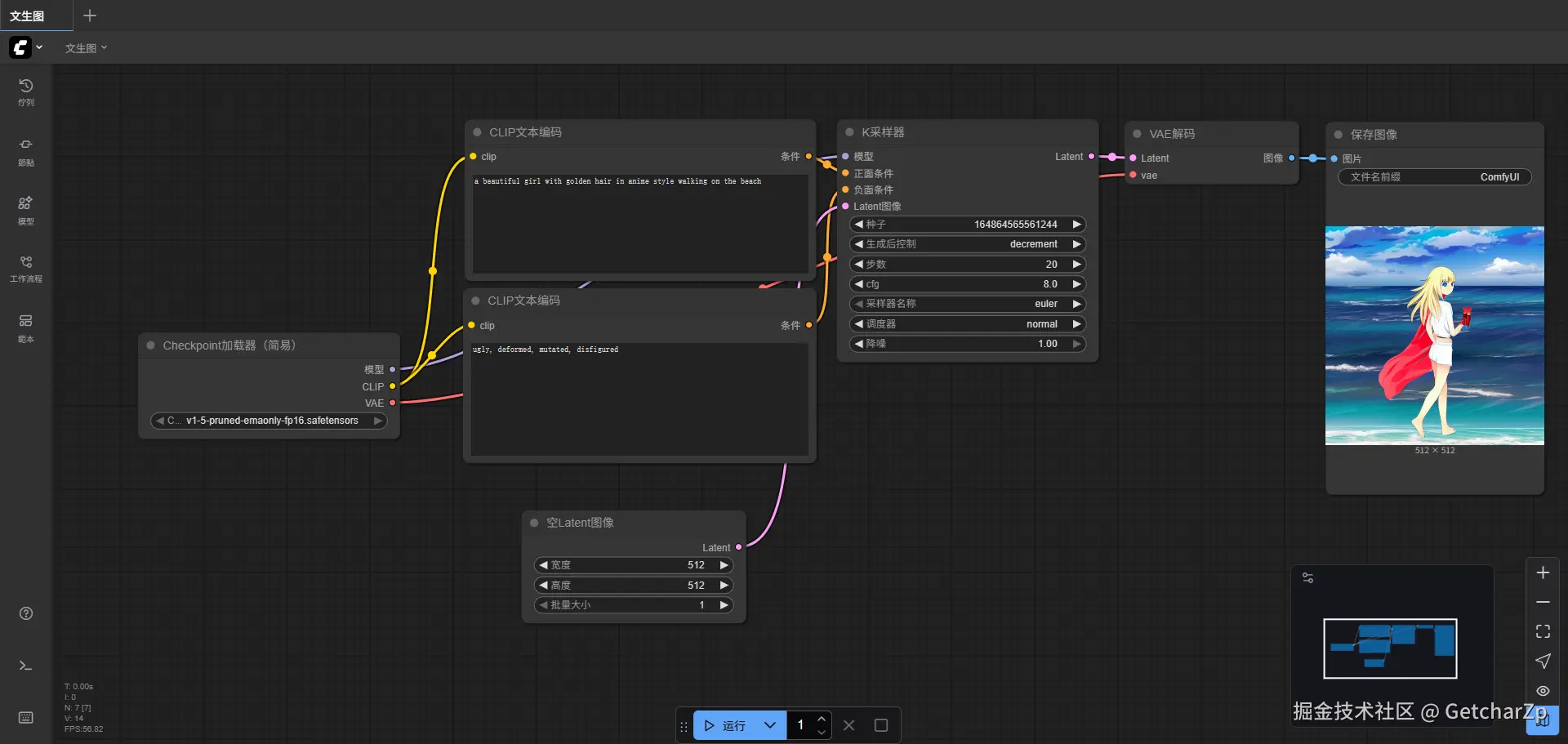

当你第一次打开 ComfyUI,会看到一个默认的"文生图"工作流。让我们来快速解读并生成第一张图片。

默认工作流主要包含以下几个核心节点:

-

Load Checkpoint: 这是你的起点。第一次进来的时候没有模型,ComfyUI 会提示你下载模型,模型下载完成后,将其上传到

ComfyUI/models/checkpoints目录下。 -

CLIP Text Encode (Prompt): 这就是提示词输入框。上面的是正向提示词 (你想要生成的画面内容),下面的是负向提示词(你不希望出现的元素)。

txt# 正向提示词(一个漂亮的金色头发的女孩) a beautiful girl with golden hair in anime style walking on the beach # 负向提示词(丑陋的,畸形的,变异的,毁容的) ugly, deformed, mutated, disfigured -

Empty Latent Image: 在这里可以设置生成图片的尺寸(宽高)。注意,尺寸最好与你使用的模型所建议的尺寸匹配(例如SD1.5模型常用512x512,SDXL模型常用1024x1024)。

-

KSampler: 这是核心的采样器节点。你可以在这里调整步数(steps)、CFG(提示词相关性)、采样器名称(sampler_name)等关键参数。对于初学者,可以暂时保持默认设置。

-

VAE Decode & Save Image: 这两个节点负责将AI在潜在空间计算的数据"解码"成我们能看到的图片,并将其保存到

ComfyUI/output文件夹中,同时也会在界面右侧预览。

现在,开始创作吧!填写提示词,点击 运行 。

结语

恭喜你,已经成功迈出了探索 ComfyUI 的第一步!

今天我们所体验的,仅仅是 ComfyUI 强大功能的冰山一角。它的真正魅力在于,你可以通过添加更多的节点(例如 ControlNet、LoRA、图像缩放等)来构建出无限复杂的个性化工作流。现在,就去尽情探索,连接属于你自己的"魔法"节点,释放无限的创造力吧!