Linux 系统调优工具详解

内容概览

本章重点介绍了 Linux 系统性能调优的核心工具,涵盖 CPU、内存、磁盘 I/O 和网络四大子系统。关键在于掌握工具的使用方法 并理解各子系统指标间的相互影响。

核心工具 :top, mpstat, free, iostat, iotop, nethogs, vmstat, sar

预备工作 :确保已安装 sysstat (包含 iostat, mpstat, sar), iotop, nethogs, nload 软件包。

1. CPU 性能分析

核心指标

-

负载:单位时间内系统平均活跃进程数(可运行+不可中断)

-

使用率 :用户态(

%usr)、内核态(%sys)、I/O等待(%iowait)、空闲(%idle)

关键工具与命令

| 工具/命令 | 主要功能与用途 | 常用命令示例 | 解读要点 |

|---|---|---|---|

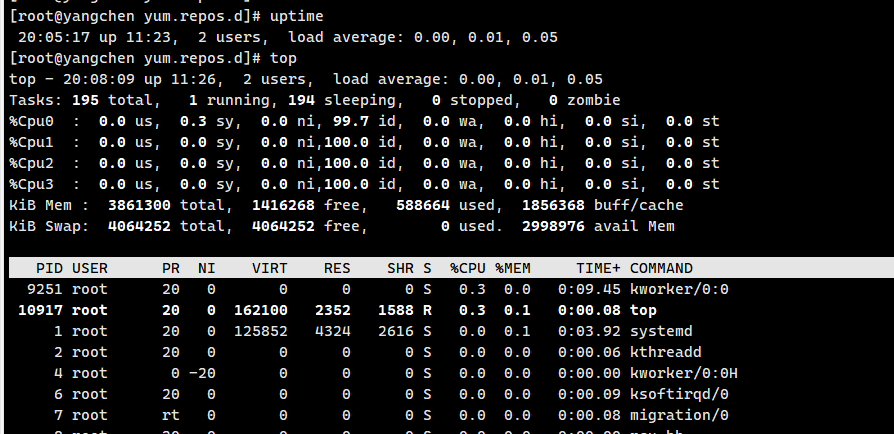

uptime |

查看系统平均负载 | uptime |

1/5/15分钟负载趋势。若1分钟值持续 > CPU核心数,表示可能过载。 |

top |

实时监控系统进程和资源 | top -> 按 P |

动态视图。按P依CPU使用率排序,快速定位高CPU进程。 |

ps |

查看进程快照 | `ps -aux --sort -pcpu | head -10` |

mpstat |

查看每个CPU核心的详细统计 | mpstat -P ALL 1 5 |

查看所有CPU核心(-P ALL)的详细分布。高%iowait 可能预示磁盘瓶颈;**高%sys**可能系统调用频繁。 |

2. 内存性能分析

核心指标

-

可用内存 :

available(包括可回收的缓存/缓冲区) -

使用情况 :活跃(

Active)、非活跃(Inactive,可被换出)

关键工具与命令

| 工具/命令 | 主要功能与用途 | 常用命令示例 | 解读要点 |

|---|---|---|---|

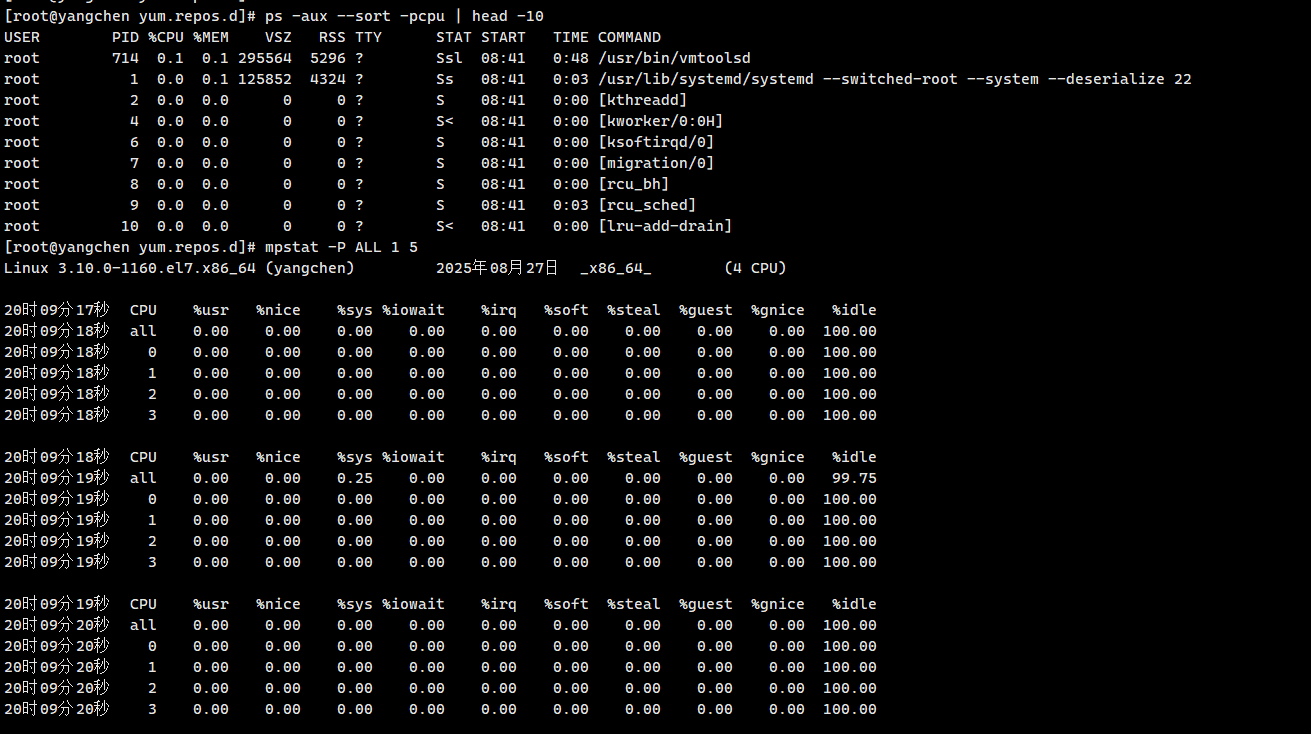

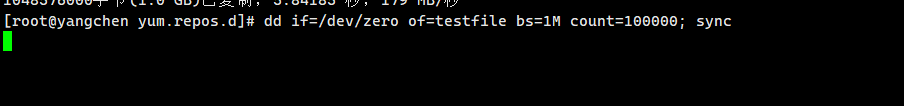

free |

查看内存总量和使用情况 | free -m (以MB显示) |

关注 available 列,这是估算的可用内存。 |

/proc/meminfo |

查看内核内存状态的详细数据 | cat /proc/meminfo |

包含所有内存指标的详细信息。关注Active/Inactive。 |

top |

实时监控 | top -> 按 M |

按M依内存使用(RES)降序排列。 |

ps |

查看进程内存使用快照 | `ps -aux --sort -rss | head -10` |

-`%usr`:用户空间CPU占比;

-

`%sys`:内核空间CPU占比;

-

`%iowait`:等待I/O占比;

-

`%idle`:空闲占比。

-

`Active`:活跃内存;

-

`Inactive`:非活跃内存(可被换出)。

3. 磁盘 I/O 性能分析

核心概念与指标

-

块大小:文件系统读写的基本单位 (e.g., 4KiB)

-

吞吐量 :读写速率 (

kB_read/s,kB_wrtn/s) -

利用率:磁盘忙于处理I/O请求的时间百分比

关键工具与命令

| 工具/命令 | 主要功能与用途 | 常用命令示例 | 解读要点 |

|---|---|---|---|

tune2fs/xfs_growfs |

查看文件系统块大小 | `tune2fs -l /dev/sda1 | grep "Block size" xfs_growfs -l /dev/sda1 |

iostat |

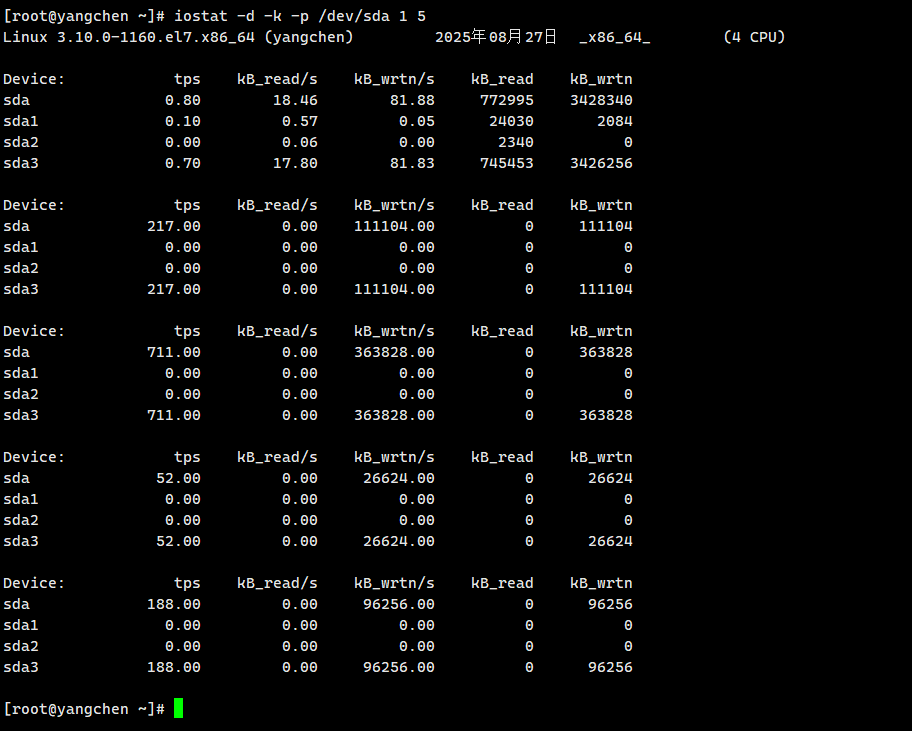

查看磁盘I/O统计 | iostat -d -k -p /dev/sda 1 5 |

查看指定磁盘(-p /dev/sda)的吞吐量(kB_read/s, kB_wrtn/s) 和利用率(%util)。 |

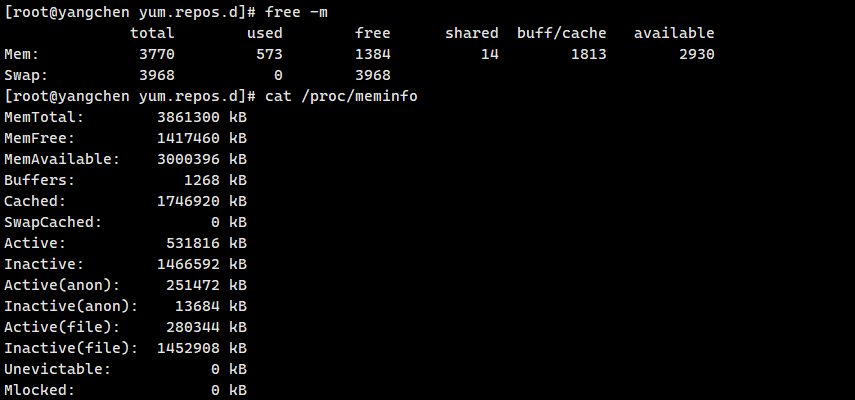

dd |

磁盘性能简单测试 | dd if=/dev/zero of=testfile bs=1M count=1000; sync |

测试顺序写入速度。需配合sync 确保数据落盘。结果需结合iostat观看。 |

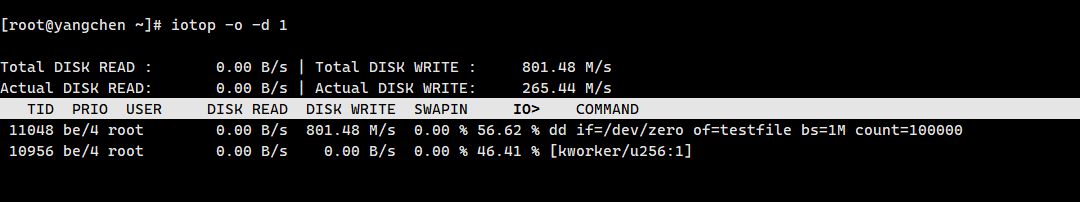

iotop |

监控进程级磁盘I/O | iotop -o -d 1 (需root) |

-o 只显示有I/O活动的进程。实时查看哪个进程在大量读写磁盘。 |

dd if=/dev/zero of=testfile:使用dd命令从/dev/zero(一个源源不断输出 0 字节的特殊设备)读取数据,写入到名为testfile的文件中

bs=1M:设置每次读写的块大小为 1MB

count=1000:设置读写的块数量为 1000,所以总文件大小是 1MB×1000=1000MB(约 1GB)

; sync:分号分隔两个命令,sync用于将内存中的数据强制刷新到磁盘,确保文件真正写入硬盘

-

`kB_read/s`:每秒读取数据量;

-

`kB_wrtn/s`:每秒写入数据量。

4. 网络性能分析

核心指标

-

带宽 :接收(

rxkB/s)/发送(txkB/s)速率 -

包量 :接收(

rxpck/s)/发送(txpck/s)的包数量

关键工具与命令

| 工具/命令 | 主要功能与用途 | 常用命令示例 | 解读要点 |

|---|---|---|---|

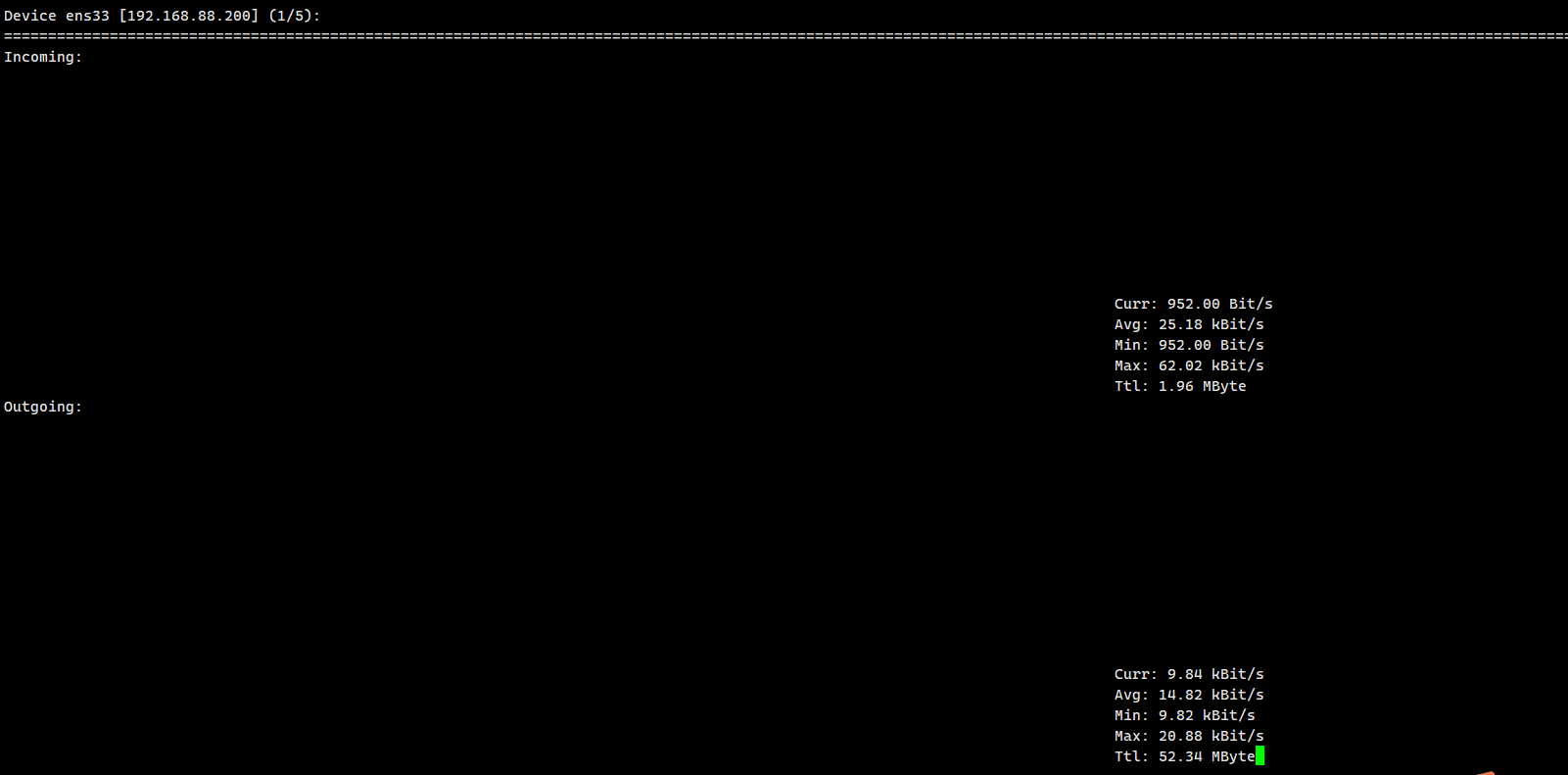

nload |

实时监控网络带宽 | nload |

直观显示每个网卡的实时流入(Incoming)/流出(Outgoing)流量。 |

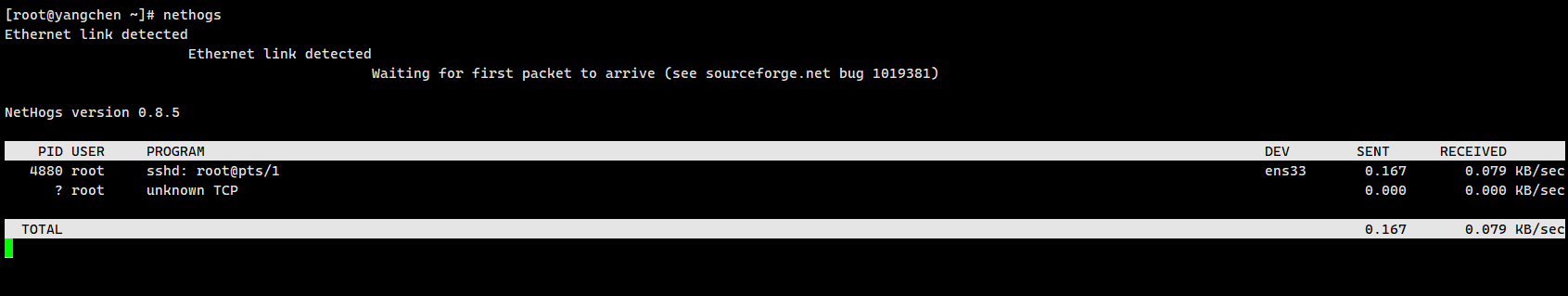

nethogs |

监控进程级网络带宽 | nethogs (需root) |

实时查看每个进程占用的网络带宽。 |

sar |

查看历史网络流量 | sar -n DEV 1 5 |

**-n DEV**查看网络设备指标。可用于查看历史记录。 |

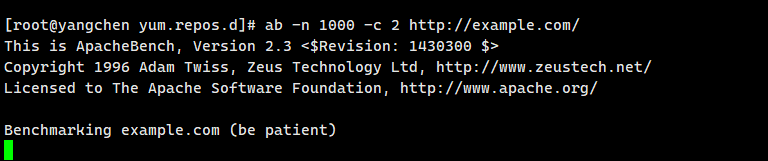

ab |

HTTP服务压力测试 | ab -n 1000 -c 2 http://example.com/ |

-n 总请求数,**-c**并发数。测试Web服务性能。 |

实时网络流量状态 (Incoming/Outgoing)

指标 值 说明

当前速率 (Curr) 41.12 kBit/s 瞬时接收速率

平均速率 (Avg) 166.04 kBit/s 本次会话的平均接收速率

最小速率 (Min) 3.49 kBit/s 本次会话的最小接收速率

最大速率 (Max) 1.33 MBit/s 本次会话的最大接收速率 (峰值)

总数据量 (Ttl) 81.77 MByte 本次会话累计接收的总数据量

5. 系统整体状态分析

核心工具

| 工具/命令 | 主要功能与用途 | 常用命令示例 | 关键指标解读 |

|---|---|---|---|

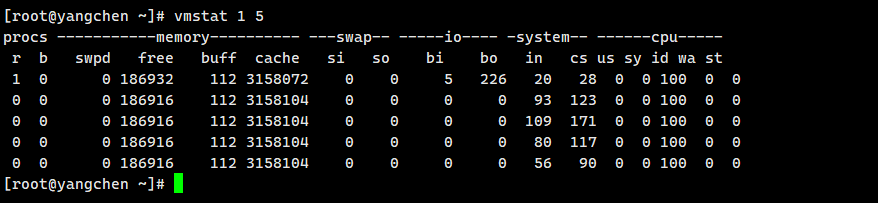

vmstat |

报告虚拟内存、进程、CPU、I/O整体状态 | vmstat 1 5 |

r : 运行队列长度(>CPU数则饱和) b : 阻塞进程数(>0可能有I/O瓶颈) si/so : Swap换入/换出(>0表示内存不足) bi/bo : 块设备读/写(磁盘I/O量) wa: I/O等待CPU时间(%)(>20%可能I/O瓶颈) |

sar |

系统活动报告器,系统监控全能王者 | sar -u 2 5 -o cpu.sar sar -r 1 5 sar -n DEV 1 5 |

1. 记录 (-o):保存数据以备后查 2. 查看CPU(-u)、内存(-r)、网络(-n DEV) 等 3. 查看历史 :sar -f /var/log/sa/sa15 |

r:等待运行的进程数(如果长期大于 CPU 核心数,说明 CPU 不够用)

b:处于不可中断睡眠的进程数(通常是等待 I/O,数值高说明 I/O 繁忙)

si/so:每秒从 swap 分区读入 / 写入内存的数据量(非 0 说明内存不足,开始用交换分区)

bi/bo:每秒从块设备读入 / 写入的数据量(反映磁盘 I/O 活动)

wa:CPU 等待 I/O 的时间百分比(超过 20% 说明 I/O 成为瓶颈)

us/sy:用户态 / 内核态占用 CPU 的百分比(us 高说明应用消耗 CPU 多,sy 高可能是系统调用频繁)

id:CPU 空闲百分比(过低说明 CPU 负载高)

6.CPU 资源调优

调整进程优先级(nice 值)

你已准确理解了nice和renice的作用和用法。需要强调的是:

-

权限限制 :普通用户只能降低优先级(增大

nice值)。设置负值(提高优先级)必须使用root权限。16 -

实时进程 :

nice值对 Linux 实时调度策略 (如SCHED_FIFO,SCHED_RR) 的进程无效,它们的优先级更高。

设置 CPU 亲和力(taskset)

你提供的命令是正确的。绑定CPU核心(CPU Affinity)在以下场景特别有用:

-

CPU缓存友好性:进程在固定的CPU核心上运行,可以更有效地利用该核心的各级缓存,减少缓存失效(cache miss)。

-

避免上下文切换开销:减少进程在多个核心之间迁移带来的性能损耗。

-

隔离关键进程:将某个关键应用(如数据库、高速网络处理进程)绑定到专用核心,避免其他进程干扰。

使用 vmstat 分析系统瓶颈

vmstat 是快速判断系统整体瓶颈的利器。你提到的关键指标非常到位,我们再来深化一下解读方法:

-

如果

r列数值持续超过系统的CPU逻辑核心数,说明CPU资源可能已饱和。 -

us和sy的比例可以帮助判断负载类型:高us说明应用本身占CPU多;高sy则说明系统调用、中断处理、内核任务等占用了大量CPU。 -

wa(I/O Wait)是关键中的关键 。如果它持续很高(例如超过20%),即使id(空闲)很低,也往往意味着瓶颈在磁盘I/O,而不是CPU。此时盲目增加CPU资源效果不大。

理解 /proc/cpuinfo

你提供的解读非常全面。对于调优而言,我们通常最关心:

-

核心数量 :通过

processor的数量了解可用的逻辑CPU数(包括超线程核心)。 -

指令集(flags) :某些高性能应用或库(如科学计算、视频编码)会依赖特定的指令集(如

AVX2)。确认CPU支持这些指令集可以确保软件能发挥最佳性能。

| 调优方向 | 核心目标 | 关键配置/命令示例 | 注意事项 |

|---|---|---|---|

| CPU 资源调优 | 合理分配CPU时间,提升关键任务响应 | nice -n -5 vim, renice -n 6 24318, taskset -c 0 vim |

nice值负数需root权限,绑定CPU需考虑负载均衡 |

| 磁盘 I/O 调优 | 最大化磁盘吞吐量,减少I/O等待 | ulimit -n 10000, hdparm -t --direct /dev/sda, dd测试 |

dd测试会破坏目标文件,注意数据安全 |

| 内核网络调优 | 提升网络吞吐,增强安全与稳定性 | net.ipv4.tcp_syncookies=1, net.ipv4.tcp_max_syn_backlog=2048038, fs.file-max=819200 |

修改需sysctl -p生效,部分参数需重启 |

接下来,我们对每个部分进行更详细的解读。

7.磁盘 I/O 调优

ulimit 资源限制

你正确指出了配置文件和查看命令。需要补充的是:

-

生效范围 :修改

/etc/security/limits.conf后,通常需要用户重新登录(或重启相关服务)才能对新会话生效。5 -

全局限制 :

/proc/sys/fs/file-max定义了整个系统 可以打开的文件句柄总数,ulimit设置的是单个进程或用户的限制。确保前者大于后者。510 -

/proc/sys/fs/file-nr:这个文件动态显示了当前系统文件句柄的使用情况(已分配、已使用、最大值),是实时监控的好帮手。10

测试磁盘速度

你提供的测试命令很好。

-

hdparm -t:测试的是缓存和缓冲的读取速度,结果可能偏高,更多反映的是从缓存读取的能力。 -

hdparm -t --direct:如你所说,绕过缓存,测试的是磁盘原始的读取速度,更真实。 -

dd命令的注意事项:-

oflag=direct:同样是为了绕过系统缓存,得到更真实的磁盘顺序写入性能。 -

谨慎选择

of(输出文件)目标 :最好是一个新挂载的、空闲的文件系统,避免影响现有数据。不要直接在重要数据目录下运行,测试完成后记得删除生成的大文件。 -

dd的局限性 :dd主要测试顺序读写 性能。数据库、小文件操作等随机读写 场景,性能可能截然不同,建议使用fio工具进行更全面的测试。

-

8.内核参数调优

防御 SYN 洪水攻击 & 网络性能

你列出的 /etc/sysctl.conf 参数组合非常经典,常用于Web服务器、负载均衡器等网络密集型服务。我们来深入理解几个关键参数:

| 参数 | 建议值 | 作用说明 | 参考来源 |

|---|---|---|---|

net.ipv4.tcp_syncookies |

1 |

启用 SYN Cookie 。在半连接队列满时,用于防范 SYN Flood 攻击。49 即使没有明显攻击,对高负载服务器也建议开启。 | 49 |

net.ipv4.tcp_max_syn_backlog |

20480 |

增大半连接队列(SYN Queue) 的长度。允许存放更多等待完成三次握手的连接。38 | 38 |

net.core.somaxconn |

65535 |

增大全连接队列(Accept Queue) 的长度。允许存放更多已被内核完成三次握手、正等待应用程序(如Nginx)accept() 取走的连接。9 应用程序的监听 backlog 参数(如Nginx的backlog)不能大于此值。 |

9 |

net.ipv4.tcp_tw_reuse |

1 |

允许内核复用处于 TIME-WAIT 状态的连接 给新的出向TCP连接。有助于减少高并发短连接场景下的TIME-WAIT连接数,缓解端口资源紧张。38 | 38 |

net.ipv4.ip_local_port_range |

10000 65535 |

扩大本地端口的可用范围 。为出向连接(如程序连接数据库、Redis等)提供更多可用端口,配合tcp_tw_reuse/recycle应对高并发短连接。 |

|

fs.file-max |

819200 |

增加系统全局最大文件句柄数。510 高并发网络连接会消耗大量文件句柄。 | 510 |

net.core.rmem_max, net.core.wmem_max |

增加TCP socket 读写缓冲区的最大大小 。9 对于长连接或高带宽延迟积(BDP)的网络(如高速公网),适当调大有助于提升吞吐。但过大会增加内存消耗。 | 9 |

关于 net.ipv4.tcp_tw_recycle:

该参数曾用于快速回收 TIME-WAIT 状态的连接套接字。但在 NAT(网络地址转换)环境下可能导致问题 (例如,部分用户连接失败)。**在新版本内核中已被移除,不应再使用。**38

如何应用和生效

-

备份 :修改前备份

/etc/sysctl.conf文件。 -

编辑 :使用

vim等编辑器修改或添加参数。 -

生效 :运行

sudo sysctl -p使修改立即生效。7 -

验证 :使用

sysctl <参数名>或查看/proc/sys/下对应的文件来确认新值已应用。

总结与建议

-

循序渐进,监控为先 :调优前、后,务必使用

vmstat,iostat,sar,netstat等工具监控系统指标,确保证据变化符合预期。不要一次性修改大量参数。 -

参数并非万能 :内核参数的优化能解决一部分问题,但根本性能取决于硬件资源和应用架构。如果应用本身效率低下,参数调优的效果会很有限。

-

理解业务场景:根据服务器的具体角色(Web、DB、文件存储等)进行针对性调优。没有一套配置能适合所有场景。

-

稳定性第一 :在生产环境修改任何内核参数前,务必在测试环境进行充分验证。

总结与关联性理解 (难点)

-

全局视野 :不要孤立地看一个指标。使用

vmstat或sar等工具获取系统整体视图。 -

因果关系:

-

高CPU

%iowait(mpstat) + 高wa(vmstat) + 长运行队列(vmstat r) -> 很可能是因为磁盘I/O (iostat) 成为瓶颈,导致进程等待。 -

内存不足 (

freeavailable少) -> 会引发Swap使用 (vmstatsi/so) -> 导致磁盘I/O压力增大 (iostat) -> 进一步导致CPU I/O等待升高 (mpstat%iowait),形成恶性循环。 -

网络流量激增 (

nload,sar -n DEV) -> 可能消耗大量CPU资源处理协议栈(mpstat %sys)。

-

-

分析流程:

-

uptime,top快速定位大致方向 (CPU负载高?内存快满了?) -

使用

vmstat或sar确认整体状态,判断瓶颈可能出现在哪个子系统。 -

使用专项工具 (

iostat,iotop,nethogs,free) 深入分析可疑子系统。 -

结合进程查看工具 (

top,ps,iotop,nethogs) 定位到具体问题进程。

-