1. 引言

在机器学习领域中,模型的泛化能力一直是研究的核心问题。一个优秀的机器学习算法不仅要在训练数据上表现良好,更重要的是要在未见过的新数据上保持良好的性能。然而,在实际应用中,我们经常面临着一个关键的挑战:如何在模型复杂度和泛化能力之间找到最佳的平衡点。这个问题的核心涉及到三个基本概念:容量(Capacity)、欠拟合(Underfitting)和过拟合(Overfitting)。

容量是衡量模型能够拟合各种复杂函数能力的重要指标。它决定了模型能够学习的函数的复杂程度和多样性。当模型容量过低时,可能无法充分学习训练数据中的模式,导致欠拟合;而当容量过高时,模型可能会过度拟合训练数据,包括其中的噪声,从而导致过拟合。理解这些概念及其相互关系对于设计有效的机器学习系统至关重要。

本文将深入探讨这些基本概念,从理论基础出发,结合数学推导和实际案例,全面分析容量、欠拟合与过拟合的本质特征、产生原因以及解决方案。我们将从统计学习理论的角度解释这些现象,探讨偏差-方差权衡的数学原理,并介绍各种正则化技术的工作机制。同时,我们还会讨论这些概念在深度学习中的特殊表现和应对策略。

2. 容量的基本概念与理论基础

2.1 容量的定义与重要性

在机器学习中,模型的容量(Capacity)是一个描述模型学习能力范围的基本概念。通俗地说,容量反映了模型拟合各种复杂函数的能力。高容量的模型能够学习复杂的、变化剧烈的函数,而低容量的模型只能学习相对简单、变化平缓的函数。

从数学角度来看,假设我们有一个假设空间H,它包含了学习算法可能选择的所有函数。模型的表示容量(Representational Capacity)就是这个假设空间中函数的丰富程度。例如,对于线性回归模型,其假设空间包含所有形如下式的线性函数:

f(x; \\theta) = \\theta\^T x + b

其中是权重向量,b是偏置项。这个假设空间的容量相对较低,因为它只能表示线性关系。

相比之下,如果我们考虑多项式回归模型,其假设空间包含所有d次多项式:

f(x; \\theta) = \\sum_{i=0}\^{d} \\theta_i x\^i

随着次数d的增加,模型的容量也随之增加,因为它能够拟合更加复杂的非线性关系。

2.2 有效容量与表示容量的区别

在实际应用中,我们需要区分两种不同类型的容量:表示容量和有效容量。表示容量是由模型架构决定的理论上限,而有效容量(Effective Capacity)则受到优化算法性能的限制。

表示容量定义了模型在理论上能够表示的函数范围。例如,一个具有足够多参数的神经网络理论上可以逼近任何连续函数(万能逼近定理),这就是其表示容量。然而,在实际训练过程中,由于优化算法的限制、计算资源的约束以及训练数据的有限性,模型可能无法达到其理论上的最大容量。这种实际能够实现的容量就是有效容量。

有效容量与多个因素相关:

-

优化算法的效率:不同的优化算法具有不同的收敛特性和搜索能力。例如,梯度下降算法可能陷入局部最优解,从而限制了模型的有效容量。

-

训练数据的质量和数量:训练数据的分布和规模直接影响模型能够学习的复杂度。

-

正则化技术:各种正则化方法会主动限制模型的有效容量,以提高泛化性能。

2.3 VC维度理论

为了更精确地量化模型容量,统计学习理论引入了VC维度(Vapnik-Chervonenkis Dimension)的概念。VC维度提供了一种衡量二元分类器容量的方法。

对于一个二元分类器,其VC维度定义为该分类器能够完全分离(shatter)的最大样本数量。如果存在m个不同的数据点,分类器能够实现这m个点的所有种可能的二元标记,则称该分类器的VC维度至少为m。

数学上,设H是一个假设类,是m个数据点的集合。如果对于

中的每一个标记向量

,都存在

使得

对所有

成立,则称H能够分离集合S。

VC维度的重要性在于它提供了泛化误差的理论上界。根据VC理论,对于VC维度为d的假设类,其泛化误差满足:

R(h) \\leq R_{emp}(h) + \\sqrt{\\frac{d(\\log(2m/d) + 1) - \\log(\\delta/4)}{m}}

其中R(h)是真实风险,是经验风险,m是训练样本数量,

是置信度参数。

这个不等式揭示了一个重要的权衡关系:随着VC维度(即容量)的增加,右侧第二项(复杂度惩罚项)增大,这意味着需要更多的训练数据来保证良好的泛化性能。

3. 欠拟合现象的深入分析

3.1 欠拟合的定义与特征

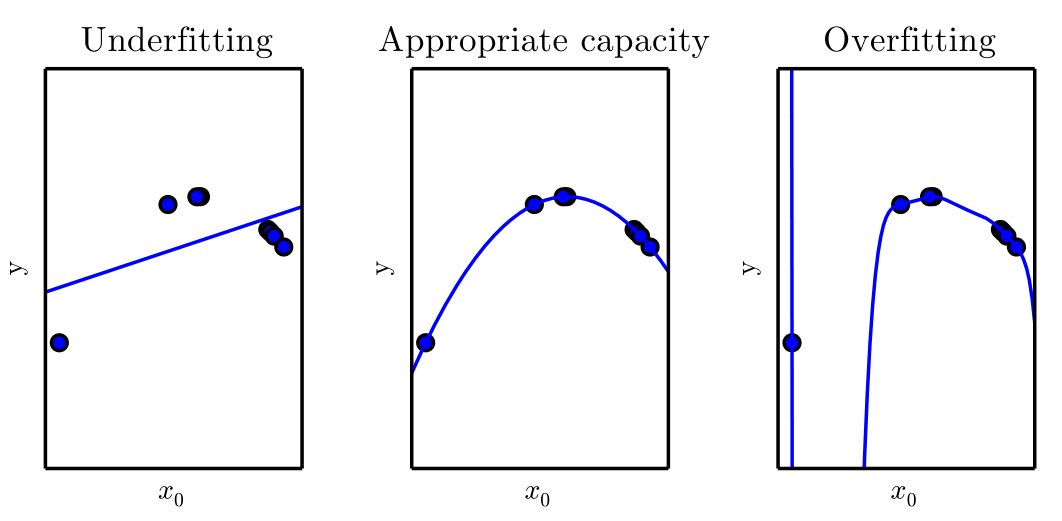

欠拟合(Underfitting)是指模型在训练数据上的性能就很差的现象。当模型的容量不足以学习数据中的潜在模式时,就会发生欠拟合。这种情况下,模型过于简单,无法捕捉到数据的真实分布特征。

从数学角度来看,假设真实的数据生成函数为,我们的模型试图学习一个近似函数

。当模型过于简单时,即使在训练数据上优化到全局最优,

也可能与

相差甚远。这种差异主要来源于模型的表达能力限制,而非优化或过拟合问题。

欠拟合的主要特征包括:

- 训练误差高:模型在训练集上的表现就很差,损失函数值居高不下。

- 验证误差也高:由于模型本身就不能很好地拟合数据,在验证集上的表现同样不佳。

- 训练误差与验证误差接近:由于模型没有过度拟合训练数据,两者之间的差距通常较小。

3.2 欠拟合的数学分析

为了更深入地理解欠拟合现象,我们可以从偏差的角度进行分析。考虑一个回归问题,真实的目标函数为:

y = f\^\*(x) + \\epsilon

其中是均值为0的噪声项。假设我们使用一个线性模型来拟合这个关系:

\\hat{f}(x; \\theta) = \\theta\^T x

如果真实函数是非线性的,比如

,那么无论我们如何优化参数

,线性模型都无法准确表示这种二次关系。此时,模型的偏差(Bias)为:

\\text{Bias}\[\\hat{f}(x)\] = \\mathbb{E}\[\\hat{f}(x)\] - f\^\*(x)

对于欠拟合的情况,这个偏差通常很大,因为模型的假设空间不包含真实函数或其良好近似。

让我们考虑一个具体的例子。假设真实函数为,我们使用线性模型

来拟合。最小二乘估计会给出:

\\min_{a,b} \\mathbb{E}\[(ax + b - x\^2)\^2\]

即使找到最优的a和b,线性模型也无法准确表示二次函数的形状,导致系统性的预测误差。

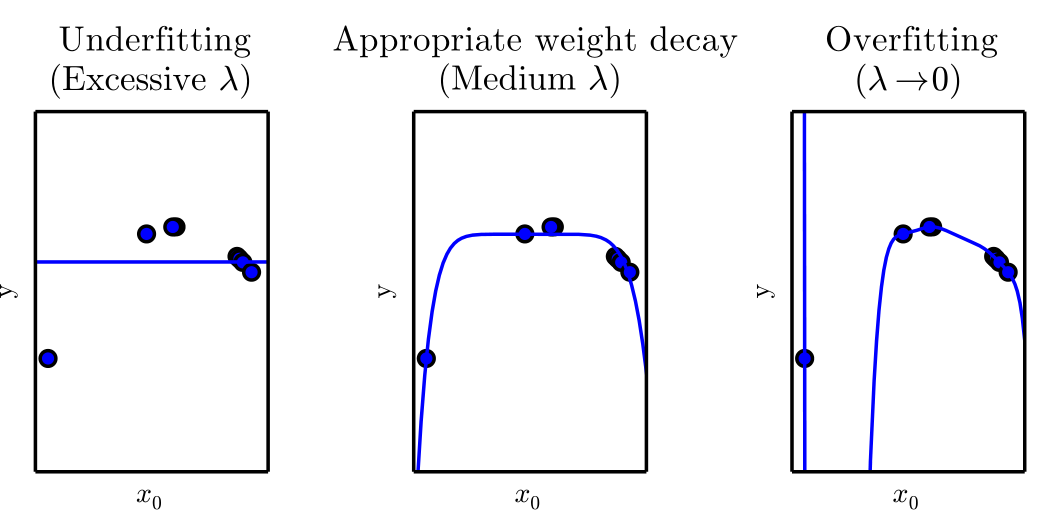

3.3 导致欠拟合的原因

欠拟合的产生有多种原因,理解这些原因有助于我们在实践中避免或减轻欠拟合现象:

模型复杂度过低是最直接的原因。当我们选择的模型架构过于简单,无法表达数据中的复杂关系时,就会发生欠拟合。例如,使用线性回归来处理明显非线性的数据,或者使用参数过少的神经网络来处理复杂的图像识别任务。

特征工程不充分也会导致欠拟合。如果输入特征不能充分表达问题的本质,即使是复杂的模型也可能表现不佳。这种情况在传统机器学习中尤为常见,需要领域专家设计合适的特征变换。

正则化过度是另一个重要原因。虽然正则化技术旨在防止过拟合,但如果正则化强度过大,可能会过度限制模型的学习能力,导致欠拟合。例如,在权重衰减正则化中:

J(\\theta) = \\mathcal{L}(\\theta) + \\lambda \|\\theta\|\^2

当正则化系数过大时,模型会过分追求参数的小值,而忽视了数据拟合的准确性。

训练不充分也可能导致看似欠拟合的现象。有时候模型的容量是足够的,但由于训练时间不够、学习率设置不当或优化算法选择不合适,模型没有收敛到较好的解。

4. 过拟合现象的全面解析

4.1 过拟合的定义与本质

过拟合(Overfitting)是机器学习中最常见也是最棘手的问题之一。它指的是模型在训练数据上表现很好,但在新的、未见过的数据上性能显著下降的现象。过拟合的本质是模型记住了训练数据中的噪声和无关细节,而不是学习到了数据的真正规律。

从信息论的角度来看,过拟合可以理解为模型学习了过多的"无用信息"。训练数据包含两部分信息:反映真实规律的信号和随机噪声。理想的学习算法应该只学习信号部分,忽略噪声。然而,当模型容量过大时,它不仅学习了信号,还记住了噪声,这就导致了过拟合。

数学上,我们可以将数据生成过程表示为:

y = f\^\*(x) + \\epsilon

其中是真实的目标函数,

是噪声项。过拟合的模型

不仅学习了

,还试图拟合*

*,这导致它在训练数据上的误差很小,但泛化性能较差。

4.2 过拟合的数学特征

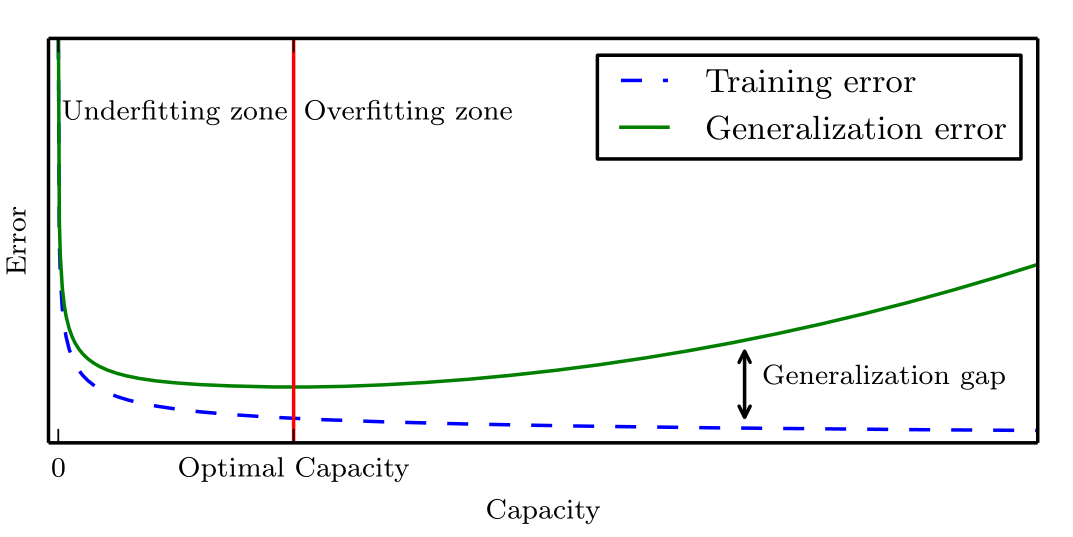

过拟合现象可以通过训练误差和泛化误差之间的差异来量化。设训练误差为:

R_{train}(\\hat{f}) = \\frac{1}{n} \\sum_{i=1}\^{n} L(y_i, \\hat{f}(x_i))

泛化误差为:

R_{test}(\\hat{f}) = \\mathbb{E}_{(x,y) \\sim P}\[L(y, \\hat{f}(x))\]

其中P是真实的数据分布,L是损失函数。

过拟合的数学特征是泛化间隙(Generalization Gap)较大:

\\text{Generalization Gap} = R_{test}(\\hat{f}) - R_{train}(\\hat{f})

当这个间隙显著大于0时,我们就认为模型发生了过拟合。

从复杂度的角度来看,过拟合与模型的Rademacher复杂度密切相关。Rademacher复杂度定义为:

\\hat{R}*n(\\mathcal{F}) = \\mathbb{E}*{\\sigma} \\left\[ \\sup_{f \\in \\mathcal{F}} \\frac{1}{n} \\sum_{i=1}\^{n} \\sigma_i f(x_i) \\right\]

其中是独立的Rademacher随机变量(取值为

,各有1/2的概率)。Rademacher复杂度越高,模型越容易过拟合。

4.3 过拟合与模型容量的关系

过拟合与模型容量之间存在密切的关系。一般来说,模型容量越高,越容易发生过拟合。这种关系可以通过以下几个方面来理解:

参数数量与样本数量的比例 是一个重要指标。当模型参数数量接近或超过训练样本数量时,模型有可能记住每个训练样本的具体细节。例如,考虑一个具有p个参数的模型和n个训练样本。当时,模型可能有足够的自由度来完美拟合训练数据,包括其中的噪声。

模型的函数复杂度也影响过拟合的程度。即使参数数量相同,不同的模型架构也可能表现出不同的过拟合倾向。例如,深度神经网络由于其非线性激活函数的组合,能够表示极其复杂的函数,因此更容易过拟合。

训练数据的噪声水平 是另一个重要因素。在噪声较高的数据集上,高容量模型更容易学习到噪声模式。假设噪声水平为,那么过拟合的程度通常与

成正比。

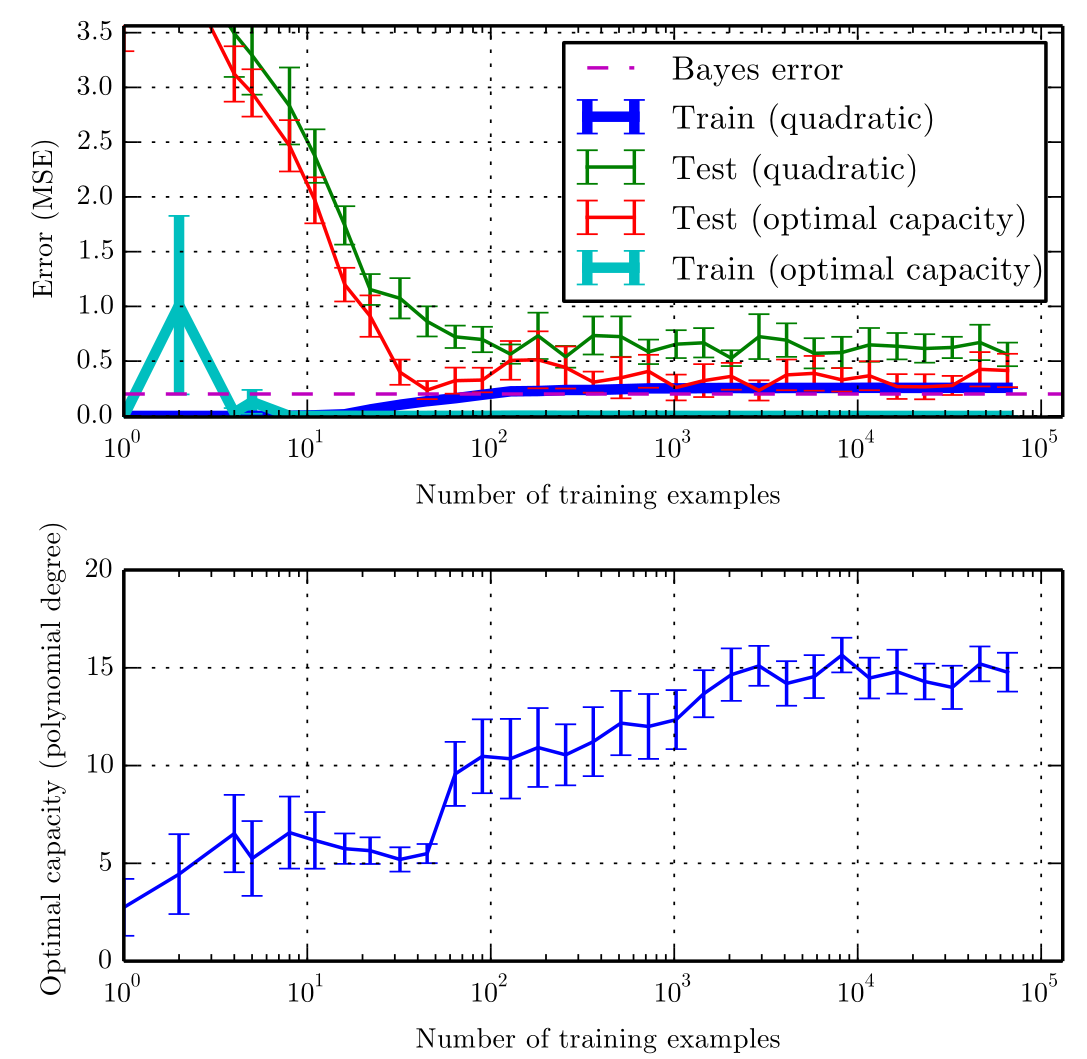

我们可以通过一个简单的多项式回归例子来说明这种关系。考虑真实函数,我们使用不同次数的多项式来拟合:

当d较小时,模型容量不足,可能出现欠拟合;当d过大时,模型开始拟合噪声,出现过拟合。最优的d值取决于数据的复杂性和噪声水平。

5. 偏差-方差权衡的深层理论

5.1 偏差-方差分解的数学推导

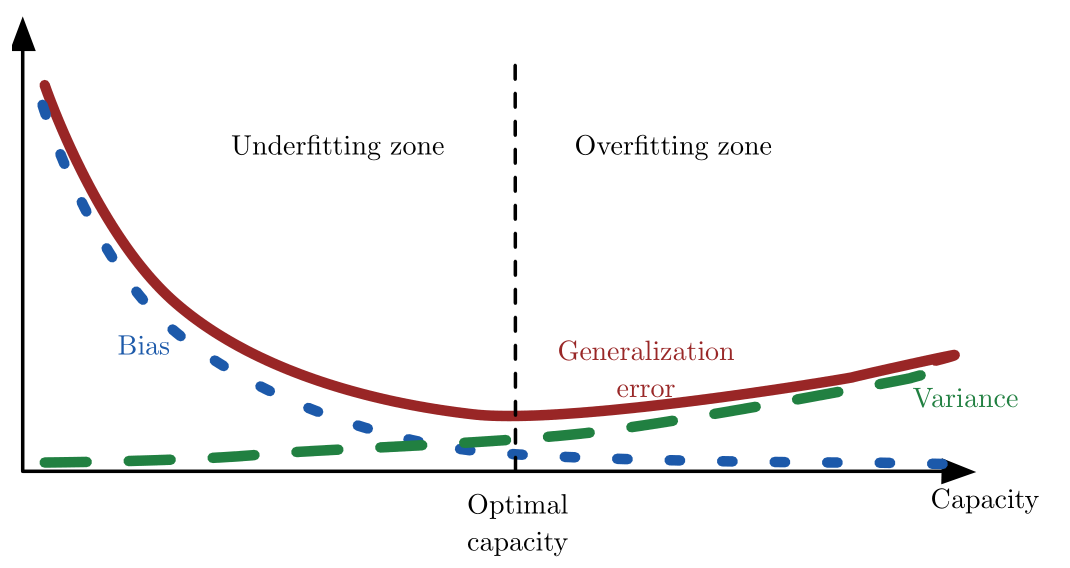

偏差-方差权衡(Bias-Variance Tradeoff)是理解容量、欠拟合和过拟合关系的核心理论框架。这个理论将预测误差分解为三个组成部分:偏差、方差和不可约误差。

考虑一个回归问题,真实的数据生成过程为:

y = f\^\*(x) + \\epsilon

其中是噪声项。给定训练集

,我们学习到一个模型

。

对于任意测试点,预测误差的期望可以分解为:

\\mathbb{E}_{\\mathcal{D}, \\epsilon}\[(y_0 - \\hat{f}(x_0; \\mathcal{D}))\^2\] = \\text{Bias}\^2 + \\text{Variance} + \\text{Noise}

具体地:

其中:

- 偏差(Bias) :

,衡量模型的系统性错误。

- 方差(Variance) :

,衡量模型预测的不稳定性。

- 噪声(Noise) :

,数据本身的不可约误差。

5.2 偏差与方差的直观理解

偏差反映了模型的系统性错误。高偏差通常意味着模型过于简单,无法捕捉数据的真实规律。例如,使用线性模型拟合非线性数据时,无论如何调整参数,都会存在系统性的预测误差。

方差反映了模型对训练数据变化的敏感性。高方差的模型在不同的训练集上会产生显著不同的预测结果。这通常发生在模型过于复杂、对训练数据过度敏感的情况下。

我们可以用一个打靶的比喻来理解这两个概念:

- 高偏差、低方差:箭矢集中,但偏离靶心(欠拟合)

- 低偏差、高方差:箭矢分散在靶心周围(过拟合)

- 高偏差、高方差:箭矢既分散又偏离靶心(最差情况)

- 低偏差、低方差:箭矢集中在靶心(理想情况)

5.3 容量与偏差-方差的关系

模型容量与偏差-方差权衡之间存在明确的关系:

随着容量增加,偏差通常会减少。更复杂的模型能够更好地逼近真实函数,减少系统性错误。在极限情况下,如果模型具有无限容量且能够找到全局最优解,偏差可以降至0。

随着容量增加,方差通常会增加。复杂模型对训练数据的微小变化更加敏感,导致预测结果的不稳定性增加。这是因为复杂模型有更多的参数需要从有限的训练数据中估计。

这种权衡关系可以用数学公式表示。对于一个具有p个参数、n个训练样本的模型,在某些假设下:

\\text{Bias}\^2 \\propto \\text{model_complexity}\^{-\\alpha}$$ $$\\text{Variance} \\propto \\frac{p}{n}

其中\\alpha \> 0是一个常数,取决于具体的模型类型和数据分布。

总误差为:

\\text{Total Error} = \\text{Bias}\^2 + \\text{Variance} + \\sigma\^2

最优的模型复杂度是使得总误差最小的复杂度,这通常对应于偏差和方差之间的最佳平衡点。

6. 正则化技术的理论与实践

6.1 正则化的基本原理

正则化(Regularization)是解决过拟合问题的最重要技术之一。其基本思想是在原始的损失函数基础上增加一个惩罚项,以限制模型的复杂度。正则化的数学形式通常为:

J_{reg}(\\theta) = J(\\theta) + \\lambda \\Omega(\\theta)

其中是原始损失函数,

是正则化项,

是正则化强度参数。

正则化的工作原理可以从贝叶斯的角度来理解。正则化项对应于参数

的先验分布的负对数。例如,L2正则化对应于高斯先验:

p(\\theta) \\propto \\exp\\left(-\\frac{\\lambda}{2}\|\\theta\|\^2\\right)

从这个角度来看,正则化实际上是在进行最大后验估计(MAP),而不是最大似然估计(MLE)。

6.2 L1和L2正则化的比较分析

**L2正则化(权重衰减)**是最常用的正则化技术之一。其正则化项为:

\\Omega(\\theta) = \|\\theta\|\^2 = \\sum_{i} \\theta_i\^2

L2正则化的目标函数变为:

J_{L2}(\\theta) = J(\\theta) + \\frac{\\lambda}{2}\|\\theta\|\^2

L2正则化的梯度更新规则为:

\\theta \\leftarrow \\theta - \\eta \\frac{\\partial J}{\\partial \\theta} - \\eta \\lambda \\theta

这相当于在每次更新时对参数进行衰减,因此被称为权重衰减。

L1正则化(稀疏正则化)的正则化项为:

\\Omega(\\theta) = \|\\theta\|*1 = \\sum*{i} \|\\theta_i\|

L1正则化的一个重要特性是它能够产生稀疏解,即许多参数会被压缩到恰好为0。这种特性对特征选择很有帮助。

L1和L2正则化的几何解释非常有启发性。在参数空间中,L2正则化对应于圆形(或高维球面)约束,而L1正则化对应于菱形(或高维正则单纯形)约束。L1约束的角点特性导致了稀疏解的产生。

6.3 其他正则化技术

Dropout是深度学习中非常有效的正则化技术。在训练过程中,Dropout随机将某些神经元的输出设置为0,其概率为p:

\\tilde{h}_i = \\begin{cases} 0 \& \\text{with probability } p \\ \\frac{h_i}{1-p} \& \\text{with probability } 1-p \\end{cases}

其中是第i个神经元的原始输出,

是应用Dropout后的输出。Dropout可以看作是对模型进行集成学习的一种近似。

早停法(Early Stopping)是另一种简单而有效的正则化技术。基本思想是在验证误差开始增加时停止训练,即使训练误差还在下降。这防止了模型过度拟合训练数据。

数据增强(Data Augmentation)通过人工增加训练数据的多样性来提高模型的泛化能力。对于图像数据,常见的数据增强技术包括旋转、缩放、裁剪、翻转等。

批归一化(Batch Normalization)虽然主要目的是加速训练,但也具有正则化效果。批归一化通过标准化每一层的输入来减少内部协变量偏移:

\\hat{x}_i = \\frac{x_i - \\mu_B}{\\sqrt{\\sigma_B\^2 + \\epsilon}}

其中和

分别是批次的均值和方差。

6.4 正则化强度的选择

正则化强度的选择是正则化技术应用中的关键问题。

的值直接影响偏差-方差权衡:

=0:无正则化,可能过拟合

适中:达到最佳偏差-方差权衡

过大:可能导致欠拟合

选择最优的常用方法是交叉验证。我们在不同的

值下训练模型,选择在验证集上性能最好的

。

数学上,最优的应该满足:

\\lambda\^\* = \\arg\\min_{\\lambda} \\mathbb{E}_{test}\[L(y, f(x; \\theta\^\*(\\lambda)))\]

其中是在正则化强度为

时的最优参数。

7. 深度学习中的容量控制策略

7.1 深度学习的特殊性

深度学习模型在容量控制方面有其独特的特点。现代深度神经网络通常包含数百万甚至数十亿个参数,远远超过传统机器学习模型的规模。这种巨大的参数规模带来了新的挑战和机遇。

过参数化现象是深度学习的一个重要特征。许多成功的深度学习模型都是过参数化的,即参数数量远超训练样本数量。根据传统理论,这样的模型应该严重过拟合,但实际上它们往往具有良好的泛化性能。这个现象挑战了传统的偏差-方差权衡理论。

隐式正则化是深度学习中的另一个重要概念。某些训练技术,如随机梯度下降(SGD)本身就具有正则化效果。SGD引入的噪声可以帮助模型逃离尖锐的局部最小值,趋向于平坦的最小值,从而提高泛化性能。

7.2 架构设计的正则化效应

深度学习中的很多架构设计原则本身就具有正则化效果:

权重共享是卷积神经网络(CNN)的核心思想。通过在不同位置共享相同的滤波器,CNN大大减少了参数数量,同时引入了平移不变性的归纳偏置。这种设计有效地控制了模型容量。

深度结构本身也是一种容量控制机制。虽然深度网络可能有很多参数,但其层次化的结构限制了函数的表达方式。深度结构偏向于学习层次化的表示,这与许多现实世界问题的结构相匹配。

注意力机制在Transformer等模型中广泛使用,它允许模型动态地选择重要信息,这也是一种软性的容量控制机制。

7.3 现代正则化技术

DropPath是Dropout的一种变体,特别适用于残差网络。它随机跳过某些残差块,可以表示为:

y = x + \\text{DropPath}(F(x))

其中F(x)是残差函数,DropPath以一定概率将F(x)设为0。

标签平滑(Label Smoothing)通过软化目标标签来提供正则化效果。原始的one-hot标签被替换为:

y_{smoothed} = (1 - \\alpha) y + \\alpha / K

其中是平滑参数,K是类别数量。

混合数据增强技术如Mixup和CutMix也提供了有效的正则化:

Mixup将两个样本线性组合: $$\tilde{x} = \lambda x_i + (1 - \lambda) x_j$$ $$\tilde{y} = \lambda y_i + (1 - \lambda) y_j$$

其中。

7.4 容量自适应机制

现代深度学习还发展了一些自适应容量控制机制:

动态网络能够根据输入的复杂性动态调整使用的计算资源。例如,某些卷积网络可以根据输入图像的复杂性选择不同的处理路径。

神经网络剪枝技术可以在训练过程中或训练后移除不重要的连接或神经元,从而减少模型容量。

知识蒸馏通过让小模型学习大模型的输出分布,实现了容量的有效压缩:

L = \\alpha L_{CE}(y, p) + (1-\\alpha) L_{KD}(\\sigma(z_s/T), \\sigma(z_t/T))

其中是交叉熵损失,

是知识蒸馏损失,T是温度参数。

8. 结论与未来展望

8.1 核心观点总结

通过本文的深入分析,我们可以得出以下核心观点:

容量是机器学习模型性能的关键决定因素。适当的容量能够确保模型既能学习数据中的真实模式,又不会过度拟合噪声。容量的控制需要考虑数据规模、任务复杂度、噪声水平等多个因素。

欠拟合和过拟合是容量设置不当的两种典型表现。欠拟合源于容量不足,导致高偏差;过拟合源于容量过剩,导致高方差。理想的模型应该在偏差和方差之间找到最佳平衡。

正则化是控制有效容量的主要手段。从简单的L1/L2正则化到复杂的Dropout、批归一化等技术,都是通过限制模型的学习能力来提高泛化性能。正则化的选择和调整需要根据具体问题进行优化。

深度学习时代带来了新的挑战和机遇。大规模模型的成功表明传统的容量理论需要发展和完善。双下降现象、过参数化的益处、隐式正则化等新发现为我们提供了新的思路。

8.2 实践指导原则

基于理论分析和实验经验,我们可以总结出以下实践指导原则:

从简单模型开始。在解决新问题时,建议从相对简单的模型开始,逐步增加复杂度。这样可以建立基线性能,并更好地理解数据特征。

重视数据质量和数量。高质量、大规模的训练数据是避免过拟合的最好方法。数据增强、数据清洗等预处理步骤往往比复杂的正则化技术更有效。

系统性的超参数优化。使用交叉验证、贝叶斯优化等方法系统性地优化超参数,避免依赖经验或随意调整。

多种正则化技术的组合使用。不同的正则化技术往往具有互补的效果,合理的组合能够取得更好的效果。

持续监控和诊断。建立完善的监控体系,及时发现和纠正拟合问题。学习曲线、验证曲线等可视化工具是重要的诊断手段。

8.3 未来发展方向

容量、欠拟合和过拟合的研究在未来可能会朝以下方向发展:

理论基础的完善。需要发展新的理论框架来解释过参数化模型的成功,完善对深度学习泛化能力的理解。神经切线核理论、信息瓶颈理论等是有前景的方向。

自适应容量控制。发展能够根据数据特征和任务需求自动调整容量的方法,减少人工调参的需求。神经架构搜索(NAS)、动态网络等技术展现了这种可能性。

跨领域的方法迁移。将一个领域中有效的容量控制方法迁移到其他领域,如将计算机视觉中的技术应用到自然语言处理中。

可解释性的提升。发展更好的方法来理解和可视化模型的容量使用情况,帮助研究者和实践者更好地调试模型。

硬件感知的容量优化。随着专用AI芯片的发展,需要考虑硬件特性对容量控制的影响,发展硬件感知的模型设计方法。

机器学习中的容量、欠拟合与过拟合问题是一个持续发展的研究领域。随着新技术和新理论的不断涌现,我们对这些基本概念的理解也在不断深化。掌握这些基础理论和实践方法,对于设计高效、可靠的机器学习系统具有重要意义。

参考资料

-

Goodfellow, I., Bengio, Y., & Courville, A. (2016). Deep Learning. MIT Press.网址:https://www.deeplearningbook.org/

-

Hastie, T., Tibshirani, R., & Friedman, J. (2009). The Elements of Statistical Learning. Springer.

-

Bishop, C. M. (2006). Pattern Recognition and Machine Learning. Springer.

网址:https://www.microsoft.com/en-us/research/people/cmbishop/prml-book/

-

Vapnik, V. N. (1995). The Nature of Statistical Learning Theory. Springer-Verlag.

-

Neyshabur, B., Bhojanapalli, S., McAllester, D., & Srebro, N. (2017). Exploring Generalization in Deep Learning. NIPS.

-

Zhang, C., Bengio, S., Hardt, M., Recht, B., & Vinyals, O. (2016). Understanding Deep Learning Requires Rethinking Generalization. ICLR.

-

Belkin, M., Hsu, D., Ma, S., & Mandal, S. (2019). Reconciling Modern Machine-Learning Practice and the Classical Bias-Variance Trade-off. PNAS.

-

Frankle, J., & Carbin, M. (2019). The Lottery Ticket Hypothesis: Finding Sparse, Trainable Neural Networks. ICLR.

-

Jacot, A., Gabriel, F., & Hongler, C. (2018). Neural Tangent Kernel: Convergence and Generalization in Neural Networks. NIPS.

-

Tishby, N., & Zaslavsky, N. (2015). Deep Learning and the Information Bottleneck Principle. ITW.