要指标还是更多有价值的论文,顶级学术会议似乎也面临着「to be or not to be」的难题。

NeurIPS 2025 将于 2025 年 12 月 2 日到 7 日在美国圣地亚哥举办,并且首次设置了第二个官方分会场墨西哥城。

最近几天,根据国内外社交媒体的众多反馈,本届 NeurIPS 的 Meta Review(元评审,即多位匿名审稿人提交评审意见后由领域主席或高级审稿人撰写总结性评审)已经陆续完成。

出自:MiroMind 研究科学家 Bai Song(小红书)

从更多领域主席(AC)透露的消息中,有一些现象关系到了投稿人论文最终能否被接收。

其中,有领域主席表示,「在 DB(数据集和基准) track,即使得分 4-4-4-5(均分 4.25)也有可能被拒稿。」根据此前的相关数据统计,本届 NeurIPS 的投稿数量或达到史上最多的 30000。

他认为,不要为了接收率固定在 20% 到 25%,而拒掉获得审稿人积极评分并达成共识的论文。并且,他呼吁向程序主席(PC)建议提高接收率。而根据 Senior PC(高级程序委员会成员)的回复,由于场地和资源有限以及投稿量超出了预期,本届会议必须控制接收率。

作为对比,NeurIPS 2024 的接收率为 25.8%(主会议)和 25.3%(DB),NeurIPS 2023 的接收率为 26.1(主会议)和 32.6%(DB)。

出自:Jian Wang---Snap Research(小红书)

另一位研究者、加州大学圣塔芭芭拉分校助理教授 Xin Eric Wang 也提到了这一现象,「有些领域主席即使在所有评审意见都是正面的情况下,仅仅是为了控制接收率,依然会拒稿。」

他认为这种做法是不对的,并回想起几年前类似的 AAAI 投稿经历:一篇评分为 7-7-7-6 的论文仅仅因为结果报告中写成 0.84 而不是 84% 就被拒掉了。「当学术会议开始为名额游戏而拒绝优秀的工作时,声誉就会下降。学术声望源于公平的评审以及吸引顶尖的投稿,而不是人为地压低接收率。」

有人晒出了自己过去两届 NeurIPS 的「悲惨」遭遇,「8-7-7-6-5」和「7-6-6-6」高分均被拒稿。

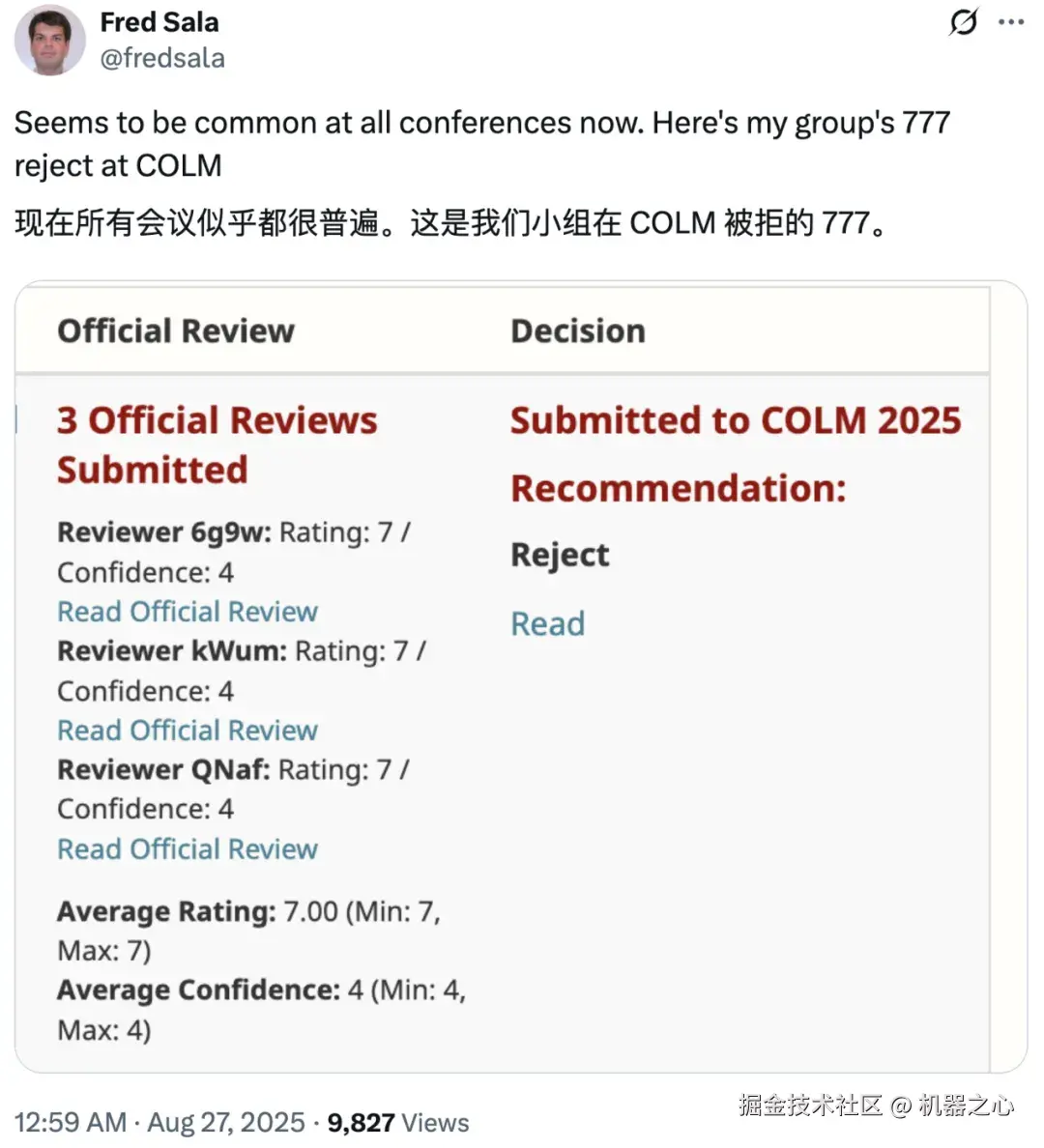

这样遗憾的结果出现在了其他更多学术会议中,比如陈丹琦等一批知名青年学者组织的新会议 COLM(Conference on Language Modeling,语言建模会议)。

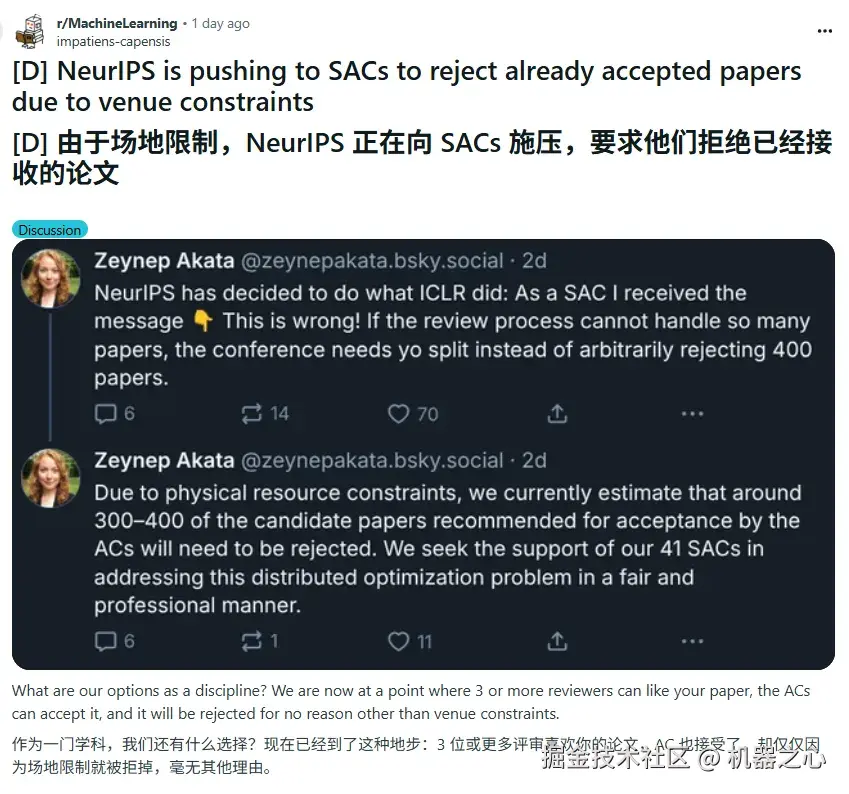

我们进一步发现,国外社区有类似的消息透露,「NeurIPS 官方正向高级领域主席(SAC)施压,要求他们拒掉已经接收的论文,理由是场地限制。」

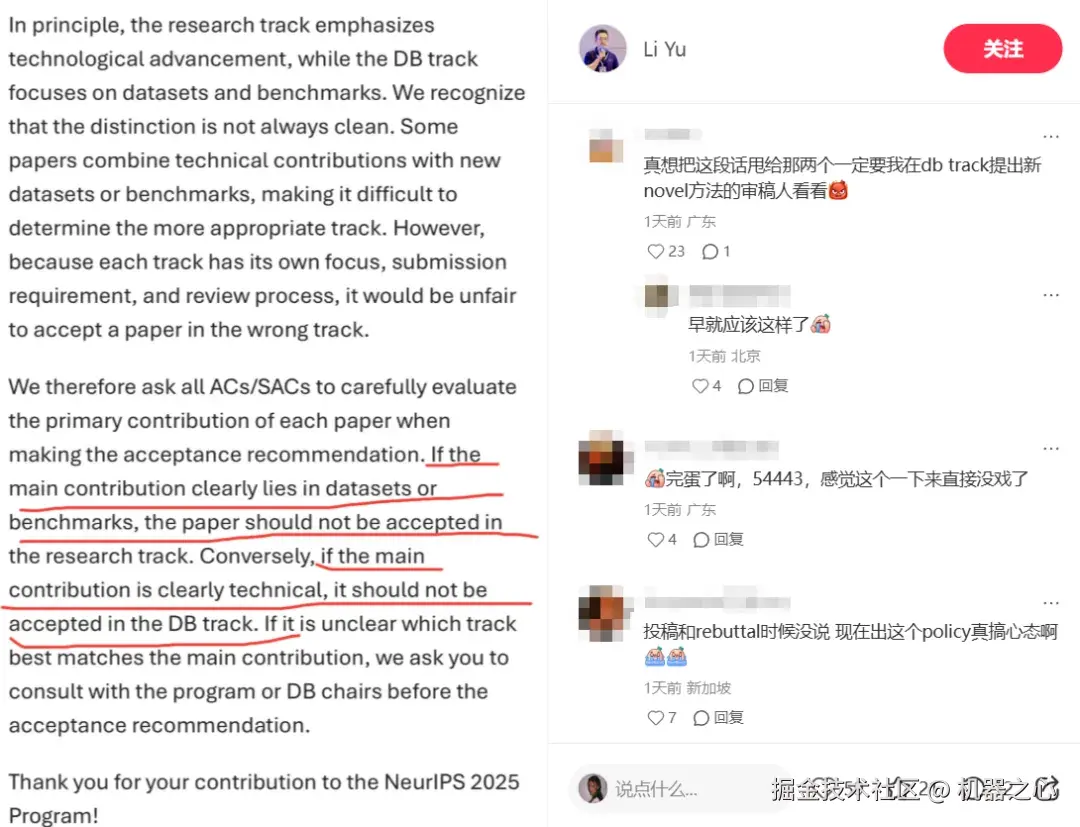

网传的官方发给审稿委员会成员的指南显示,官方要求领域主席们严格执行「专业对口」的原则,确保每篇被录用的论文都因其最核心的贡献而被放在了最合适的类别下,避免出现用「数据集的贡献」去填充「技术创新名额」的情况,反之亦然。

评论区有投稿人反映,在论文提交和 rebuttal 阶段,官方并未明确告知这一严格的划分标准。这种在评审后期才明确的内部准则,让人感到措手不及。

出自:Li Yu(小红书)

原则上,研究赛道 (research track) 侧重于技术进步,而数据集与基准测试赛道 (DB track) 则聚焦于数据集和基准测试。我们认识到,这种区分并非总是清晰明了。有些论文将技术贡献与新的数据集或基准测试相结合,这使得确定哪个赛道更为合适变得困难。

然而,由于每个赛道都有其各自的侧重点、提交要求和评审流程,因此将一篇论文录用在错误的赛道上是不公平的。

因此,我们要求所有的领域主席 (ACs) 和高级领域主席 (SACs) 在给出录用建议时,仔细评估每篇论文的主要贡献。如果一篇论文的主要贡献明确在于数据集或基准测试,那么它就不应该被研究赛道录用。反之,如果主要贡献明确是技术性的,那么它就不应被数据集与基准测试赛道录用。如果不清楚哪一个赛道最匹配论文的主要贡献,我们请您在给出录用建议前,与程序主席 (program chairs) 或数据集与基准测试赛道主席 (DB chairs) 进行协商。感谢您为 NeurIPS 2025 会议程序所做的贡献。

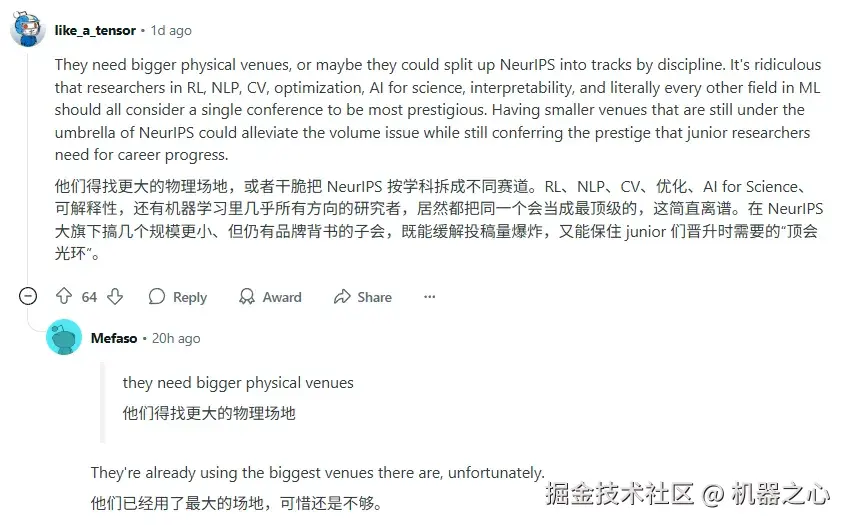

针对此次争议,有人表示:「不如将 NeurIPS 拆分成多个按具体研究领域划分的、规模较小的会议。」

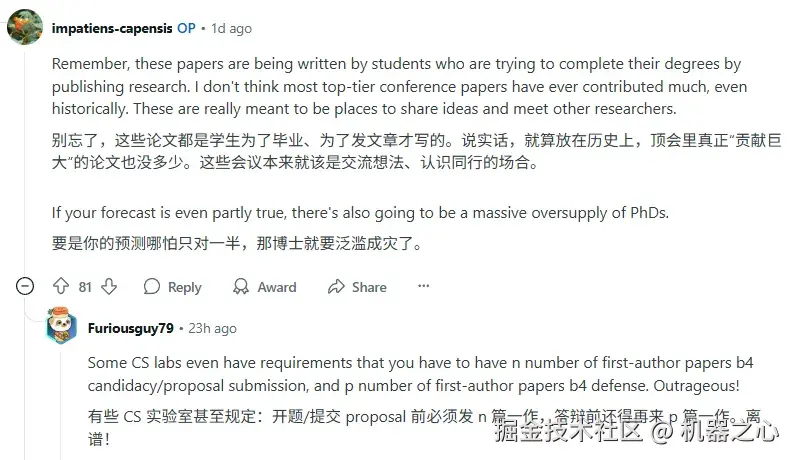

当然,对「发文指标」的吐槽也从不缺席。

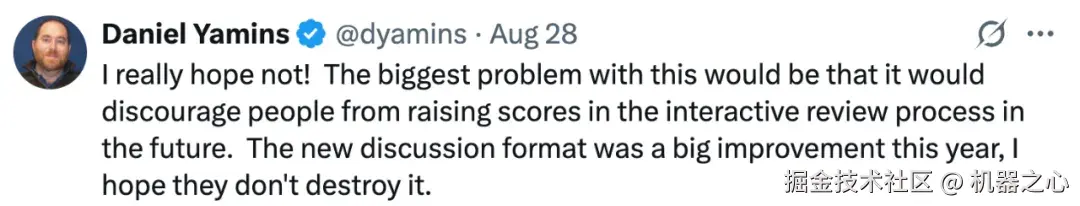

针对 NeurIPS 2025 出现的这些现象,有学者表示真的希望不要这样,如此一来会导致审稿人在未来的互动评审过程中不愿意再提高评分。

此外,本届 NeurIPS 引入的「rolling discussion」(滚动讨论,即在讨论阶段允许审稿人与作者之间实时地展开交流与澄清)机制是一项显著的改进,希望不要把它破坏掉。

正如下面这位老哥所言,「这样的体系存在着问题,当你把接收指标置于学术价值之上时,真正的创新就会受到损害。」

对于 NeurIPS 2025 审稿问题,你有什么想讨论的?欢迎留言。

参考链接: