一、核心原理概述

图像拼接的本质是解决空间映射 和图像融合两个核心问题。

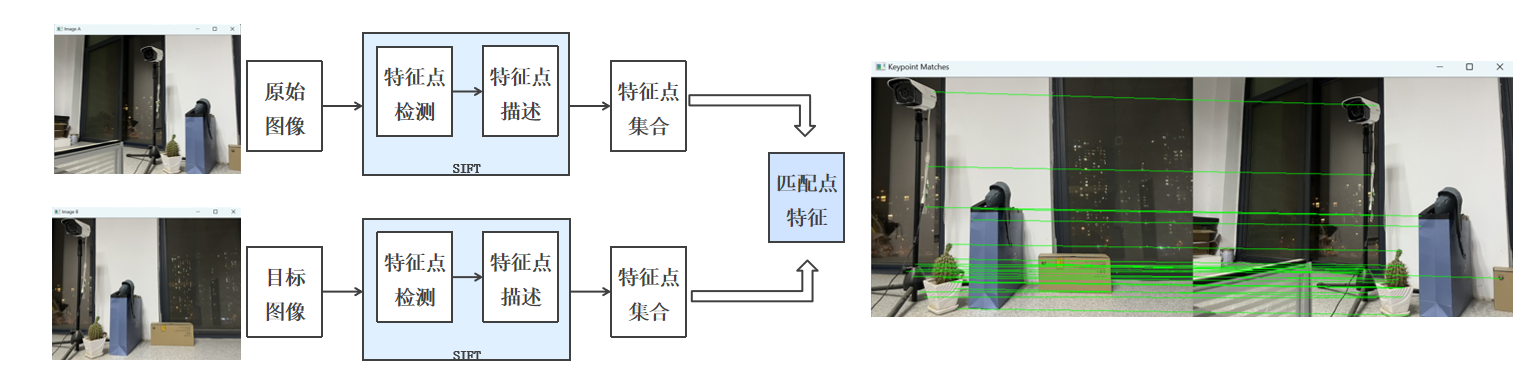

基于透视变换的双图拼接,核心依赖特征提取与匹配 和单应性矩阵求解。

图像拼接的关键在于找到两张图片的重叠区域并完成空间变换,核心步骤可概括为:

-

特征提取:用 SIFT 算法检测图像的特征点和描述符(具有尺度不变性);

-

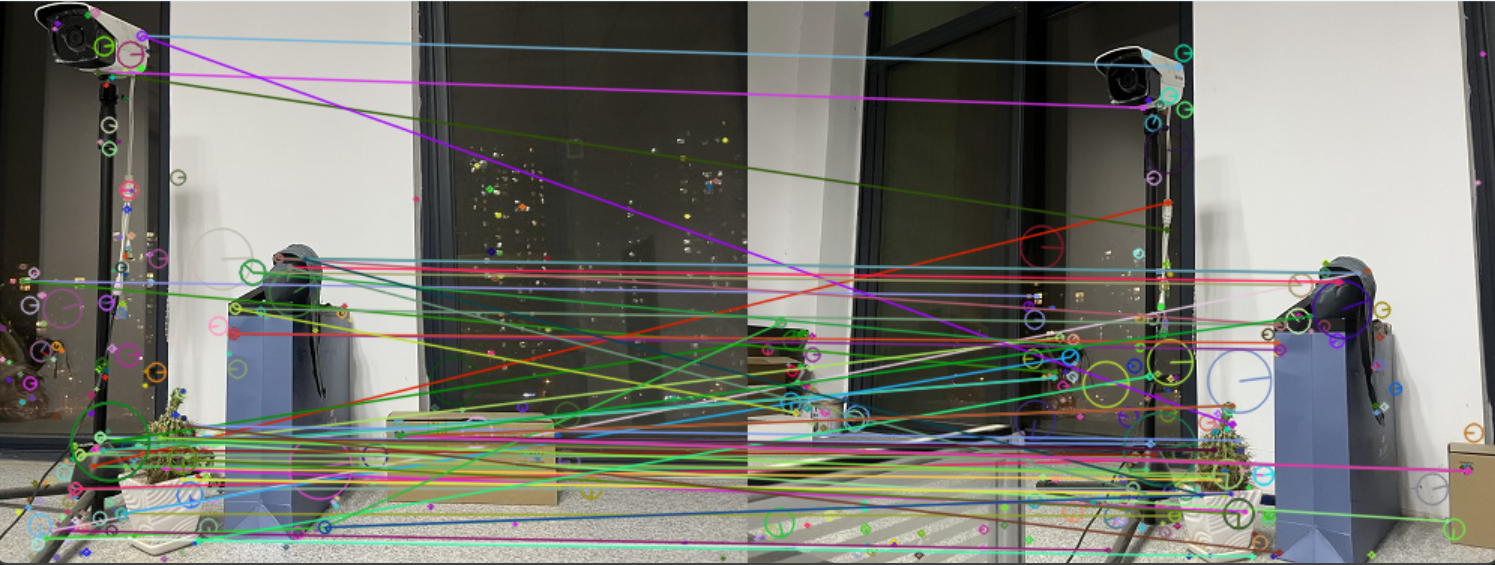

特征匹配:通过暴力匹配器筛选优质匹配对,剔除错误匹配;

-

透视变换:计算单应性矩阵(Homography),将右图映射到左图的坐标系;

-

图像融合:将变换后的右图与左图拼接,生成最终全景图。

二、特征匹配的方法

关键点A与找到的两个关键点 X、Y的欧氏距离分别 d1、d2,且d1<d2。

欧氏距离(关键点A,关键点X)=d1。

欧氏距离(关键点A,关键点Y)=d2。

(1)d1<d2,比值较大:可能不是匹配点,通常是由噪声引起的。

(2)d1<d2,比值较小:是匹配点。

三、完整代码实现

python

import cv2

import numpy as np

import sys

def cv_show(name, img):

"""

显示图片并等待按键关闭窗口

:param name: 窗口名称

:param img: 要显示的图像数组

"""

cv2.imshow(name, img)

cv2.waitKey(0)

cv2.destroyWindow(name) # 关闭指定窗口,避免窗口残留

def detectAndDescribe(image):

"""

检测图像的SIFT特征点并计算描述符

:param image: 输入的彩色图像

:return: (关键点对象列表, 关键点坐标数组, 描述符数组)

"""

# 将彩色图片转换成灰度图

gray = cv2.cvtColor(image, cv2.COLOR_BGR2GRAY)

# 建立SIFT生成器

sift = cv2.SIFT_create()

# 检测SIFT特征点,并计算描述符(第二个参数为掩膜,None表示整图检测)

(kps, des) = sift.detectAndCompute(gray, None)

# 将关键点坐标转换为NumPy数组(float32类型)

kps_float = np.float32([kp.pt for kp in kps])

return (kps, kps_float, des)

def stitch_images(imageA_path, imageB_path, output_path="pingjie.jpg"):

"""

拼接两张图片的核心函数

:param imageA_path: 第一张图片路径(左图)

:param imageB_path: 第二张图片路径(右图)

:param output_path: 拼接结果保存路径

"""

# 1. 读取图片并做异常处理

try:

imageA = cv2.imread(imageA_path)

imageB = cv2.imread(imageB_path)

if imageA is None:

raise FileNotFoundError(f"无法读取图片: {imageA_path}")

if imageB is None:

raise FileNotFoundError(f"无法读取图片: {imageB_path}")

except Exception as e:

print(f"读取图片失败: {e}")

sys.exit(1)

# 显示原始图片

cv_show('原始图片A', imageA)

cv_show('原始图片B', imageB)

# 2. 计算图片特征点及描述符

(kpsA, kps_floatA, desA) = detectAndDescribe(imageA)

(kpsB, kps_floatB, desB) = detectAndDescribe(imageB)

# 3. 特征点匹配(暴力匹配器)

matcher = cv2.BFMatcher()

rawMatches = matcher.knnMatch(desB, desA, k=2) # k=2表示取Top2匹配结果

good_matches = [] # 存储符合阈值的优质匹配对

valid_matches = [] # 存储匹配对的索引

# 筛选优质匹配对(距离比值法)

for m in rawMatches:

if len(m) == 2 and m[0].distance < 0.65 * m[1].distance:

good_matches.append(m)

valid_matches.append((m[0].queryIdx, m[0].trainIdx))

print(f"筛选后的优质匹配点数: {len(good_matches)}")

# 显示匹配结果

match_vis = cv2.drawMatchesKnn(

imageB, kpsB, imageA, kpsA, good_matches, None,

flags=cv2.DRAW_MATCHES_FLAGS_DRAW_RICH_KEYPOINTS

)

cv_show('特征点匹配结果', match_vis)

# 4. 透视变换与图片拼接

if len(valid_matches) > 4:

# 获取匹配对的坐标

ptsB = np.float32([kps_floatB[i] for (i, _) in valid_matches])

ptsA = np.float32([kps_floatA[i] for (_, i) in valid_matches])

# 计算透视变换矩阵(RANSAC算法去除外点)

(H, mask) = cv2.findHomography(ptsB, ptsA, cv2.RANSAC, ransacReprojThreshold=10)

# 对图片B做透视变换

result = cv2.warpPerspective(

imageB, H, (imageB.shape[1] + imageA.shape[1], imageB.shape[0])

)

cv_show('透视变换后的图片B', result)

# 将图片A拼接到结果图的左侧

result[0:imageA.shape[0], 0:imageA.shape[1]] = imageA

cv_show('最终拼接结果', result)

# 保存拼接结果

cv2.imwrite(output_path, result)

print(f"拼接完成!结果已保存至: {output_path}")

else:

print(f"仅找到 {len(valid_matches)} 个匹配点,不足4个,无法完成拼接")

sys.exit(1)

# 主程序入口

if __name__ == "__main__":

# 请修改这里的图片路径为你自己的图片路径

IMAGE_A_PATH =(r"C:\Users\LEGION\Desktop\01976caaa7cc71a6b45ac1aff5630afb.jpg") # 左图路径

IMAGE_B_PATH =(r"C:\Users\LEGION\Desktop\56d609fe3d12557c6f1111e9e50a0c0b.jpg") # 右图路径

OUTPUT_PATH = "pingjie.jpg" # 拼接结果保存路径

# 执行图片拼接

stitch_images(IMAGE_A_PATH, IMAGE_B_PATH, OUTPUT_PATH)

# 释放所有OpenCV窗口

cv2.destroyAllWindows()特征提取函数detectAndDescribe:

拼接的核心工具函数,负责检测 SIFT 特征点并计算描述符。先将彩色图像转为灰度图,减少计算量;再通过cv2.SIFT_create()创建 SIFT 检测器,调用detectAndCompute检测特征点并生成描述符;最后将特征点坐标转为 float32 类型的 NumPy 数组,适配后续矩阵运算,返回特征点对象、坐标数组和描述符数组。

核心参数调优

代码中有两个关键参数,直接影响拼接效果,需根据实际图像情况微调:

-

距离比值阈值:代码中设为 0.65,是筛选优质匹配对的经验值。阈值过小,匹配精度高但数量少,可能导致匹配点不足;阈值过大,匹配数量多但易引入错误匹配,导致拼接错位。特征丰富、重叠率高的图像可适当提高至 0.7,特征稀疏的图像应降低至 0.6。

-

RANSAC 重投影阈值:代码中设为 10,是判断外点的依据。阈值过小,对错误匹配剔除更严格,但可能误判有效点;阈值过大,无法有效剔除外点,矩阵求解精度下降。一般情况下,保持 10 即可,若拼接出现重影,可适当降低至 5-8。

运行结果:

常见问题与解决方案

实际运行中,问题主要集中在特征匹配和拼接效果上,以下是 3 类高频问题及针对性解决方案:

-

匹配点不足 4 个,拼接失败:原因是图像重叠率低、特征稀疏或分辨率过低。解决方案:更换重叠率≥30% 的图像,提升图像分辨率,微调距离比值阈值增加匹配点,或对图像进行对比度增强、去噪处理,增加特征点数量。

-

拼接结果重影、错位:原因是错误匹配过多,单应性矩阵精度低。解决方案:降低距离比值阈值筛选更优质匹配对,调整 RANSAC 重投影阈值,对图像进行灰度化、去噪处理减少干扰特征点。