在大模型私有化部署需求日益增长的今天,DeepSeek-R1 凭借其出色的推理能力和多场景适配性,成为很多开发者的首选。而 Ollama 作为轻量化大模型管理工具,能极大简化部署流程。本文将从 Ollama 下载安装开始,一步步教你完成 DeepSeek-R1 的本地部署,并通过 Web UI 实现直观交互,全程附带避坑指南,零基础也能轻松上手。

一、前期准备:了解核心工具与硬件要求

在开始部署前,先明确两个核心要素:工具定位与硬件适配,避免因配置不足导致部署失败。

1. 核心工具说明

- Ollama:一款开源的大模型管理工具,支持一键下载、运行、管理各类主流大模型(如 Llama 3、DeepSeek、Qwen 等),自动处理依赖环境,无需手动配置 CUDA 等复杂环境。

- DeepSeek-R1:深度求索推出的新一代开源大模型,在代码生成、逻辑推理、多轮对话等场景表现优异,提供 1.5B~671B 多种参数版本,可根据硬件选择适配型号。

2. 硬件要求(重点!)

不同参数的 DeepSeek-R1 对显卡显存要求差异较大,建议根据自身设备选择,避免 "下载完跑不动" 的问题。

| 模型版本 | 最低显卡要求 | 适用场景 |

|---|---|---|

| DeepSeek-R1-1.5B | NVIDIA RTX 3060 12GB 及以上 | 轻量化测试、简单对话 |

| DeepSeek-R1-7B/8B | NVIDIA RTX 3060 12GB 及以上 | 日常推理、代码辅助 |

| DeepSeek-R1-14B | NVIDIA RTX 3060 12GB 及以上 | 复杂任务、专业领域问答 |

| DeepSeek-R1-32B | NVIDIA RTX 4090 24GB 及以上 | 企业级应用、高精度推理 |

| DeepSeek-R1-70B | NVIDIA RTX 4090 24GB×2 及以上 | 大规模部署、深度研究 |

| DeepSeek-R1-671B | NVIDIA A100 80GB×16 及以上 | 工业级场景、超大规模任务 |

注:若使用 AMD 显卡或无独立显卡,可尝试 CPU 运行,但 1.5B 版本可能仍存在卡顿,建议优先选择 NVIDIA 显卡并安装最新显卡驱动。

二、第一步:下载并安装 Ollama(避坑指南)

Ollama 官方提供 Windows、macOS、Linux 版本,本文以Windows 系统为例,重点解决 "默认装 C 盘""下载慢" 等常见问题。

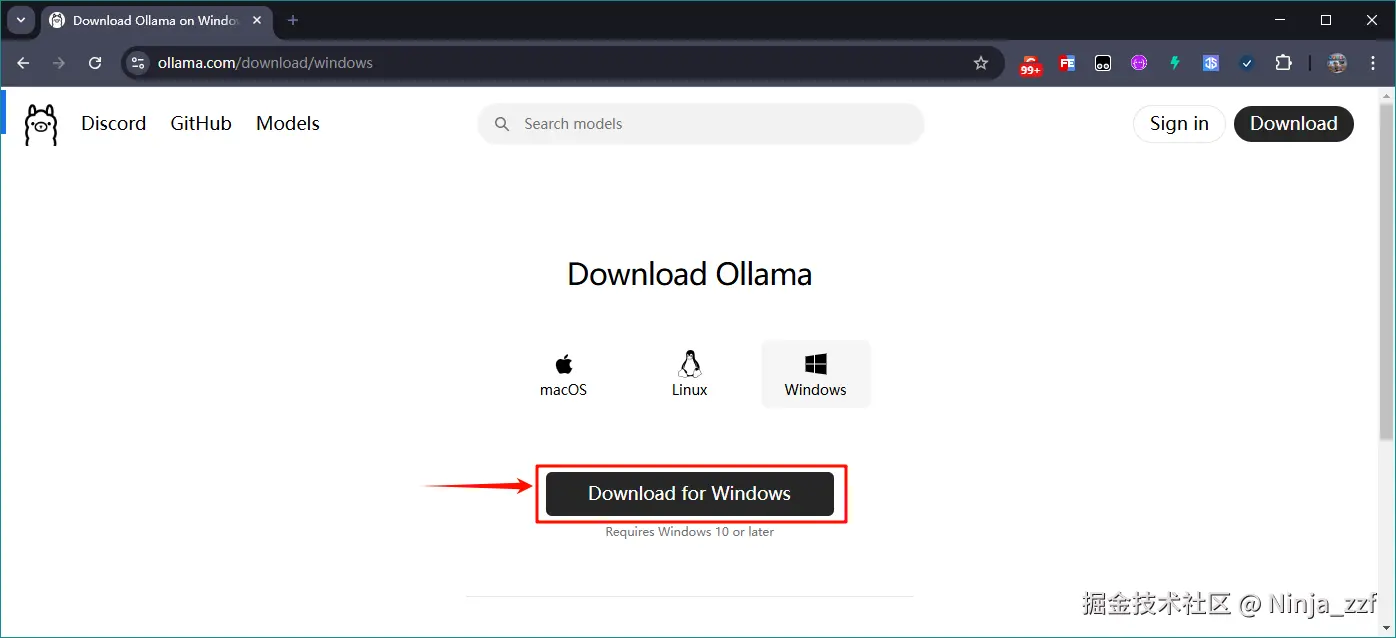

1. 下载 Ollama 安装包

访问 Ollama 官网:ollama.com/,点击右上角 "Download" 按钮,选择 Windows 版本(安装包最终会跳转至 GitHub 下载,若速度过慢可尝试切换网络或使用加速工具)。

2. 安装 Ollama(推荐命令安装,避免 C 盘占用)

Ollama 提供两种安装方式,强烈推荐 "命令安装" ------ 可自定义安装目录,避免默认装 C 盘导致空间不足。

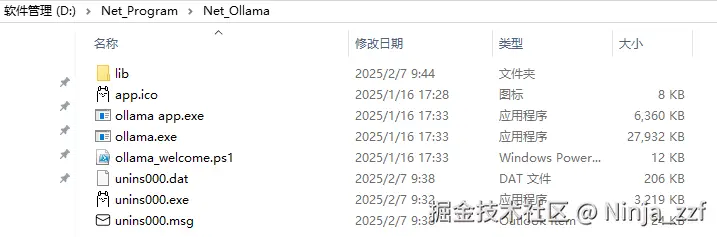

方式 1:命令安装(推荐)

- 找到下载的

OllamaSetup.exe文件(假设存放在D:\Temp目录); - 以管理员身份 打开 CMD(按下

Win+R,输入cmd,右键 "以管理员身份运行"); - 在 CMD 中输入以下命令,定位到安装包目录:

cd /d D:\Temp - 执行安装命令(

DIR后填写自定义安装目录,如D:\Net_Program\Net_Ollama):

OllamaSetup.exe /DIR="D:\Net_Program\Net_Ollama" - 弹出安装窗口后,点击 "Install",等待安装完成。

方式 2:双击安装(不推荐)

直接双击OllamaSetup.exe,默认安装到C:\Users[你的用户名]\AppData\Local\Programs\Ollama,无法修改目录,仅适合 C 盘空间充足的用户。

3. 安装后关键操作:退出 Ollama 临时服务

安装完成后,Ollama 会自动启动(任务栏右下角会出现 Ollama 图标),先右键图标选择 "Quit" 退出------ 后续配置环境变量后再重启,避免配置不生效。

4. 若已装 C 盘:迁移安装目录(补救方案)

如果不小心用了双击安装,可按以下步骤迁移到其他盘:

-

退出 Ollama 服务(任务栏右键退出);

-

将

C:\Users[你的用户名]\AppData\Local\Programs\Ollama文件夹完整剪切 到目标目录(如D:\Net_Program\Net_Ollama);

-

配置环境变量:

- 按下

Win+R,输入sysdm.cpl,打开 "系统属性"→"高级"→"环境变量"; - 在 "用户变量" 中找到

Path,双击编辑,将原来的 Ollama 路径改为迁移后的路径(如D:\Net_Program\Net_Ollama); - 点击 "确定" 保存。

- 按下

三、第二步:验证 Ollama 安装是否成功

配置完成后,通过简单命令验证 Ollama 是否正常工作:

- 打开 CMD(无需管理员身份);

- 输入以下命令查看版本:

ollama -v

若输出类似ollama version 0.1.30的信息,说明安装成功; - 输入

ollama -h可查看所有支持的命令,后续会常用到。

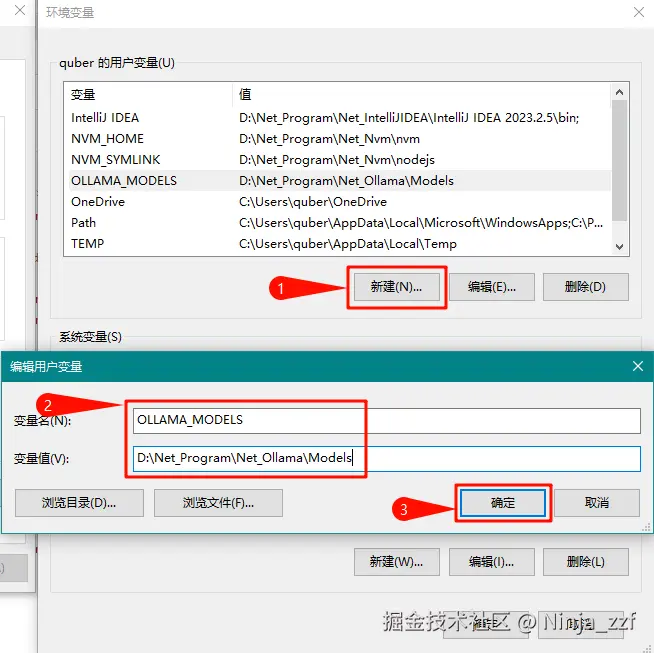

四、第三步:修改大模型存储位置(避免 C 盘爆仓)

Ollama 默认将大模型存储在C:\Users[你的用户名].ollama\models,若 C 盘空间不足,需提前修改存储路径:

-

打开 "环境变量"(步骤同上);

-

在 "用户变量" 中点击 "新建",输入:

- 变量名:

OLLAMA_MODELS - 变量值:

D:\Net_Program\Net_Ollama\Models(自定义的模型存储目录,需提前创建文件夹);

- 变量名:

-

点击 "确定" 保存,务必重启 CMD,确保环境变量生效。

五、第四步:下载并运行 DeepSeek-R1 模型

一切准备就绪后,即可通过 Ollama 一键下载 DeepSeek-R1,操作极其简单。

1. 选择模型版本

- 访问 Ollama 模型库:ollama.com/models,搜索 "deepseek-r1";

- 点击进入模型页面,下拉框中选择所需版本(如 1.5B、7B 等),复制对应的运行命令(如

ollama run deepseek-r1:1.5b)。

2. 下载并启动模型

- 打开新的 CMD 窗口(确保环境变量生效);

- 粘贴刚才复制的命令,回车执行:

ollama run deepseek-r1:1.5b - 首次运行会自动下载模型,等待下载完成(若速度过慢,可按

Ctrl+C中断,重新执行命令重试,通常会恢复速度); - 当 CMD 显示

>>>时,说明模型已启动成功,可直接输入问题进行对话(如输入 "你好",模型会立即回复)。

3. 常用模型管理命令

后续操作中可能需要管理模型,以下是核心命令:

| 命令 | 说明 | 示例 |

|---|---|---|

ollama list |

查看已安装的所有模型 | - |

ollama run 模型名 |

启动指定模型 | ollama run deepseek-r1:1.5b |

ollama stop 模型名 |

停止正在运行的模型 | ollama stop deepseek-r1:1.5b |

ollama rm 模型名 |

删除已安装的模型 | ollama rm deepseek-r1:1.5b |

ollama show 模型名 |

查看模型详细信息(大小、参数等) | ollama show deepseek-r1:1.5b |

ollama ps |

查看正在运行的模型进程 | - |

退出模型对话:在

>>>后输入/bye,即可退出当前模型。

六、第五步:配置 Web UI,实现可视化交互

虽然 CMD 可以对话,但 Web UI 更直观易用。本文推荐两种主流方案:Chrome 插件(轻量化)和 Chatbox(功能全面)。

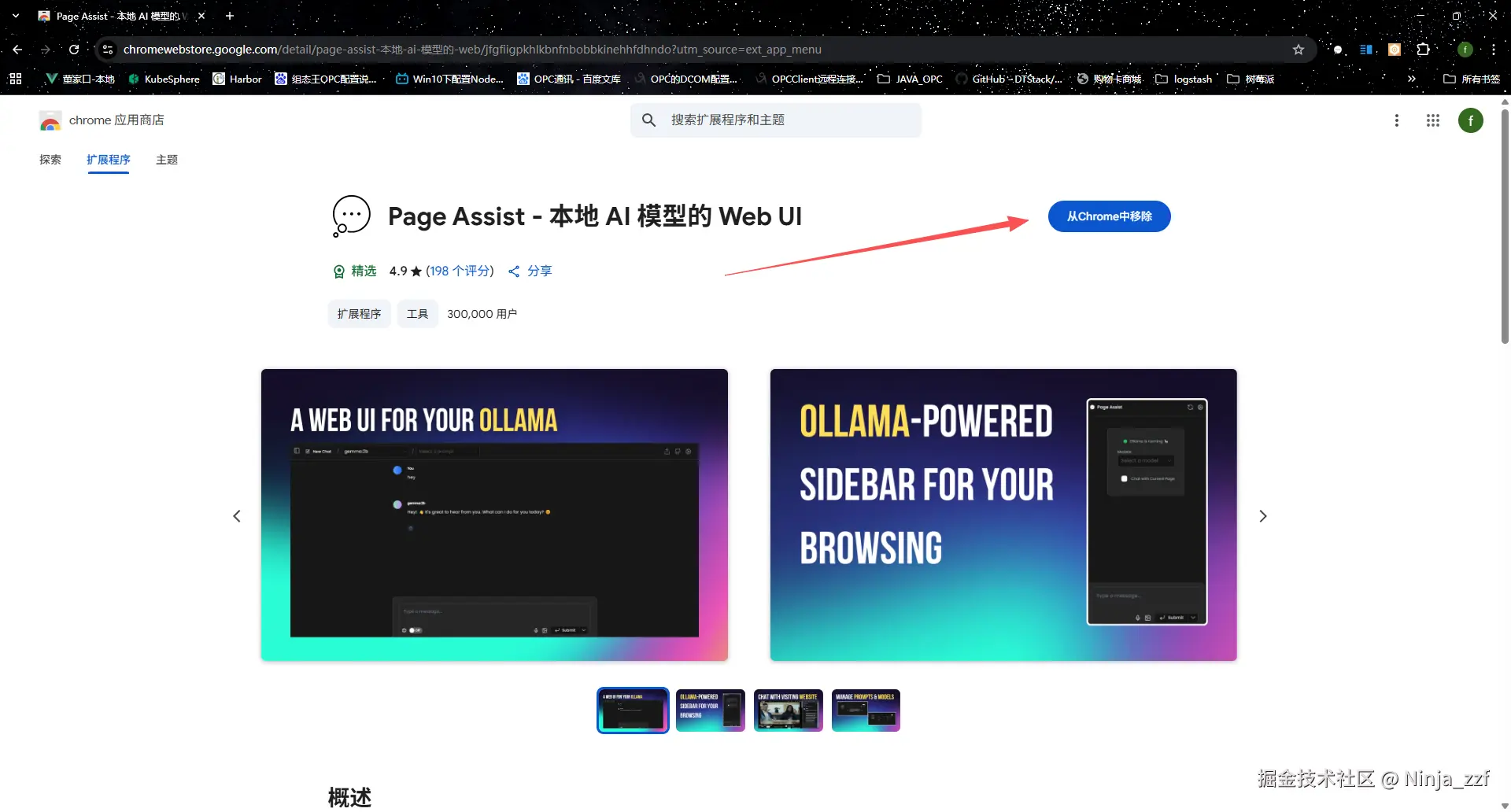

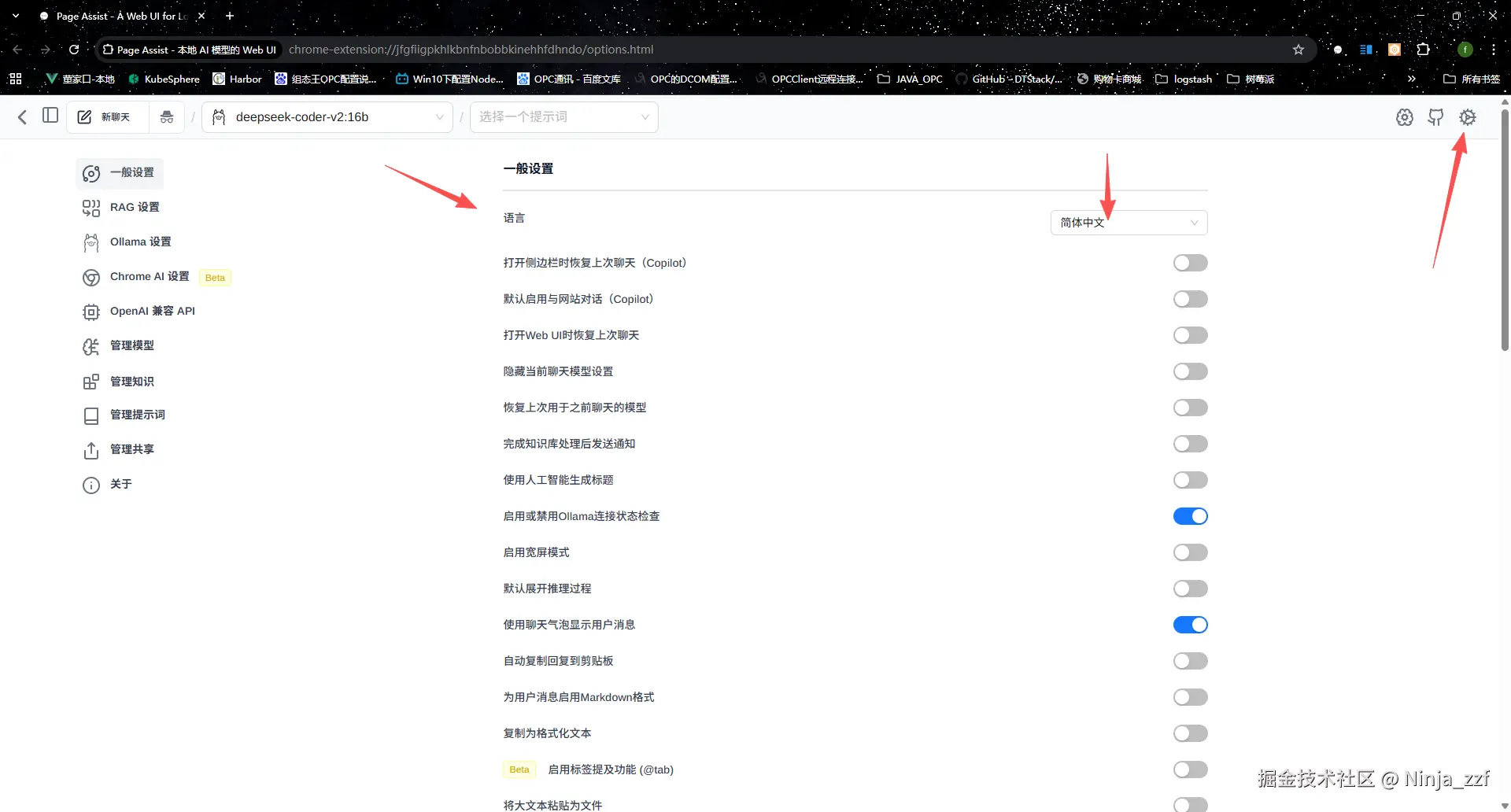

方案 1:Chrome 插件 ------Page Assist(简单快捷,需使用VPN安装谷歌插件)

适合快速上手,无需复杂配置,仅需 Chrome 浏览器即可。

- 打开 Chrome 应用商店,搜索 "Page Assist";

- 点击 "添加至 Chrome",安装完成后将插件固定到浏览器工具栏(这里是因为我已经安装过了);

- 启动 Ollama 服务(在开始菜单搜索 "Ollama",点击启动);

- 点击 Page Assist 插件,首次打开会提示 "Unable to connect to Ollama"------ 确保 Ollama 已启动,刷新插件即可;

- 配置中文:点击插件右上角 "Settings",将 "Language" 改为 "简体中文";

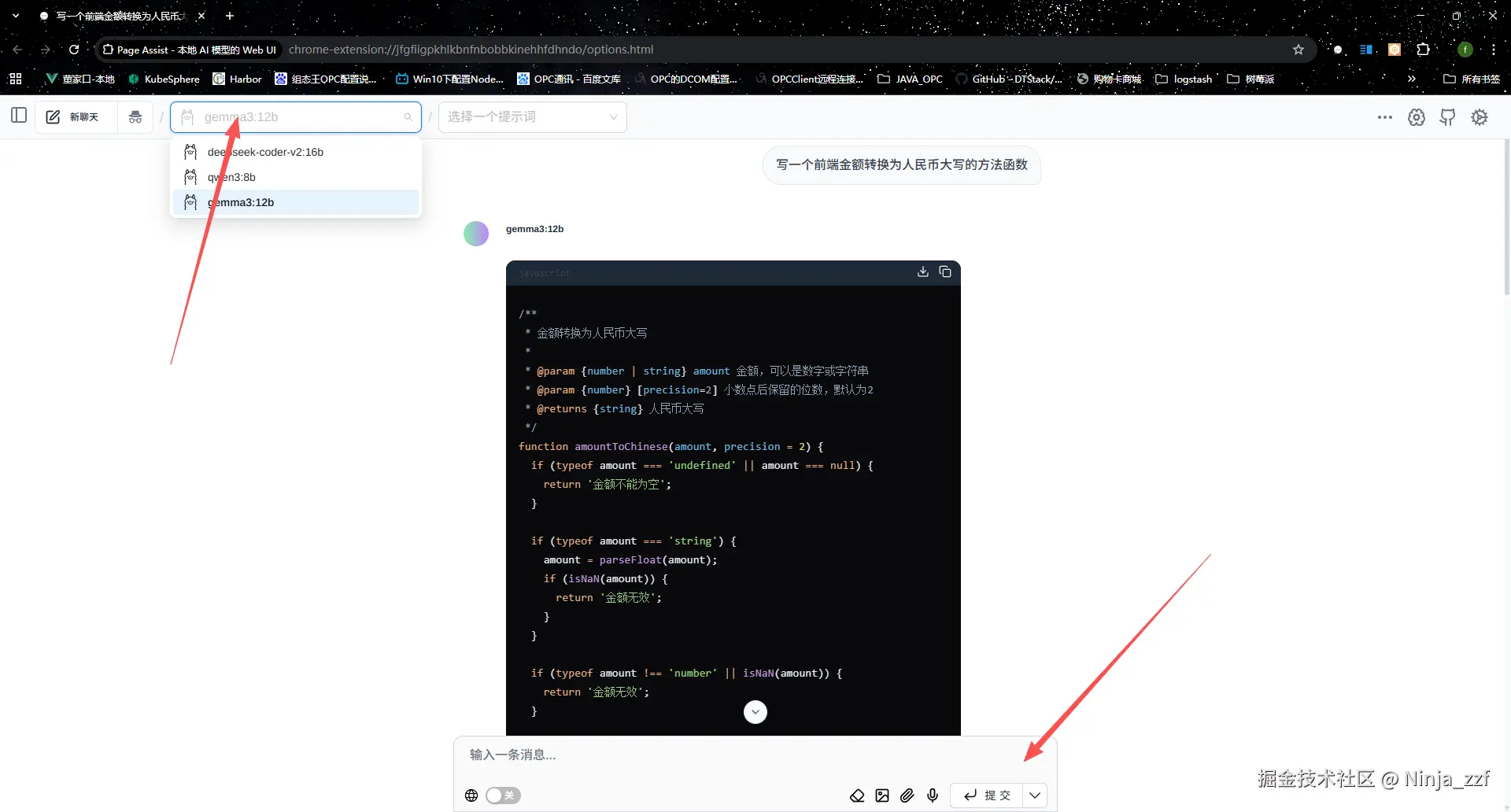

- 选择模型:在插件首页的下拉框中选择自己安装的模型name,即可开始对话。

方案 2:Chatbox(功能强大,支持多模型)

Chatbox 是一款开源的 AI 对话客户端,支持 Ollama、OpenAI 等多种接口,推荐追求功能完整性的用户。

- 下载 Chatbox:访问Chatbox 官网,下载 Windows 版本并安装;

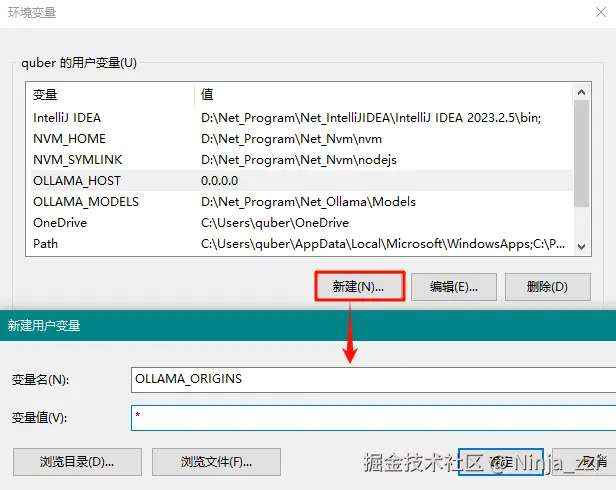

-

配置 Ollama 环境变量(允许 Chatbox 访问):

-

打开 "环境变量",新建两个用户变量:

- 变量名:

OLLAMA_HOST,变量值:0.0.0.0(允许任何 IP 访问 Ollama 服务); - 变量名:

OLLAMA_ORIGINS,变量值:*(允许所有来源请求);

- 变量名:

-

重启 Ollama 服务,确保配置生效;

-

-

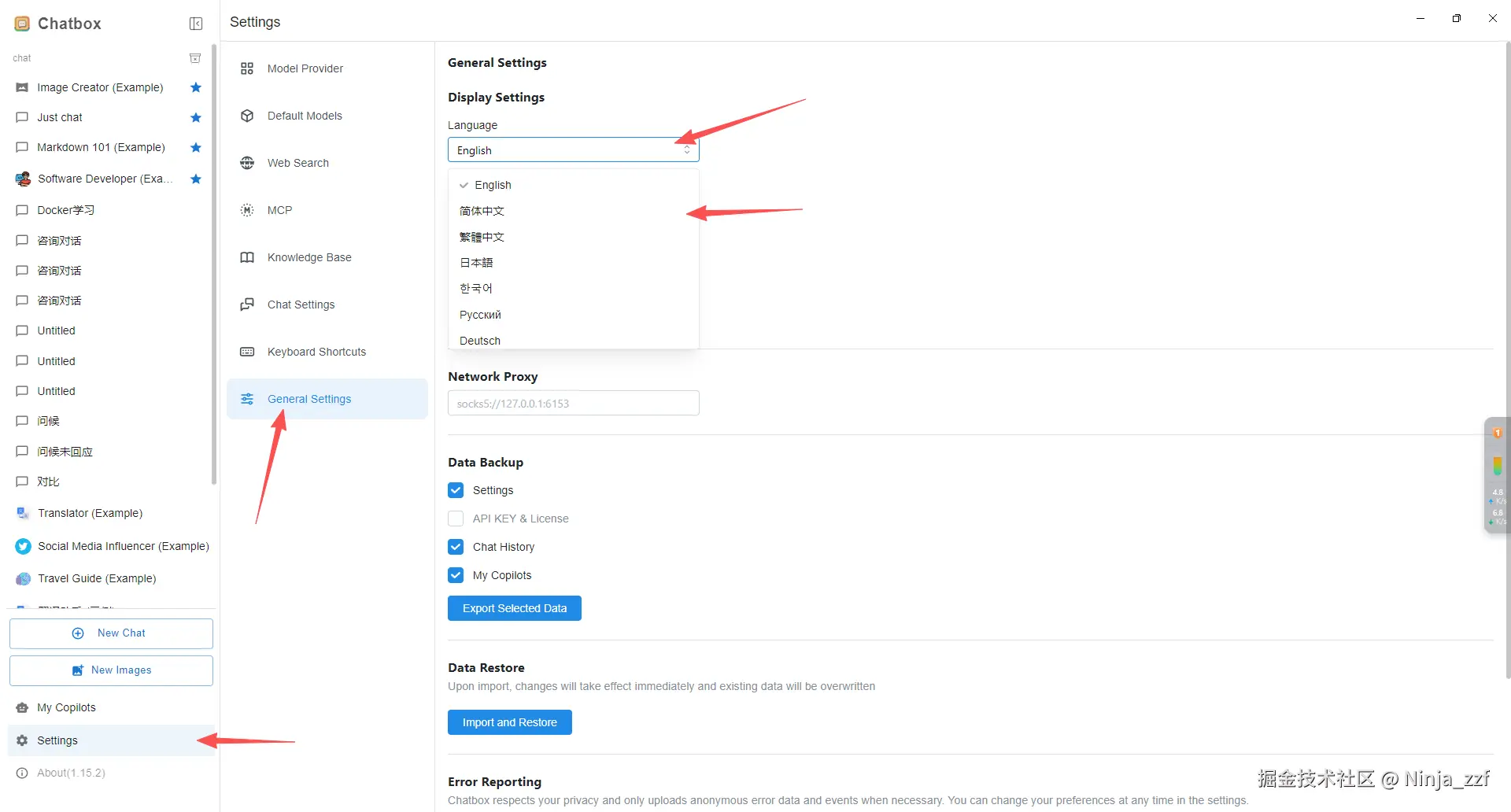

Chatbox设置中文:

- 打开 Chatbox,点击左下角 "设置";

- 选择 "常规设置" ,点击"Language",选择简体中文;

-

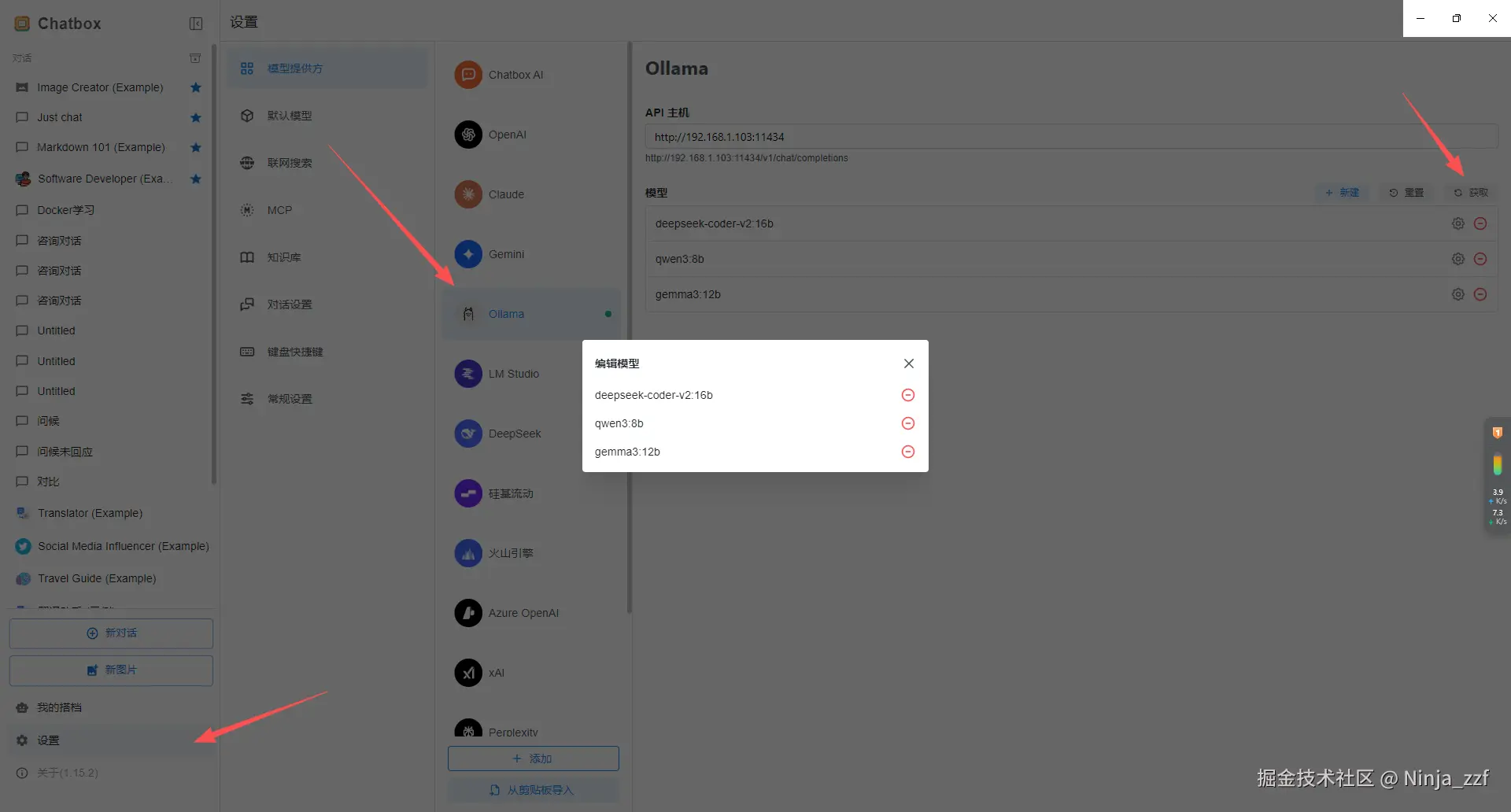

配置 Chatbox:

- 打开 Chatbox,点击左下角 "设置";

- 选择 "模型提供方" 为 "Ollama";

- "模型" 点击获取,勾选自己安装的模型;

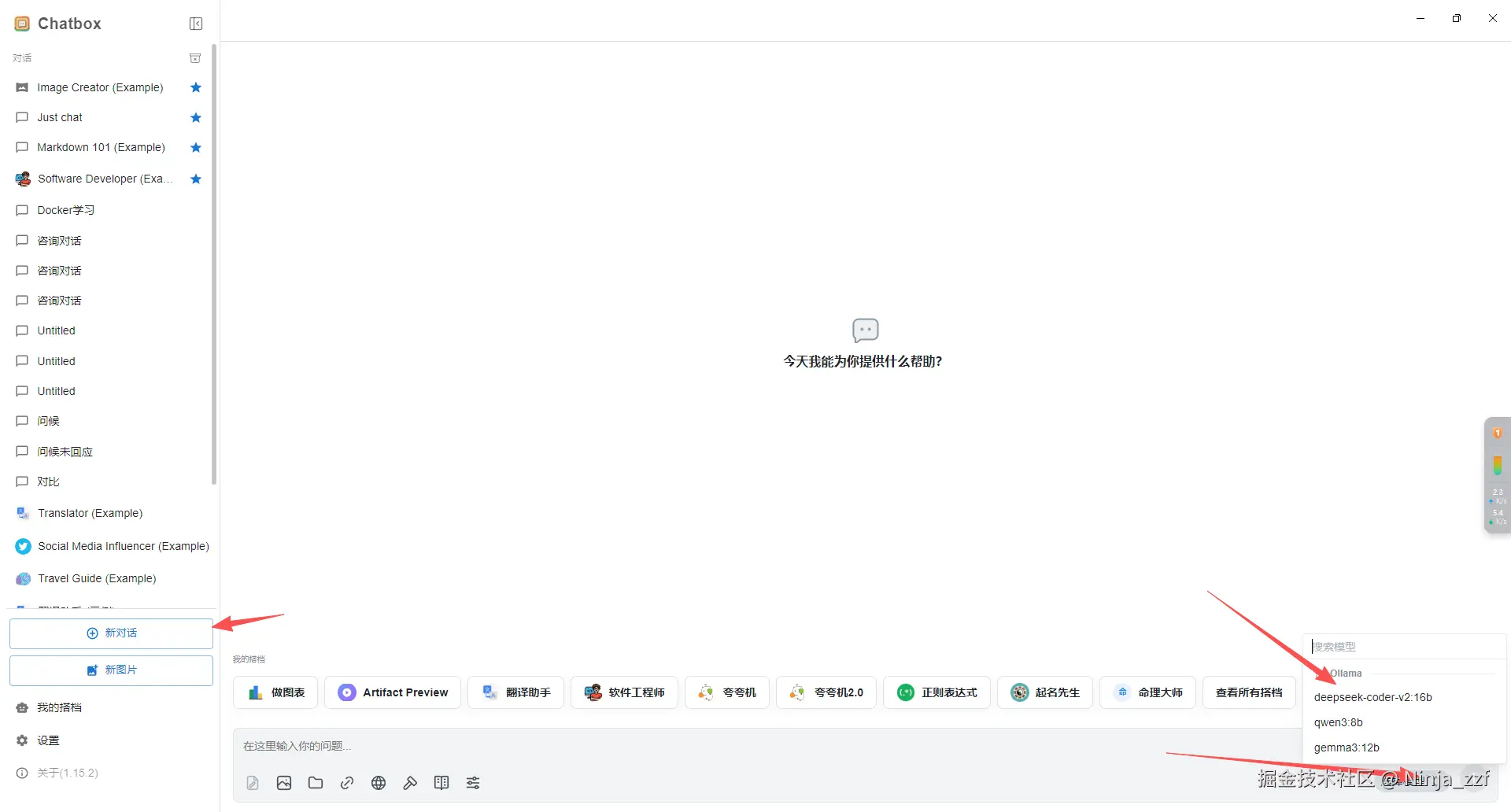

5. 开始对话:返回 Chatbox 主界面,选择模型,然后方可提问。

5. 开始对话:返回 Chatbox 主界面,选择模型,然后方可提问。

七、常见问题与避坑指南

- Ollama 启动失败?

检查是否以管理员身份安装,或尝试重启电脑;若提示 "端口被占用",可通过netstat -ano | findstr 11434(Ollama 默认端口)查看占用进程,结束后重启 Ollama。 - 模型下载速度慢?

尝试切换手机热点、使用加速工具,或多次中断重试(Ctrl+C后重新执行ollama run命令)。 - Web UI 无法连接 Ollama?

确认 Ollama 已启动,且OLLAMA_HOST和OLLAMA_ORIGINS环境变量配置正确;若使用 Chatbox 网页版(web.chatboxai.app/)连接失败,建议下载桌面端程序。 - 运行模型时卡顿 / 闪退?

检查显卡显存是否满足要求,若显存不足,可切换更小参数的模型(如 1.5B),或关闭其他占用显存的程序(如游戏、视频剪辑软件)。

总结

通过 Ollama 部署 DeepSeek-R1 的流程可概括为:安装 Ollama(自定义目录)→ 配置模型存储路径 → 下载模型 → 配置 Web UI。整个过程无需复杂的环境配置,即使是非专业开发者也能在 30 分钟内完成。后续可根据需求尝试 DeepSeek-R1 的代码生成、文档总结等功能,或部署其他开源模型(如 Llama 3、Qwen-7B)。

如果在部署过程中遇到其他问题,可访问 Ollama 官方文档(ollama.com/docs)或 DeepSeek GitHub 仓库(github.com/deepseek-ai...)查找解决方案。