智能交通拥堵治理柔性设计实践复盘小结

一、DDD柔性设计:从矛盾到破局

之前从模式的角度编写了设计模式的落地,本次从智能交通领域拥堵治理子域的整体柔性设计,来应对城市交通存在事故、特殊车流、设备新增等不确定性场景;柔性设计核心是构建"随需而变"能力,关键实践包括:

- 业务规则在线配置:暴雨天临时调整路口绿灯时长,无需停服,30秒内生效;

- 设备协议柔性扩展:新增SCOOT协议信号机,开发适配插件即可接入,上线周期从1周缩至2天;

- 算法热替换:春节返乡潮时切换"节假日专项算法",无需重启调度即使生效;

- 弹性扩容:演唱会散场周边流量骤增5倍时,分钟级自动扩容计算资源,保障资源动态调配。

二、柔性设计四步走:从痛点到方案

通过四步构建可持续演进的智能交通管理系统,解决核心痛点:

1. 领域建模构建:统一语言,隔离变化

- 交通痛点:和业务人员达成共识,不同区域拥堵治理逻辑差异大,但核心规则需统一,避免系统碎片化;

- 技术方案:聚合根封装核心业务规则(如"拥堵治理策略"聚合生效时段、目标区域等)、值对象承载领域知识(如"拥堵等级"红/黄/蓝定义)、工厂隔离复杂创建逻辑(如"策略工厂"生成专用策略)。

2. 事件驱动解耦:让系统"说话",而非"硬编码"

- 交通痛点:多子系统协同解藕(如拥堵升级时同步调信号+推绕行信息),硬编码调用易"牵一发而动全身";

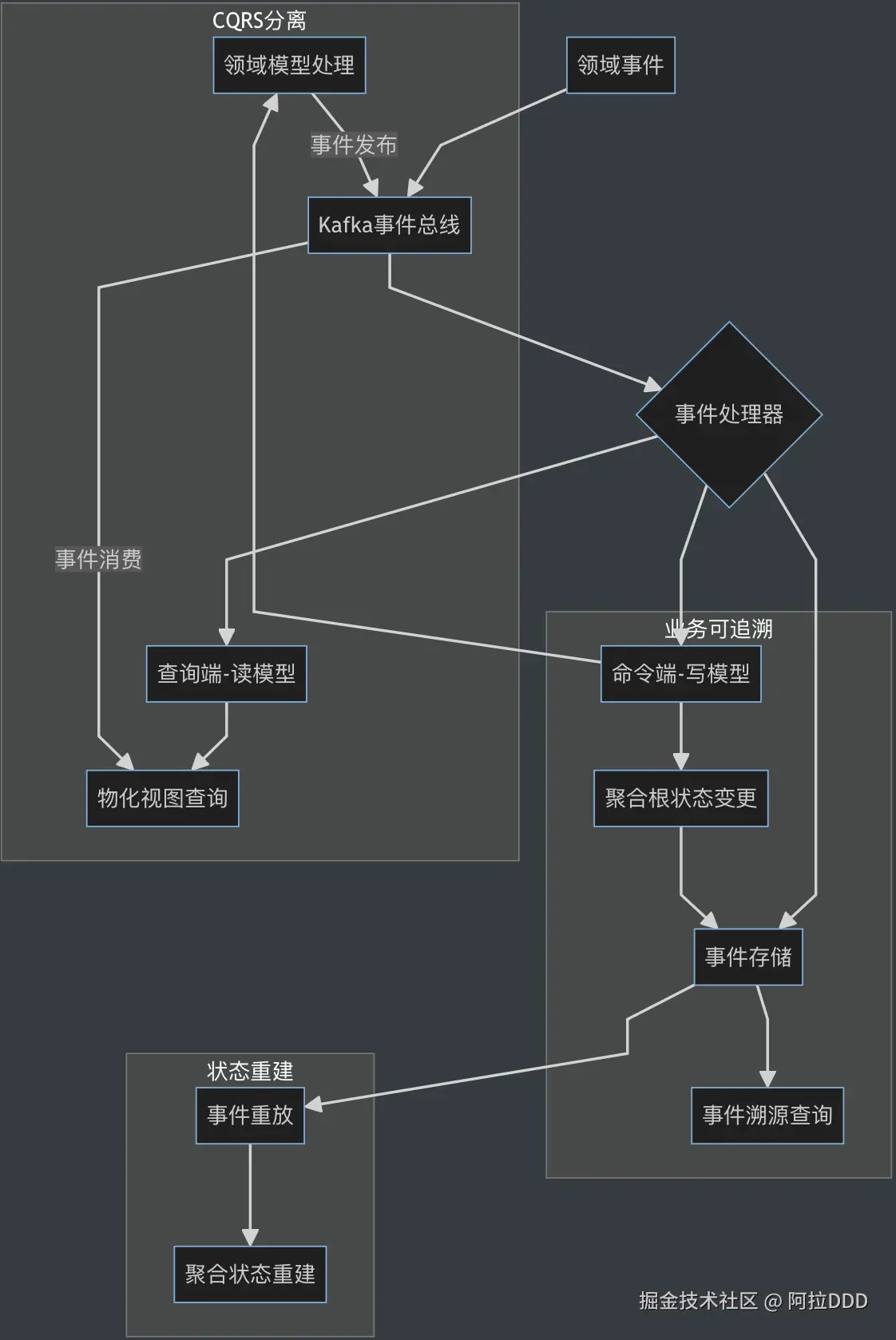

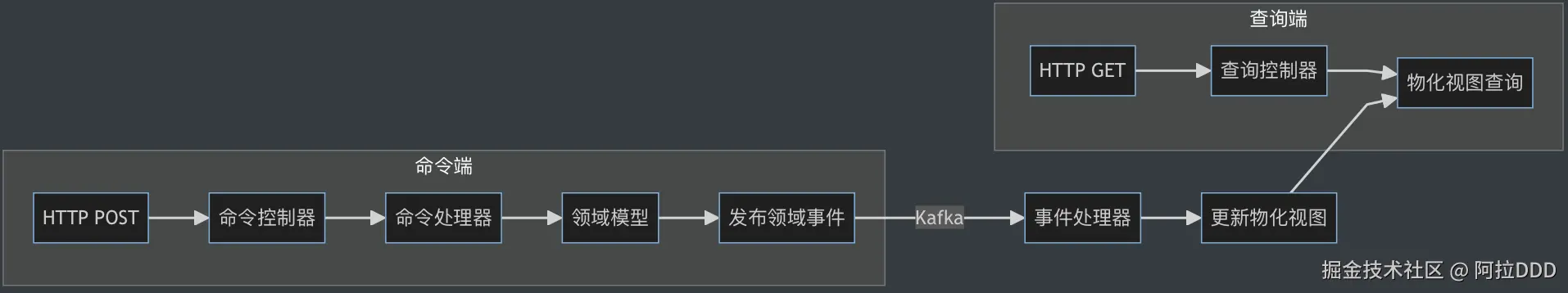

- 技术方案:领域事件驱动串联跨系统协作(如"拥堵升级事件"触发多服务响应)、CQRS分离读写(查询不影响实时控制性能)、事件溯源支持回溯(还原策略调整轨迹)。

3. 技术模式适配扩展:用设计模式化解多样性难题

-

交通痛点:数据采集、设备协议多样,方案需适应多变场景;

-

技术方案:

- 策略+观察者模式:适配多源设备数据格式,实时感知数据异常;

- 工厂+责任链模式:快速创建治理方案,按拥堵等级依次执行避免冲突;

- 适配+桥接模式:统一设备协议接口,分离控制逻辑与硬件交互。

4. 弹性基础设施支持动态伸缩:打破边界,随需而变

- 交通痛点:行政与物理边界导致资源利用率低、跨区协调滞后;

- 技术方案:k8s实现资源弹性调度、按"行政边界+路网拓扑"分片部署区域决策节点、Flink流处理按区域ID分区保证计算效率。

三、领域模型防腐:从DDD驱动设计到C4Model落地

1、限界上下文:定义系统"职责范围"

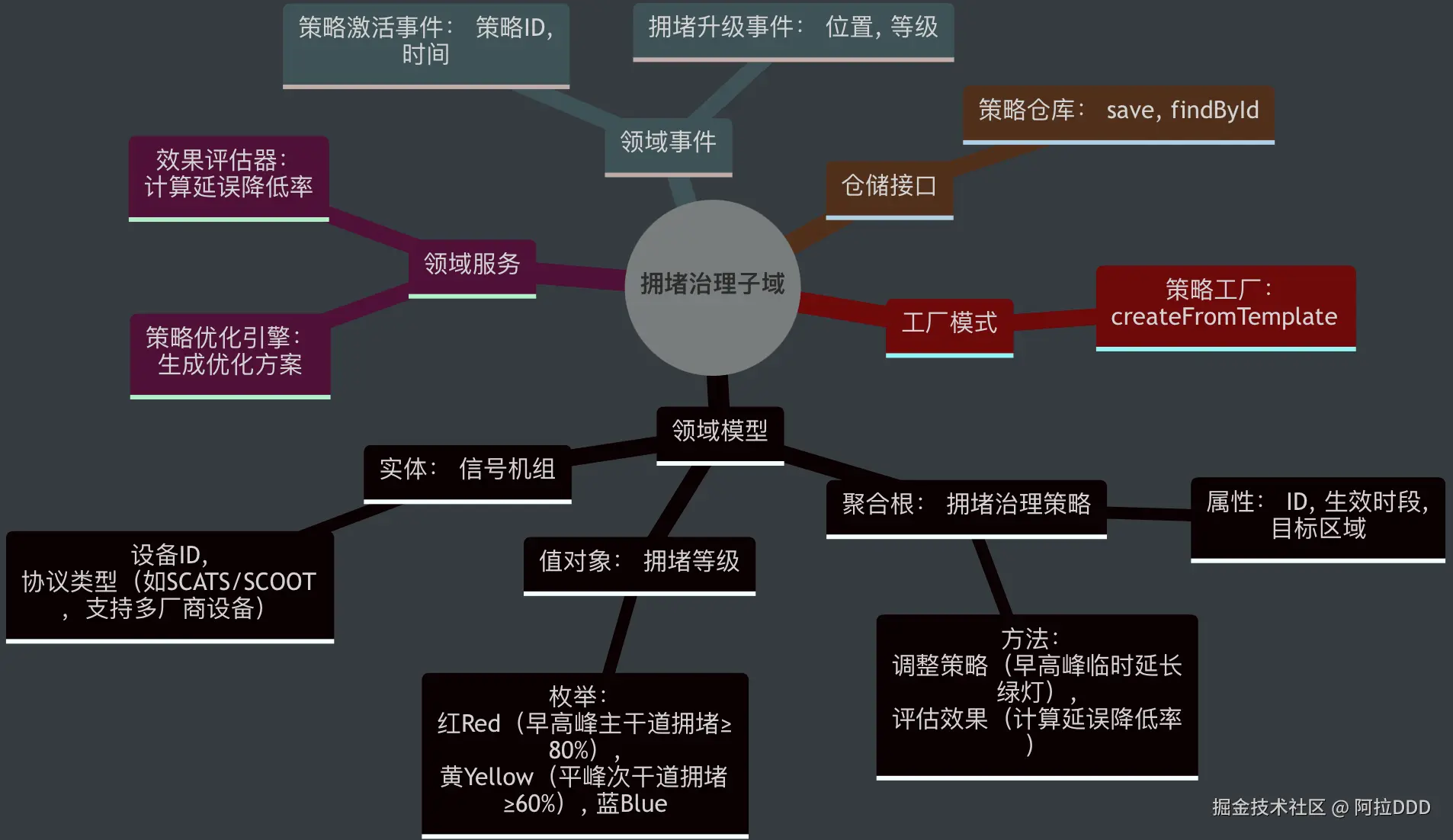

用mindmap梳理拥堵治理核心域:

设计思路:

- 核心决策域:治理策略生成与优化

- 支撑域:信号控制/诱导发布/仿真验证

- 事件驱动:Kafka实现最终一致性

- 协议适配:gRPC用于高效内部通信

边界设计依据

- 为何决策中心与信号控制系统用 MQTT 协议? 「场景」:信号机多部署在户外,网络不稳定,MQTT 的 "发布 - 订阅" 模式支持断网重连,确保控制指令不丢失。

- 为何诱导发布系统用 Kafka? 「场景」:晚高峰需向 10 万 + 车主推送绕行信息,Kafka 的高吞吐能力支持消息秒级扩散。

2、C4上下文设计:让协作有章可循

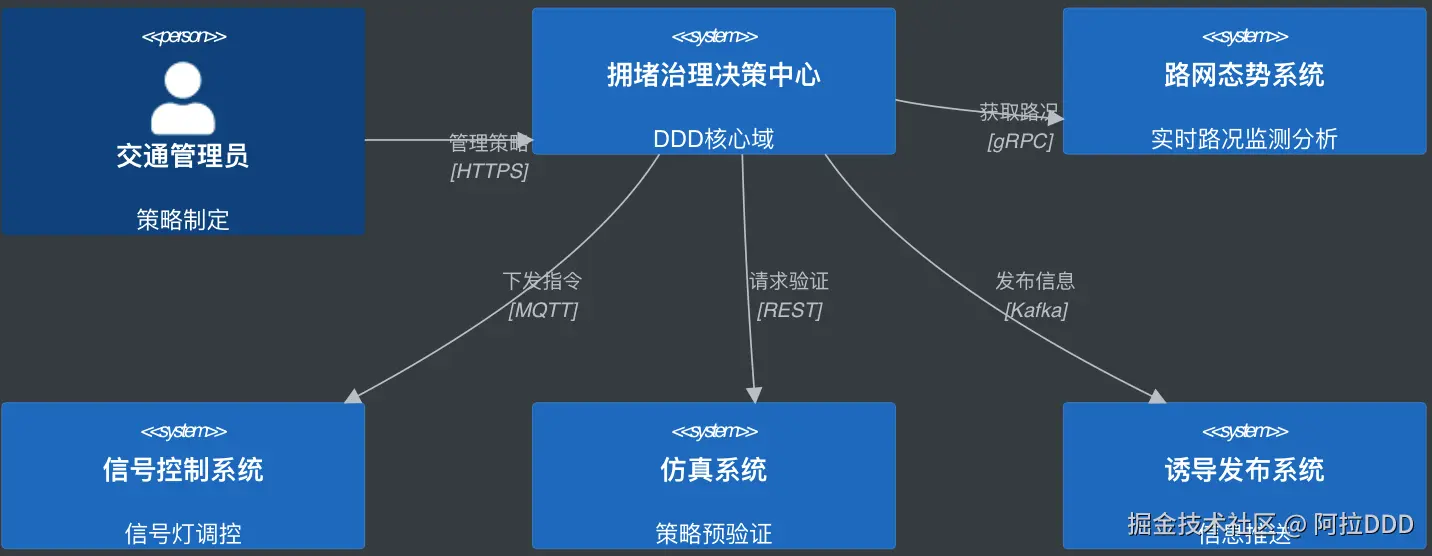

C4上下文图定义各系统分工:

设计思路:

- 核心决策域:治理策略生成与优化

- 支撑域:信号控制/诱导发布/仿真验证

- 事件驱动:Kafka实现最终一致性

- 协议适配:gRPC用于高效内部通信

边界设计依据

- 为何决策中心与信号控制系统用 MQTT 协议? 「场景」:信号机多部署在户外,网络不稳定,MQTT 的 "发布 - 订阅" 模式支持断网重连,确保控制指令不丢失。

- 为何诱导发布系统用 Kafka? 「场景」:晚高峰需向 10 万 + 车主推送绕行信息,Kafka 的高吞吐能力支持消息秒级扩散。

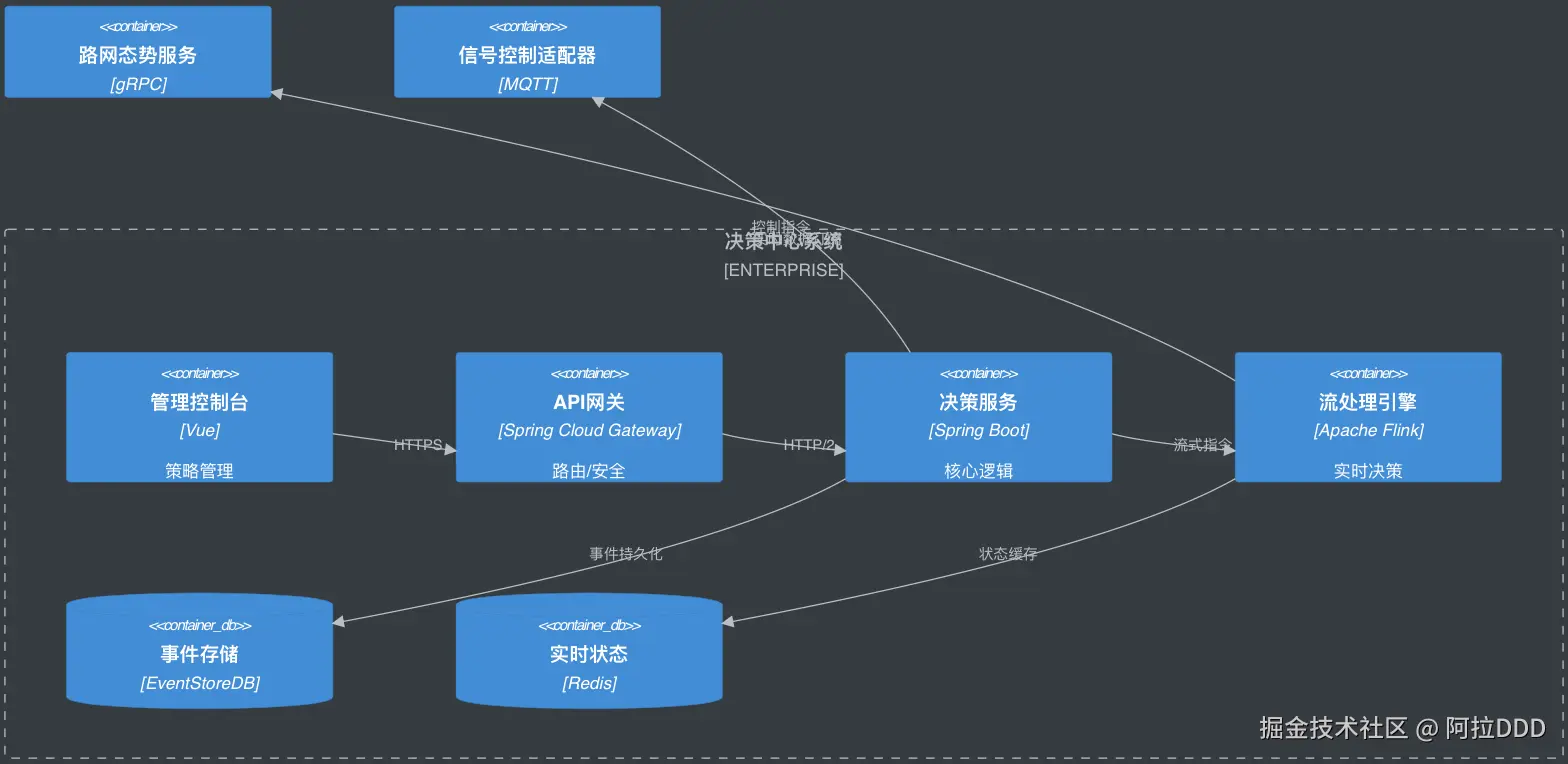

3、C4容器视图:流动的数据,高效的决策

决策中心容器设计围绕"实时性"展开:

交互流程:

交互流程:

- 路况数据 → Flink实时处理 → 决策引擎

- 决策服务 → 信号控制指令 → MQTT下发

- 执行反馈 → 事件溯源 → 策略优化

设计决策依据:

- 为何选择 Flink 而非 Spark Streaming 做流处理? 业务场景要求毫秒级实时决策 (如早高峰突发拥堵需立即调整信号配时),Flink 的基于事件时间的精确处理 和状态一致性保障,能避免 Spark Streaming 微批处理带来的秒级延迟,确保路况数据无间断实时分析。

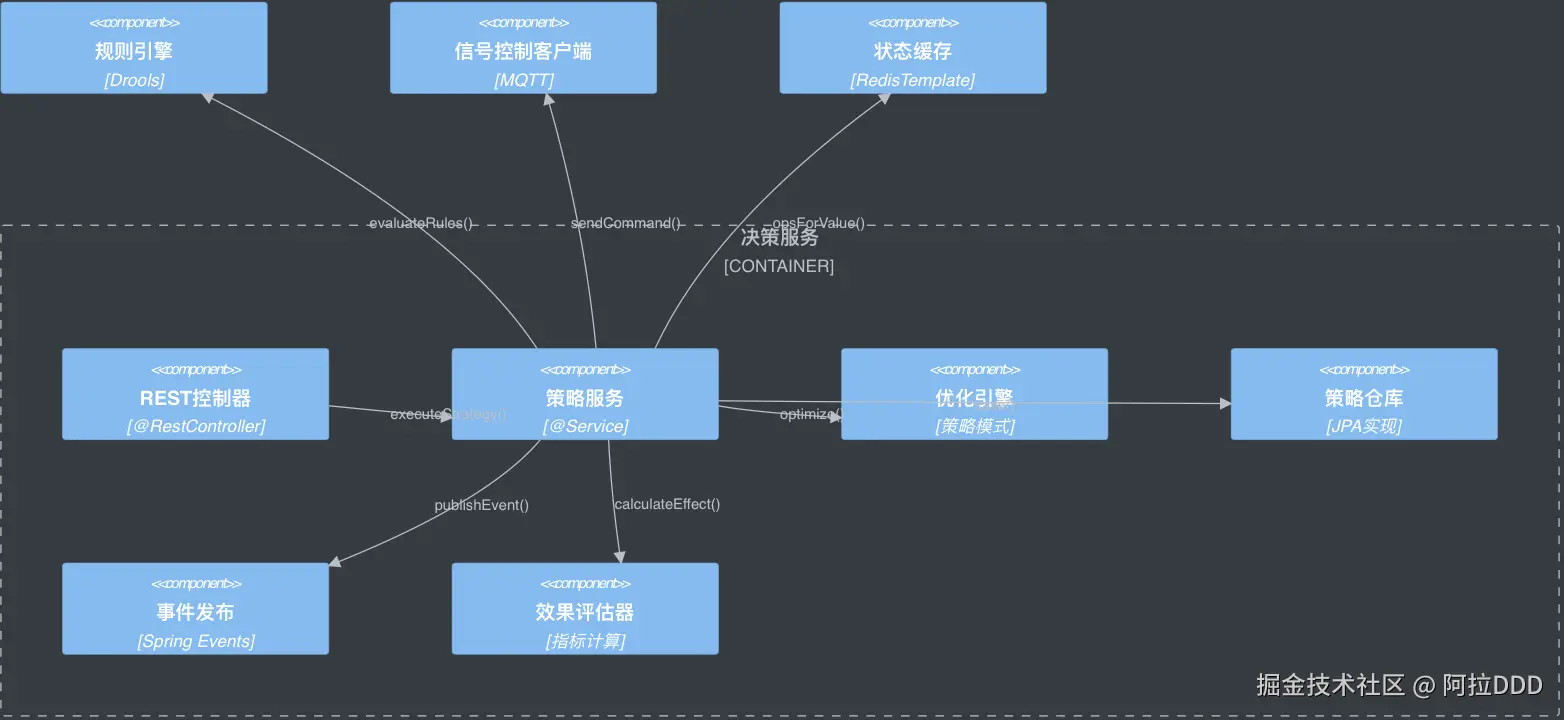

4、C4组件视图:各司其职,灵活协同

决策服务组件分工:

设计思路:

设计思路:

- 全流程闭环域:决策服务作为智能交通拥堵治理的核心执行单元,需实现 "策略接收 - 优化 - 验证 - 执行 - 反馈" 的全流程闭环。

- "高内聚、低耦合" :通过分层拆分与职责隔离,支撑柔性设计中的 "业务规则可配置、策略可扩展、执行可追溯" 需求。

- 核心逻辑链:外部请求(如管理员调整策略、实时路况触发)通过 REST 控制器进入系统,由策略服务统筹调度各组件完成策略优化、规则验证、效果评估等操作,最终通过信号控制客户端执行指令,并将过程以事件形式发布,同时同步数据至仓库与缓存,确保全链路可追溯、可复用。

设计要求

- 无冗余依赖:所有组件仅与策略服务交互,避免 "网状依赖"(如优化引擎不直接调用信号客户端),确保某组件升级(如更换仓库为 MongoDB)时,仅需修改策略服务的适配代码。

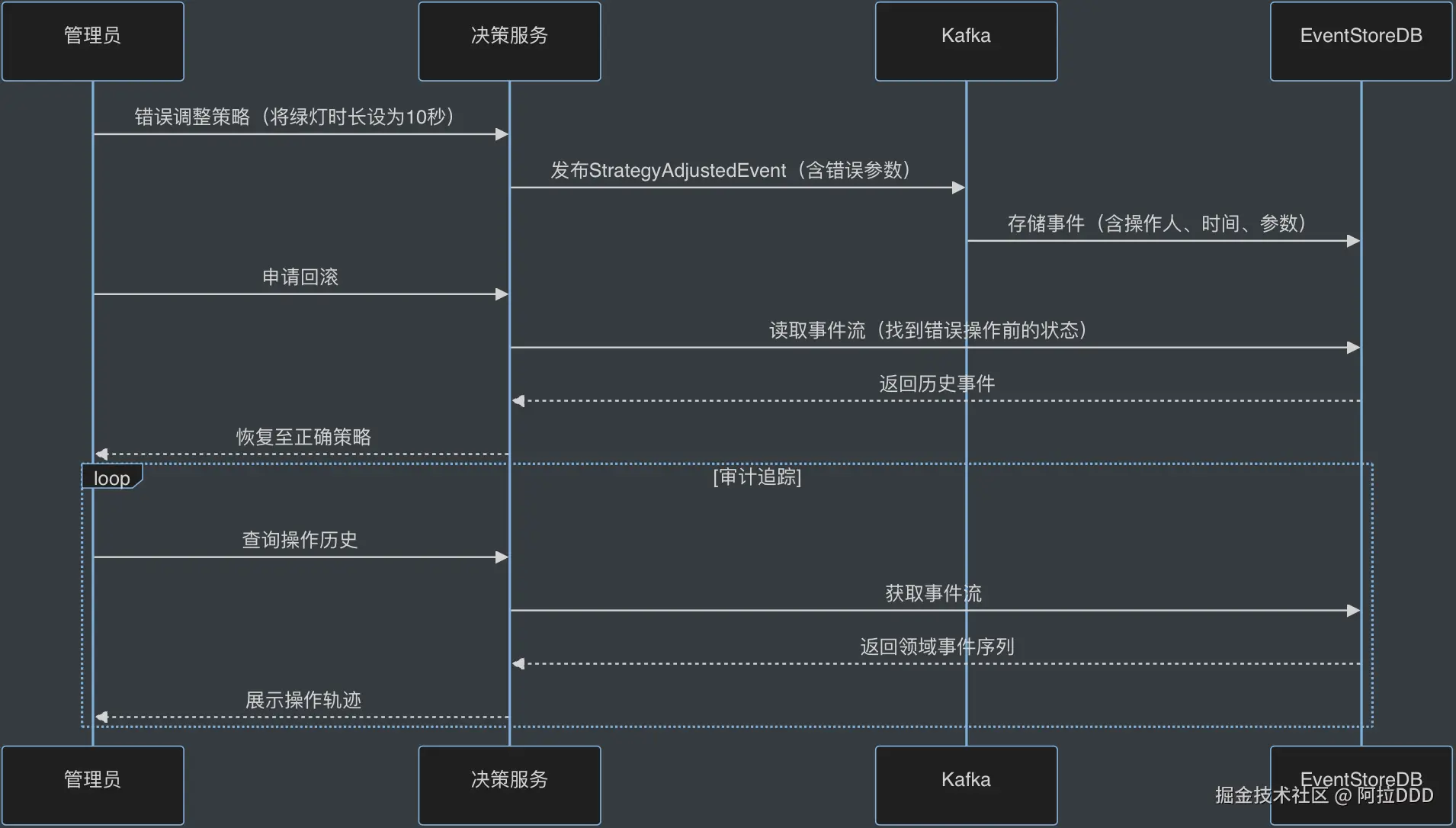

- 流程可追溯:从请求进入到指令执行,每一步操作均通过事件发布记录(如StrategyOptimizedEvent"RuleEvaluatedEvent),结合仓库存储的策略数据,可完整还原某次拥堵治理的全流程,支撑业务审计与优化迭代。

关键组件设计:

-

策略服务(strategy_service)作为核心协调者

- 设计依据:拥堵治理策略的生成需多步骤协同(如优化算法选择、规则校验、效果预测),将这些能力聚合到策略服务中,避免组件间直接交互导致的耦合。例如:早高峰某路口拥堵时,策略服务需先调用优化引擎生成配时方案,再通过规则引擎验证是否符合 "学校区域限速" 等特殊规则,最后调用效果评估器预测延误降低率,全过程由策略服务统一调度,确保业务逻辑的连贯性。

- 业务关联:解决 "多环节协同的复杂性"------ 若组件间直接通信(如优化引擎直接调用规则引擎),会导致某环节修改(如更换规则引擎)时需重构多个组件,而策略服务作为中间层,可隔离这种变更影响。

-

优化引擎(optimizer)采用策略模式

- 设计依据 :不同场景需不同优化算法(如早高峰用 "绿波带协调" 算法,突发事故用 "局部优先疏解" 算法),策略模式允许动态切换算法而无需修改核心逻辑。例如:春节返乡潮期间,策略服务可通过

optimize()方法动态调用 "节假日反向流量算法",替换平日的 "通勤算法",且切换过程不影响其他组件。 - 技术必要性:符合柔性设计中 "算法热替换" 需求,避免因算法迭代导致服务停机。

- 设计依据 :不同场景需不同优化算法(如早高峰用 "绿波带协调" 算法,突发事故用 "局部优先疏解" 算法),策略模式允许动态切换算法而无需修改核心逻辑。例如:春节返乡潮期间,策略服务可通过

-

规则引擎(rule_engine)独立部署(Drools)

- 设计依据 :交通治理规则具有强业务属性且频繁变动(如新增 "暴雨天限速规则""高考期间禁鸣规则"),采用 Drools 作为独立规则引擎,支持规则以脚本形式在线更新,无需修改代码或重启服务。例如:策略服务通过

evaluateRules()方法将实时路况数据传入规则引擎,引擎自动匹配最新规则(如 "早 7 点 - 8 点学校周边绿灯延长 20 秒"),返回是否允许执行当前策略。 - 业务价值:将 "业务规则" 与 "技术代码" 分离,交通管理员可通过可视化平台修改规则,响应速度从 "天级" 缩短至 "分钟级"。

- 设计依据 :交通治理规则具有强业务属性且频繁变动(如新增 "暴雨天限速规则""高考期间禁鸣规则"),采用 Drools 作为独立规则引擎,支持规则以脚本形式在线更新,无需修改代码或重启服务。例如:策略服务通过

-

事件发布组件(event_pub)与外部事件总线联动

- 设计依据 :策略调整、指令执行等关键操作需同步至其他系统(如诱导发布系统、仿真系统),通过 Spring Events 将事件聚合后发布至 Kafka,确保跨系统协同的最终一致性。例如:策略服务执行信号配时调整后,事件发布组件会发布

StrategyAdjustedEvent,诱导发布系统订阅该事件后,可立即推送绕行信息,实现 "信号调整 + 诱导引导" 的联动。 - 技术选型:Spring Events 负责内部事件聚合,Kafka 负责跨系统传输,结合事件溯源设计,可通过事件流还原任意时间点的策略状态,支撑故障排查与审计需求。

- 设计依据 :策略调整、指令执行等关键操作需同步至其他系统(如诱导发布系统、仿真系统),通过 Spring Events 将事件聚合后发布至 Kafka,确保跨系统协同的最终一致性。例如:策略服务执行信号配时调整后,事件发布组件会发布

-

信号控制客户端(signal_client)基于 MQTT 协议

- 设计依据 :信号机多部署于户外,存在网络波动(如暴雨导致 网络信号中断),MQTT 协议支持 "发布 - 订阅" 模式与断网重连,确保控制指令不丢失。例如:策略服务通过

sendCommand()下发绿灯延长指令时,若信号机临时离线,客户端会缓存指令,待网络恢复后自动重发,避免因瞬时网络问题导致策略执行失败。 - 业务关联:解决 "设备通信可靠性" 问题,保障跨区域信号联动的稳定性(如主城区与郊区快速路的信号协同)。

- 设计依据 :信号机多部署于户外,存在网络波动(如暴雨导致 网络信号中断),MQTT 协议支持 "发布 - 订阅" 模式与断网重连,确保控制指令不丢失。例如:策略服务通过

-

Redis 缓存(redis_template)存储实时状态

- 设计依据 :策略执行过程中需频繁访问实时数据(如当前信号配时、拥堵等级),Redis 的高性能读写能力可支撑毫秒级响应。例如:效果评估器计算延误率时,需实时获取路口当前通行量,通过

opsForValue()从 Redis 读取(而非查询数据库),确保评估结果的实时性。 - 数据一致性:缓存数据与事件存储联动,策略调整后通过事件触发缓存更新,避免 "缓存与数据库不一致" 导致的决策错误。

- 设计依据 :策略执行过程中需频繁访问实时数据(如当前信号配时、拥堵等级),Redis 的高性能读写能力可支撑毫秒级响应。例如:效果评估器计算延误率时,需实时获取路口当前通行量,通过

-

REST 控制器(controller)与仓库(repository)的职责隔离

- 设计依据 :控制器仅负责请求解析与响应封装,不处理业务逻辑,避免 "接口层与业务层耦合"。例如:管理员通过

/strategy/adjust接口提交调整请求,控制器仅验证参数格式,将核心逻辑交给策略服务,符合 "单一职责原则"。 - 仓库(repository)采用 JPA 实现:支持策略数据的持久化与复杂查询(如按区域、时段筛选历史策略),为事后复盘(如分析某策略的长期效果)提供数据支撑。

- 设计依据 :控制器仅负责请求解析与响应封装,不处理业务逻辑,避免 "接口层与业务层耦合"。例如:管理员通过

5、Java代码实现(核心片段)

5.1 聚合根实现

typescript

public class CongestionMitigationStrategy extends AbstractAggregateRoot<CongestionMitigationStrategy> {

public record GeoPolygon(List<Coordinate> points) {}

@Id

private StrategyId id;

private TimeWindow effectivePeriod;

private GeoPolygon targetArea;

private AlgorithmType algorithmType;

// 柔性设计点:动态切换算法,无需重启服务

public void switchAlgorithm(AlgorithmType newType) {

if (this.algorithmType != newType) {

registerEvent(new AlgorithmChangedEvent(this.id, newType));

this.algorithmType = newType;

}

}

public void executeCommand(SignalCommand command) {

validateCommand(command);

registerEvent(new SignalCommandEvent(command));

}

@DomainEvents

public Collection<Object> domainEvents() {

return super.domainEvents();

}

}5.2 领域服务实现

typescript

@Service

public class StrategyOptimizationService {

private final Map<AlgorithmType, OptimizationAlgorithm> algorithms;

@Autowired

public StrategyOptimizationService(List<OptimizationAlgorithm> algorithmImpls) {

algorithms = algorithmImpls.stream()

.collect(Collectors.toMap(

OptimizationAlgorithm::getAlgorithmType,

Function.identity()

));

}

// 柔性设计点:可插拔算法

public SignalPlan optimize(TrafficMetrics metrics, AlgorithmType type) {

return algorithms.get(type).optimize(metrics);

}

@TransactionalEventListener(phase = AFTER_COMMIT)

public void handleAlgorithmChanged(AlgorithmChangedEvent event) {

log.info("Algorithm changed to {} for strategy {}",

event.newType(), event.strategyId());

}

}5.3 协议适配器实现

less

@Component

@ConditionalOnProperty(name = "signal.protocol", havingValue = "scats")

public class ScatsAdapter implements SignalControlAdapter {

private final ScatsClient client;

// 柔性设计点:适配不同协议信号机,新增设备仅扩展适配器

@Override

public void sendCommand(SignalCommand command) {

ScatsProtocol scatsCmd = convertCommand(command);

client.send(scatsCmd);

}

private ScatsProtocol convertCommand(SignalCommand command) {

return new ScatsProtocol(

command.intersectionId(),

command.phaseTimings().stream()

.map(pt -> new PhaseSetting(pt.phaseId(), pt.duration()))

.toList()

);

}

}四、事件驱动:让系统自己"讲故事"

1、事件驱动架构全景设计

以"早高峰路口拥堵升级(黄→红)"场景为例,展示架构逻辑:

2、领域事件有效管理

以"管理员误操作策略需回滚"场景为例,展示业务可追溯能力:

3、CQRS读写分离设计

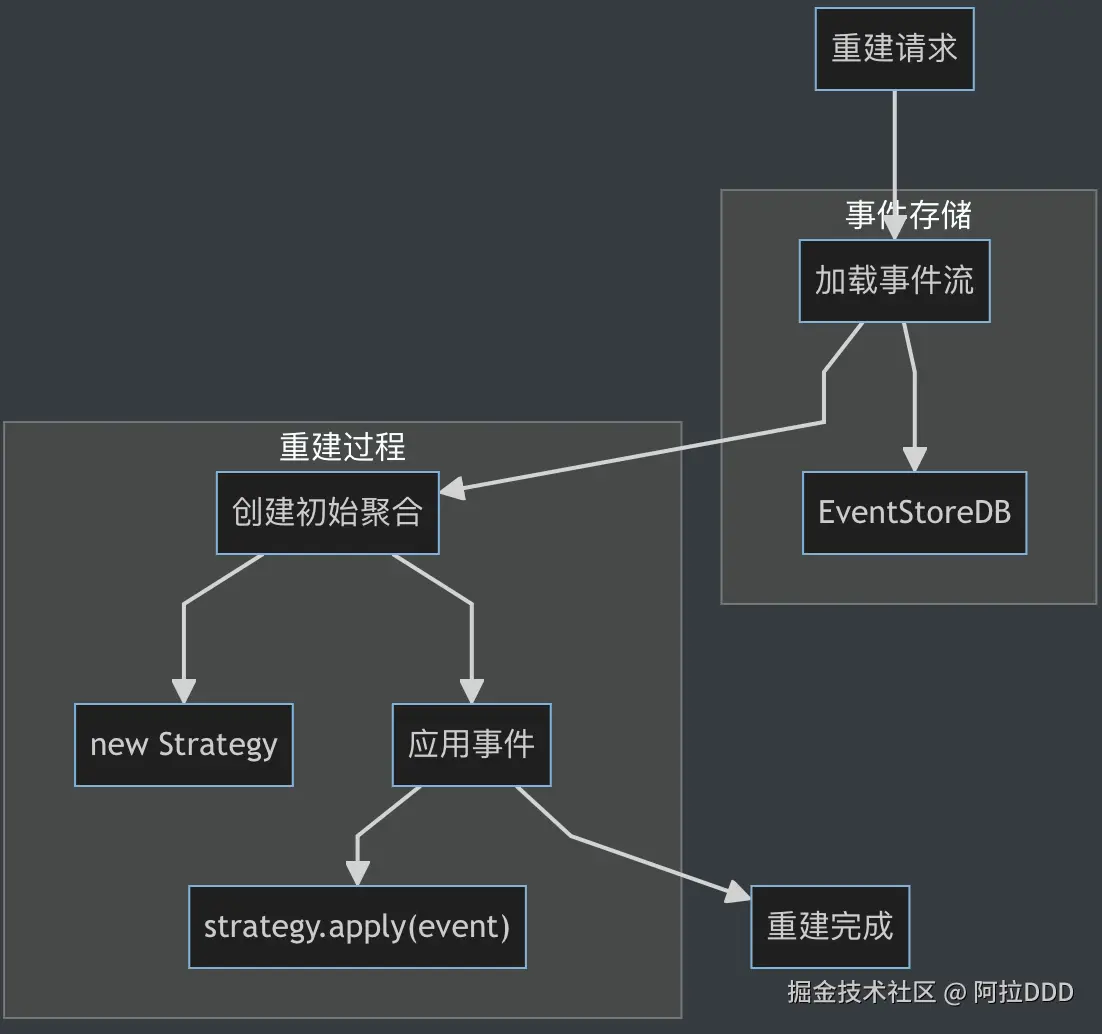

4、事件追溯支持状态重建

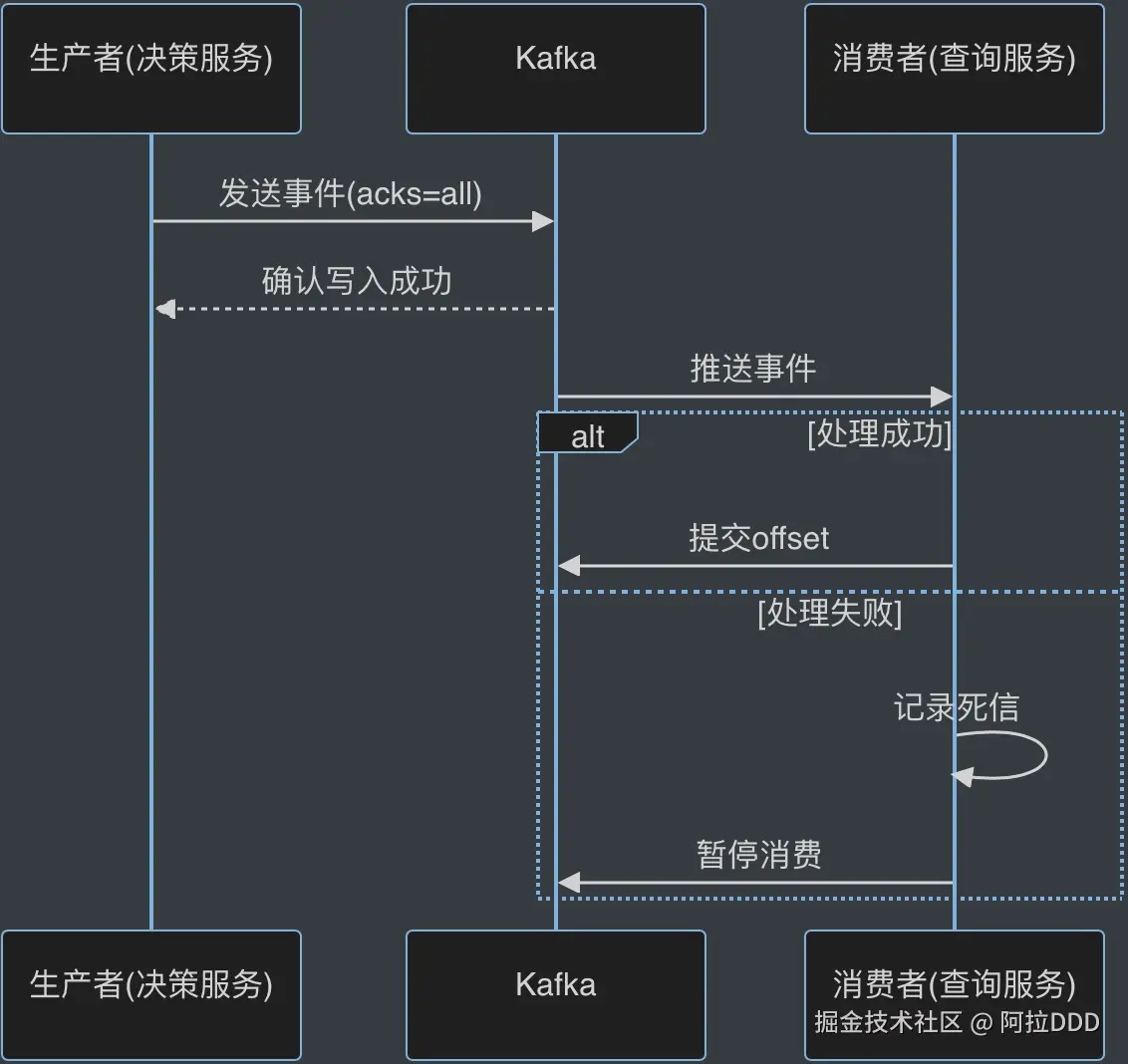

5、Kafka最终一致性实现

5.1 消息传递保障

设计决策依据:

设计决策依据:

- 为何选择 Kafka 而非 RabbitMQ 作为事件总线? 智能交通场景下,事件吞吐量峰值可达 10 万 +/ 秒 (如晚高峰全路网状态同步),且需要事件持久化与重放能力(用于策略调整追溯和系统故障恢复)。Kafka 的分区机制支持水平扩展,且磁盘持久化特性天然适配事件溯源需求,并且之前有同事在其他项目中使用过;而 RabbitMQ 在高吞吐场景下性能衰减更明显,且持久化配置复杂。