在一家大型装备制造企业的智能工厂推进过程中,数据团队遭遇了一个棘手问题:生产线上数百台数控机床、PLC控制器和MES系统每分钟都在产生大量运行日志、工艺参数和设备状态数据。这些数据分散存储于不同的边缘数据库(如SQLite)、工业SCADA系统(基于Oracle)、时序数据库(InfluxDB)以及Kafka消息队列中。更复杂的是,同一设备的"停机代码"在不同车间的定义不一致------有的用数字编码,有的用中文描述;部分传感器上报的时间戳未做时区对齐;某些关键字段(如主轴温度)存在异常跳变或长时间恒定值,疑似采集故障。

项目目标是把这些数据统一归集到数据湖中,用于设备健康预测和OEE(设备综合效率)分析。然而,传统的ETL工具只能按固定周期批量抽取,无法应对高频率、小批次的流式数据;清洗工作依赖Python脚本手工处理,维护成本极高;一旦上游数据格式变更,整个流程就会中断,缺乏自动感知与适配能力。

这正是当前制造业数字化转型中的典型缩影:数据量大、源头杂、质量差、时效紧,而传统ETL架构却仍停留在"定时搬运"的初级阶段。

一、引言:从"搬运工"到"智能工厂"

过去十年,ETL的核心价值被简化为"把A库的数据搬到B库"。这种模式在小规模、静态数据场景下尚可运行,但在当前多源异构、高频更新、强合规性的业务环境中已显疲态。

真实痛点包括:

-

数据源多样性加剧:关系型数据库、NoSQL、消息队列、API接口共存;

-

数据质量参差不齐:缺失、重复、格式错误频发;

-

时效性要求提升:T+1批处理难以支撑实时风控、动态营销等场景;

-

治理合规压力增大:GDPR、等保2.0等法规对数据血缘、脱敏提出明确要求。

因此,现代ETL平台必须超越简单的数据迁移功能,向智能化转换与清洗演进。谷云科技ETLCloud其设计理念正是围绕"全流程数据治理"展开,在保障高效传输的同时,集成元数据管理、规则引擎、流式处理与可视化编排能力,真正实现从"搬数据"到"炼数据"的跃迁。

二、智能数据转换:从规则到算法的升级

1.多源数据统一建模

ETLCloud支持超过100种主流数据源连接器,涵盖MySQL、PostgreSQL、Oracle、SQL Server、MongoDB、Kafka、Hive、HBase、SAP、Salesforce等常见系统。更重要的是,平台通过自动元数据采集机制,可在连接后秒级解析表结构、字段类型、主外键关系,并生成标准化的中间模型。

2.高级数据转换功能

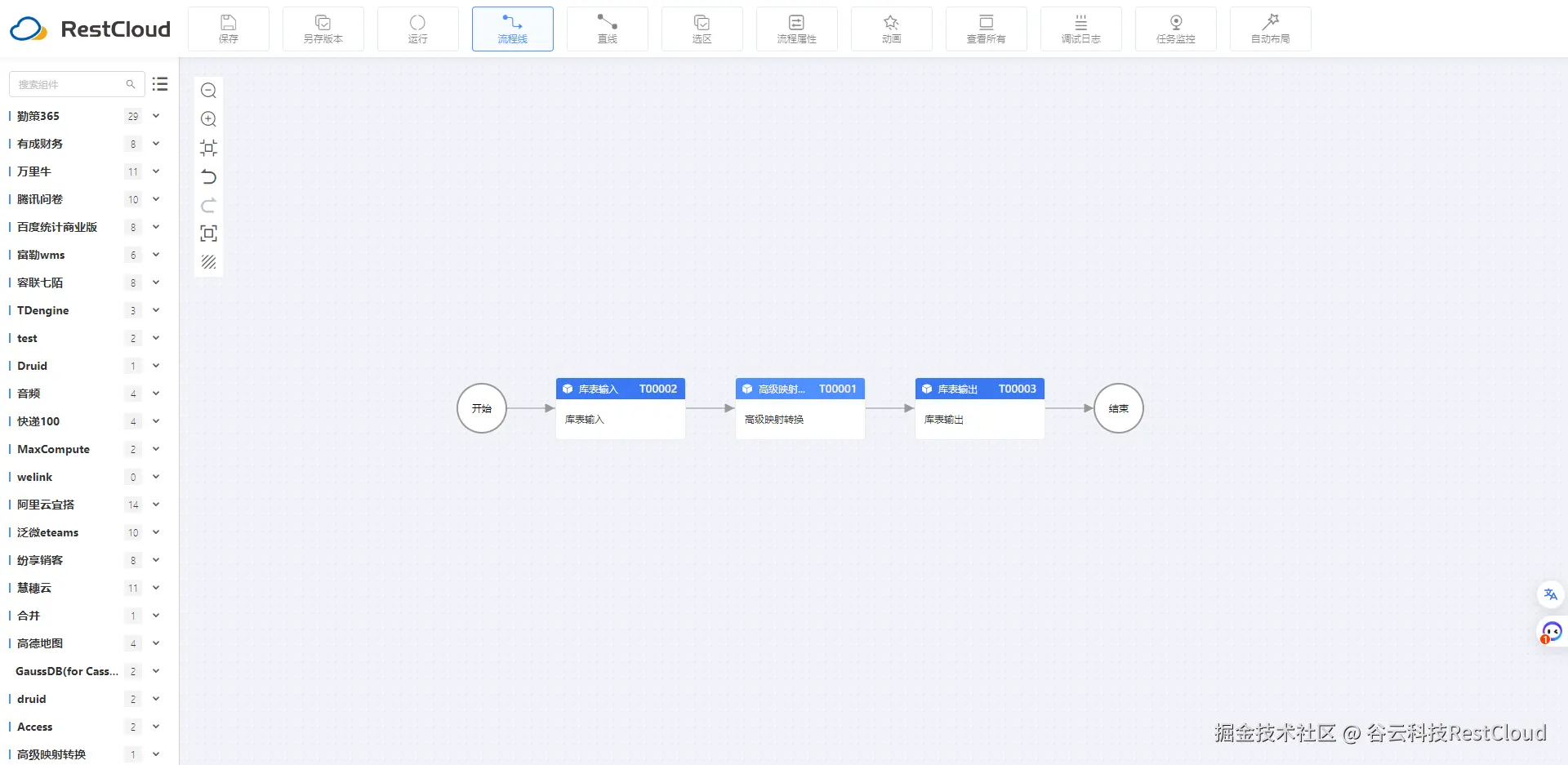

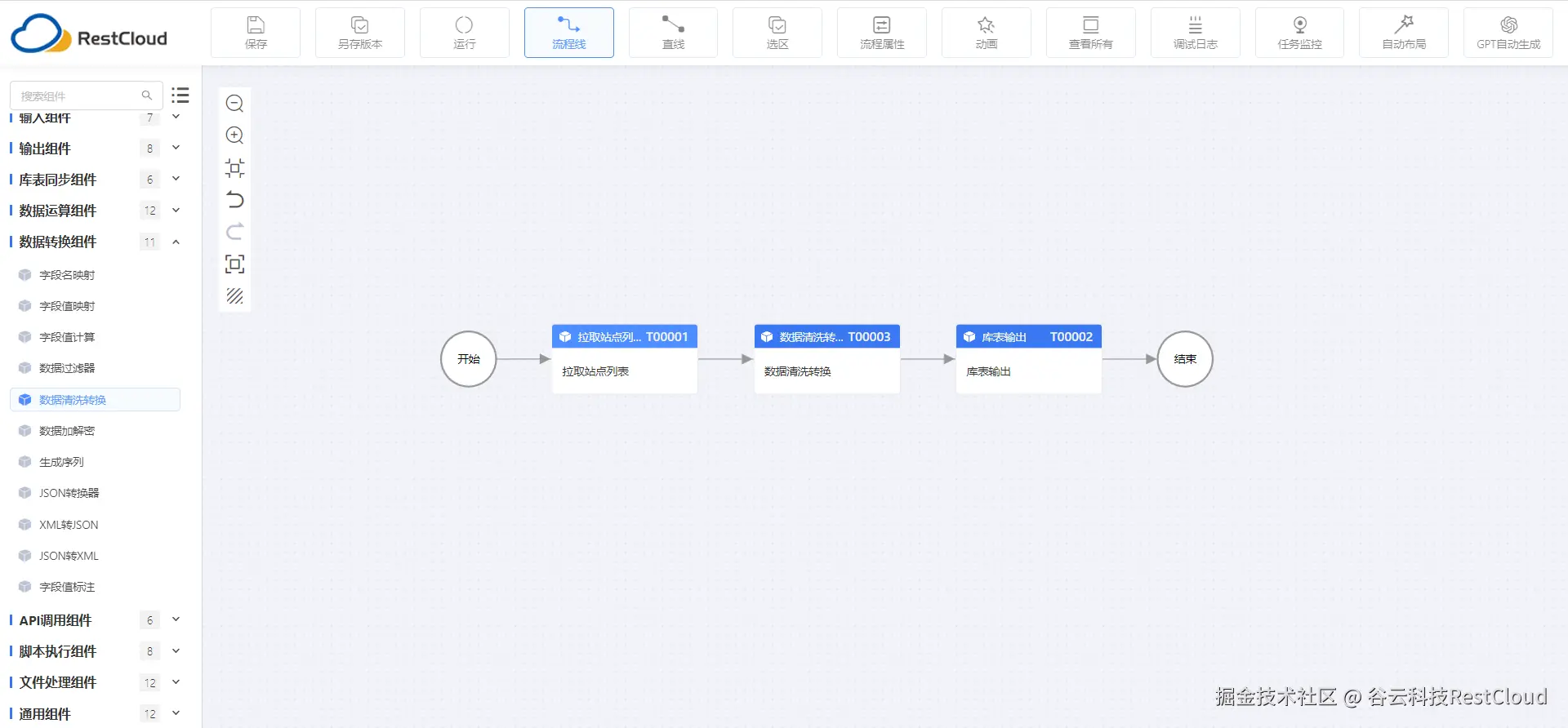

传统ETL工具往往依赖脚本编写实现复杂逻辑,而ETLCloud提供了丰富的可视化组件库,覆盖以下核心能力:

-

基础清洗:字段重命名、类型转换(如字符串转日期)、空值填充(默认值/前向填充)、正则表达式替换;

-

逻辑运算:支持自定义表达式进行数值计算、条件判断(IF-ELSE)、时间偏移(如

order_time + INTERVAL '8 HOUR'); -

多流处理:可将来自Kafka的用户行为流与MySQL的商品维度表进行实时关联,输出带品类标签的行为事件流,适用于推荐系统预处理。

这些组件可通过拖拽方式组合成完整流程,无需编码即可完成复杂的跨系统数据融合。

3.智能化规则驱动

ETLCloud引入了规则模板机制,允许用户将常用清洗逻辑(如手机号脱敏、金额单位统一为元)封装为可复用模块。某电商企业在大促前快速复制了"订单数据清洗模板",应用于天猫、京东、抖音小店三个渠道的数据接入任务,配置效率提升60%以上。

此外,平台支持基于条件触发的动态路由,比如当检测到某字段包含敏感词时,自动跳转至加密节点;或根据数据量大小选择全量同步还是增量拉取策略,体现了初步的"智能决策"能力。

三、数据清洗的智能化策略

1.数据质量评估与监控

单纯执行清洗任务并不足够,企业更需掌握"清洗效果"。ETLCloud内置数据质量看板,可实时统计每批次数据的完整性(非空率)、一致性(参照完整性校验)、唯一性(主键重复检查)等指标。

2.自动化异常修正

基于内置的规则引擎,ETLCloud可配置自动化修复策略:

-

缺失值:按均值、众数或上下文推断补全;

-

重复记录:依据业务主键自动去重;

-

异常数值:设置阈值范围,超出则归零或置为NULL。

同时,任务失败时支持智能重试机制,结合指数退避算法减少雪崩风险。若连续三次失败,则触发邮件/钉钉告警,并暂停下游依赖任务,保障整体链路稳定性。

3.流式清洗与低延迟处理

对于实时性要求高的场景,ETLCloud支持流式ETL架构,可直接消费Kafka主题,结合Flink或平台自带的流处理引擎进行边读边洗。某券商利用该能力构建了"交易流水实时质检系统",在数据写入ClickHouse前完成字段校验、IP归属地补全和反欺诈标记,端到端延迟控制在200ms以内。

四、实践案例与应用场景

场景一:实时营销分析

通过ETL工具打通电商平台订单流(Kafka)与会员画像库(MySQL),经过实时清洗与聚合后写入ClickHouse。BI系统据此生成"小时级销售热力图"和"爆款预警看板",市场团队可在促销开始两小时内调整广告投放策略,ROI提升23%。

场景二:跨系统财务对账

电商平台在双十一期间面临多渠道结算难题。通过ETL工具部署并行数据管道,分别接入淘宝、京东、拼多多的结算文件,执行统一的时间戳对齐、金额格式标准化、发票编号去重等操作,最终生成标准化对账单,结算周期由原来的T+3缩短至T+0.5。

场景三:医疗行业数据治理

某区域健康大数据平台需整合电子病历、检验报告和穿戴设备数据。我们可以通过预设脱敏规则自动屏蔽患者姓名、身份证号,保留可用于统计分析的匿名化数据,并记录每一次数据访问日志,满足《个人信息保护法》合规要求。

五、让 ETL 成为数据价值的放大器

今天的ETL早已不是IT部门后台默默运行的"黑盒子"。它是连接业务与数据资产的关键枢纽,是确保数据可信、可用、可追溯的第一道防线。

借助ETLCloud这类新一代数据集成平台的能力------广泛的连接性、可视化的智能转换、自动化的清洗策略以及完善的管控体系------企业得以将原始数据流转化为高质量的信息资产。未来,随着AI技术的融入,我们有望看到更多"自适应清洗建议""异常模式自动学习"等功能落地,进一步降低数据治理门槛。