目录

- 引言

- [一、在 K8s 环境中,是否引入 Service Mesh](#一、在 K8s 环境中,是否引入 Service Mesh)

- [二、Service Mesh 实现之 Istio 一文入门](#二、Service Mesh 实现之 Istio 一文入门)

-

-

- [🔩 Istio 核心原理](#🔩 Istio 核心原理)

- [📦 入门配置案例:Bookinfo 应用](#📦 入门配置案例:Bookinfo 应用)

- [💎 重要概念与技巧](#💎 重要概念与技巧)

- [💡 进阶探索与注意事项](#💡 进阶探索与注意事项)

-

引言

本文为总结整理笔记,便于后续查阅,部分来自AI。为免拾人牙慧之嫌,小马特此声明。主要在于K8s 中是否必须使用 Service Mesh,以及如果需要实现 Service Mesh,Istio的原理理解和基础案例参考,一文入门上手。

一、在 K8s 环境中,是否引入 Service Mesh

在 Kubernetes(K8s)环境中,是否引入 Service Mesh(如 Istio、Linkerd)会显著影响服务治理的方式、能力与复杂度。以下是两者的核心区别分析,结合架构、功能、运维及适用场景等维度:

⚙️ 架构与治理模型

| 维度 | 不使用 Service Mesh(K8s 原生方案) | 使用 Service Mesh |

|---|---|---|

| 服务发现与负载均衡 | 依赖 K8s Service 和 CoreDNS: - Service 分配 ClusterIP,通过 kube-proxy 维护 iptables/IPVS 规则,实现四层(TCP/UDP)负载均衡。 - 不支持七层协议(如 HTTP/gRPC)的精细控制。 | Sidecar 代理(如 Envoy)接管流量: - 通过 xDS 协议从控制面(如 Istiod)动态获取服务端点(Endpoint)。 - 支持七层协议的高级负载均衡(如 gRPC 长连接、按权重分流)。 |

| 治理能力实现 | 需集成 SDK(如 Spring Cloud): - 熔断、限流等逻辑嵌入业务代码,多语言支持成本高。 | 治理能力下沉至 Sidecar: - 业务代码零侵入,策略通过 CRD(如 VirtualService、DestinationRule)动态配置。 |

| 流量劫持机制 | kube-proxy 在节点层面拦截流量,通过 iptables 转发至 Pod IP。 | Sidecar 通过 init 容器配置 iptables,劫持进出 Pod 的流量至代理端口(如 15001/15006),实现精细控制。 |

Envoy 是 Istio 中最基础的组件,所有其他组件的功能都是通过调用 Envoy 提供的 API,在请求经过 Envoy 转发时,由 Envoy 执行相关的控制逻辑来实现的。

🛠️ 二、功能对比

流量治理能力

-

K8s 原生

- 仅支持基础路由(Ingress)和四层负载均衡,无法实现灰度发布、流量镜像等高级策略。

- 依赖 HPA 实现扩缩容,但缺乏服务级熔断和限流支持。

-

Service Mesh

- 动态路由 :通过

VirtualService实现金丝雀发布、A/B 测试。 - 弹性策略 :通过

DestinationRule配置连接池、熔断、重试。 - 故障注入:模拟服务异常以测试系统韧性。

- 动态路由 :通过

安全与可观测性

| 能力 | K8s 原生 | Service Mesh |

|---|---|---|

| 安全通信 | 需手动配置 NetworkPolicy(网络策略),无自动 mTLS。 | 自动注入 mTLS,通过 PeerAuthentication 强制服务间加密认证。 |

| 可观测性 | 需独立集成 Prometheus、Jaeger 等工具,配置分散。 | 内置三支柱: - Metrics(Prometheus)、 - Tracing(Jaeger)、 - 拓扑可视化(Kiali)。 |

⚖️ 三、运维与性能

| 维度 | K8s 原生 | Service Mesh |

|---|---|---|

| 运维复杂度 | 简单:仅需维护 K8s 核心组件(kube-proxy、CoreDNS)。 | 高:需管理控制面(Istiod)和数据面(Sidecar),版本升级、Sidecar 注入故障排查复杂。 |

| 性能开销 | 低:kube-proxy 基于 iptables,转发效率高,无额外延迟。 | 显著:Sidecar 增加 1-2 跳本地回环(localhost),延迟提升 10-30%,内存占用增长 20-50%。 |

| 扩展性 | 受限:仅支持 K8s 集群内服务治理,跨集群/混合云需自研方案。 | 强大:原生支持多集群流量调度(如 Istio 东西向网关),兼容虚拟机/容器混合环境。 |

🚀 四、适用场景建议

适合使用 Service Mesh 的情况:

- 大规模多语言微服务:需统一治理 Java/Go/Python 等异构服务,避免 SDK 维护成本。

- 高级流量治理需求:如全链路灰度发布、跨集群蓝绿部署。

- 严格安全合规:自动 mTLS 加密、服务间鉴权。

适合 K8s 原生方案的情况:

- 中小规模应用:服务数量少(<20),无复杂路由或安全需求。

- 性能敏感场景:低延迟要求(如高频交易系统),无法接受 Sidecar 开销。

- 技术栈单一:全栈 Java 可考虑 Proxyless 方案(如 Dubbo-go + Nacos),避免 Sidecar 资源消耗。

💎 总结:核心区别与演进关系

- K8s 的本质 :提供应用生命周期管理(部署、扩缩容、自愈),专注资源调度。

- Service Mesh 的本质 :解耦服务间通信治理(流量、安全、观测),专注服务调度。

- 演进关系 : K8s 确保服务"活下来"(资源层),Service Mesh 确保服务"活得好"(应用层)。

若需平衡性能与治理能力,可考虑 Proxyless Mesh(如火山引擎 MSE Agent),通过 Java Agent 实现无侵入治理,避免 Sidecar 开销,适合 Java 主导的场景。

二、Service Mesh 实现之 Istio 一文入门

Istio 作为服务网格技术的代表,能很好地解决微服务架构中的连接、管理和监控难题。下面我们梳理其核心原理,并借助官方示例演示入门配置。

🔩 Istio 核心原理

Istio 的架构清晰地将数据平面 和控制平面分离开来。

- 数据平面 :由以 Sidecar 模式 部署的智能代理(Envoy)构成。这些代理会伴随每个微服务部署,透明地接管服务间的所有入站和出站网络流量,是实现流量管理、安全控制和可观测性的基础。Istio 支持两种数据平面模式:传统的 Sidecar 模式以及更新的 Ambient 模式。

- 控制平面 (新版中主要为 Istiod ):作为大脑,负责管理和配置数据平面中的代理。它主要包括以下功能:

- 服务发现:从底层平台(如 Kubernetes)获取服务信息。

- 配置管理:将用户定义的高级路由规则、安全策略转换为 Envoy 能理解的配置并下发。

- 证书管理:作为内置的证书颁发机构(CA),自动为服务间通信提供双向 TLS(mTLS)加密和身份认证。

通过这种架构,Istio 实现了对微服务的流量管理 (如动态路由、故障恢复)、安全通信 (服务间身份验证和授权)以及可观测性(指标、日志、追踪),而业务代码几乎无需改动。

小马插播一下精华总结:

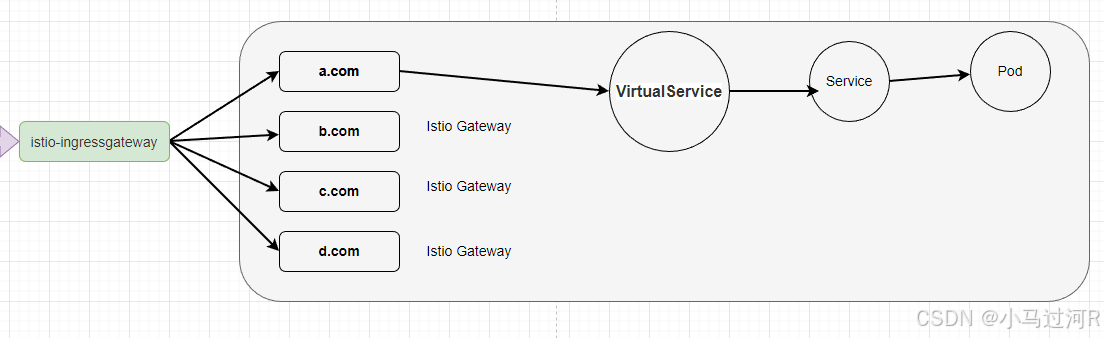

istio-ingressgateway 、 Istio Gateway 、 VirtualService 这一套相当NGINX 的功能。

istio-ingressgateway 监听 Istio Gateway网关名;

VirtualService 网关名+uri 路由找服务;

具体的案例参考这里 istio官网 、案例,非常好理解,强烈推荐。

📦 入门配置案例:Bookinfo 应用

Bookinfo 是 Istio 官方的示例应用,非常适合入门实践。它由四个微服务组成:productpage、details、reviews(三个版本)、ratings。部署后,通过其页面可以直观地看到 Istio 的流量管理效果。

| 微服务 | 功能描述 |

|---|---|

productpage |

前端页面,调用 details 和 reviews 服务 |

details |

提供书籍详情信息 |

reviews |

提供评论信息,有 v1, v2, v3 三个版本 |

ratings |

提供评分信息(reviews v2/v3 版本会调用) |

下面表格汇总了部署和配置 Bookinfo 应用的关键步骤:

| 步骤 | 核心命令/操作 | 简要说明 |

|---|---|---|

| 1. 部署应用 | kubectl apply -f samples/bookinfo/platform/kube/bookinfo.yaml |

在已启用 Istio 的 Kubernetes 集群中部署 Bookinfo 应用。 |

| 2. 创建网关 | kubectl apply -f samples/bookinfo/networking/bookinfo-gateway.yaml |

创建 Gateway 和 VirtualService 资源,允许外部流量访问 productpage 服务。 |

| 3. 访问应用 | 确定入口网关地址后访问 http://$GATEWAY_URL/productpage |

通过浏览器访问应用页面,此时刷新页面会看到 Reviews 部分随机显示不同样式(红/黑星标或无星标),这对应了 reviews 服务的三个版本,说明流量正在随机分配。 |

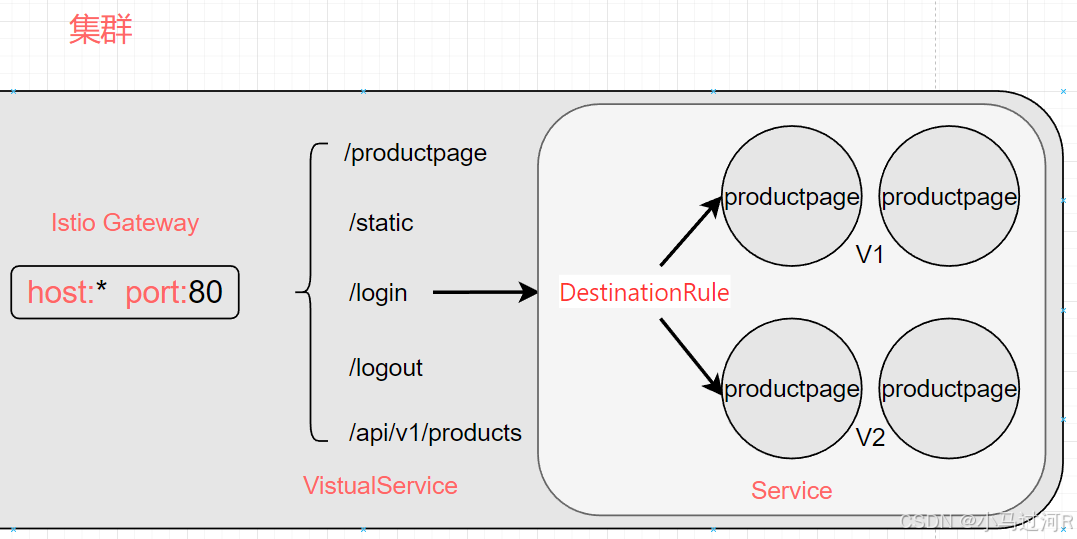

| 4. 目标规则 | kubectl apply -f samples/bookinfo/networking/destination-rule-all.yaml |

定义 DestinationRule ,为 reviews 服务明确划分出 v1, v2, v3 三个子集(subsets),为精细路由做准备。 |

| 5. 虚拟服务 | kubectl apply -f samples/bookinfo/networking/virtual-service-all-v1.yaml |

创建 VirtualService 规则,将所有流量定向到 reviews 服务的 v1 版本。刷新页面后,Reviews 部分将稳定显示为无星标。 |

完成上述步骤后,你就成功实现了将全部流量固定到 reviews 服务某个特定版本的基础路由功能。

💎 重要概念与技巧

- VirtualService (VS) :定义了如何路由流量。它通过匹配规则(如根据来源、URL路径等)将请求路由到特定目标服务的某个子集。

- DestinationRule (DR) :定义了到达目标服务后的策略 。它将一个服务划分为多个子集(例如按版本),并可以配置负载均衡策略、连接池大小等。VS 和 DR 通常需要配合使用。

- 自动 Sidecar 注入 :为了省去手动修改每个应用部署 YAML 的麻烦,可以给 Kubernetes 的命名空间打上标签(如

istio-injection=enabled),这样在该命名空间下新建的 Pod 就会自动注入 Istio 的 Sidecar 代理。 - 使用

istioctl analyze:这是一个有用的命令,可以检查你的 Istio 配置是否存在潜在问题。

💡 进阶探索与注意事项

掌握了基本路由后,你可以进一步尝试 Istio 更强大的功能:

- 灰度发布与金丝雀发布:通过配置 VirtualService,可以按比例(如 90% 流量到 v1,10% 到 v2)将流量逐步切到新版本,实现平滑上线。

- 故障注入:在 VS 中模拟服务故障(如返回特定错误码)或延迟,测试应用的容错能力。

- 流量镜像:将线上流量复制一份到新版本服务,在不影响用户的情况下进行测试。

- 可观测性:集成 Prometheus、Grafana、Kiali 和 Jaeger 等工具,可以直观地查看服务拓扑、监控指标和追踪请求链路。

需要注意,Istio 的功能虽然强大,但也会增加系统复杂性。建议从一个小型项目或特定功能(如遥测)开始,逐步应用。

希望这些原理和案例能帮助你迈出 Istio 实践的第一步。如果你对特定功能(比如如何具体配置一个金丝雀发布,或者如何查询监控指标)有更深入的兴趣,我们可以继续探讨。

- 彩蛋时间~~

乱入一下,上一个AI的价值:要闻。