最近,整个AI圈都对一则重磅消息引起了广泛关注:英伟达,这位在AI算力领域叱咤风云的巨头,正式开源了其生成式AI面部动画模型 Audio2Face(A2F) 。这无疑是给虚拟角色创作领域送上的一份厚礼,它意味着给数字生命注入灵魂,将变得前所未有的简单和高效。

核心魔法:听声辨情,以声塑形

想象一下,你只需对着麦克风说几句话,屏幕上的虚拟角色就能立即同步地动嘴、眨眼、皱眉,甚至精确表达出喜怒哀乐。这听起来像魔法,而Audio2Face正是实现这魔法的幕后推手。

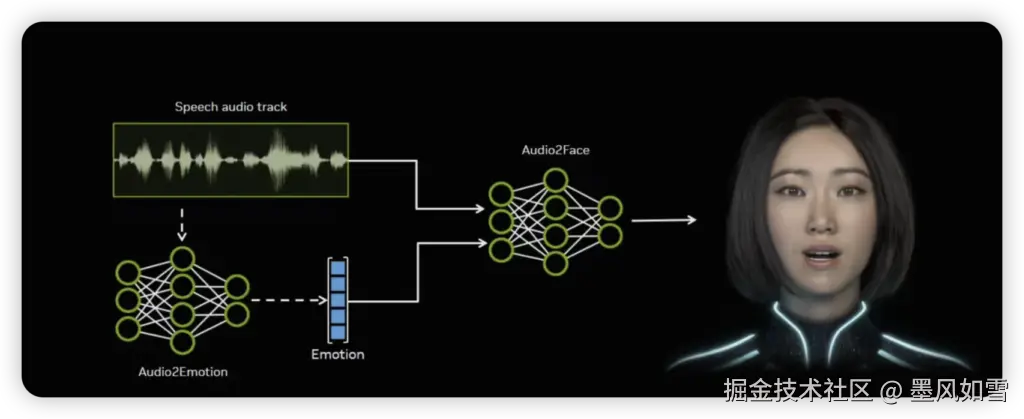

它的核心能力在于深度分析音频中的音素、语调乃至情感内容等声学特征,并将其转化为虚拟角色精确的面部肌肉运动参数,实现毫秒级的唇形同步和自然的情感表达。无论是追求影视级精度的离线渲染模式,还是游戏、虚拟客服等需要动态交互的实时流式处理模式,A2F都能游刃有余地应对,确保低延迟响应。

慷慨馈赠:一份开发者的"全家桶"

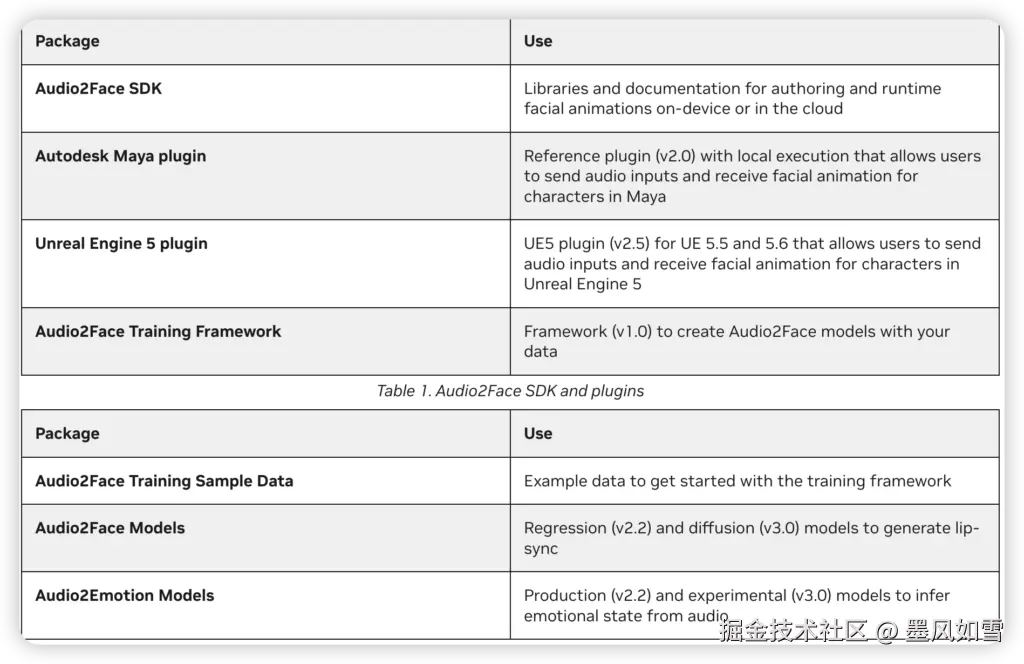

英伟达此举,远不止开源一个模型那么简单。它提供的是一整套"全家桶"式的开发资源,旨在显著降低在虚拟角色创建中应用高质量面部动画的技术门槛和成本:

- Audio2Face SDK:核心库与文档,支持在设备或云端进行面部动画的创作和运行时处理。

- 主流3D软件插件:包括Autodesk Maya插件(v2.0)和Unreal Engine 5插件(v2.5),让开发者能在熟悉的创作环境中直接调用A2F功能。

- 完整的训练框架(v1.0) :开发者可以利用它使用自有数据对预训练模型进行微调,以适应特定需求,实现定制化的角色表现。

- 丰富的示例资源:包含用于口型同步的回归模型(v2.2)和扩散模型(v3.0),以及用于从音频推断情绪的Audio2Emotion模型,甚至还有训练框架的示例数据集,助你快速上手。

这意味着,开发者可以轻松地将A2F集成到自己的工作流,甚至用少量样本数据就能训练出更符合特定语言或文化表情的模型。更令人兴奋的是,它支持多语言,即便你对着角色"胡言乱语",它也能尝试生成动画,大大拓宽了应用边界。

落地实践:从像素到生动的存在

这项技术的影响力已在多个领域显现,并被广泛采纳。在游戏界,Survios工作室在《异形:侠盗入侵进化版》中,用A2F将口型同步的制作周期从数天缩短至短短数小时,效率提升了不止一星半点。而The Farm 51工作室在《切尔诺贝利人2:禁区》里,也借此直接从音频生成了细腻的面部动画,让剧情角色的真实感大幅飙升,获得了玩家的高度认可。

不只是游戏,影视动画制作、数字人客服、虚拟主播、在线教育等场景,都将因A2F的开源而迎来一次效率与真实感的飞跃。它让高质量的面部动画不再是少数大厂的专属,而是触手可及的创作工具,为AI驱动的内容创作开辟了新的可能性。

审慎前行:机遇与挑战并存

当然,强大的技术总伴随着挑战。A2F对硬件有着较高要求,尤其在实时运行模式下,NVIDIA RTX 40系列及以上的显卡是其流畅发挥的关键。同时,对于超长音频的连贯性处理,未来仍有优化的空间。

更重要的是,任何生成式AI技术都可能被滥用。在享受开源带来的创作自由和效率提升的同时,开发者也需警惕深度伪造(deepfake)等伦理风险,并审慎负责地使用这项技术。英伟达采用宽松的MIT许可证,旨在吸引更广泛的开发者、学生和研究社区参与,共同推动技术进步,同时也强调了负责任AI的重要性。

展望未来:数字角色,因AI而生动

英伟达Audio2Face的开源,是其推动AI技术普及化的又一里程碑。它不仅为虚拟世界注入了更生动的表情和更丰富的生命力,更激发了全球开发者社区的无限潜能。一个由AI驱动、表情丰富、生动自然的数字内容创作新时代,正加速向我们走来。

如果你也对最新的AI信息感兴趣或者有疑问 都可以加入我的大家庭 第一时间分享最新AI资讯、工具、教程、文档 欢迎你的加入!!!😉😉😉

公众号:墨风如雪小站