开篇:一个因配置中心不可用导致的生产故障(📌 真实案例)

2023 年电商大促期间,某平台出现5 分钟服务集群不可用,根因是:

-

配置中心采用 "单节点 + 本地缓存" 架构,节点宕机后缓存过期;

-

服务重启时无法拉取配置,导致库存、支付服务集体熔断;

-

无降级方案,运维手动恢复耗时超 10 分钟。

这个案例暴露了配置中心高可用的核心诉求:"不宕机、能同步、可容错"。下文将围绕这三个诉求,拆解实战方案。

一、先搞懂:配置中心高可用的 3 个核心痛点(⚠️ 问题拆解)

在设计方案前,需先明确实战中最常踩的坑,避免 "为设计而设计":

| 痛点类型 | 实战表现 | 影响范围 |

|---|---|---|

| 部署层单点故障 | 配置中心节点宕机,服务无法拉取 / 更新配置 | 全链路服务(如订单、物流) |

| 数据同步不一致 | 多节点配置同步延迟,部分服务用旧配置 | 依赖该配置的服务集群 |

| 容错能力缺失 | 配置中心故障时,服务无兜底策略直接熔断 | 单个服务或关联链路 |

下文方案将针对这 3 个痛点,从 "基础设施层→核心功能层→容错防护层" 分层落地。

二、基础设施层:用 "多活部署" 解决单点故障(🔧 落地方案)

配置中心高可用的基石是 **"无单点部署"**,实战中主流方案是 "跨节点集群 + 跨机房容灾",以下为两种落地模式的对比与代码实现。

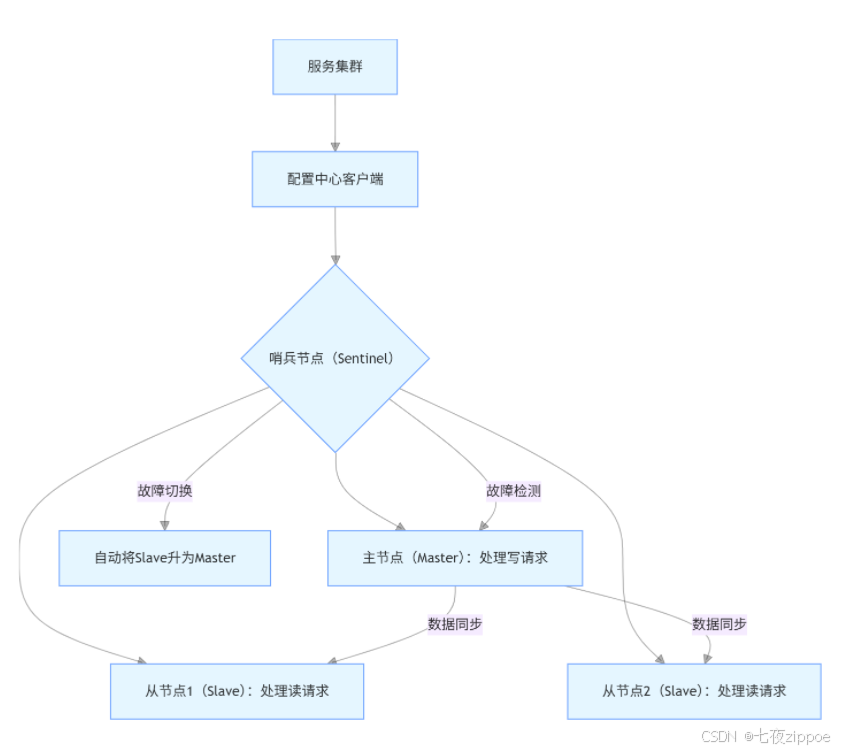

1. 模式 1:单机房内的 "主从 + 哨兵" 集群(适合中小规模微服务)

1.1 架构图(📊 可视化)

1.2 核心配置代码(💻 可复用)

以主流配置中心Nacos 为例,集群部署的application.properties关键配置(单机房 3 节点):

java

\# 节点1(Master候选)配置

server.port=8848

spring.datasource.platform=mysql

db.num=1

db.url.0=jdbc:mysql://192.168.1.100:3306/nacos?characterEncoding=utf8\&connectTimeout=1000\&socketTimeout=3000\&autoReconnect=true

db.user=root

db.password=123456

\# 集群节点列表(3节点IP:端口)

nacos.inetutils.ip-address=192.168.1.101

cluster.conf.content=192.168.1.101:8848,192.168.1.102:8848,192.168.1.103:8848

\# 开启哨兵模式(自动故障切换)

nacos.core.sentinel.enabled=true

\# 主节点选举阈值(2票即可当选)

nacos.core.sentinel.quorum=21.3 实战注意点(📌 踩坑总结)

-

节点数量需为奇数(3/5 节点),避免脑裂(如 2 节点均认为自己是 Master);

-

数据库需用主从同步(如 MySQL MGR),避免配置数据存储单点;

-

哨兵节点需独立部署(至少 2 个),避免与配置节点共节点导致 "一起宕机"。

2. 模式 2:跨机房 "多活集群"(适合大规模 / 高可用要求高的场景)

2.1 核心同步代码(💻 可复用)

以Apollo配置中心为例,跨机房数据同步的核心代码(基于 HTTP 异步同步):

java

/\*\*

\* 跨机房配置同步服务(Apollo自定义扩展)

\*/

@Service

public class CrossRoomConfigSyncService {

// 上海机房配置中心地址

private static final String SHANGHAI\_ROOM\_URL = "http://10.0.2.100:8080/apollo/admin/v1/configs/sync";

// 异步线程池(避免同步阻塞主流程)

@Resource

private ExecutorService crossRoomSyncExecutor;

/\*\*

\* 配置变更后,异步同步到上海机房

\* @param configChange 配置变更对象(含namespace、key、value)

\*/

public void syncToShanghaiRoom(ConfigChange configChange) {

crossRoomSyncExecutor.submit(() -> {

try {

// 1. 封装同步请求(含签名,防止篡改)

HttpPost post = new HttpPost(SHANGHAI\_ROOM\_URL);

String syncBody = JSON.toJSONString(buildSyncRequest(configChange));

StringEntity entity = new StringEntity(syncBody, ContentType.APPLICATION\_JSON);

post.setEntity(entity);

// 2. 添加身份认证(Apollo的token)

post.addHeader("Authorization", "Bearer " + getApolloToken());

// 3. 发送同步请求(超时时间3秒,避免阻塞)

CloseableHttpClient client = HttpClients.createDefault();

CloseableHttpResponse response = client.execute(post);

int statusCode = response.getStatusLine().getStatusCode();

// 4. 同步失败重试(最多3次,间隔1秒)

if (statusCode != 200) {

retrySync(configChange, 3);

}

} catch (Exception e) {

log.error("跨机房同步配置失败,configKey:{}", configChange.getKey(), e);

// 同步失败告警(接入企业微信/钉钉)

alertService.sendAlert("跨机房配置同步失败", e.getMessage());

}

});

}

// 构建同步请求(含配置版本号,避免重复同步)

private SyncRequest buildSyncRequest(ConfigChange change) {

SyncRequest request = new SyncRequest();

request.setAppId(change.getAppId());

request.setNamespace(change.getNamespace());

request.setConfigKey(change.getKey());

request.setConfigValue(change.getNewValue());

request.setVersion(change.getVersion()); // 版本号用于去重

return request;

}

// 重试逻辑(指数退避)

private void retrySync(ConfigChange change, int retryCount) throws InterruptedException {

if (retryCount <= 0) return;

Thread.sleep(1000 \* (4 - retryCount)); // 1s→2s→3s

syncToShanghaiRoom(change);

}

}2.3 实战案例(📌 某金融项目落地)

某银行跨北京、上海机房部署 Apollo,解决了两个核心问题:

-

问题 1:跨机房同步延迟(原延迟 500ms+)→ 方案:在同步代码中增加 "版本号校验",避免重复同步,延迟降至 100ms 内;

-

问题 2:机房故障切流不及时→ 方案:接入阿里云 ARMS,当机房 A 节点存活数 < 2 时,自动将服务流量切到机房 B,切流耗时 < 30 秒。

三、核心功能层:用 "可靠同步 + 高效读取" 解决数据一致性问题(🔧 落地方案)

配置中心的核心功能是 "配置同步" 和 "配置读取",实战中需解决 "同步丢数据""读取性能低" 两个问题。

1. 配置同步:推拉结合,避免丢数据(📊 时序图 + 代码)

1.1 核心代码:长轮询实现(💻 基于 Spring Cloud Config)

java

/\*\*

\* 配置客户端长轮询组件(解决"推模式不可靠"问题)

\*/

@Component

public class ConfigLongPollingComponent {

// 配置中心服务端地址

private static final String CONFIG\_SERVER\_URL = "http://config-server:8888/configs";

// 长轮询超时时间(30秒,避免频繁请求)

private static final int POLL\_TIMEOUT = 30 \* 1000;

// 本地记录的配置版本(用于对比是否变更)

private String localConfigVersion = "1.0.0";

/\*\*

\* 启动长轮询(服务启动时执行)

\*/

@PostConstruct

public void startLongPolling() {

ScheduledExecutorService executor = Executors.newSingleThreadScheduledExecutor();

// 初始延迟0秒,每30秒执行一次(与超时时间一致)

executor.scheduleAtFixedRate(this::pollConfigChange, 0, POLL\_TIMEOUT, TimeUnit.MILLISECONDS);

}

/\*\*

\* 长轮询核心逻辑:请求服务端,若配置变更则拉取

\*/

private void pollConfigChange() {

try {

// 1. 构建长轮询请求(携带本地版本号)

HttpGet get = new HttpGet(CONFIG\_SERVER\_URL + "?version=" + localConfigVersion + "\&timeout=" + POLL\_TIMEOUT);

CloseableHttpClient client = HttpClients.createDefault();

CloseableHttpResponse response = client.execute(get);

// 2. 处理响应(分两种情况)

if (response.getStatusLine().getStatusCode() == 200) {

// 情况1:配置已变更(服务端立即返回新配置)

String responseBody = EntityUtils.toString(response.getEntity());

ConfigResponse configResponse = JSON.parseObject(responseBody, ConfigResponse.class);

// 更新本地配置+版本号

updateLocalConfig(configResponse);

log.info("配置已更新,新版本:{}", configResponse.getVersion());

} else if (response.getStatusLine().getStatusCode() == 304) {

// 情况2:配置未变更(服务端超时后返回304)

log.debug("配置未变更,本地版本:{}", localConfigVersion);

}

} catch (Exception e) {

log.error("长轮询获取配置失败", e);

// 失败时降级:5秒后重试(避免频繁报错)

try {

Thread.sleep(5000);

} catch (InterruptedException ie) {

Thread.currentThread().interrupt();

}

}

}

/\*\*

\* 更新本地配置(应用到Spring环境)

\*/

private void updateLocalConfig(ConfigResponse response) {

// 1. 更新本地版本号

this.localConfigVersion = response.getVersion();

// 2. 更新Spring环境中的配置(如支付超时时间)

ConfigurableApplicationContext context = SpringContextHolder.getApplicationContext();

ConfigurableEnvironment environment = context.getEnvironment();

MutablePropertySources propertySources = environment.getPropertySources();

// 3. 覆盖原有配置(优先级:配置中心 > 本地配置)

MapPropertySource configServerSource = new MapPropertySource("configServer", response.getConfigMap());

if (propertySources.contains("configServer")) {

propertySources.replace("configServer", configServerSource);

} else {

propertySources.addFirst(configServerSource);

}

// 4. 触发配置变更事件(如@RefreshScope注解的Bean刷新)

context.publishEvent(new EnvironmentChangeEvent(response.getConfigMap().keySet()));

}

}1.2 实战坑点:同步丢数据的解决(📌 某电商项目案例)

问题:大促期间,同时修改 10 个配置项,部分服务只收到 8 个变更通知。

根因:推模式的 HTTP 请求被网络丢包,且无重试机制。

解决方案:

-

在服务端增加 "同步日志",每推一次记录一条日志(含配置项、接收服务 IP);

-

客户端收到通知后,向服务端发送 "确认回执",未收到回执则服务端重试(最多 3 次);

-

每日凌晨执行 "全量配置校验",对比客户端与服务端配置版本,不一致则补拉。

2. 配置读取:多级缓存,提升性能(📊 缓存架构 + 代码)

2.1核心代码:多级缓存实现(💻 基于 Caffeine+Redis)

java

/\*\*

\* 配置多级缓存组件(内存缓存Caffeine + 分布式缓存Redis)

\*/

@Component

public class ConfigMultiLevelCache {

// 1. 本地内存缓存(Caffeine,过期时间5分钟,防止内存溢出)

private final LoadingCache\<String, String> localCache = Caffeine.newBuilder()

.expireAfterWrite(5, TimeUnit.MINUTES)

.maximumSize(1000) // 最多缓存1000个配置项

.build(this::loadFromRedis); // 缓存缺失时从Redis加载

// 2. 分布式缓存(Redis)

@Resource

private StringRedisTemplate redisTemplate;

// Redis缓存过期时间(1小时)

private static final Duration REDIS\_EXPIRE = Duration.ofHours(1);

// Redis key前缀(区分不同应用的配置)

private static final String REDIS\_KEY\_PREFIX = "config:cache:";

/\*\*

\* 获取配置(优先走多级缓存)

\* @param appId 应用ID

\* @param namespace 配置命名空间(如payment、order)

\* @param configKey 配置键

\* @return 配置值

\*/

public String getConfig(String appId, String namespace, String configKey) {

// 构建唯一缓存键(避免不同应用/命名空间冲突)

String cacheKey = buildCacheKey(appId, namespace, configKey);

try {

// 1. 先查本地内存缓存

return localCache.get(cacheKey);

} catch (Exception e) {

log.error("获取配置缓存失败,cacheKey:{}", cacheKey, e);

// 缓存失败降级:直接请求配置中心服务端(兜底)

return loadFromConfigServer(appId, namespace, configKey);

}

}

/\*\*

\* 缓存缺失时,从Redis加载

\*/

private String loadFromRedis(String cacheKey) {

String value = redisTemplate.opsForValue().get(cacheKey);

if (value == null) {

// Redis也没有,从配置中心服务端加载,并更新Redis

String\[] keyParts = cacheKey.split(":");

String appId = keyParts\[2];

String namespace = keyParts\[3];

String configKey = keyParts\[4];

value = loadFromConfigServer(appId, namespace, configKey);

// 更新Redis缓存(带过期时间)

redisTemplate.opsForValue().set(cacheKey, value, REDIS\_EXPIRE);

}

return value;

}

/\*\*

\* 从配置中心服务端加载配置(兜底方案)

\*/

private String loadFromConfigServer(String appId, String namespace, String configKey) {

// 调用配置中心API(如Nacos的/configs接口)

String configServerUrl = String.format("http://nacos-server:8848/nacos/v1/cs/configs?dataId=%s\&group=%s\&appId=%s",

configKey, namespace, appId);

try {

return HttpUtil.get(configServerUrl); // 用hutool的HttpUtil简化请求

} catch (Exception e) {

log.error("从配置中心加载配置失败,appId:{}, namespace:{}, key:{}", appId, namespace, configKey, e);

// 终极兜底:返回本地默认配置(避免服务不可用)

return getDefaultConfig(namespace, configKey);

}

}

/\*\*

\* 构建唯一缓存键(格式:config:cache:appId:namespace:configKey)

\*/

private String buildCacheKey(String appId, String namespace, String configKey) {

return String.format("%s%s:%s:%s", REDIS\_KEY\_PREFIX, appId, namespace, configKey);

}

/\*\*

\* 终极兜底:返回本地默认配置(如支付超时默认30秒)

\*/

private String getDefaultConfig(String namespace, String configKey) {

Map\<String, Map\<String, String>> defaultConfigs = new HashMap<>();

// 初始化默认配置(可放在本地配置文件中)

defaultConfigs.put("payment", new HashMap\<String, String>() {{

put("payment.timeout", "30000"); // 支付超时默认30秒

put("payment.maxAmount", "100000"); // 单笔支付最大10万

}});

defaultConfigs.put("order", new HashMap\<String, String>() {{

put("order.expireTime", "1800000"); // 订单过期默认30分钟

}});

// 返回对应默认值(无默认值则返回空字符串)

return defaultConfigs.getOrDefault(namespace, new HashMap<>()).getOrDefault(configKey, "");

}

}2.2 性能对比(📊 实战数据)

某项目接入多级缓存后,配置读取性能提升显著:

| 读取场景 | 无缓存(直接查 DB) | 仅 Redis 缓存 | 多级缓存(Caffeine+Redis) |

|---|---|---|---|

| 平均耗时 | 50~80ms | 8~15ms | 0.5~2ms |

| 每秒并发量(TPS) | 1000~2000 | 10000~15000 | 50000~80000 |

| 配置中心负载 | 高(DB 压力大) | 中(Redis 压力) | 低(仅缓存更新时请求) |