| 大家好,我是工藤学编程 🦉 | 一个正在努力学习的小博主,期待你的关注 |

|---|---|

| 实战代码系列最新文章😉 | C++实现图书管理系统(Qt C++ GUI界面版) |

| SpringBoot实战系列🐷 | 【SpringBoot实战系列】SpringBoot3.X 整合 MinIO 存储原生方案 |

| 分库分表 | 分库分表之实战-sharding-JDBC分库分表执行流程原理剖析 |

| 消息队列 | 深入浅出 RabbitMQ-RabbitMQ消息确认机制(ACK) |

| AI大模型 | 零基础学AI大模型之大模型私有化部署全指南 |

前情摘要:

1、零基础学AI大模型之读懂AI大模型

2、零基础学AI大模型之从0到1调用大模型API

3、零基础学AI大模型之SpringAI

4、零基础学AI大模型之AI大模型常见概念

5、零基础学AI大模型之大模型私有化部署全指南

本文章目录

- 零基础学AI大模型之AI大模型可视化界面

-

- 一、为什么需要LLM可视化界面?命令行与可视化的核心差异

- 二、主流LLM可视化客户端工具解析

-

- [2.1 Dify:开源LLM应用开发平台,从"模型部署"到"业务应用"的桥梁](#2.1 Dify:开源LLM应用开发平台,从“模型部署”到“业务应用”的桥梁)

- [2.2 Cherry Studio:多服务商集成的AI对话客户端](#2.2 Cherry Studio:多服务商集成的AI对话客户端)

- [2.3 Chatbox:多平台兼容的LLM桌面客户端,私有化模型的"可视化交互首选"](#2.3 Chatbox:多平台兼容的LLM桌面客户端,私有化模型的“可视化交互首选”)

- 三、Chatbox+Ollama可视化部署实战:DeepSeek模型的"可视化交互"全流程

-

- [3.1 步骤1:安装Chatbox客户端(可选,支持网页版)](#3.1 步骤1:安装Chatbox客户端(可选,支持网页版))

- [3.2 步骤2:配置Ollama允许远程访问(确保Chatbox可连接)](#3.2 步骤2:配置Ollama允许远程访问(确保Chatbox可连接))

- [3.3 步骤3:在Chatbox中配置Ollama的DeepSeek模型](#3.3 步骤3:在Chatbox中配置Ollama的DeepSeek模型)

- [3.4 步骤4:可视化交互测试与进阶操作](#3.4 步骤4:可视化交互测试与进阶操作)

- 四、工具选型与场景匹配:不同需求下的可视化工具选择

零基础学AI大模型之AI大模型可视化界面

在《零基础学AI大模型之大模型私有化部署全指南》中,我们聚焦于命令行层面 的大模型私有化落地,让技术同学掌握了从硬件选型到Ollama实操的核心能力。但在实际开发与调试中,纯命令行操作对非资深工程师并不友好------可视化界面工具的价值就此凸显:它能将复杂的模型交互、参数配置、多模型管理等操作"图形化",大幅降低使用门槛,同时提升调试效率。

本文将承接私有化部署的技术脉络,系统解析Dify、Cherry Studio、Chatbox三款主流LLM可视化客户端工具,详解其核心能力、部署步骤与实操场景,并以Chatbox对接本地Ollama部署的DeepSeek模型为例,完成"可视化界面+私有化模型"的端到端实战,为个人开发者与企业团队提供从"命令行部署"到"可视化应用"的完整进阶路径。

一、为什么需要LLM可视化界面?命令行与可视化的核心差异

在大模型技术栈中,命令行工具 (如Ollama、llama.cpp)胜在"轻量、灵活、底层可控",但存在交互不直观、多模型管理繁琐、参数调试成本高 等问题;而可视化界面工具通过图形化交互、模块化配置、场景化模板,实现了"降低使用门槛、提升调试效率、支撑业务落地"的核心价值。

| 维度 | 命令行工具(如Ollama) | 可视化界面工具(如Chatbox) |

|---|---|---|

| 操作门槛 | 需熟悉终端命令、参数格式 | 图形化点击操作,小白友好 |

| 多模型管理 | 依赖命令行列表、手动切换 | 界面化模型列表、一键切换 |

| 参数调试 | 需手动修改命令参数、重启服务 | 界面滑块/下拉框调整,实时生效 |

| 业务适配 | 需自行开发前端或对接LangChain等框架 | 内置对话模板、工作流(如Dify),直接支撑业务 |

二、主流LLM可视化客户端工具解析

2.1 Dify:开源LLM应用开发平台,从"模型部署"到"业务应用"的桥梁

Dify是一款开源的生成式AI应用开发平台 ,核心定位是"让开发者无需关注底层模型细节,快速构建AI原生应用"。它不仅支持模型可视化交互,更提供工作流编排、数据集管理、API封装等能力,是企业级AI应用落地的核心工具之一。

-

核心功能:

- 模型管理:对接本地Ollama、云端OpenAI/Anthropic等多源模型,统一管理与调用;

- 工作流设计:通过拖拽式节点(如"文本生成""条件判断""工具调用")编排业务逻辑;

- 应用发布:将AI能力封装为API、网页应用或微信小程序,直接对外提供服务;

- 数据闭环:支持数据集标注、模型微调(需结合训练框架),实现"数据-模型-应用"的迭代闭环。

-

部署步骤(Docker Compose):

-

下载Docker Compose配置文件:

bashgit clone https://github.com/langgenius/dify.git cd dify -

启动服务(自动拉取依赖镜像):

bashdocker compose up -d -

访问可视化界面:浏览器打开

http://localhost:3000,注册账号后即可开始配置模型与应用。

-

-

对接本地Ollama的DeepSeek模型 :

在Dify的"模型管理"模块中,选择"自定义模型",填写Ollama的API地址(如

http://<你的服务器IP>:11434/v1),并配置模型名称(如deepseek:7b-instruct),即可将本地私有化的DeepSeek接入Dify,用于工作流编排或直接对话。

2.2 Cherry Studio:多服务商集成的AI对话客户端

Cherry Studio是一款支持多AI服务商集成的可视化对话工具,既可以对接OpenAI、Claude等云端模型,也能连接本地Ollama、LM Studio等私有化部署的大模型,适合需要"多模型对比、多场景测试"的开发者。

-

核心优势:

- 多模型聚合:在同一界面中切换DeepSeek、Llama 3、GPT-4等不同模型,快速对比推理效果;

- 对话增强:支持对话历史管理、prompt模板保存、多轮对话上下文延续;

- 跨平台支持:提供Windows/Mac客户端,也可通过网页版访问,适配不同使用场景。

-

部署与配置:

- 官网下载安装包(https://cherry-ai.com/),根据系统选择对应版本;

- 打开Cherry Studio,在"设置-模型服务"中添加本地Ollama的API地址(

http://localhost:11434/v1); - 选择模型(如

deepseek:7b-instruct),即可开始可视化对话。

2.3 Chatbox:多平台兼容的LLM桌面客户端,私有化模型的"可视化交互首选"

Chatbox是一款轻量级、跨平台 的LLM桌面客户端,支持Windows、Mac、Linux系统,同时提供网页版访问。它的核心优势是对私有化模型(如Ollama部署的DeepSeek)的无缝支持,且操作逻辑与ChatGPT高度相似,学习成本极低。

- 核心功能 :

- 多模型支持:兼容Ollama、OpenAI、Azure OpenAI等多源模型,本地模型优先;

- 界面友好:对话历史分组、模型参数可视化调整(温度、上下文长度等)、Markdown格式渲染;

- 隐私保护:纯本地交互(对接私有化模型时),数据不上传第三方服务器;

- 扩展能力:支持自定义API接口、导入/导出对话记录、快捷prompt模板。

三、Chatbox+Ollama可视化部署实战:DeepSeek模型的"可视化交互"全流程

接下来,我们以Chatbox对接本地Ollama部署的DeepSeek-7B模型为例,完成从"工具安装"到"可视化交互"的完整实战。

3.1 步骤1:安装Chatbox客户端(可选,支持网页版)

-

访问Chatbox官网(https://chatboxai.app/zh),根据系统选择安装包:

- Windows:下载

.exe文件,双击安装; - Mac:下载

.dmg文件,拖入"应用程序"文件夹; - Linux:下载

.AppImage文件,赋予执行权限后启动(chmod +x Chatbox-xxx.AppImage && ./Chatbox-xxx.AppImage)。

- Windows:下载

-

启动Chatbox,界面与ChatGPT类似,默认会提示配置模型服务。

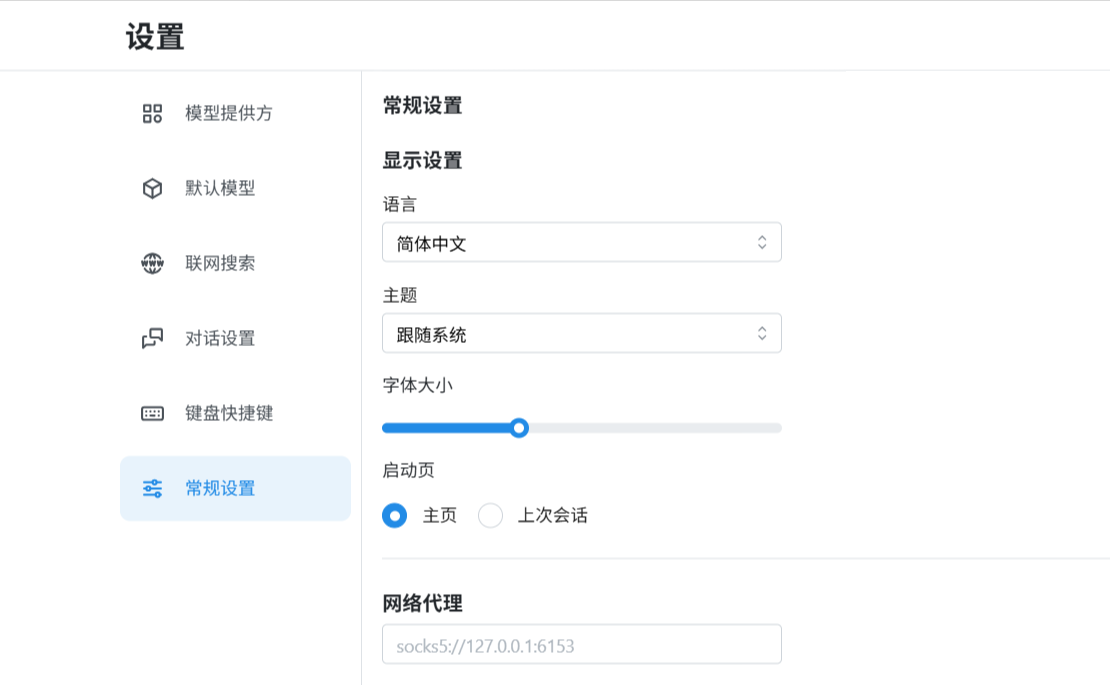

可以在设置中,修改语言,默认为英语

3.2 步骤2:配置Ollama允许远程访问(确保Chatbox可连接)

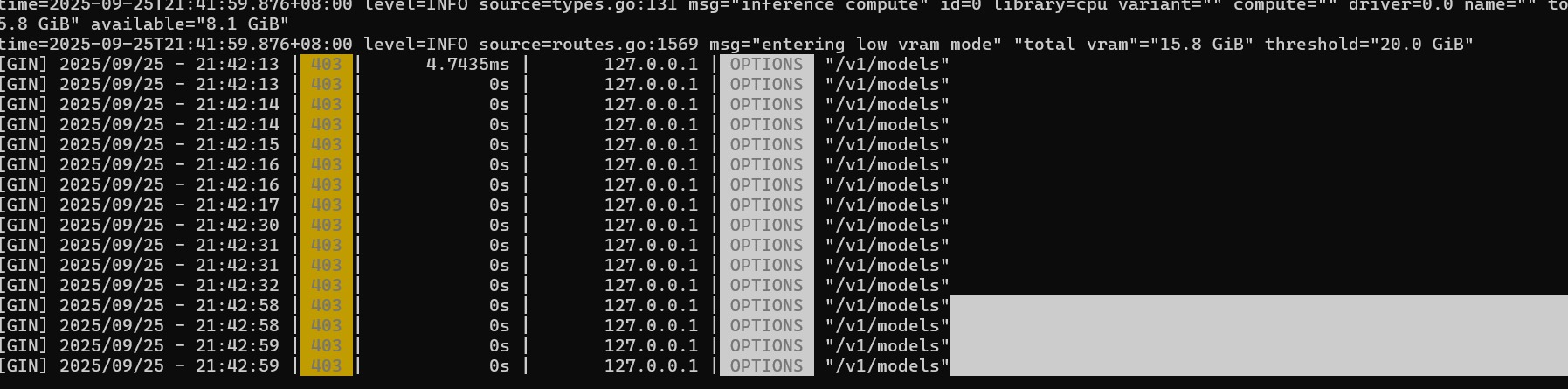

为了让网页版的Chatbox可以访问我们本地部署好的DeepSeek,我们需先配置Ollama的网络绑定与跨域权限,否则无法获取到我们本地的大模型,问题如下图

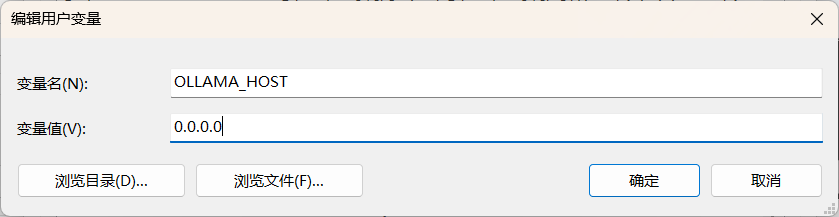

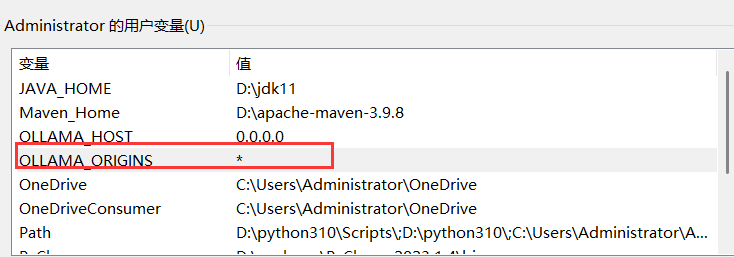

首先我们需要在系统的环境变量中添加两个环境变量

添加完成后点击确定关闭所有环境变量窗口

- 验证Ollama服务状态:

打开终端,执行ollama serve(若已配置永久环境变量,服务会自动监听0.0.0.0:11434)。

再执行netstat -tuln | grep 11434(Linux/Mac)或Get-NetTCPConnection -LocalPort 11434(Windows PowerShell),确认输出包含0.0.0.0:11434,说明服务已支持远程连接。

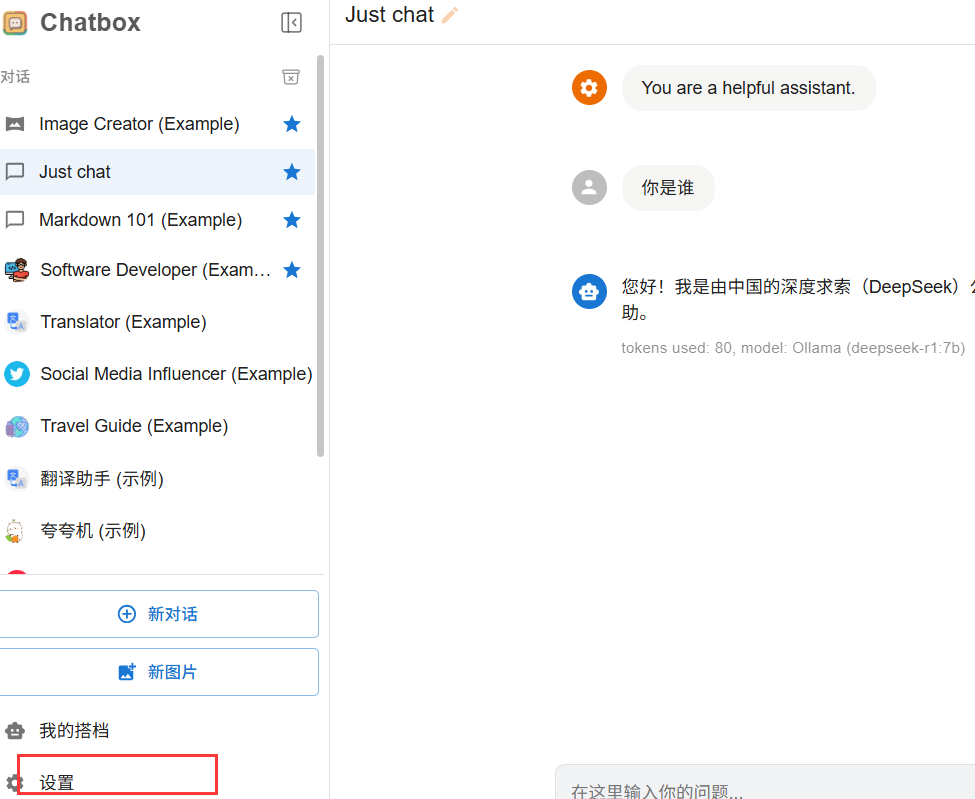

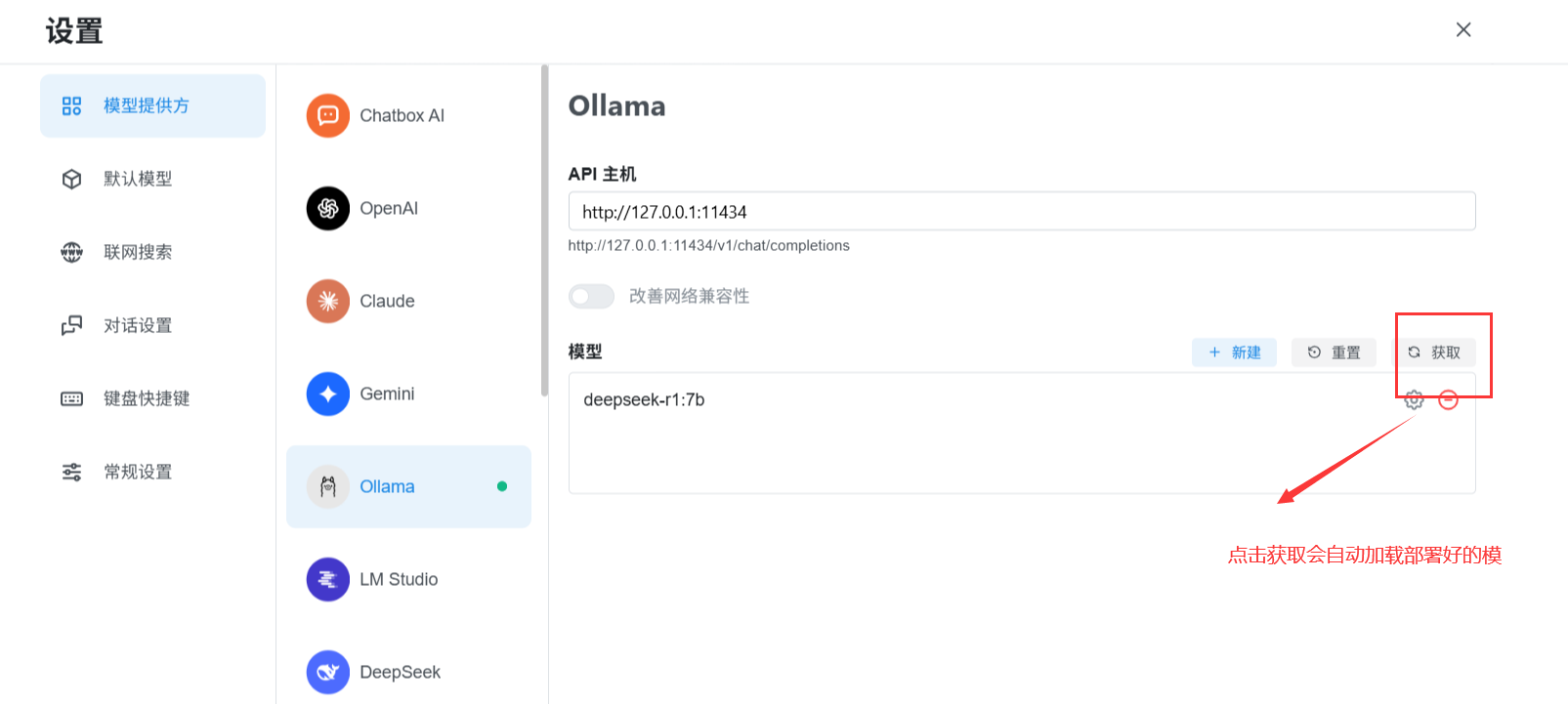

3.3 步骤3:在Chatbox中配置Ollama的DeepSeek模型

- 打开Chatbox,点击左下角「设置」图标,选择「模型服务」;

- 点击「添加服务」,选择「Ollama」,填写以下信息:

-

服务名称:自定义(如"本地DeepSeek-7B");

-

API地址:

http://localhost:11434/v1(若Ollama部署在其他机器,替换为对应IP,如http://192.168.1.100:11434/v1);

-

模型名称:

deepseek:7b-instruct(Ollama中DeepSeek-7B的模型标签,可通过ollama list查看本地模型);

-

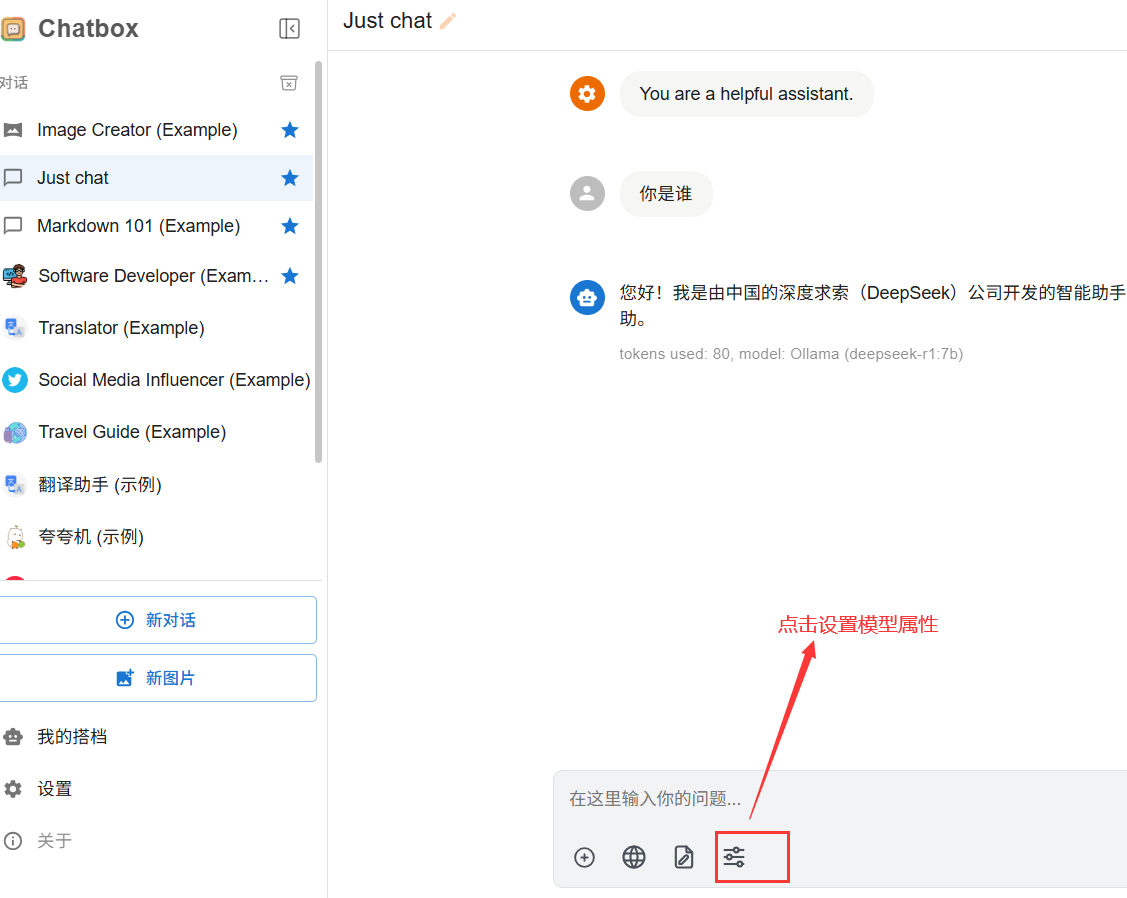

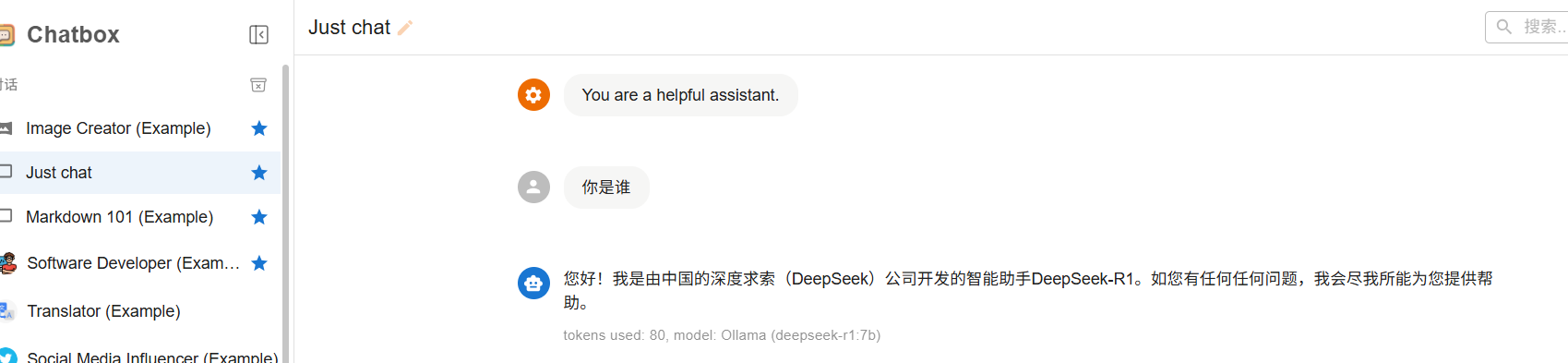

3.4 步骤4:可视化交互测试与进阶操作

-

基础对话 :返回Chatbox主界面,选择"本地DeepSeek-7B"模型,输入问题(如"请解释大模型的注意力机制"),即可看到模型的可视化回答,支持Markdown格式渲染、代码块高亮。

-

参数调试 :点击输入框上方的「参数」按钮,可调整温度(Temperature)、上下文长度(Max Tokens)、Top P等参数,实时观察模型输出的变化(如提高温度会增加回答的随机性)。

-

对话管理:左侧栏会自动保存对话历史,可分组管理;点击对话标题可重命名,方便后续追溯。

-

快捷Prompt模板 :在「设置-快捷指令」中添加常用prompt(如"充当Python导师,解释以下代码:{{code}}"),后续可直接调用,提升调试效率。

四、工具选型与场景匹配:不同需求下的可视化工具选择

| 工具 | 核心定位 | 适用场景 | 技术门槛 | 私有化模型支持度 |

|---|---|---|---|---|

| Dify | 企业级AI应用开发平台 | 需构建AI原生应用(如智能客服、知识库问答) | ★★★☆☆ | 高(支持对接Ollama、本地模型) |

| Cherry Studio | 多服务商AI对话客户端 | 需对比多模型效果(如DeepSeek vs GPT-4) | ★☆☆☆☆ | 中(需手动配置本地API) |

| Chatbox | 私有化模型可视化交互工具 | 个人/小团队调试本地大模型(如Ollama部署的DeepSeek) | ★☆☆☆☆ | 高(无缝对接Ollama) |

- 个人开发者/小团队调试 :优先选择Chatbox,零门槛对接Ollama,快速实现本地模型的可视化交互;

- 企业级AI应用落地 :选择Dify,通过工作流编排与应用发布能力,将私有化模型转化为业务价值;

- 多模型对比与研究 :选择Cherry Studio,在同一界面中快速切换不同服务商、不同规模的模型,高效完成效果对比。

若你在实践中遇到问题,或对大模型私有化、可视化工具的选型有进一步疑问,欢迎在评论区交流讨论!