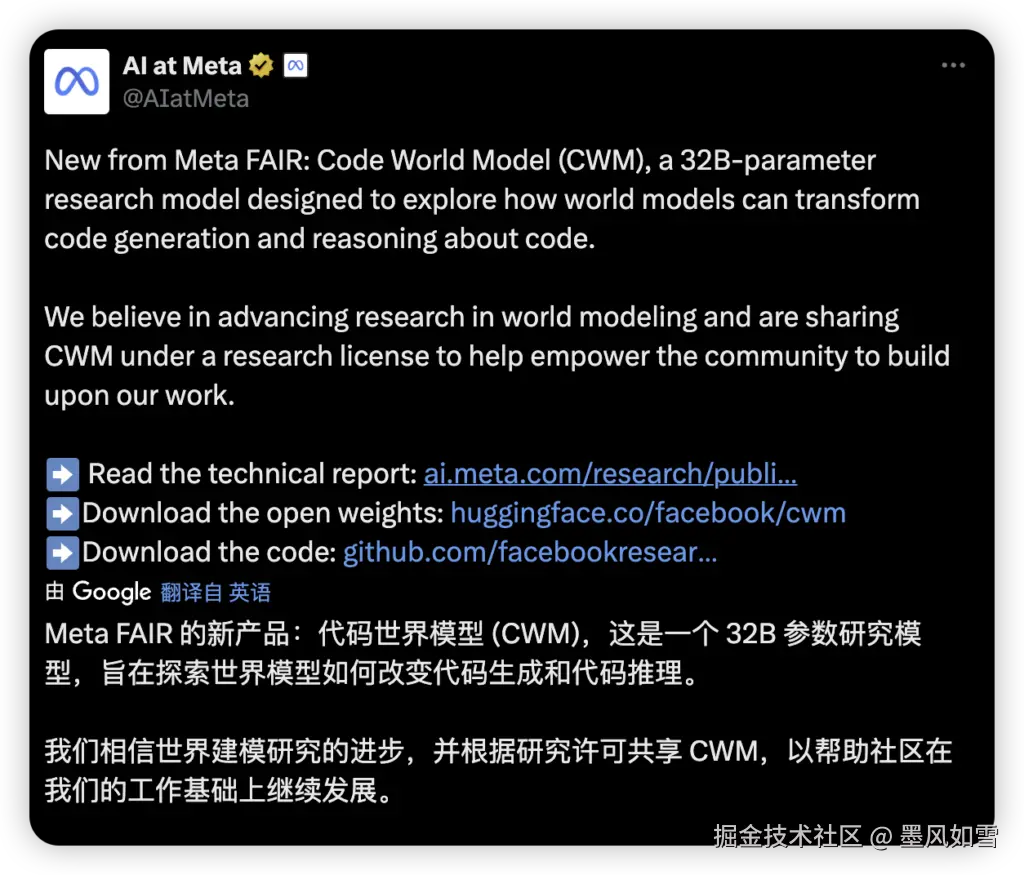

AI写代码,大家见多了,但有多少是写得"活"的?那些语法严谨却在实际运行中错漏百出的"纸上谈兵"式代码,是否让你哭笑不得?最近,Meta FAIR团队给出了一个令人兴奋的答案------他们推出的代码世界模型(CWM,Code World Model) ,这项技术突破简直令人拍案叫绝,因为它让AI写代码,从"依葫芦画瓢"进化到了"深思熟虑"。

核心革新:AI开始"懂"执行了!

CWM最大的魅力,在于它首次系统性地将"世界模型"的概念引入代码生成。这可不是小修小补,而是一次范式上的深刻转变:AI不再仅仅将代码视为静态的文本字符串进行模式匹配,而是开始尝试理解代码是如何在运行时改变程序状态的------比如变量的值、文件系统的变化,甚至是潜在的错误。

想象一下,一个AI不再仅仅是词语的拼接者,而是程序运行的"沙盘推演者"。CWM就像一个无形的"神经调试器",它能够在生成代码的同时,在内部模拟这段代码执行的每一步,预测变量如何流动、系统如何响应。这让它拥有了人类程序员才具备的核心能力:

- 代码执行模拟:在脑海中"跑"一遍代码,预测可能的结果。

- 自我调试与修复:不仅能写,还能通过构造测试用例,在发现错误时自行修改,形成"编写-测试-修正"的闭环。

- 复杂任务推理与规划:面对"先修这个bug,再写那个测试"的多步骤任务,AI也能有条不紊地分析和规划。

探秘幕后:从数据到智能的炼成

CWM的能力并非凭空而来,其技术架构和训练流程堪称精妙。这款拥有320亿参数的Decoder-only Transformer模型,支持高达131,072 tokens的超长上下文窗口,足以处理复杂的代码库。更巧妙的是,它采用了局部与全局交替的注意力机制,平衡了效率与效果。

真正的"魔法"发生在它的三阶段训练流程中:

- 预训练:海量的通用代码和自然语言数据,为模型打下扎实的编程语法基础。

- 中期训练(重头戏) :Meta在这里倾注了5万亿token的"代码世界建模"专属数据。这包括了Python代码在解释器中运行时的完整变量状态变化序列 ,以及在一个Docker环境中,智能体进行编辑文件、运行测试、执行命令的300万条交互轨迹。正是这些"观察-行动-观察"的执行路径数据,让CWM学会了如何"看见"并"理解"代码的动态世界。

- 后训练:通过监督微调和强化学习,进一步打磨模型指令遵循和解决复杂问题的能力。

亮眼成绩:用数据说话的硬实力

CWM的诞生绝非纸上谈兵,它在多项权威基准测试中展现出了令人信服的性能:

- 在解决真实GitHub问题的SWE-bench Verified 上,CWM取得了65.8% 的成绩,这一表现已经接近顶尖的闭源模型水平,并遥遥领先同规模的开源模型。

- 在评估实时编码能力的LiveCodeBench 上,CWM也拿下了68.6% 。

- 更令人惊喜的是,在需要深度逻辑推理的Math-500 和高难度数学竞赛AIME 2024 中,CWM分别取得了96.6% 和76.0% ,这有力证明了其超越代码本身的强大推理能力。

影响深远:开源精神与未来愿景

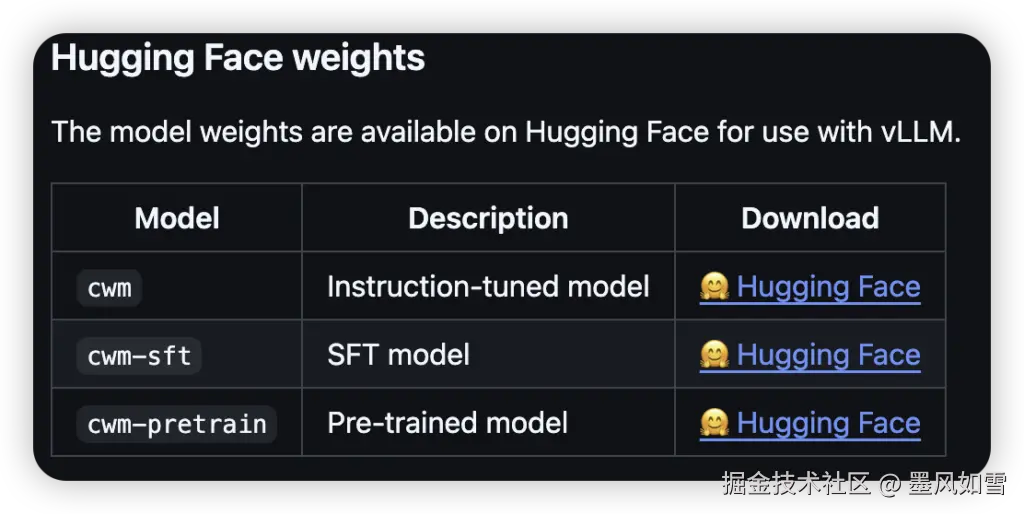

Meta FAIR此次选择开源CWM的完整模型权重,甚至包括了各个训练阶段的检查点,无疑是对AI开源生态的一大贡献。在当前闭源趋势渐显的背景下,这更显得弥足珍贵,为全球学术研究社区提供了宝贵的资源,无疑延续了其首席科学家Yann LeCun所倡导的开源理念。

展望未来,CWM的技术路径为AI编程助手开启了全新的篇章。我们或许很快就能看到:

- 实时交互的"神经调试"开发环境,AI能在你写代码时同步预测错误。

- 大规模软件工程的自动化,如智能化的代码审查、bug自动修复,让程序员从繁琐中解放。

- "世界模型"的理念甚至可能延伸到机器人控制、复杂系统仿真等更广阔的领域。

坦诚相待:目前的局限与期待

当然,作为一项前沿研究成果,CWM并非没有其局限性。它目前主要是一个研究型模型,硬件要求极高(运行完整模型需要约160GB显存),且其"世界建模"能力主要基于Python语言的数据。因此,它不适合作为通用聊天机器人,也尚未覆盖C++、Java等其他主流语言。

总而言之,Meta发布的CWM模型,以其独特的"世界模型"视角,为AI编程助手的发展描绘了一幅激动人心的蓝图。它不仅在性能上实现了里程碑式的突破,其开源策略也为后续研究奠定了重要基础。虽然目前仍处于研究阶段且存在一些限制,但它无疑为未来AI编程从"写得对"到"懂运行"指明了一个充满无限可能性的方向。我们正站在一个新时代的门槛上,见证着AI如何一步步深入理解我们的创造物------代码。

如果你也对最新的AI信息感兴趣或者有疑问 都可以加入我的大家庭 第一时间分享最新AI资讯、工具、教程、文档 欢迎你的加入!!!😉😉😉

公众号:墨风如雪小站