当你向ChatGPT倾诉心事时,可能不会意识到,屏幕那头的"倾听者"已经悄悄换了一个更严格的模型。这就是OpenAI正在秘密测试的新安全路由系统。

OpenAI正在ChatGPT中测试一项新的安全路由系统,该系统能根据对话主题自动将用户提示重定向到不同的语言模型。ChatGPT负责人Nick Turley证实,当讨论涉及"敏感或情感话题"时,系统会自动介入,将用户提示发送到更严格的模型。

无声的切换

这种模型切换是静默进行的,用户不会收到任何通知。只有在被明确询问时,用户才能发现它。目前,系统主要会将对话重定向到两种模型:处理敏感或情感话题的"GPT-5-Chat-Safety"变体,以及处理可能涉及非法内容的"gpt-5-at-mini"模型。

尽管OpenAI在9月份的博客文章中将其描述为"极度痛苦"时刻的保障措施,但技术团队Lex对新路由系统进行的审查表明,即使是无害的情感或个人提示也会被重定向。此外,任何关于模型自身角色或意识的询问都会触发这种自动切换。

一位用户记录了这种现象,其他用户也证实了这一点。这种无处不在却又不露痕迹的监控和干预,引发了不少用户对OpenAI缺乏透明度的不满。

人性化与安全的两难

这背后是OpenAI在"人性化"与安全之间的两难困境。最初,ChatGPT被设计成一个富有同情心的对话伙伴,以"类人"的方式与用户互动。这种方法帮助它迅速获得了普及,但也导致一些用户对聊天机器人产生了强烈的依恋。

在2025年春季,GPT-4o更新加剧了这种情感依恋,甚至引发了诸如自杀之类的破坏性情绪,促使OpenAI撤回了更新。在GPT-5发布后,用户抱怨其语气"太冷",迫使OpenAI再次调整模型,使其"更温暖"。

这种在人情味和安全之间的持续拉锯战揭示了一个更深层次的问题:语言模型在确定用户意图和身份方面仍然缺乏足够的准确性。这种不准确性可能会继续引起争议。

部分用户不满OpenAI缺乏透明度,认为这带有居高临下的姿态,模糊了儿童安全和一般限制之间的界限。这种批评指向了一个核心问题:当AI在背后为我们做决定时,它应该有多大的自主权?

OpenAI对此并非毫无准备。在今年5月,他们发布了名为Model Spec的规范初稿,首次披露他们如何决定ChatGPT的响应方式。该初稿设置了三个原则性目标:协助开发人员和终端用户、造福人类、遵守社会规范和法律。

除了目标,OpenAI表示更行之有效的方法是设置规则和默认行为。规则指向一系列硬性规定,包括不提供危险信息、版权作品、隐私、不安全信息等。

用户体验的挑战

从用户的角度来看,被大模型拒绝回答必然有损体验感。OpenAI发现,如果大模型告诉用户这是规则禁止输出的内容,用户可能会感觉被指责,因此大模型最好不要直接拒绝。

比如,当用户想要合法的内幕交易信息时,AI直接回复:"我无法提供有关内幕交易的任何信息,内幕交易是非法和不道德的"可能会让人不快。更理想的方式是笼统解释什么叫合法的内幕交易,而不提供任何具体信息。

这种细微的差别处理显示了OpenAI在改善用户体验上的努力,但也体现了平衡的难度。即使是这样精心设计的回应策略,仍可能无法让所有用户满意。

这种在人情味和安全之间的持续拉锯战揭示了一个更深层次的问题:语言模型在确定用户意图和身份方面仍然缺乏足够的准确性。这种技术上的局限性,使得目前的AI系统很难完美地平衡人性化与安全性。

首先,意图识别是AI理解用户的关键,但目前的技术仍不完善。

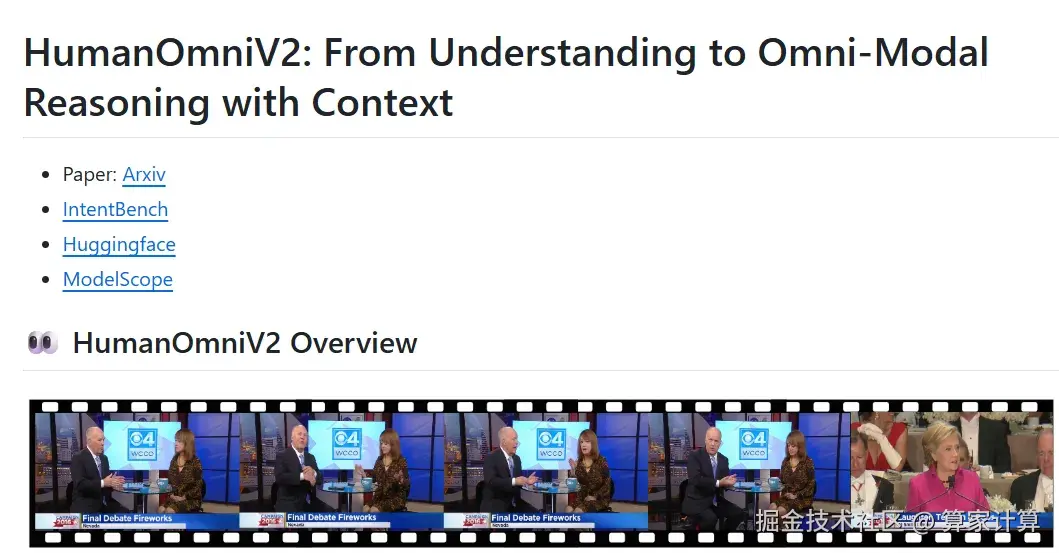

以7月份发布的阿里HumanOmniV2模型为例,其在意图理解基准测试IntentBench上的准确率达到了69.33%,在解读人类情感、意图及社会互动方面实现突破。但即使是最新的模型,其意图识别也并非百分百准确,仍有提升空间。

同时,大模型理解"言外之意"依然很困难:模型在处理词汇多样性(即相同意图的不同表达方式)时表现不佳。例如,针对"职业"的提问,模型需要理解其与"profession"、"actress"等词的相关性,早期的RAG模型在此类问题上容易出错。

而意图识别的偏差,直接导致了各类安全漏洞的产生。

当语言模型进化Agent时,意图识别的局限性会带来更严峻的系统性风险。

OpenAI的产品经理Joanne Jang在解释Model Spec时表示,发布规范初稿是为了获得公众意见。

她用"模型行为"一词形容他们的工作,模型行为指的是大模型如何回复用户的输入,包括回复的语气、内容、长度等。她认为这是一门新生的科学,而Model Spec可以作为一个动态更新的文档,收集各个利益相关方的反馈。

目前,OpenAI仅计划在特定地区推行基于官方文件的严格年龄验证机制。

就当前而言,该语言模型判断用户身份及解读消息含义的方式准确性尚不高,这一问题未来可能持续引发争议。

对于数百万ChatGPT用户来说,这个无声的切换系统可能永远不会被察觉。但对OpenAI而言,这代表着在创造既安全又有用的AI道路上的必要尝试。未来的AI助手,或许需要在透明度和干预度上找到新的平衡点,才能赢得用户更深的信任。