目录

[1 -> 概述](#1 -> 概述 "#1%20-%3E%20%E6%A6%82%E8%BF%B0")

[2 -> 技术架构概览](#2 -> 技术架构概览 "#2%20-%3E%20%E6%8A%80%E6%9C%AF%E6%9E%B6%E6%9E%84%E6%A6%82%E8%A7%88")

[2.1 -> 底层算法层](#2.1 -> 底层算法层 "#2.1%20-%3E%20%E5%BA%95%E5%B1%82%E7%AE%97%E6%B3%95%E5%B1%82")

[2.2 -> 引擎服务层](#2.2 -> 引擎服务层 "#2.2%20-%3E%20%E5%BC%95%E6%93%8E%E6%9C%8D%E5%8A%A1%E5%B1%82")

[2.3 -> Unity SDK层](#2.3 -> Unity SDK层 "#2.3%20-%3E%20Unity%20SDK%E5%B1%82")

[3 -> 核心算法深度解析](#3 -> 核心算法深度解析 "#3%20-%3E%20%E6%A0%B8%E5%BF%83%E7%AE%97%E6%B3%95%E6%B7%B1%E5%BA%A6%E8%A7%A3%E6%9E%90")

[3.1 -> 手部检测算法](#3.1 -> 手部检测算法 "#3.1%20-%3E%20%E6%89%8B%E9%83%A8%E6%A3%80%E6%B5%8B%E7%AE%97%E6%B3%95")

[3.2 -> 手骨关键点检测](#3.2 -> 手骨关键点检测 "#3.2%20-%3E%20%E6%89%8B%E9%AA%A8%E5%85%B3%E9%94%AE%E7%82%B9%E6%A3%80%E6%B5%8B")

[3.3 -> 手势分类逻辑](#3.3 -> 手势分类逻辑 "#3.3%20-%3E%20%E6%89%8B%E5%8A%BF%E5%88%86%E7%B1%BB%E9%80%BB%E8%BE%91")

[4 -> Unity SDK源码深度分析](#4 -> Unity SDK源码深度分析 "#4%20-%3E%20Unity%20SDK%E6%BA%90%E7%A0%81%E6%B7%B1%E5%BA%A6%E5%88%86%E6%9E%90")

[4.1 -> RKInput 输入管理系统](#4.1 -> RKInput 输入管理系统 "#4.1%20-%3E%20RKInput%20%E8%BE%93%E5%85%A5%E7%AE%A1%E7%90%86%E7%B3%BB%E7%BB%9F")

[4.2 -> RKHand 手部交互组件](#4.2 -> RKHand 手部交互组件 "#4.2%20-%3E%20RKHand%20%E6%89%8B%E9%83%A8%E4%BA%A4%E4%BA%92%E7%BB%84%E4%BB%B6")

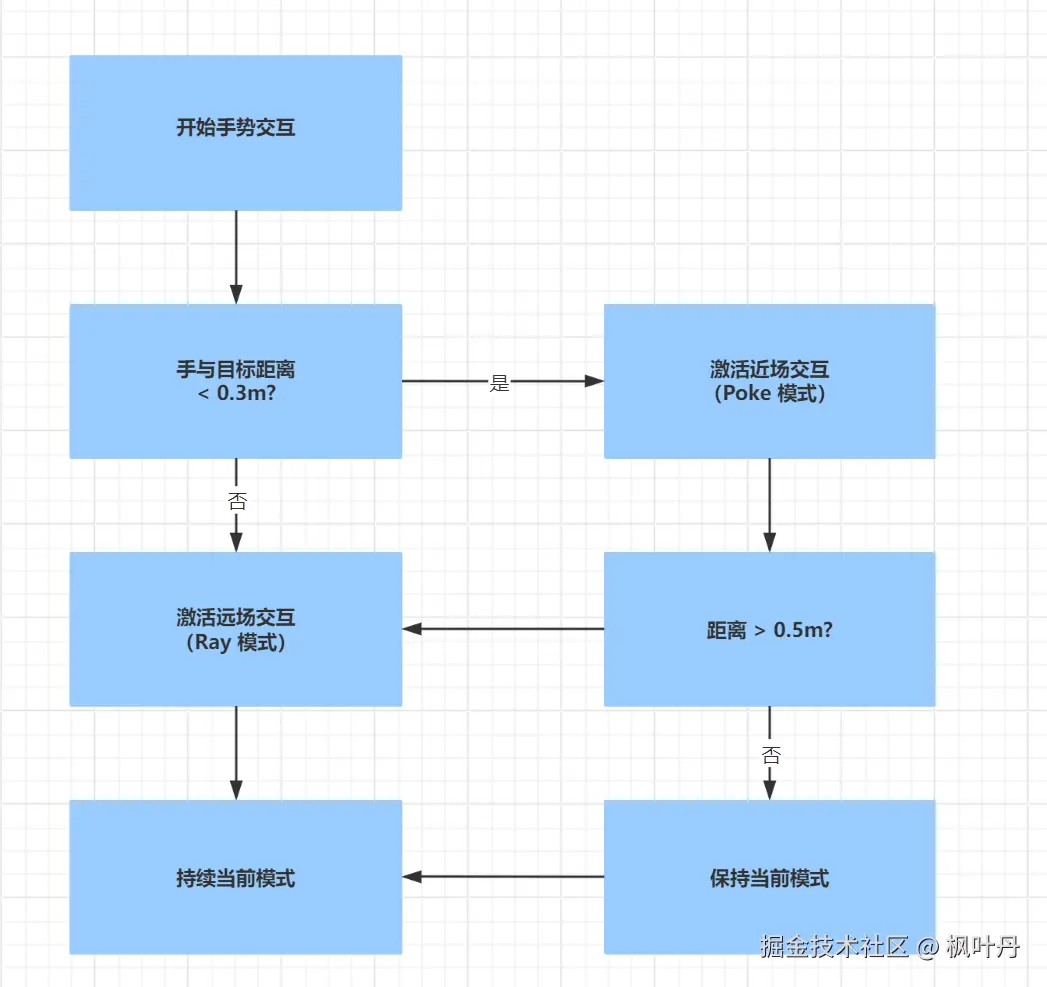

[4.3 -> 远近场交互切换机制](#4.3 -> 远近场交互切换机制 "#4.3%20-%3E%20%E8%BF%9C%E8%BF%91%E5%9C%BA%E4%BA%A4%E4%BA%92%E5%88%87%E6%8D%A2%E6%9C%BA%E5%88%B6")

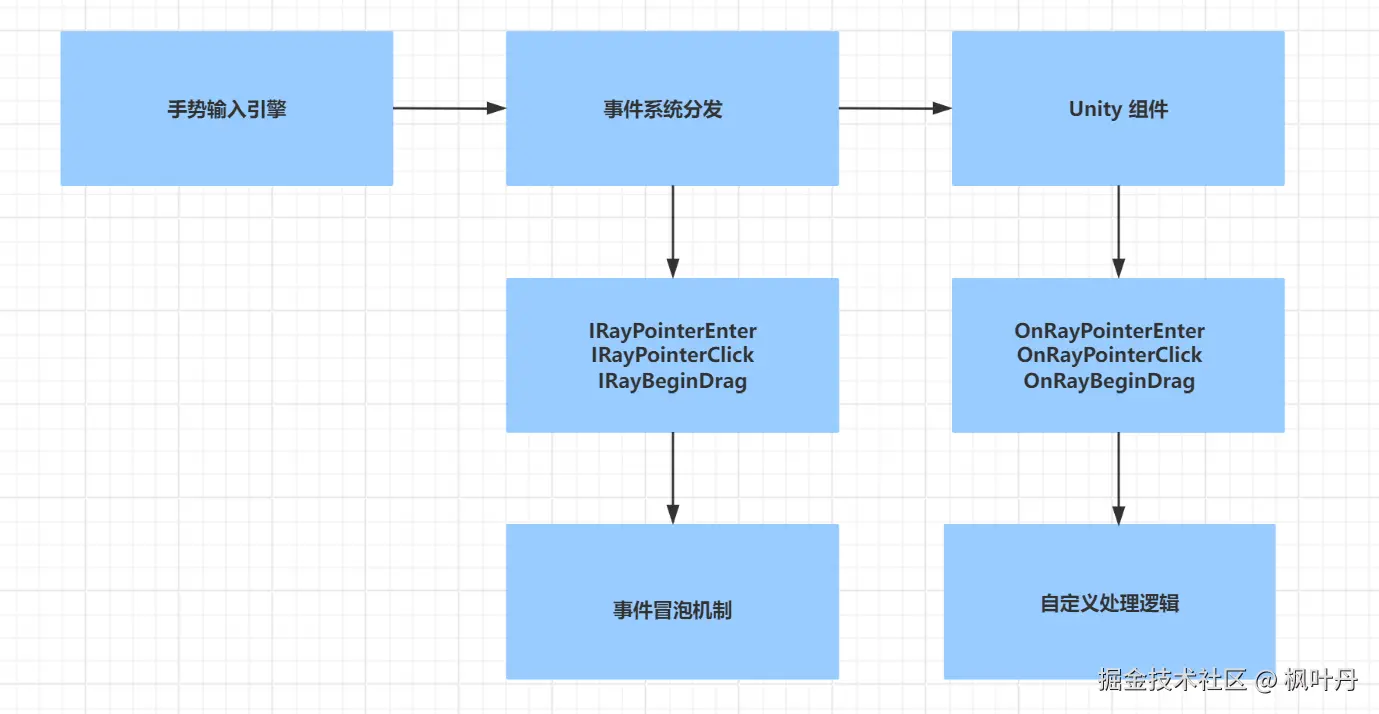

[4.4 -> 手势事件系统](#4.4 -> 手势事件系统 "#4.4%20-%3E%20%E6%89%8B%E5%8A%BF%E4%BA%8B%E4%BB%B6%E7%B3%BB%E7%BB%9F")

[5 -> 性能优化策略](#5 -> 性能优化策略 "#5%20-%3E%20%E6%80%A7%E8%83%BD%E4%BC%98%E5%8C%96%E7%AD%96%E7%95%A5")

[5.1 -> 模型推理优化](#5.1 -> 模型推理优化 "#5.1%20-%3E%20%E6%A8%A1%E5%9E%8B%E6%8E%A8%E7%90%86%E4%BC%98%E5%8C%96")

[5.2 -> 渲染优化](#5.2 -> 渲染优化 "#5.2%20-%3E%20%E6%B8%B2%E6%9F%93%E4%BC%98%E5%8C%96")

[5.3 -> 内存管理](#5.3 -> 内存管理 "#5.3%20-%3E%20%E5%86%85%E5%AD%98%E7%AE%A1%E7%90%86")

[6 -> 高级特性与自定义扩展](#6 -> 高级特性与自定义扩展 "#6%20-%3E%20%E9%AB%98%E7%BA%A7%E7%89%B9%E6%80%A7%E4%B8%8E%E8%87%AA%E5%AE%9A%E4%B9%89%E6%89%A9%E5%B1%95")

[6.1 -> 自定义手势识别](#6.1 -> 自定义手势识别 "#6.1%20-%3E%20%E8%87%AA%E5%AE%9A%E4%B9%89%E6%89%8B%E5%8A%BF%E8%AF%86%E5%88%AB")

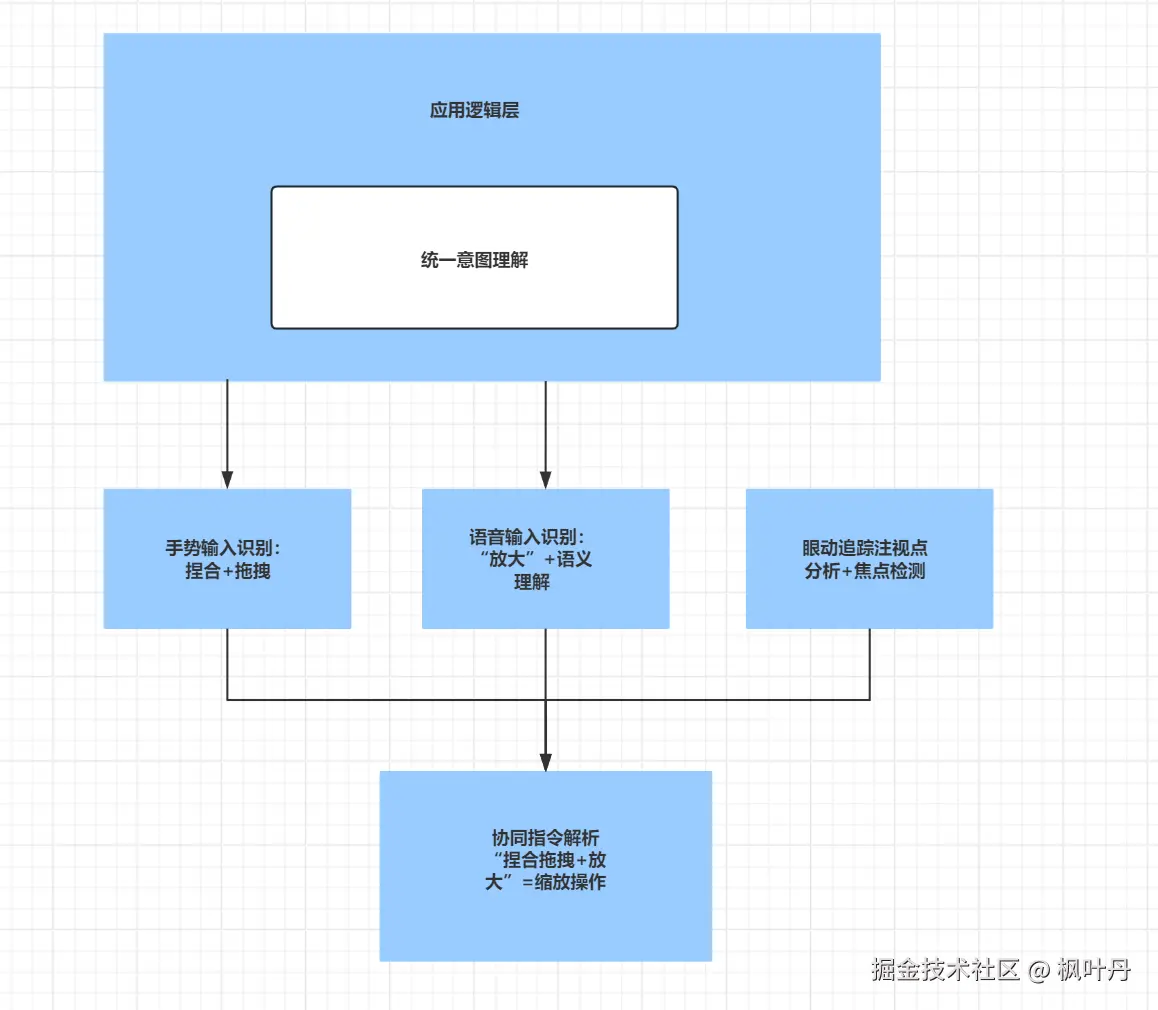

[6.2 -> 多模态融合](#6.2 -> 多模态融合 "#6.2%20-%3E%20%E5%A4%9A%E6%A8%A1%E6%80%81%E8%9E%8D%E5%90%88")

[7 -> 实战应用案例](#7 -> 实战应用案例 "#7%20-%3E%20%E5%AE%9E%E6%88%98%E5%BA%94%E7%94%A8%E6%A1%88%E4%BE%8B")

[7.1 -> 3D 物体操控](#7.1 -> 3D 物体操控 "#7.1%20-%3E%203D%20%E7%89%A9%E4%BD%93%E6%93%8D%E6%8E%A7")

[7.2 -> UI 交互优化](#7.2 -> UI 交互优化 "#7.2%20-%3E%20UI%20%E4%BA%A4%E4%BA%92%E4%BC%98%E5%8C%96")

[8 -> 技术挑战与解决方案](#8 -> 技术挑战与解决方案 "#8%20-%3E%20%E6%8A%80%E6%9C%AF%E6%8C%91%E6%88%98%E4%B8%8E%E8%A7%A3%E5%86%B3%E6%96%B9%E6%A1%88")

[8.1 -> 遮挡处理](#8.1 -> 遮挡处理 "#8.1%20-%3E%20%E9%81%AE%E6%8C%A1%E5%A4%84%E7%90%86")

[8.2 -> 光照适应性](#8.2 -> 光照适应性 "#8.2%20-%3E%20%E5%85%89%E7%85%A7%E9%80%82%E5%BA%94%E6%80%A7")

[9 -> 未来演进方向](#9 -> 未来演进方向 "#9%20-%3E%20%E6%9C%AA%E6%9D%A5%E6%BC%94%E8%BF%9B%E6%96%B9%E5%90%91")

[10 -> 结语](#10 -> 结语 "#10%20-%3E%20%E7%BB%93%E8%AF%AD")

编辑

1 -> 概述

Rokid 作为国内 AR 领域的领军企业,其手势识别技术在多代产品中不断演进,为开发者提供了强大的自然交互能力。本文将深入剖析 Rokid 手势识别的技术架构,结合 Unity SDK 源码,从底层算法到上层应用进行全面解析。

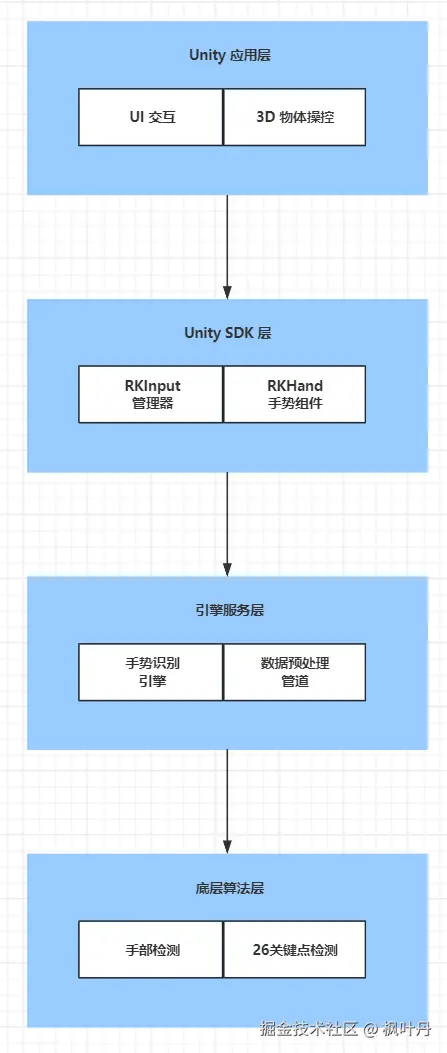

2 -> 技术架构概览

Rokid 手势识别系统采用分层架构设计,从下至上包括:

编辑

2.1 -> 底层算法层

- 手部检测与追踪:基于深度学习的手部边界框检测

- 26点手骨关键点检测:精确识别手部关节位置

- 手势分类算法:实时识别预定义手势状态

- 位姿估计算法:计算手部的3D空间位置和朝向

2.2 -> 引擎服务层

- 手势识别引擎:C++ 核心处理模块

- 数据预处理管道:图像标准化、数据增强

- 模型推理优化:针对移动端的神经网络加速

2.3 -> Unity SDK层

- RKInput 管理器:统一的多模态输入管理

- RKHand 组件:手部渲染与交互逻辑

- 事件系统:手势事件的传递与处理

3 -> 核心算法深度解析

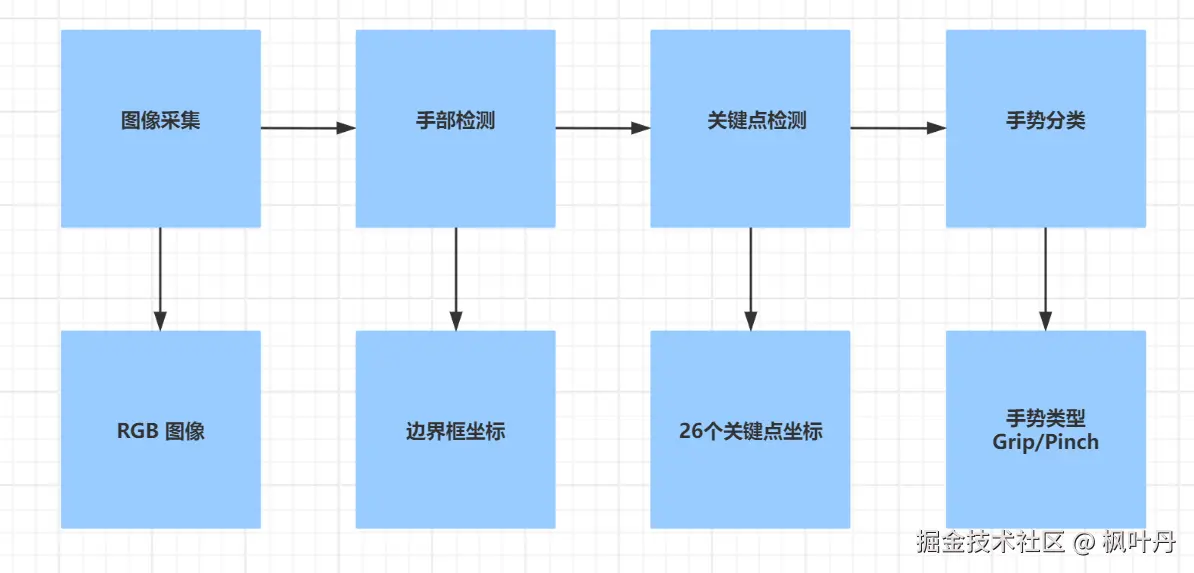

编辑

3.1 -> 手部检测算法

Rokid 采用轻量级 YOLOv4-tiny 改进版本进行手部检测:

arduino

// 手部检测流程

class HandDetector {

public:

DetectionResult detect(const cv::Mat& frame) {

// 图像预处理

cv::Mat preprocessed = preprocess(frame);

// 神经网络推理

float* output = network.inference(preprocessed);

// 后处理 - 非极大值抑制

vector<BoundingBox> boxes = nms(output, confidence_threshold);

return {boxes, frame.size()};

}

};关键优化点:

- 输入分辨率:416×416,平衡精度与速度

- Anchor设计:针对手部比例优化预定义框

- 量化策略:INT8 量化减少模型体积

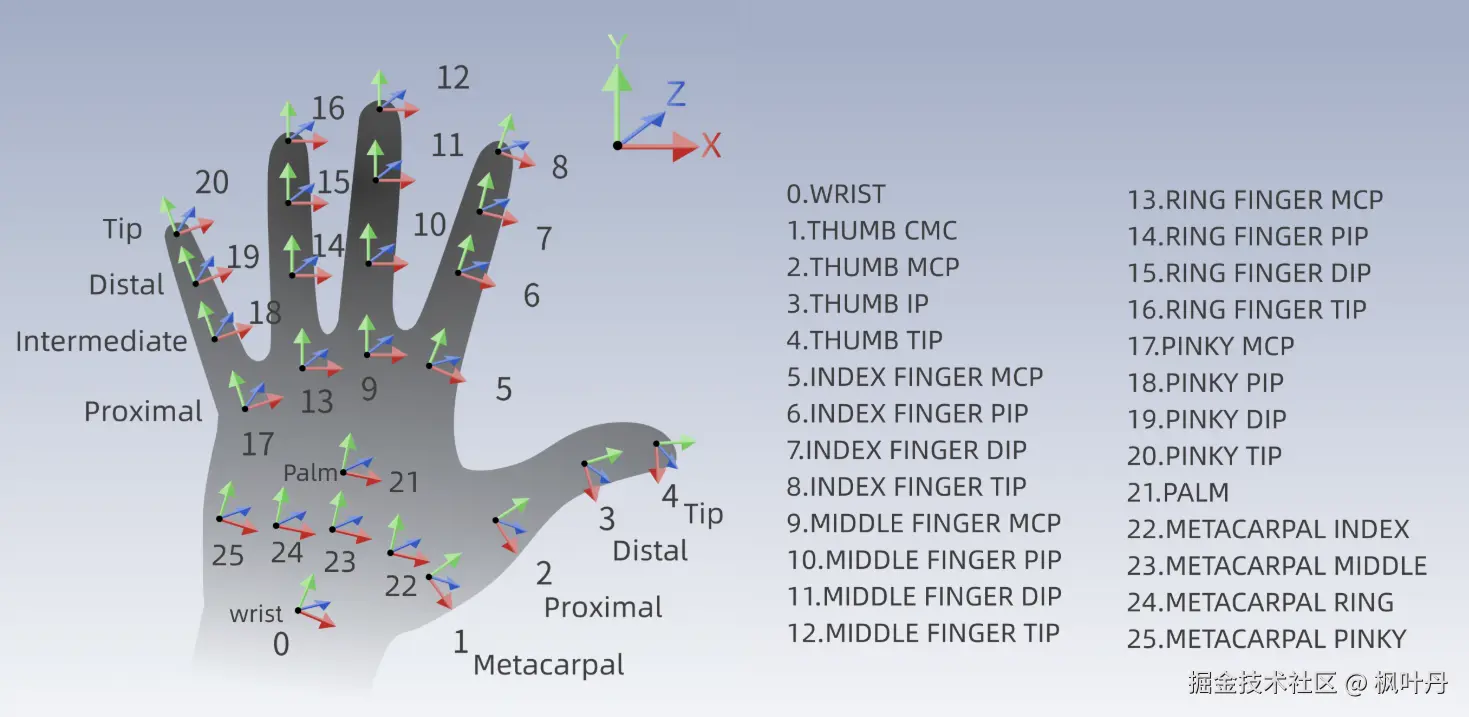

3.2 -> 手骨关键点检测

编辑

基于 Heatmap 回归的 26 点关键点检测:

ini

class HandLandmarkDetector {

private:

const int NUM_KEYPOINTS = 26;

const int HEATMAP_SIZE = 64;

public:

vector<KeyPoint> estimate(const cv::Mat& hand_roi) {

// 生成26个通道的Heatmap

vector<cv::Mat> heatmaps = model.predict(hand_roi);

vector<KeyPoint> keypoints;

for (int i = 0; i < NUM_KEYPOINTS; i++) {

// 寻找Heatmap极值点

Point2f max_loc = findMaxLocation(heatmaps[i]);

// 亚像素精度优化

KeyPoint kp = refineKeyPoint(max_loc, heatmaps[i]);

keypoints.push_back(kp);

}

return keypoints;

}

};技术亮点:

- Encoder-Decoder 架构:保持空间分辨率的同时提取深层特征

- Coordinate Decoding:基于热力图的最大值位置提取关键点坐标

- 多任务学习:同时预测关键点位置和手部存在置信度

3.3 -> 手势分类逻辑

基于关键点空间关系的状态机分类:

kotlin

// Unity SDK中的手势分类实现

public enum GestureType {

None = -1,

Grip = 1, // 握拳

Palm = 2, // 手掌

Pinch = 3, // 捏合

OpenPinch = 4 // 捏合松开

}

public class GestureClassifier {

public GestureType Classify(List<Vector3> keypoints) {

// 计算手指弯曲角度

float thumbAngle = CalculateFingerAngle(keypoints, FingerType.Thumb);

float indexAngle = CalculateFingerAngle(keypoints, FingerType.Index);

// 基于角度阈值分类

if (thumbAngle < 30f && indexAngle < 25f) {

return GestureType.Pinch;

} else if (AllFingersBent(keypoints)) {

return GestureType.Grip;

} else if (AllFingersExtended(keypoints)) {

return GestureType.Palm;

}

return GestureType.None;

}

}4 -> Unity SDK源码深度分析

4.1 -> RKInput 输入管理系统

作为多模态输入的统一入口,RKInput 采用模块化设计:

csharp

// Assets/Rokid/UXR/Scripts/Input/RKInput.cs

public class RKInput : MonoBehaviour {

[SerializeField] private InputModuleType defaultInitModule = InputModuleType.Gesture;

[SerializeField] private InputModuleType defaultActiveModule = InputModuleType.Gesture;

private InputModuleManager moduleManager;

private Dictionary<InputModuleType, IInputModule> modules;

void Start() {

InitializeModules();

ActivateDefaultModule();

}

private void InitializeModules() {

modules = new Dictionary<InputModuleType, IInputModule>();

// 动态加载预配置的输入模块

if (defaultInitModule.HasFlag(InputModuleType.Gesture)) {

var gestureModule = gameObject.AddComponent<GestureInputModule>();

modules[InputModuleType.Gesture] = gestureModule;

}

// 其他模块初始化...

}

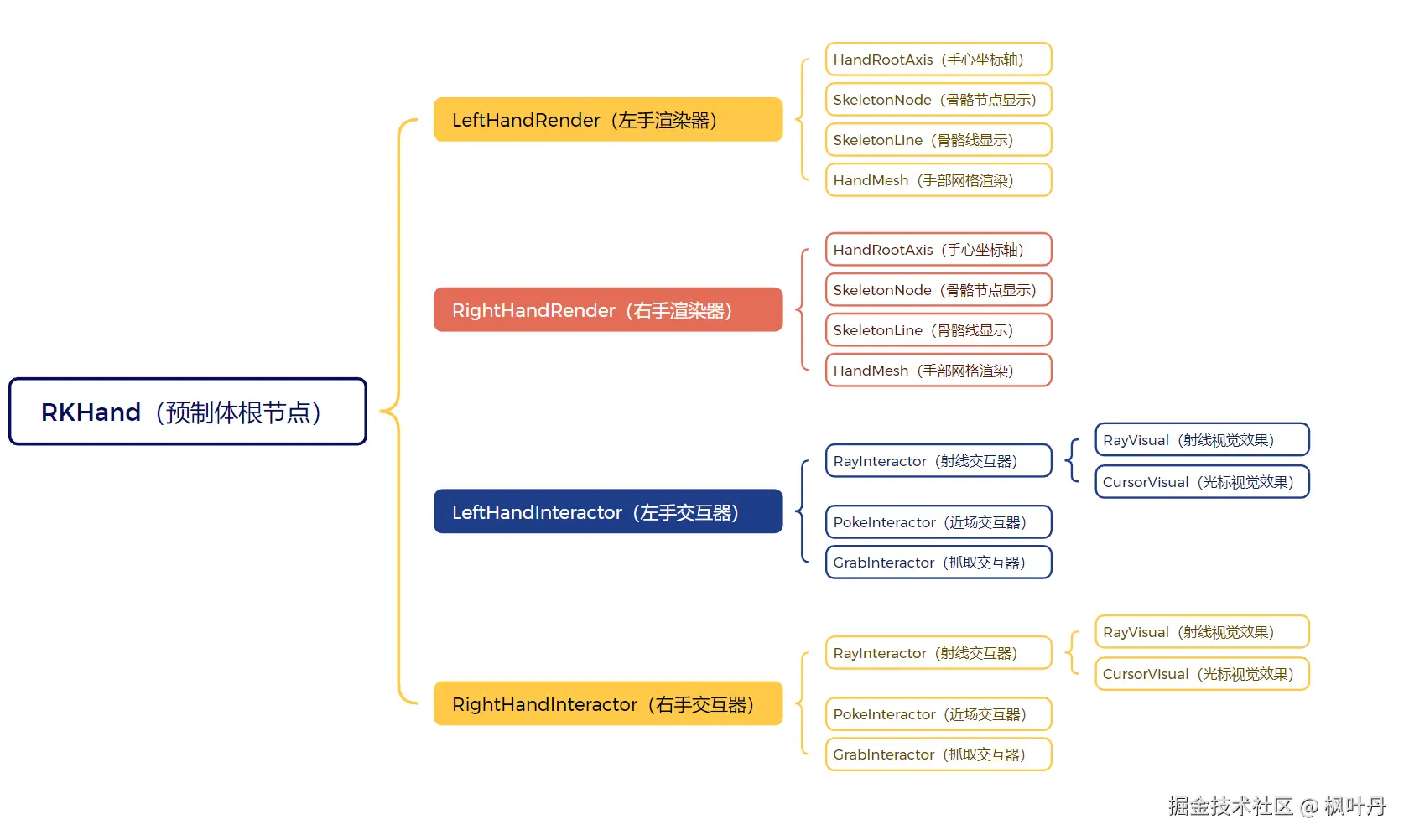

}4.2 -> RKHand 手部交互组件

编辑

RKHand 是手势交互的核心,实现远近场无缝切换:

ini

// Assets/Rokid/UXR/Scripts/Hand/RKHand.cs

public class RKHand : MonoBehaviour {

[SerializeField] private HandType handType = HandType.RightHand;

[SerializeField] private HandRender handRender;

[SerializeField] private ModuleInteractor moduleInteractor;

// 关键组件引用

private RayInteractor rayInteractor;

private PokeInteractor pokeInteractor;

private InteractorStateChange stateChange;

void Update() {

UpdateHandPose();

UpdateInteractorState();

}

private void UpdateHandPose() {

// 从手势引擎获取最新手部数据

var handData = GesEventInput.Instance.GetHandData(handType);

if (handData.isValid) {

transform.position = handData.position;

transform.rotation = handData.rotation;

UpdateSkeletonPose(handData.keypoints);

}

}

}4.3 -> 远近场交互切换机制

编辑

基于 InteractorStateChange 的状态管理:

csharp

// Assets/Rokid/UXR/Scripts/Interaction/InteractorStateChange.cs

public class InteractorStateChange : MonoBehaviour {

[SerializeField] private float nearFieldThreshold = 0.3f;

private bool isFarField = true;

private PokeInteractor pokeInteractor;

private RayInteractor rayInteractor;

public void OnPokeInteractorHover() {

// 切换到近场交互

if (isFarField) {

rayInteractor.SetActive(false);

pokeInteractor.SetActive(true);

isFarField = false;

}

}

public void OnPokeInteractorUnHover() {

// 切换回远场交互

if (!isFarField) {

pokeInteractor.SetActive(false);

rayInteractor.SetActive(true);

isFarField = true;

}

}

}4.4 -> 手势事件系统

编辑

扩展 Unity 原生事件系统,支持 3D 交互:

csharp

// Assets/Rokid/UXR/Scripts/Interaction/Interfaces/IRayInterfaces.cs

public interface IRayPointerEnter : IEventSystemHandler {

void OnRayPointerEnter(PointerEventData eventData);

}

public interface IRayPointerClick : IEventSystemHandler {

void OnRayPointerClick(PointerEventData eventData);

}

// 具体实现示例

public class CustomRayInteractable : MonoBehaviour,

IRayPointerEnter,

IRayPointerClick {

public void OnRayPointerEnter(PointerEventData eventData) {

Debug.Log($"Ray entered: {gameObject.name}");

// 高亮反馈

}

public void OnRayPointerClick(PointerEventData eventData) {

Debug.Log($"Ray clicked: {gameObject.name}");

// 点击逻辑

}

}5 -> 性能优化策略

5.1 -> 模型推理优化

- 分层推理:检测与关键点分步执行,降低计算负载

- 动态帧率:根据系统负载调整识别频率

- ROI 缓存:连续帧间手部区域缓存,减少全图检测

5.2 -> 渲染优化

ini

// 手部Mesh LOD控制

public class HandRender : MonoBehaviour {

private SkinnedMeshRenderer handMesh;

private float[] lodDistances = { 0.5f, 1.0f, 2.0f };

private int[] polyCounts = { 2000, 1000, 500 };

void UpdateLOD() {

float distance = Vector3.Distance(transform.position,

Camera.main.transform.position);

for (int i = 0; i < lodDistances.Length; i++) {

if (distance < lodDistances[i]) {

handMesh.mesh = GetLODMesh(polyCounts[i]);

break;

}

}

}

}5.3 -> 内存管理

- 对象池:交互器对象重复使用

- 资源异步加载:手势模型按需加载

- 事件回收:避免事件监听器泄漏

6 -> 高级特性与自定义扩展

6.1 -> 自定义手势识别

基于骨骼数据的自定义手势检测:

arduino

public class CustomGestureDetector {

public bool DetectThumbsUp(HandType handType) {

var thumbTip = GesEventInput.Instance.GetSkeletonPose(

SkeletonIndexFlag.THUMB_TIP, handType);

var indexTip = GesEventInput.Instance.GetSkeletonPose(

SkeletonIndexFlag.INDEX_FINGER_TIP, handType);

// 拇指向上且其他手指弯曲

return thumbTip.position.y > indexTip.position.y &&

CheckFingersCurl(handType, excludeThumb: true);

}

private bool CheckFingersCurl(HandType handType, bool excludeThumb) {

// 基于关键点角度计算手指弯曲程度

// 实现细节...

}

}6.2 -> 多模态融合

编辑

手势与语音、控制器输入的协同:

scss

public class MultiModalManager : MonoBehaviour {

private void Update() {

// 手势优先级判断

if (IsHandInView()) {

SwitchToGestureInput();

} else if (IsControllerActive()) {

SwitchToControllerInput();

}

// 手势+语音组合命令

if (IsPinchGesture() && IsVoiceCommand("放大")) {

ExecuteZoomIn();

}

}

}7 -> 实战应用案例

7.1 -> 3D 物体操控

arduino

public class ObjectManipulator : MonoBehaviour,

IRayBeginDrag,

IRayDragToTarget,

IRayEndDrag {

private Vector3 dragStartPosition;

private bool isDragging = false;

public void OnRayBeginDrag(PointerEventData eventData) {

dragStartPosition = transform.position;

isDragging = true;

}

public void OnRayDragToTarget(Vector3 targetPoint) {

if (isDragging) {

transform.position = targetPoint;

}

}

public void OnRayEndDrag(PointerEventData eventData) {

isDragging = false;

}

}7.2 -> UI 交互优化

csharp

public class AdvancedPointableUI : PointableCanvas {

[SerializeField] private float hoverScaleFactor = 1.1f;

[SerializeField] private float animationDuration = 0.2f;

protected override void OnRayPointerEnter(PointerEventData eventData) {

base.OnRayPointerEnter(eventData);

StartCoroutine(ScaleAnimation(hoverScaleFactor));

}

protected override void OnRayPointerExit(PointerEventData eventData) {

base.OnRayPointerExit(eventData);

StartCoroutine(ScaleAnimation(1.0f));

}

}8 -> 技术挑战与解决方案

8.1 -> 遮挡处理

- 部分遮挡推理:基于可见关键点推测完整手型

- 时序连续性:利用帧间一致性填补缺失数据

- 多手分离:通过空间关系区分重叠手部

8.2 -> 光照适应性

- 数据增强训练:包含各种光照条件的训练数据

- 实时白平衡:图像预处理中的自动色彩校正

- 模型鲁棒性:对亮度变化不敏感的网络结构

9 -> 未来演进方向

- 更精细的手势识别:支持手指微动作、双手复杂交互

- 语义理解:结合上下文理解手势意图

- 跨设备协同:多设备间手势交互无缝切换

- 个性化适配:基于用户习惯的自适应识别

10 -> 结语

Rokid 手势识别技术通过深度学习算法与精心设计的 Unity SDK 架构,为开发者提供了强大而灵活的自然交互能力。从底层的21点关键点检测到上层的多模态输入管理,整个技术栈体现了工程优化与用户体验的深度结合。

随着 AR/VR 技术的不断发展,手势交互必将成为人机交互的重要方式。Rokid 通过开源其 SDK 和持续的技术迭代,正在推动整个生态的繁荣发展。对于开发者而言,深入理解其技术原理和实现细节,将有助于打造更加自然、沉浸的交互体验。

本文基于 Rokid UXR SDK 3.0 版本分析,具体实现可能随版本更新而变化。建议开发者参考官方最新文档和源码获取最准确的信息。

感谢各位大佬支持!!!

互三啦!!!