传送锚点

-

- 引言

- 1.技术基础:Whisper为什么能"听懂全世界"?

-

- [1.1 模型架构与训练数据](#1.1 模型架构与训练数据)

- [1.2 核心创新:多任务"一站式"处理](#1.2 核心创新:多任务“一站式”处理)

- 2.零门槛部署:共绩算力容器化方案

- 3.两种使用方式:API和网页服务

-

- [3.1 生产环境:HTTP 接口调用](#3.1 生产环境:HTTP 接口调用)

-

- [3.1.1 asr:语音识别接口](#3.1.1 asr:语音识别接口)

- [3.1.2 /detect-language:语言检测接口](#3.1.2 /detect-language:语言检测接口)

- [3.2 网页服务:可视化操作](#3.2 网页服务:可视化操作)

-

- [3.2.1 英文音频转文字](#3.2.1 英文音频转文字)

- [3.2.2 中文视频转文字](#3.2.2 中文视频转文字)

- 4.参数调优:提升识别精度的关键

- 5.Whisper模型语音识别最佳实践场景

-

- [5.1 内容创作与媒体制作](#5.1 内容创作与媒体制作)

- [5.2 教育与学术研究](#5.2 教育与学术研究)

- [5.3 多语言交流与协作](#5.3 多语言交流与协作)

- 6.总结与展望

引言

OpenAI 于2022年12月开源的 Whisper 模型,凭借 多语言支持(98种语言)、零样本迁移能力、噪声鲁棒性 等核心优势,迅速成为语音识别领域的"明星工具"。其在英语语音识别任务中接近人类水平(LibriSpeech测试清洁切分WER达2.5%),同时支持语音翻译、语言识别等多任务,无需针对特定场景微调即可直接应用 。

本文将从技术原理出发,结合共绩科技的容器化部署方案,详细解析 Whisper 的部署步骤、使用方法及参数调优技巧,帮助开发者快速上手专业级语音转写服务。

1.技术基础:Whisper为什么能"听懂全世界"?

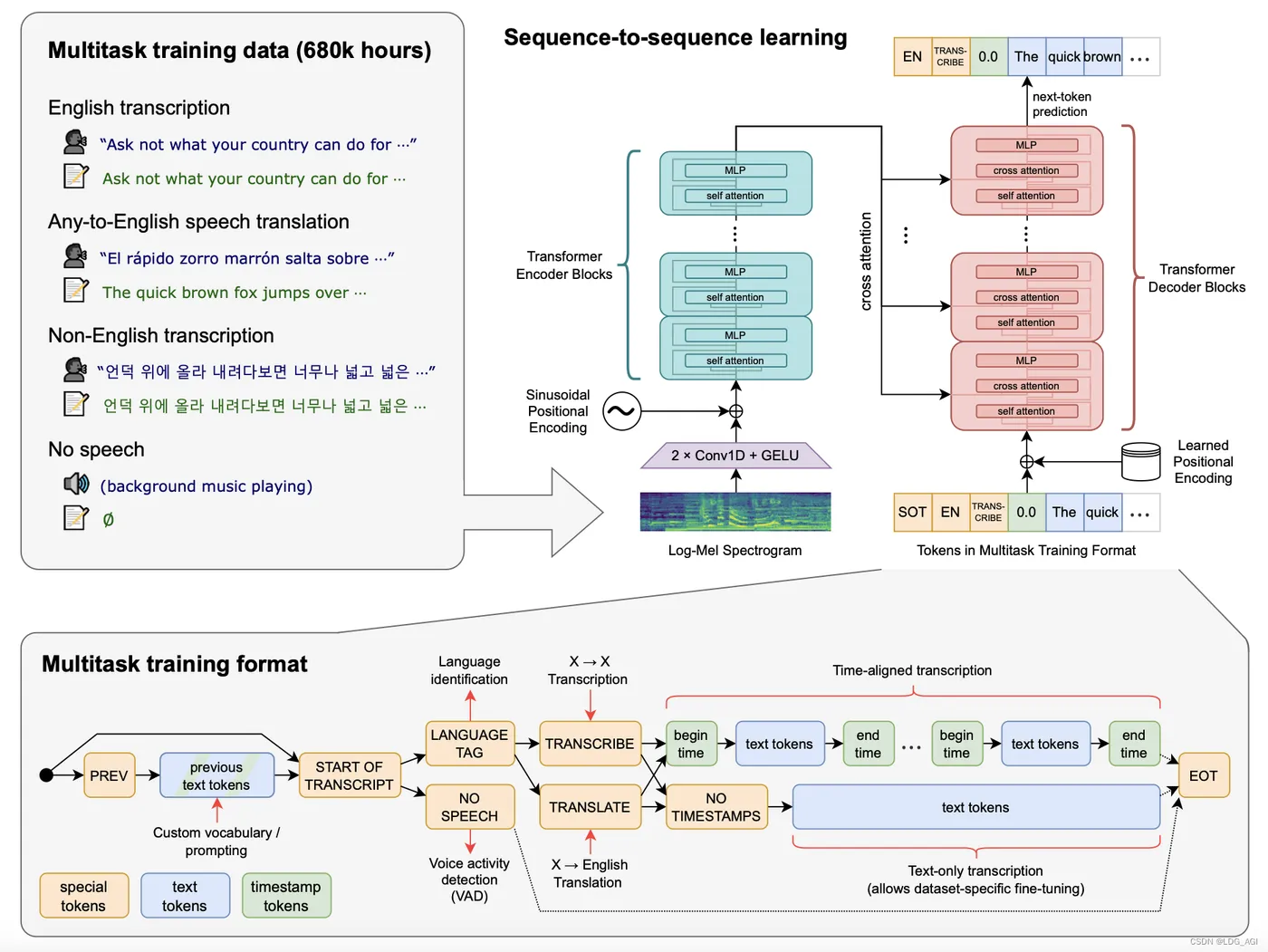

1.1 模型架构与训练数据

Whisper采用经典的 Transformer 编码器-解码器架构 ,模型参数从 Tiny(39M)到 Large(1550M)不等,适配不同场景需求。其原始版本基于 68 万小时多语言音频数据训练(含75种语言的转录数据和 21 种语言的翻译数据),而 Large-v3 模型进一步扩展至 100 万小时弱标注音频+400 万小时伪标注音频,显著提升了复杂场景下的泛化能力 。

1.2 核心创新:多任务"一站式"处理

通过在输入中加入任务标记(如转录/翻译)和对应语言标记 ,Whisper实现了多任务都可以一个接口处理:

语音识别(支持 98 种语言转录);语音翻译(任意语言转英语);语言识别(检测音频语言类型);语音活动检测(判断是否含人声)。

这种设计简化了传统多任务系统的复杂架构,开发者无需为每个任务单独调用模型 。

2.零门槛部署:共绩算力容器化方案

为降低部署门槛,共绩算力平台提供了预制 Whisper 容器镜像 ,支持快速在云端部署生产级语音识别服务。以下是详细部署步骤(适合首次接触的开发者):

2.1 部署准备

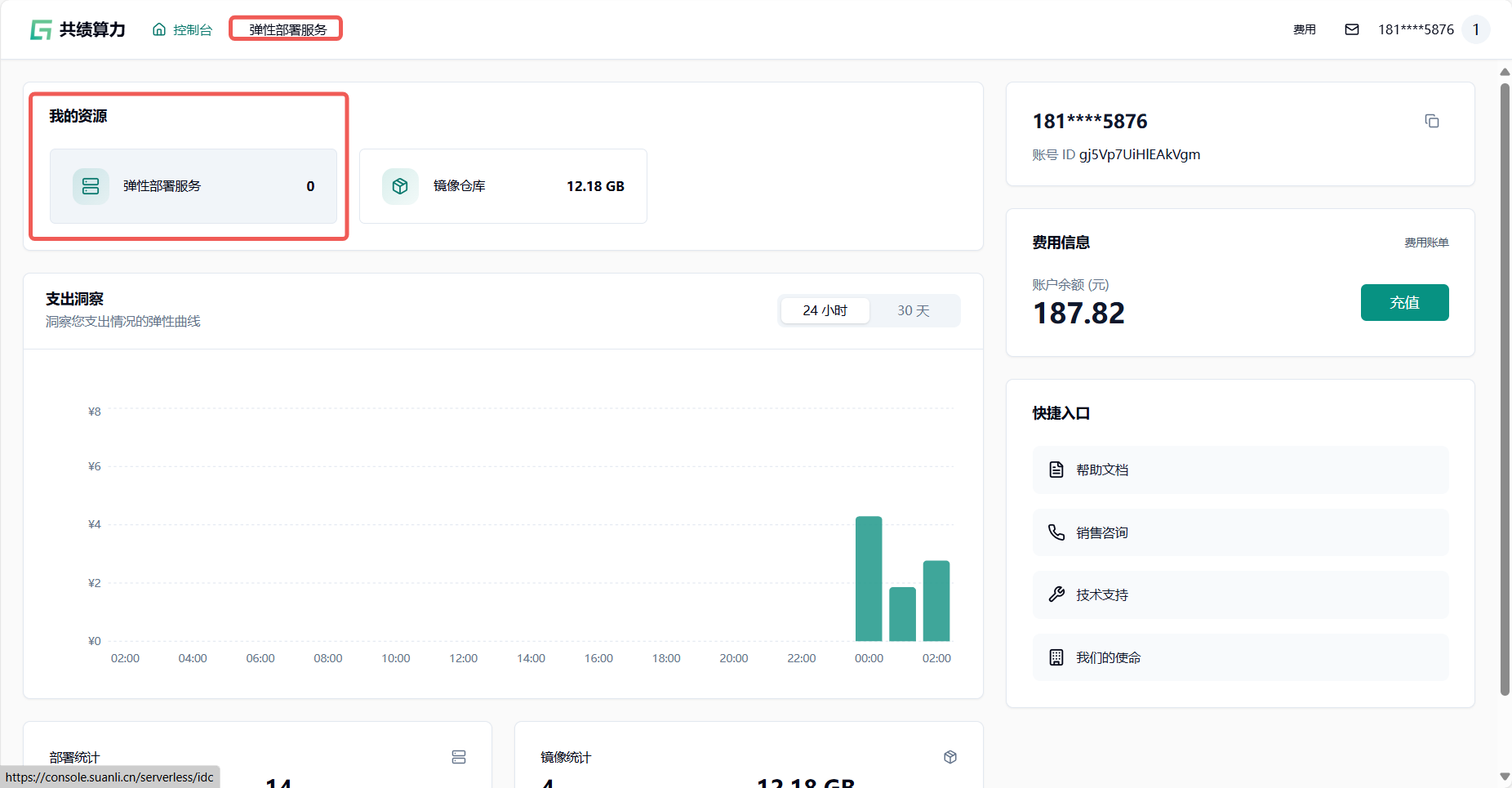

访问共绩算力控制台(https://console.suanli.cn),确保账户具备弹性部署服务权限。

2.2 部署步骤

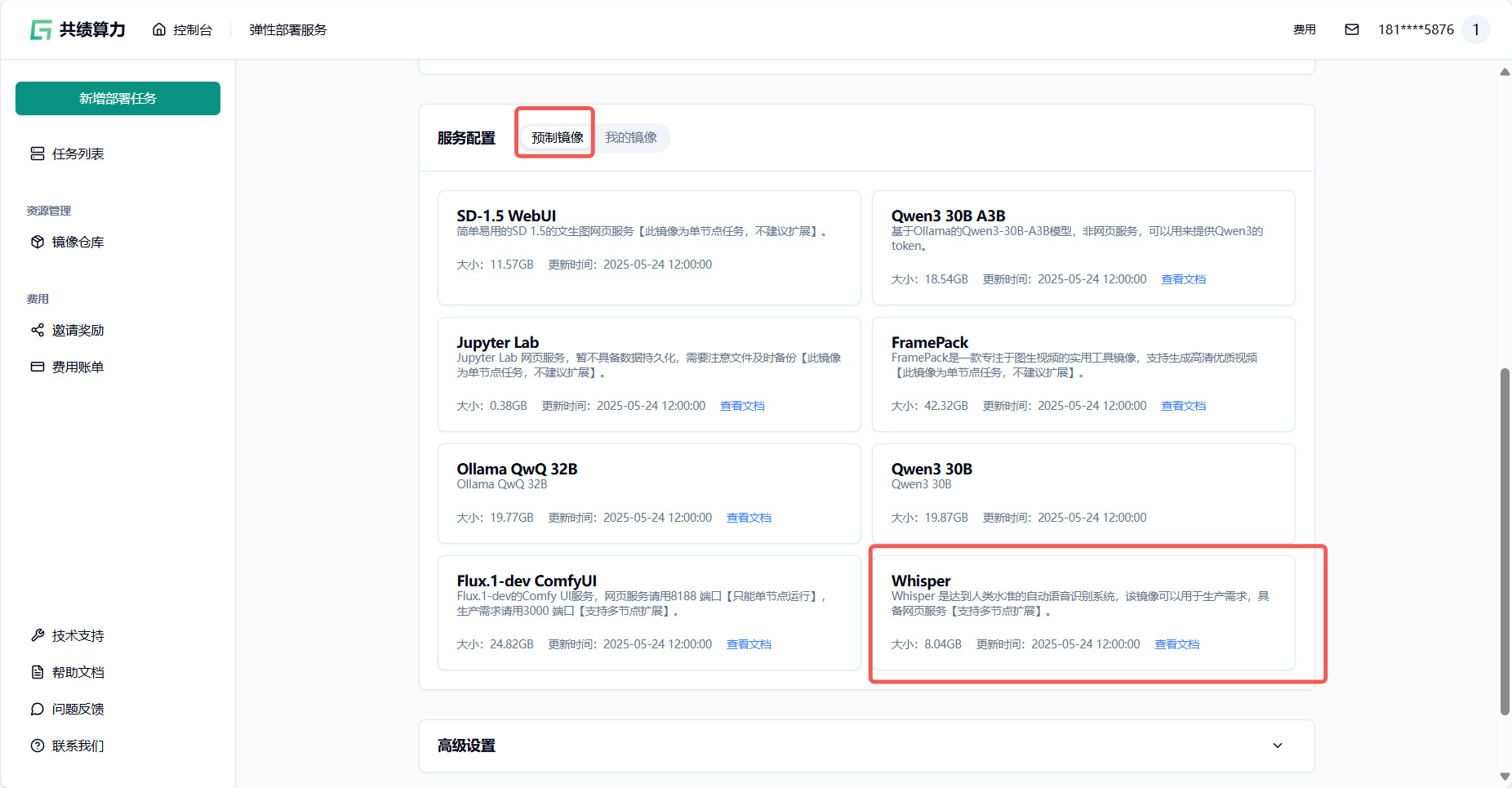

- 选择弹性部署服务 :登录控制台后,点击任意弹性部署服务进入管理页面(图1);

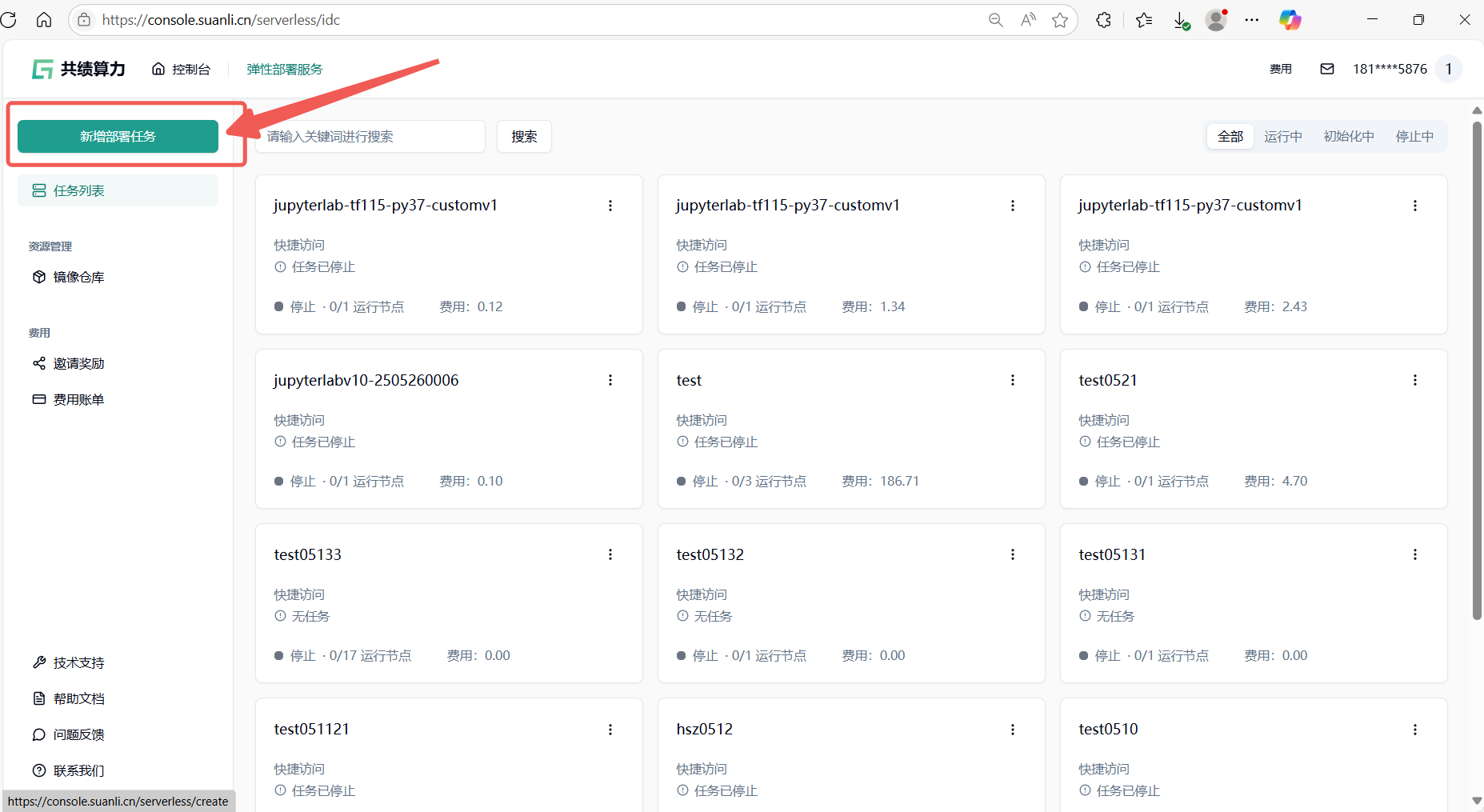

- 创建新服务 :在服务列表中点击"新增部署服务"按钮(图2);

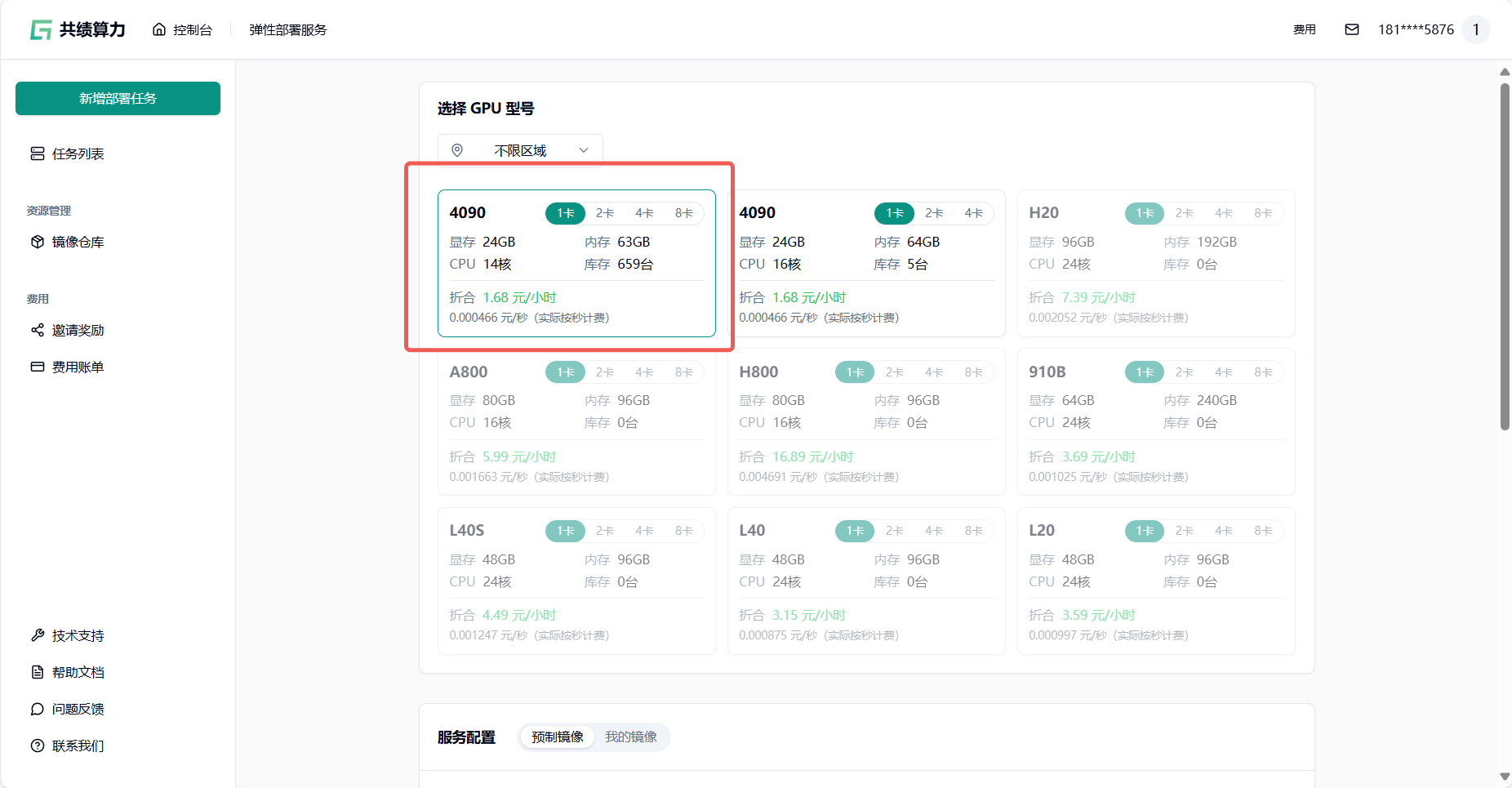

- 配置硬件资源 :参考配置为单卡4090(适合调试),可根据实际需求调整显卡型号和数量(图3);

-

选择预制镜像:在"服务配置-预制镜像"中选择共绩科技打包的 Whisper 镜像,一键启动服务(图4);

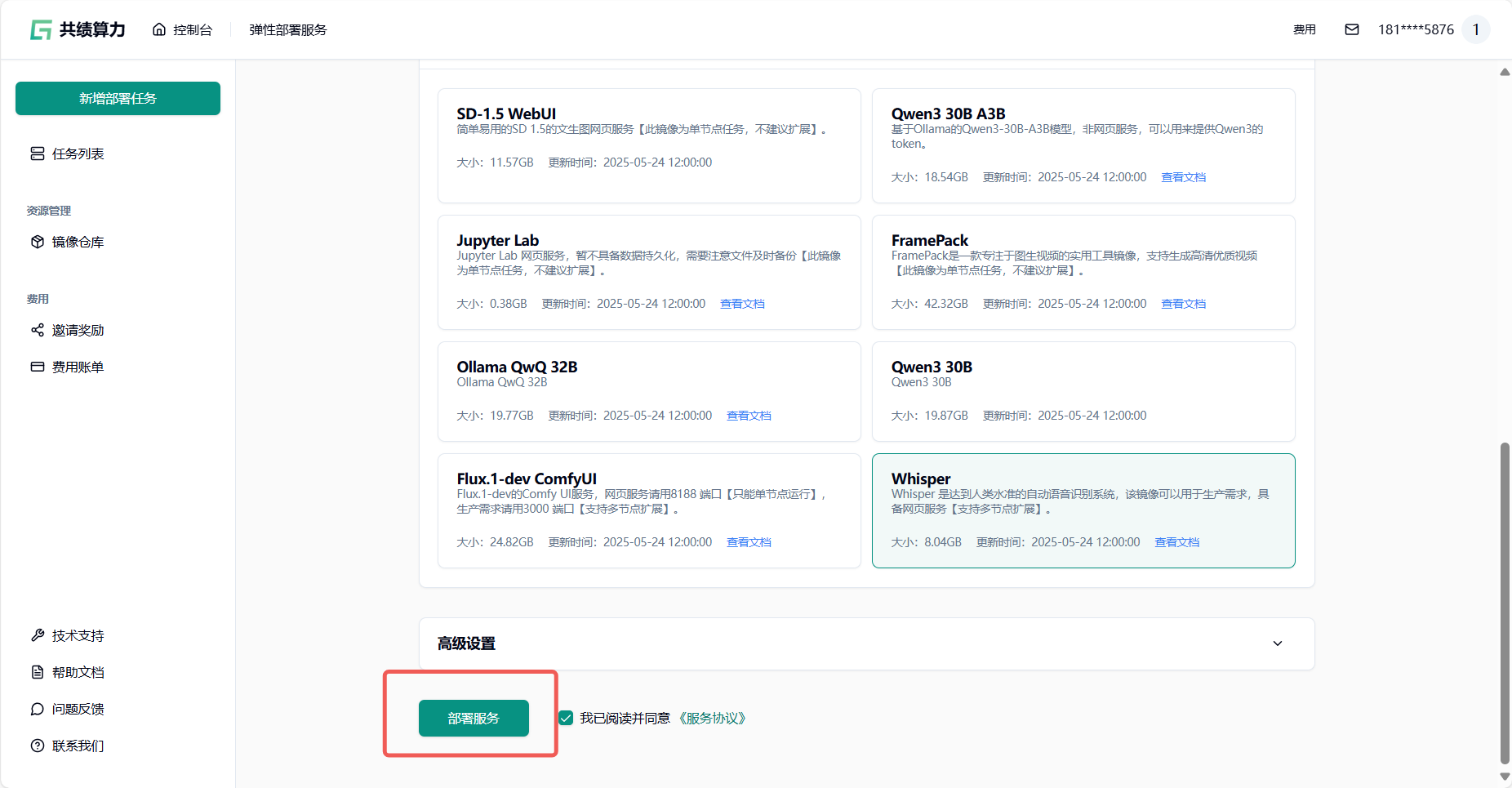

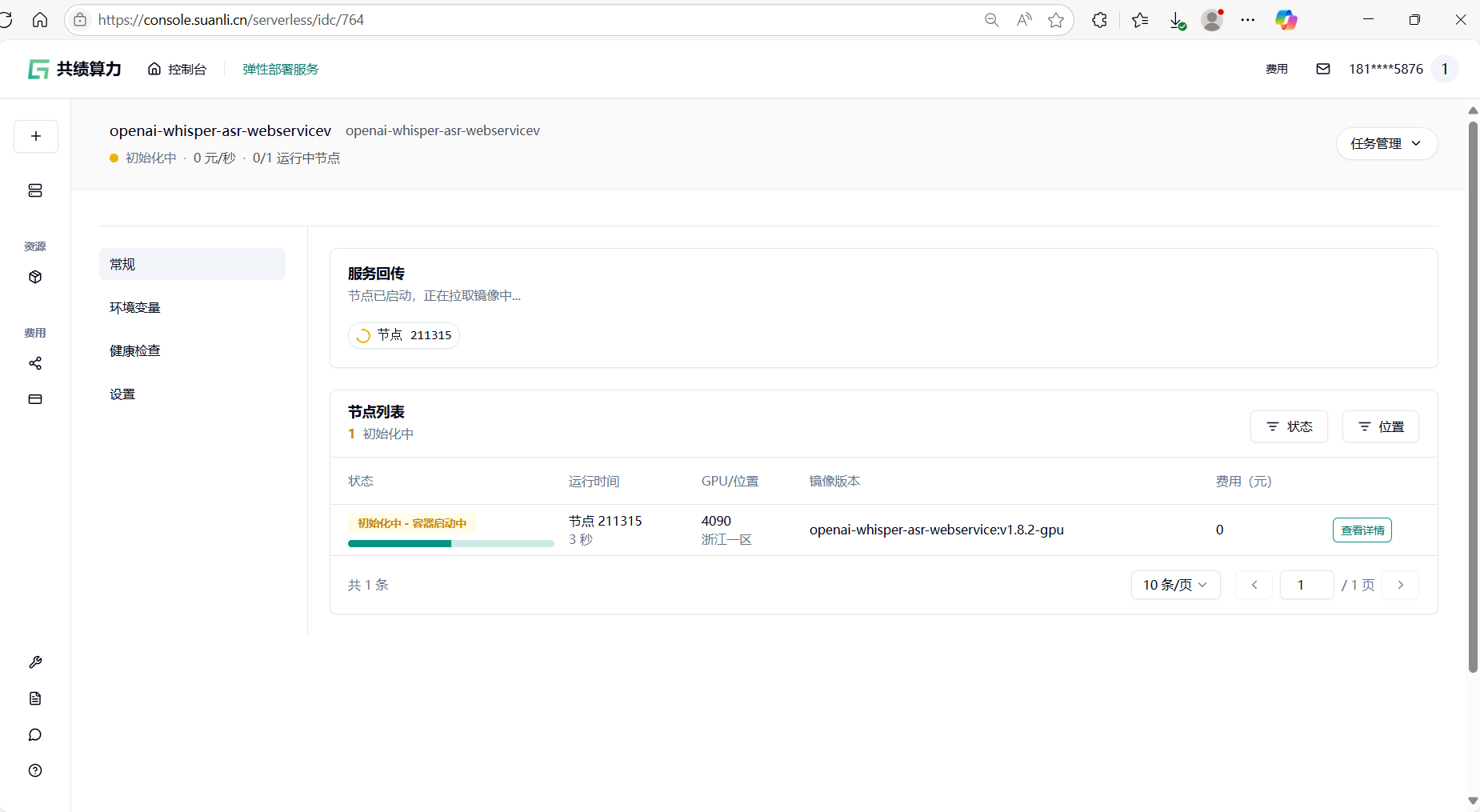

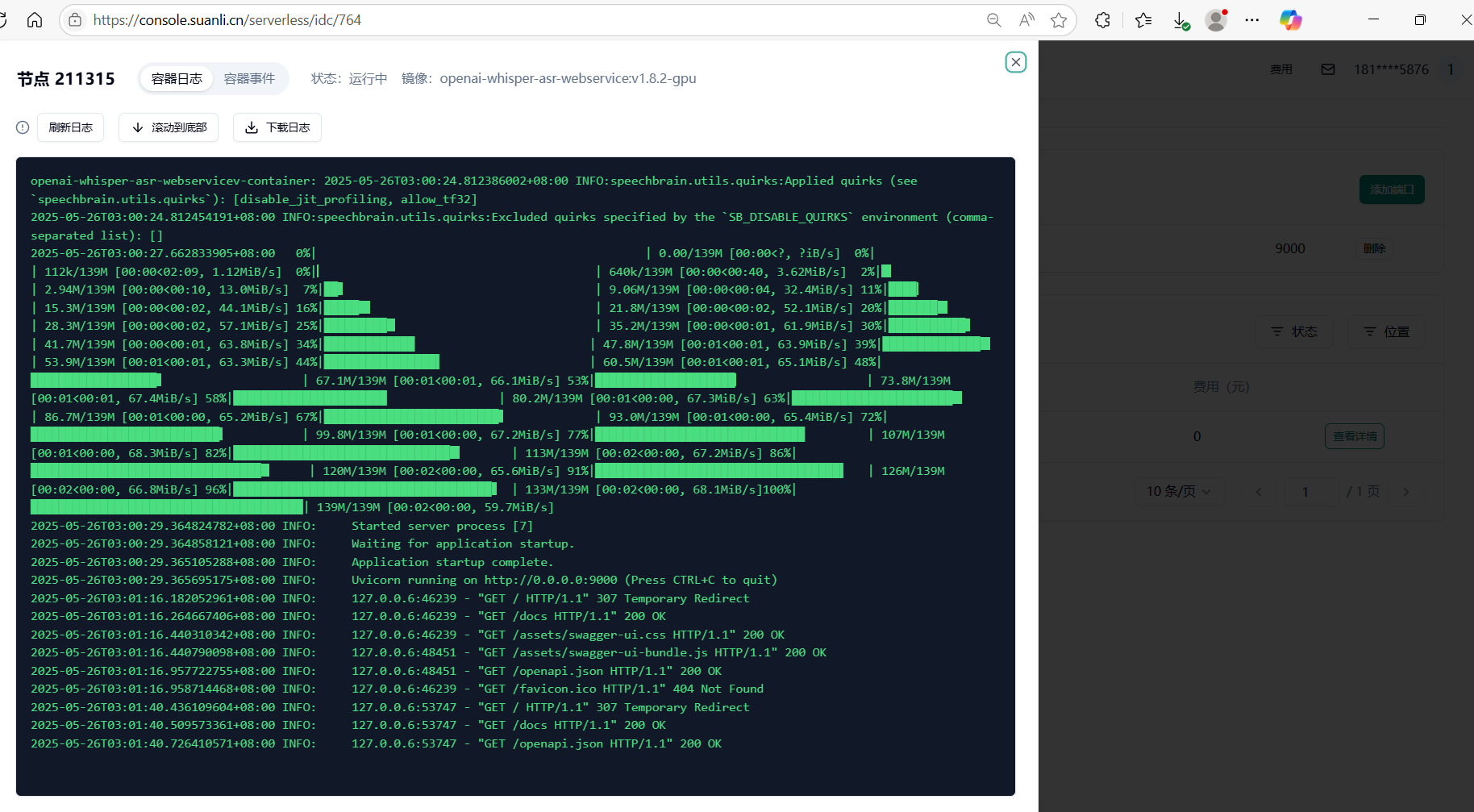

- 启动并等待加载 :点击"部署服务"后,节点将自动拉取镜像并初始化。首次启动需下载模型(约1-2分钟),可通过"节点列表-查看详情"监控容器状态(图5)(图6);

-

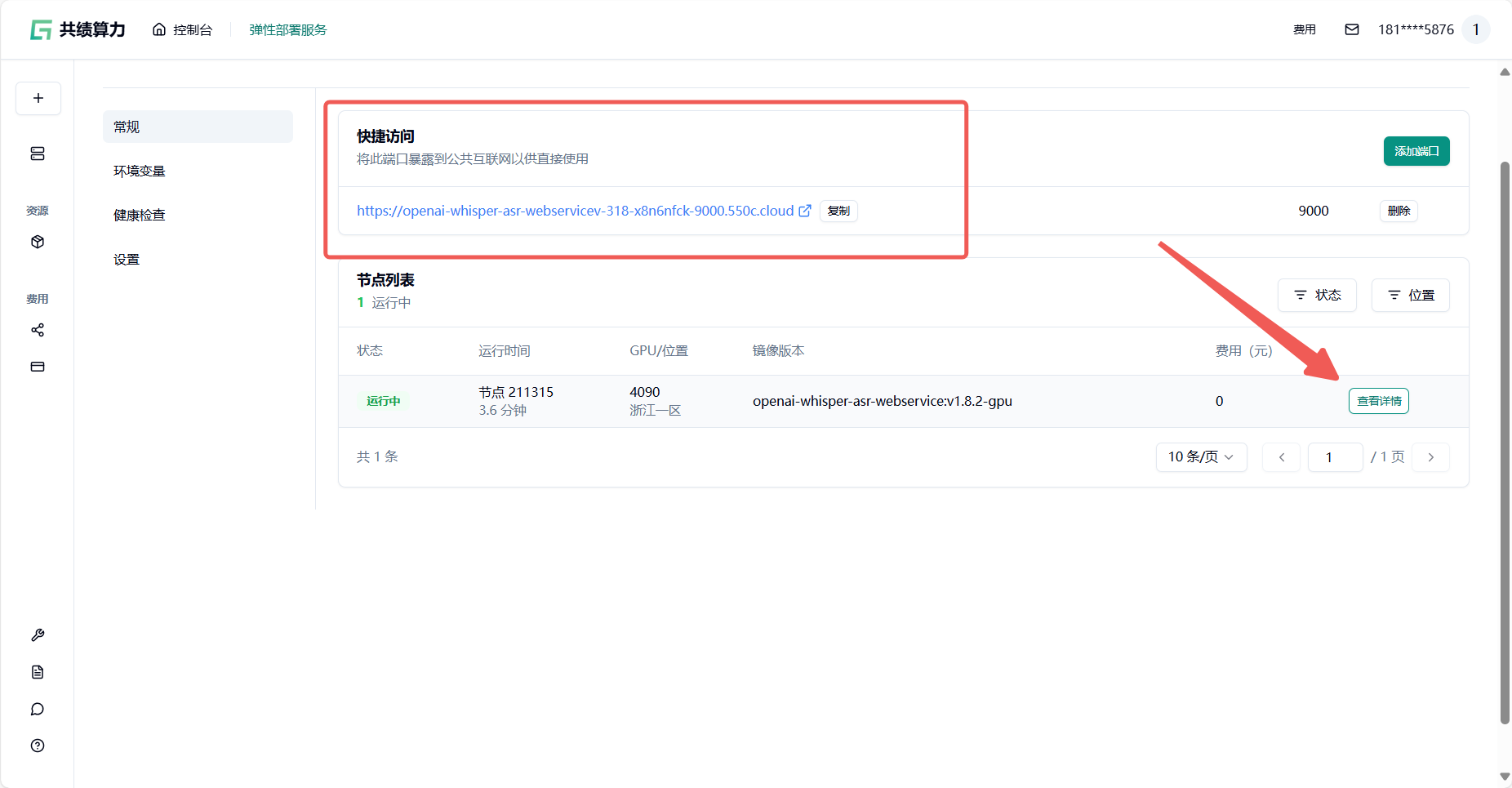

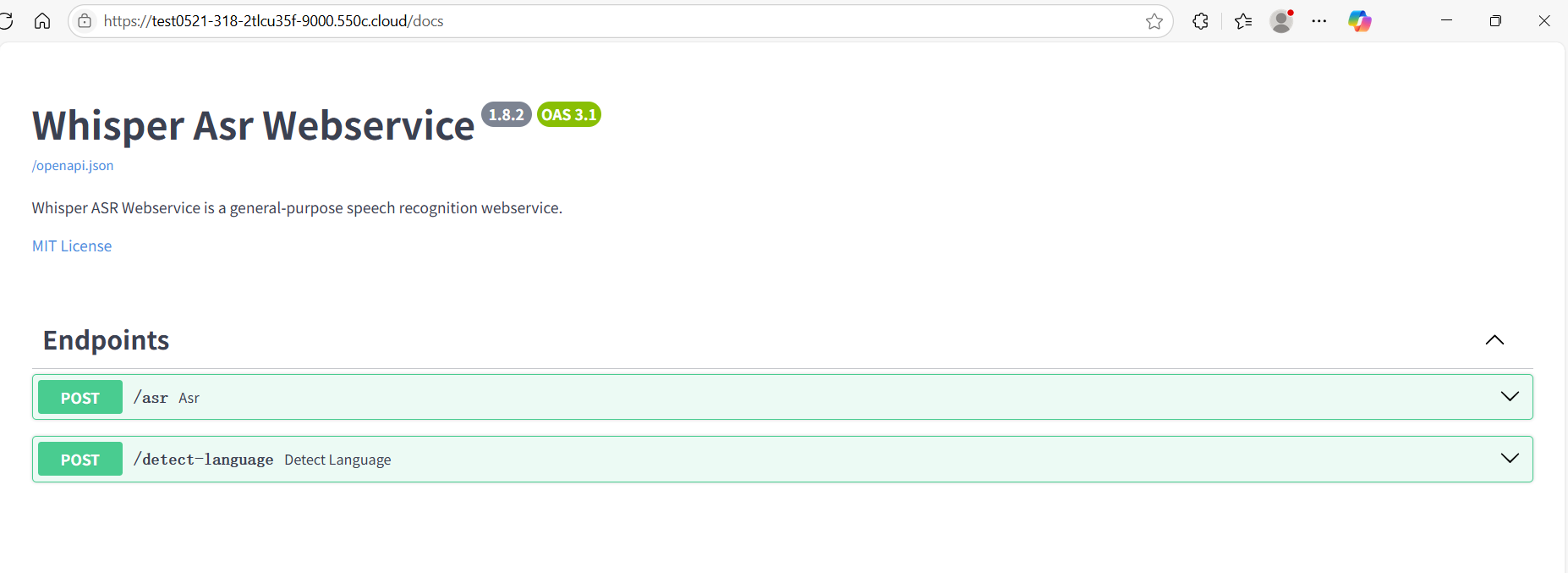

验证服务 :节点启动后,在"公开访问"中找到9000端口的公网域名链接,点击即可开始使用服务(图7)(图8)(图9)。

3.两种使用方式:API和网页服务

部署完成后,Whisper 提供 HTTP 接口 和网页服务两种使用方式,覆盖生产环境调用与普通用户操作。

3.1 生产环境:HTTP 接口调用

共绩算力 Whisper 镜像提供2个核心 API:

3.1.1 asr:语音识别接口

功能 :上传音频/视频文件,输出文本(支持转录/翻译模式)。

-

参数 :

-

language(必填):指定音频语言(如en/zh); -

file(必填):支持 MP3、WAV、MP4 等格式; -

task(选填):transcribe(转录,源语言→同语言文本)或translate(翻译,任意语言→英语文本)。

-

-

响应时间 :

| 文件大小 | 预估时间 |

|---|---|

| <10MB | 3-8秒 |

| 10-50MB | 10-25秒 |

| >50MB | 异步处理(返回任务ID) |

示例请求(CURL):

bash

curl -X POST "http://[公网域名]/asr" -H "Authorization: Bearer YOUR_API_KEY" -F "file=@test.mp3" -F "language=en" -F "task=transcribe"3.1.2 /detect-language:语言检测接口

功能 :上传文件,返回音频语言类型(仅检测,不生成文本)。

参数 :仅需 file(支持格式同上)。

响应时间 :大文件仅检测前30秒,<10MB文件约2-5秒完成 。

3.2 网页服务:可视化操作

通过9000端口的公网域名访问网页服务。

3.2.1 英文音频转文字

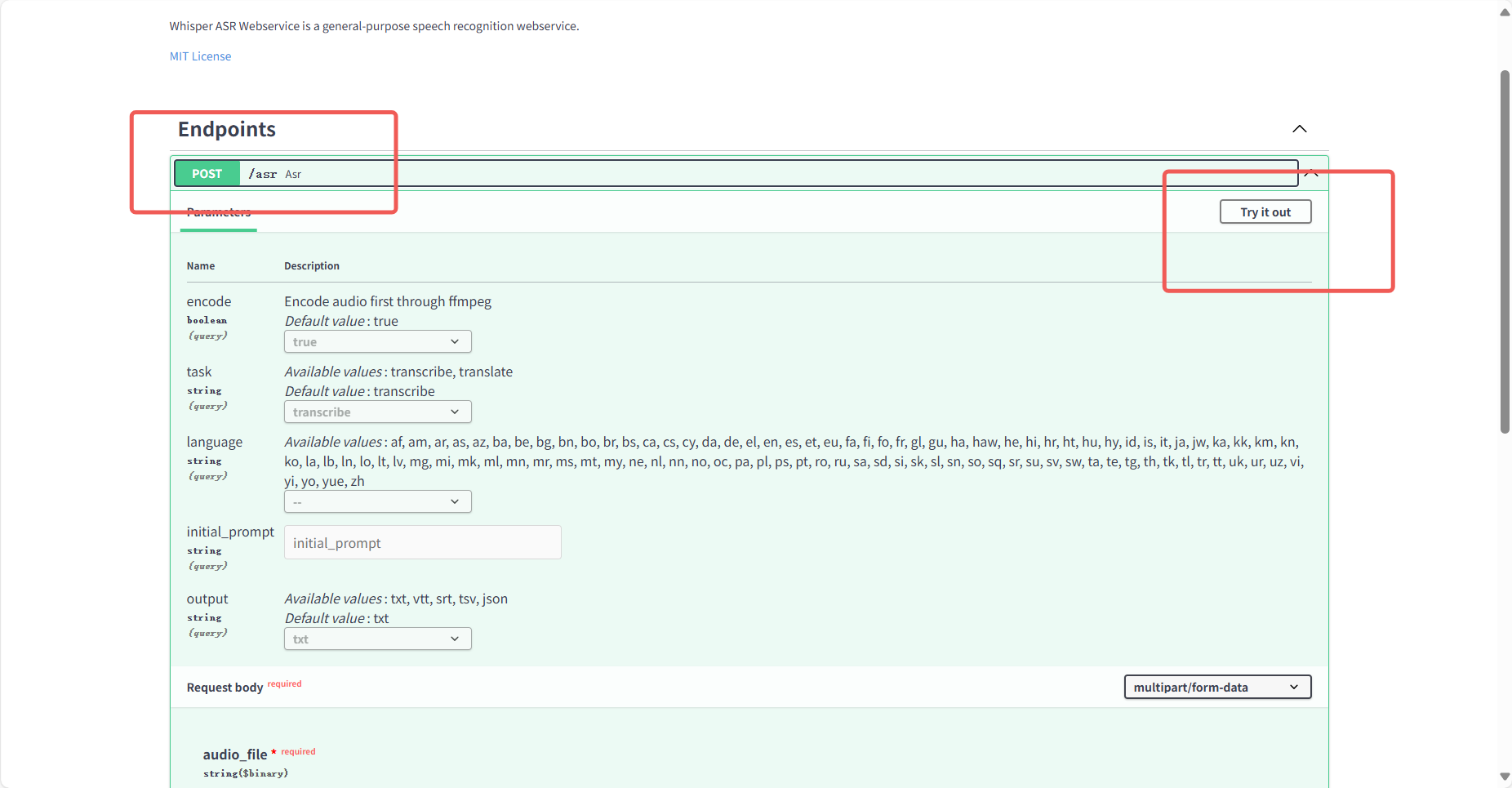

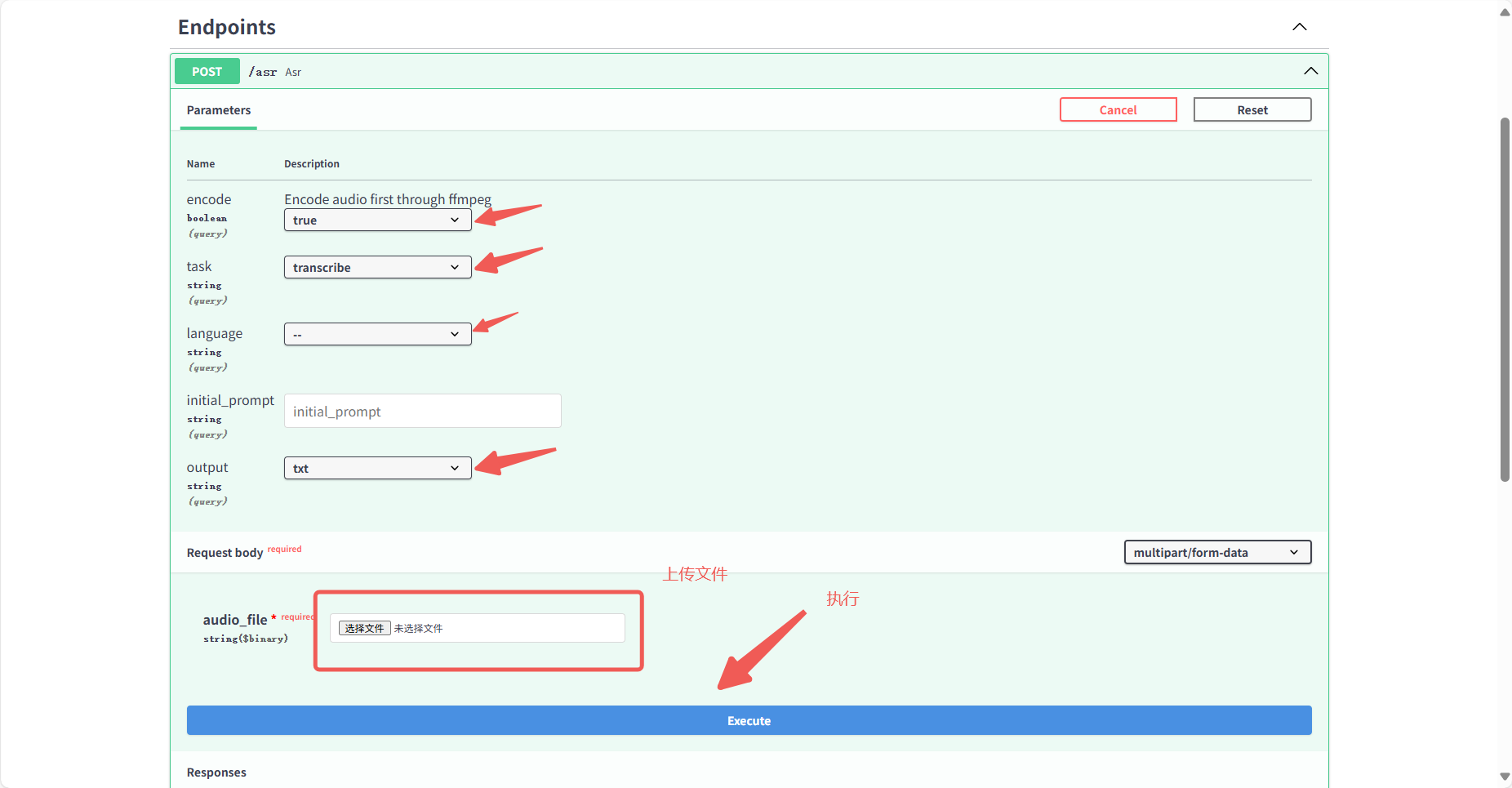

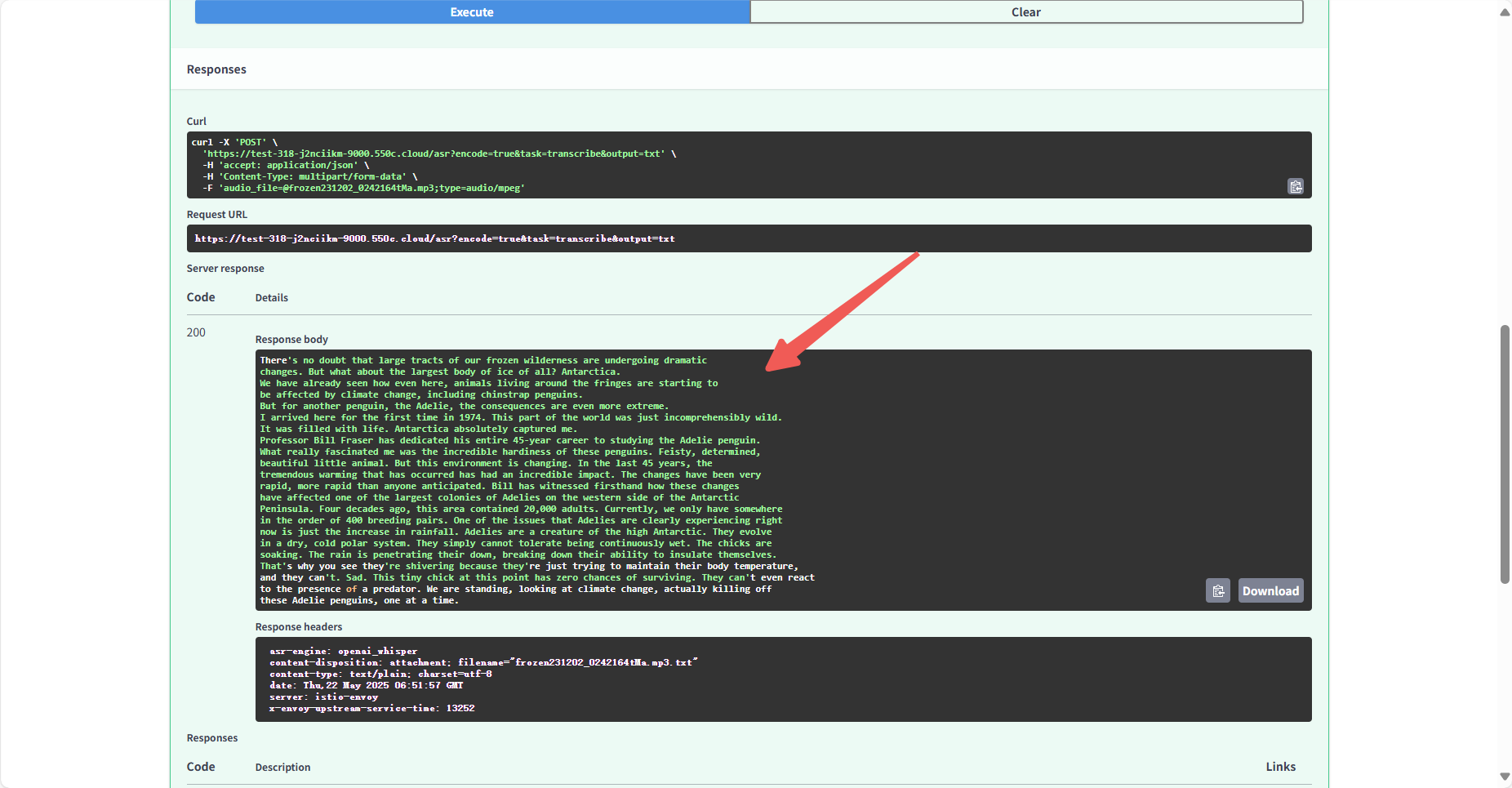

- 进入/asr接口页面,点击右上角"Try it out"(图10);

- 上传英文MP3文件(测试用例下载:https://www.gongjiyun.com/resource/frozen231202_0242164tMa.mp3),填写参数(默认

transcribe模式)(图11);

- 提交后,在"response body"查看转录结果(含词级时间戳和置信度)(图12)。

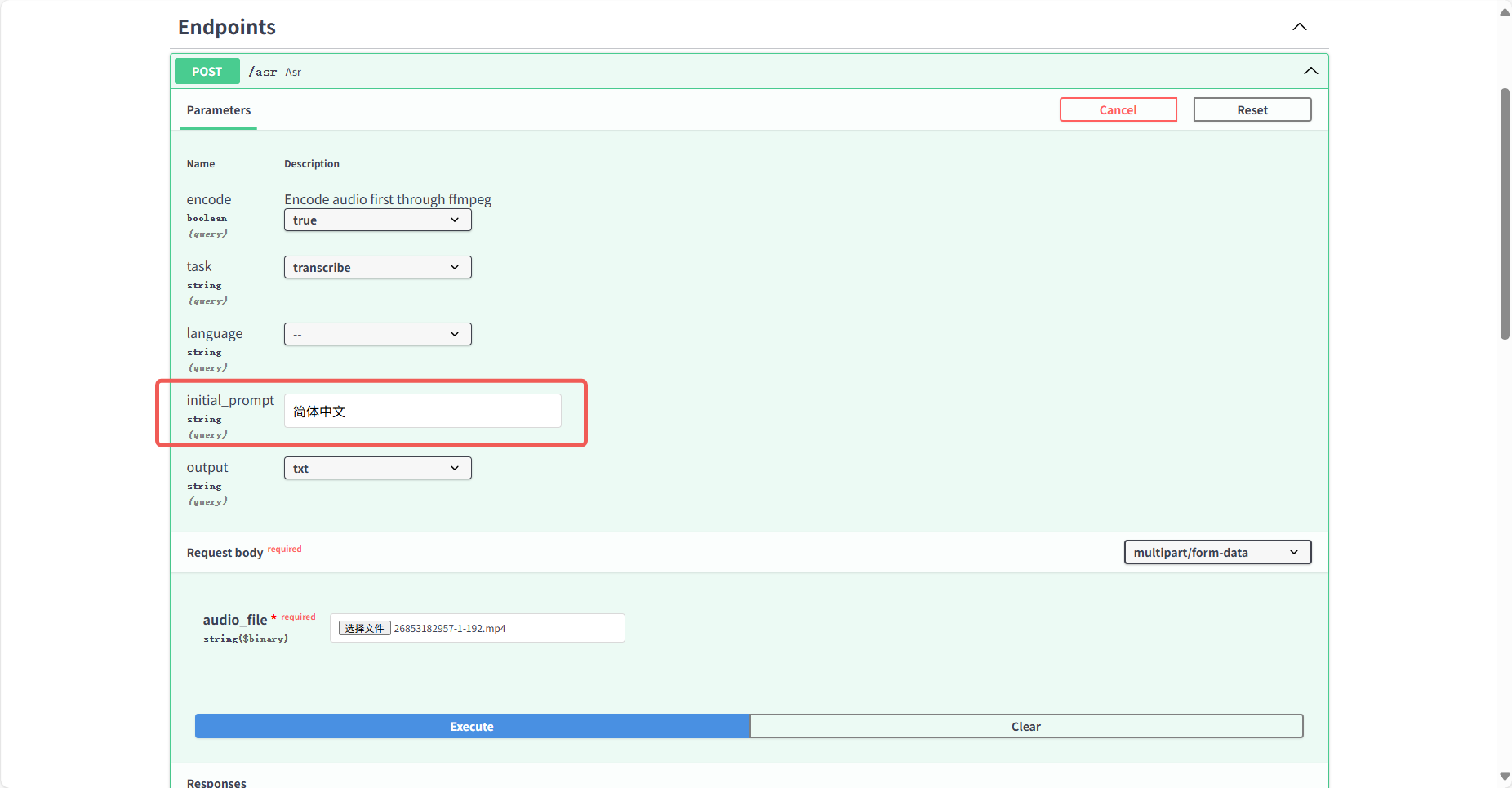

3.2.2 中文视频转文字

上传中文视频(如MP4格式),在 initial_prompt 中填写"简体中文"(默认输出繁体)(图13);

输出支持SRT、VTT等字幕格式,可直接嵌入视频。

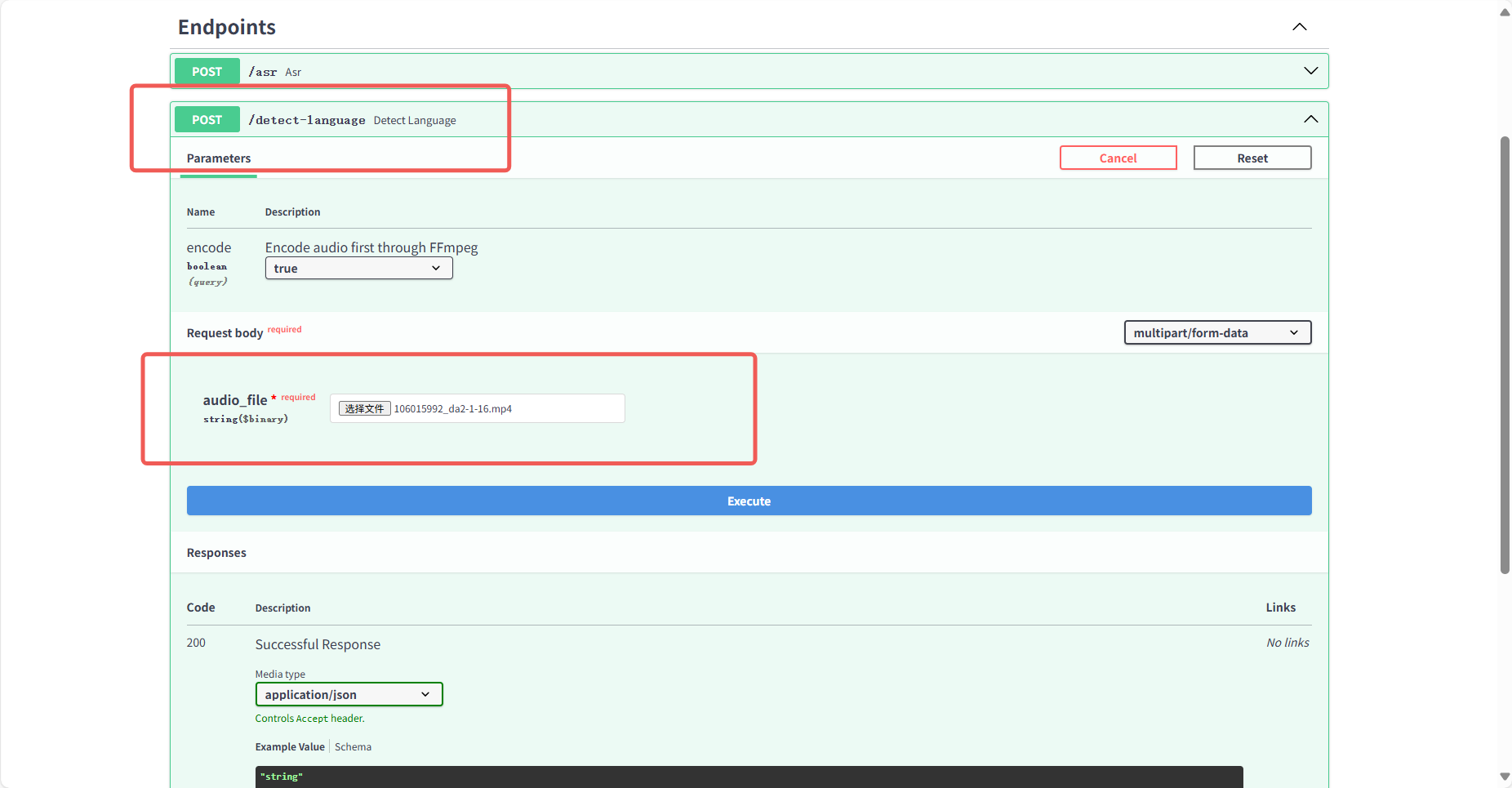

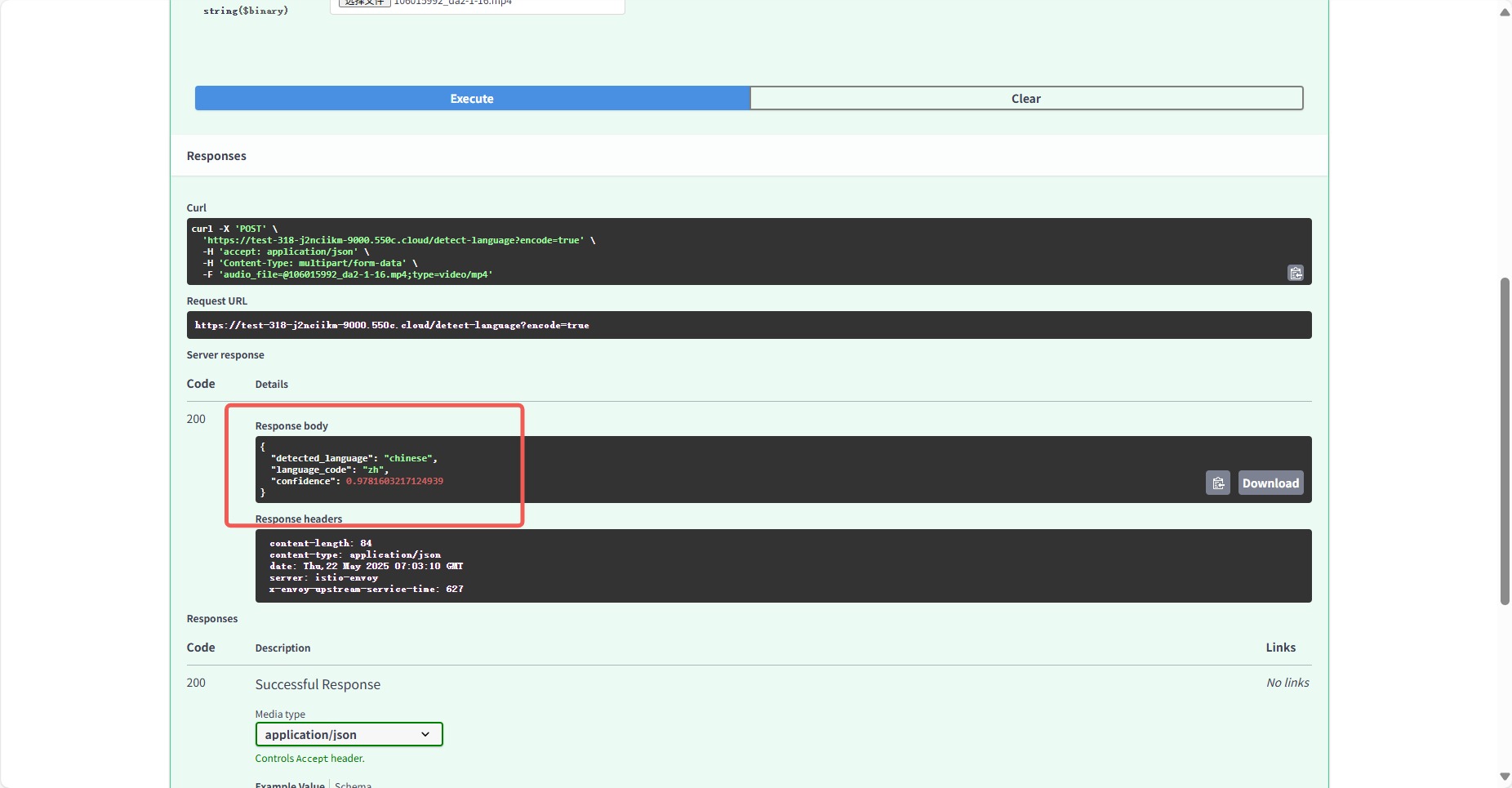

3.2.3 语言检测

选择/detect-language接口,上传文件后系统自动分析前30秒内容,返回语言类型(如 zh/ en/ es 等)(图14)(图15)。

4.参数调优:提升识别精度的关键

Whisper支持多个参数调整,可根据场景优化效果:

encode(编码预处理):始终设为 true(仅当输入为原始WAV文件时可设为 false)。

initial_prompt(上下文提示):输入领域关键词(如"人工智能、大模型"),提升专业术语识别精度;

word_timestamps(时间戳控制):控制输出是否包含词级时间标注。兼容格式 JSON(完整时间戳)、SRT(句子级分段)、TXT(无时间戳)。

output(输出格式):TXT:快速预览;SRT/VTT:视频字幕嵌入;JSON:开发者分析

5.Whisper模型语音识别最佳实践场景

5.1 内容创作与媒体制作

快速文字生成:例如短视频脚本撰写、播客内容整理,可直接通过语音转文字功能输出初稿,再进行润色。

视频字幕制作:支持输出 SRT、VTT、TXT、JSON 等格式,其中 SRT/VTT 格式可直接嵌入视频,适用于影视剪辑、课程视频等场景。

5.2 教育与学术研究

语言学习辅助:支持98种语言转录与翻译,可用于听力训练(如外语音频转文字对照学习)、课程录音整理(将教授讲座转成文字笔记)。

专业领域音频转写:通过 initial_prompt 参数输入领域关键词(如"人工智能、大模型",需用英文填写),可提升学术会议、专业讲座中术语识别精度,满足学术资料整理需求。

5.3 多语言交流与协作

多语言会议记录:支持混合语言会议转录,可强制指定主语言(如英语)提高识别准确性。

实时语言检测:通过/detect-language接口快速检测音频前30秒语言类型(如中文、英语、西班牙语等),为后续转录或翻译提供语言依据。

6.总结与展望

说实话,Whisper 在语音识别这块儿确实挺能打!多语言通吃、上手快,让它成了很多开发者搞语音处理时的"瑞士军刀" 。你想快速搭个稳定可靠的语音转文字服务?用「共绩算力」一键部署 Whisper 就搞定了,别管底下是什么服务器显卡,省心!

好奇这"语音识别瑞士军刀"到底有多利索?现在就去共绩算力控制台(https://console.suanli.cn)开箱试试,分分钟开启语音转写体验!