**路径** **篇**

从概念验证到规模运营的

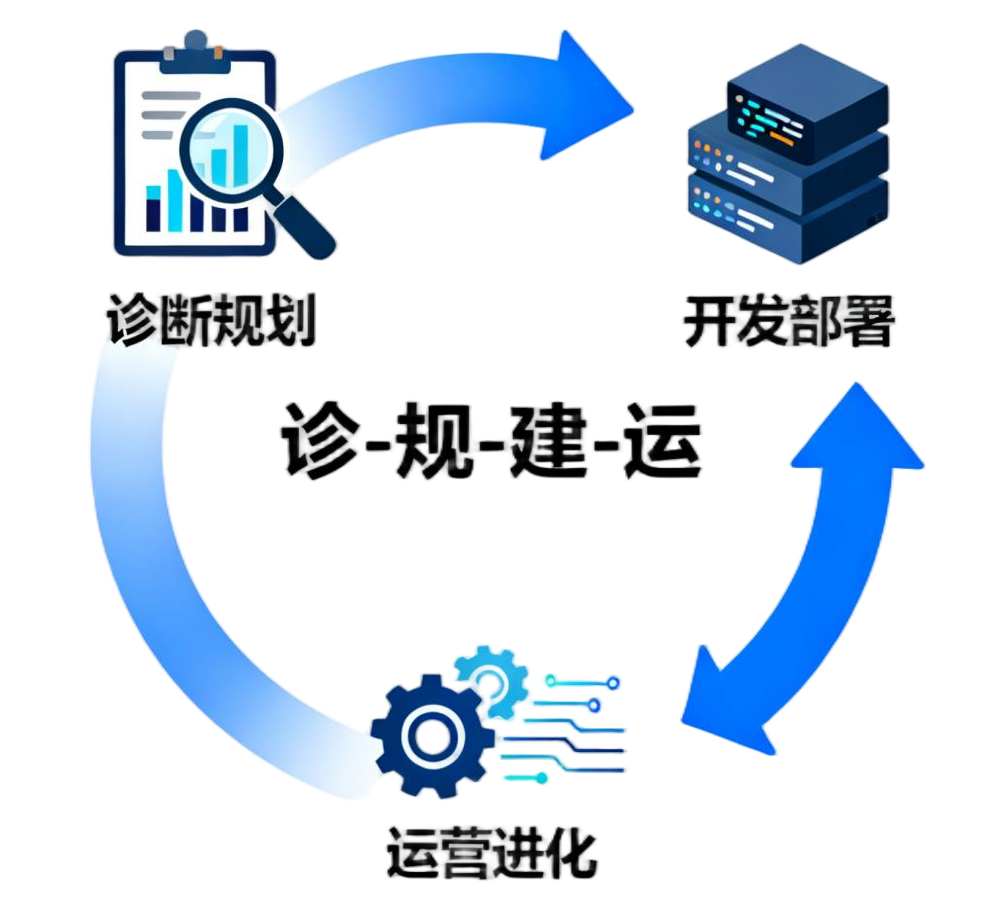

"诊---规---建---运"实施指南

在数字经济加速渗透的今天,数据空间已从"概念热点"成为企业激活数据价值的核心载体。但从抽象理念到规模化落地,企业往往陷入"不知从何入手""建设与运营脱节""投入与产出失衡"的困境。

今天,我们拆解"诊断规划、开发部署、运营进化"三阶段实施路径,用**"诊---规---建---运"闭环逻辑**,为企业提供兼具系统性与灵活性的建设路线图。

01.诊断规划期: 锚定价值,画好"施工蓝图"

数据空间建设最怕"无的放矢"------盲目堆砌技术却贴合业务需求。这一阶段核心是**"诊现状、规目标"**,完成从"模糊想法"到"清晰蓝图"的落地。

关键目标: 锁定"灯塔式"场景,构建可落地的实施基准

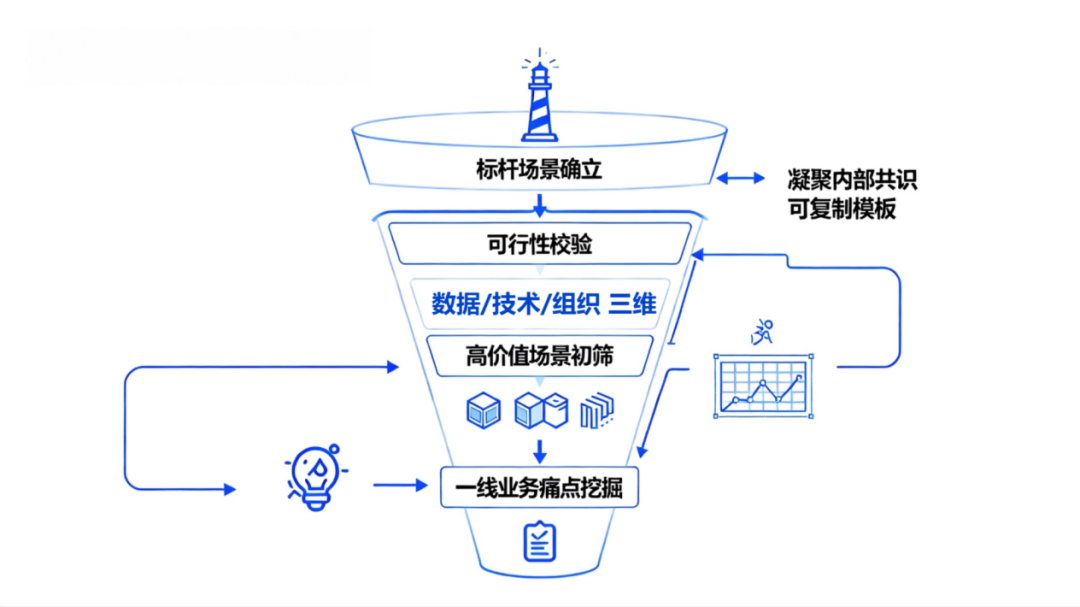

打破传统"自上而下"的宏观规划误区,从一线业务痛点中挖掘突破口,筛选出兼具高业务价值与高可行性的示范场景,为后续推广树立可复制的标杆,同时凝聚内部共识。

核心行动: 三步完成场景锚定与规划

价值场景挖掘: 聚焦业务核心痛点,建立**"价值---影响"评估矩阵**,优先选择对运营效率提升、成本结构优化或客户体验改善有直接且显著影响的场景。这类场景能快速产生可感知的成果(如流程周期缩短、资源利用率提升),为项目争取初期资源与内部支持。同时需避免选择过于宏大的"全流程改造"场景,优先聚焦单一业务环节的具体问题。

可行性评估: 构建**"数据---技术---组织"** 三维校验框架。数据层面 ,核查场景所需数据源的完整性、准确性与可获取性;技术层面 ,评估现有技术储备与外部工具的适配性,避免依赖尚未成熟的前沿技术;组织层面,考量业务团队的参与意愿与变革接受度,确保落地过程中得到充分协作。若多维度条件暂不具备,可退而选择"数据基础较好的局部场景",通过小范围验证逐步积累能力。

标杆效应设计: 从候选场景中遴 选1---2个 "灯塔式"场景 重点突破 ,明确量化目标 (如"资源利用率提升30%""故障响应时间缩短50%"),同步制定实施流程 、责任分工 与评估标准 。需确保标杆场景的解决方案具备通用性,例如数据治理流程、接口标准等可复用于后续扩展场景,形成**"试点成功---经验沉淀---规模推广"**的良性循环。

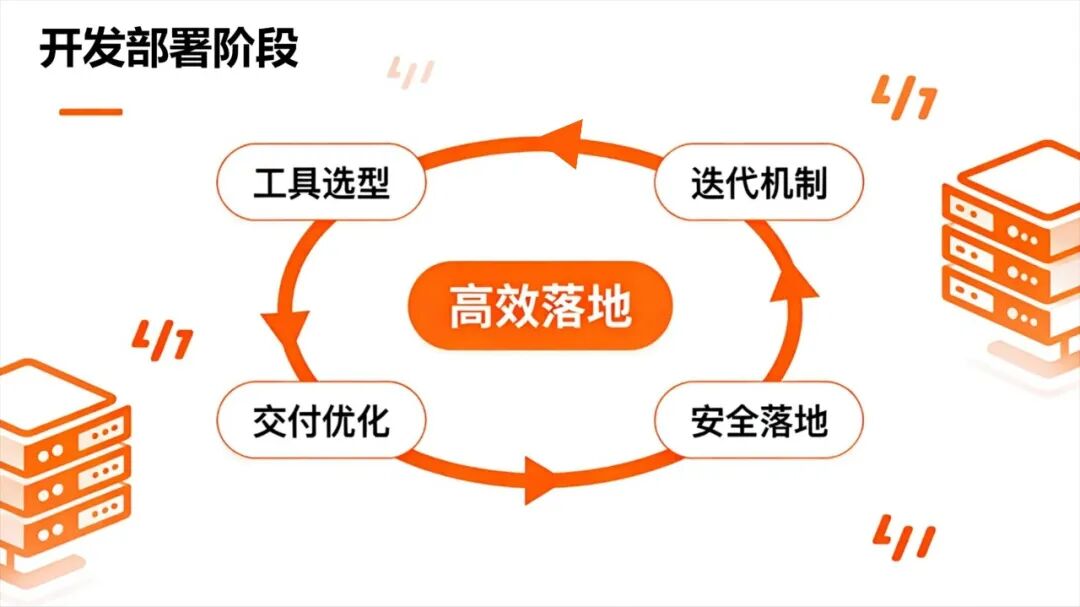

02.开发部署阶段: 高效落地,筑牢"技术底座"

如果说规划期是"画图纸",开发部署期就是"搭骨架"。这一阶段要兼顾**"效率"与"稳健"** ,用轻量化工具 和迭代式开发加速落地。

01 工具选型:选对"装备"少走弯路

拒绝盲目追求"高大上"技术,优先选择"适配性强、易上手"的工具组合:

**数据集成:**优先用低代码ETL工具(如FlinkCDC、Airbyte),降低跨系统对接难度;

**开发平台:**推荐支持"拖拽式操作"的低代码数据空间平台,减少定制化开发成

**测试工具:**搭配自动化测试工具(如TestContainers),保障数据准确性和系统稳定性。

**小技巧:**先通过免费试用或POC(概念验证)验证工具适配性,避免后期返工。

02 快速迭代:用"MVP思维"跑通闭环

借鉴互联网产品"最小可行产品"逻辑,先搭"简化版"数据空间:

**第一版聚焦"核心功能":**如试点场景的数据采集、清洗和基础可视化,暂不追求复杂的权限管控或高级分析;

**每周迭代优化:**联合业务团队做"小步测试",收集反馈快速调整(例:根据销售团队需求,新增区域数据对比模块);

**试点验证:**在小范围业务场景中试运行1---2个月,验证数据准确性、系统响应速度等指标,达标后再扩容。

03 灰度发布:降低规模化风险

从试点到全面上线,需通过"灰度发布"平稳过渡:

**分批次推广:**先开放给IT团队和核心业务骨干,再逐步扩大至全部门;

**数据双轨运行:**初期保留原有工作模式,与数据空间并行使用,对比结果确保无误后再切换;

**实时监控:**部署运维监控工具,跟踪系统负载、数据同步延迟等指标,出现问题立即回滚。

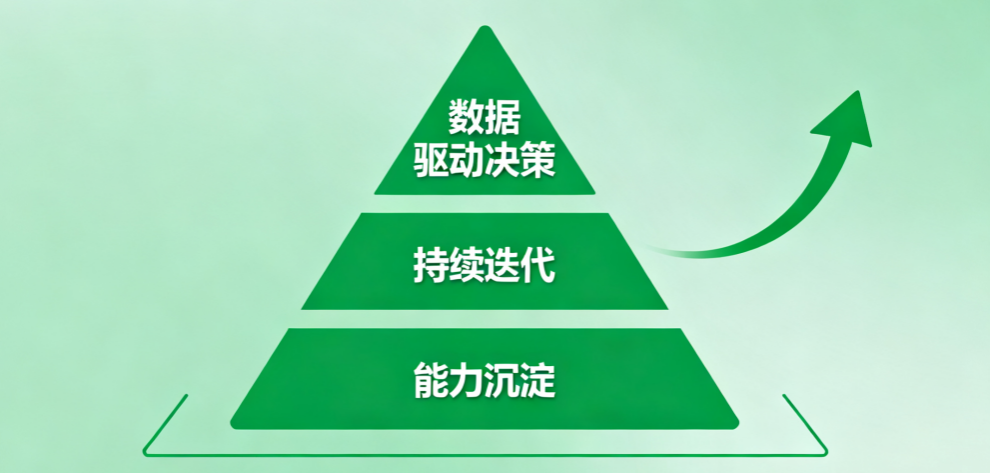

03.运营进化期: 数据驱动,实现"持续生长"

数据空间不是"一建了之"的工程,而是"持续进化"的生命体。运营期核心是**"用数据、促迭代"**,让数据空间真正融入业务流程。

01 数据驱动决策:从"有数据"到"用数据"

推动业务团队养成"数据化思维",关键做好两件事:

**轻量化赋能:**将场景化数据报表、分析工具嵌入业务系统(如:把库存预警数据直接推送到采购人员工作台),减少使用门槛;

**建立反馈机制:**每月召开"数据价值复盘会",由业务团队分享数据使用案例(例:通过数据空间发现华东区域经销商补货滞后,及时调整发货计划),反向推动工具优化。

02 持续迭代:跟着业务"动态升级"

业务需求在变,数据空间也要"常更常新":

**定期更新数据资产:**新增业务系统数据接入、淘汰冗余数据,保障数据"鲜活度";

**优化技术能力:**根据业务增长扩容资源,引入AI分析、隐私计算等新技术(例:当跨企业数据协同需求增加时,适配联邦学习工具);

**拓展场景边界:**从初期的"内部效率提升"延伸至"外部价值创造"(如:向合作伙伴开放合规数据接口,打造数据服务生态)。

03 能力沉淀:从"项目制"到"常态化"

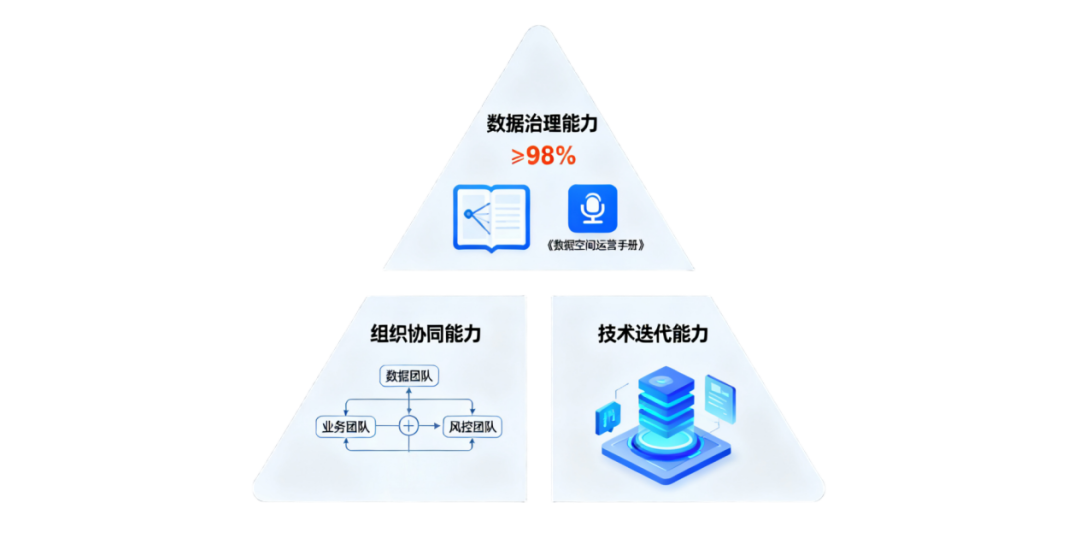

要让数据空间持续创造价值,需沉淀三类能力:

**数据治理能力:**建立数据质量考核指标(如:数据准确率≥98%)、权限管理规范,形成《数据空间运营手册》;

**组织协同能力:**明确数据团队(技术支撑)、业务团队(需求提出)、风控团队(合规审核)的协同流程,避免"各自为战";

**技术迭代能力:**跟踪行业新技术(如数据空间操作系统、分布式存储),保持技术架构的灵活性。

04.结语: 从"建起来"到"用出彩"的 核心逻辑

数据空间建设从来不是"技术竞赛",而是**"业务适配战"**。

**"诊断规划找方向、开发部署抓落地、运营进化促生长"**的三阶段路径,本质是用"诊---规---建---运"闭环,解决"建什么、怎么建、如何用"的核心问题。

企业无需追求一步到位,只需锚定核心价值场景,小步快跑、快速迭代,就能让数据空间从"概念验证"走向"规模运营",真正成为激活数据价值的"加速器"。