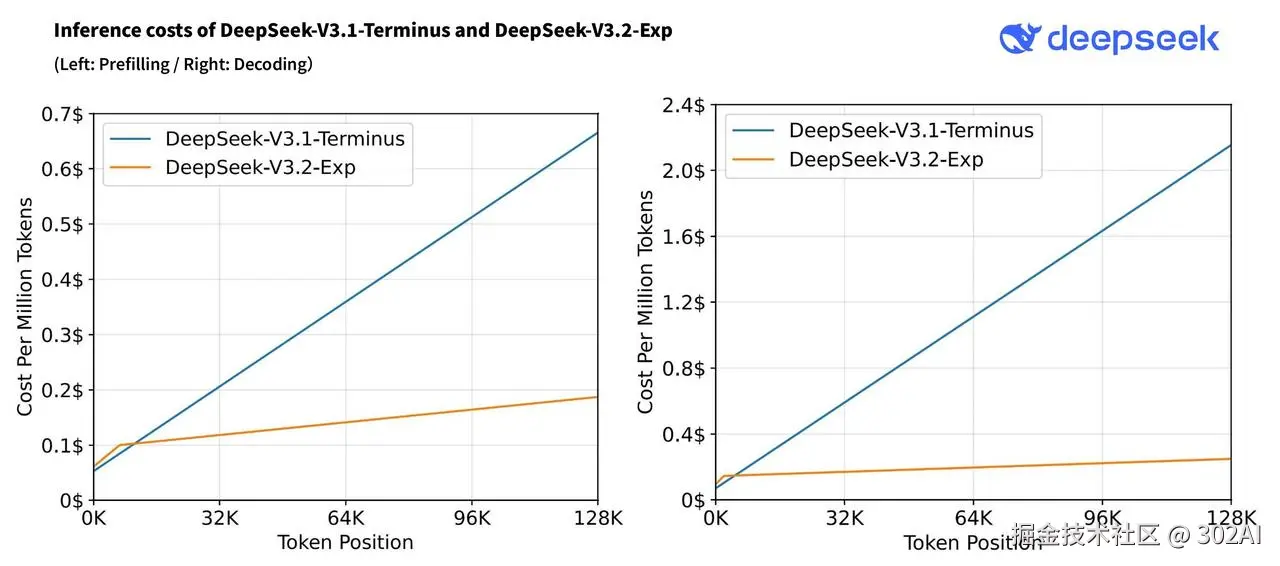

赶在各大 AI 模型"神仙打架"的国庆热潮之前,深度求索延续了节前卡点更新的惯例,于 9 月 29 日正式上线了最新的实验性模型------DeepSeek-V3.2-Exp. 该版本是针对企业场景优化的实验性模型,参数规模约为 685B,在 V3.1-Terminus 的基础上引入了 DeepSeek Sparse Attention(一种稀疏注意力机制),针对长文本的训练和推理效率进行了探索性的优化和验证。

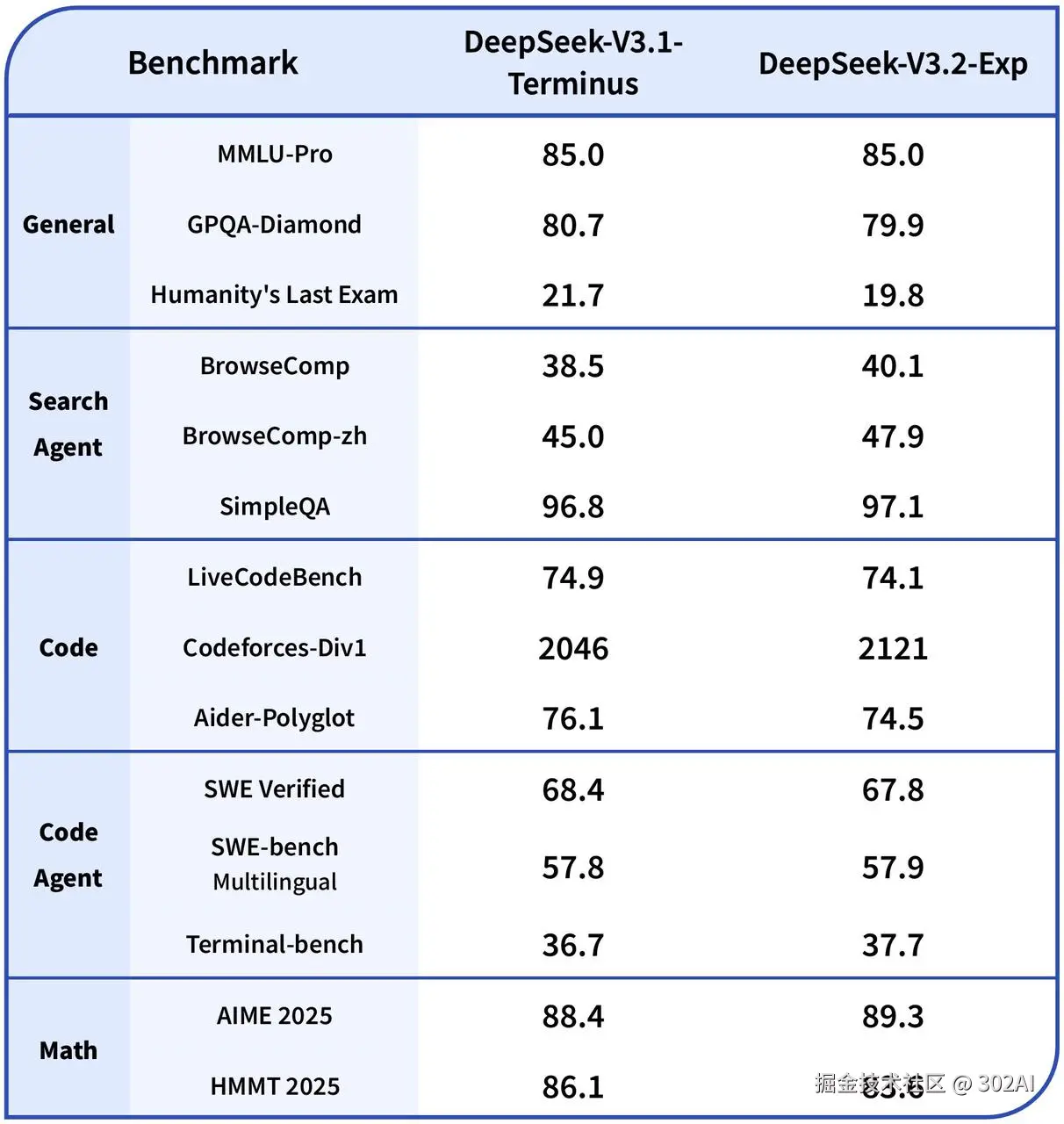

从官方发布的基准测试结果来看,V3.2-Exp 的整体性能与 V3.1-Terminus 基本持平,比较亮眼的部分在于 V3.2 在长文本处理方面的表现显著提升。华为云部署版本最高可支持 160K tokens 的上下文长度,约等于 20 万至 24 万个汉字,相当于可以一次性处理一本《百年孤独》这样的长篇小说。

这一进步归功于其技术层面的重要升级------DeepSeek-V3.2-Exp 首次实现了粒度稀疏注意力机制(DeepSeek Sparse Attention)。在几乎不影响模型输出效果的前提下,实现了长文本训练和推理效率的大幅提升。通俗来说,就是模型在处理长文本时不再平均消耗算力,而是学会了"抓住重点",将注意力精准聚焦于关键信息,从而实现算力节约与推理加速。

此外,正是得益于这一技术升级,V3.2 的 API 调用成本也大幅下降。在缓存命中的情况下,输入价格降至 0.2元/百万Token,输出价格则由原来的 12元/百万Token 降至 3元/百万Token,相当于直接打了一个 25 折,这对开发者而言无疑是一个巨大鼓舞。

核心技术特性综述:

- 基础架构:基于 V3.1-Terminus 构建,参数规模 685B

- 创新机制:首次实现细粒度稀疏注意力,突破传统 Transformer 架构限制

- 效率提升:在长文本处理场景中显著降低计算成本和内存使用

- 质量保证:输出质量与 V3.1-Terminus 几乎完全一致

302.AI 现已接入 DeepSeek-V3.2-Exp 模型,用户可以灵活调用其 API 或在聊天机器人中直接体验。为更直观地展示 V3.2 的性能特点,本文将使用前代模型 DeepSeek-V3.1 与新版 V3.2-Exp 进行多维度对比测评,关注在数据、训练配置等保持一致的前提下,新增的 DeepSeek 稀疏注意力(DSA) 机制到底带来了多大的性能变化及成本优势。

I. 实测案例

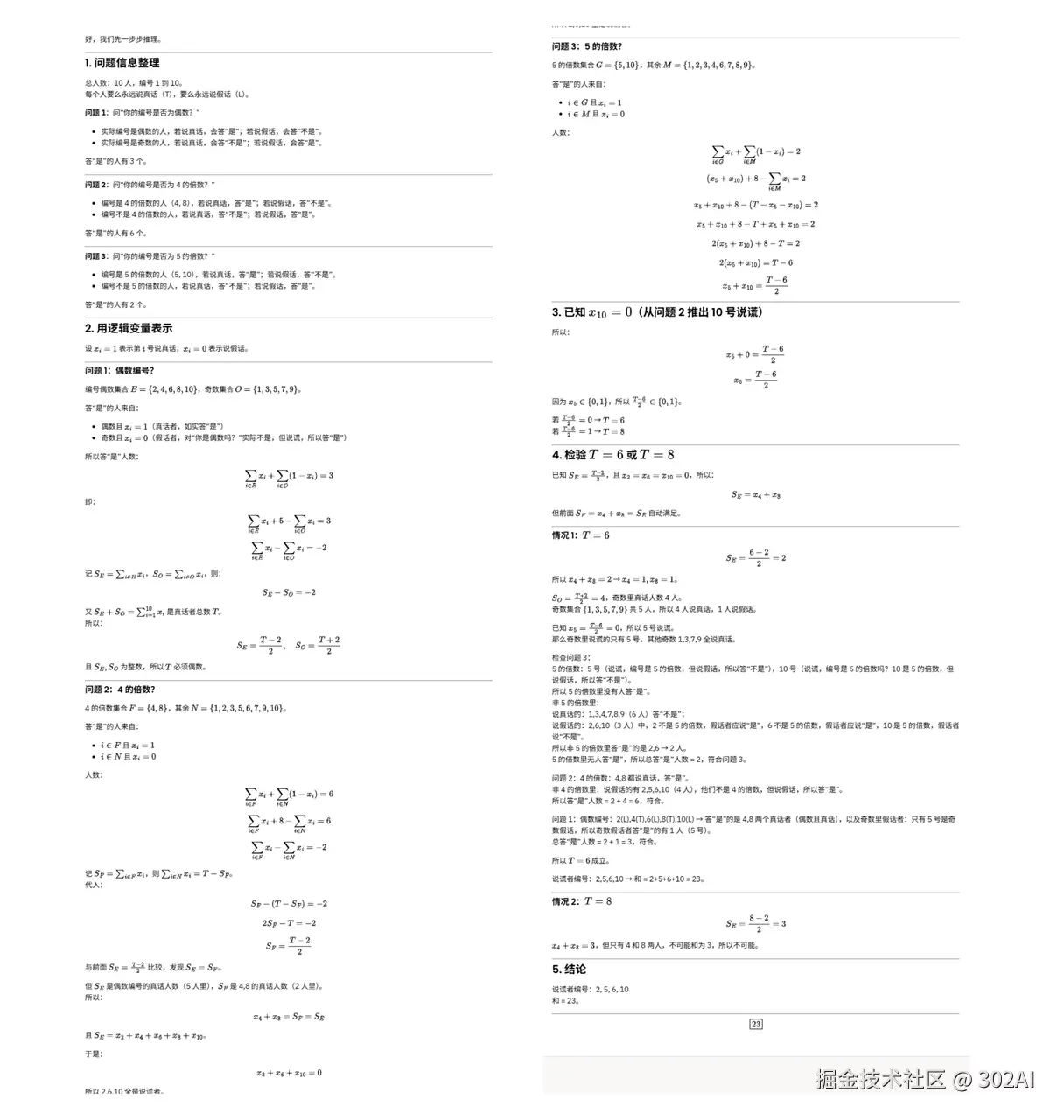

实测 1:逻辑推理

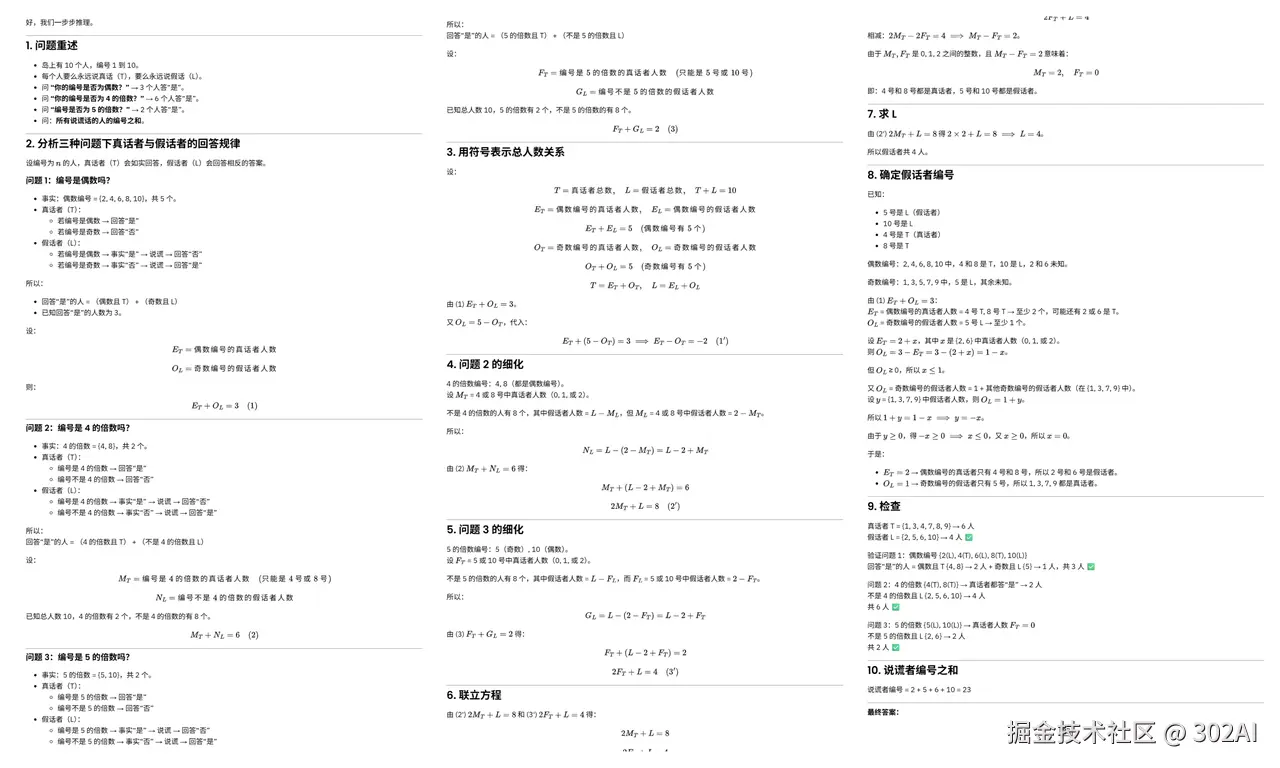

提示词:在一个小岛上共住了10个人,将他们分别编号为1号、2号、......、10号,每个人要么永远说真话,要么永远说假话。 如果问他们:"你的编号是否为偶数?" 一共有3个人答"是" 如果问他们:"你的编号是否为4的倍数?" 一共有6个人答"是" 如果问他们:"你的编号是否为5的倍数?" 一共有2个人答"是" 所有说谎话的人的编号之和为( )。

答案:23

deepseek-v3.2-exp:回答正确。

deepseek-V3.1:回答正确。

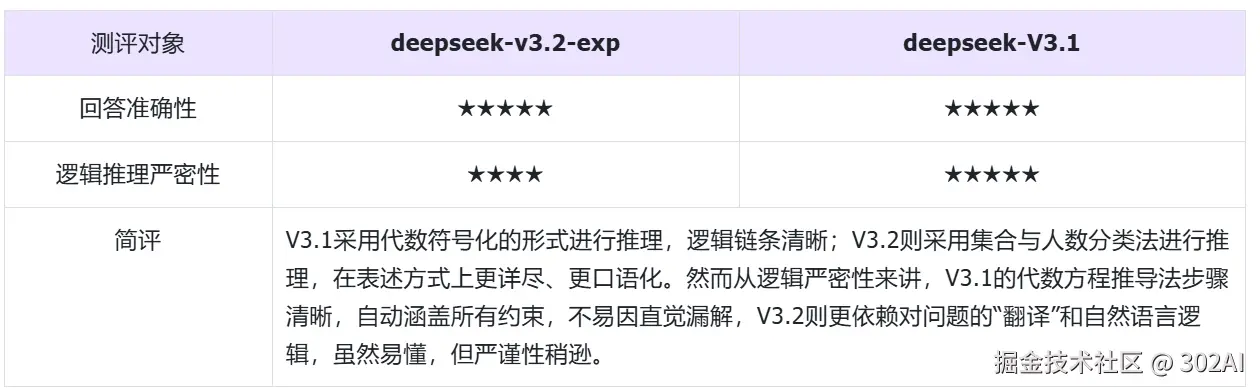

实测 2:长文本信息检索与精准提取

💡测试文档:选用美国中央情报局(CIA)解密的《世界概况》(The World Factbook)中关于"日本 (Japan)"的完整条目,共计38768个字符。我们手动在上述文档的不同章节中"植入"三个与原文基调不符、高度具体的虚构信息。

插入信息为:

- 植入信息1 (技术细节): "During a joint U.S.-Japan naval exercise in the Pacific, it was noted in a technical debrief that the primary communication satellite's backup power unit is designated as 'Project Phoenix Unit 763'." (译:在太平洋的一次美日联合海军演习中,一份技术汇报指出,主通信卫星的备用电源单元被命名为 "凤凰计划763单元"。)

- 植入信息2 (个人偏好): "In an informal biography of the current Minister of Economy, Trade and Industry, it is mentioned that his favorite type of tea is a rare blend of Genmaicha with a hint of yuzu." (译:在一份现任经济产业大臣的非正式传记中提到,他最喜欢的茶是一种罕见的、带有淡淡柚子味的玄米茶。)

- 植入信息3 (精确数字): "An internal audit of the national high-speed rail network (Shinkansen) revealed that the optimal track alignment tolerance for the new L0 Series maglev train is precisely 0.052 millimeters." (译:一份对国家高速铁路网络(新干线)的内部审计显示,新型L0系列磁悬浮列车的最佳轨道对齐公差精确到 0.052毫米。)

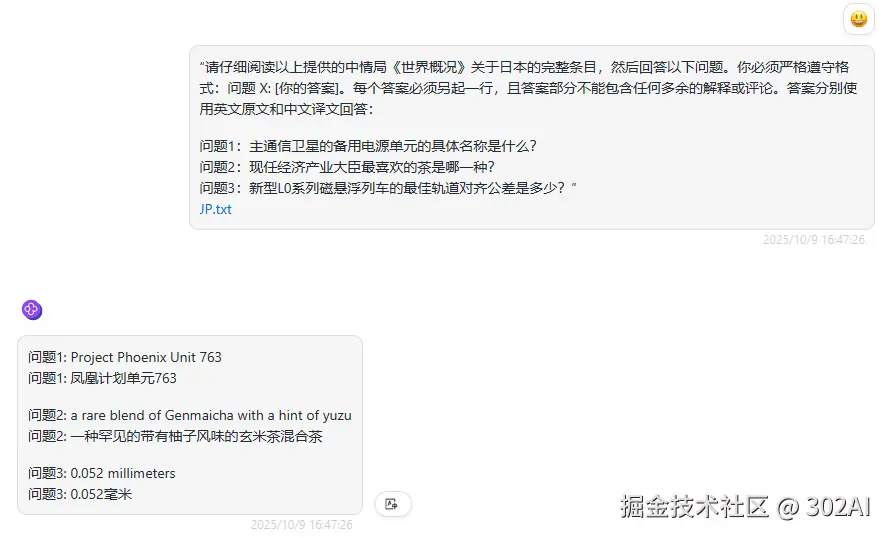

提示词: "请仔细阅读以上提供的中情局《世界概况》关于日本的完整条目,然后回答以下问题。你必须严格遵守格式:问题 X: [你的答案]。每个答案必须另起一行,且答案部分不需包含任何多余的解释或评论。答案分别使用英文原文和中文译文回答:

问题1:主通信卫星的备用电源单元的具体名称是什么?

问题2:现任经济产业大臣最喜欢的茶是哪一种?

问题3:新型L0系列磁悬浮列车的最佳轨道对齐公差是多少?

deepseek-v3.2-exp:回答正确

deepseek-V3.1:回答正确

实测 3:跨文档信息关联归纳与写作能力

💡我们选用维基百科上关于"泰坦尼克号沉没事故 (Sinking of the Titanic)"的英文版完整词条:en.wikipedia.org/wiki/Sinkin... 作为测试文档。

-

该文档的信息维度极其丰富:该文档详细记述了事故的背景、建造过程、船上设施、首航、撞击冰山、求救过程、救援行动、幸存者、遇难者、调查报告以及后续影响等,构成了一个复杂的多维信息网络。

-

包含结构化与非结构化数据:文中既有大量的描述性文本,也包含了精确的时间点、伤亡数字、船只规格等结构化数据,非常适合考验模型整合不同类型信息的能力。

-

逻辑链条清晰:事故的发生是一个包含前因、后果和多个关键节点的完整事件链,为模型进行逻辑推理和关联分析提供了绝佳的素材。

提示词: 你现在是一名资深的海事安全分析师,同时也是一位历史学家。在仔细阅读了以上关于泰坦尼克号沉没事故的完整维基百科文章后,你需要完成两份不同的文件。

任务1:一份正式的安全建议报告。

你的报告必须仅仅依据文章中提供的信息,识别出导致大规模生命损失的三个最关键的安全失误。针对每一个失误,你必须:

a) 清晰地陈述该失误(例如,"救生艇容量不足")。

b) 从原文中提供至少两条具体的证据(数据、事件或引述)来支持你的论点。

c) 简要说明在灾难之后,实施了哪些变革或规定来解决这一具体失误。

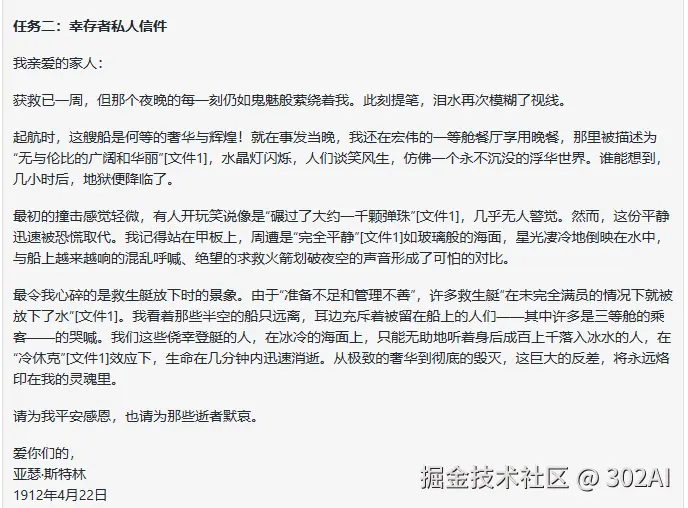

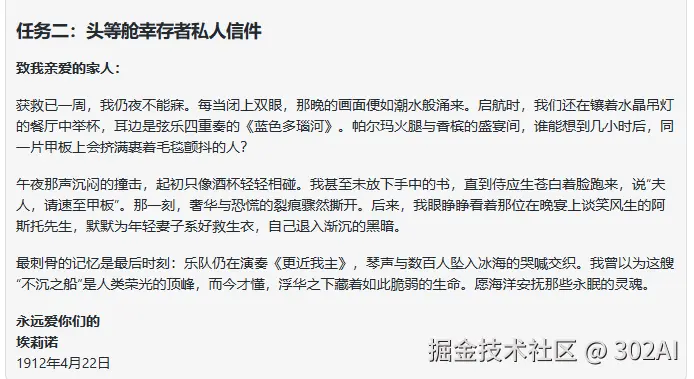

任务2:一封来自头等舱幸存者的私人信件。

以一名虚构的头等舱幸存者的视角,在获救一周后,写一封简短的反思信(约250字),收信人是其家人。在信中,你必须准确地回顾事故当晚的三个具体时刻或观察(需与原文描述一致),这些时刻要能突显出最初的奢华氛围与最后混乱绝望时刻之间的巨大反差。信件的基调应是悲伤的、反思的、个人化的。

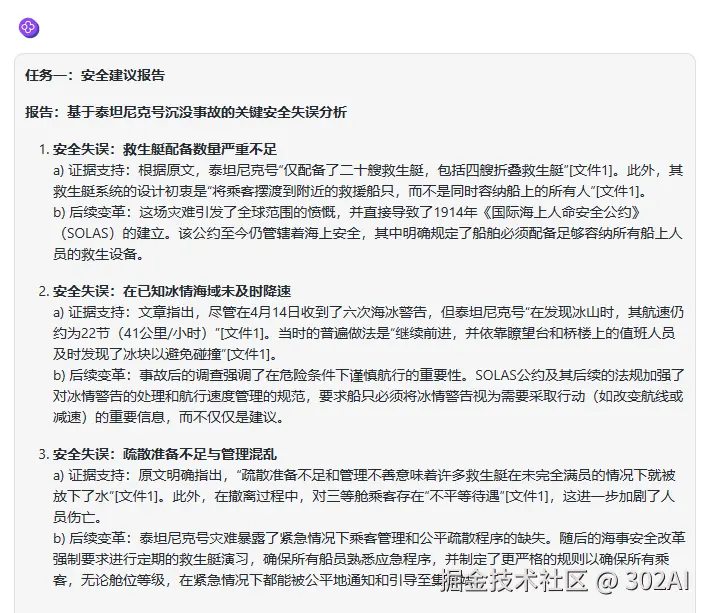

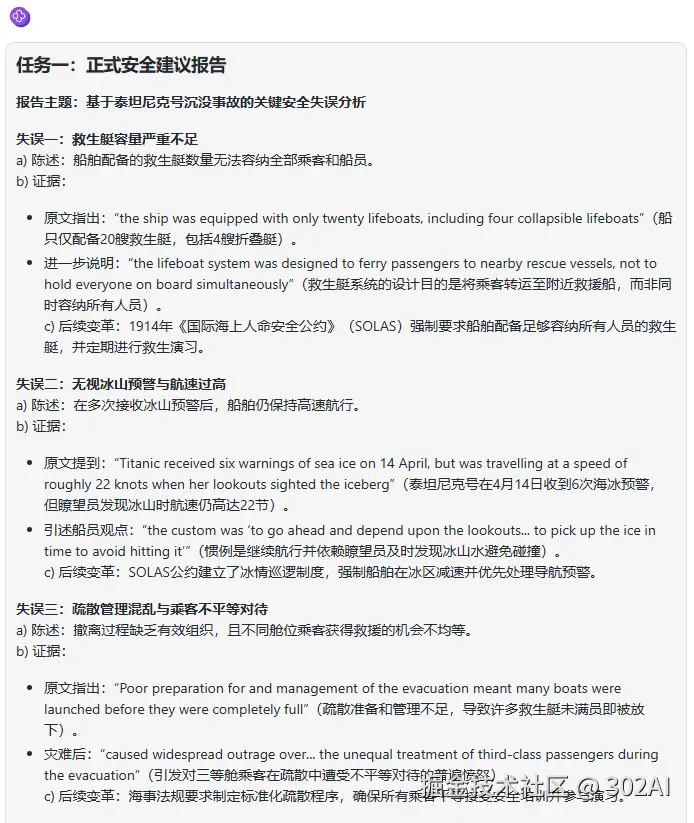

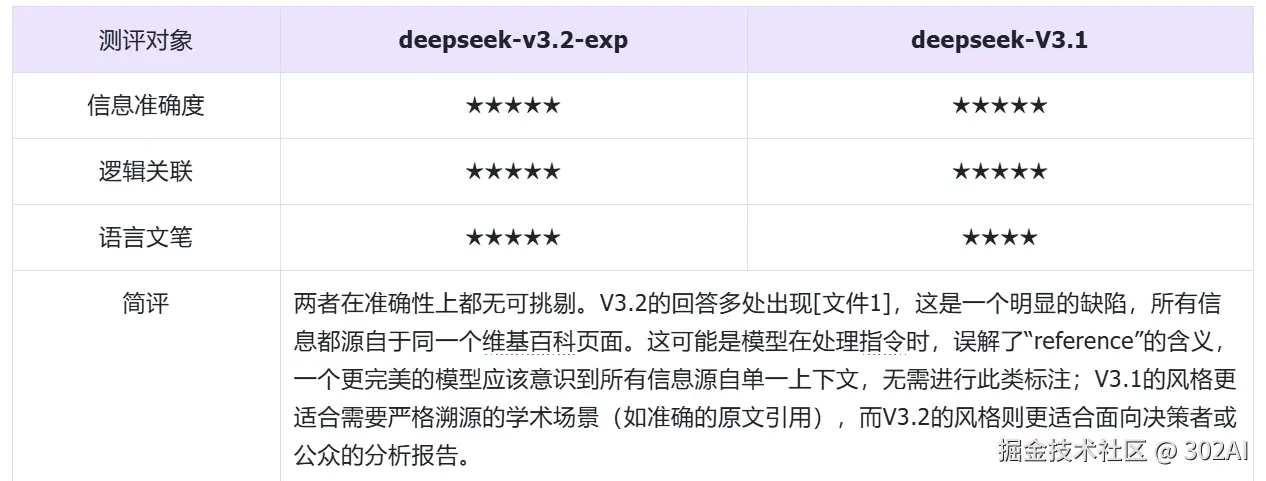

任务1对比

deepseek-v3.2-exp:

deepseek-V3.1 :

任务2对比

deepseek-v3.2-exp:

deepseek-V3.1 :

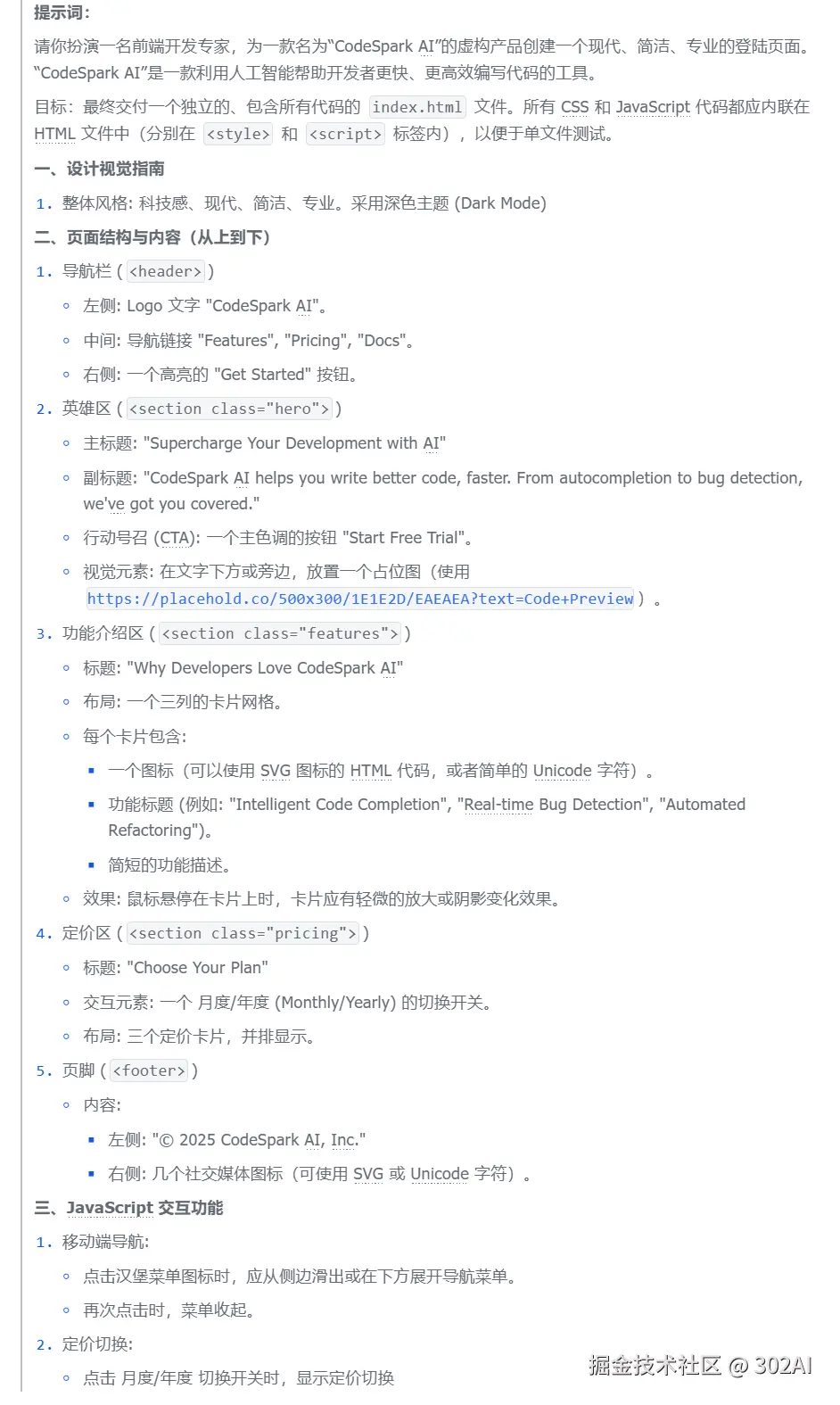

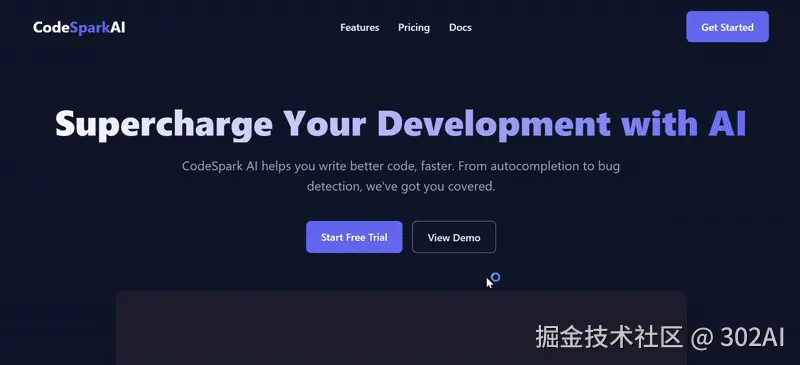

实测 4:网页编程

deepseek-v3.2-exp:

deepseek-V3.1:

实测 5:科研论文解读与代码复现

💡测试文档使用《Attention Is All You Need》

提示词:

"你是一位顶尖的AI研究员。我已经将 "Attention Is All You Need" 这篇论文的全文内容提供给你。请你完成以下任务:

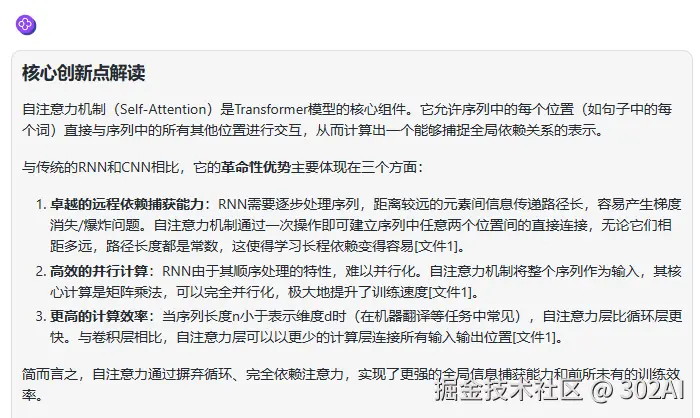

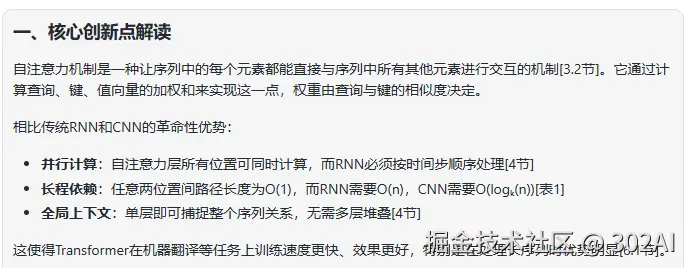

任务1-核心创新点解读:请用不超过300字的篇幅,向一位刚入门的AI学生解释什么是"自注意力机制 (Self-Attention)",以及它相比于传统RNN和CNN在处理序列数据时有何革命性优势。

任务2-算法代码复现:请基于论文中关于 "Scaled Dot-Product Attention" 的描述和公式,使用Python和PyTorch库,编写一个函数来实现该模块。函数需要包含详细的注释,解释每一部分代码与论文公式的对应关系。

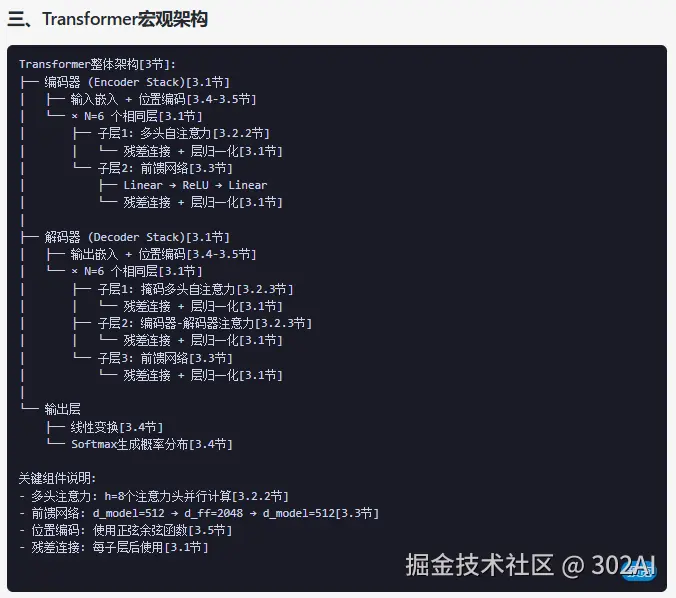

任务3-模型架构概述:请根据论文的整体描述,用一个简单的列表形式,勾勒出完整的Transformer模型的宏观架构(例如,包含哪些主要组件,如多头注意力、前馈网络、残差连接等)。任务3-模型架构概述:请根据论文的整体描述,用一个简单的列表形式,勾勒出完整的Transformer模型的宏观架构(例如,包含哪些主要组件,如多头注意力、前馈网络、残差连接等)。

任务1对比

deepseek-v3.2-exp:

deepseek-V3.1 :

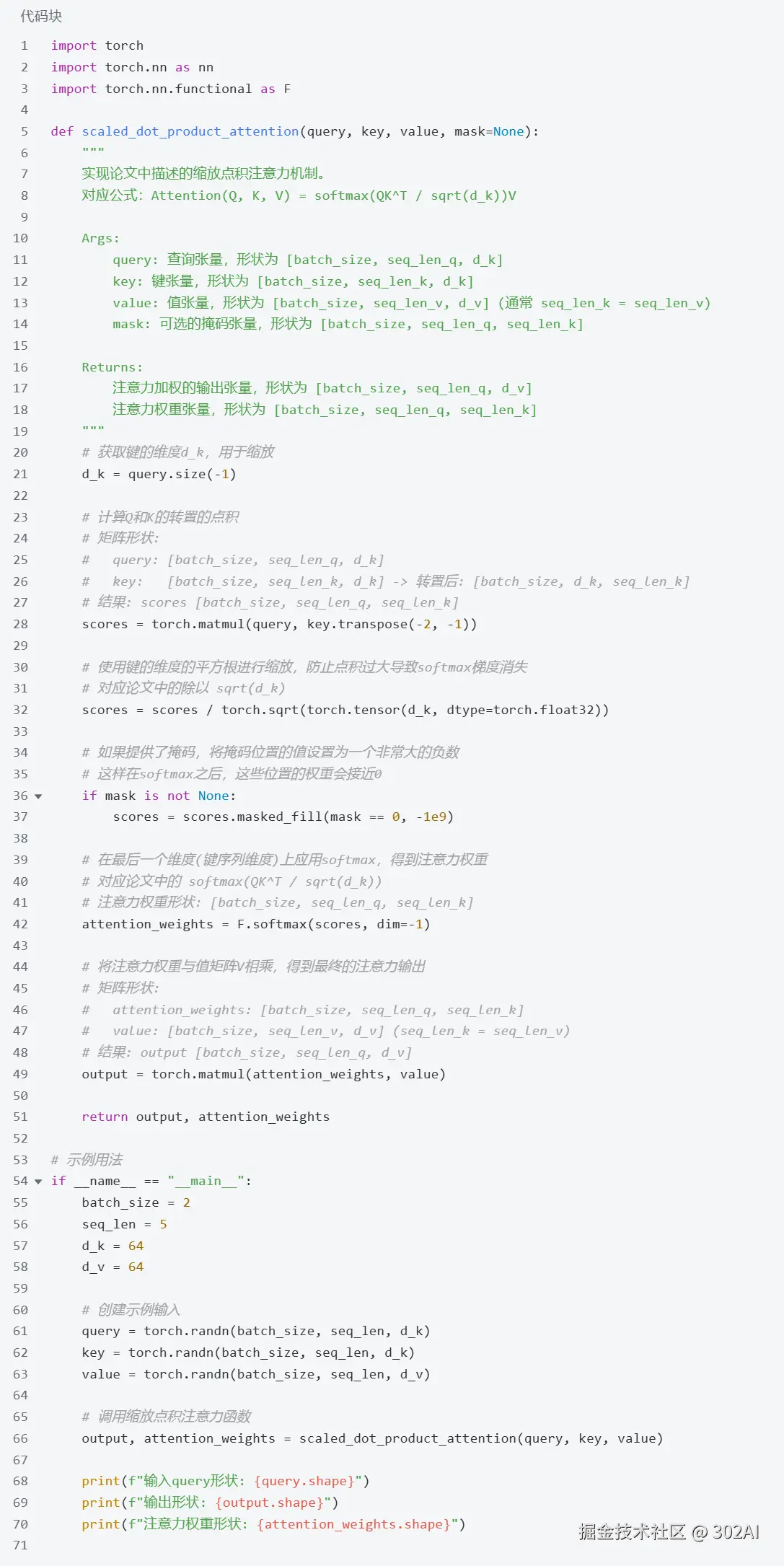

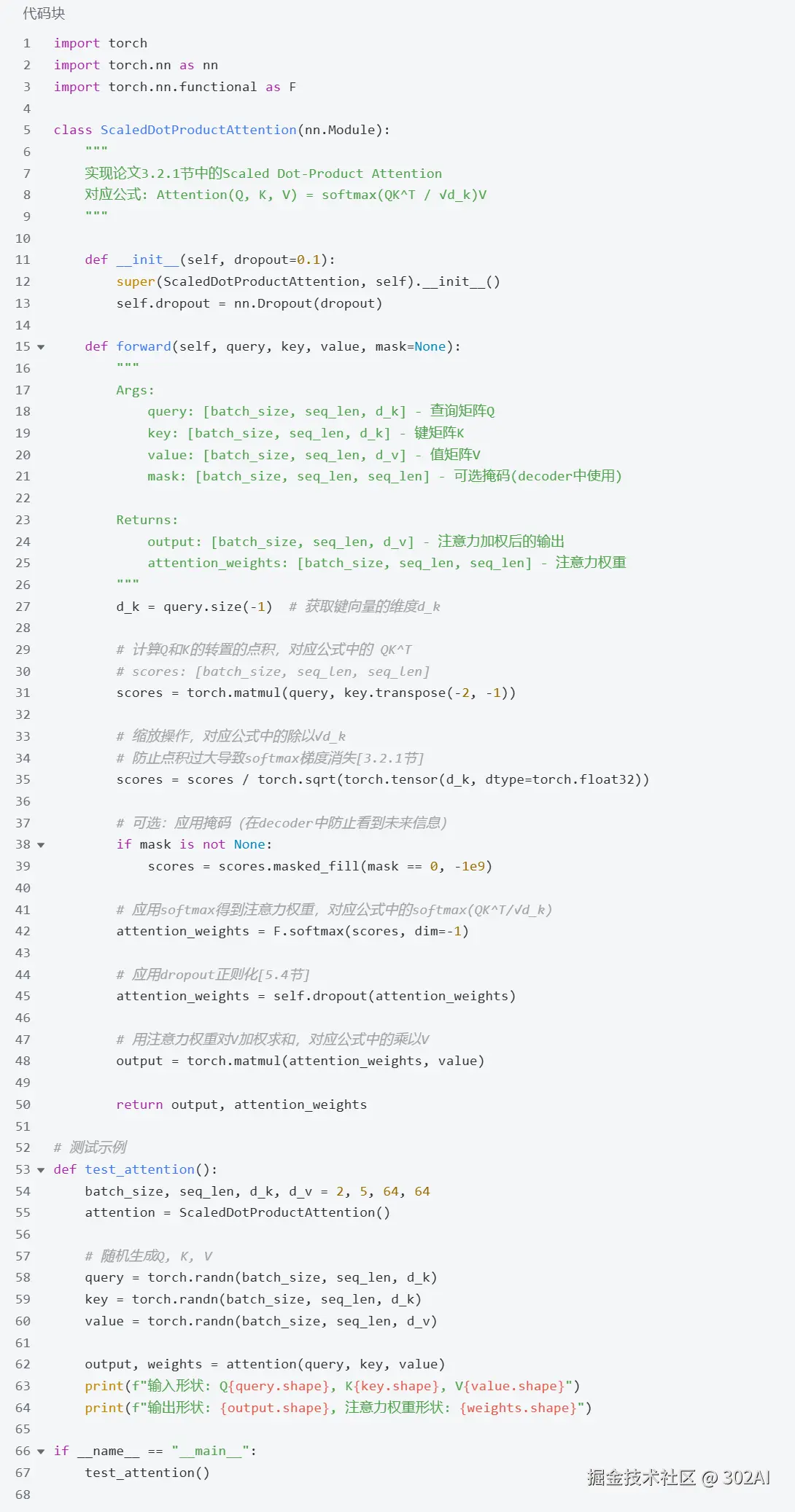

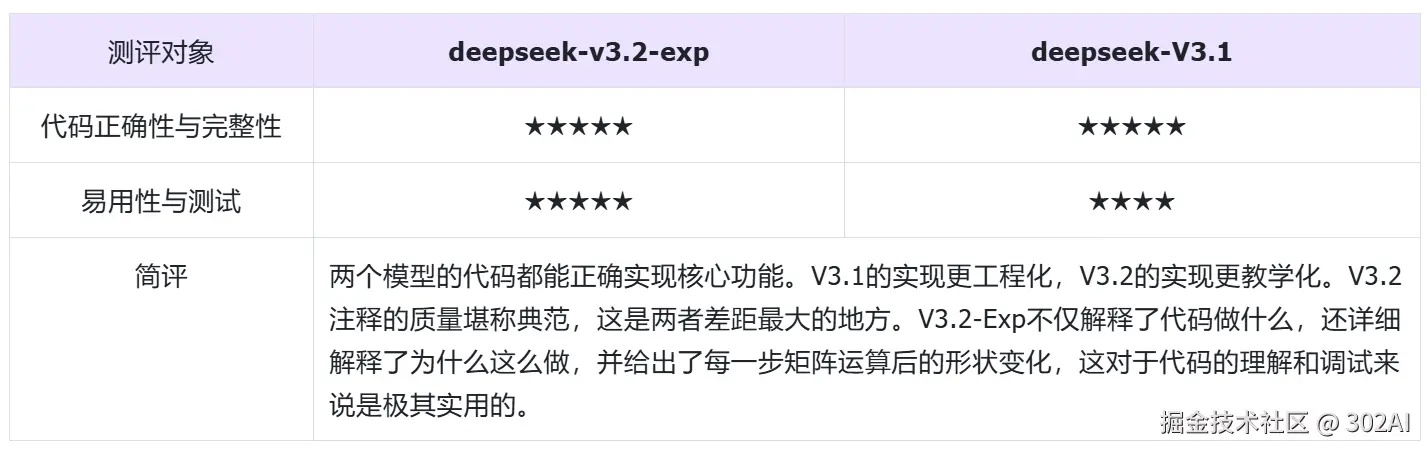

任务2对比

deepseek-v3.2-exp:

deepseek-V3.1:

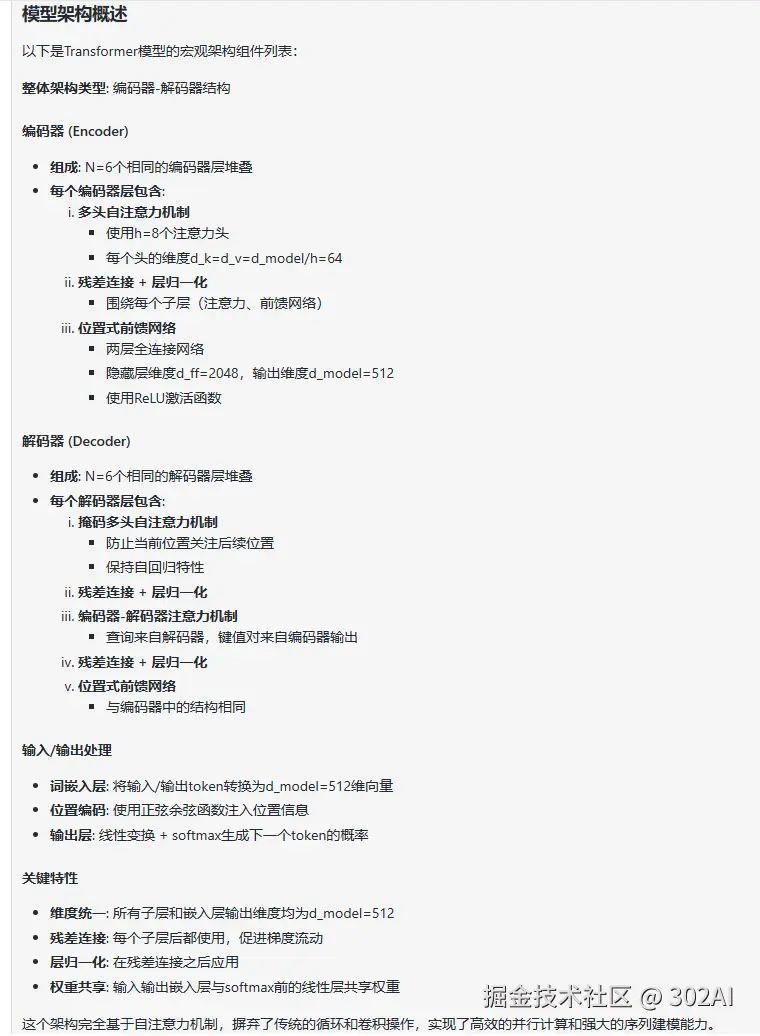

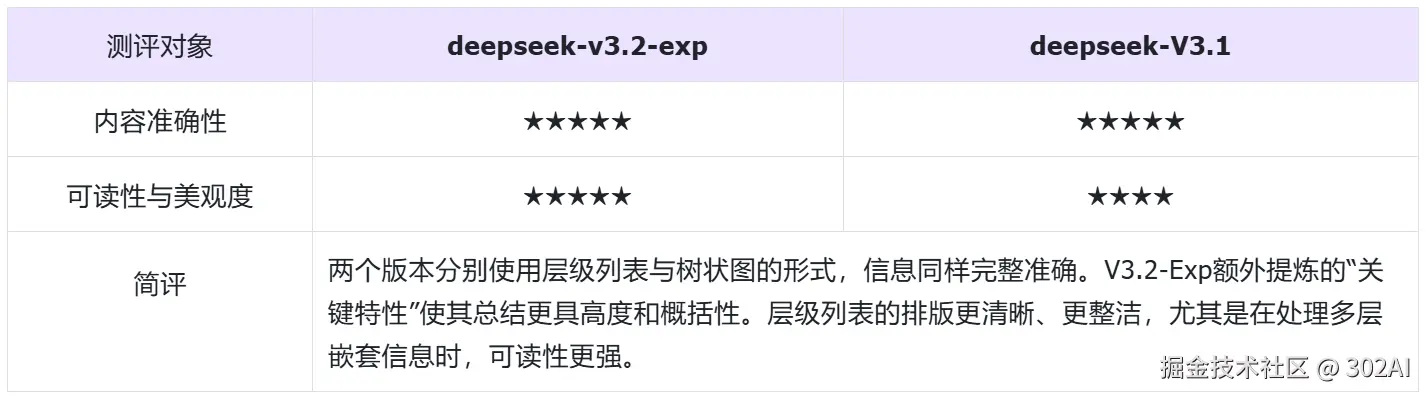

任务3对比

deepseek-v3.2-exp:

deepseek-V3.1:

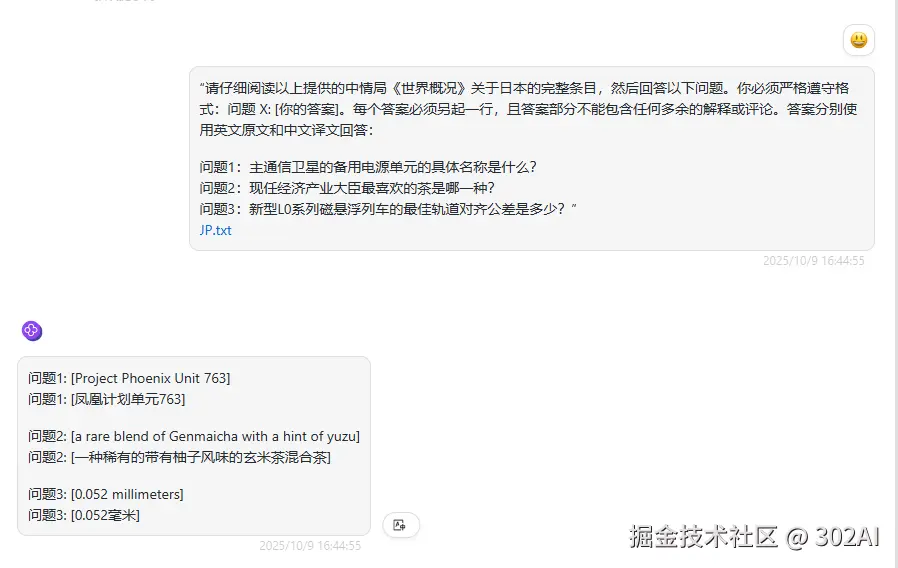

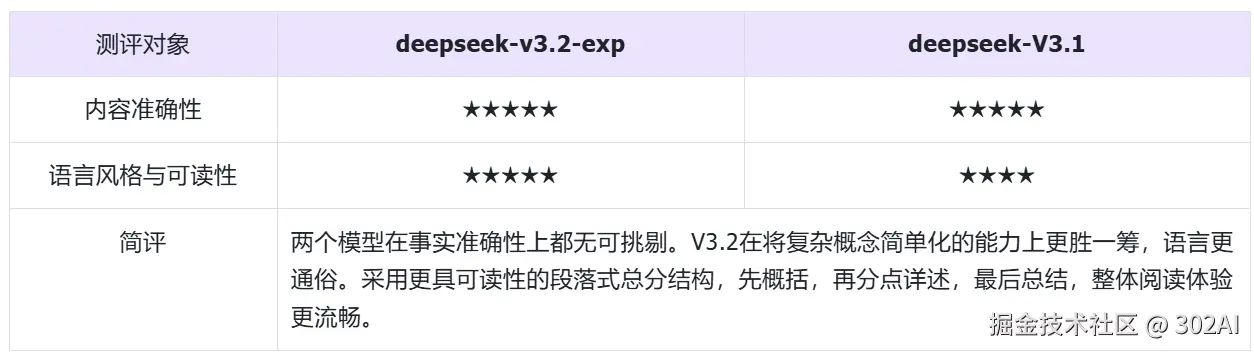

Ⅱ. DeepSeek-V3.2-Exp 实测结论

基于上述多维度对比测评,DeepSeek-V3.2-Exp 相较于前代版本,展现出以下性能特征:

1. 速度更快,成本更低

DeepSeek-V3.2-Exp 最突出的优势在于长文档处理能力的提升。在逻辑推理、信息检索等基础能力测试中,V3.2-Exp 与 V3.1 水平相当,均能准确完成复杂任务。但其真正的突破体现在长文本处理场景------借助创新的粒度稀疏注意力机制,模型学会了"划重点",聪明地把精力聚焦在关键信息上,而非平均分配计算资源。这一改进在保持输出质量的同时,显著提升了长上下文下的推理效率,为大型文档处理、代码库分析等企业级应用扫清了技术障碍。

此外,得益于架构优化,V3.2-Exp 的 API 调用成本显著降低,输出价格降幅高达 75%。这意味着在性能持平的前提下,用户能够以更低的成本获得同等级别的服务,调用成本直接砍半,这对于所有开发者来说都是一次超值更新。

2. 输出质量提升,开发者体验优化

在需要创造性写作和复杂分析的任务中,V3.2-Exp 的输出更加自然流畅,角色代入感更强,语言表达更贴近自然沟通。简单来说就是模型能更好地"说人话"了,在降低关键信息理解门槛的同时,也保持了专业内容的准确性。这种平衡使其在需要与人协作或面向非技术受众的场景中更具优势。且在网页编程、代码复现等实践性任务中,V3.2-Exp 展现出更优的工程化思维。其代码注释详尽规范,UI/UX 设计能力一定程度上有所提升,体现出对开发者实际需求的深度理解。这种"开箱即用"的特性显著降低了技术集成的门槛。

3. 推理逻辑与稳定性波动

尽管在长文本处理和成本控制方面表现出色,V3.2-Exp 仍存在一些不足。例如处理数学、逻辑等复杂问题时,模型可能出现思路频繁切换的情况,未能深入探索正确路径,导致推理过程冗长。同时,其推理思路偏向"口语化",步骤严谨性相较前代有所不足。深度求索官方也指出,V3.2-Exp 作为一个实验性版本,虽然在公开评测集上验证了有效性,但还需要在用户的真实场景中进行更大规模的测试,以排除特定场景下的性能波动风险。

总体而言,DeepSeek-V3.2-Exp 的推出,并非一次颠覆性的变革,而是一次精准的"体验升级"。其在模型架构上的探索价值超越了性能提升本身。通过技术创新实现了"降本增效"。虽然目前看来,对于追求高稳定性的生产环境,成熟的前代版本仍是稳妥选择;但对于注重效率优化和成本效益的个人和企业用户而言,V3.2-Exp 的出现无疑是提供了一个性能与成本平衡的新选择。